Прямо сейчас в Силиконовой долине проходит GPU Technology Conference. Это важнейшее событие для всех тех, кто занимается технологиями параллельных вычислений, нейронными сетями и искусственным интеллектом. Текущий 2016 год особенный для этой конференции. То к чему готовились и шли долгое время именно сейчас приобретает законченные формы. Причем, как и предопределено развитием технологий, прорыв происходит сразу по всем направлениям:

- нейронные сети, построенные на обучении с подкреплением, берут следующую высоту после шахмат и побеждают человека в го, игру, которая превосходит шахматы по своей комбинаторной сложности;

- беспилотные автомобили проходят проверку на дорогах и доказывают свою состоятельность;

- платформы искусственного интеллекта от IBM, Amazon, Google и Microsoft готовы для интеграции в реальный мир;

- виртуальная и дополнительная реальность уже реализованы и готовы к масштабному внедрению от Oculus, HTC, Sony и Sumsung;

- решения на базе HPC (High Performance Computing) интегрируются практически повсеместно.

Пожалуй, главный участников прорыва — это компания NVIDIA. Именно на ее железе работает большая часть всех революционных чудес.

Вчера NVIDIA провела презентацию, показала оборудование и озвучила идеи, которые будут определять ход компьютерной революции как минимум ближайший год. Наверняка об этом будет много новостей и обзоров. Мне довелось присутствовать на этом мероприятии, пересказывать его полностью я не буду, но попробую отметить те детали, которые особенно отложились в памяти.

Есть у компании NVIDIA со-основатель и в одном лице ее президент Дженсен Хуанг. Он и вел презентацию. Насколько это хороший оратор и яркий рассказчик вы можете судить по тому, что к концу презентации, я стал искренне переживать, что в моем любимом iMac стоит видеокарта от AMD. Вот она сила слова!

Вообще же, я еще раз убедился в том, что компьютеры стали иными. Центральный процессор, еще недавно сердце компьютера, сейчас отошел на второй план. Навигация в интернете или работа с текстом — практически не требуют системных ресурсов. Даже самый слабый из современных процессоров с легкостью справляется с этим. А вот для всего действительно современного и интересного даже самый мощный процессор оказывается совершенно не пригоден. Создание графики в играх, моделирование виртуальной или дополнительной реальности, обработка изображений в реальном времени — все это возможно только на системах с параллельными вычислениями, когда счет количества параллельных потоков идет не на единицы, а на тысячи.

Почти в самом начале выступления прозвучала фраза, которая сразу запомнилась: “уже никому не нужна реалистичность, нужна реальность”. Чтобы это продемонстрировать NVIDIA применила два козыря: интригующую тему и несомненного авторитета. Они смоделировали с абсолютной достоверностью восемь квадратных миль поверхности Марса с базой NASA и разной техникой поблизости. Опробовать это по прямой видеосвязи пригласили Стива Возняка. Было трогательно и забавно, когда Дженсен поблагодарил Стива за первый компьютер, за SSD и предложил, что дескать если тот и дальше хочет быть впереди, то компания NVIDIA готова устроить ему право быть первым космонавтом в полете на Марс в 2030 году. Стив радостно согласился. Дженсен, правда заметил, что NVIDIA готова оплатить билет только в один конец. Возняк не смутился и сказал, что Марс — это мечта и в один, так в один. Короче, сошлись на том, что ждать 2030 года не стоит и лучше, не откладывая, прямо сейчас опробовать Марс в исполнении NVIDIA, тем более, что обещана была “не реалистичность, а реальность”. Судя по реакции, реальность Марса Возняку понравилась. Он бодро гонял в шлеме Окулус на марсохроде и было видно, как ему хочет попробовать протаранить здания базы, видимо, чтобы проверить обещанную реальность ну уж совсем по полной.

Оправдывая лозунг “не реалистичность, а реальность”, NVIDIA презентовала главного виновника торжества новую архитектуру Pascal. 15 миллиардов транзисторов на одном кристалле — это больше чем у любого другого чипа, созданного людьми ранее. Потрясающие характеристики можно посмотреть по ссылке.

Когда была озвучена сумма, затраченная за три года разработок этой архитектуры, мне почему-то подумалось, что «Роснано» как-раз могло потянуть, но почему-то не потянуло, стало как-то грустно.

Игровые видеокарты на Pascal появятся уже в этом году. Похоже, что их высокая производительность понадобится в первую очередь второму поколению систем виртуальной реальности. Сейчас для всех систем VR разрешение еще достаточно далеко от ретины. И Oculus, и HTC в своем первом релизе при выборе разрешения исходили из производительности существующих на сегодня видеокарт. Возможно Pascal исправит эту ситуацию.

Показали модуль Tesla P100. Это первый продукт на базе новой архитектуры. P100 — ускоритель на базе которого можно строить различные вычислительные системы. Обещали, что в начале следующего года появятся сервера от всех крупных игроков.

Сама NVIDIA показала, то чем заслуженно можно гордиться — суперкомпьютер DGX-1.

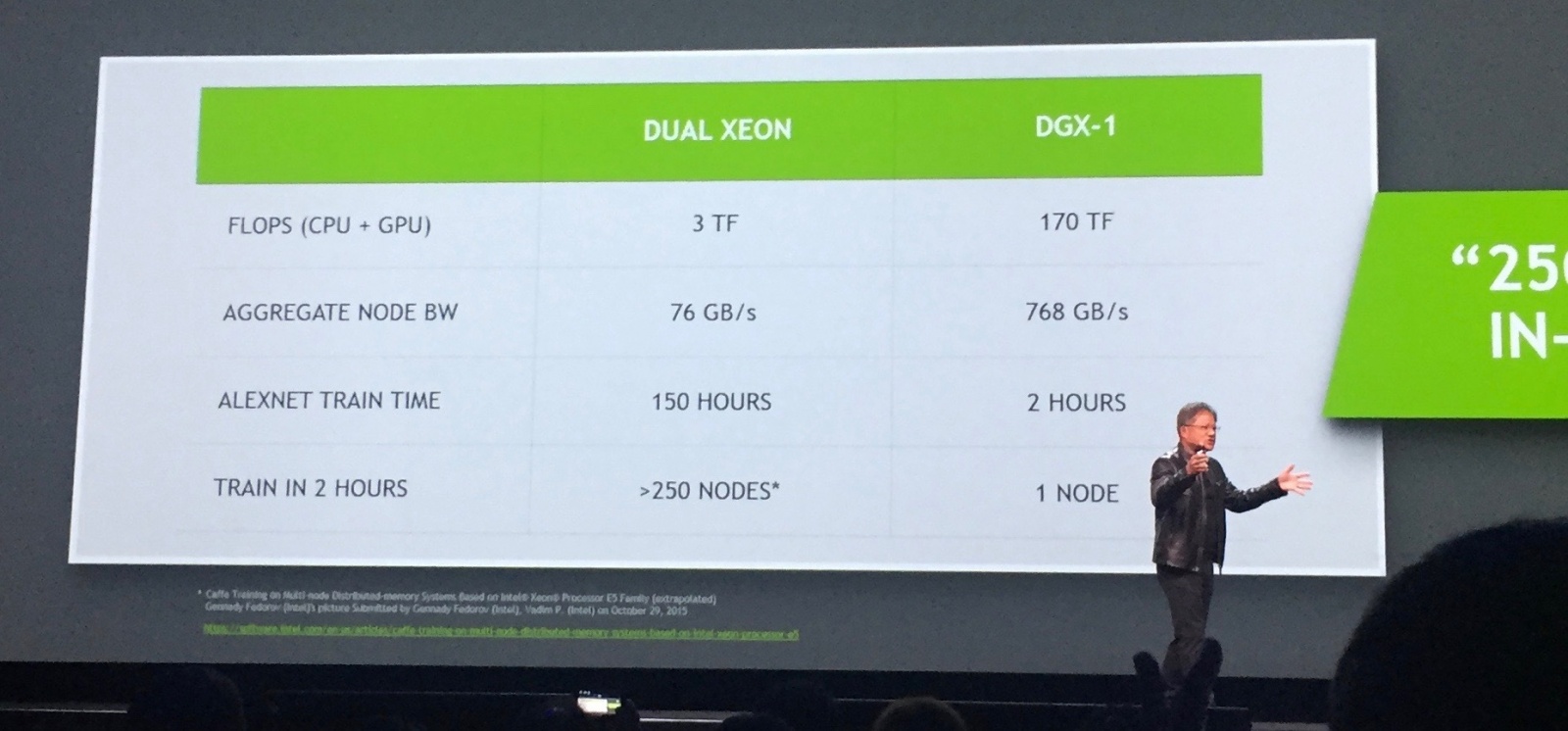

Назначение этого чуда — глубокое обучение нейронных сетей. Суперкомпьютер состоит из восьми модулей P100 и имеет производительность 170 терафлопс. Цифра огромная, но большее впечатление производит не ее астрономическая величина, а сравнение с производительностью аналога предыдущего поколения. Удалось добиться, не предусмотренного никаким законом Мура, рекордного ускорения в 12 раз.

DGX-1 позволяет тренировать нейронные сети, соответственно, в 12 раз быстрее, там где раньше требовалось несколько суток, теперь нужны часы.

Стоит это чудо 129 000 долларов, но есть ощущение, что оно того стоит. На стенде NVIDIA, где можно было рассмотреть DGX-1 живьем (фото со стенда на КДПВ), вместе со мной был инженер из JP Morgan, который хорошо знает толк в таких вещах, я видел как искренне у него горели глаза.

Но железо — это только пол-дела. Глубокое обучение в сочетании со сверточными сетями начали давать удивительные результаты. Уже сейчас можно говорить не об эволюции, а революции в машинном обучении. Но да я с этого начинал. Однако качественный скачек к сильному искусственному интеллекту еще только предстоит сделать. Что для этого надо и какое изменение вычислительной парадигмы нам предстоит я попробую описать несколько позже.

Автор: AlexeyR