Работа сисадмина основана на вере, что инженеры ЦОДа знают свое дело. Мы создаем отказоустойчивые кластеры, но чего будет стоить эта отказоустойчивость, если отключится электричество? Какая разница, как быстро сервер обрабатывает запрос, если упал канал от ЦОДа до точки обмена трафиком? Как поднимать сервер, если он физически перегрелся?

А хотелось бы не верить, а знать, как именно создается отказоустойчивость на железном уровне. Откуда берутся те «девятки» надежности оборудования, о которых мы говорим, формулируя SLA Кубернетесов. Что происходит, когда проект горит в самом прямом смысле этого слова.

Нам повезло пройтись по ЦОД Selectel на третий день Слёрма DevOps, заглянуть в святая святых и даже кое-что сфотографировать на память. А также мы спросили о легендах компании, которые сотрудники Selectel никому никогда не рассказывают. Да и как выяснилось, сами уже не помнят.

Нашу компанию Southbridge связывают с Selectel давние партнёрские отношения. Сейчас мы поддерживаем 58 проектов, размещенных на серверах провайдера. Когда клиенту нужен сервер, расположенный в России, мы рекомендуем Selectel, потому что по опыту работы считаем его самым надежным и удобным провайдером IT-инфраструктуры.

Поехали!

Пока поднимались по лестнице на четвёртый этаж — самые хитрые поехали на лифте, самые спортивные пошли по лестнице — коллеги из Southbridge напомнили мне, что надо обязательно узнать о легендах Selectel: об оборотне, о неприкаянном духе, что бродил и завывал при постройке нового здания ЦОД. Меня всегда интересовала мифология крупных компаний, которая осталась от бурного этапа рождения и первого роста.

В самом начале у компании был один дата-центр на Цветочной 1 в Санкт-Петербурге. ЦОД обслуживал компанию Вконтакте. Мы его увидели из окна, когда поднялись на четвёртый этаж. Он один раз останавливался на модернизацию лет девять-десять назад — и с тех пор работает непрерывно. По категории надежности он относится к Tier II.

Информация к размышлению(с) "Семнадцать мгновений весны":

Основной показатель работы ЦОД — отказоустойчивость. Всего существует 4 категории — от Tier I до Tier IV. Принадлежность к определённой категории указывает на уровень резервирования, физической безопасности и надежности.

Tier I (Резервирование — N, отказоустойчивость — 99,671%) — в дата-центре отсутствуют фальшполы, нет резервных источников электроснабжения и источников бесперебойного питания, не резервируется инженерная инфраструктура. При плановом или срочном ремонте ЦОД останавливается.

Tier II (Резервирование — (N+1), отказоустойчивость — 99,749%) — имеется небольшой уровень резервирования, в дата-центре смонтированы фальшполы и резервные источники электроснабжения, проведение ремонтных работ вызывает остановку работы дата-центра, как и в категории Tier I.

Tier III (Резервирование — 2N, отказоустойчивость — 99,982%) — возможно проведение ремонтных работ (замена компонентов системы, добавление и удаление вышедшего из строя оборудования) без остановки работы дата-центра. Все системы зарезервированы, имеется несколько каналов распределения электропитания и охлаждения.

Tier IV (Резервирование — 2(N+1), отказоустойчивость — 99,995%) — в требованиях двойное резервирование и дублирование системы. Возможно проведения любых работ без остановки работы дата-центра. Инженерные системы двукратно зарезервированы, то есть продублированы как основная, так и дополнительная системы.

Впереди нас ждала мощная решётка, дверь с электронным замком и вертушка в полный рост, изготовленная из толстых металлических профилей. А за ней само пространство ЦОД.

Дата-центр, в котором мы находились, более новый, чем ЦОД по соседству — его построили в 2015 году. И он относится к категории Tier III.

Сейчас у Selectel два действующих центра на Цветочной, ещё три в Дубровке, два ЦОД в Москве, которые в компании считаются, как один дата-центр. Всего шесть.

В здании четыре этажа. На первом расположены офисы и размещена часть оборудования. Четвёртый этаж частично выделен под офисы, но большая его часть занята техническими помещениями.

До того, как сюда въехал провайдер, в здании было расположено производство. Сотрудники дата-центра и сами уже не помнят производство чего именно — то ли фотоплёнки, то ли одежды. Здание компания купила, чтобы исключить риски сложных имущественных отношений, если собственником здания является стороннее лицо.

Несмотря на то, что здесь раньше располагалось производство, стояли станки и другая тяжёлая машинерия, Selectel дополнительно укрепил этажи. Ещё в конференц-зале на первом этаже, где проходил интенсив Слёрм DevOps (1, 2, 3), мы обратили внимание на усиленные опоры.

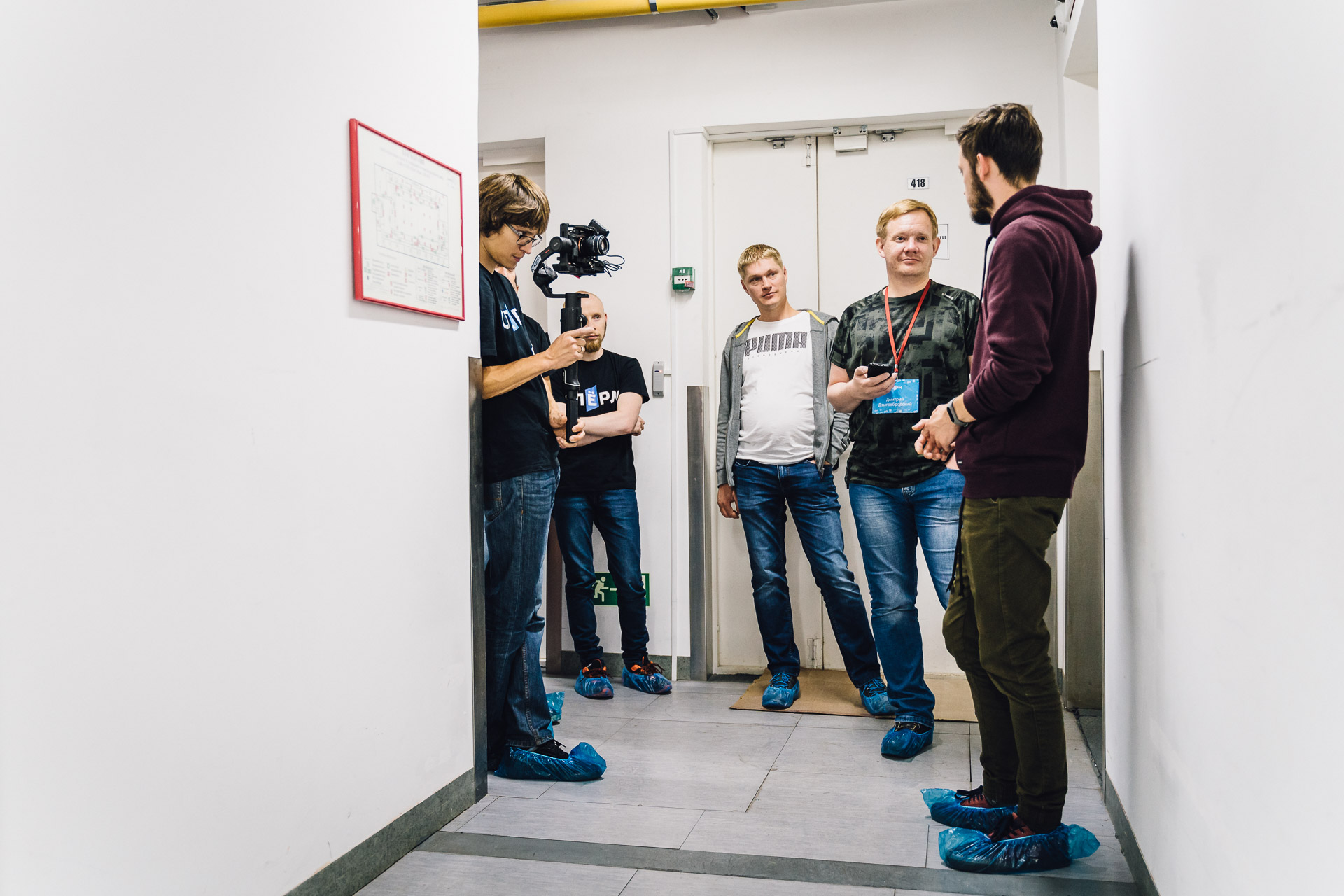

В ЦОД заходим только в бахилах — привычное правило для таких помещений. Для надевания полиэтиленовых онучей стоит "бахильница". Мы искренне прониклись. Сопровождающий предложил нам выбор — самим обуться или доверить конечности прожорливому аппарату.

Наш выбор был предсказуем. Игорь Олемской, директор Southbridge: «Мы за автоматизацию». Антон Тарасов, администратор Southbridge: «Если бы так с носками было, я был бы самым счастливым человеком на планете».

Пока обувались, разработчики Southbridge активно интересовались, где именно стоят сервера VMware. Всем было интересно взглянуть, на каком оборудовании работает эта технология.

Как только зашли в техническую зону, сразу же нам озвучили правила: «Ничего не едим, не пьём, не курим. Никуда не суём руки, ни в какие щиты, ни в какие стойки, кондиционеры, пульты. Руки держим перед собой, как тираннозавр».

На четвёртом этаже расположены три серверные. Вся аппаратура стоит на фальшполу. Он необходим, чтобы снизу шла подача холодного воздуха, а также чтобы можно было прокладывать коммуникации, к которым не нужен постоянный доступ. Это и силовые линии, и трубопроводы охлаждения.

Как только зашли в малую серверную, на нас обрушился гул. Персонаж известного мультика с опилками в голове точно бы сказал: «Это ж-ж-ж-ж-ж неспроста!». С непривычки первые пару минут мы друг друга почти не слышали. Пояснения экскурсовода тоже еле угадывались, пришлось толпиться поближе.

Вокруг расположены стойки, стойки и ещё больше стоек… Они выстроились строгими рядами. В серверных ЦОД ряды нам встречались разные: на 10 стоек, 12, 20, 30. В зависимости от конфигурации помещения, арендованной клиентом площади и задач.

В ЦОД во всех серверных помещениях системы охлаждения выглядит так: сверху и по бокам охлаждаемое пространство ограничивается конструкцией стойки, фронтальная часть закрыта перфорированными дверями. Кондиционеры загоняют холодный воздух под фальшпол — и воздух под давлением поднимается в стойки.

Достаточно зайти между рядами, чтобы почувствовать, как температура воздуха резко понизится градусов на пять, можно даже почувствовать границу температур. Стыки в фальшполу подогнаны настолько плотно, что кондиционированному воздуху просто некуда деться, кроме пути, специально предусмотренного для охлаждения.

В самой серверной температура поддерживается где-то 22 + 2 градуса по Цельсию. В «холодном» коридоре температура может опускаться до 16-17 градусов. В малой серверной было два «холодных» коридора. Соответственно, коридоры между ними называются «горячими». В них чуть теплее, чем в среднем по серверной — воздух проходит через стойки и нагревается от оборудования.

Здесь расположены стойки под аренду клиентам. Инженеры подключают питание — клиент заезжает с оборудованием и делает, что хочет, в рамках регламента и законодательства. Стойки можно арендовать разные. Целые на 47 юнитов, половинчатые, четырёхсекционные. Они физически разделены — используются разные замки. Можно арендовать всего на 10 юнитов. У кого совсем немного оборудования, этого будет вполне достаточно. Соответственно, меньше мощности — дешевле получается.

Если клиент арендует, например, «четвертинку» в нижней секции и нужно проложить кабель, он будет протягиваться по специальному металлическому каналу. И клиенты в верхних частях стойки никак не получат доступ к чужим коммуникациям: ни к силовым, ни к медным, ни к оптическим.

В серверной стоят кондиционеры в количестве трёх штук. Работают из них только два. Если будет выводиться один кондиционер на техническое обслуживание или произойдёт поломка, инженеры включат запасной. Этот запас по резервированию — требование по спецификации Tier III.

Например, есть источники бесперебойного питания. Их определённое количество, предположим, 12. Но работает 6. Серверная может проработать час на аккумуляторах, если в ЦОД перестанет поступать электричество. Но если вдруг гипотетически сломаются 6 ИБП, то инженеры включат ещё шесть. Узлов в дата-центре всегда в два раза больше для надёжности.

Этот ЦОД по проекту может потреблять до 10 МВт. Но сейчас здесь всего лишь 1,5. Пока что только четвёртый этаж используется под оборудование — второй и третий на этапе строительства. Да и четвёртый ещё не до конца заполнен: он рассчитан на 250 стоек, а занято 200. Есть куда расти.

Всего Selectel во всех ЦОД использует 14,4 МВт. А стоек в эксплуатации 1 200.

Кроме основных стоек, которые идут под разные проекты, в основном под аренду для клиентов, в серверных расположены и служебные стойки, где стоит только оборудование Selectel. Есть стойки кроссовые для пассивного соединения. Они без питания, только оптическое волокно — для соединения оборудования между площадками и между помещениями. В каждой серверной есть такой же шкаф с кроссами. Кросс может уходить в другое помещение, в другую серверную на первом этаже, как только её построят, может уходить в соседний дата-центр или даже в дата-центр на Дубровке.

У компании таких волокон несколько. Если одно будет перебито, ЦОД без паузы начнёт работать по другим. Все пути, которые прокладываются, всегда резервируются.

Если будут делать соединение между этим дата-центром и соседним, один линк инженеры проведут через кросс по воздуху между дата-центрами, а второй линк будут вести по канализации через другой кросс. И что бы ни случилось, всегда будет резервный канал.

Так как в ЦОД много оборудования, сотрудники строго следят за пожарной безопасностью. В дата-центре есть несколько сценариев взаимодействия с пожарами. В Selectel в каждом помещении — и офисном, и техническом — есть огнетушители. И людей специально обучают работать с ними. Если пожар локальный, с ним можно справиться самим.

Но если горит сильно, например, блок-питания у сервера или контур компрессора с маслом, тогда не всегда огнетушители могут справиться. Для таких случаев в ЦОД есть станция газового пожаротушения. От неё по потолку в каждое помещение идут жёлтые трубы.

При серьёзном пожаре всех людей выводят из серверной. Возле каждой двери находится жёлтая кнопка. Закрывается плотно дверь, нажимается кнопка, даётся отсчёт 30 секунд. Подаётся газ «хладон-125» — пентафторэтан, химическая формула С2F5H. Он ингибирует процесс горения — и пожар сразу же прекращается. При пожаротушении в ЦОД не используются ни жидкости, ни порошок — потому что испортят оборудование.

В большой серверной нам запретили делать фотоснимки. Потому расскажу по памяти, что увидели. Всего в этом ЦОД одна маленькая серверная и две большие.

В первой большой серверной один «холодный» коридор, который сделан под проекты Selectel и под аренду клиентов. Он намного длиннее, чем в малой серверной. На некоторых стойках бывают индивидуальные меры безопасности — на одной из стоек мы заметили электронный замок с pin-кодом и сверху видеокамеру.

Посмотрели, как изнутри выглядит услуга «аренда выделенного пространства». Можно купить любую квадратуру на площадке — естественно, из той, что имеется в наличии. И клиент там может разместить любые стойки и оборудование, соответствующие нормам.

Рассмотрели через ограждающий забор очень большую площадь, которая принадлежит одному клиенту. Там стояли немецкие стойки по специальному заказу. Там же расположился небольшой отдельный склад.

По рассказам нашего экскурсовода, эта услуга не обязательно бывает такой масштабной. Можно поставить две стойки и окружить клеткой. И доступ к ним будет только у вас. Обычно такие требование возникают, если это банк или клиент работает с финансовыми учреждениями.

Заглянули в помещение станции пожаротушения. Вот здесь и стоят баллоны с «хладоном-125». Оборудование настроено так, что в каждое помещение в зависимости от размеров направляется газ из определённого количества баллонов.

Слева по коридору расположена электрощитовая. Но туда нам доступа нет, экскурсантов на всякий случай не водят — а то неудобно будет, и запах долго не выветрится.

Там расположены источники бесперебойного питания и щиты. Именно в эту комнату приходит питание для всего здания. И уже отсюда идёт разводка по всем помещениям. В серверные идут шинопроводы, которые можно увидеть под потолком в коридоре.

В каждую серверную направлены два шинопровода. Один идёт под потолком, один идёт под фальшполом — так выполняется условие резервирования. Всё здание питается от двух лучей ввода от электростанции. Если отключается один ввод, то ЦОД будет работать от второго.

Если же отключатся сразу два, то всё оборудование переходит на аккумуляторные батареи. В специальном помещении расположены 750 аккумуляторов. Чуть дальше ещё одна такая же комната — и там ещё столько же. Жить на них ЦОД сможет 1-3 часа в зависимости от нагрузки, но для переключения на дизель нужно всего лишь 2 минуты.

В отдельных помещениях расположены гигантские дизель-генераторные установки. Каждая стоит на платформе высотой примерно по колено — как я понял из объяснений, это отдельный бак с топливом для каждого дизеля. Плюс в ЦОДе есть несколько ёмкостей, которые закопаны под землю и рассчитаны на несколько десятков тонн горючего.

Поскольку топливо деградирует, его периодически заменяют. Если заканчивается топливо в баке дизеля, то насос подкачивает топливо из цистерн. Если вдруг случится неприятность и сломается насос, есть ещё запасной.

Абсолютно все системы дублируются — интернет-каналы связи, охлаждение, электропитание, аварийные системы пожаротушения и альтернативного питания.

Мы задали вопрос по поводу операторов связи. Инженер компании рассказал, что они пользуются постоянно 5-6 операторами для uplinks. И маршрутов довольно много. Плюс у провайдера есть связи практическими со всеми точками обмена трафиком в Санкт-Петербурге и Москве. В Москве самая крупная — это М9. А в Питере — Б18 и Кантемировская.

Если топливо в подземных цистернах подходит к концу, привозят ещё цистерну. У Selectel заключён договор со топливной компанией. ЦОД может бесконечно жить на дизеле, просто это дороже.

Мы поинтересовались, как Selectel работает с человеческим фактором — потому что именно он наибольшая опасность, и никакое резервирование не поможет.

— Как вы работаете с человеческими ошибками?

— Мы стараемся их не повторять. Мы предсказываем возможные ошибки. Проводим тренировки, учения. Например, тренировки по переходу на дизель-генератор: тестируем людей, переходим на дизели в процессе работы, иногда переводим на них всю нагрузку. Плюс есть база знаний.

Добрались мы и до VMware. На облачных серверах используются только интеловские платформы, SSD на 2 террабайта. Естественно, резервирование здесь просто на всё. Например, мы увидели вблизи: в каждом сервере две сетевые карты, в каждую втыкаются два линка. Один линк идёт в свитч, который наверху, другой линк идёт в свитч соседней стойки. Используются по два блока питания на каждый модуль.

В дата-центре в основном стоят российские стойки ЦМО. В клиентских стойках на арендованной площади встречаются разные решения.

Чуть дальше по коридору от второй большой серверной мы увидели лифтовую. Для подъёма оборудования есть два лифта — на одну тонну и на две тонны. Погрузочная зона сделана отдельно — она расположена рядом с конференц-залом на первом этаже.

В помещении лифтовой мы увидели «небольшую» коробочку с роутером Juniper MX 2010. Мечта любого админа: три блока питания переменного тока (AC), 1 модуль RE (Routing engine): 1800x4 (CPU 1.8 GHz QuadCore, 16 GB RAM), 1 модуль SFB (Switch Fabric Board).

Коллеги заспорили, куда бы его поставить. Решили, что дома он будет смотреться лучше всего. Можно будет wi-fi раздавать на домашнюю технику. Громоздко и солидно — серьёзный роутер для серьёзных админов. А когда надоест, можно продать и купить квартиру в крупном городе.

Есть ещё более крупная, мощная и производительная модель — MX 2020.

Как роутер работает? В него вставляются модули, линейные карты — они непривычно высокие и очень узкие. И такие линейные карты бывают очень разные — в них может быть 8, 24, 48 портов. Порты могут быть и «десятки», и «сотки». В зависимости от того, какие у вас потребности и какие финансовые возможности.

В MX 2020 слотов под линейные карты 32 штуки: 16 сверху и 16 снизу. И условно говоря, если вставляете 10 линейных карт, а в каждой по 48 портов, то в итоге получается 480 портов. Втыкаете «двадцатипятки» трансиверы — и умножаем 480 портов на 25 гигабит. Это один из вариантов. Можно поставить и «сотки».

Когда уже вышли из технических помещений, немного задержались на «точке перекуса», где инженеры Selectel восстанавливают силы по ночам. Поинтересовались, дублируются ли в ЦОД кофе-машины по категории Tier III. Две кофемашины на каждой точке — у каждой два блока питания… и так далее.

Игорь Олемской поинтересовался:

— Как достигается высокий уровень квалификации персонала по сравнению с другими дата-центрами?

— Есть определённый порог вхождения. Не каждого будут принимать. Естественно, каждый человек, который сюда приходит, будет проходить дообучение. Много разных направлений. Постоянно проходят внутренние тренинги от различных людей — технического директора, например. В конференц-зале проходит много внешних мероприятий. И сотрудники часто в них участвуют, набираются знаний. После возвращения с конференции сотрудник готовит презентацию — и рассказывает коллегам, что он там узнал, чему научился.

Экскурсовод так же рассказал, что у них сейчас вводится DCIM (Data Center Infrastructure Management). Это система, в которую заносится абсолютно всё в дата-центре, чтобы управлять и отслеживать жизненные циклы. Всё серверное оборудование, сетевое оборудование, стойки, клиенты, трассировки.

На вопрос, а сколько серверов у Selectel, наш сопровождающий возвёл глаза к потолку — то ли считал, то ли запрашивал разрешение у высшего начальства, и с небольшой паузой ответил: "На 6 дата-центров у нас сейчас около 40 000 серверов".

Наш экскурсовод работает в инженерно-техническом отделе — занимается обслуживанием серверных и смотрит, чтобы там всё работало без сбоев. Охлаждалось по требованиям, дизели не протекали, напряжение было на аккумуляторах.

Немного нам рассказал, как у них строится работа. В праздники и выходные всегда присутствует человек на площадке, чтобы в крайнем случае проследить, как ЦОД переходит на дизель-генераторы. Если что-то происходит, в центре управления всегда находится один человек, пока второй выходит проверить серверные.

В целях безопасности дежурные едят разную еду. Если что-то заказывают, то из двух разных мест.

Конечно же, мы спросили, а что он может рассказать о форс-мажорах и фейлах. Сам диалог получился просто замечательный.

— Расскажите что-нибудь плохое?

— Осень наступила, — честно ответил инженер Selectel.

— Расскажите какой-то плохой факт, который вы хорошо решили.

— Или плохо решили.

— Или не решили.

Под таким напором наш сопровождающий сдался и рассказал две истории.

За всё время существования ЦОДа был только один пожар. На четвёртом этаже загорелось техническое помещение. Ничего серьёзного, но всем пожар запомнился тем, что один сотрудник выбежал из здания в обнимку с самым ценным, что есть в компании. С большим динозавром, символом Selectel. И сейчас этот зубастый погорелец стоит в конференц-зале.

Нам сразу же стало интересно, а как сотрудники Selectel борются не с самим пожаром, а с пожарными:

— А когда пожарные приезжают, они знают, что ЦОД нельзя водой заливать?

— Им пофиг. Они пожарные, — грустно ответил инженер.

Но как он пояснил, в дата-центре стараются справиться своими силами. Кроме станций пожаротушения, есть различные огнетушители, даже такие, что дают струю на 8 метров. Постоянно проводят тренировки персонала. Если случается что-то огнеопасное, сотрудники Selectel встречают пожарных, поясняют, что справились, и говорят, что воды не надо, совсем не надо.

Наш сопровождающий рассказал ещё об одном случае, когда всё легло прочно и совсем. Тогда вышел из строя оптоволоконный кабель — между Цветочной и Дубровкой. В итоге оказалось, что рядом с одним участком оптоволокна какая-то толпа собралась и начала стрелять из воздушки по кабелям. И они перебили оптоволоконник. Тогда компания достаточно долго решала проблему. И в сети народ начал поговаривать, что у инженеров провайдера руки кривые, как у динозавра. С тех пор плюшевых динозавров стали изготавливать с прямыми лапами. На всякий случай.

Когда мы знакомились с сотрудницами Selectel, нам рассказали историю о селектеловском оборотне — то ли мальчике, воспитанном бигдатой и разговаривающем на брейнфаке, то ли сисадмине, который в полнолуние перекидывается в разработчика. Мол, воет по ночам, шуршит за фальш-потолком, иногда его можно заметить краем глаза: лохматого, нечёсаного, с красными глазами.

Мы решили разобраться.

— А что за история с оборотнем? Говорят, кто-то воет по ночам и в коридорах видели бородатое существо с красными глазами? Может, вы при реконструкции ЦОДа замуровали комнату с админом внутри?

— Это ложь, красноглазый бородач — это проекция Сатоси Накамото, он единомоментно существует во всех ЦОДах мира. А воют те, кто купил биткойны в декабре семнадцатого.

Судя по уклончивым ответам, тема селектеловского оборотня покрыта мраком NDA. Мы так и не узнали, существует ли он, зато посмотрели ЦОД изнутри.

Автор: ddz