Уважаемые читатели,

Уважаемые читатели,

мы открываем цикл публикаций, посвященный инновационной технологии виртуализации серверного ввода-вывода, в котором сделаем краткое сравнение с технологиями FCoE и iSCSI, детально рассмотрим устройство виртуализации ввода-вывода и архитектуру ЦОД с использованием данной технологии, ознакомим аудиторию с основными характеристиками и особенностями подключения и эксплуатации устройства виртуализации ввода-вывода, а также покажем результаты сравнительного тестирования.

Представляем вашему вниманию первую статью цикла.

Достаточно ли в нашем ЦОДе ресурсов для решения текущих и будущих задач?

В ЦОДах, в которых применяется традиционная методология статического разделения ресурсов, значительная часть оборудования, как правило, загружена слабо, а в некоторых критических местах постоянно наблюдаются перегрузки. Устранение одного узкого места по известному закону Мерфи сразу же приводит к выявлению других узких мест. В настоящее время в большинстве ЦОДов проведена консолидация систем хранения и серверов, а также используются системы управления виртуализацией серверов, применение которых позволяет динамически распределять ресурсы и прогнозировать момент возникновения потребности в дополнительных серверных мощностях, узлах коммутации, ресурсах систем хранения. Теперь с уверенностью можно рассчитать, к какой дате требуется оперативная память или сервер, или определенное количество жестких дисков, или дисковая полка. И пока это вписывается в возможности расширения существующего оборудования, расходы сравнительно небольшие. Однако когда речь заходит о вводе новой серверной стойки, особенно с серверами значительно большей производительности, данное изменение затрагивает большее количество подсистем ЦОДа: в первую очередь ядра LAN и SAN, в которые ранее были инвестированы значительные средства и которые бы хотелось сохранить.

Какие архитектуры и технологии можно использовать для сохранения инвестиций в оборудование ЦОДа?

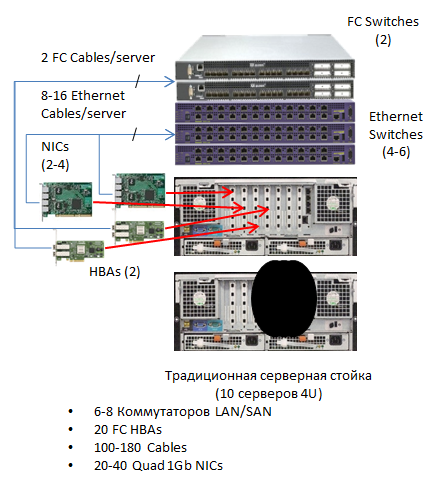

Классическая архитектура (Ethernet + FC)

При классическом общепринятом подходе в ЦОДе существуют две полностью независимые сети — LAN и SAN, — имеющие свои коммутаторы ядра и доступа. При этом в серверы устанавливаются сетевые адаптеры обоих типов, которые дублируются при необходимости резервирования. Физически коммутаторы ядра LAN и SAN располагаются, как правило, в выделенном секторе ЦОДа.

При классическом общепринятом подходе в ЦОДе существуют две полностью независимые сети — LAN и SAN, — имеющие свои коммутаторы ядра и доступа. При этом в серверы устанавливаются сетевые адаптеры обоих типов, которые дублируются при необходимости резервирования. Физически коммутаторы ядра LAN и SAN располагаются, как правило, в выделенном секторе ЦОДа.

В серверные шкафы устанавливаются коммутаторы доступа, так называемые TOR- коммутаторы (Top Of Rack). Как правило, используют по одному коммутатору каждого типа, а для повышения отказоустойчивости и резервирования по два коммутатора. Коммутаторы доступа и ядра соединяются по магистральным линиям связи. При необходимости добавления нового шкафа или стойки с серверами такая система легко масштабируется: добавляется стойка с серверами и TOR-коммутаторами, а в коммутаторы ядра добавляются необходимые интерфейсные модули, и прокладываются новые соединительные линии.

Данный подход наиболее оправдан, если ранее была обеспечена избыточность ядра (имеются свободные слоты в магистральных устройствах).

Конвергентная архитектура на основе расширений протоколов Ethernet

Поскольку классическая схема изначально должна иметь значительную избыточность, в последнее время предпринимаются серьезные попытки обеспечить конвергенцию сетей LAN и SAN: c одной стороны это технология 10 Gbit iSCSI, с другой — технология FCoE. Применение первой технологии позволяет использовать существующие в организации коммутаторы ядра LAN, но требует полной замены систем хранения в SAN (нужны интерфейсы подключения 10G iSCSI). Применение второй технологии сохраняет инвестиции в FC SAN, но требует полной замены коммутаторов ядра и доступа. Обе технологии обеспечивают конвергенцию и экономию на коммутаторах и адаптерах, но их применение экономически оправдано, когда речь идет о полной замене одной из подсистем ЦОДа.

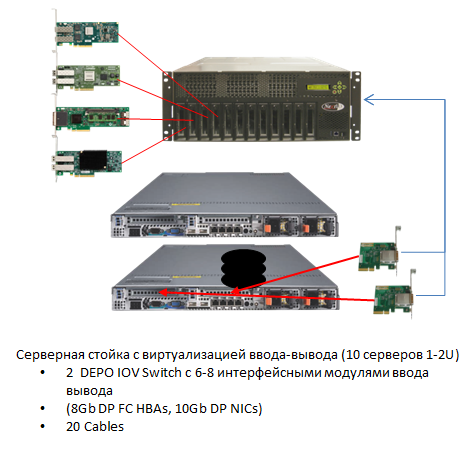

Архитектура с использованием инновационной технологии виртуализации серверного ввода-вывода

Если ранее в ЦОД были сделаны значительные инвестиции (как в SAN, так и в LAN), но требуется увеличить серверные ресурсы, можно использовать новую технологию виртуализации ввода-вывода, в которой используется коммутация на уровне шины PCI-E. Это наиболее естественный для серверов способ коммутации, поскольку в современных серверах на процессорах Intel Xeon E5 контроллер PCI-E встроен непосредственно в процессор. Такие процессоры умеют обрабатывать запросы ввода-вывода непосредственно в собственной кэш-памяти без обращения в оперативную память, что повышает производительность операций ввода-вывода до 80 %. Коммутатор виртуализации ввода-вывода (далее IOV — Input Output Virtualization) имеет входы для подключения серверов по шине PCI-E, а также интерфейсные модули для подключения к LAN и SAN. Такие интерфейсные модули распознаются драйверами мониторов виртуальных машин (гипервизоров) и операционных систем как стандартные адаптеры LAN и SAN (фактически они становятся коллективными для серверной фермы), и полоса пропускания в сети LAN и SAN распределяется динамически. Возможно также выделение полосы, приоритезация и агрегация трафика. Динамическое разделение полосы пропускания магистральных связей дает возможность экономии, например, за счет уменьшения количества интерфейсов и, соответственно, уменьшения количества портов на коммутаторах ядра. Таким образом обеспечивается защита инвестиций и снижается стоимость владения. Кроме этого, будут значительно уменьшены задержки доступа к ядру LAN и к СХД за счет исключения коммутации в TOR.

Если ранее в ЦОД были сделаны значительные инвестиции (как в SAN, так и в LAN), но требуется увеличить серверные ресурсы, можно использовать новую технологию виртуализации ввода-вывода, в которой используется коммутация на уровне шины PCI-E. Это наиболее естественный для серверов способ коммутации, поскольку в современных серверах на процессорах Intel Xeon E5 контроллер PCI-E встроен непосредственно в процессор. Такие процессоры умеют обрабатывать запросы ввода-вывода непосредственно в собственной кэш-памяти без обращения в оперативную память, что повышает производительность операций ввода-вывода до 80 %. Коммутатор виртуализации ввода-вывода (далее IOV — Input Output Virtualization) имеет входы для подключения серверов по шине PCI-E, а также интерфейсные модули для подключения к LAN и SAN. Такие интерфейсные модули распознаются драйверами мониторов виртуальных машин (гипервизоров) и операционных систем как стандартные адаптеры LAN и SAN (фактически они становятся коллективными для серверной фермы), и полоса пропускания в сети LAN и SAN распределяется динамически. Возможно также выделение полосы, приоритезация и агрегация трафика. Динамическое разделение полосы пропускания магистральных связей дает возможность экономии, например, за счет уменьшения количества интерфейсов и, соответственно, уменьшения количества портов на коммутаторах ядра. Таким образом обеспечивается защита инвестиций и снижается стоимость владения. Кроме этого, будут значительно уменьшены задержки доступа к ядру LAN и к СХД за счет исключения коммутации в TOR.

Описание устройства DEPO IOV Switch можно посмотреть здесь.

Порты для подключения серверов: 15 неблокируемых портов PCIe x8.

Производительность на порт: 20 Gbps.

Кабели для подключения к серверам: PCIe x8 (1, 2 или 3 м).

Слоты для установки модулей ввода-вывода: 8 слотов, поддерживающих любые комбинации модулей ввода-вывода FC, Ethernet 10GE

(в планах — поддержка модулей ввода-вывода SAS2 и GPU)

Модуль ввода-вывода 10 Gigabit Ethernet

Интерфейсы модуля ввода-вывода: два порта 10G Ethernet (коннектор SFP+, поддерживаются модули 10 GBase-SR и DA-кабели).

Распределение MAC-адресов: каждый виртуальный сетевой адаптер (vNIC) получает уникальный MAC-адрес; обеспечивается динамическая миграция MAC-адресов при перемещении между физическими серверами.

Вычисление контрольных сумм Tx/Rx IP, SCTP, TCP и UDP checksum offloading capabilities, Tx TCP segmentation offload, IPSec offload and MacSec (IEEE 802.1ae).

Поддержка VLAN: поддерживает IEEE 802.1Q VLANs и trunks.

Поддержка IPv6.

Поддержка межпроцессного взаимодействия (IPC).

Quality of Service (QoS): есть.

Модуль ввода-вывода 8 Gigabit Fibre Сhannel

Интерфейсы модуля ввода-вывода: два порта 8Gb Fibre Channel (коннектор SFP+, LC, MM).

Поддерживаемые протоколы FC-PI-4, FC-FS-2, FC FS-2/AM1, FC-LS, FC-AL-2, FC-GS-6, FC FLA, FC-PLDA, FC-TAPE, FC-DA, FCP through FCP-4, SBC-3, FC-SP, FC-HBA and SMI-S v1.1.

Поддержка World Wide Name: каждый виртуальный HBA (vHBA) получает уникальный WWN; WWN могут динамически перемещаться между физическими серверами.

Поддерживается возможность загрузки с SAN, vHBA можно настроить на загрузку с SAN.

Поддерживаемые операционные системы и гипервизоры

Windows 2008 (32-bit и 64-bit), Windows 2008 R2.

Linux RHEL 5.3, 5.4, 5.5 and 6.0, CentOS, SEL 11.x.

VMware ESXi 4.1 update 1.

Консоль управления

Управление через выделенный порт Ethernet 10/100/1000 Mbps.

Интерфейс управления:

— веб-интерфейс управления GUI (Firefox 3.5, Firefox 4, IE8, IE9, Chrome 11+).

— CLI через Telnet/SSH и Open API для интеграции с другими системами управления.

Lights Out Management — поддержка SNMPv3 Trap Configuration with 2 user accounts and 3 trap destinations.

Мониторинг среды — environment monitoring and chassis alert.

Обеспечение высокой доступности

Резервирование и «горячая» замена блоков питания, вентиляторных модулей, FRU.

Поддержка 10Gbps Ethernet NIC teaming и failover.

Поддержка Fibre Channel Multi-Pathing (MPIO).

Параметры электропитания

110—240 В, 47—63 Гц.

Максимальная потребляемая мощность: 600 Вт.

Габаритные размеры и масса

172,7 х 482,6 х 508 (В хШхГ, мм)

31,8 кг

Условия эксплуатации

Температура эксплуатации: от +10°C до 35°C.

Допустимая влажность: от 8 до 80% (без конденсации).

Высота над уровнем моря: от 0 до 2000 м.

Каким образом производится встраивание серверной фермы с виртуализацией ввода-вывода в существующую инфраструктуру ЦОДа?

Процедура добавления серверной фермы с виртуализацией ввода-вывода мало отличается от аналогичной процедуры добавления серверов с физическими адаптерами. Отличия только в настройке коммутаторов IOV и TOR. У IOV имеется некоторое преимущество: при перемещении (живой миграции) виртуальных серверов в пределах серверной фермы, подключенной к устройству IOV, никаких дополнительных настроек не требуется. IOV позволяет разделить процесс администрирования серверной фермы и ядра сети между различными группами администраторов. В случае если к моменту внедрения новой серверной фермы на коммутаторах ядра не будет свободных портов, но будет запас по производительности, можно избежать дорогостоящей модернизации коммутаторов ядра. Достаточно лишь заменить TOR-коммутаторы на IOV в имеющихся стойках и разделить между ними существующие порты на коммутаторе ядра. Для подключения существующих серверов к IOV существует единственное требование: наличие 1-2 свободных слотов PCI-E 1.0 или 2.0 с разъемом x8.

Какие способы более детального ознакомления с новой технологией виртуализации ввода-вывода доступны в настоящее время?

Мы проводим обучение по развертыванию тестовой фермы, подключение к LAN, SAN, VMWare vCenter, перенос виртуальной машины между серверами фермы, перенос настроек на второй коммутатор ввода-вывода, их резервное копирование и восстановление, добавление нового физического сервера и многое другое. После проведения обучения мы можем передать оборудование на тестирование, в том числе с новыми серверами, предварительно настроенными и подготовленными для подключения к ЦОДу заказчика (имеется два демокомплекта).

В чем заключаются преимущества устройств виртуализации ввода-вывода перед другими решениями?

Первое преимущество состоит в том, что это, пожалуй, наиболее эффективное решение для того, чтобы увеличить максимально возможное число виртуальных машин, которое можно запустить на одном физическом сервере (за счет большой полосы пропускания PCI и возможности агрегирования интерфейсов, по сравнению с применением 10GbE адаптеров – в 2,5 раза).

Второе значительное преимущество технологии виртуализации ввода-вывода — уменьшение задержек сетевых операций ввода-вывода более чем в два раза, что может оказаться ключевым преимуществом для применения IOV в подсистемах ЦОДа, на которых развернуты финансовые системы (за счет уменьшения времени обработки транзакций и передачи сетевого трафика между серверами по высокоскоростной шине PCI-E), а также в телекоммуникационных системах для обеспечения требуемого качества обслуживания.

Другие преимущества и выгоды

- Упрощение администрирования. Используя данное устройство, системный администратор может назначить любой интерфейс ввода-вывода любому серверу одним щелчком мыши. Динамическое распределение ресурсов помогает оптимизировать конфигурацию в соответствии с изменяющимися условиями по нагрузке.

- Общее уменьшение количества промежуточных коммутаторов, сетевых адаптеров, кабелей может обеспечить снижение капитальных и операционных затрат (CAPEX до 40 % и OPEX до 60 %).

Кроме того, обеспечивается защита инвестиций в существующее оборудование LAN и SAN при добавлении новой серверной фермы, возможность использования других модулей ввода-вывода. В ближайшее время планируется выпуск интерфейсных модулей для подключения к сетям SAS2 и коллективного использования ресурсов GPU.

При построении частного облака «с нуля» под управлением платформы виртуализации VMWare и Microsoft использование технологии виртуализации ввода-вывода — наиболее верный выбор, поскольку данная технология позволяет полностью использовать все возможности, предоставляемые современными платформами виртуализации и облачных вычислений.

Устройства DEPO IOV Switch, в частности, используются в типовом решении DEPO Сloud 4000 для построения частных облаков, рассчитанных на более чем 2 000 рабочих мест.

senko,

ведущий менеджер по продукции DEPO Computers

Автор: DEPOteam