Всего 4 месяца прошло с предыдущего релиза, 4.6, и вот на партнерской конференции .NEXT в Лас Вегасе уже рассказали о фичах нового большого релиза, 4.7, который будет «выкачен» уже через несколько дней.

Ну раз руководство почло за добро публично рассказать на конференции о фичах накануне релиза (обычно нас за это очень сильно не хвалят), расскажем о них и мы тут, в России.

Но сперва коротко пробежимся по тем фичам, которые появились в релизе 4.6, совсем, казалось бы, недавно:

- «Файловый сервер» для внешних пользователей, с поддержкой протокола SMB 2.1, single namespace, distributed, etc.

- Значительное, в разы (2,5-1,5 раз в зависимости от профиля ввода-вывода) увеличение производительности, в том числе на уже инсталлированных системах. Еще больше — на AllFlash, фактически вплотную сравниваясь с топовыми allflash CХД.

- Volume Groups — возможность подключать в VM блочные LUN-ы через iSCSI, размещаемые в кластерном сторадже Nutanix

- Self-Service Restore через наш Guest Tools, пользователь может самостоятельно получить доступ к файлам на сделанном им снэпшоте.

- 1-Click Upgrade для «железа» платформы, не прерывающее работу VM на кластере обновление BIOS, BMC, прошивок дисков, гипервизоров и NOS.

- Metro Availability не требующее перезапуска мигрированной VM на DR-сайте.

- Cross-Hypervisor DR, позволяющее поддерживать разные гипервизоры в разных датацентрах (например, vSphere на продакшне и AHV на DR)

- Техпревью средства автоматизированного преобразования гипервизора со всеми VM из vSphere в кластер AHV.

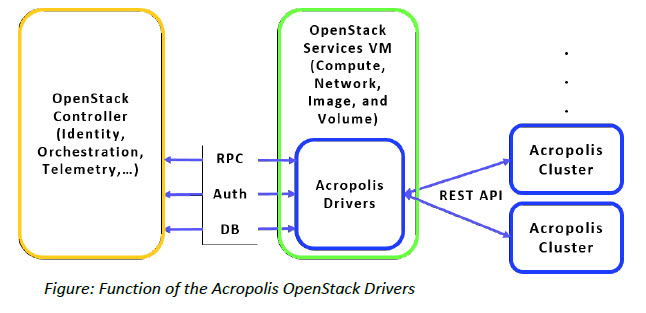

- Интеграция с OpenStack

- Интеграция в Citrix XenDesktop.

- Поддержка скриптов настройки VM в формате clusterinit и sysprep

- AHV VLAN Trunking

- Новый продукт Prism Pro, расширяющий Prism (теперь — Prism Element), в том числе сервисами оценки и предсказания потребности в ресурсах (месте, ядрах CPU, RAM или нодах кластера), настраиваемыми дашбордами, и пр.

- Возможность поменять на живой системе уровень Replication Factor (FTT)

- Application-consistent Snapshots

Итак, на днях в планах у нас выкатить в продакшн новый релиз, 4.7, затем, в начале осени — 4.8. Следующее большое изменение, которое, вероятнее всего, станет «5.0» мы ожидаем в первом квартале 2017 года.

В этом, а также в ближайшем следом, 4.8, релизе у нас появятся:

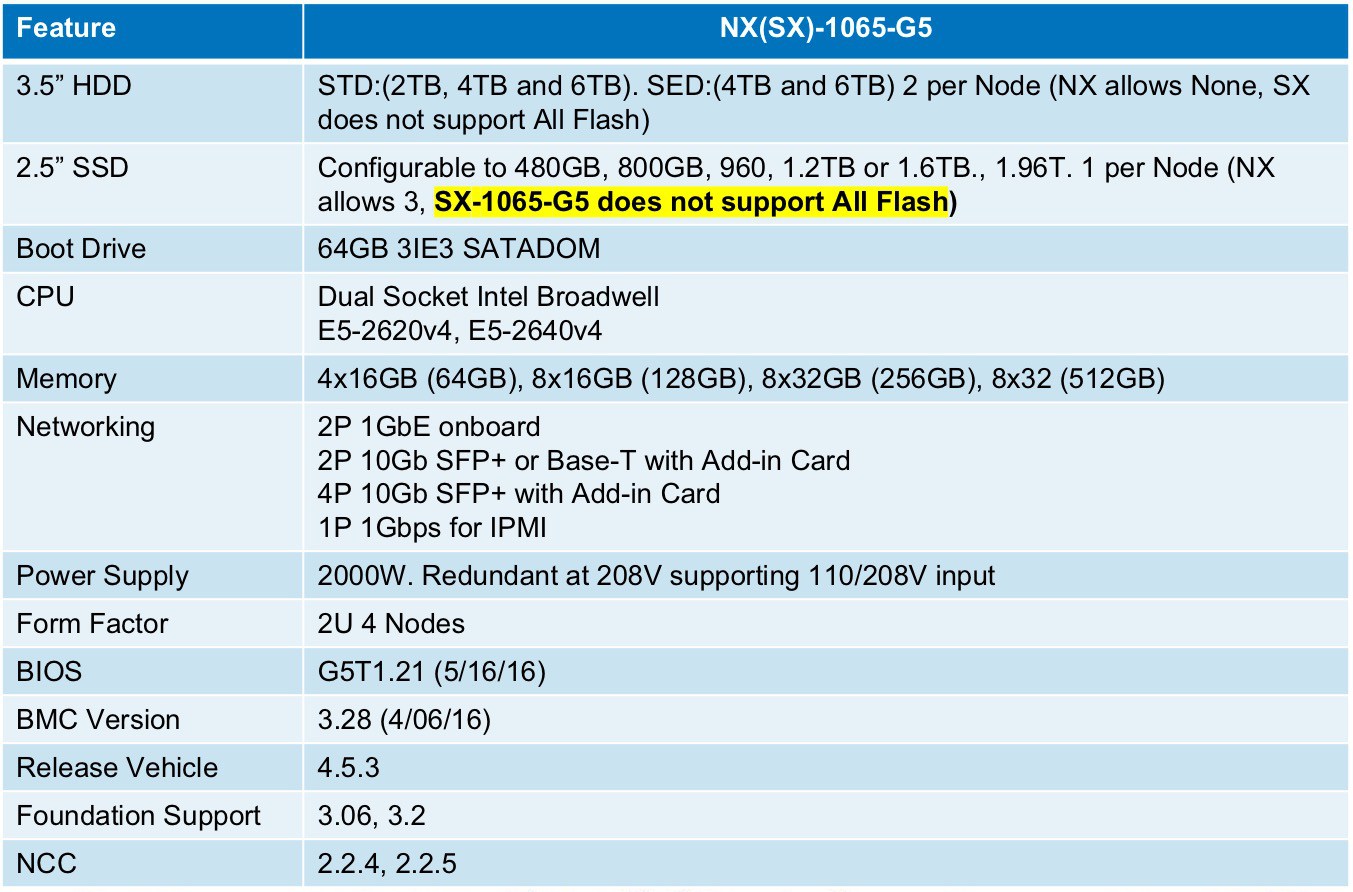

Поддержка аппаратного обновления платформы и переход на Intel Broadwell, который завершится у нас до конца лета, и, примерно, в тех же временных рамках, пройдет и у наших OEM-партнеров, Dell и Lenovo. Это будет наша Generation 5 (G5) линейка платформ.

Поддержка нашей Special Edition-версии для SMB-пользователей, SX-1065/Xpress.

ABS — Acropolis Block Services — фича, позволяющая использовать пространство на объеме кластера Nutanix для подключения сторонних физических хостов «снаружи», например, в случае, если какие-то отдельные приложения не поддерживают работу под гипервизором, и не могут быть мигрированы в среду кластера нод Nutanix, либо ограничения по лицензированию (а также их цена, пример — Oracle DB), препятствуют переходу в Nutanix.

Начиная с версии 4.5 у нас уже тестировался этот механизм, а форме так называемых Volume Groups, блочных разделов, доступных изнутри Nutanix, размещенным в нем VM, подключающимся к ним с помощью iSCSI. Это позволяет организовать работу тех OS и приложений, которым нужен блочный доступ к дискам (пример: MS Exchange, quorum disk в MSCS). Теперь такое подключение к хранилищу по блочному протоколу iSCSI возможно и для сторонних хостов.

Еще про ABS было на днях тут: http://blog.in-a-nutshell.ru/abs-acropolis-block-service/

Дальнейшее развитие и улучшение AFS — Acropolis File Services — то есть использование пространства на кластере Nutanix как NAS-сервиса, например, для высоконадежного, распределенного хранения пользовательских файлов (пример: домашние папки и пользовательские профили в VDI-системе). Среди этих новых фич в AFS — поддержка TRIM, облегчающая высвобождение пространства после удаления файлов, и «утоньшение» хранилища, улучшение производительности, постепенное добавление разнообразных фич SMB 2.1

На сегодня AFS пригодно для размещения файловых сервисов с числом хранимых файлов около 10 миллионов на ноду, что, наряду с неограниченным числом нод в кластере, позволяет использовать Nutanix как весьма масштабный файловый сторадж, например, для HPC применений.

Решение для ситуации «плохо работающей ноды», ее т.н. degraded state. Сейчас у Nutanix ситуация, когда нода в кластере «работает, но криво» (сбои памяти, исправляемые ECC, «мерцающие» отказы оборудования, деградация SSD и пр.) потенциально может вызвать проблемы снижения работоспособности для кластера в целом. Если бы она отказала полностью, то, ОК, мы ее «выводим из обращения», и проблема уходит вместе с ней. Но вот ситуация когда «вроде живая, но как-то плохо живая» автоматически не обрабатывалась. Сейчас у нас будет подобное поведение отслеживаться, и, на основании автоматически назначаемых «баллов» мы можем обнаруживать такие ноды, и принимать к ним автоматические «оргвыводы» на уровне OS, например, автоматически выводить с нее VM и уведомлять админа, как самое простое и очевидное.

Продолжает развиваться Acropolis Hypervisor, наш собственный, бесплатный для пользователей гипервизор, основанный на коде Linux KVM. В ближайших релизах появится (долгожданный) DRS (Dynamic Resource Scheduler), а также добавлены affinity и anti-affinity rules.

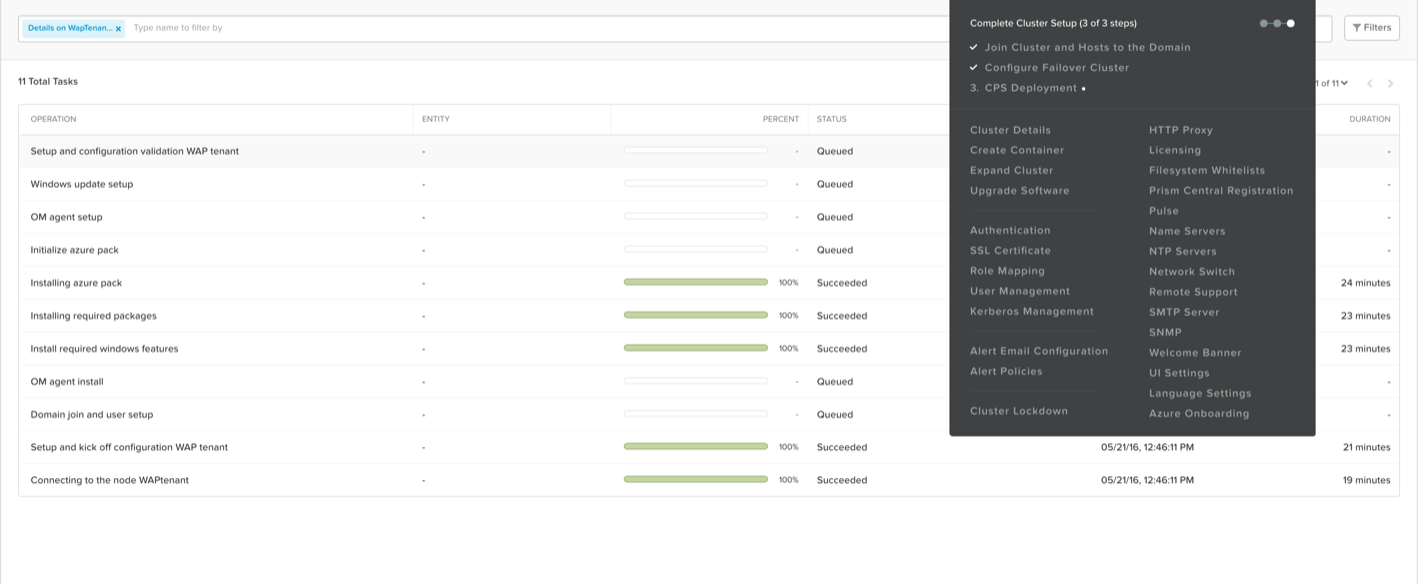

В релизе 4.7 для поддержки развертывания Azure Pack для Hyper-V на Nutanix будет включен наш, разработанный в сотрудничестве с Microsoft инструмент — CPS Standard.

Azure Pack для Hyper-V это private Azure для вашей инфраструктуры на Hyper-V, портал самообслуживания, и вот это вот все, к чему вы привыкли, используя Azure в web.

Развертывание Azure Pack до этого релиза было процедурой ручной и довольно продолжительной. Теперь это автоматизировано.

Интеграцию с OpenStack, появившуюся в релизе 4.6 (драйвера для Nova, Cinder, Glance и Neutron), дополнит Nutanix Self-service Portal, который позволит удобнее реализовывать «облако» в multi-tenant инфраструктуре, то есть когда у «облака» на базе Nutanix будет множество разнородных пользователей, например, это может пригодиться для «AWS-подобных» сервис-провайдеров и хостинг-провайдеров, построенных с использованием облачного сервиса. Такие пользователи сервиса, будучи изолированными друг от друга, смогут самостоятельно разворачивать на выделенных ресурсах контейнеры для данных, создавать виртуальные машины из каталога шаблонов, интегрировать полученную инфраструктуру в частные и гибридные облака.

Nutanix начинает поддерживать Docker в нашем Acrpolis Container Services. Это решение разработано для того, чтобы вы могли полноценно развертывать и использовать Docker в среде кластера Nutanix.

Про работу и поддержку Docker в Nutanix я планирую написать отдельную статью. Пока же упомяну, что это разработка включает в себя Acropolis DSF Volume Plugin for Docker и Docker Machine Driver. На видео можно понять, как и что мы сделали.

В 4.7 эти функции доступны только в CLI, но в 4.8 будет готова интеграция в Prism.

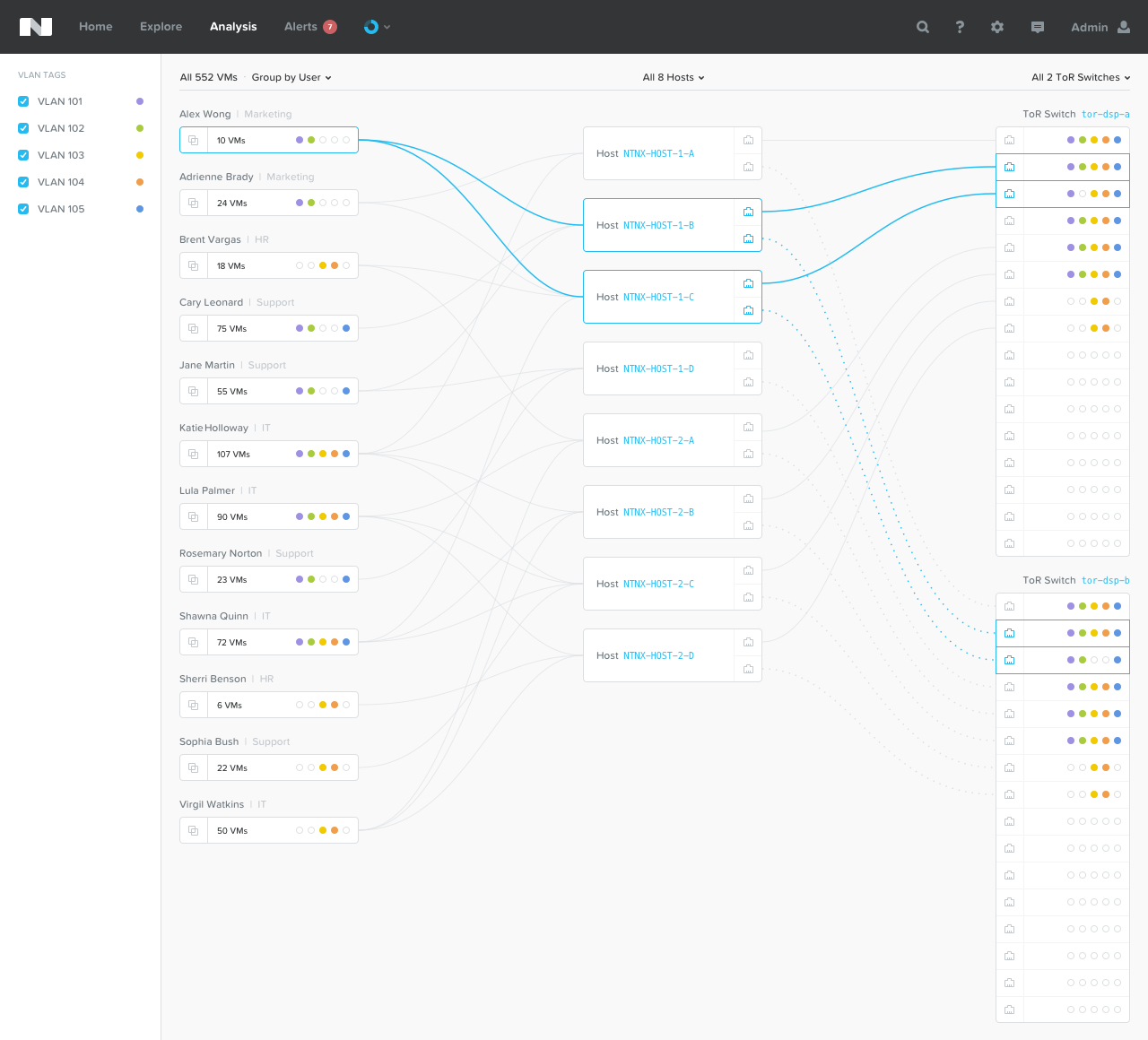

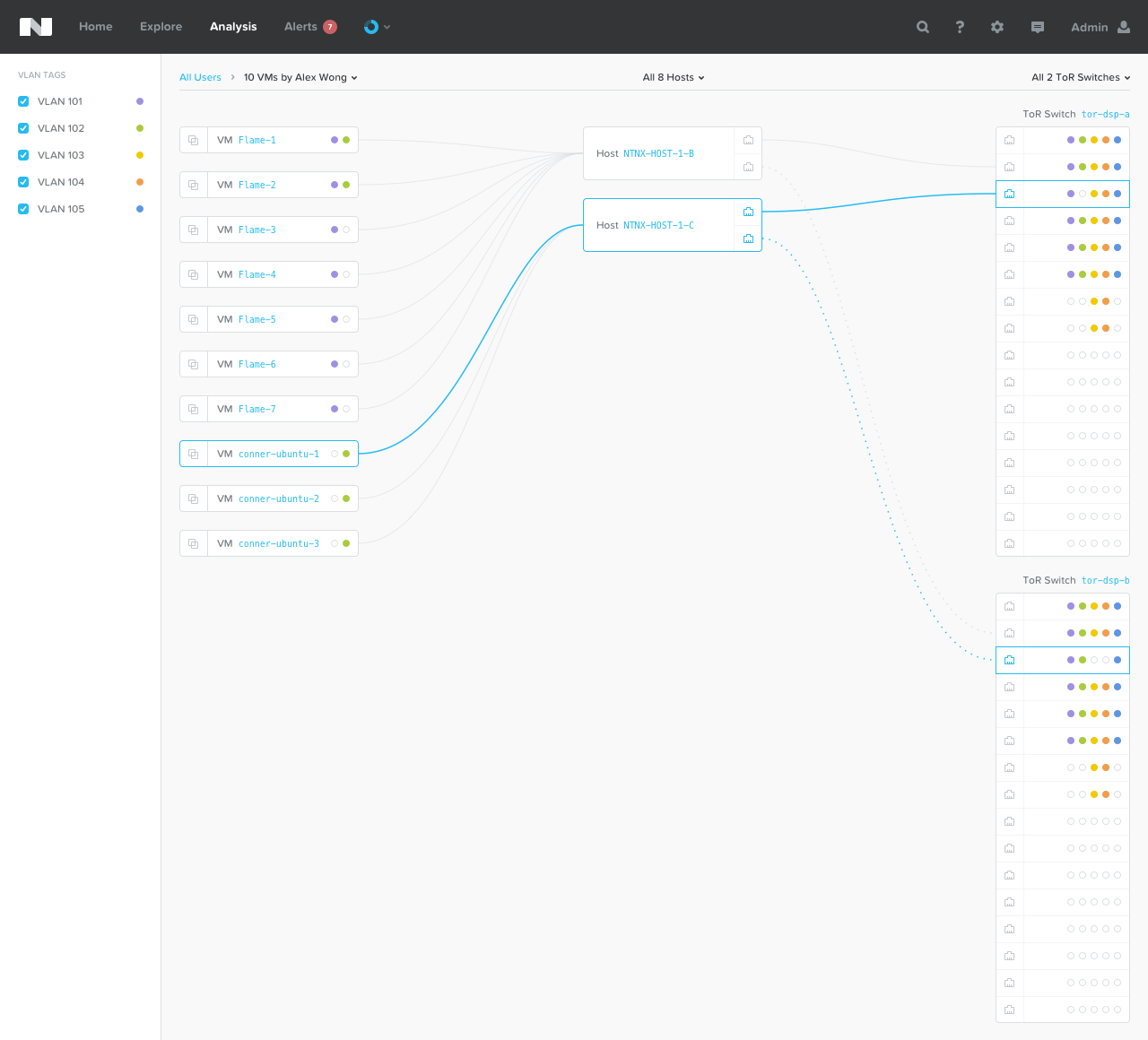

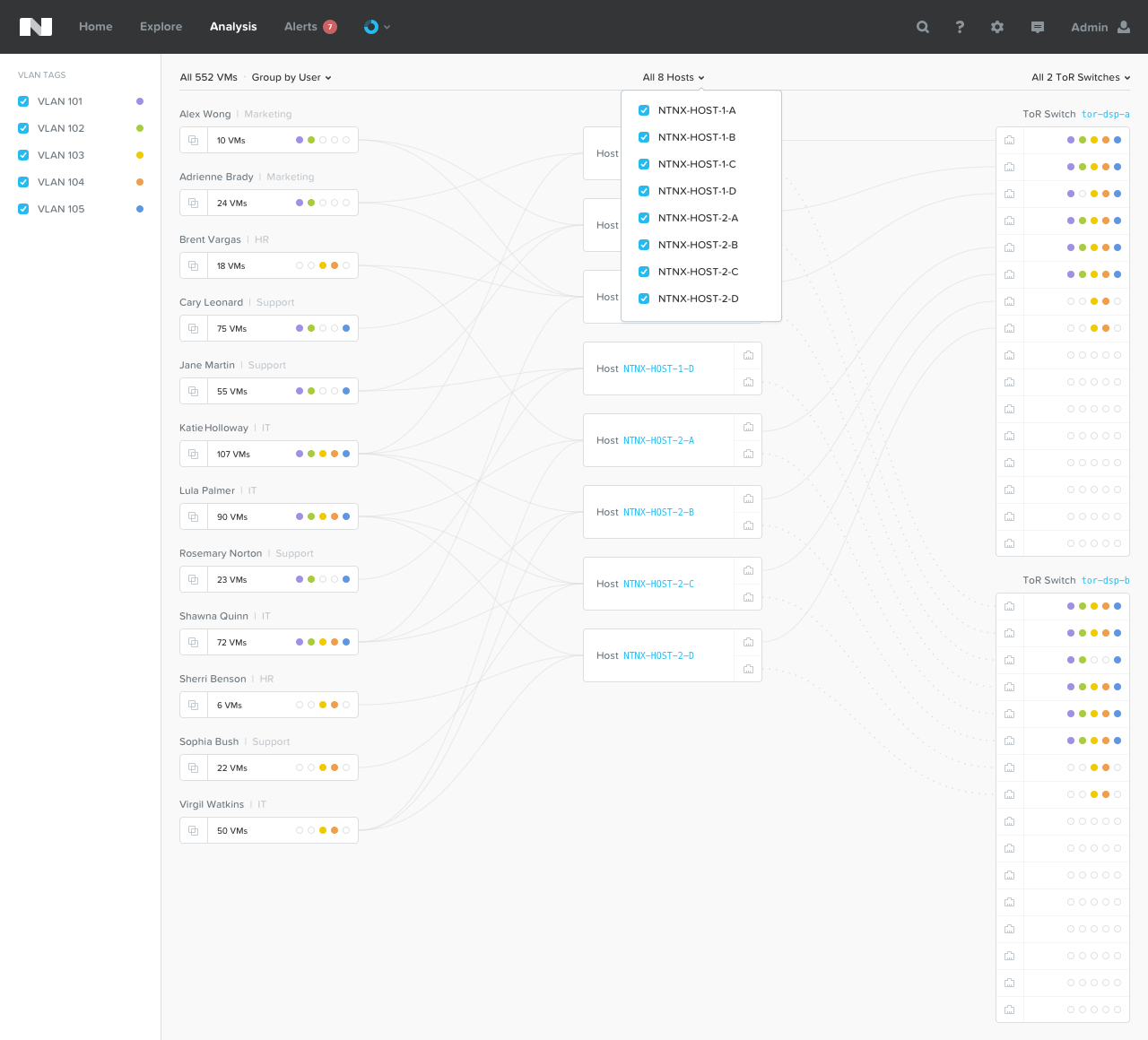

В релизе 4.8 в Prism также будет включена наша система визуализации сетевых соединений в инфраструктуре Nutanix, проще показать, чем описывать, что это:

В систему визуализации будут включены средства диагностики, позволяющие найти проблемы на уровне сети (высокий уровень потерянных пакетов, неверную настройку MTU, конфигурацию VLAN)

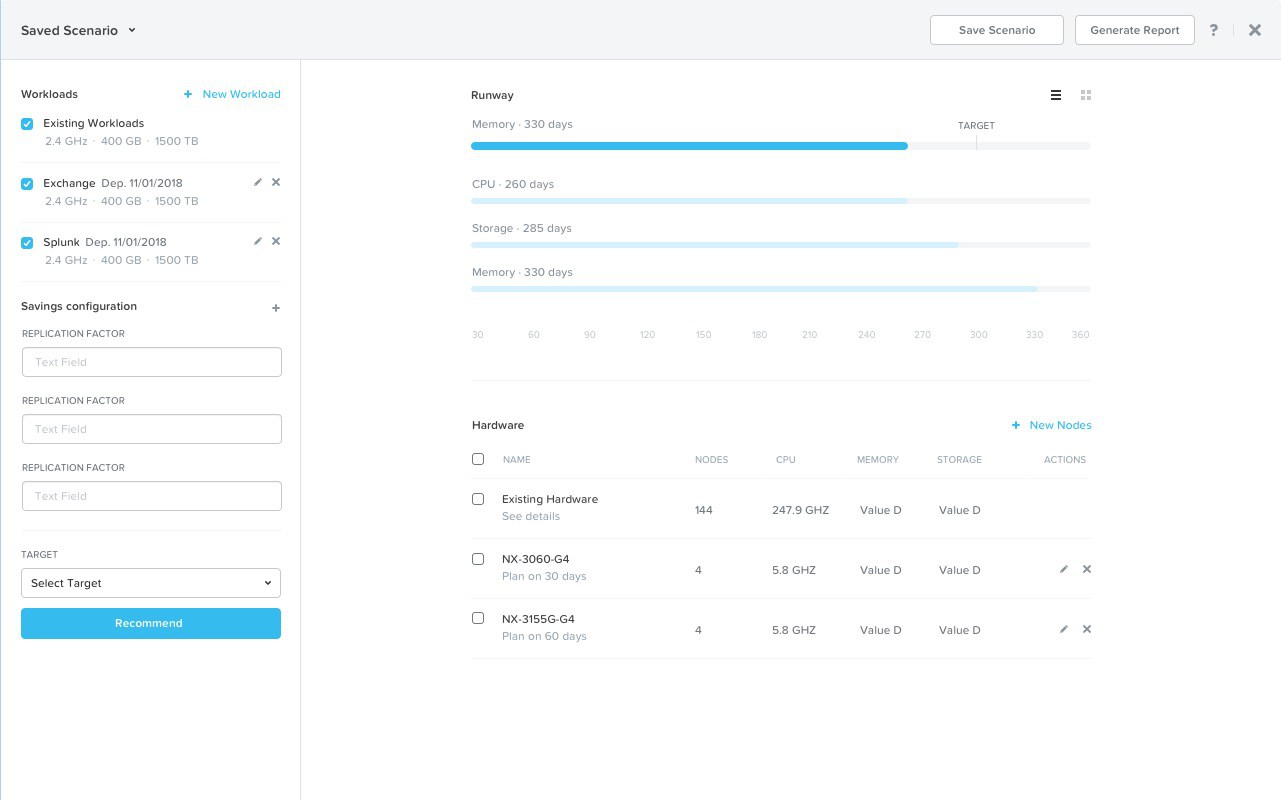

В релизе 4.8 у нас также появится расширенный анализ What-If, позволяющий админу лучше планировать ресурсы. Он поможет дать ответ на вопросы вида «Что, если мы развернем еще 10 копий вот этой VM?» или «Что, если нагрузка на эту базу данных вырастет на 25% в следующем месяце?»

Итак, если у вас уже используется Nutanix, ждите онлайн-обновления через 1-Click, если вы еще раздумываете — обратите внимание на новые и планируемые в ближайшие три месяца фичи.

Автор: Nutanix