Зачем вообще сравнивать медиаконтент?

Каждый день миллионы изображений, видео и аудиофайлов загружаются в интернет. Мы смотрим фильмы, слушаем музыку, листаем соцсети, даже не задумываясь о том, какие алгоритмы стоят за тем, чтобы контент отображался корректно и не повторялся. Но что, если вам нужно сравнивать медиаконтент автоматически? Как понять, одинаковые ли две фотографии, если одна немного темнее? Как сравнить два видео, если они сняты под разными углами? А что делать, если вам нужно найти дубликат аудиофайла, но на одной записи есть шум?

Если эти вопросы вам интересны – добро пожаловать в мир сравнения медиаконтента! Сегодня мы разберем, какие бывают методы, их плюсы и минусы, а главное – расскажем о наших экспериментах, где мы проверили, какие алгоритмы лучше справляются с реальными проблемами.

Наши эксперименты: как проверяли алгоритмы?

Прежде чем говорить о методах, давайте разберем четыре типичных ситуации, с которыми сталкиваются алгоритмы сравнения медиаконтента в реальной жизни:

Видеонаблюдение: меняется экспозиция – если камера снимает в разное время суток или на нее падает свет.

Видеонаблюдение: смещение фото – если кадры сдвигаются из-за движения камеры (например, от ветра).

Аудио: зашумление данных – когда запись содержит фоновый шум, мешающий анализу.

Аудио: изменение тона и фильтрация частот – когда одна и та же запись звучит немного по-разному из-за обработки.

Для каждого сценария мы изменяли исходные данные и проверяли, какие методы справляются лучше всего.

Видеонаблюдение: что делать, если меняется освещение?

Как проводился эксперимент?

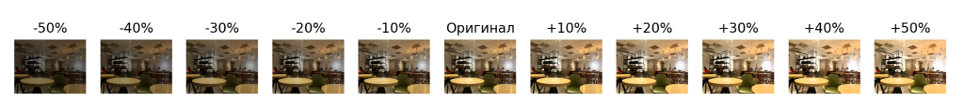

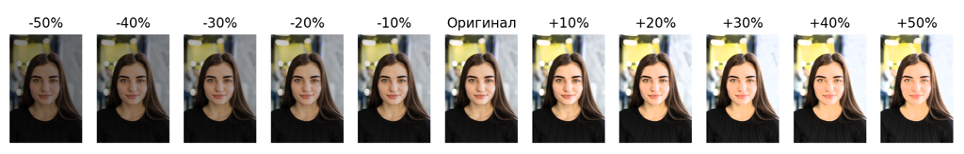

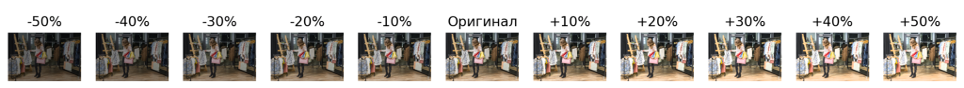

Мы взяли несколько кадров с видеокамер и искусственно изменяли их экспозицию на ±50% с шагом в 10% (то есть, делали картинку темнее или светлее). Затем сравнивали измененные версии с оригиналом.

Какие алгоритмы справились лучше?

-

Гистограммы – плохо, так как освещение сильно меняло распределение цветов.

-

Попиксельное сравнение – полностью провалилось, так как изменение яркости ломает этот метод.

-

ORB, SIFT – показали средний результат: если изменения были небольшими, то метод работал, но при изменении яркости более чем на 30% точность падала.

-

CLIP, ResNet – оказались лучшими, так как понимали, что объекты на фото остались теми же.

Вывод

Если вы разрабатываете систему видеонаблюдения, которая должна сравнивать кадры при разном освещении, вам стоит использовать ResNet или CLIP. Классические методы не справятся.

Видеонаблюдение: что делать, если камера дрожит?

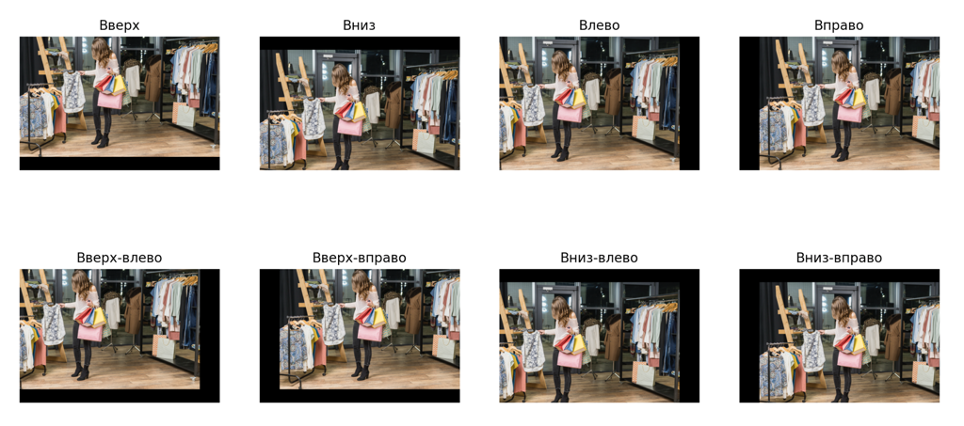

Как проводился эксперимент?

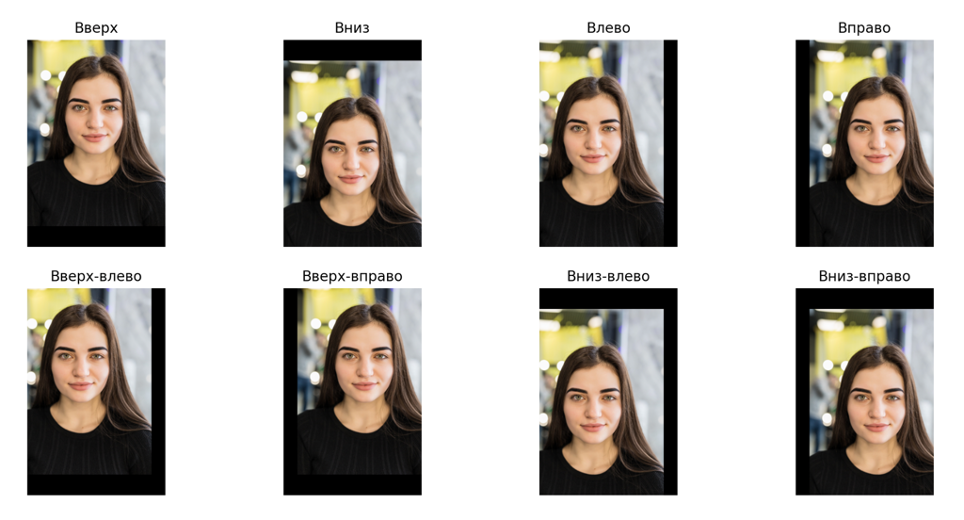

Мы смещали фото в разные стороны (вверх, вниз, влево, вправо и по диагонали) на 10% от его размеров и сравнивали с оригиналом.

Какие алгоритмы справились лучше?

-

Попиксельное сравнение – провалилось, так как сдвиг даже на 1 пиксель делает два изображения совершенно разными.

-

Гистограммы – не сработали, так как учитывают только цвет, а не расположение объектов.

-

ORB, SIFT – показали хороший результат, так как они устойчивы к небольшим сдвигам и поворотам.

-

CLIP, ResNet – тоже сработали, но иногда ошибались, если изображения были сдвинуты и обрезаны.

Вывод:

Если вам нужно сравнивать изображения с возможным сдвигом (например, при дрожащей камере), используйте ORB или SIFT – они намного устойчивее к таким изменениям.

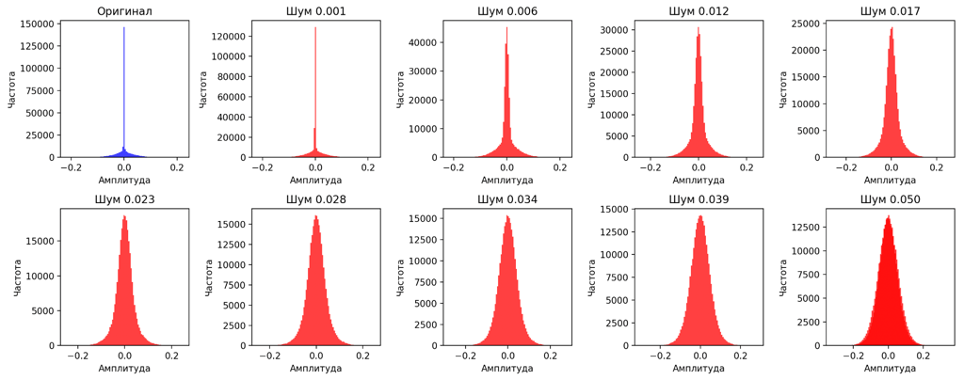

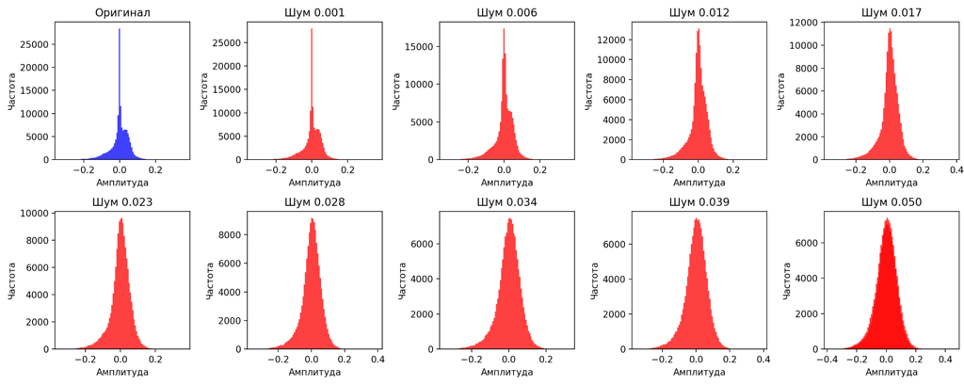

Аудио: что делать, если запись зашумлена?

Как проводился эксперимент?

Мы добавляли в аудиофайл белый шум с увеличением интенсивности от 0.001 до 0.05 и сравнивали с оригиналом.

Какие алгоритмы справились лучше?

-

Кросс-корреляция – показала средний результат: шум влиял на точность.

-

Спектрограмма – работала лучше, так как анализировала частотные характеристики.

-

MFCC – справился хорошо, так как этот метод разработан для работы с голосовыми сигналами и фильтрует шумы.

-

Wav2Vec – лучший результат, так как нейросеть смогла распознать голос, даже если был добавлен шум.

Вывод

Если вам нужно сравнивать зашумленные аудиофайлы, лучше всего использовать Wav2Vec или MFCC, так как они наиболее устойчивы к фоновому шуму.

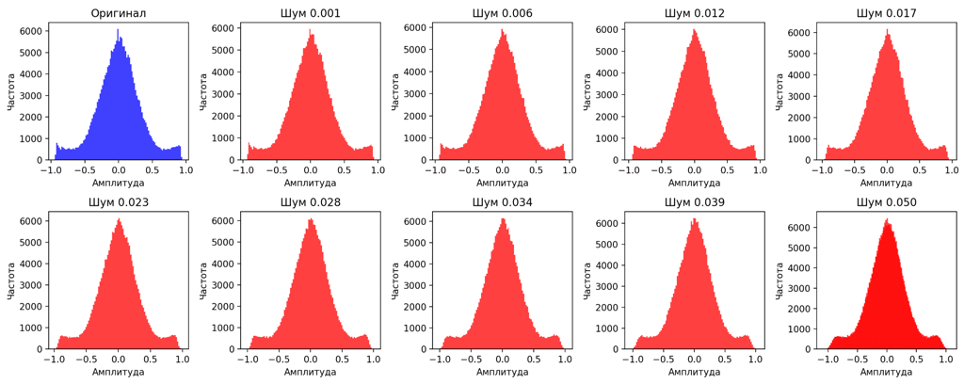

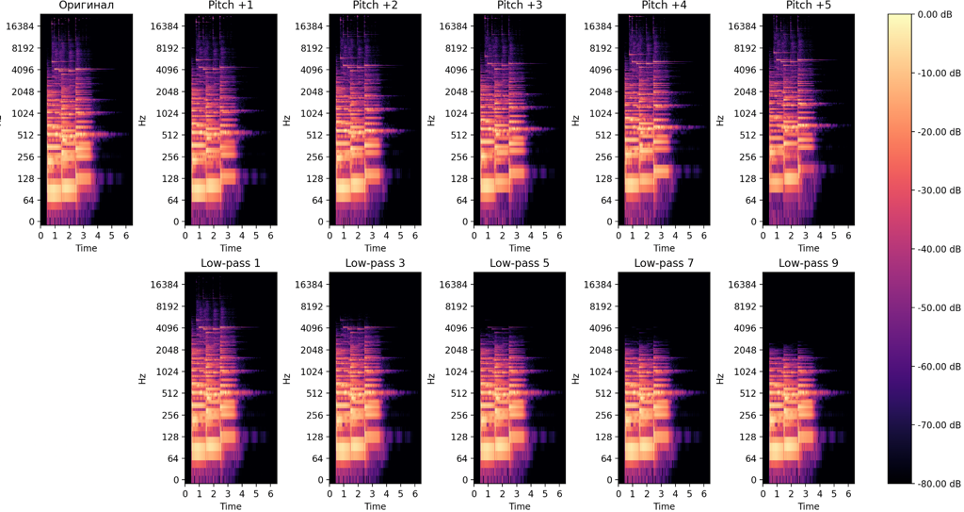

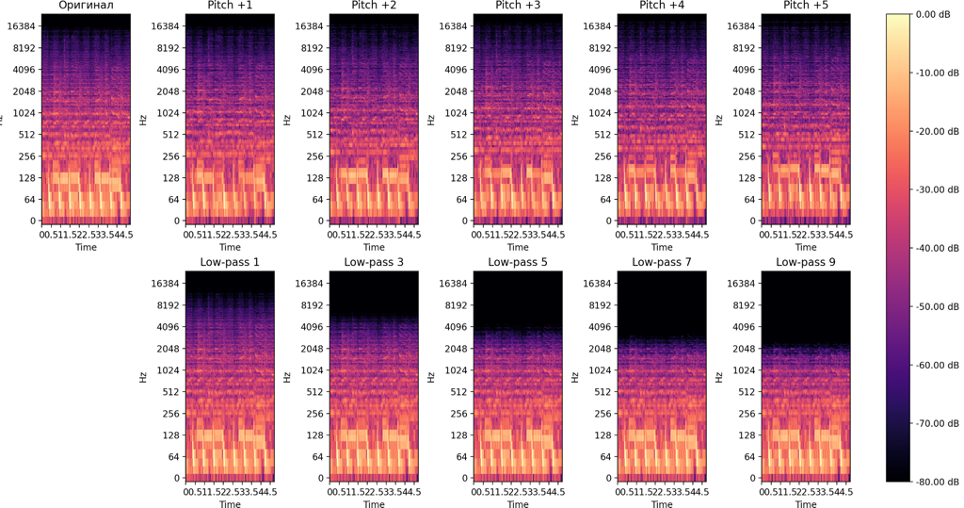

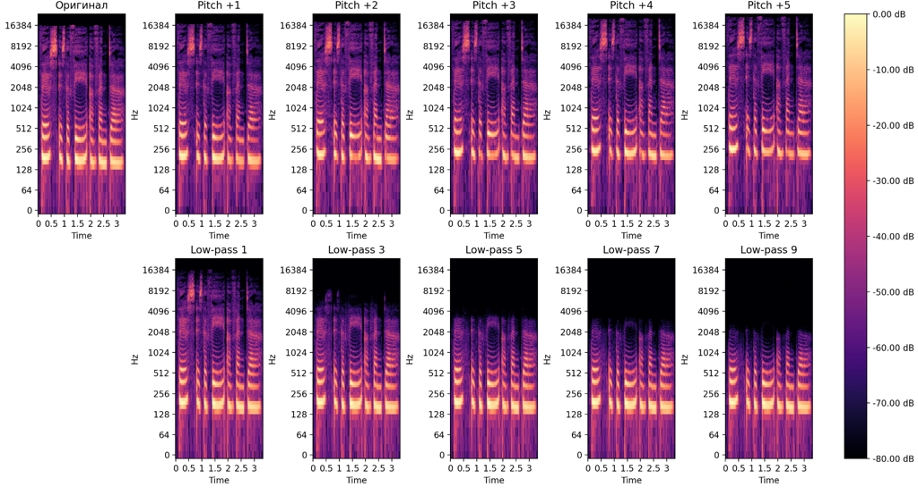

Аудио: что делать, если изменился тон или фильтрация частот?

Как проводился эксперимент?

Мы изменяли высоту звука на ±5 полутонов и применяли низкочастотные фильтры разной интенсивности.

Какие алгоритмы справились лучше?

-

Кросс-корреляция – провалилась, так как любые изменения сильно влияли на схожесть.

-

Спектрограмма – работала, но теряла точность при сильном изменении тона.

-

MFCC – показала хорошие результаты, так как анализировала общий тембр.

-

Wav2Vec – опять лучший результат, так как понимала, что на обеих записях один и тот же голос.

Вывод

Если вам нужно сравнивать аудио с возможными изменениями тона или фильтрации, используйте MFCC или Wav2Vec.

Итоговые рекомендации

|

Сценарий |

Лучшие методы |

|---|---|

|

Изменение яркости (видео) |

CLIP, ResNet |

|

Смещение кадра (видео) |

ORB, SIFT |

|

Зашумление (аудио) |

Wav2Vec, MFCC |

|

Изменение тона (аудио) |

MFCC, Wav2Vec |

Если вам нужно сравнивать медиаконтент в сложных условиях – используйте современные нейросетевые методы. Классические подходы хороши в идеальных условиях, но они ломаются при реальных изменениях.

Хотите попробовать код? Исходники тут

Автор: kudoff