Байесовская статистика — это что-то вроде античного оракула в современном мире данных. Она не просто предсказывает будущее, она делает это с потрясающей уверенностью, опираясь на всё, что знает (или думает, что знает) о прошлом. Представьте себе модель машинного обучения, которая не довольствуется лишь холодными числами и вероятностями, полученными из текущих данных.

Она как опытный инвестор, который всегда держит в уме свой предыдущий опыт, но готов быстро адаптироваться, как только рынок (то есть данные) даёт ему новую информацию. Именно здесь в игру вступают априорные и апостериорные вероятности — два основных инструмента, при помощи которых Байесовский подход разворачивает свою магию.

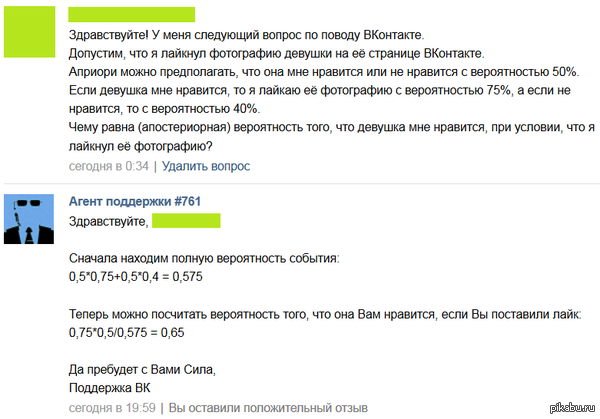

Априорная вероятность — некий изначальный набор гипотез, который может быть основан на знаниях, догадках или статистике. Например, если вы обучаете модель для распознавания мошенничества в финансовых операциях, ваш априор может быть основан на данных предыдущих лет, когда мошенничество составляло, скажем, 5% от общего числа операций.

Но вот наступает момент, когда вы сталкиваетесь с новыми данными, и тут появляется апостериорная вероятность. Это ваше новое, обновлённое представление о мире, которое учитывает уже не только старые догадки, но и свежие факты. Ваше мнение о том, сколько мошеннических операций действительно происходит, корректируется с учётом того, что система наблюдает в реальном времени.

Сущность теоремы Байеса — это постоянное обновление информации. Каждое новое наблюдение влияет на ваше представление о модели мира. Например, представьте, что вы разрабатываете модель для прогнозирования отказов оборудования. Априори вы думаете, что оборудование надёжно и отказы маловероятны.

Но если данные начинают показывать, что отказы происходят чаще, чем вы ожидали, вы корректируете свои апостериорные вероятности и меняете выводы о надёжности системы. Здесь важно понимать, что байесовская модель не просто подстраивается под данные — она активно использует прошлый опыт для принятия более взвешенных решений в будущем. Это делает её более гибкой и адаптивной, чем многие традиционные частотные модели.

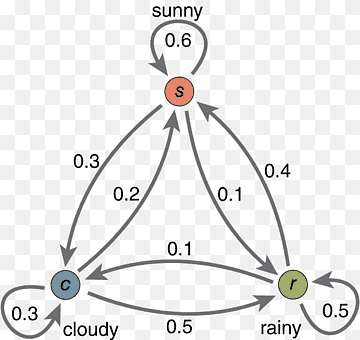

Философия Байеса заключается в том, что вероятность — это не объективная характеристика события, как утверждает частотная школа, а субъективная степень уверенности. Это как если бы вы спорили с друзьями на тему погоды: один из вас уверен, что завтра пойдёт дождь, а другой настаивает на солнечном дне.

В частотной интерпретации вам бы пришлось ждать, пока пройдут сто дней, чтобы узнать среднюю вероятность дождя, тогда как байесовец просто сказал бы: "С учётом всего, что я знаю о погоде в этом регионе, завтра дождь с вероятностью 70%". И это ключевой момент: Байесовская вероятность позволяет делать выводы даже при ограниченном объёме данных, что критически важно в условиях, когда обучение модели происходит в режиме реального времени.

Для машинного обучения это настоящий подарок. Многие задачи требуют, чтобы модель принимала решения, не дожидаясь большого набора данных. Например, в задаче распознавания объектов на изображениях байесовский подход позволяет учесть не только информацию, полученную от текущего изображения, но и опыт обработки предыдущих изображений.

Модель может предполагать, что, если на фотографии есть фрагмент, похожий на кошачий хвост, то и сам объект с высокой вероятностью окажется кошкой — даже если хвост немного размыт. Это и есть истинная сила байесовской модели: использование априорных знаний позволяет ей принимать более обоснованные решения при ограниченных данных.

Частотная интерпретация, напротив, требует наличия огромного количества данных для выведения точных вероятностей. Байесовцы скажут вам, что в реальном мире данных всегда недостаточно, и что лучше иметь какую-то начальную гипотезу, чем полное незнание.

Вот почему байесовские методы так востребованы в задачах, связанных с обработкой сложных многомерных данных, где вариативность столь велика, что невозможно учесть все комбинации без использования априорных знаний.

Например, в задачах, связанных с прогнозированием поведения пользователей в приложениях или анализом данных о медицинских диагнозах, байесовские модели помогают строить более точные прогнозы, комбинируя историческую информацию с текущими наблюдениями.

Выбор априорного распределения в байесовском подходе является не просто технической задачей, а важнейшим концептуальным этапом, который оказывает значительное влияние на структуру и поведение модели.

В отличие от частотных методов, где гипотезы и параметры выводятся исключительно на основе наблюдаемых данных, байесовский метод предполагает наличие предшествующих знаний, представленных априорными распределениями.

Именно эти априорные распределения играют ключевую роль в формировании апостериорных оценок после того, как модель сталкивается с новыми данными. В контексте машинного обучения это означает, что правильный выбор априора может как значительно ускорить обучение и повысить точность модели, так и ввести её в тупик, если априорная информация выбрана неуместно или недостаточно обоснованно.

Начнём с неинформативных априоров. Здесь ваша позиция такова: "Я ничего не знаю и знать не хочу". Это как приходить на переговоры с абсолютно открытыми картами, заявляя, что у вас нет никаких предположений о том, что должно произойти.

В байесовской статистике неинформативные априоры применяются, когда мы сознательно хотим минимизировать влияние предшествующих знаний и дать данным максимальную возможность "говорить за себя". Это, конечно, звучит благородно, но стоит помнить, что неинформативный априор может оказаться и не столь нейтральным, как кажется.

В зависимости от того, какую форму вы ему дадите, он может по-прежнему сильно влиять на апостериорное распределение, особенно при недостатке данных. Например, если вы используете неинформативный априор в задаче классификации, ваша модель может стать чрезмерно осторожной, что замедлит её способность обучаться на новых данных.

Далее идут информативные априоры, где вы начинаете с позиции "Я кое-что знаю и готов этим поделиться". Этот тип априоров особенно полезен в случаях, когда у вас уже есть значительный объём исторических данных или экспертных знаний.

Представьте себе задачу прогнозирования спроса на продукт в новом регионе, но у вас есть данные о схожем продукте в других регионах. Информативный априор здесь поможет модели быстрее адаптироваться к новым условиям, основываясь на уже известных закономерностях.

Однако информативные априоры таят в себе и определённые риски: если ваши предшествующие знания окажутся неправильными или слишком узкими, это может создать систематическую ошибку в ваших апостериорных оценках.

Теперь перейдём к конъюгированным априорам. Если не вдаваться в излишние детали, то конъюгированный априор — это как подобрать идеальный ключ к замку.

Он разработан таким образом, что в результате применения теоремы Байеса апостериорное распределение будет иметь ту же функциональную форму, что и априорное, что делает вычисления более простыми и эффективными.

Это может показаться небольшой технической удобностью, но на практике конъюгированные априоры значительно ускоряют процесс обучения, особенно в больших моделях.

Например, если вы работаете с задачами, связанными с фильтрацией спама в электронной почте, использование конъюгированных априоров позволяет системе быстро адаптироваться к новым типам спама без необходимости пересчёта всей модели.

Неконъюгированные априоры, напротив, представляют собой менее гибкий подход, где апостериорное распределение не совпадает с априорным. Это может усложнить вычисления, требуя использования численных методов для получения апостериорных оценок.

Тем не менее, неконъюгированные априоры могут быть полезны, когда мы сталкиваемся с более сложными и нетривиальными структурами данных, которые не укладываются в рамки простых конъюгированных моделей.

Например, если вы работаете с мультимодальными данными, где априорные предположения не могут быть выражены с помощью одной функции, неконъюгированные априоры дадут вам большую гибкость в моделировании.

Практическое руководство по выбору априорных распределений заключается в том, чтобы внимательно оценить характер задачи и доступные данные.

Если у вас есть большое количество исторических данных или экспертные знания, использование информативных априоров может значительно ускорить процесс обучения модели.

В задачах с малым количеством данных или высокой неопределённостью более уместным будет неинформативный или слабо информативный априор, чтобы не перегружать модель избыточными гипотезами. В случае, когда важна эффективность вычислений, стоит обратить внимание на конъюгированные априоры, которые сохраняют простоту и гибкость, не усложняя расчёты.

Выбор априорного распределения — это тонкий баланс между интуицией, опытом и прагматизмом. Как и в любом хорошем проекте, ключевое слово здесь — адаптивность.

Байесовские модели позволяют вам не просто учиться на данных, но и эволюционировать вместе с ними, и это то, что отличает байесовский подход от более жёстких частотных методов.

И наконец, всегда помните, что ваш априор — это не догма, а начальная гипотеза, которая может и должна изменяться под влиянием новых данных.

Апостериорное распределение представляет собой ключевую компоненту байесовского подхода, отражающую обновленное состояние знаний после получения данных. Фактически, оно комбинирует априорную информацию с новыми наблюдениями, формируя распределение, которое служит основой для последующих выводов, прогнозов и принятия решений.

Однако вычисление апостериорных распределений, особенно в сложных моделях машинного обучения, является задачей далеко не тривиальной, требующей как теоретической подкованности, так и понимания особенностей алгоритмических методов.

В зависимости от структуры модели, количества данных и вычислительных ресурсов, доступных в конкретной задаче, разработчику необходимо выбирать между различными подходами, включающими аналитические методы и численные приближения, такие как марковские цепи Монте-Карло (MCMC), вариационные методы и гибридные техники.

Аналитическое нахождение апостериорных распределений, как правило, возможно только в узком круге задач, где существует строгая математическая структура, позволяющая выразить апостериорное распределение в закрытой форме.

Типичным примером таких ситуаций является использование конъюгированных априоров, где априор и апостериорные распределения принадлежат одному и тому же семейству распределений. Это упрощает не только вычисления, но и интерпретацию результатов.

Однако подобные модели, несмотря на свою элегантность, редко встречаются в реальных задачах машинного обучения. Проблемы высокой размерности данных, сложные зависимости между переменными и нелинейные структуры вносят значительные усложнения, что делает применение чисто аналитических методов нецелесообразным. Поэтому в большинстве случаев приходится полагаться на численные методы вычисления апостериорных распределений.

Один из наиболее распространённых численных методов — это метод марковских цепей Монте-Карло (MCMC), который представляет собой семейство алгоритмов, использующих случайные выборки для приближения апостериорного распределения.

Суть MCMC заключается в том, что вместо того, чтобы пытаться вычислить апостериорное распределение напрямую (что часто невозможно), создаётся марковская цепь, которая "гуляет" по пространству параметров модели, постепенно приближаясь к истинному апостериорному распределению.

Методы MCMC, такие как метод Метрополиса-Гастингса и алгоритм Гиббса, являются мощными инструментами для работы с высокоразмерными пространствами параметров и сложными апостериорными распределениями, но они имеют свои ограничения.

В частности, скорость сходимости марковской цепи и вычислительная сложность делают данный подход затратным в контексте реальных приложений.

Проблемы смешивания цепи и её "прилипание" к локальным максимумам также могут усложнить использование MCMC на практике, что делает этот метод не всегда подходящим для моделей с большим количеством параметров или сложными априорными предположениями.

Альтернативным подходом является использование вариационного вывода, который предлагает более детерминированную и вычислительно эффективную аппроксимацию апостериорного распределения.

В отличие от MCMC, где строится выборка, вариационный метод формулирует задачу оптимизации: апостериорное распределение аппроксимируется более простой функцией, а задача сводится к минимизации дивергенции между аппроксимацией и истинным апостериорным распределением.

Этот подход позволяет значительно ускорить вычисления, что особенно важно при работе с большими наборами данных и сложными моделями, такими как вариационные автоэнкодеры и байесовские нейронные сети.

Однако основной недостаток вариационного вывода заключается в том, что аппроксимация может быть слишком грубой, что приводит к потерям важной информации о структуре апостериорного распределения. Вариационный вывод также чувствителен к выбору семейства аппроксимирующих функций, и неверный выбор может существенно повлиять на качество получаемых решений.

Сравнивая эти методы, можно выделить несколько ключевых аспектов. MCMC обеспечивает более точную аппроксимацию апостериорного распределения, но это достигается ценой значительных вычислительных затрат.

В контексте задач, где важны точные прогнозы и апостериорные оценки, такие как медицинская диагностика или финансовое моделирование, использование MCMC может быть оправданным, несмотря на его ресурсоёмкость.

Вариационные методы, напротив, жертвуют точностью ради скорости, что делает их более подходящими для задач, где время является критическим фактором, например, в приложениях, связанных с онлайн-обучением или системах реального времени.

Существует также ряд гибридных методов, комбинирующих элементы MCMC и вариационного вывода. Например, стохастический вариационный вывод (SVI) объединяет идею стохастической оптимизации с вариационными методами, что позволяет одновременно достигать как скорости, так и приемлемой точности.

Другие подходы используют гибридные модели, в которых вариационные методы используются для инициализации марковских цепей, что ускоряет их сходимость. Такие гибридные решения всё чаще применяются в современных задачах машинного обучения, особенно в тех случаях, где требуется баланс между вычислительной эффективностью и качеством апостериорных оценок.

Таким образом, выбор метода вычисления апостериорных распределений определяется целым рядом факторов: сложностью модели, количеством данных, доступными вычислительными ресурсами и требованиями к точности. Для разработчиков уровня senior, работающих в области машинного обучения, важно не только понимать различия между этими методами, но и уметь адекватно оценивать их применимость в зависимости от конкретных сценариев.

А теперь о нейросетях…

Байесовские методы в задаче классификации: Наивный Байесовский классификатор и его вариации

Этот метод базируется на теореме Байеса, но с весьма упрощенной предпосылкой: все признаки условно независимы друг от друга, если известен целевой класс.

В реальных данных условная независимость редко является абсолютной, но это допущение открывает возможности для использования байесовской вероятности в вычислениях, делая алгоритм относительно быстрым и производительным. Наивный байесовский классификатор представлен в нескольких основных вариациях, каждая из которых адаптирована для работы с различными типами данных и базируется на уникальных предположениях о распределении.

Мультиномиальный наивный байес ориентирован на работу с дискретными данными, как в задачах классификации текста, где векторы частот слов представляют собой основу для вероятностной оценки. Примером может служить классификация электронных писем: обученная наивная модель способна классифицировать сообщения как спам или не-спам, опираясь на частоту встречаемости определённых слов.

Именно мультиномиальная модель используется при моделировании дискретных событий, таких как словоформы в документах, что делает её оптимальным выбором для анализа текстов и классификации сообщений.

Гауссовская версия наивного байесовского классификатора, напротив, предполагает, что признаки распределены нормально, и чаще всего применяется для классификации данных с непрерывными значениями. К примеру, классификация данных о физиологических характеристиках пациентов в медицинских исследованиях может использоваться гауссовской моделью для предсказания диагнозов на основе метрик, таких как возраст, вес или уровень холестерина.

Данное предположение о нормальности распределения значительно упрощает вычисления и делает метод интуитивно понятным и легко интерпретируемым. Однако в случаях, когда распределение данных заметно отличается от нормального, результаты гауссовского классификатора могут быть менее точными.

Бернуллиевский наивный байес представляет собой ещё одну версию метода, которая предполагает бинарное представление признаков. Этот классификатор разработан для работы с признаками, которые принимают только два значения, и может быть эффективен, когда анализируется присутствие или отсутствие определённых характеристик.

В задачах анализа текста бернуллиевский классификатор определяет, содержит ли документ определенное слово, что может быть полезно, когда частота встречаемости не столь важна, а акцент делается на самом факте наличия определенных признаков. Он особенно удобен для анализа бинарных данных в условиях, где присутствие признаков несет больше смысла, чем их количество, например, в классификации коротких текстов или документов по категориям.

Пример кода, иллюстрирующий процесс применения мультиномиального наивного байесовского классификатора для задачи классификации текстов, может быть представлен следующим образом:

|

from sklearn.feature_extraction.text import CountVectorizer texts = ["положительный отзыв о продукте", "отрицательное мнение", "хороший отзыв", "критический анализ"] vectorizer = CountVectorizer() model = MultinomialNB() |

В этом примере реализуется базовый мультиномиальный наивный байесовский классификатор, который преобразует текстовые данные в частотные векторы и применяет вероятностный подход к классификации на основе условной вероятности класса.

Предположение независимости признаков, которое является основой метода, делает его чувствительным к случаям, когда признаки взаимозависимы или проявляют сильные корреляции. Классификатор может выдавать ложные предсказания в тех случаях, когда характер данных противоречит основной предпосылке условной независимости.

Тем не менее, даже в условиях, где допущение независимости нарушено, наивный байесовский классификатор способен выдавать достаточно приемлемые результаты, что обусловлено его относительно низкой вычислительной сложностью и простотой реализации.

Регуляризация и байесовские методы в линейной регрессии

В отличие от традиционных методов, таких как Lasso и Ridge, которые добавляют штрафы к функциям потерь и таким образом регулируют величину коэффициентов регрессии, байесовская линейная регрессия рассматривает параметры как случайные величины и встраивает их неопределенность в сам процесс моделирования.

Данный подход позволяет модели учитывать априорные знания о параметрах, что особенно полезно, когда у нас есть предположения относительно возможных значений коэффициентов регрессии. Это не только улучшает устойчивость модели, но и помогает избежать переобучения, привлекая концепцию регуляризации как неотъемлемую часть байесовской формализации.

Предположим, что в задаче линейной регрессии требуется предсказать значение целевой переменной как линейную комбинацию признаков.

В классической линейной регрессии минимизация функции потерь, обычно квадратичной, приводит к определению параметров модели.

Однако в байесовском подходе мы предполагаем априорное распределение параметров, которое интегрируется с данными в процессе вычисления апостериорных распределений, позволяя параметрам оставаться адаптивными.

Например, часто используются нормальные априорные распределения для весов, так как они предоставляют возможность вводить слабые или сильные предположения о параметрах. Эти априорные распределения вводят структурированную неопределенность в модели, позволяя учитывать потенциальные вариации весов без фиксированных значений.

Чтобы продемонстрировать, как байесовская линейная регрессия решает задачу, рассмотрим пример кода, использующего априорные распределения для весов в линейной модели:

|

import numpy as np # Создание синтетических данных # Инициализация байесовской линейной регрессии # Предсказание и оценка модели |

В этом примере BayesianRidge реализует байесовскую линейную регрессию, в которой веса параметров рассматриваются как случайные величины с нормальными априорными распределениями. Этот подход вводит регуляризацию через априорные предположения о значениях весов, влияя на их апостериорные оценки на основе данных. Примечательно, что апостериорные распределения параметров позволяют оценить неопределенность для каждого параметра, давая более детальное представление о значимости признаков, чем традиционные методы.

Пример также иллюстрирует ключевое преимущество байесовской регуляризации — возможность интерпретировать модель и параметры в терминах вероятностей.

Поскольку апостериорные распределения могут указывать на степень неопределенности в весах, байесовская линейная регрессия более гибка и способна точнее оценивать влияние признаков, что особенно полезно в условиях ограниченных данных или мультиколлинеарности.

В сравнении с методами, такими как Lasso и Ridge, которые накладывают жесткие штрафы на коэффициенты, байесовская линейная регрессия позволяет параметрам принимать разные значения с разной вероятностью, в зависимости от априорных предположений.

Этот подход более естественно учитывает неопределенность, делая модель менее подверженной переобучению. Традиционная регуляризация находит компромисс между сложностью модели и точностью, но игнорирует вероятностную природу параметров, что в некоторых случаях ведет к субоптимальным решениям, тогда как байесовский подход учитывает эту неопределенность в параметрах на всех этапах моделирования.

Байесовские нейронные сети: принцип работы и преимущества

Байесовские нейронные сети представляют собой один из наиболее изящных (и немного эксцентричных) методов борьбы с переобучением и учета неопределенности в сложных моделях, как бы намекая, что каждая из весовых связей в сети — не просто значение, а своего рода шанс, вероятность.

В этом байесовском подходе веса сети рассматриваются не как фиксированные коэффициенты, а как случайные переменные с априорными распределениями.

В результате, вместо того чтобы просто пытаться запомнить данные, сеть, скорее, стремится понять их через вероятностные связи, что позволяет избежать зазубривания каждого отдельного тренировочного примера и удерживает сеть от неконтролируемого роста сложности.

Основной принцип работы байесовских нейронных сетей заключается в рассмотрении весов как вероятностных распределений, где обучение предполагает обновление этих распределений на основе данных.

Как только мы определяем априорное распределение, например, на веса сети, апостериорное распределение рассчитывается с учетом наблюдаемых данных, что делает вывод более гибким и позволяет захватывать вариативность в данных.

Этот подход обеспечивает возможность моделировать неопределенность напрямую — будь то параметры модели или прогнозы, что часто является жизненно важным для практических приложений, где понимание возможных ошибок столь же важно, как и сами прогнозы.

Одним из популярных методов для создания байесовских нейронных сетей является использование dropout как аппроксимации байесовского вывода. Да, вы не ослышались — старый добрый dropout, оказывается, не только эффективен как регуляризатор, но и приближает вероятностный вывод, если его рассматривать как метод Монте-Карло.

Каждый раз, когда мы выключаем случайные нейроны в слое, мы по сути делаем выборку из возможного распределения весов сети. Классический трюк, но с байесовским твистом, который позволяет избежать переобучения и сохраняет информативность вывода, не теряя при этом эффективность. Это можно реализовать буквально в пару строк кода:

|

import torch class BayesianNeuralNetwork(nn.Module): def forward(self, x): # Пример использования |

В этом примере мы используем dropout для того, чтобы получать различные варианты вывода на каждой итерации, фактически создавая байесовский ансамбль. Однако стоит помнить, что использование dropout как байесовского метода является приближением, и для более точного байесовского вывода можно применять вариационные методы.

Вариационные методы — еще один мощный инструмент, когда мы говорим о полномасштабных байесовских нейронных сетях. В этом подходе вместо того чтобы рассчитывать апостериорное распределение напрямую, мы аппроксимируем его с помощью так называемого вариационного распределения, что позволяет существенно снизить вычислительные затраты.

Например, вариационный метод вывода может быть полезен, когда мы работаем с архитектурами, содержащими миллионы параметров, так как позволяет оценивать апостериорные распределения весов более эффективно.

В отличие от детерминированных сетей, байесовские нейронные сети на вариационном выводе могут вычислять доверительные интервалы на основе вероятностной природы весов, что повышает интерпретируемость и позволяет оценить, насколько надежны предсказания модели для каждого конкретного примера.

Смешной парадокс заключается в том, что такие сложные байесовские модели, требующие значительных вычислительных ресурсов, возвращают нас к основам неопределенности. Они напоминают, что любая "уверенность" нейронной сети в своей правоте — это иллюзия: модель всегда работает в условиях неопределенности.

Конечно, байесовский подход не идеален и требует затрат на вычисления, что делает его применение не всегда целесообразным в реальных задачах.

Но когда вопрос стоит о моделировании риска или принятии решений на основе вероятностей, байесовские нейронные сети выигрывают в гонке благодаря своему подходу к регуляризации, интегрированному в основу вычислений.

Байесовская оптимизация гиперпараметров в машинном обучении

Основной принцип здесь — не жадный перебор, а изящное лавирование между возможностями модели и структурой данных. Байесовская оптимизация стремится минимизировать количество необходимых запусков модели, подбирая гиперпараметры так, чтобы сократить как временные, так и вычислительные затраты — вещь, о которой многим ML-разработчикам стоит только мечтать, ведь кто из нас не знает чувство, когда ожидаешь конца grid search после сотен неудачных конфигураций.

Итак, как работает эта методика? Байесовская оптимизация строит аппроксимацию функции потерь (или функции качества) как вероятностную модель, принимая в расчет результаты предыдущих экспериментов. То есть на каждом шаге метод не просто берет очередную случайную комбинацию гиперпараметров, а использует предыдущие наблюдения, чтобы «предсказать», где в гиперпараметрическом пространстве стоит искать оптимум.

Как правило, для этого используется гауссовский процесс, что позволяет строить модель функции потерь в виде распределения, а не единственного значения, заодно напоминая нам, что каждая гипотеза — всего лишь вероятность, а не железобетонное утверждение.

Для иллюстрации того, как это работает на практике, можно посмотреть код, который использует библиотеку skopt, что отлично демонстрирует разницу подходов:

|

from skopt import BayesSearchCV # Загружаем данные и создаем модель # Гиперпараметры и их диапазоны для байесовской оптимизации # Оптимизируем гиперпараметры |

Здесь мы используем BayesSearchCV, который подобен старому-доброму GridSearchCV, но с тем важным отличием, что за каждым запуском скрывается статистическая магия гауссовских процессов.

Каждый следующий запуск модели использует апостериорное распределение вероятности для выбора наилучшего набора гиперпараметров, сокращая общее количество итераций и не заставляя вас часами ждать, пока вся инфраструктура поймет, что n_estimators=50 оказался вполне достойным.

Чем же байесовская оптимизация лучше традиционных методов вроде grid и random search? Она максимально эффективно использует данные о предыдущих запусках для оценки новых, что значительно сокращает затраты ресурсов.

Например, в случайных поисках мы можем в буквальном смысле бесконечно долго искать идеальную точку, тогда как байесовская оптимизация сосредоточится на тех участках пространства гиперпараметров, где, с высокой вероятностью, и находится оптимум. В крупных проектах, таких как настройка гиперпараметров в моделях глубокого обучения, когда каждый запуск требует многочасовых тренировок, байесовский подход может стать тем самым спасительным якорем в море вычислительных затрат.

Автор: The-Founder-1