В одном из предыдущих постов мы обсудили, пожалуй, центральное понятие в анализе данных и проверке гипотез — p — уровень значимости. Если мы не применяем байесовский подход, то именно значение p — value мы используем для принятия решения о том, достаточно ли у нас оснований отклонить нулевую гипотезу нашего исследования, т.е. гордо заявить миру, что у нас были получены статистически значимые различия.

Однако в большинстве статистических тестов, используемых для проверки гипотез, (например, t — тест, регрессионный анализ, дисперсионный анализ) рядом с p — value всегда соседствует такой показатель как число степеней свободы, он же degrees of freedom или просто сокращенно df, о нем мы сегодня и поговорим.

Степени свободы, о чем речь?

По моему мнению, понятие степеней свободы в статистике примечательно тем, что оно одновременно является и одним из самым важных в прикладной статистике (нам необходимо знать df для расчета p — value в озвученных тестах), но вместе с тем и одним из самых сложных для понимания определений для студентов — нематематиков, изучающих статистику.

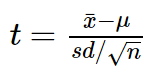

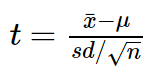

Давайте рассмотрим пример небольшого статистического исследования, чтобы понять, зачем нам нужен показатель df, и в чем же с ним такая проблема. Допустим, мы решили проверить гипотезу о том, что средний рост жителей Санкт — Петербурга равняется 170 сантиметрам. Для этих целей мы набрали выборку из 16 человек и получили следующие результаты: средний рост по выборке оказался равен 173 при стандартном отклонении равном 4. Для проверки нашей гипотезы наиболее разумно будет использовать одновыборочный t — критерий Стьюдента, позволяющий оценить как сильно выборочное среднее отклонилось от предполагаемого среднего в генеральной совокупности в единицах стандартной ошибки:

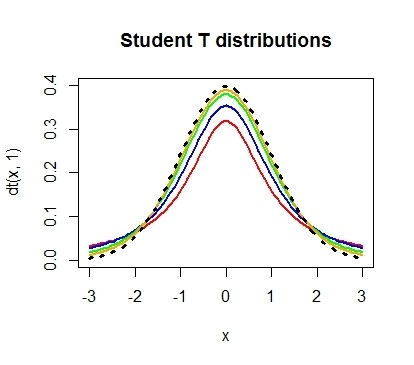

Проведем необходимые расчеты и получим, что значение t критерия равняется 3, отлично, осталось рассчитать p — value и задача решена. Однако, ознакомившись с особенностями t — распределения мы выясним, что его форма различается в зависимости от числа степеней свобод, рассчитываемых по формуле n — 1, где n — это число наблюдений в выборке:

Сама по себе формула для расчета df выглядит весьма дружелюбной, подставили число наблюдений, вычли единичку и ответ готов: в нашем случае p — value приблизительно равняется 0.004.

Но почему n минус один?

Когда я впервые в жизни на лекции по статистике столкнулся с этой процедурой, у меня как и у многих студентов возник законный вопрос: а почему мы вычитаем единицу? Почему мы не вычитаем двойку, например? И почему мы вообще должны что-то вычитать из числа наблюдений в нашей выборке?

В учебнике я прочитал следующее объяснение, которое еще не раз в дальнейшем встречал в качестве ответа на данный вопрос:

“Допустим мы знаем, чему равняется выборочное среднее, тогда нам необходимо знать только n — 1 элементов выборки, чтобы безошибочно определить чему равняется оставшейся n элемент”. Звучит разумно, однако такое объяснение скорее описывает некоторый математический прием, чем объясняет зачем нам понадобилось его применять при расчете t — критерия. Следующее распространенное объяснение звучит следующим образом: число степеней свободы — это разность числа наблюдений и числа оцененных параметров. При использовании одновыборочного t — критерия мы оценили один параметр — среднее значение в генеральной совокупности используя, n — элементов выборки, значит df = n — 1.

Однако ни первое, ни второе объяснение так и не помогает понять, зачем же именно нам потребовалось вычитать число оцененных параметров из числа наблюдений?

Причем тут распределение Хи — квадрат Пирсона?

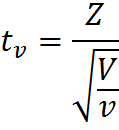

Давайте двинемся чуть дальше в поисках ответа. Сначала обратимся к определению t — распределения, очевидно, что все ответы скрыты именно в нем. Итак случайная величина:

имеет t – распределение с df = ν, при условии, что Z – случайная величина со стандартным нормальным распределением N(0; 1), а V – случайная величина с распределением Хи — квадрат, с ν числом степеней свобод. Это уже серьезный шаг вперед, оказывается, за число степеней свободы ответственна случайная величина с распределением Хи — квадрат в знаменателе нашей формулы.

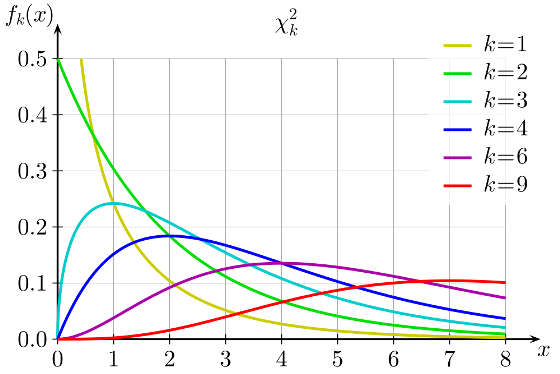

Давайте тогда изучим определение распределения Хи — квадрат. Распределение Хи — квадрат k степенями свободы — это распределение суммы квадратов k независимых стандартных нормальных случайных величин.

Кажется, мы уже совсем у цели, по крайней мере, теперь мы точно знаем, что такое число степеней свободы у распределения Хи — квадрат — это просто число независимых случайных величин с нормальным стандартным распределением, которые мы суммируем. Но все еще остается неясным, на каком этапе и зачем нам потребовалось вычитать единицу из этого значения?

Давайте рассмотрим небольшой пример, который наглядно иллюстрирует данную необходимость. Допустим, мы очень любим принимать важные жизненные решения, основываясь на результате подбрасывания монетки. Однако, последнее время, мы заподозрили нашу монетку в том, что у нее слишком часто выпадает орел. Чтобы попытаться отклонить гипотезу о том, что наша монетка на самом деле является честной, мы зафиксировали результаты 100 бросков и получили следующий результат: 60 раз выпал орел и только 40 раз выпала решка. Достаточно ли у нас оснований отклонить гипотезу о том, что монетка честная? В этом нам и поможет распределение Хи — квадрат Пирсона. Ведь если бы монетка была по настоящему честной, то ожидаемые частоты выпадания орла и решки были бы одинаковыми, то есть 50 и 50. Легко рассчитать насколько сильно наблюдаемые частоты отклоняются от ожидаемых. Для этого рассчитаем расстояние Хи — квадрат Пирсона по, я думаю, знакомой большинству читателей формуле:

Где O — наблюдаемые, E — ожидаемые частоты.

Дело в том, что если верна нулевая гипотеза, то при многократном повторении нашего эксперимента распределение разности наблюдаемых и ожидаемых частот, деленная на корень из наблюдаемой частоты, может быть описано при помощи нормального стандартного распределения, а сумма квадратов k таких случайных нормальных величин это и будет новая случайная величина, имеющая распределение хи квадрат.

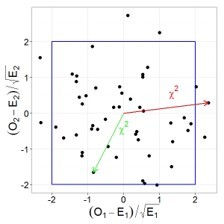

Давайте проиллюстрируем этот тезис графически, допустим у нас есть две случайные, независимые величины, имеющих z — распределение. Тогда их совместное распределение будет выглядеть следующим образом:

При этом квадрат расстояния от нуля до каждой точки это и будет случайная величина, имеющая распределение Хи — квадрат с двумя степенями свободы. Вспомнив теорему Пифагора, легко убедиться, что данное расстояние и есть сумма квадратов значений обеих величин.

Пришло время вычесть единичку!

Ну а теперь кульминация нашего повествования. Возвращаемся к нашей формуле расчета расстояния Хи — квадрат для проверки честности монетки, подставим имеющиеся данные в формулу и получим, что расстояние Хи — квадрат Пирсона равняется 4. Однако для определения p — value нам необходимо знать число степеней свободы, ведь форма распределения Хи — квадрат зависит от этого параметра.

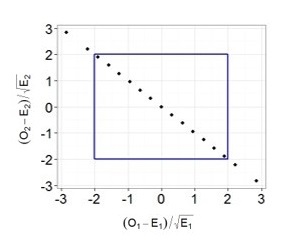

Предположим, что мы решили многократно повторять 100 бросков, и каждый раз мы записывали наблюдаемые частоты орлов и решек, рассчитывали требуемые показатели (разность наблюдаемых и ожидаемых частот, деленная на корень из ожидаемой частоты) и как и в предыдущем примере наносили их на график.

Легко заметить, что теперь все точки выстраиваются в одну линию. Все дело в том, что в случае с монеткой наши слагаемые не являются независимыми, зная общее число бросков и число решек, мы всегда можем точно определить выпавшее число орлов и наоборот, поэтому в данном случае мы не можем сказать, что два наших слагаемых — это две независимые случайные величины. Также вы можете убедиться, что все точки действительно всегда будут лежать на одной прямой: если у нас выпало 30 орлов, значит решек было 70, если орлов 70, то решек 30 и т.д. Таким образом, несмотря на то, что в нашей формуле было два слагаемых, для расчета p — value мы будем использовать распределение Хи — квадрат с одной степенью свободы! Вот мы наконец-то добрались до момента, когда нам потребовалось вычесть единицу. Если бы мы проверяли гипотезу о том, что наша игральная кость с шестью гранями является честной, то мы бы использовали распределение Хи — квадрат с 5 степенями свободы. Ведь зная общее число бросков и наблюдаемые частоты выпадения любых пяти граней, мы всегда можем точно определить, чему равняется число выпадений шестой грани.

Все становится на свои места

Теперь, вооружившись этими знаниями, вернемся к t — тесту:

в знаменателе у нас находится стандартная ошибка, которая представляет собой выборочное стандартное отклонение, делённое на корень из объёма выборки. В расчет стандартного отклонения входит сумма квадратов отклонений наблюдаемых значений от их среднего значения — то есть сумма нескольких случайных положительных величин. А мы уже знаем, что сумма квадратов n случайных положительных величин может быть описана при помощи распределения хи-квадрат с n-1 степеням свободы, если эти случайные величины не являются независимыми! Так как зная выборочное среднее и n-1 элементов выборки, мы всегда можем точно задать последний элемент (отсюда и берется это объяснение про среднее и n — 1 элементов необходимых для однозначного определения n элемента)! Получается, в знаменателе t-статистики у нас спрятано распределение хи-квадрат c n — 1 степенями свободы, которое используется для описания распределения выборочного стандартного отклонения! Таким образом, степени свободы в T-распределении на самом деле берутся из распределения хи-квадрат, которое спрятано в формуле T-статистики.

Схожая логика расчета числа степеней свободы сохраняется и при работе с другими тестами, например, в регрессионном или дисперсионном анализе, все дело в случайных величинах с распределением Хи — квадрат, которые присутствуют в формулах для расчета соответствующих критериев.

Таким образом, чтобы правильно интерпретировать результаты статистических исследований и разобраться, откуда возникают все показатели, которые мы получаем при использовании даже такого простого критерия как одновыборочный t — тест, любому исследователю необходимо хорошо понимать, какие математические идеи лежат в основании статистических методов.

Онлайн курсы по статистике: объясняем сложные темы простым языком

Основываясь на опыте преподавания статистики в Институте биоинформатики , у нас возникла идея создать серию онлайн курсов, посвященных анализу данных, в которых в доступной для каждого форме будут объясняться наиболее важные темы, понимание которых необходимо для уверенного использования методов статистики при решении различного рода задача. В 2015 году мы запустили курс Основы статистики, на который к сегодняшнему дню записалось около 17 тысяч человек, три тысячи слушателей уже получили сертификат о его успешном завершении, а сам курс был награждён премией EdCrunch Awards и признан лучшим техническим курсом. В этом году на платформе stepik.org стартовало продолжение курса Основы статистики. Часть два, в котором мы продолжаем знакомство с основными методами статистики и разбираем наиболее сложные теоретические вопросы. Кстати, одной из главных тем курса является роль распределения Хи — квадрат Пирсона при проверке статистических гипотез. Так что если у вас все еще остались вопросы о том, зачем мы вычитаем единицу из общего числа наблюдений, ждем вас на курсе!

Стоит также отметить, что теоретические знания в области статистики будут определенно полезны не только тем, кто применяет статистику в академических целях, но и для тех, кто использует анализ данных в прикладных областях. Базовые знания в области статистики просто необходимы для освоения более сложных методов и подходов, которые используются в области машинного обучения и Data Mining. Таким образом, успешное прохождение наших курсов по введению в статистику — хороший старт в области анализа данных. Ну а если вы всерьез задумались о приобретении навыков работы с данными, думаем, вас может заинтересовать наша онлайн — программа по анализу данных, о которой мы подробнее писали здесь. Упомянутые курсы по статистике являются частью этой программы и позволят вам плавно погрузиться в мир статистики и машинного обучения. Однако пройти эти курсы без дедлайнов могут все желающие.

Автор: Stepik.org