Приветствую!

Сегодня я бы хотел рассказать про свой проект, старт которому был дан еще в 2008 году. С тех пор многое поменялось, как в архитектуре хранения данных, так и в алгоритмах обработки информации.

Речь пойдет о сервисе для SEO специалистов и/или рядовых вебмастеров. BotHunter является системой пассивного наблюдения (в реальном режиме времени) за юзерагентами на вашем сайте. Примеры интерфейсов см. ниже, либо в DEMO аккаунте на сайте системы (в demo режиме ограниченный функционал). Читаем далее

Предыстория

Учитывая свои аппетиты и объем анализируемых данных, я написал данный сервис под себя. Для меня более понятный именно «графический ответ» на все вопросы. Частые вопросы, на которые BotHunter даст ответы:

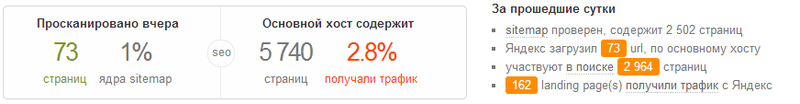

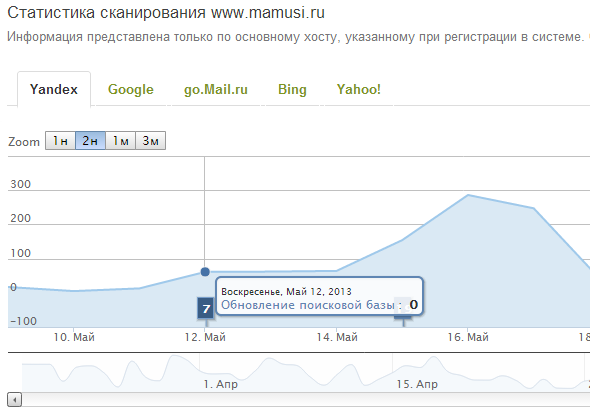

- Посещали мой сайт поисковые роботы, когда, как часто?

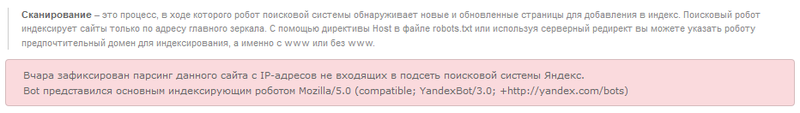

- Кто парсил мой сайт & когда, представляясь поисковым ботом?

- Сколько страниц моего сайта были загружены поисковым роботом?

- Сколько страниц, которые посетил поисковый crawler, участвуют в поиске?

- Сколько страниц, участвующих в поиске, приносят трафик?

- Какова доля landing page(s) которые посетил поисковый бот, но они никогда не были точками входа (с поисковых систем)?

- Сколько страниц из Sitemap.XML были проиндексированы?

- поисковый бот посещает мой сайт постоянно, а этого достаточно?

- Можно ли в одной системе посмотреть данные о работе с Яндекс, Google, Поиск.Mail.ru, Bing, Yahoo! (по большому списку моих сайтов) ?

- Есть ли на сайте страницы, которые могут быть «вредны» для поискового продвижения?

- и т.д. и т.п.

Есть готовый велосипед

Сразу хотел бы остановить тех, кто готов сейчас задать вопрос «Зачем? есть же яндекс.вебмастер и google webmasters ?»

Да, указанные сервисы полезны и известны, НО они не дадут ответ на следующие вопросы:

1. Есть на моем сайте страницы, о которых знают боты, но их нет в Sitemap.XML?

2. Есть на моем сайте страницы, которые посещал бот, но по ним ни разу не было трафика (хочу список)?

3. Какую долю урлов, постоянно посещают краулеры, но их нет в поиске?

4. Есть на моем сайте страницы, с одинаковым весом в байтах (тоже тема по дубликатам)?

5. После обновления поисковой базы (или смены алгоритма) такого-то числа; сколько страниц сайта больше не посещают боты? А сколько из них больше не являются точками входа трафика с органической выдачи?

6. и т.д.

Список занятных вопросов можно продолжать и у каждого из нас этот список будет свой…

Каковы плюсы сервиса

- есть система оповещений о событиях (по списку критериев)

- нет ограничений для числа сайтов в одном аккаунте

- нет смысла искать «иголку» в пачке логов, система сама проинформирует вас о событии

- анализируем и представляем в одном интерфейсе данные о нескольких поисковых системах

- есть возможность анализировать не только весь сайт, а лишь его срез, сегмент и т.д. (на основе регулярных выражений по урлу)

- все данные хранятся в нашем облаке и история доступна с момента регистрации сайта в системе

- отчеты позволяют предотвратить появление нечетких дубликатов

- если регулярно парсят ваш сайт, мы сообщим кто это. Вам не надо будет постоянно грепать логи

- сервис бесплатный

Кроме простых и понятных отчетов BotHunter ежедневно осуществляет проверку на целостность robots.txt и sitemap.xml файлов по каждому вашему сайту. По поводу sitemap.xml отдельная песня, файл проходит проверку на валидность и соответствие протоколу sitemap. Система пишет журнал о всех проверках и фактах генерации отчетов ежедневно.

Что в планах

- выявление отклонений от статистической нормы индексирования (вашего сайта)

- выявление типовых ошибок

- рекомендации по настройкам индексирования (учитывая особенности каждого сайта)

- [коллекция] сбор ключевых фраз, которые приносили трафик на сайт

- [расширение коллекции] получение списка ключевых фраз, рекомендуемых для сайта

- интеграция с Google Analytics для прогнозирования потери трафика (по сегментам сайта)

- то, что полезно специалистам (ваши рекомендации и идеи)

p.s. по поводу ТТХ, кратко:

- используется собственная серверная группа в ДЦ Filanco

- храним и анализируем все данные в NoSQL, если более конкретно — использую MongoDB

- ваши log файлы не храним, только результаты обработки

- Для авторизации используйте свой профиль в: facebook, Яндекса или Google

Основная задача данного поста — получить ваш совет.

Еще какие данные вы бы хотели получить и в каком виде?

Какие идеи вы бы предложили?

Заранее благодарю за конструктивную критику…

Автор: chudinov