«Чиповый бум» может привести к дефициту электроэнергии и трансформаторов уже в ближайшие годы. Многие современные технологии становятся все более ресурсоемкими, а в первую очередь это касается ИИ. Рассказываем, как это влияет на работу и развитие дата-центров, какие меры можно предпринять для увеличения энергоэффективности, а также делимся опытом Selectel.

Приглашаем 10 октября на Selectel Tech Day

Приглашаем 10 октября на Selectel Tech Day

Расскажем о новинках на рынке и обновлениях в наших продуктах. Вас ждут доклады, нетворкинг, мастер-классы и вечерняя программа. Участие бесплатное, но нужно зарегистрироваться.

Развитие ИИ требует все больше электроэнергии

В декабре 2023 года группа ученых опубликовала исследование с оценками того, сколько энергии используют для операций различные модели искусственного интеллекта.

Авторы провели тесты на 88 различных моделях искусственного интеллекта для ряда задач, включая создание изображений. После этого они рассчитали, сколько электроэнергии нужно произвести на электростанции для выполнения этих запросов и сколько углекислого газа в результате этого окажется в атмосфере.

В среднем на одну задачу по генерации текста нужно несколько милливатт-часов. Однако для создания изображений это количество примерно в 1000 раз больше: мы говорим о нескольких ватт-часах на одну картинку.

Согласно исследованию, для создания одного изображения с помощью ИИ требуется почти столько же энергии, сколько для зарядки смартфона.

Или другой пример: рассчитаем, сколько электроэнергии нужно для обучения ChatGPT:

- Минимальное время обучения нейросети — 1 месяц, или 720 часов. За это время нейросеть обучится минимум на 3 петабайтах данных.

- Ежемесячное энергопотребление минимального кластера ИИ — аппаратного объединения мощностей дата-центра для формирования достаточной для ИИ вычислительной мощности — составляет в среднем 600–800 кВт.

- Умножаем энергопотребление на часы: 800 × 720 = 576 МВт·ч.

Таким образом, по логике этого расчета на месяц обучения ChatGPT потребуется 576 МВт·ч. Это примерно месячное потребление электроэнергии городком с населением 3000 человек.

Тезис о том, что на обучение нейросети потребуется месяц — предположение. Через 30 дней нейросеть начинает выдавать результаты, однако ее обучение еще не закончено. Длительность обучения ИИ зависит от объема материала и от размера, то есть числа нейронов в ней.

Чтобы добиться от искусственного интеллекта точности выполнения задачи на 95%, ему нужно пройти обучение на 10–20 тысячах изображений. Затем для повышения точности на каждый 1% нужно увеличивать существующий датасет в два раза. Каждый шаг нейросети требует затрат электроэнергии, поэтому 576 МВт·ч лишь примерный показатель. Проблема касается и ЦОД: серверы, работающие с искусственным интеллектом, становятся все более мощными и потребляют все больше энергии.

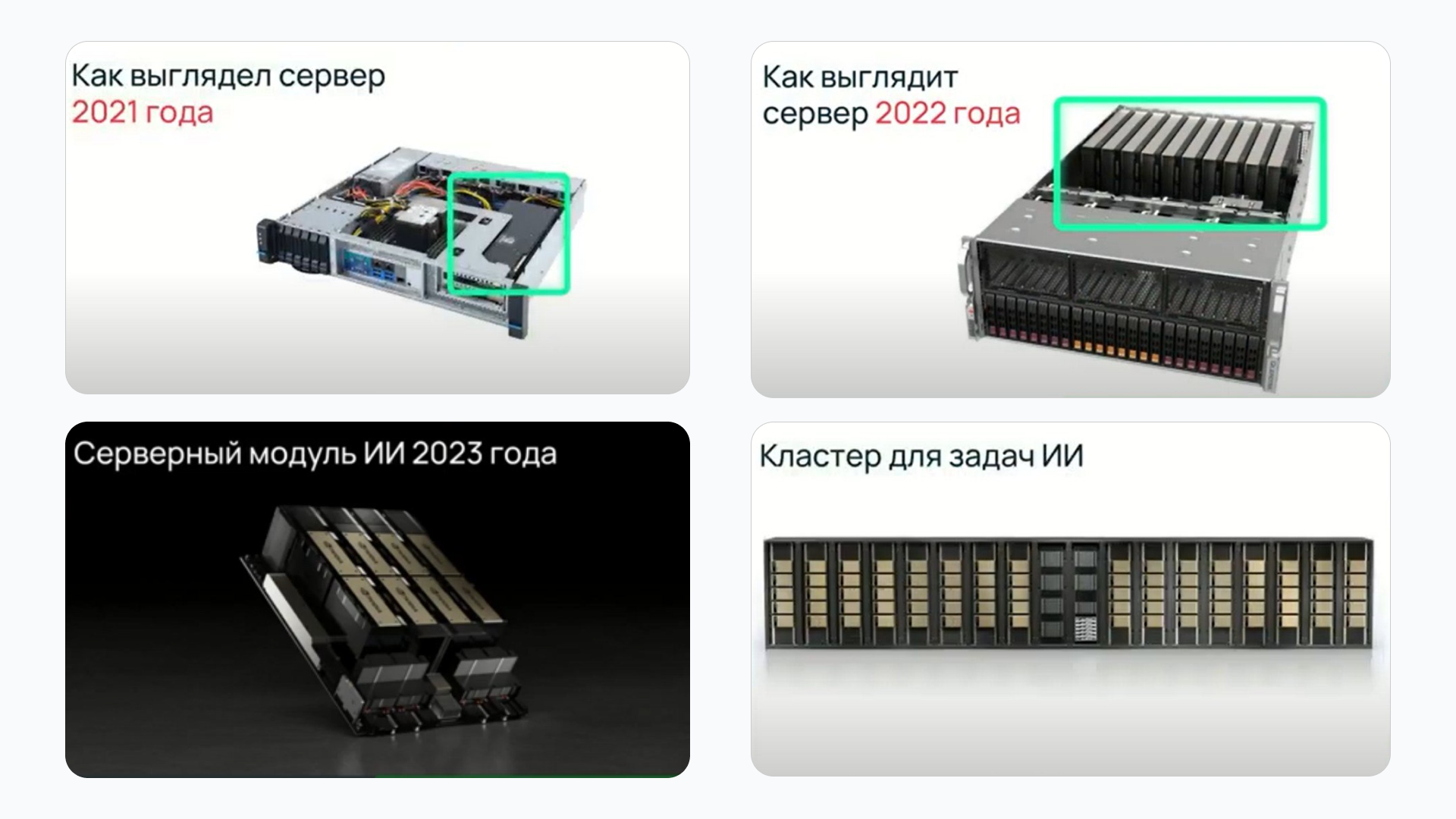

Увеличить скорость работы ИИ помог модуль ускорения вычислений для работы нейросетей. Это видеокарта (Graphic Processing Unit, GPU), которую используют для правильных и быстрых расчетов. Она требуется, например, когда компьютер активно занят ресурсоемкими задачами по отрисовке сцен для игр или мультфильмов.

Чтобы повысить скорость вычислений, в один компьютер можно поставить несколько видеокарт. В 2022 году число модулей ускорения вычислений увеличилось до 4–8. Такой сервер потребляет до 3 кВт. Спустя год появился серверный модуль ИИ, который содержит восемь GPU — графических процессоров, способных выполнять вычисления с высокой скоростью, — и потребляет уже 8 кВт. При этом такой сервер будет полностью загружен задачами, чтобы оправдать свою высокую стоимость, а значит, потребляет энергию постоянно и на максимум.

Затем появляются вычислительные кластеры для задач ИИ, которые потребляют уже 600–800 кВт.

Эволюция серверных модулей за четыре года. Оборудование становится мощнее, производительнее и энергозатратнее.

Кластеры создали в целях увеличения вычислительной мощности. Кроме того, плотное размещение серверов позволяет достичь экономии на дорогих соединительных кабелях между ними. Серверы рентабельнее объединять в единую структуру, а не распределять по стойкам в зале.

Однако на маленькой площади при размещении кластера растет потребление электроэнергии на охлаждение системы. В случае серверного шкафа мощностью 10 кВт на вентиляторы для его охлаждения тратится 6% общего потребления электричества этим шкафом. Если взять серверный шкаф, в который можно разместить оборудование суммарной мощностью до 50 кВт, расходы электричества только на вентиляторы составят до 60% общего энергопотребления шкафа.

Если поставим 16 серверов в 16 шкафов на 10 кВт, то каждый будет потреблять 10 кВт, и на вентилятор надо будет потратить 600 Вт. Если поставить 16 серверов в четыре шкафа по 40–50 кВт, то на охлаждение каждого шкафа потребуется до 30 кВт.

Большую часть энергии ЦОД получают за счет сжигания ископаемого топлива. Из-за этого в атмосферу выбрасывается огромное количество углекислого газа, который вызывает парниковый эффект.

Чтобы оценить, какой урон ИИ наносит экологии, рассмотрим Сургутскую ГРЭС-2 (ГРЭС — государственная районная электростанция, не путать с ГЭС — гидроэлектростанцией). Эта тепловая электростанция (ТЭС) — самый крупный производитель электричества в России, который в основном сжигает полученный из нефти попутный нефтяной газ. Доля СО2 в нем составляет 0,10–2,77%. Возьмем минимум — 0,10%.

Удельный расход топлива на парогазовых установках ТЭС — 225 г на 1 кВт·ч. Для выработки 576 000 кВт·ч, которые потребляет нейросеть при обучении, нужно 129 600 000 г топлива. Доля СО2: 129 600 000 г × 0,10% = 129 600 г.

Одна легковая машина в день выбрасывает 9000 г СО2. Чтобы понять, сколько легковых машин выбросит 129 600 г СО2, разделим это число на 9000. Получается, минимальное обучение нейросети наносит экологии такой же урон, как и работа 14–15 автомобилей.

Как Selectel решает проблему потребления ресурсов для таких задач

Внутри Selectel мы внедрили несколько решений, которые уже сейчас помогают снизить потребление ресурсов для таких задач.

Увеличиваем энергоэффективность ЦОД

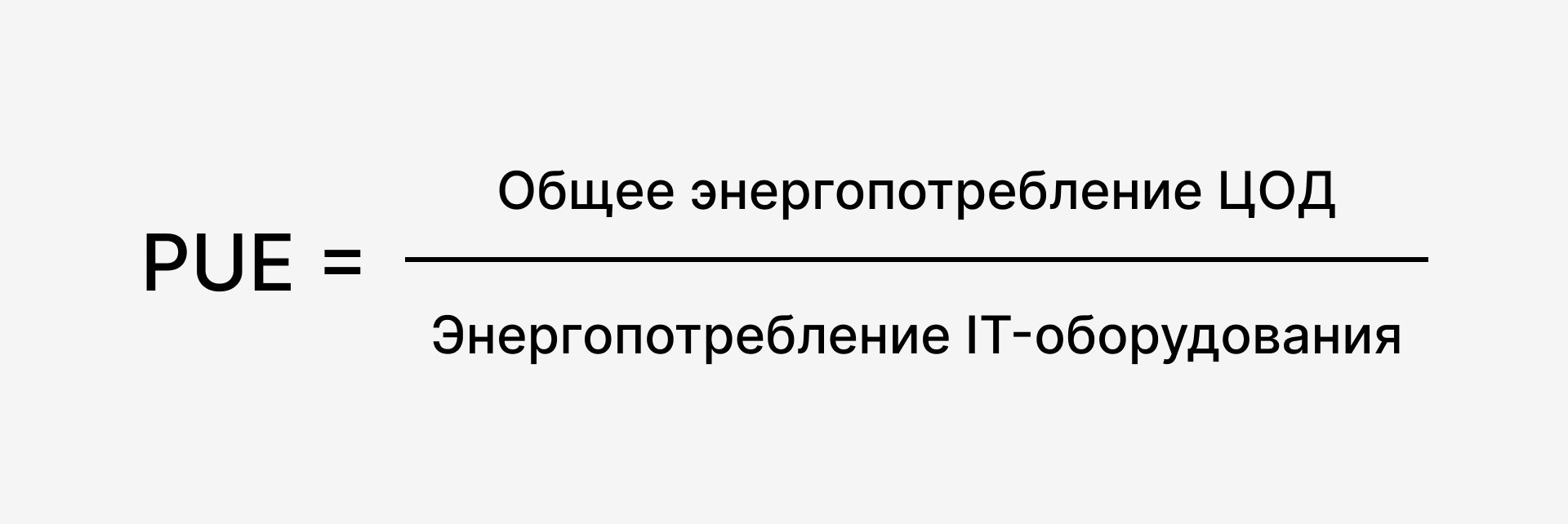

В первую очередь требуется увеличить энергоэффективность дата-центров, то есть уменьшить долю электроэнергии, которую дата-центр расходует, помимо обеспечения работы вычислительных ресурсов (охлаждение, освещение и другие дополнительные нужды). В этом нам помогает PUE — показатель оценки энергоэффективности ЦОД.

Для обслуживания одного и того же количества серверов можно использовать разные системы охлаждения: например, чиллеры имеют более низкий PUE, чем стандартные кондиционеры с фреоном, и более энергоэффективны.

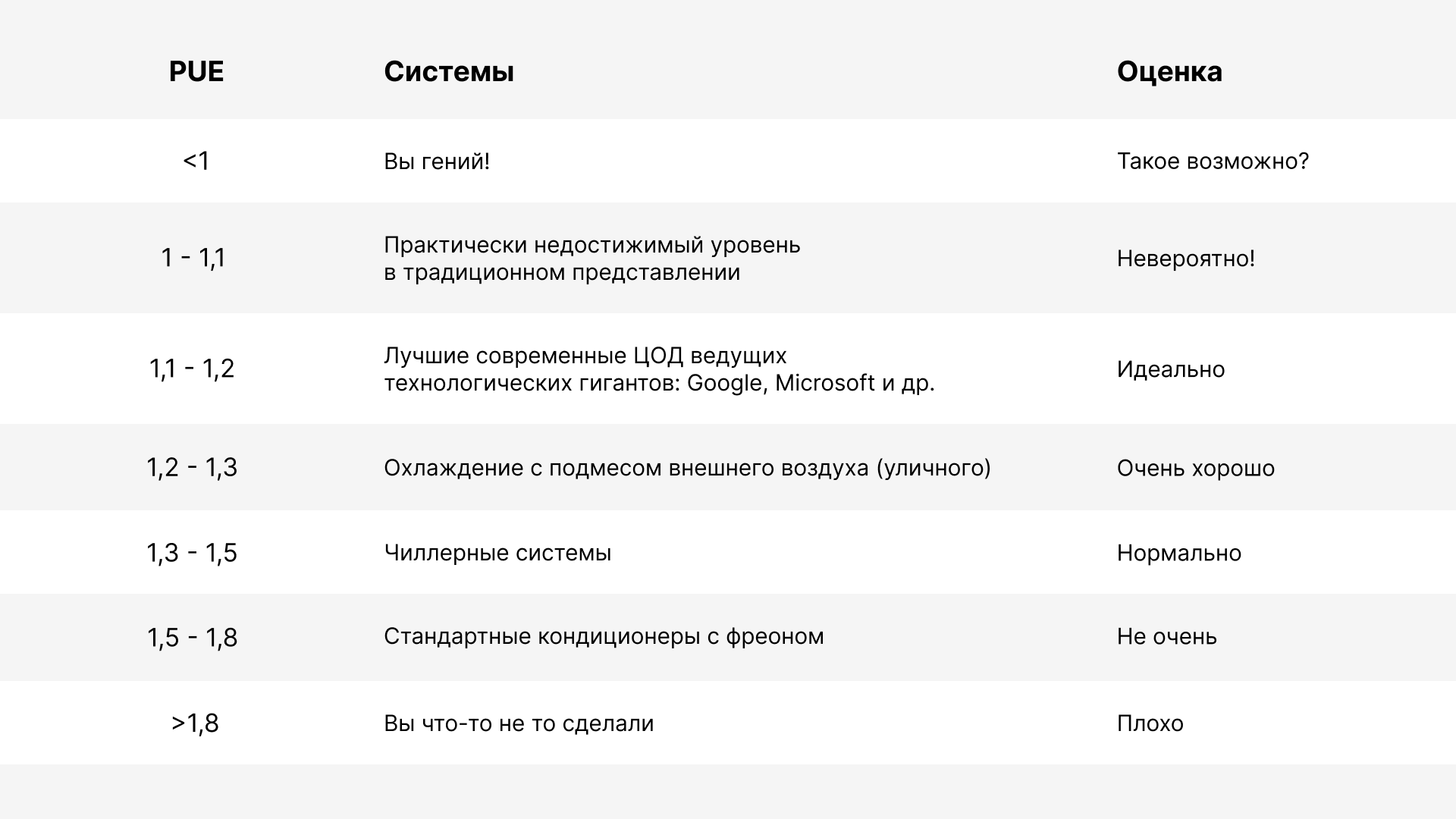

Диапазоны PUE. Показатель, стремящийся к единице, пока практически недостижим, но является хорошим ориентиром

Как мы снижаем PUE

1. Расширяем рабочие температурные диапазоны IT-оборудования. Ранее допустимым для дата-центров считалось значение в районе 18–20 °C, но теперь мы допускаем, что температура может достигать 27 °C.

2. Используем чиллеры вместо фреоновых кондиционеров. Показатель PUE системы охлаждения на базе классических фреоновых кондиционеров по современным меркам довольно высок и составляет 1,6–1,7 и выше, в то время как PUE системы охлаждения на базе чиллеров — в районе 1,4. Второй вариант более энергоэффективен.

Используем фрикулинг и дополнительное охлаждение

Фрикулинг бывает прямой и непрямой. В случае прямого фрикулинга воздух с улицы напрямую подается вентиляторами в машинный зал (через систему фильтров, конечно же), при непрямом вентиляторы используются два раза: когда воздух с улицы подают на теплообменник и когда его подают в зал.

В нашем дата-центре «Дубровка 3» используем прямой фрикулинг с блоком дополнительного охлаждения на базе абсорбционной холодильной машины (АБХМ) — на случай летней жары, а в дата-центре «Берзарина» (Москва) — прямой фрикулинг с адиабатической системой дополнительного охлаждения.

Суть такой системы вот в чем: для работы адиабатической системы доохлаждения нужен достаточно сухой воздух. Он бывает обычно летом, поэтому адиабатика работает только при теплой погоде. Воздух, проходя через блок дополнительного увлажнения, снижает свою температуру до 8 ℃. Систему включают в районе 1 мая, когда пиковая температура становится больше 25 ℃, и отключают условно 1 октября. Такая система доохлаждения особенно эффективна для южных регионов.

Использование энергоэффективных подходов позволяет нам обеспечивать необходимые рабочие температуры для оборудования и при этом не затрачивать лишних ресурсов на его охлаждение.

В 2003 году действовали рекомендации (ASHRAE), которые определяли верхний предел температуры в дата-центрах до 24 ℃. Сейчас постоянный верхний предел температуры по текущим рекомендациям — 27 ℃, а временный — до 30 ℃. Диапазон возможных температур расширился за счет технического прогресса серверных решений, поэтому сейчас мы можем широко использовать фрикулинг с адиабатическим доохлаждением для дата-центров.

Рационально используем мощности дата-центра

Чтобы не тратить электроэнергию зря, где она не нужна, нам помогают технологии. Расскажем о каждой подробнее.

Мониторинг энергоснабжения

Для того чтобы начать экономить, надо знать, где это расходуется. Дизельный генератор даже на холостых оборотах или на минимальной мощности, неиспользуемый, но включенный ИБП или включенный кондиционер потребляют электроэнергию. При отсутствии нагрузки их целесообразно отключить.

Чтобы понять, когда необходимости в оборудовании нет, мы в Selectel используем специальные DCIM-системы для мониторинга. Это программное обеспечение, которое собирает информацию с датчиков внутри дата-центра и сообщает о ситуации. На основании показаний этой системы мы принимаем решение о том, что можно исключить источник бесперебойного питания или кондиционер в зале.

Например, когда дата-центр загружен на 100%, ему требуется работа четырех генераторов. При нагрузке дата-центра в 10–15% достаточно одного дизельного генератора, а два можно выключить (один все равно остается в резерве). Это значит, что у них как минимум выключается система обогрева, а электричество не тратится на постоянную готовность.

Динамические ИБП вместо статических

Динамические источники бесперебойного питания (ДИБП) более экологичны, чем статические (СИБП), потому что:

- Им нужно меньше дополнительного охлаждения — диапазон их работы 4–50 ℃, а не 20–25 ℃, как у СИБП.

- Их реже обслуживают, следовательно, они генерируют меньше использованных расходных материалов.

- Они занимают меньше места, следовательно, экологический след при строительстве помещения для них ниже.

- Для добычи 20 тонн свинца для СИБП нужно приложить примерно в четыре раза больше усилий, чем для получения пяти тонн железа для ДИБП.

- После окончания срока службы переработка ДИБП легче, и в итоге получается меньше отходов. В них содержится железо без примесей, а в СИБП — загрязненный кислотой свинец, который надо очищать.

Умное освещение

В дата-центрах мы используем датчики присутствия. Свет включается, только когда в серверной есть человек. Кроме оптимизации энергопотребления, есть еще один способ позаботиться об экологии — продлевать жизнь старой техники или правильно утилизировать ее. У Selectel большое количество оборудования, которое устаревает со временем. Мы нашли три способа давать железу вторую жизнь: модернизировать, перепродавать детали или отправлять на утилизацию.

Selectel сотрудничает с несколькими лицензированными компаниями, которые специализируются на утилизации техники. В утиль идут неисправные жесткие диски (после уничтожения внутренностей в специальной «черной коробочке») и другие серверные комплектующие, а также этиленгликоль из систем охлаждения. Кабельная продукция идет на цветмет, а оптика — в утилизацию. Туда же чаще всего отправляется мелкая офисная техника — мышки, клавиатуры и т. д. Все это помогает снижать негативное влияние на экологию.

Темпы развития ИИ продолжают ускоряться, при этом оборудование для искусственного интеллекта модернизируется. Например, следующее поколение платформ для ИИ уже будет рассчитано на жидкостное охлаждение. Эффективность охлаждения можно будет снизить со значения показателя PUE в 1,6 до 1,2. При этом Selectel не ждет их ввода в работу, а уже заботится об экологии, используя фрикулинг, АСД, DCIM-систему, динамические ИБП и другие решения.

Поделитесь в комментариях — в каких сценариях вы уже замечали, что новые технологии требуют все больших мощностей?

Автор: DimDimDimDimDim