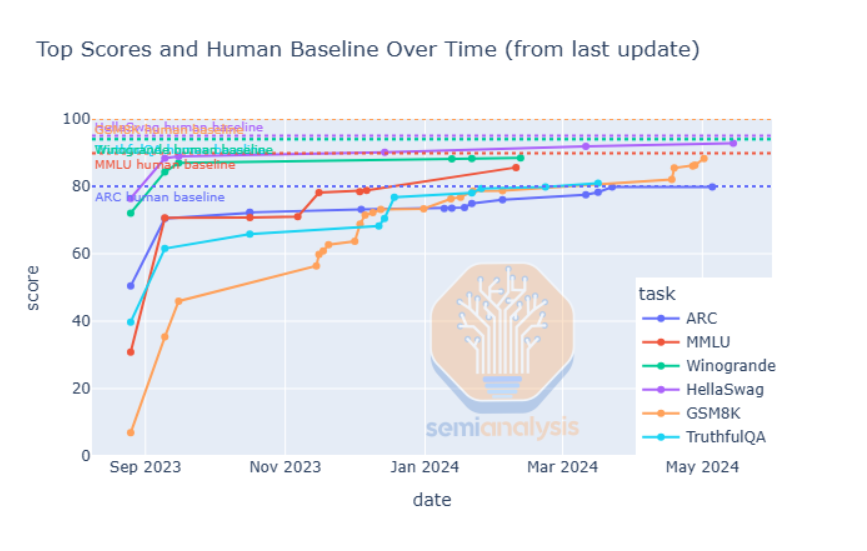

С каждым днем растут страхи и сомнения относительно законов масштабирования ИИ. Большинство предсказателей отрасли ИИ утверждают об окончании законов масштабирования, которые за последние несколько лет привели к мгновенному улучшению возможностей крупных языковых моделей (LLM). К ним присоединились журналисты, вооружившись неопределенной информацией о неспособности моделей успешно масштабироваться из-за предполагаемой низкой производительности. Критики также указывают на насыщенность существующих бенчмарков, где новые модели демонстрируют лишь незначительные улучшения, а также на исчерпание доступных данных для обучения и замедление аппаратного масштабирования.

Несмотря на эту тревогу, увеличение капитальных затрат на строительство крупных лабораторий искусственного интеллекта говорит само за себя. Amazon, инвестирующая значительные суммы в ускорение Trainium2, планы Meta по созданию центров обработки данных мощностью 2 ГВт в 2026 году в Луизиане, агрессивные планы Google по обучению нескольких центров обработки данных для преодоления ограничений мощности на одном объекте — все эти ключевые лица, по-видимому, непоколебимы в своей убежденности в том, что законы масштабирования все еще живы. Почему?

Масштабирование обучения, новые и старые парадигмы продолжаются

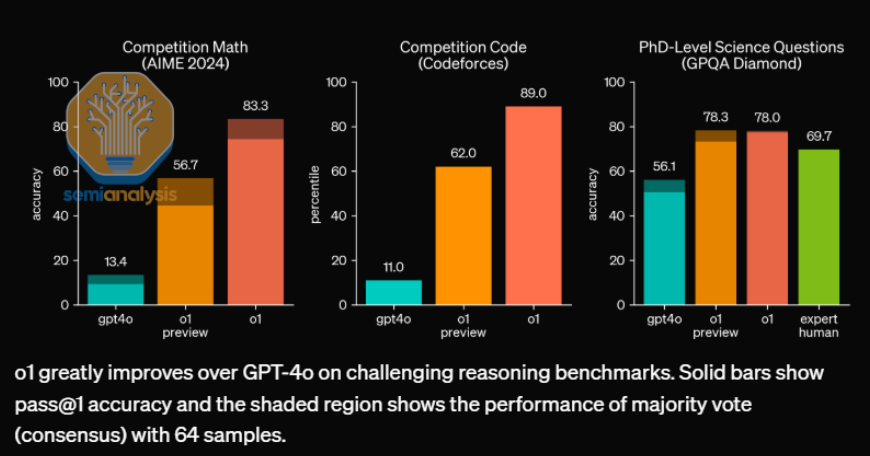

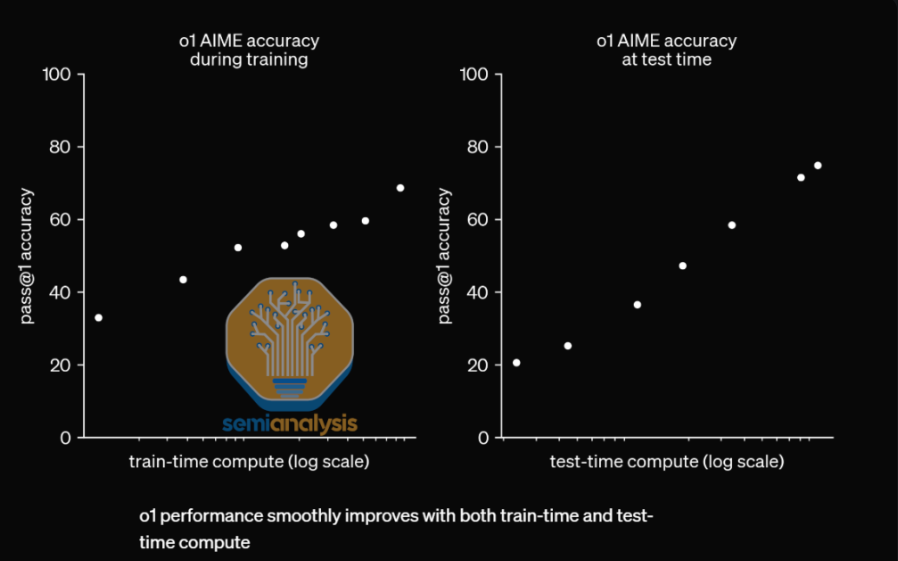

Выпуск OpenAI o1 доказал полезность и потенциал моделей рассуждений, открыв новые неизведанные измерения для масштабирования. Но это не единственный метод, который обеспечивает значимые улучшения в производительности модели по мере масштабирования вычислений. Другие методы, которые обеспечивают улучшения модели с большим количеством вычислений, включают генерацию синтетических данных, оптимизацию проксимальной политики (PPO), функциональные верификаторы и другую инфраструктуру обучения для рассуждений. Масштабирование меняется и развивается, и вместе с этим продолжает ускоряться весь процесс разработки ИИ. Переход от неисправных контрольных показателей к более сложным позволит лучше измерять прогресс. В этом отчете мы опишем старую тенденцию масштабирования до обучения, а также новые тенденции масштабирования. Это означает, что новые методы потребуют еще больше времени обучения для масштабирования вычислений, чем предполагалось ранее.

Мы рассмотрим архитектуру OpenAI o1 и o1 Pro как с точки зрения инфраструктуры обучения, так и с точки зрения токеномики вывода, включая стоимость, масштабирование KVCache, пакетирование и многое другое. Мы также обсудим ведущие синтетические данные AI Lab и инфраструктуру RL. Также мы хотим прояснить ситуацию с «провалами» Claude 3.5 Opus от Anthropic и Orion от OpenAI, а также с тем, какие планы масштабирования будут реализованы.

Масштабирование поет оды величайшему закону масштабирования вычислений — закону Мура

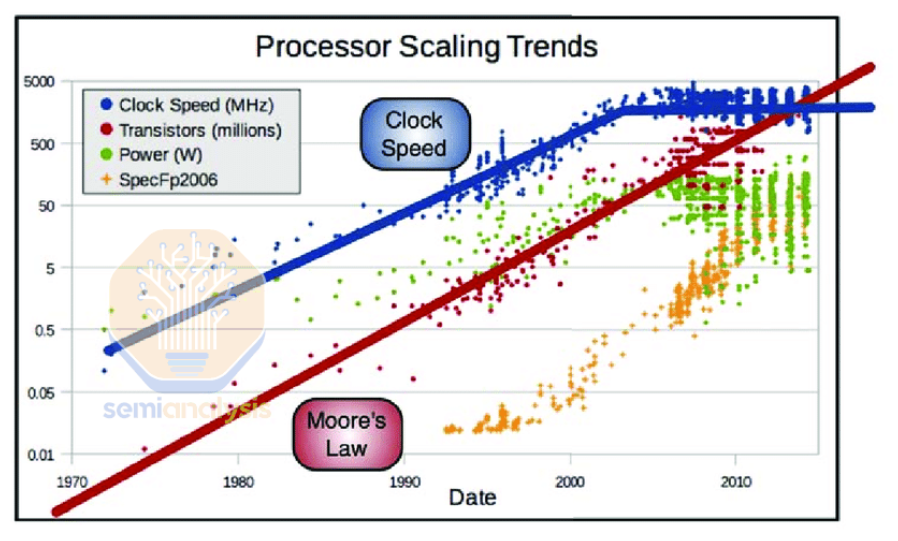

Сегодняшние дебаты о законах масштабирования ИИ не отличаются от многолетних дебатов вокруг масштабирования вычислений и закона Мура. Любой, кто попытается измерить вычислительную мощность ЦП по тактовой частоте — распространенной метрике, использовавшейся до конца 2000-х годов, примерно во время окончания масштабирования Деннарда — будет утверждать, что с тех пор мы вообще не добились никакого прогресса. Но на самом деле, вычислительная мощность постоянно совершенствовалась — когда мы достигли предела в тактовой частоте процессоров, фокус сместился на многоядерные архитектуры и другие методы повышения производительности, несмотря на ограничения плотности энергии и охлаждения.

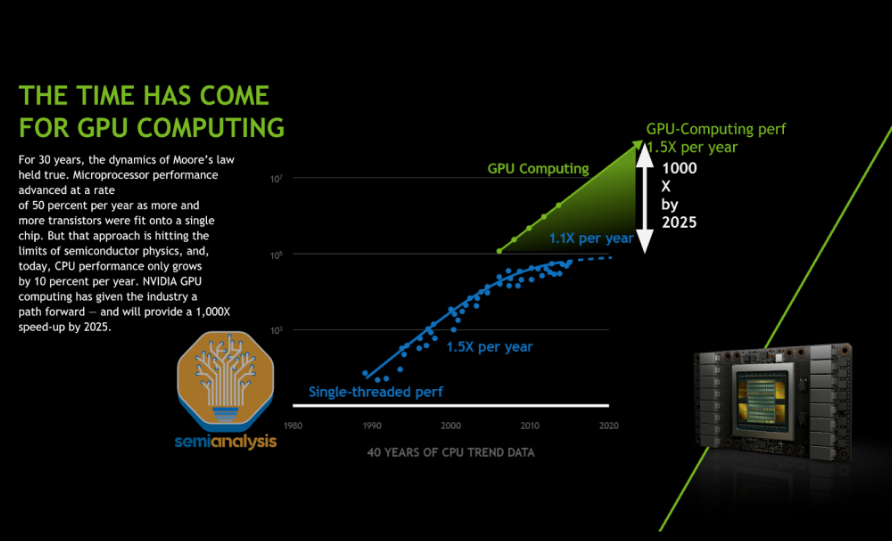

Конец закона Мура — еще одно препятствие, с которым столкнулась полупроводниковая промышленность, но в последнее время эти дебаты стихли, поскольку пионеры ИИ, такие как Nvidia, обеспечили огромный прирост вычислений за счет масштабирования по нескольким совершенно новым измерениям. Усовершенствованная упаковка позволила продолжить прогресс в вычислениях за счет масштабирования ввода/вывода (I/O) и позволила чипам использовать общую площадь кремния за пределами ограничений. Параллельные вычисления внутри и между чипами и создание более крупных сетевых доменов с высокой пропускной способностью позволили чипам лучше работать вместе в масштабе, особенно для вывода.

Как и компьютерные энтузиасты в 2004 году, сегодняшние основные аналитики и журналисты не видят леса за деревьями: несмотря на замедление одной тенденции, отрасль в целом продолжает двигаться вперед с головокружительной скоростью из-за других новых появляющихся парадигм, которые созрели для масштабирования. Предварительное обучение станет лишь одним из векторов улучшения, а совокупный «закон масштабирования» продолжит масштабироваться так же, как закон Мура на протяжении последних 50 лет.

Проблемы масштабирования предварительного обучения

Масштабирование предварительного обучения обеспечило значительный прирост производительности модели, но есть несколько препятствий, на преодолении которых отрасль в настоящее время сосредоточена.

Одним из очевидных препятствий является то, что данные становится все труднее собирать — данные в Интернете не расширяются со скоростью, пропорциональной вычислительным ресурсам. Вот почему сегодняшние мегамодели с триллионами параметров оказались меньше оптимальных для Chinchilla — имеют гораздо меньшее количество токенов обучения по сравнению с параметрами модели.

Масштабирование Chinchilla относится к оптимальному увеличению данных по сравнению с количеством параметров относительно увеличения вычислительных ресурсов. Недостаток данных приводит к тому, что модель плохо обобщает, в то время как избыток данных приводит к переобучению и тратам вычислительных ресурсов. В некоторых случаях отклонение от оптимального соотношения имеет смысл: модели с избыточным обучением (например, GPT-4o и Llama) могут значительно снизить затраты на вывод и являются предпочтительными для поставщиков, которые имеют большую базу пользователей для обслуживания этой модели.

В январе 2023 года, до запуска GPT-4, мы писали о практических ограничениях масштабирования и о том, как GPT-4 планировала их преодолеть. С тех пор модели колебались от более чем Chinchilla Optimal (гораздо больше данных, чем параметры модели) до менее чем Chinchilla Optimal (когда данные стали ограниченными). Ограничения вычислительных мощностей в прошлом преодолевались за счет улучшения аппаратного обеспечения для обучения и вывода.

На сегодняшний день полезные источники данных, такие как учебники и документация, полностью исчерпаны, и то, что осталось, в основном представляет собой текстовые источники данных низкого качества. Кроме того, веб-данные по-прежнему представляют собой узкое распределение данных, и моделям нужно больше данных, чтобы продолжать обобщать. Поскольку модели сложнее масштабировать оптимальным образом, предварительное обучение становится более сложным.

Кроме того, если лаборатории обучают модели с недостаточным количеством данных по мере их масштабирования, модели становятся чрезмерно параметризованными, становясь неэффективными и приводя к большому объему запоминания, а не обобщения. Вместо этого лаборатории обращаются к более широкому использованию синтетических данных, чтобы облегчить эту проблему.

Однако эта проблема в меньшей степени относится к основным лабораториям искусственного интеллекта. Meta имеет примерно в 100 раз больше данных, чем в общедоступном Интернете (при условии, что они могут использовать эти данные в соответствии с нормативными требованиями). Это может дать им преимущество в продолжении масштабирования с меньшим количеством проблем, чем у других. На YouTube ежедневно загружается 720 000 новых часов видео, и нам кажется, что AI Labs только начали рассматривать возможность обучения на огромном объеме данных, содержащихся в видео. Это в дополнение к их способности генерировать качественные синтетически сгенерированные данные, архитектуру которых мы обсудим позже.

Для обучения на квадриллионах альтернативных токенов, доступных из видео, требуется огромное масштабирование общего FLOP обучения, которое будет обеспечено аппаратными инновациями и системной инженерией. Например, масштабирование еще на один порядок величины FLOP обучения потребует обучения в нескольких центрах обработки данных, поскольку необходимое количество ускорителей больше не может поместиться в пределах одного центра обработки данных. Проект Rainier предлагает Amazon предоставить Anthropic 400 тысяч чипов Tranium 2, но в сыром FLOP это меньше 100 тысяч GB200. Anthropic придется добиться значительных инженерных достижений, чтобы провести обучение в таком кластере. Распространение ускорителей по большому кампусу или нескольким кампусам само по себе приводит к значительным проблемам, вызванным законом Амдаля, хотя уже существует несколько предложений для решения этой проблемы.

Другим ограничением в отношении параметров масштабирования является экономика вывода. Лаборатории ИИ могут капитализировать огромные суммы инвестиций в обучение больших моделей и амортизировать использование модели как для большой и растущей базы пользователей, так и для внутренних вариантов использования для разработки дальнейших итераций модели. Когда дело доходит до вывода, они должны быть осторожны, чтобы не выводить на рынок модели, которые слишком дороги или неэкономичны для обслуживания.

Оценки также не являются всеобъемлющими. Есть множество возможностей или свойств моделей, которые существующие оценки не охватывают должным образом. Передача обучения, когда модель становится лучше в домене за счет изучения чего-то другого, и контекстное обучение — это области, где необходимо разрабатывать еще больше оценок. И наконец, всегда будут варианты конечного использования, которые трудно предсказать заранее, но которые приносят конечным пользователям огромную выгоду.

То, что измеряется, всегда улучшается.

Новые, более сложные оценки

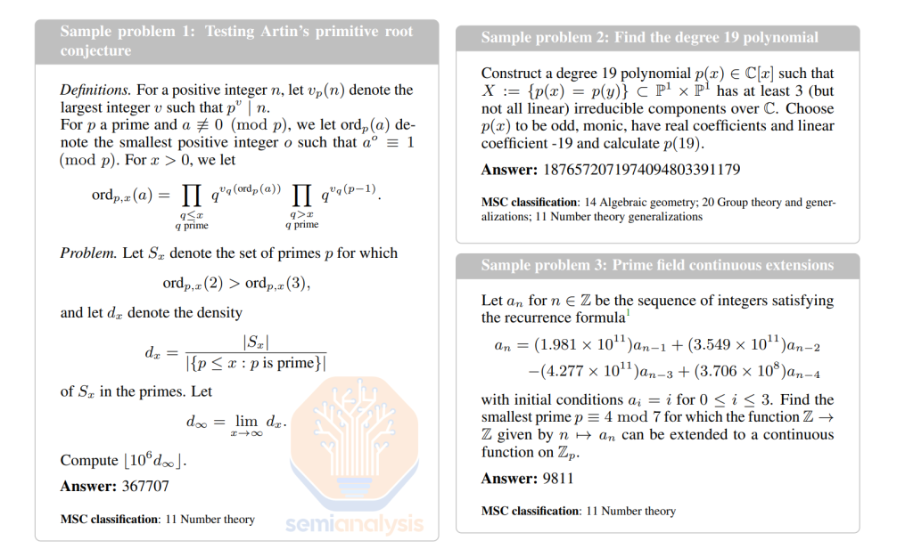

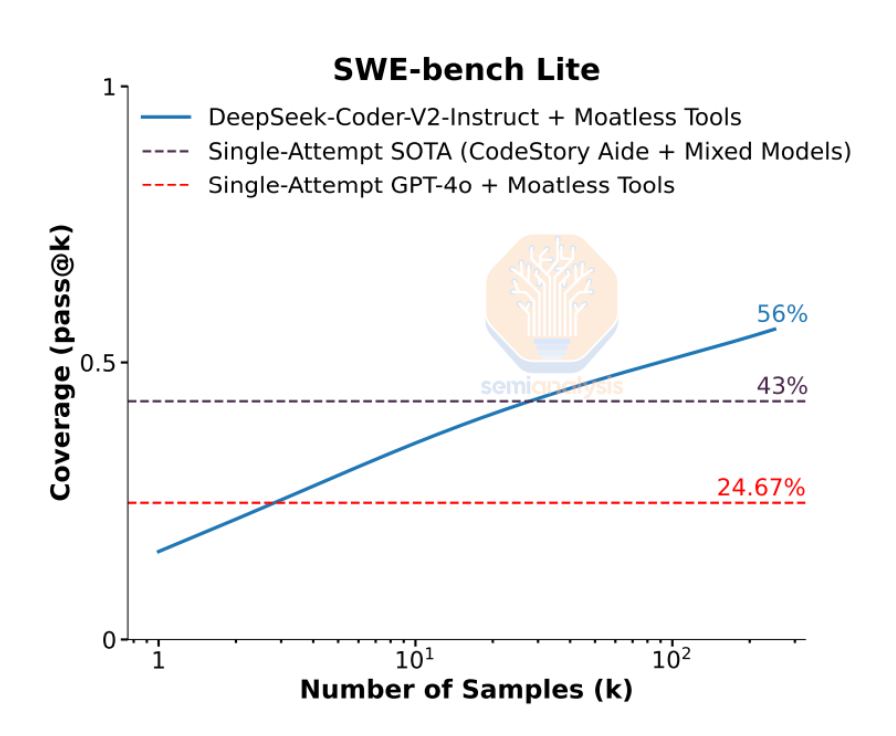

Появились новые оценки, направленные на лучшую дифференциацию моделей и сосредоточенные на непосредственном решении конкретных полезных приложений. SWE-Bench, например, является одним из важнейших бенчмарков, направленных на решение проверенных людьми задач из открытых репозиториев Python на GitHub. Новый Claude 3.5 Sonnet достиг результата 49% (State of the Art) на SWE-Bench Verified, тогда как большинство моделей существенно отстают.

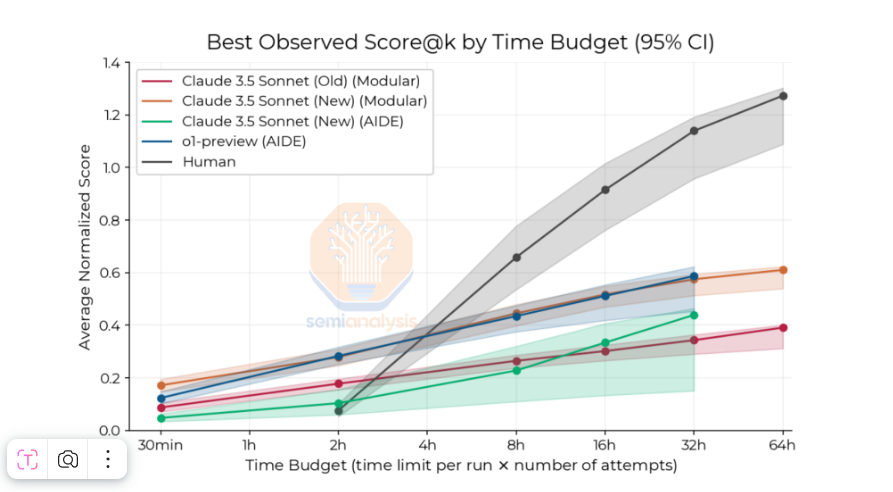

Еще один пример — бенчмарк, оценивающий возможности AI в R&D, который некоторые считают «самой важной характеристикой для отслеживания». Research Engineering Benchmark (RE) состоит из семи сложных и открытых исследовательских сред машинного обучения. Люди, как правило, лучше справляются с оценками в течение более длительных временных горизонтов, но в течение 2-часового временного горизонта лучшие агенты ИИ набрали балл в 4 раза выше, чем люди. Важные задачи, подобные описанным выше, в которых в настоящее время доминируют люди, являются идеальной основой для масштабирования вычислений времени вывода. Мы ожидаем, что модели, которые лучше используют эту форму масштабирования, в будущем превзойдут людей.

Еще одна тенденция заключается в том, что оценки включают чрезвычайно сложные вопросы экспертного уровня. Два ярких примера — Graduate-Level Google-Proof Q&A Benchmark (GPQA) и Frontier Math. GPQA состоит из 448 вопросов с несколькими вариантами ответов по химии, биологии и физике. Для сравнения, OpenAI выяснила, что люди экспертного уровня (т. е. люди с докторской степенью) набрали ~70% на GPQA Diamond, а o1 набрал 78% на том же наборе. В прошлом году GPT-4 с поиском (и методом цепочки размышлений при отказе) набрал 39% на GPQA Diamond.

Еще один пример тенденции к использованию чрезвычайно сложных вопросов — FrontierMath (FM). FM — это бенчмарк из сотен оригинальных математических вопросов, на решение которых у людей могут уйти часы и даже дни. Он охватывает широкий спектр математических тем, включая теорию чисел, вещественный анализ и т. д. Особенностью этой оценки является то, что она не публикуется, и это сводит к минимуму риск загрязнения данных; в процессе может участвовать автоматизированный верификатор, что упрощает процесс оценки.

Лучшая производительная модель в этом бенчмарке составляет 2%, но лаборатории ожидают, что этот показатель значительно улучшится. В среднесрочной перспективе Anthropic может достичь 80% на FrontierMath.

Последующее обучение: новая область масштабирования

Предварительное обучение находится в центре дебатов относительно законов масштабирования, поскольку его легко понять, но это только одна часть жизненного цикла ИИ. После того, как модель предварительно обучена, еще предстоит проделать значительную работу по ее подготовке к использованию. Целью предварительного обучения является, в очень узком смысле, «правильно спрогнозировать следующий токен». Достижение этого все еще оставляет нас далеко от конечной цели развития LLM, которая заключается в «ответе на запросы пользователя» или «выполнении задачи».

Прежде чем погрузиться в то, как работает и как была создана модель OpenAI O1 Pro, мы сделаем обзор Supervised Fine-Tuning (SFT), обучения с подкреплением (RL) и синтетических данных.

Supervised Fine-Tuning

Supervised Fine-Tuning (SFT) — наиболее известный тип постобучения. В модели отображается тщательно подобранный набор данных пар входных и выходных данных, а «демонстрационные данные» охватывают конкретную область (например, код, математические вычисления, выполнение инструкций и т. д.). В отличие от предварительной подготовки, здесь важнее качество данных, чем их количество. Из-за меньшего объема данных процесс дообучения требует меньше вычислительных ресурсов.

Изначальный успех GPT был обусловлен использованием тщательно отобранных образцов данных, созданных и размеченных людьми, предоставленных компаниями вроде Scale AI. Однако со временем сгенерированные человеком данные с трудом масштабируются.

Неотъемлемая роль синтетических данных в постобучении

Самой важной задачей в SFT является создание достаточно больших и высококачественных наборов данных в желаемых областях. Это позволяет модели лучше работать в определенных областях, таких как код, математика, рассуждения; благодаря передаче обучения имеются побочные эффекты, делая модель лучше и в других областях. Очевидно, что модели с сильными математическими и кодировочными навыками лучше справляются с общими рассуждениями, но это распространяется и на другие области — модели, обученные на китайском и английском языках, лучше справляются с английским, чем те, которые были обучены только на английском. Синтетические данные открыли измерение, в котором высококачественные данные могут быть получены с использованием контролируемой и немасштабируемой методологии для дообучения моделей на любые темы, если есть возможность их создать.

Интенсивное использование синтетических данных также стимулирует стремление к лучшим моделям. Например, OpenAI первой разработала GPT-4 и использовала её для создания лучших синтетических наборов данных, чем другие поставщики моделей — до тех пор, пока у них не появились модели аналогичного уровня. Именно это позволило многим открытым моделям и лабораториям из Китая быстро догнать лидеров, поскольку они обучались на синтетических данных от GPT-4.

Чем лучше базовая модель справляется с задачами оценки, тем лучше набор данных для обучения. Этому свойственны свои собственные законы масштабирования. Вот как мы получили «новый Claude 3.5 Sonnet». Anthropic завершил обучение Claude 3.5 Opus, и он показал себя хорошо, масштабируясь соответствующим образом (не обращайте внимания на сторонников отрицания масштабирования, которые утверждают обратное).

Однако Anthropic не выпустил его. Это связано с тем, что вместо публичного выпуска Anthropic использовал Claude 3.5 Opus для генерации синтетических данных и моделирования вознаграждений, чтобы значительно улучшить Claude 3.5 Sonnet наряду с пользовательскими данными. Затраты на вывод кардинально не изменились в отличие от производительности модели. Зачем выпускать 3.5 Opus, если с точки зрения затрат это экономически невыгодно по сравнению с выпуском 3.5 Sonnet с дальнейшим постобучением из указанного 3.5 Opus?

С большим количеством синтетических данных появляются лучшие модели. Лучшие модели предоставляют лучшие синтетические данные и действуют как лучшие судьи для фильтрации или оценки предпочтений. При использовании синтетических данных существует множество более мелких законов масштабирования, которые в совокупности подталкивают к более быстрой разработке лучших моделей.

Примеры синтетических данных

Выборка отбраковки

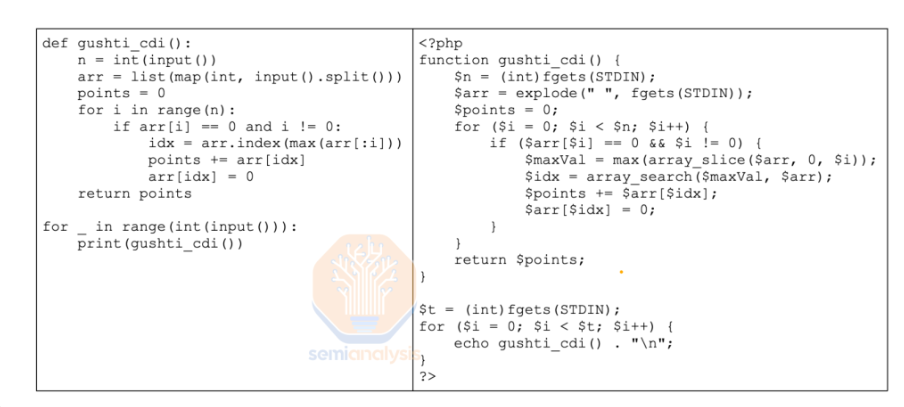

Пример области, где синтетические данные активно используются, — это генерация наборов данных кода. Обычно это делается путем обозначения различных задач программирования или подсказок в качестве начальных значений и побуждения модели генерировать вопросы, относящиеся к этим задачам.

Затем модель просят сгенерировать набор потенциальных решений. Решения, которые проходят соответствующие тесты или могут выполняться правильно, добавляются к обучающему набору данных, эффективно отфильтровывая некачественные образцы в процессе, называемом выборкой отбраковки (Rejection Sampling). Выборка отбраковки является важной частью процесса генерации синтетических данных, поскольку она гарантирует, что набор данных достаточно высокого качества, чтобы быть ценным во время Supervised Fine-Tuning (SFT) или обучения с подкреплением (Reinforcement Learning). Однако в результате многие из сгенерированных токенов выбрасываются, так как генерация синтетических данных требует много вычислений.

Эта методология построения синтетического набора данных для дообучения была принята многими крупными AI-лабораториями и используется для дообучения моделей Gemini, GPT, Llama и Claude.

Но выборка отбраковки может быть сложнее, чем кажется. В случае Llama модель была вынуждена пересмотреть свой ответ, если первоначальный ответ был неверным, и модель давала правильный ответ со второй попытки в 20% случаев. В качестве еще одной иллюстрации полезности синтетических данных команда Meta перевела код Python на PHP, обеспечив качество с помощью синтаксического анализа и выполнения, и ввела эти дополнительные данные в набор данных SFT, чтобы учесть отсутствие общедоступного кода PHP. Это эффективно демонстрирует, что синтетические данные используются для надежной и предсказуемой генерации полезных данных для недостаточно представленных областей.

Оценка модели другими моделями

Еще одна тенденция — использовать другую LLM в качестве судьи. В качестве выборки отбраковки Meta использовала другую, более раннюю версию Llama 3, выступая в качестве судьи для кода, который не был строго исполняемым (т. е. псевдокода), и оценивая результаты по принципу "зачет/незачет" с точки зрения корректности и стиля кода. В некоторых случаях выборка отбраковки выполняется с помощью различных моделей, работающих одновременно для оценки моделей. Хотя это обходится дешевле, чем человеческие данные, достаточно трудно справиться с таким набором автоматических судей.

Здесь важно отметить для всех методов выборки отбраковки — чем лучше модель «судьи», тем выше качество полученного набора данных. Несмотря на то, что этот цикл обратной связи был введен Meta в производство в этом году, он в течение года или двух до этого использовался Anthropic и OpenAI.

Длинные контекстные наборы данных

Другим примером использования синтетических данных являются размеры контекстов. Модели предварительно обучаются с ограниченными размерами контекста, поскольку большинство данных уже имеют малую длину контекста, а также потому что большая длина последовательности требует большего объема памяти для хранения кэшированных значений (KV Cache), что делает развертывание инфраструктуры обучения еще сложнее, чем оно есть. Такие модели, как Gemini, GPT и Claude, изначально предварительно обучаются с меньшей длиной последовательности, а затем впоследствии постобучаются для добавления более длинных контекстов.

Обычно людям сложно аннотировать длинные примеры контекста в данных SFT, поскольку существуют ограничения человеческих ресурсов для предоставления качественной аннотации. Чтение длинных фрагментов текста занимает много времени и утомительно. Синтетические данные появились как полезный и надежный способ решения этой проблемы.

Один из методов создания синтетических данных большой длины контекста заключается в использовании модели из более ранней контрольной точки и суммировании ею больших фрагментов текста, разбитых на фрагменты размером ее (в настоящее время небольшой) длины контекста. Эти сводки, включающие смоделированные вопросы и ответы, затем могут быть использованы для создания массива синтетических данных, которые затем могут быть использованы в SFT.

Другие примеры включают генерацию синтетических данных для прохождения сложных тестов, таких как задачи "поиск иголки в стоге сена". Существует множество более сложных типов синтетических данных, предназначенных для обучения моделей обобщению и пониманию информации в различных частях расширенного контекста.

Обучение с подкреплением

Обучение с подкреплением (RL) является ведущим методом для согласования и улучшения моделей.

Обучение с подкреплением (RL) — это когда агент (например, крупная языковая модель) обучается выполнять определенные действия и добиваться определенных результатов, максимизируя вознаграждения, которые даются либо за эти конкретные действия, либо за достижение определенного результата. Есть две стороны касательно RL: источник обратной связи и способ её использования. Первая касается того, как получать сигналы, а вторая — того, как использовать эти сигналы для обновления модели.

С подкреплением обучения крупная языковая модель, которую мы пытаемся оптимизировать, играет роль агента, который может выполнять набор действий, учитывая входные данные, и получать различные вознаграждения в зависимости от действия, которое он выполняет. Мы оптимизируем поведение этого агента в отношении наших целей подкрепления обучения, заставляя агента изучать действия, которые могут максимизировать ожидаемое кумулятивное вознаграждение.

Существует несколько основных подходов к интеграции обратной связи и определению действий, которые выполняет агент, — с использованием методов, на основе ценности (Value-based) или методов на основе политики (Policy-based), таких как оптимизация предпочтений (Direct Preference Optimization) и оптимизация политики в доверительной области (Trust Region Policy Optimization, TRPO), а также методы актёр-критик (Actor-Critic), которые комбинируют методы на основе политики и ценности. Proximal Policy Optimization (PPO) является ярким примером модели актера-критика, а более сложные ее вариации являются основным методом RL во всех основных лабораториях ИИ.

Методы, основанные на ценностях, определяют ценность достижения заданного состояния и определяют значения для каждого возможного состояния. Каждому состоянию присваивается значение, основанное на ожидаемой доходности, которую агент может получить, начав с этого состояния, а затем определяет свое действие на каждом шаге, основываясь на ценности каждого действия, доступного ему. Исторически, методы, основанные на ценностях, чаще использовались в RL, но современные приложения гораздо более эффективно работают с методами на основе политики.

В методах на основе политики агент управляется функцией политики, которая определяет набор действий для данного состояния, и назначает распределение вероятностей для этого набора действий. Действия, которые должны быть выполнены в данном состоянии, могут быть детерминированными, то есть нахождение в каждом состоянии всегда приведет к одному и тому же действию, или стохастическими, где распределение вероятностей описывает потенциальные действия в данном состоянии. Затем функция политики обучается направлять агента к действиям, которые максимизируют ожидаемое вознаграждение.

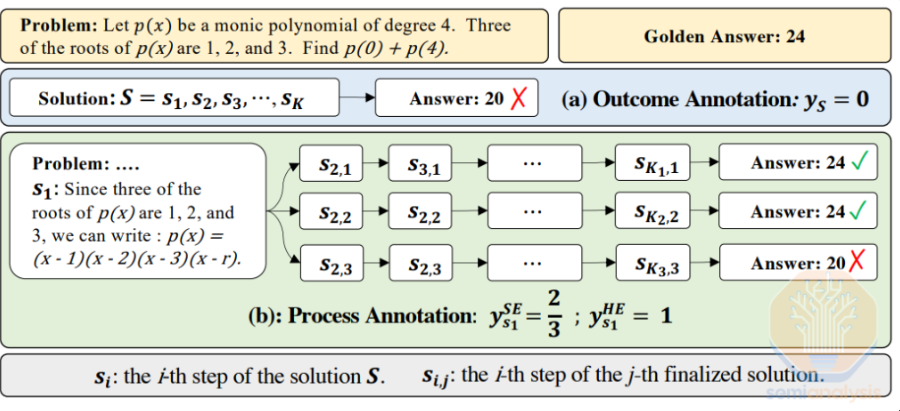

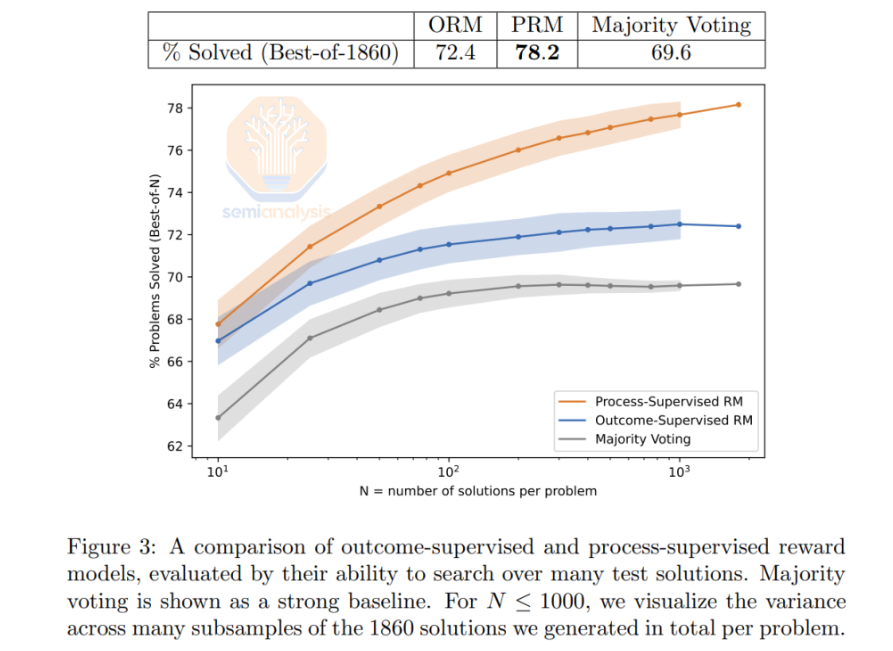

При использовании методов на основе политики в обучении с подкреплением, модель может либо оценить конечный результат данной задачи, чтобы определить вознаграждение в случае модели вознаграждения за результат (ORM), либо определить вознаграждение, оценивая каждый отдельный шаг в данном процессе, в случае модели вознаграждения за процесс (PRM). Использование PRM может быть особенно полезным при обучении моделей рассуждений - в то время как ORM может обнаружить, что цепочка рассуждений привела к неправильному ответу, PRM может сообщить вам, на каком шаге цепочки была ошибка.

Поскольку функция политики направляет действия агента на каждом шаге, она также является особенно полезной структурой для оптимизации поведения агентов/моделей на промежуточных шагах процесса вывода.

Модели вознаграждения за результат и модели вознаграждения за процесс часто используются в алгоритме Proximal Policy Optimization (PPO), который широко применяется в обучении с подкреплением для поэтапного улучшения модели политики с целью максимизации суммарного вознаграждения и оптимизации LLM для достижения заданной цели. Использование ORM и PRM с PPO особенно важно при обучении многошаговых моделей рассуждений, которые в настоящее время являются ключевым направлением в сообществе. Ниже мы опишем, как это делается для o1 Pro.

Proximal Policy Optimization (PPO)

Proximal Policy Optimization (PPO) может использоваться как для выравнивания, так и для тонкой настройки (Fine-Tuning), но она гораздо лучше подходит и чаще используется во время обучения с подкреплением, используемого во время выравнивания.

В контексте PPO, «Policy» (Политика) относится к использованию модели политики для определения действий агента или модели, «Proximal» (Приближённость) указывает на методологию алгоритма, заключающуюся в том, что политика обновляется постепенно, а «Optimization» (Оптимизация) — это процесс поэтапного улучшения политики с использованием обратной связи от модели вознаграждения для улучшения модели политики, что, в свою очередь, оптимизирует ожидаемое кумулятивное вознаграждение.

Выше мы в основном обсуждали методы, основанные на политиках, но PPO включает в свою реализацию как методы, основанные на политиках, так и методы, основанные на ценностях. Таким образом, можно сказать, что PPO использует метод актера-критика. Актер управляется моделью, основанной на политике, которая определяет, какое действие предпринять для данного состояния (т. е. метод, основанный на политиках), а Критик оценивает предпринятое действие в соответствии с функцией ценности (метод, основанный на ценностях). Таким образом, Актер и Критик работают вместе итеративным образом.

Следовательно, максимизация целевой функции PPO подтолкнет политику в направлении предпочтения действий, которые соответствуют более высокому значению функции преимущества.

RLHF

Обучение с подкреплением и обратной связью от человека (RLHF) является основным методом согласования LLM; оно сделало LLM полезными и стало ведущим фактором для взрывного роста ChatGPT. Обычно оно использует обучение на основе политики, когда модель вознаграждения, которая обучается на основе обратной связи от человека, используется для обновления политики, которая управляет поведением модели.

С помощью RLHF люди-аннотаторы просматривают выборку ответов на подсказки и ранжируют свои предпочтения для одного ответа по сравнению с другим. Целью здесь является сбор важных данных о том, какие ответы люди предпочитают. Эти данные о предпочтениях затем используются для обучения модели вознаграждения, которая пытается угадать среднее предпочтение маркировщика для заданного вывода модели. Другими словами, обученная модель вознаграждения действует как Критик в структуре «Актер-Критик».

Обученная модель вознаграждения оценивает это действие по сравнению с человеческими предпочтениями, на которых она обучена, и насколько лучше или хуже действие по сравнению со средним действием. Затем обратная связь от этой модели вознаграждения действует для согласования модели Актера, гарантируя, что она выполняет действия (генерирует токены) в соответствии с желаемой политикой.

Как обсуждалось выше, PPO используется для итеративного обновления функции политики языковой модели, обеспечивая стабильное обучение при предотвращении резких изменений в политике. Крупномасштабный PPO для лабораторий ИИ использует несколько взвешенных моделей вознаграждения для определенных аспектов, таких как полезность, правдивость и безопасность.

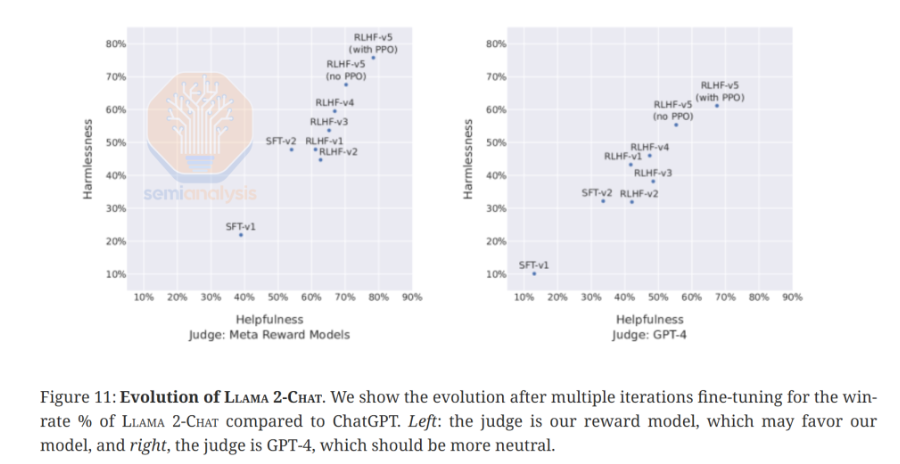

В целом, RLHF позволяет моделям лучше справляться с задачами, которые волнуют реальных пользователей и по которым они предоставили данные о своих предпочтениях. Llama 2-Chat от Meta достигла гораздо лучшей производительности по таким факторам, как полезность и безвредность после раундов RLHF. Дополнительные вычисления, используемые для масштабирования моделей во время RL, дают четкие результаты. Потенциальные преимущества использования синтетических данных вместо обратной связи, созданной человеком, и большее полагание на ИИ для обратной связи также могут оправдать использование ещё большего объёма вычислений.

Однако у RLHF есть существенные ограничения. Во-первых, выполнение всего жизненного цикла RLHF может быть очень медленным, поскольку необходимо время, чтобы предоставить различные сгенерированные ответы людям-респондентам, обычно через компанию ИИ, вставляющую такие подсказки для обратной связи при обслуживании своих моделей.

Даже при большой базе пользователей сбор большого объема данных о предпочтениях сложен и дорог — Meta потратила от 10 до 20 миллионов долларов на данные о предпочтениях для Llama 2, что больше, чем стоимость самого времени вычислений.

RLHF по своей сути сложно масштабировать, особенно в областях, где нет огромного количества существующих данных. Аннотация человеком также является дорогой. Именно поэтому многие AI-компании переходят к использованию обучения с подкреплением с обратной связью от ИИ (RLAIF) в процессе обучения.

Более крупные компании, занимающиеся искусственным интеллектом, имеют здесь явное преимущество. Claude, Gemini и ChatGPT просят пользователей оставить отзыв об ответах моделей, которые они размещают. Например, иногда ChatGPT просит выбрать, какой из двух ответов вы предпочитаете. Этот процесс фактически бесплатно собирает лучший источник обратной связи (непосредственно от пользователей). Поскольку OpenAI имеет огромную клиентскую базу из более чем 300 миллионов пользователей, он может собирать достаточно обратной связи для улучшения моделей.

Поставщики с меньшим количеством пользователей или использующие платформу, которая менее благоприятна для предоставления пользователями обратной связи, должны прибегать к другим методам, таким как DPO вместо PPO. Прямая оптимизация предпочтений (DPO) — еще один метод, часто обсуждаемый вместе с RLHF, хотя большинство технически не относят его к методу обучения с подкреплением.

DPO полностью отказывается от обучения модели вознаграждения и вместо этого использует оптимизацию для прямой корректировки политики, чтобы максимизировать вероятность того, что политика заставляет модель выдавать предпочтительные результаты на основе данных о предпочтениях человека. Оптимизация работает с использованием бинарной кросс-энтропийной потери, которая сравнивает отношения вероятностей между текущей моделью и эталонной моделью (обычно той же моделью до тонкой настройки). DPO гарантирует, что модель учится отдавать предпочтение желаемым ответам, оставаясь при этом близкой к поведению эталонной модели.

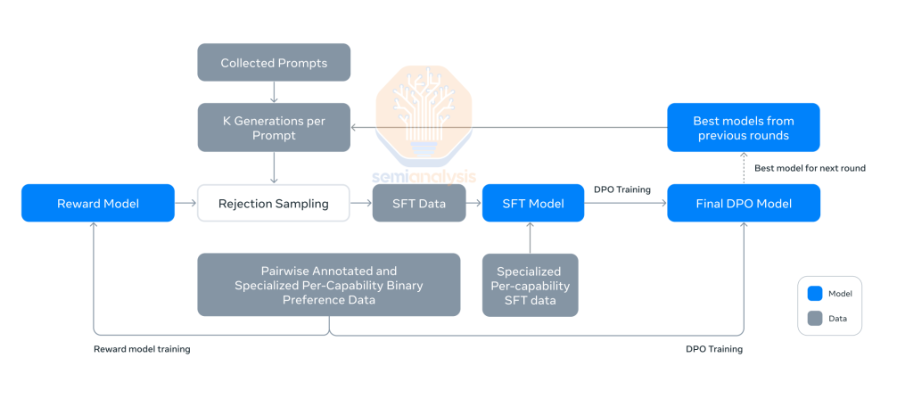

Более простой подход, используемый в DPO, может достигать сопоставимых или лучших результатов, чем RLHF с использованием полной модели вознаграждения, при этом он менее подвержен сбоям и проще в реализации. Ярким примером достоинств этого подхода является то, что Llama 3 не подвергалась RLHF и прошла через DPO. Meta обнаружила, что в случае Llama 3 DPO была более эффективной и стабильной, чем PPO, и использовала меньше вычислений. Но использование DPO означает, что качество набора данных предпочтений имеет первостепенное значение, заслуживая особого внимания к тому, как эти данные собираются и обрабатываются.

В конечном итоге Meta извлекла урок, который другие лаборатории уже знали: DPO не масштабируется так же хорошо, как PPO, — и чтобы продолжить улучшать свое постобучение, они должны обратиться к RLAIF. Это было продемонстрировано в релизе новейшей LLAMA 3.3.

RLAIF

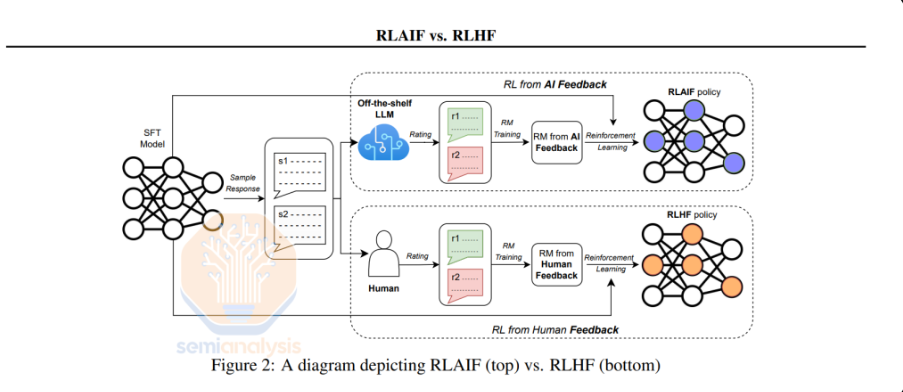

Вместо того, чтобы полагаться на обратную связь человека для обучения модели вознаграждения, обучение с подкреплением с обратной связью ИИ (RLAIF) заменяет обратную связь человека другой моделью. Модель вознаграждения обучается на основе обратной связи, генерируемой ИИ — обычно это некая форма модели или алгоритма оценки, которая будет оценивать данные завершения и определять вознаграждение соответствующим образом.

В общем, ничего принципиально нового по сравнению с RLHF в RLAIF нет, но это вносит значительные изменения. Аннотации могут быть выполнены быстро, а запросы могут быть сгенерированы синтетически, чтобы инициировать обучение модели с подкреплением в тех областях, где требуется дополнительное обучение или данные.

Кроме того, предоставление обратной связи по типичным задачам в области математики, науки и общего знания, RLAIF также позволяет быстро генерировать обратную связь для решения более тонких задач, таких как этические дилеммы, культурные нормы и социальные взаимодействия, а также ранжировать эти ответы с помощью другой LLM. Это позволяет обеспечить более широкий охват тем для выравнивания модели и дает возможность тренерам моделей быстро начать обучение по этим темам, не ожидая сбора человеческой обратной связи.

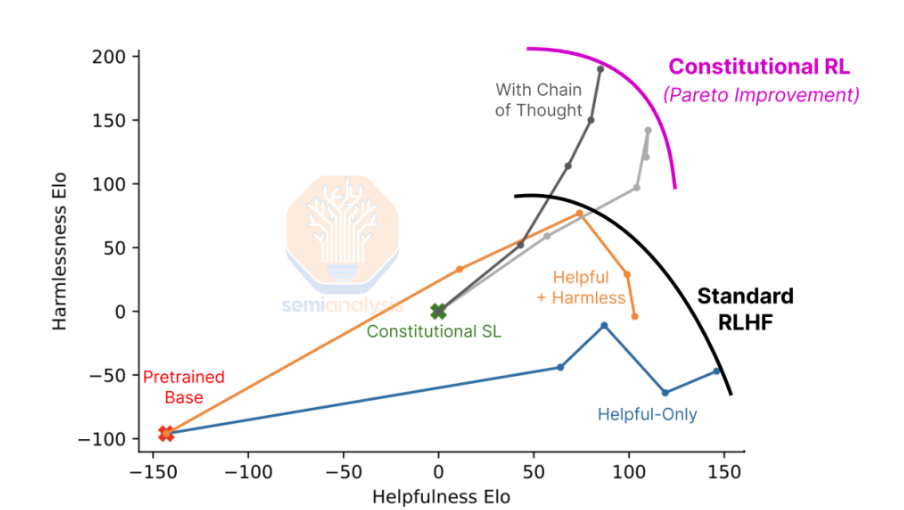

Уникальным применением RLAIF является конституционный ИИ от Anthropic. Конституционный ИИ работает в два этапа. На первом этапе базовая модель критикует и пересматривает свои собственные результаты в соответствии с набором конституционных принципов, написанных людьми. Эти первоначальные ответы могут быть токсичными или бесполезными. Затем ответы непрерывно пересматриваются с использованием различных принципов из конституции. Это создает набор данных пар пересмотра и подсказок, которые затем используются для тонкой настройки модели с помощью метода контролируемого дообучения (SFT).

Второй этап процесса для конституционного ИИ похож на RLHF, но без данных о предпочтениях человека, обеспечивающих обратную связь относительно безвредности. ИИ оценивает пары ответов из модели предыдущего этапа в соответствии с конституционными принципами, которые по сути являются моделями множественного вознаграждения. Сгенерированные ИИ предпочтения безвредности объединяются с данными обратной связи человека для полезности, чтобы обучить гибридную модель предпочтений («гибридное» означает, что модель включает человеческие данные). Наконец, модель с первого этапа дообучается с использованием RL, где эта модель предпочтений служит сигналом вознаграждения.

Самым примечательным наблюдением этого подхода является то, что он масштабируется во многих различных областях — если есть модель, которая хороша в ранжировании ответов на основе того, какой из них более точный с научной точки зрения, то в дополнение к способности определять безвредность, эта модель может использоваться для оптимизации для научно точных ответов.

RL также является ключевой частью разработки моделей рассуждений, которые используют цепочку мыслей (CoT).

Модели рассуждений и цепочка мыслей (CoT)

Математика — это фундаментальная логика и рассуждения в инженерии, строительстве и проектировании систем. Математика выделяется как целевая дисциплина для тонкой настройки моделей, поскольку на продвинутых уровнях сложности у тренеров моделей нет достаточно сложных подсказок. Один из способов решения этой проблемы — платить высококвалифицированным людям за создание подсказок или их генерацию внутри компании. Эффективное решение математических задач с помощью рассуждений требует четко сформулированной и правильной цепочки мыслей, на которой может учиться модель.

Некоторые математические возможности могут быть улучшены с помощью таких инструментов, как доступ к интерпретатору кода, позволяющий моделям генерировать и выполнять код на таких языках, как Python, который может помочь в решении некоторых математических задач, но кода недостаточно для решения многих задач, особенно самых сложных математических задач. В настоящее время огромное количество усилий направлено на обучение моделей рассуждений решению сложных математических задач.

Модели можно побуждать генерировать цепочки мыслей из коробки, но результаты могут быть ненадежными, поскольку ошибка на одном шаге цепочки приведет к неправильному конечному решению. Однако в o1 Pro есть несколько мер предосторожности, чтобы предотвратить это. Другая проблема заключается в том, что даже новейшие модели могут галлюцинировать и фальсифицировать информацию, что может легко усугубить ошибку на одном из этапов рассуждения.

Модель, настроенная на проведение рассуждения с использованием цепочки мыслей, может решить многие из вышеперечисленных проблем. В этом подходе обучение с подкреплением используется для согласования поведения модели с подходом цепочки мыслей.

Этот процесс применяет обучение с подкреплением для согласования поведения базового LLM с подходом цепочки мыслей и повышения его точности с использованием нескольких других отдельных моделей и LLM.

Первый независимый LLM, который мы обсудим, — это Generator, который обучен генерировать решения, обоснованные на нескольких этапах. Как правило, Generator отделен от базового LLM, поскольку он настроен специально для задачи генерации этих шагов рассуждения, в то время как базовый LLM обычно настроен для общих задач.

Второй LLM — это Модель верификатора, которая отвечает за оценку того, являются ли решения, созданные Generator, правильными или нет, и предоставляет соответствующее вознаграждение.

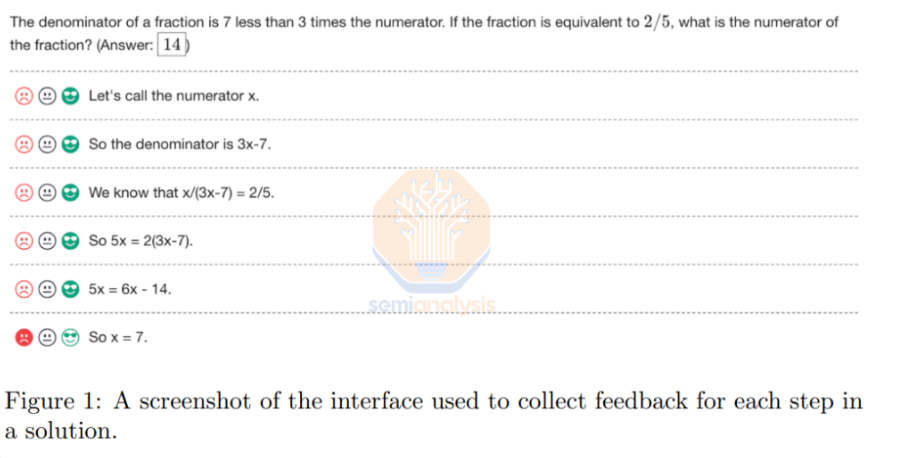

Модели верификаторов можно обучать с помощью человеческой аннотации, посредством автоматической аннотации процессов или с помощью автоматических верификаторов. В статье OpenAI «Давайте проверим шаг за шагом» исследователи представили набор данных PRM800K для наблюдения за процессом, в котором люди, размечающие данные, аннотируют 800 000 этапов процесса, которые являются частью 75 000 решений на 12 000 вопросов из математического набора данных, которые выводятся генератором, как обсуждалось в статье.

Сбор таких аннотаций связан с немалыми затратами. В одной статье по математике несколько студентов университета, которым дали час на решение 20 задач, набрали от 40% до 90%, причем 90%-ный результат получил трехкратный золотой медалист IMO. В статье OpenAI отмечается, что из-за высокой стоимости было бы непрактично создать достаточно большой набор данных, ориентированный на аннотацию процессов (PRM), чтобы сопоставить его по объёму с набором данных, ориентированным на результаты (ORM), для прямого сравнения этих подходов.

Альтернативой является использование автоматической аннотации процесса или поиск автоматических верификаторов.

Автоматические верификаторы — это система или модель, которая в идеале может быстро и легко проверить, является ли решение заданной задачи правильным. Для кода это может быть просто фактическое выполнение стоимости для проверки того, что он дает желаемые результаты, в то время как для математики это может быть оценка заданной функции или использование доказывающего средства, такого как LEAN, для проверки корректности. Но использование автоматических верификаторов может быть не таким «автоматическим», как кажется — создание зависимостей от внешних систем может добавить накладные расходы, которые могут снизить эффективность обучения. Еще автоматические верификаторы иногда могут потребовать времени для запуска.

Автоматическая аннотация процесса может генерировать эту пошаговую аннотацию процесса. Вместо того, чтобы человек оценивал промежуточный шаг, модель Completer используется для создания нескольких различных путей шагов рассуждения. В статье «Math-Shepherd» используется автоматическая аннотация процесса — генерируется ряд путей, а затем эти пути оцениваются либо путем маркировки процесса как хорошего шага рассуждения, если он приводит к правильному окончательному ответу (т. е. жесткая оценка — Hard Estimation), либо путем назначения баллов на основе частоты, с которой шаг приводит к правильному решению (т. е. мягкая оценка — Soft Estimation).

Четвертой моделью является модель вознаграждения, которая обучается на основе меток аннотации процесса.

Подводя итог нашему предыдущему объяснению, можно сказать, что существует два типа моделей вознаграждения: те, которые предоставляют вознаграждение на основе результата, модель вознаграждения за результат (ORM), и те, которые предоставляют вознаграждение на основе процесса, модели вознаграждения за процесс (PRM). ORM обычно работают, ранжируя множество различных ответов, которые предоставляет модель, а затем выбирая наиболее ранжированный. PRM, напротив, оценивают и присваивают оценку каждому шагу цепочки рассуждений и предоставляют вознаграждение на основе этой оценки, и по этой причине они обычно являются предпочтительными при обучении моделей цепочки мыслей. В статье «Давайте проверим шаг за шагом» продемонстрированы более сильные результаты для PRM по сравнению с ORM. С учетом сказанного, OpenAI по-прежнему больше полагается на ORM.

В «Math-Shepherd» обучение с подкреплением через Proximal Policy Optimization (PPO) используется для обучения итоговой языковой модели (LLM) желаемому поведению в формате цепочки рассуждений.

Масштабирование на этапе вывода

Релиз предварительной версии OpenAI o1 привлек внимание отрасли к появлению нового закона масштабирования — чем больше вычислений во время теста (т. е. вычислений во время вывода), тем лучше ответ, и попытки использовать это измерение масштабирования находятся на переломном этапе.

При получении запросов, будь то простые или сложные вопросы, традиционные LLM будут непрерывно генерировать токены, не отслеживая промежуточные шаги, пока не решат, что достигли ответа.

Но как объяснялось выше, модели рассуждений, напротив, разбивают ответ на дискретное количество шагов рассуждений, называемых цепочкой мыслей, прежде чем предоставить ответ пользователю. Модели рассуждений могут откатываться назад, если они приходят к нелогичному выводу, признавая, что была допущена ошибка или определенный подход зашел в тупик, и пересматривать предыдущие шаги, чтобы вернуть цепочку рассуждений на правильный путь.

Выпуск моделей рассуждений имеет два важных последствия: во-первых, значительное улучшение производительности модели для сложных оценок, и во-вторых, осознание того, что это улучшение производительности модели масштабируется с вычислениями во время теста и надежно распространяется на LLM.

Масштабирование во время теста — не новая концепция. В настольных играх и покере идея расширения вычислений во время теста существует уже некоторое время. Например, AlphaGo, система DeepMind для игры в Go, во время теста использует поиск по дереву Монте-Карло (Monte Carlo Tree Search), чтобы решить, какие ходы следует использовать. Если лишить ее возможности поиска во время вывода, её рейтинг Elo упадет с ~5200 до 3000 (уровень лучших людей — около ~3800). Вычисления во время вывода позволили достичь сверхчеловеческих достижений в Go.

С большими вычислениями модели рассуждений могут продумывать больше шагов и повышать вероятность получения правильного ответа. Сегодня возможности рассуждений ограничены возможностями систем вывода, поскольку большая длина контекста, необходимая для моделей рассуждений, значительно увеличивает требования к памяти и вычислениям.

Это означает, что операторы систем вывода для моделей рассуждений ограничивают длину цепочек рассуждений, чтобы поддерживать разумную длину контекста и снизить затраты, обеспечивая при этом экономически выгодное обслуживание достаточного числа пользователей с приемлемой задержкой токен-к-токену. Из этого следует, что сегодняшние модели рассуждений работают с одной рукой, связанной за спиной, и они могут значительно масштабироваться по производительности, поскольку на рынке появляются более мощные системы вывода, такие как GB200 NVL72. Когда это станет экономически выгодным, разрешение o1 регулировать длину своей цепочки рассуждений и используемых вычислений станет эффективным способом реализовать потенциал масштабирования вычислений на этапе вывода.

Как мы видим из оценок и графика ниже, с одной попытки GPT-4o превосходит другие модели. Самый наивный способ масштабировать вычисления во время теста — увеличить количество одновременно запускаемых образцов. В статье «Большие языковые обезьяны» говорится, что простое повторение выборки может масштабировать вычисления на этапе вывода и давать гораздо лучшие результаты.

Возможно, это один из самых основных способов выполнения поиска. Генерация большего количества образцов обеспечивает больший охват, что определяется как вероятность получения правильного ответа хотя бы в одном из образцов (т. е. pass@k). Можно утверждать, что предоставление меньшим моделям возможности многократно размышлять над одной задачей может быть более точным и экономически выгодным решением. Однако для успешного выполнения этой задачи потребуется эффективный верификатор, который сможет определить, когда нам удалось метафорически создать полное собрание сочинений Шекспира.

Масштабирование вычислений на этапе вывода через поиск

Поиск — это еще одно измерение масштабирования, которое не используется в OpenAI o1, но используется в o1 Pro. o1 не оценивает множественные пути рассуждений во время теста (т. е. во время вывода) и не проводит никакого поиска вообще. В видео Саши Раш «Рассуждения о масштабировании вычислений на этапе вывода (o1)» говорится о полезном обсуждении и иллюстрации поиска, а также затрагиваются другие темы, связанные с моделями рассуждений.

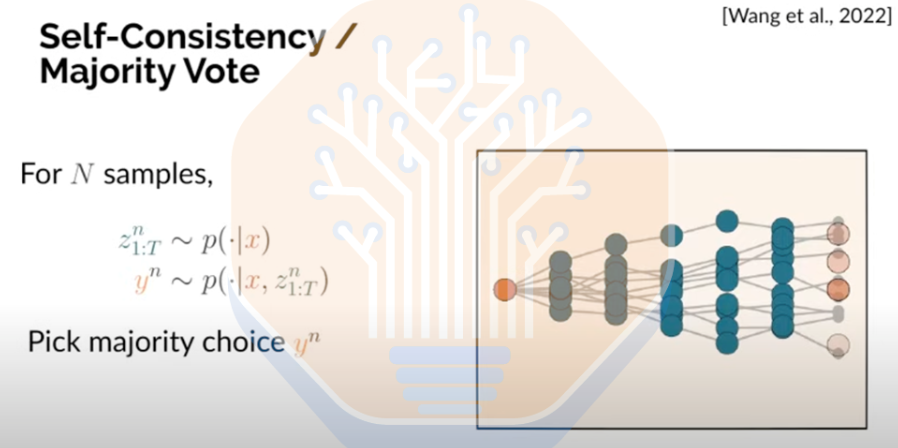

Самосогласованность/голосование большинства — это одна из методологий поиска, в которой мы запускаем подсказку через модель несколько раз, тем самым генерируя несколько ответов, а затем выбираем правильный ответ, который появляется чаще всего среди заданного количества образцов.

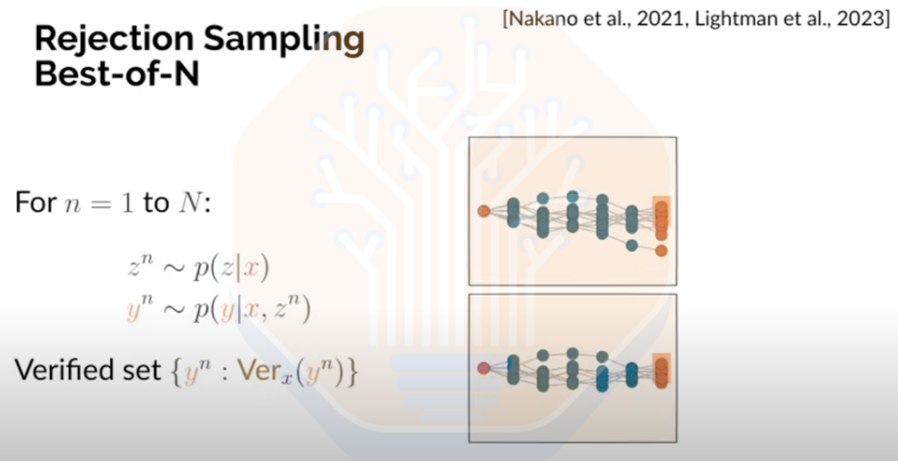

Best-of-N Sampling — еще один метод, при котором мы генерируем N решений для конкретной подсказки и затем используем модель-верификатор для идентификации цепочек рассуждений, которые привели к правильному ответу. Этот подход обычно ограничен областями, где возможна верификация (например, судоку, но не эссе) и зависит от эффективности модели-верификатора.

Monte Carlo roll-outs — этот метод основан на Best-of-N. Здесь мы оцениваем заданный промежуточный шаг, генерируя несколько путей для завершения цепочки мыслей, начиная с этого промежуточного шага. Эта оценка может помочь нам решить, продолжать ли этот шаг или двигаться вперед с предполагаемым будущим шагом, улучшая нашу общую цепочку мыслей.

Мы обсудили основы RL, синтетические данные, цепочки мыслей, вычисления на этапе вывода и другие концепции; в следующий раз мы рассмотрим, что OpenAI сделала с o1 и o1 Pro как во время обучения, так и во время вывода. Мы также обсудим токеномику вычислений на этапе вывода, включая стоимость, масштабирование KV Cache, пакетирование и многое другое. И наконец, мы объясним, что OpenAI будет делать дальше с Orion и почему слухи о его провале не соответствуют действительности.

Автор: kucev