Примечание переводчика: на Хабре уже есть два перевода про Stable Diffusion, но один описывает частный случай, а другой ощущается для меня слишком «маркетинговым». Поэтому решил, что этот текст из Ars Technica здесь будет полезен.

Генерация изображений с помощью AI пришла по-настоящему. Опенсорсная модель для синтеза изображений Stable Diffusion позволяет любому обладателю компьютера с хорошей видеокартой творить практически любую визуальную реальность, какую сможет выдумать. Она может имитировать практически любой визуальный стиль, и если задать ей фразу-описание, результаты возникают на экране словно магия.

Одни художники восхищаются открывшимися возможностями, другие недовольны, а общество в целом пока вроде бы не курсе той стремительно развивающейся технологической революции, которая происходит в сообществах на Twitter, Discord и GitHub. Возможно, синтез изображений приносит настолько же большие возможности, как изобретение камеры — или даже создание самого визуального искусства. Даже наше восприятие истории под вопросом, в зависимости от того, как всё утрясётся. В любом случае, Stable Diffusion возглавляет новую волну творческих инструментов, основанных на глубоком обучении, которые намерены революционизировать создание визуального медиаконтента.

Взлёт синтеза изображений с глубоким обучением

Stable Diffusion возник благодаря Эмаду Мостаку из Лондона (ранее работавшему менеджером хедж-фонда), который решил с помощью своей компании Stability AI нести в массы новые применения глубокого обучения. Но корни современного синтеза изображений уходят в 2014-й, и Stable Diffusion не стала первой моделью синтеза изображений (ISM), наделавшей шума в этом году.

В апреле 2022-го OpenAI представили DALL-E 2. Она шокировала соцсети способностью трансформировать словесное описание сцены («prompt», запрос) с помощью мириада разных визуальных стилей — фантастических, фотореалистичных, даже будничных. Люди с привилегией доступа к этому закрытому инструменту создавали астронавтов на лошадях, плюшевых мишек за покупкой хлеба в древнем Египте, современные скульптуры в стиле знаменитых художников, и многое другое.

Вскоре после DALL-E 2 компании-гиганты анонсировали собственные AI-модели для превращения текста в изображение. Midjourney, доступная в качестве Discord-сервера с марта 2022-го и открытая публике несколькими месяцами позже, берёт плату за доступ и достигает похожих эффектов, но с более живописным и иллюстративным качеством по умолчанию.

А затем пришла Stable Diffusion. 22 августа в Stability AI выпустили свою опенсорсную модель генерации изображений, возможно, не уступающую DALL-E 2 в качестве. А также запустила собственный коммерческий сайт DreamStudio, продающий доступ к компьютерному времени для создания изображений со Stable Diffusion. В отличие от DALL-E 2, любой может использовать это, а поскольку код Stable Diffusion открыт, проекты могут основываться на ней с довольно небольшими ограничениями.

За одну только прошедшую неделю появились десятки проектов, которые развивают Stable Diffusion в совершенно новых направлениях. И люди достигли неожиданных результатов с помощью техники img2img, которая «проапгрейдила» картинки из игр для MS-DOS, превратила графику Minecraft в реалистичную, перевела сцену из «Аладдина» в 3D, сделала из детских каракуль проработанные иллюстрации, а также многое другое. Синтез изображений может дать массовой аудитории возможность хорошо визуализировать идеи, снижая барьеры для входа, а одновременно с этим дать новые возможности художникам, примерно как Adobe Photoshop сделал в 90-х.

Вы можете сами локально запустить Stable Diffusion, если проделаете серию из нескольких хитроумных шагов. На протяжении прошедших двух недель мы запускали её на Windows-компьютере с Nvidia RTX 3060 12GB GPU. Он может генерировать изображение с разрешением 512x512 примерно за 10 секунд. На 3090 Ti это время сокращается до четырёх секунд. Интерфейсы бурно развиваются, перейдя от грубых консольных команд и ноутбуков Google Colab к более отполированным (но всё ещё сложным) GUI, а скоро всё отполируют ещё сильнее. Так что, если вы не технически продвинутый пользователь, подождите: более простые решения скоро будут. А в крайнем случае можно попробовать онлайн-демо.

Как работает Stable Diffusion

В целом новая волна ISM использует технику под названием latent diffusion. Грубо говоря, модель учится узнавать знакомые формы среди чистого шума, а затем фокусируется на этих формах, если они совпадают со словами в запросе.

Для начала человек или группа людей, тренирующих модель, собирают изображения с метаданными (вроде alt-тегов и подписей в интернете) и формируют крупный датасет. В случае Stable Diffusion компания Stability AI использовала подмножество сета LAION-5B, а это, по сути, громадный скраппинг 5 миллиардов публично доступных в интернете изображений. Недавний анализ датасета показал, что многие из изображений там взяты с сайтов вроде Pinterest, DeviantArt и даже Getty Images. В результате Stable Diffusion впитала стили многих живущих сейчас художников, и некоторые из них публично высказываются против такой практики. Больше об этом ниже.

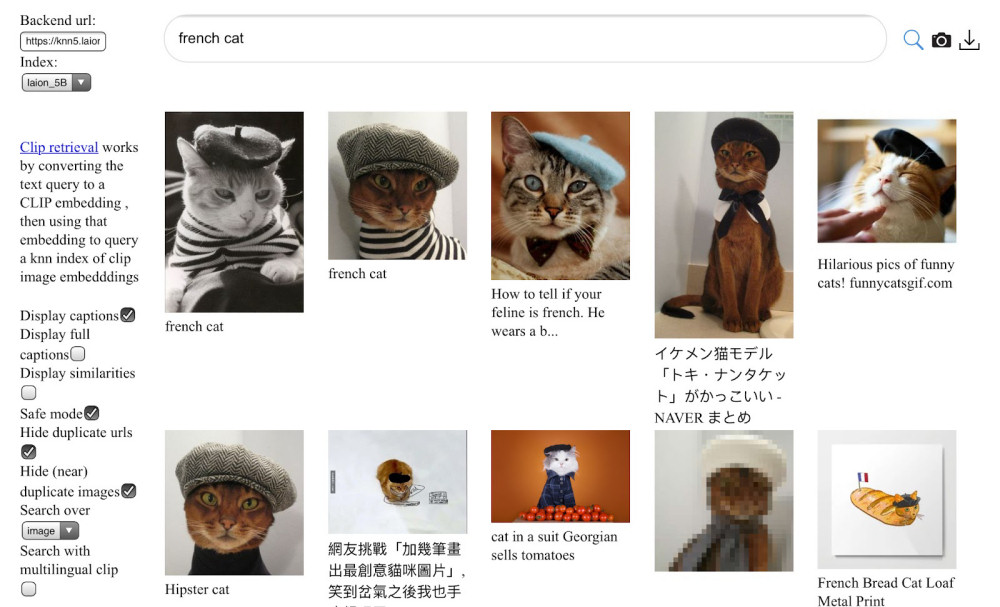

Далее модель обучается на датасете с помощью сотен высокопроизводительных GPU вроде Nvidia A100. По словам Мостака, тренировка Stable Diffusion обошлась уже примерно в $600 000 (стоимость тренировки других ISM обычно оценивают в миллионы долларов). Во время процесса обучения модель ассоциирует слова с изображениями благодаря технике под названием CLIP (Contrastive Language–Image Pre-training), которая была изобретена в OpenAI и анонсирована лишь в прошлом году.

В процессе тренировки ISM с использованием latent diffusion изучает статистические ассоциации, когда пиксели определённых цветов обычно соотносятся друг с другом определённым образом для каждой темы. Так что она не «понимает» их взаимоотношения на высоком уровне, но результаты всё равно могут быть ошеломительными и удивительными, там могут быть выводы и стилевые сочетания, которые выглядят очень разумными. После завершения процесса обучения модель никогда не повторяет изображения из исходного сета, но может создавать новые комбинации стилей, основываясь на полученных знаниях. Результаты могут быть очень увлекательными.

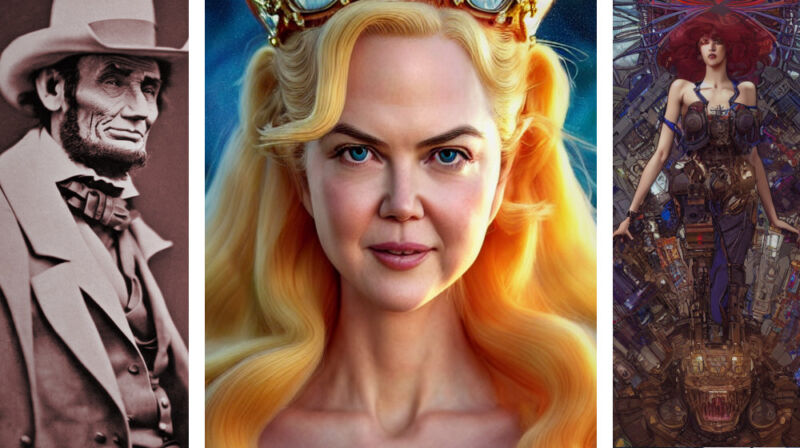

В данный момент Stable Diffusion плевать, если у изображённого человека три руки, две головы или шесть пальцев. Так что, если вы не волшебник в создании удачных запросов (иногда AI-художники называют такое «prompt engineering»), вероятно, вы будете создавать множество изображений и дальше выбирать лучшие из них. Учтите, что чем сильнее запрос совпадает с описаниями известных изображений из датасета, тем скорее вы получите желаемый результат. В будущем, вероятно, модели достаточно улучшатся, чтобы выбирать лучшие результаты пришлось поменьше — или какой-то внутренний фильтр будет выбирать за нас.

Этические и юридические опасения

Как вскользь говорилось выше, публичный релиз Stable Diffusion заставил бить тревогу некоторых людей, опасающихся его культурных и экономических последствий. В отличие от DALL-E 2, тренировочные данные Stable Diffusion («веса») доступны любому для использования без каких-либо строгих ограничений. Официальный релиз Stable Diffusion (и Dream Studio) включают автоматический фильтр NSFW (наготы) и добавляют невидимый вотермарк для трекинга, но эти ограничения можно легко обойти, когда код открыт для всех. Это значит, что Stable Diffusion можно использовать для создания изображений, которые OpenAI сейчас блокирует в DALL-E 2: пропаганда, жестокие изображения, порнография, изображения с потенциальным нарушением авторских прав, дипфейки знаменитостей и так далее. Более того, уже существуют частные Discord-сервера, целиком посвящённые порнографическим изображениям от модели.

Справедливости ради, лицензия Stable Diffusion официально запрещает многие из этих использований, но когда код и веса находятся в общем доступе, проконтролировать это крайне затруднительно, если не невозможно. В ответ на эти опасения Мостак сказал нам, что по его мнению, преимущества открытого доступа к такому инструменту (когда его можно изучать) перевешивают недостатки. В коротком интервью он сказал нам: «Мы верим в личную ответственность за свои действия. Мы включили в проект этичную политику использования и инструменты для уменьшения вреда».

Также, как уже сказано, Stable Diffusion навлёк гнев художников в Twitter из-за способности имитировать стиль живых авторов. (И несмотря на утверждения в некоторых вирусных твитах, Stability AI никогда не рекламировала эту возможность. Один из самых популярных твитов ошибочно процитировал независимое исследование). В тот сет, на котором обучали Stable Diffusion, включены миллионы произведений современных художников без консультации с ними, что вызывает этические вопросы об авторстве и копирайте. Собирать эти данные выглядит законным, если смотреть на легальный прецедент в США. Но существует мнение, что закон отстаёт от развивающихся технологий, которые меняют представление о том, как собранные данные могут быть использованы.

В результате, если технологию синтеза в будущем станут использовать крупные корпорации (что вполне может произойти скоро: «У нас коллаборативные взаимоотношения с Adobe», говорит Мостак), компании могут решить тренировать свои модели на «чистых» датасетах, где контент либо лицензированный, либо добровольно отданный авторами, либо перешедший в общественное достояние. Это может позволить избежать некоторых этических вопросов, даже если технически веб-скреппинг вполне легален. Мы спросили Мостака, есть ли у него связанные с этим планы, он сказал: «Stability работает над рядом разных моделей. И все модели сами по себе, и все, с кем у нас коллаборация, легальны в своих юрисдикциях».

Другой вопрос, связанный с моделями от всех вендоров — культурные особенности. Поскольку эти ISM сейчас работают, изучая картинки и метаданные из интернета, они впитывают социальные и культурные стереотипы, представленные в этом датасете. Например, ещё когда Stable Diffusion проходит бета-тестирование на Discord-сервере, тестировщики обнаружили, что почти любой запрос со словами «beautiful woman» в результатах ненамеренно содержал какое-либо обнажение — что отражает то, как западное общество зачастую изображает женщин в интернете. Другие культурные и расистские стереотипы также присутствуют в обучающих данных для ISM, так что исследователи предупреждают, что их не следует использовать в продакшене без значительных ограничений. Вероятно, это одна из причин того, почему другие мощные модели вроде DALL-E 2 и Imagen от Google всё ещё недоступны публично.

Хотя опасения о качестве датасета и встроенных в него предубеждениях сильны среди некоторых AI-исследователей, интернет остаётся самым большим источником изображений с метаданными. Этот клад доступен свободно, так что он всегда останется манящим для разработчиков ISM. Попытки вручную прописать описания для миллионов или миллиардов изображений, чтобы создать новый этичный датасет — вероятно, экономически недостижимая сейчас вещь, так что пока эту технологию делают возможной интернет-данные со всеми их предубеждениями. Поскольку среди разных культур не существует универсального видения мира, вероятно, разные использующие технологию сообщества будут по-разному оценивать то, до какой степени модели синтеза изображения фильтруют или интерпретируют определённые идеи.

Что дальше

Если исторические тенденции о чём-то нам говорят, то задачи, требующие сейчас мощных GPU, в будущем могут добраться до смартфонов. «Вероятно, Stable Diffusion будет запускаться на телефонах в течение года», — сказал нам Мостак. Также новые техники позволят со временем и тренировать эти модели на менее дорогом оборудовании. Мы скоро сможем увидеть взрыв в творчестве, основанном на AI.

Stable Diffusion и другие модели уже начинают применять для динамической генерации видео и манипуляций, так что можно ожидать появления фотореалистичной видеогенерации по текстовому запросу. Далее логично распространить эти возможности на аудио и музыку, видеоигры и 3D VR-опыт. Вскоре AI сможет проделывать большую часть тяжёлой работы просто по нескольким подсказкам. Представьте бесконечные развлечения, которые генерируются в реальном времени по запросу. «Я ожидаю, что это будет полностью мультимодальным, — говорит Мостак, — так что можно будет создать всё, что только можешь вообразить, как с Holodeck в "Стар Треке"».

ISM — это также мощнейший способ сжатия изображений: Stable Diffusion берёт сотни миллионов картинок и сжимает знания о них в файл размером 4.2 гигабайта. С правильным запросом и настройками определённые сгенерированные изображения могут быть воспроизведены детерминированно. Можно представить использование этой технологии в будущем для сжатия, например, 8K-фильма в несколько мегабайт текста. Когда это случится, каждый сможет так же сочинять свои собственные фильмы. Применения этой технологии сейчас только начинают открываться, так что это может завести нас далеко и в таких направлениях, о которых мы сейчас не подумаем.

Реалистичные модели синтеза потенциально опасны по уже упомянутым причинам, вроде создания пропаганды или дезинформации, переписывания истории, ускорения политических разделений, атак на людей и имперсонации, разрушения юридической значимости фото- или видеосвидетельств. В будущем с AI как мы сможем знать, было ли любое видео снято на реальную камеру, общаемся ли мы с реальным человеком? К этим вопросам Мостак подходит в целом обнадёживающе: «Будут новые системы верификации, а открытые релизы вроде нашего подтолкнут публику к обсуждению и развитию этих инструментов».

Разумеется, это проще сказать, чем сделать. Но также легко и бояться нового. Несмотря на все наши попытки, сложно знать точно, как синтез изображений и другие AI-технологии повлияют на нас как общество, пока мы не увидим их широкого применения. В итоге человечество приспособится, даже если наши культурные представления радикально поменяются в процессе. Это случалось раньше, поэтому древнегреческий философ Гераклит сказал «единственное постоянное — это изменения».

А теперь благодаря Stable Diffusion у нас есть фото того, как он это говорит.

Автор: Евгений Трифонов