Привет, читатели. В данном посте я хочу рассказать вам о проекте, над которым я работал последние 4 месяца.

Речь идет о технологичном медиаспектакле, который создавался в рамках новой сцены Александринского театра. Главными героями спектакля являются эмоциональное состояние и мысли перформера. Для начала, официальное описание из соц. сетей:

Медиаспектакль «Нейроинтегрум» — экспериментальный проект, представляющий редкое на сегодняшней отечественной сцене направление science art, или научного искусства, использующего и осмысляющего достижения современных технологий. Спектакль, создающийся под руководством известного петербургского медиа-художника Юрия Дидевича, исследует один из ключевых сюжетов культуры рубежа веков — взаимодействие человека и машины: попытка наладить культурный диалог между ними — сверхсюжет «Нейроинтегрума». В спектакле используются биопотенциалы головного исполнителя (электроэнцефалограмма ЭЭГ) для управления аудиовизуальными алгоритмами постановки.

«Нейроинтегрум» — первый театральный проект, реализованный на базе Медиацентра Новой сцены Александринского театра.

Для тех, кто заинтересовался, прошу под кат. Эксклюзивно для читательов будет несколько фоточек рабочего процесса.

Суть

Медиаспектакль «Нейроинтегрум» поднимает вопрос о вариантах взаимодействия человека, компьютера и интерфейсов, о ролевом диапазоне каждого из них.

Звук и изображение на сцене генерируются в реальном времени специально написанным для спектакля софтом. Они задают динамическую систему координат, относительно которой рассматриваются события, совпадения, динамика и драматургия. Управляющим элементом спектакля является эмоциональное состояние перформера, которое, посредством информационно-энергетического обмена с компьютером, управляет звуковыми и визуальными медиа. В результате реакции перформера на аудиовизуальные события, источником которых является он сам, происходит биологическая обратная связь.

Что же предстваляет из себя «Нейроинтегрум»

Для считывания эмоционального состояния перформера используется нейроинтерфейс Emotiv Epoc Research Edition. Его SDK позволяет получать параметры эмоционального состояния, такие как эмоциональное возбуждение и фрустрация, а также научиться нескольким мысленным командам, которые можно назначить на управление какими-либо параметрами системы. В сети можно нагуглить, например, как инвалид управляет креслом силой мысли. На фото ниже перформер Саша Румянцева заставляет двигаться 3D кубик во время одной из тренировок. Также на экране можно заметить графики с показаниями электрических потенциалов

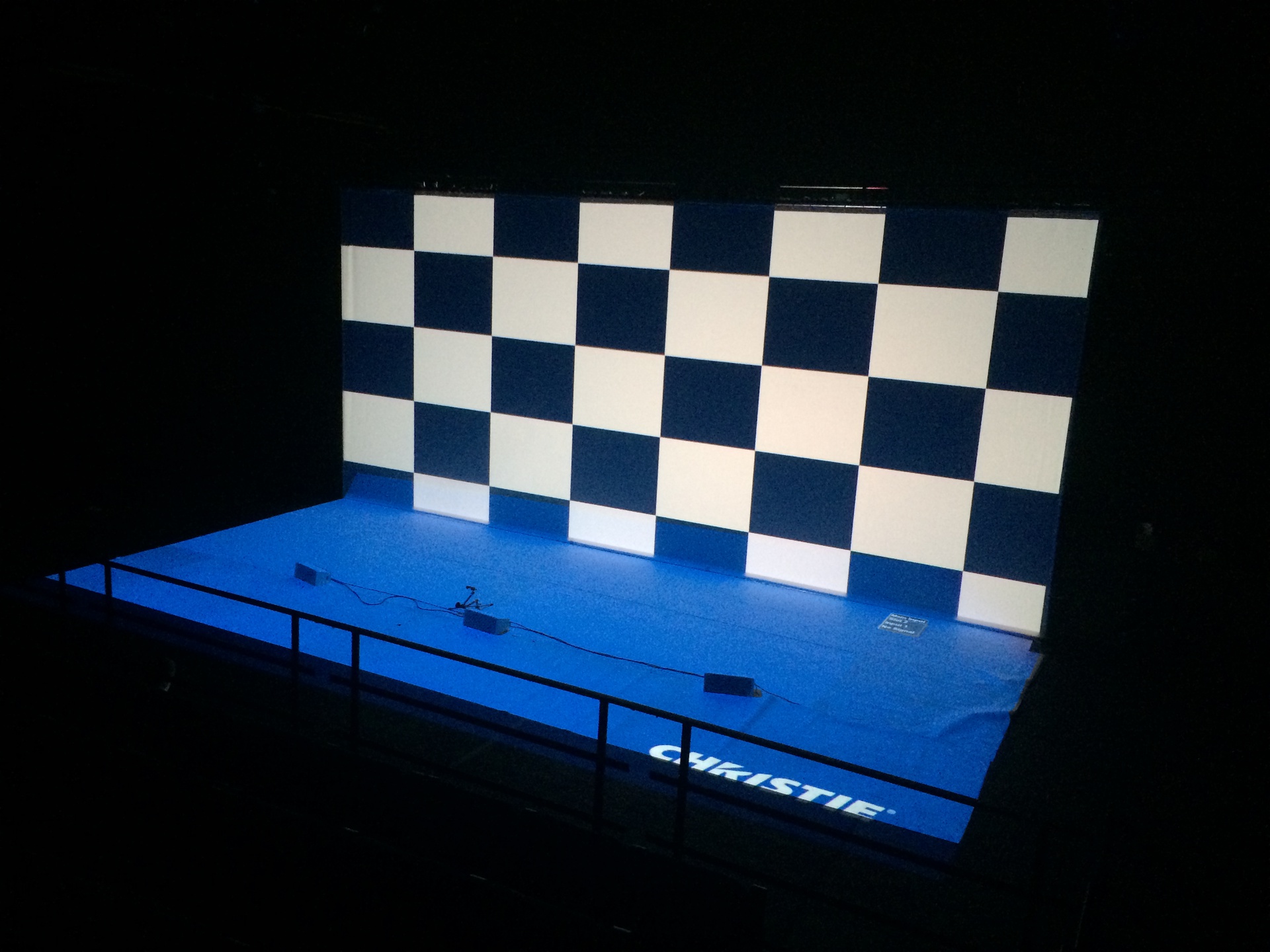

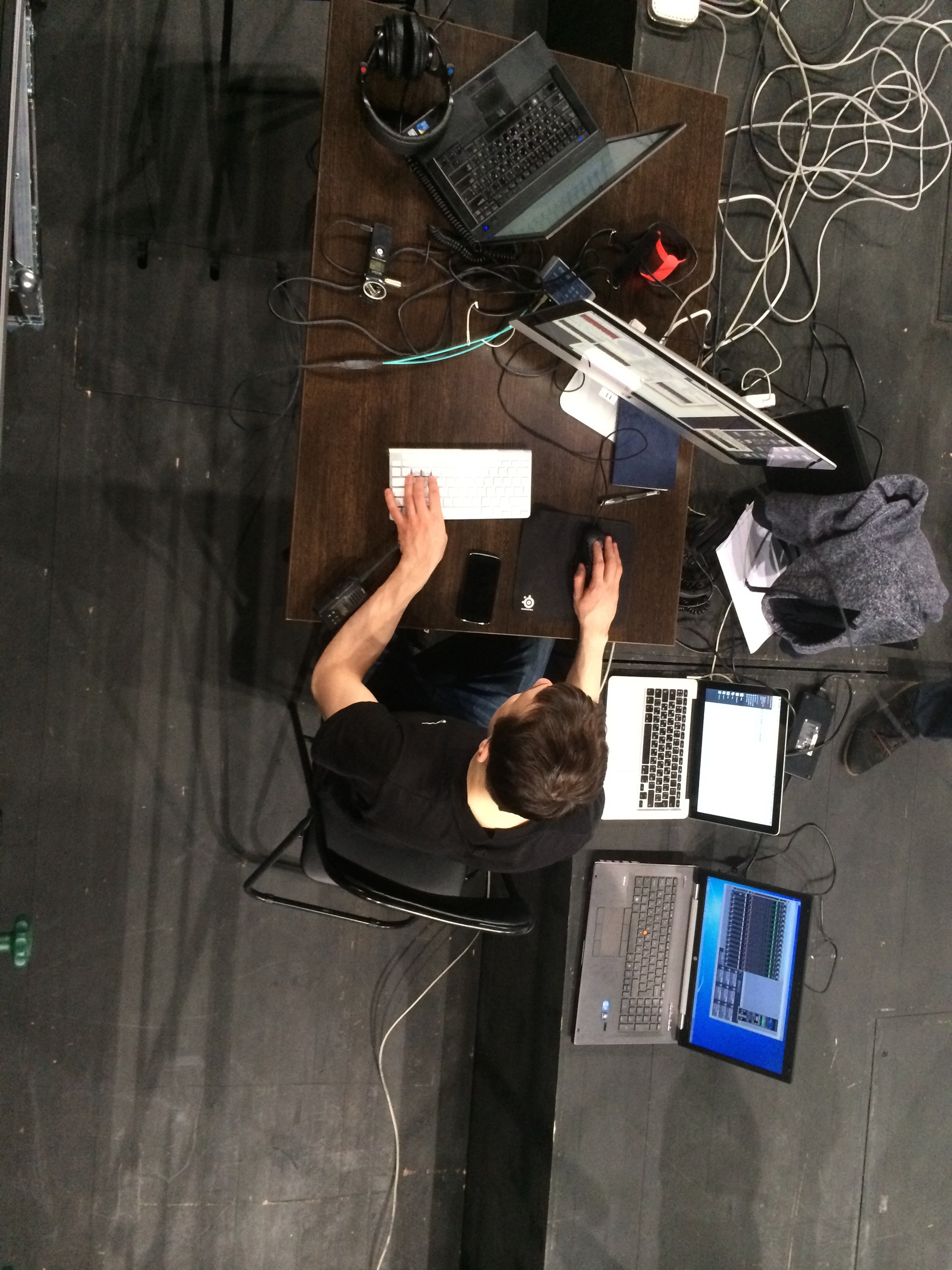

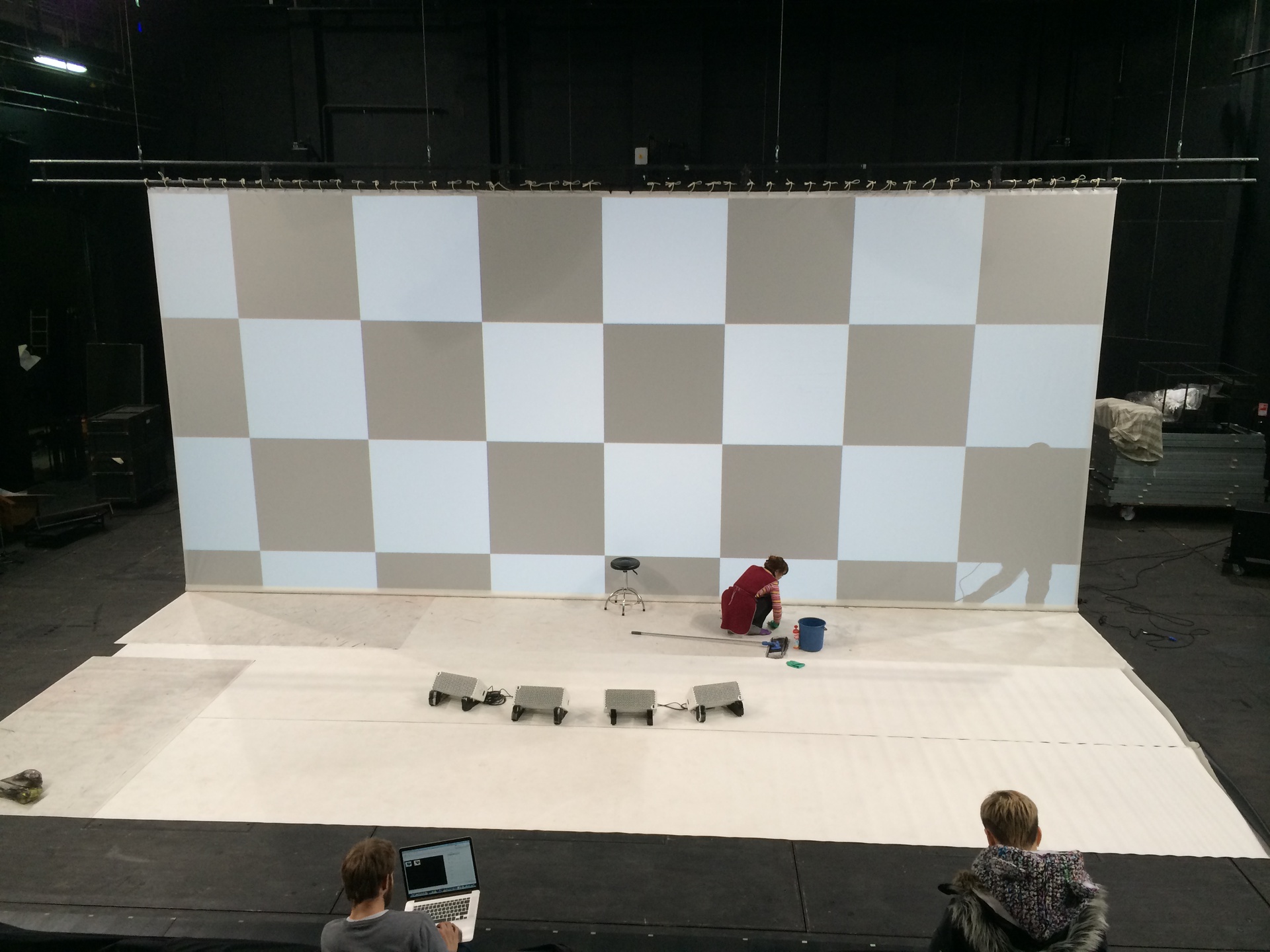

Сама сцена представляет из себя два экрана, размером 10х4,5 метра, для проекций графики (я уже говорил, что мы не используем предзаписанное видео и генерируем графику в рилтайм?), отдельно проекцию на силуэт перформера, 14 каналов звука, 2 сабвуфера, ИК-камеру, Kinect, а также имеется осветительный прибор Clay Paky A.leda Wash K20, который интерактивно управляется головой Саши в одной из сцен. Все это добро управляется с четырех компьютеров: 2 PC для генерации проекций (на пол, на экран обратной проекции, и на силуэт Саши), 1 PC (вернее, iMac с установленным Windows) для работы с нейроинтерфейсом и кинектом, а также 1 Mac для для генерации звука. И да, звук тоже генерируется в реальном времени, включая surround штуки.

Инструменты

Расскажу немного более подробно о технической стороне. Софт для графики был написан на C++ с использованием фреймворка OpenFrameworks. Для задач, связанных с подсвечиванием силуэта перформера используется OpenCV, с помощью которой обрабатывается изображение, поступающее с ИК-камеры. Ниже представлена фоточка, где видно аналоговую камеру и ИК прожектор:

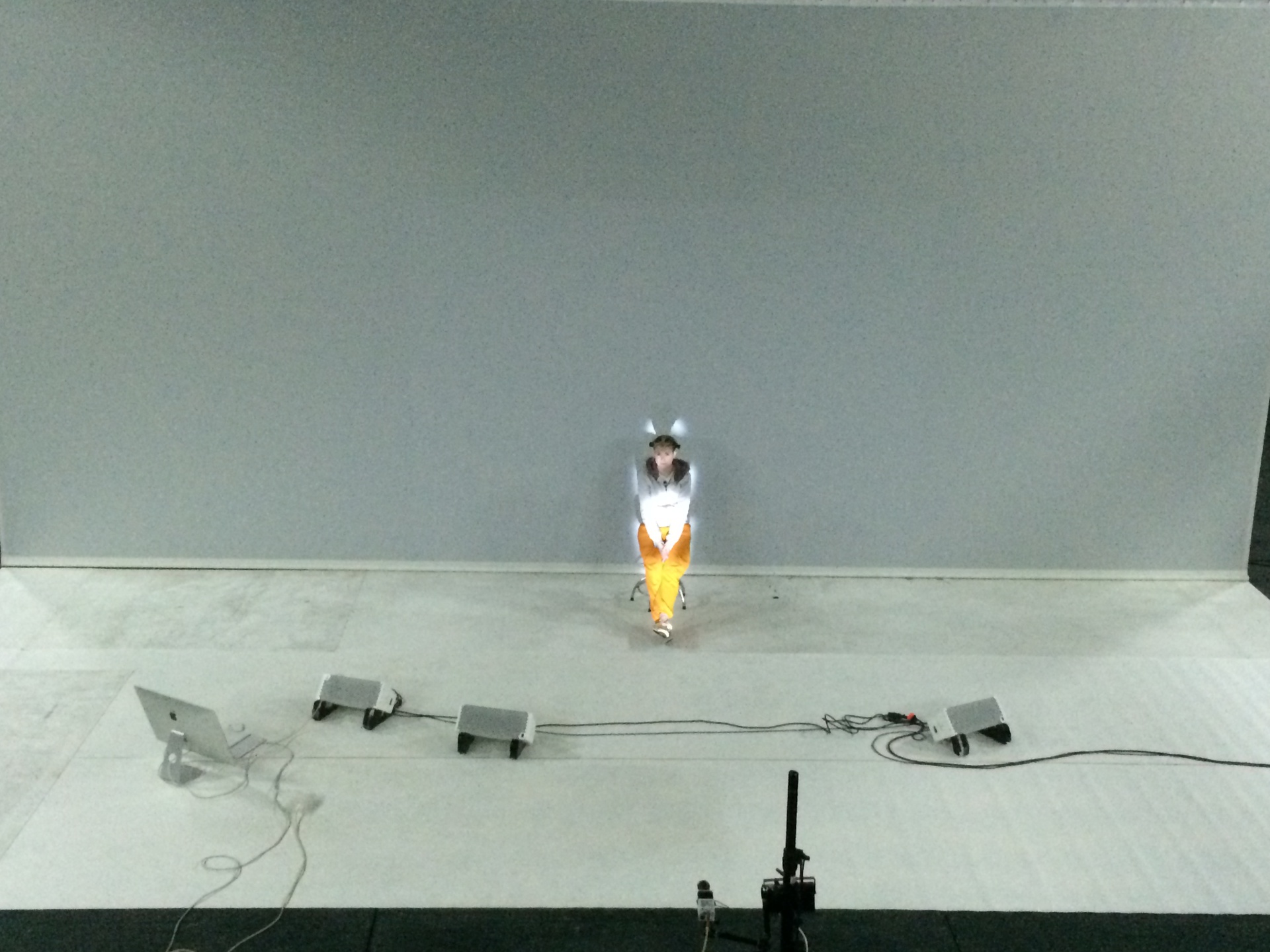

Ниже видно, как работает подсветка силуэта. Неравномерность подсветки (верхняя часть тела не подсвечивается) связана с тем, что «домашняя» одежда Саши плохо отражает ИК-излучение. Для спектакля, само собой, шился специальный костюм из ткани, которую одобрили мы, то есть программисты.

Kinect используется для распознавания некоторых жестов:

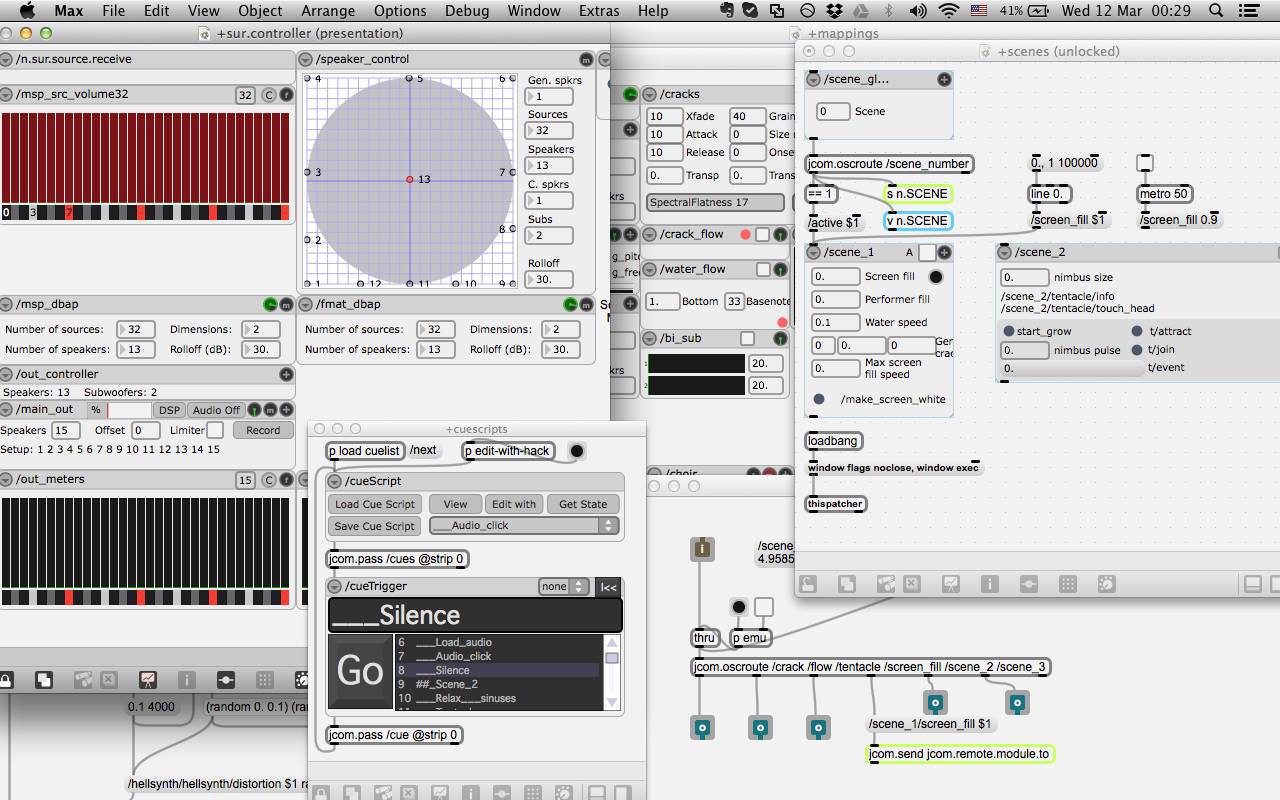

Перейдем к звуку. Софт для звука сделан в Max/MSP. Это среда визуального программирования для создания интерактивных аудиовизуальных приложений. История Max/MSP начинается в конце 80-х годов в небезызвестном парижском Институте исследования координации и акустики IRCAM (я как-то давно писал обзор этой среды). Звуковой патч «Нейроинтегрума» выглядит примерно так:

Из этого патча звук по оптике через RME MADIface направляется в микшер Yamaha M7CL. На следующем фото Я и Маша, очень толковая девушка-звукорежиссер Александринки:

Eсли вы заметили на одном из предыдущих фото, то в центре сцены также располагаются динамики. Эта «фишка» восходит корнями к системе ”Acousmonium“, разработанной учениками Пьера Шеффера, в 70-х годах в паржиском центре GRM (кстати, в конце июня в медиа-студии Александринки планируется проведение воркшопа автора австрийского Акусмониума Томаса Горбаха). Она позволяет создавать ощущение, что звук уходит в центр сцены.

Помимо того, что звук в спектакле принципиально пространственный, он также и интерактивный. Никаких аблетонов и аудио-проигрывателей. Для того, чтобы этого добиться, из графической программы постоянно передается информация о том, что рисуется в данный момент, и на основании этого уже происходит озвучивание графического элемента. Например, скажу по секрету, в первой сцене рисуется большое количество однотипных графических объектов. И по каждому такому объекту по сети передается информация о его местоположении и проценте роста — все это испольузется для того, чтобы озвучить отдельно каждый такой элемент и направить его в соответствующую точку пространственной картины звука. Звук же влияет на состояние перформера, которое уже влияет на графику.

Когда и где

Мероприятие начинается в 19:30 и состоит из трех частей: 1) показ фильма о работе над спектаклем, 2) сам спектакль и 3) открытое обсуждение, где вы сможете задать любые вопросы авторам.

Кроме того, перед каждым мероприятием в 18:00 в фойе новой сцены будет новая лекция на тему технологического искусства. Врод на лекцию бесплатный.

Ближайшие показы будут проводиться 3, 4 и 5-го апреля по адресу СПб, наб. р. Фонтанки, 49а.

Уже точно известно, что 3-го числа будет проводиться лекция Любви Бугаевой «Нейрокино и нейролитература». По приведенной ссылке вы сможете записаться на мероприятие.

Обращаю внимание, в спектакле присутствуют громкий звук и стробоскопические эффекты, поэтому эпилептикам присутствовать на мероприятии не рекомендуется.

Группы спектакля в соц. сетях: vk, facebook.

Фото процесса

Для хабра выкладываю несколько фоточек процесса.

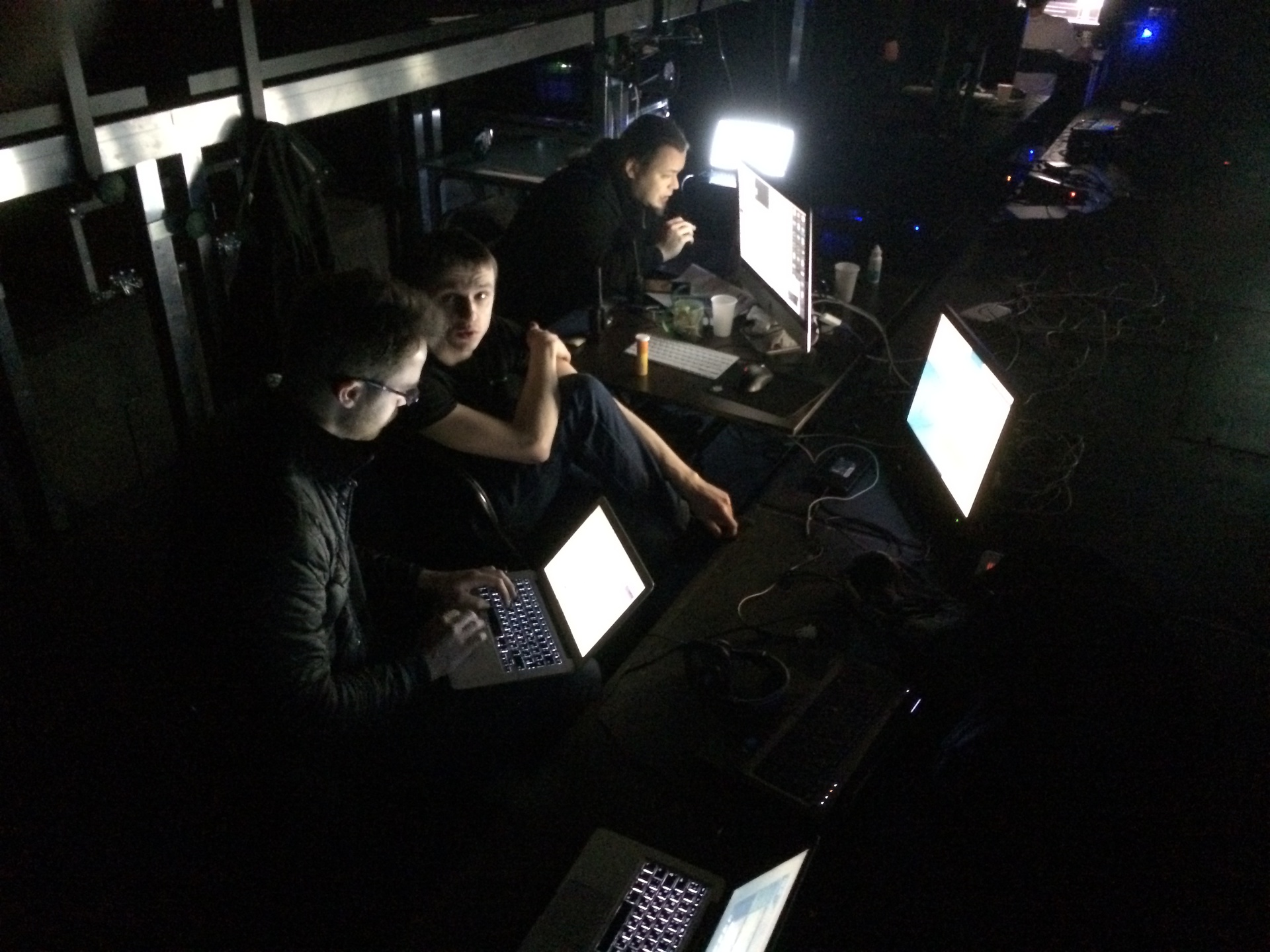

Слева сидит мой друг, специалист по компьютерным сетям, настраивает сеть для управления световыми приборами программно по протоколу ArtNet:

Ниже я и Леша Олейников. Сидим, сняв тапочки, и греем ноги на батарее:

Автор: oscii