Во время тестирования СХД специалисты часто встречаются с проблемами в производительности в связи с нюансами настройки всего комплекса. Для нагрузочного тестирования СХД не достаточно только лишь запустить симулятор нагрузки, необходимо настроить систему хранения, сеть и хост. Основная масса настроек, как правило, выполняется именно на хосте.

Целью данной статьи помощь системным администраторам и системным интеграторам в понимании настроек и нюансов при тестировании СХД NetApp. Хочу также отметить, что в этой статье не было задачи в получении максимально возможной производительности контроллеров NetApp FAS 2240, так как на момент тестирования демо оборудования не было достаточного количества дисков (144 максимум) для СХД, а также в наличии был только один сервер. Т.е. максимальная производительность здесь рассматривается в контексте конкретной конфигурации демо стенда, другими словами при большем количестве дисков, серверов и подключений по сети возможно получить результаты ещё лучше с теми же контроллерами 2240. Хотя все графики с результатами производительности взяты с конфигураций СХД использующих в тестах контроллеры 2240.

Ниже приведено комплексное описание нагрузочного тестирования СХД: настройки симулятора нагрузки IOMeter, методика настройка хоста и СХД NetApp FAS, снятие статистики нагрузки, а также интерпретация полученных результатов. На примере существующего демо стенда будет рассмотрены методы настройки всех его компонент, а также других возможных вариантов конфигураций с использованием NetApp FAS.

Демо Оборудование

NetApp FAS HA2240-2 с 4xFC8 портами 24x600х10к SAS, ONTAP 7-Mode 8.2

SAN свич

Cisco UCS C210 intel Xeon EM64T 64-bit 2x6 ядер 1,999ГГцб 32ГБ ОЗУ, VMWare ESXi 5.1

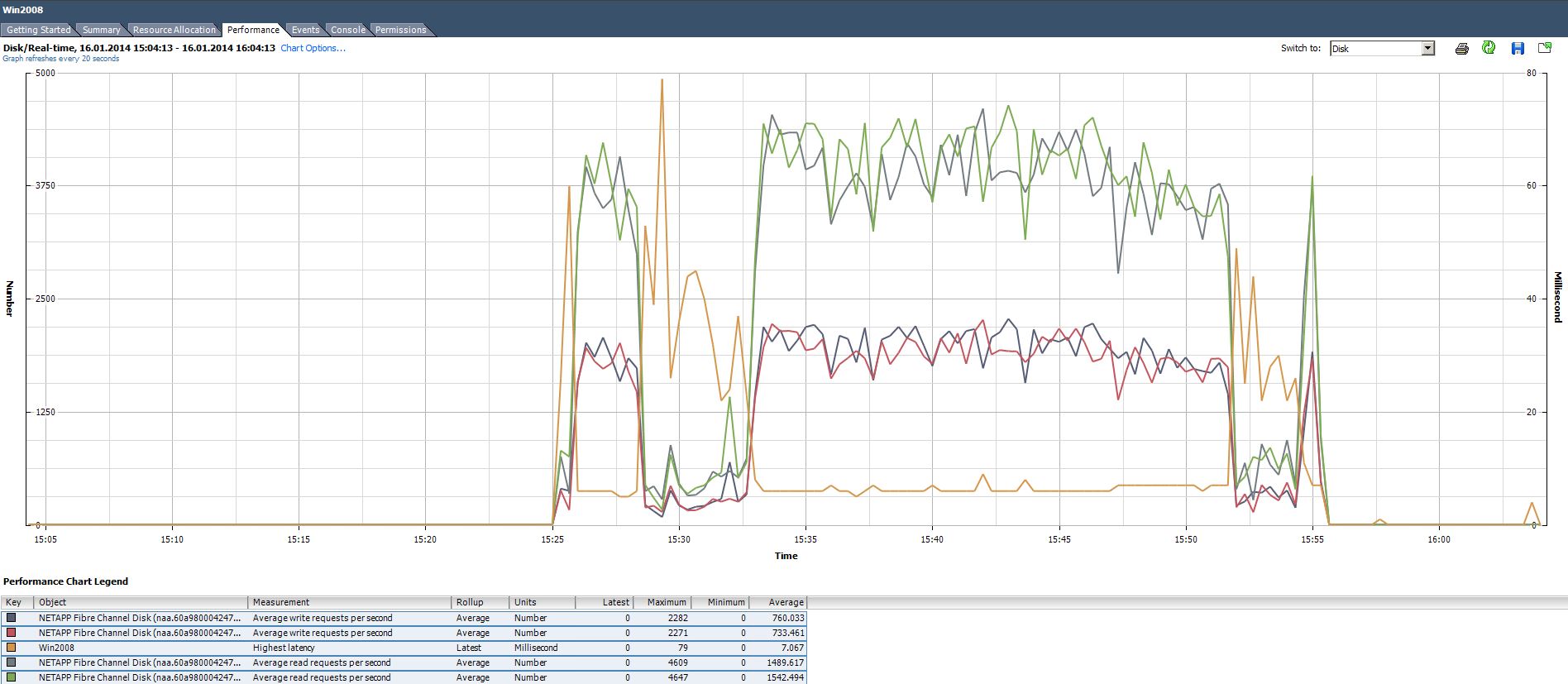

Виртуальная машина с Windows 2008 R2 x64 RDM подключением к LUN.

СХД

Все диски поделены поровну между контроллерами: 12ть одному и 12ть другому. На каждом наборе дисков создан один агрегат aggr0, на каждом агрегате присутствует один системный раздел vol0 и один раздел vol1 занимающий всё свободное пространство на агрегате, создан один лун на каждом разделе занимающий всё доступное свободное на нём. Как правило рекомендуется создавать максимально большой агрегат из максимально длинных рейд групп. При создании луна выбиралась геометрия соответствующая хосту к которому будет презентован LUN.

SAN сеть

Для мониторинга и траблшутинга SAN коммутатора удобно использовать бесплатную утилиту Brocade SANHealth. Засорившийся оптико-волоконный разъём тоже может приводить к проблемам в производительности, опять таки из реальной жизни: драйвер мультипасинга с включённой политикой Round-Robin из-за битого линка создавались огромные очереди на HBA адаптере, были большие задержки в системе ввода-вывода и наблюдалась высокая утилизация CPU.

Также не забывайте что FC линк, к примеру, 4G может физически пропускать не более 500 MB/s, а при генерации большего трафика вы также заметите повышение утилизации CPU.

SAN Multipathing

В случае подключения LUN на прямую к Windows, желательно установить NetApp DSM MPIO.

В случае же использования виртуализации с RDM или VMFS, необходимо настроить Multipathing на гипервизоре.

Multipathing должен быть с одним предпочтительным путём — путь к LUN через контроллер на котором он расположен. Сообщения в консоли СХД FCP Partner Path Misconfigured будут говорить о неправильно настроенном ALUA или MPIO. Это важный параметр, не стоит его игнорировать, так как был один реальный случай, когда взбесившийся драйвер мультипасинга безостановочно переключался между путями создавая таким образом большие очереди системе ввода-вывода хоста.

Хост ESXi

Отдавать гостевой ОС все ресурсы сервера не стоит, во первых гипервизору нужно оставить минимум 4ГБ ОЗУ, во вторых иногда наблюдается обратный эффект при добавлении ресурсов гостевой ОС, это нужно подбирать эмпирическим путём.

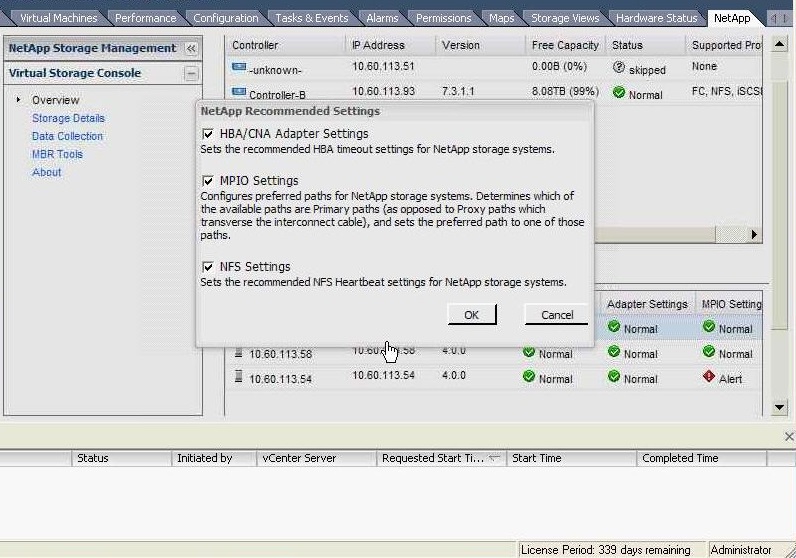

Плагин NetApp VSC, который сам по себе является бесплатным ПО, устанавливает рекомендуемые настройки: очередь, задержки и другие на ESXi хосте и HBA адаптере. Сам плагин устанавливается в vCenter.

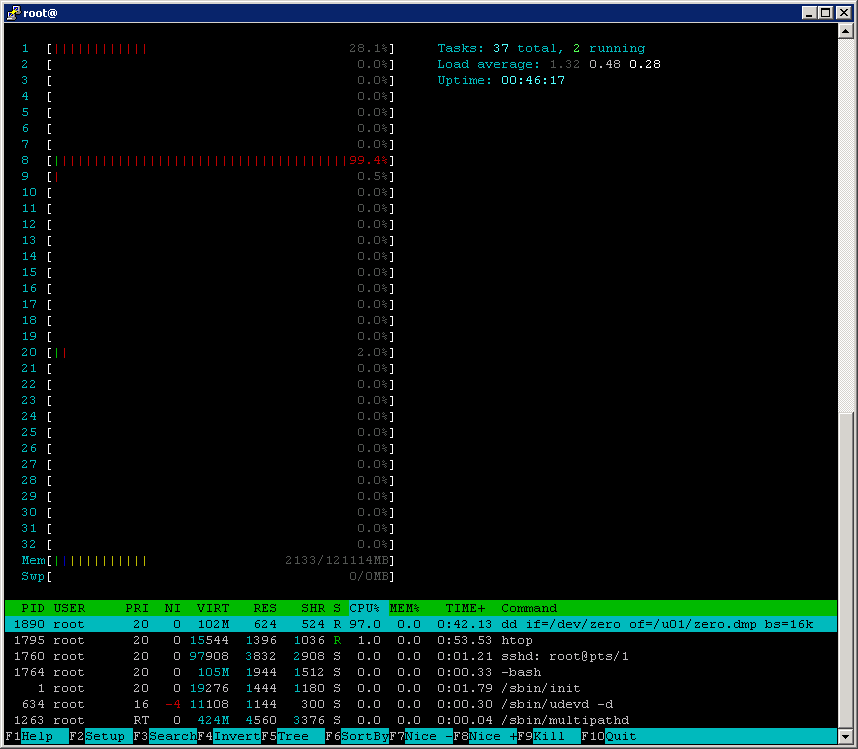

Хост BareMetal Linux

Хочу обратить ваше внимание на то, что в большинстве дистрибутивов Linux параметр I/O scheduling установлен в значение не подходящее для FAS систем, это может приводить к высокой утилизации CPU.

Обратите внимание на wait:

iostat -dx 2

Device: rrqm/s wrqm/s r/s w/s rsec/s wsec/s avgrq-sz avgqu-sz await svctm %util

sda 0.00 0.00 0.00 454.00 0.00 464896.00 1024.00 67.42 150.26 2.20 100.00

По-умолчанию значение cfq:

cat /sys/block/sda/queue/scheduler

noop anticipatory deadline [cfq]

Рекомендуется устанавливать в noop:

echo noop > /sys/block/sda/queue/scheduler

cd /sys/block/sda/queue

grep .* *

scheduler:[noop] deadline cfq

Также возможно стоит опытным путём подобрать наиболее оптимальные значения работы кеша записи ОС — параметры sysctl:

vm.dirty_background_ratio = дефолтное значение 5 или 10 в зависимости от дистрибутива Linux

vm.dirty_ratio = дефолтное значение 40

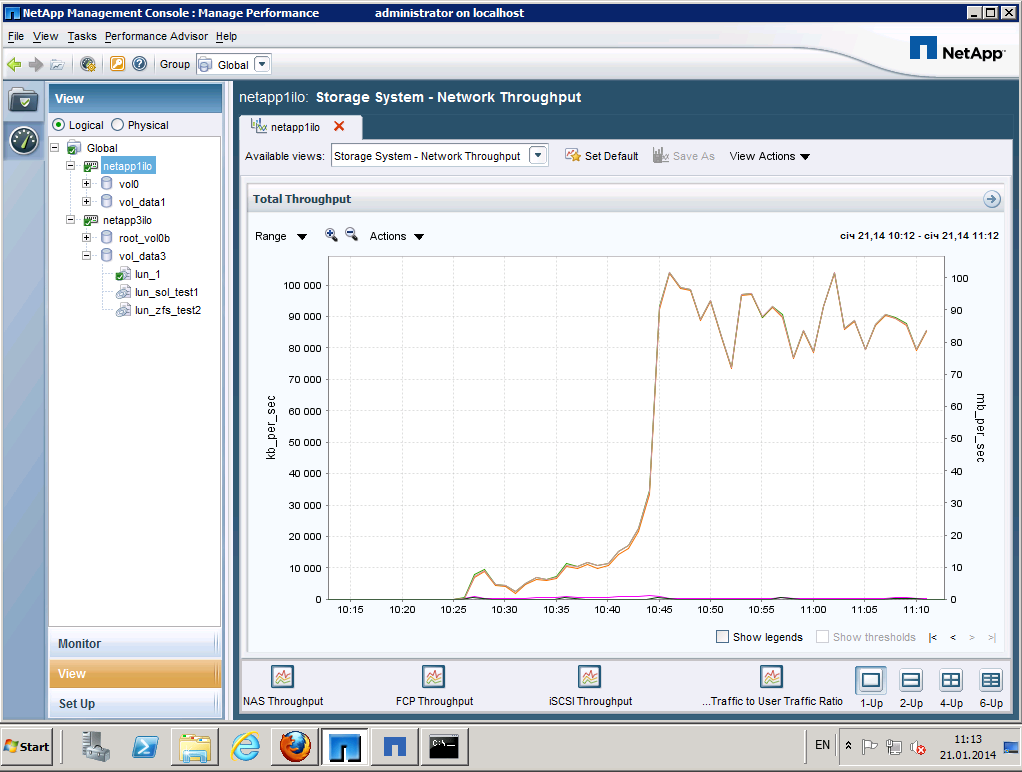

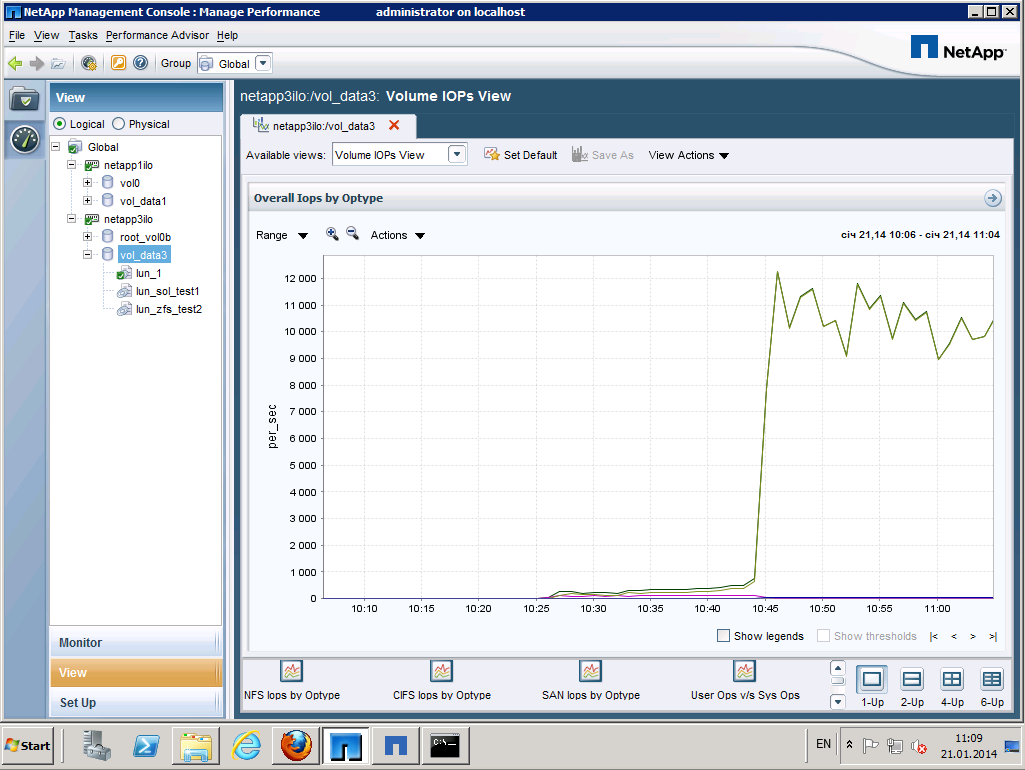

Oncommand Core + Perfomance Adviser

Рекомендуется установить набор утилит по сбору статистики отображая её в виде графиков Oncommand Core хосте не выполняющем нагрузочное тестирование. Доступно для скачивания с сайта support.netapp.com в разделе Downloads Software (Необходим аккаунт NetApp NOW ID). Логин и пароль на вход в NetApp Managment Console, соответствует логину и паролю хоста.

Требует наличие бесплатной лицензии пользователей СХД NetApp. Выполняет мониторинг систем FAS. Во время установки выбирайте "Standart Edition", а не "Express", для включения функции сбора статистики и отображения графиков.

Гостевая ОС

Windows 2008 R2 x64

выдано 6 процессоров и 16ГБ ОЗУ

Гостевой ОС по RDM отданы оба LUN

В Windows установлен пакет утилит NetApp Host Utilities 6.0.2.

В некоторых случаях VMFS показывает лучшую производительность по сравнению с RDM.

PerfStat

Утилита perfstat собирающая в текстовый файл нагрузку на СХД. Также может одновременно собирать информацию по нагрузке с хоста на котором запущена утилита. Скачать с сайта support.netapp.com раздел Download — Utility ToolChest (Для входа нужен NetApp NOW ID). Очень важно в момент нагрузки собрать статистику с СХД, так как часто бывает так, что хост не способен дать достаточную нагрузку на СХД, что будет видно из лога perfstat, в таком случае нужно будет использовать несколько хостов.

perfstat7.exe -f 192.168.0.10,192.168.0.12 -t 2 -i 3,0 -l root -S pw:123456 -F -I -w 1 >"20140114_1311.out"

При помощи этой утилиты можно отследить общую нагрузку на СХД от всех хостов проблемы на стороне СХД, к примеру когда один из дисков тормозит всю систему.

IOMeter

Все патерны сервера БД, Web сервера и сервера виртуализации, для IOMeter доступны в одном конфигурационном файле по ссылке, также вы можете запустить блокнот и сохранить его содержимое из спойлера в файл с расширением icf.

'TEST SETUP ====================================================================

'Test Description

'Run Time

' hours minutes seconds

0 0 0

'Ramp Up Time (s)

0

'Default Disk Workers to Spawn

NUMBER_OF_CPUS

'Default Network Workers to Spawn

0

'Record Results

ALL

'Worker Cycling

' start step step type

1 1 LINEAR

'Disk Cycling

' start step step type

1 1 LINEAR

'Queue Depth Cycling

' start end step step type

1 32 2 EXPONENTIAL

'Test Type

NORMAL

'END test setup

'RESULTS DISPLAY ===============================================================

'Update Frequency,Update Type

5,WHOLE_TEST

'Bar chart 1 statistic

Total I/Os per Second

'Bar chart 2 statistic

Total MBs per Second

'Bar chart 3 statistic

Average I/O Response Time (ms)

'Bar chart 4 statistic

Maximum I/O Response Time (ms)

'Bar chart 5 statistic

% CPU Utilization (total)

'Bar chart 6 statistic

Total Error Count

'END results display

'ACCESS SPECIFICATIONS =========================================================

'Access specification name,default assignment

Default,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

2048,100,67,100,0,1,4096,0

'Access specification name,default assignment

4K; 100% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

4096,100,100,0,0,1,4096,0

'Access specification name,default assignment

4K; 75% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

4096,100,75,0,0,1,4096,0

'Access specification name,default assignment

4K; 50% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

4096,100,50,0,0,1,4096,0

'Access specification name,default assignment

4K; 25% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

4096,100,25,0,0,1,4096,0

'Access specification name,default assignment

4K; 0% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

4096,100,0,0,0,1,4096,0

'Access specification name,default assignment

16K; 100% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

16384,100,100,0,0,1,4096,0

'Access specification name,default assignment

16K; 75% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

16384,100,75,0,0,1,4096,0

'Access specification name,default assignment

16K; 50% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

16384,100,50,0,0,1,4096,0

'Access specification name,default assignment

16K; 25% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

16384,100,25,0,0,1,4096,0

'Access specification name,default assignment

16K; 0% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

16384,100,0,0,0,1,4096,0

'Access specification name,default assignment

32K; 100% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

32768,100,100,0,0,1,4096,0

'Access specification name,default assignment

32K; 75% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

32768,100,75,0,0,1,4096,0

'Access specification name,default assignment

32K; 50% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

32768,100,50,0,0,1,4096,0

'Access specification name,default assignment

32K; 25% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

32768,100,25,0,0,1,4096,0

'Access specification name,default assignment

32K; 0% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

32768,100,0,0,0,1,4096,0

'Access specification name,default assignment

64K; 100% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

65536,100,100,0,0,1,4096,0

'Access specification name,default assignment

64K; 75% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

65536,100,75,0,0,1,4096,0

'Access specification name,default assignment

64K; 50% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

65536,100,50,0,0,1,4096,0

'Access specification name,default assignment

64K; 25% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

65536,100,25,0,0,1,4096,0

'Access specification name,default assignment

64K; 0% Read; 0% random,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

65536,100,0,0,0,1,4096,0

'Access specification name,default assignment

All in one,NONE

'size,% of size,% reads,% random,delay,burst,align,reply

4096,5,100,0,0,1,4096,0

4096,5,75,0,0,1,4096,0

4096,5,50,0,0,1,4096,0

4096,5,25,0,0,1,4096,0

4096,5,0,0,0,1,4096,0

16384,5,100,0,0,1,4096,0

16384,5,75,0,0,1,4096,0

16384,5,50,0,0,1,4096,0

16384,5,25,0,0,1,4096,0

16384,5,0,0,0,1,4096,0

32768,5,100,0,0,1,4096,0

32768,5,75,0,0,1,4096,0

32768,5,50,0,0,1,4096,0

32768,5,25,0,0,1,4096,0

32768,5,0,0,0,1,4096,0

65536,5,100,0,0,1,4096,0

65536,5,75,0,0,1,4096,0

65536,5,50,0,0,1,4096,0

65536,5,25,0,0,1,4096,0

65536,5,0,0,0,1,4096,0

'Access specification name,default assignment

Database pattern (Intel/StorageReview.com),NONE

'size,% of size,% reads,% random,delay,burst,align,reply

8192,100,67,100,0,1,4096,0

'Access specification name,default assignment

Fileserver pattern (Intel),NONE

'size,% of size,% reads,% random,delay,burst,align,reply

512,10,80,100,0,1,4096,0

1024,5,80,100,0,1,4096,0

2048,5,80,100,0,1,4096,0

4096,60,80,100,0,1,4096,0

8192,2,80,100,0,1,4096,0

16384,4,80,100,0,1,4096,0

32768,4,80,100,0,1,4096,0

65536,10,80,100,0,1,4096,0

'Access specification name,default assignment

Workstation pattern (StorageReview.com),NONE

'size,% of size,% reads,% random,delay,burst,align,reply

8192,100,80,80,0,1,4096,0

'Access specification name,default assignment

Webserver pattern (unknown),NONE

'size,% of size,% reads,% random,delay,burst,align,reply

512,22,100,100,0,1,4096,0

1024,15,100,100,0,1,4096,0

2048,8,100,100,0,1,4096,0

4096,23,100,100,0,1,4096,0

8192,15,100,100,0,1,4096,0

16384,2,100,100,0,1,4096,0

32768,6,100,100,0,1,4096,0

66560,7,100,100,0,1,4096,0

131072,1,100,100,0,1,4096,0

524288,1,100,100,0,1,4096,0

'END access specifications

Version 2006.07.27

По окончанию нагрузки IOMeter предоставит отчёт в виде файла CSV. Но практика показала, что этому отчёту не стоит слишком верить. IOMeter хорош для генерации нагрузки но не для сбора статистики по нагрузке.

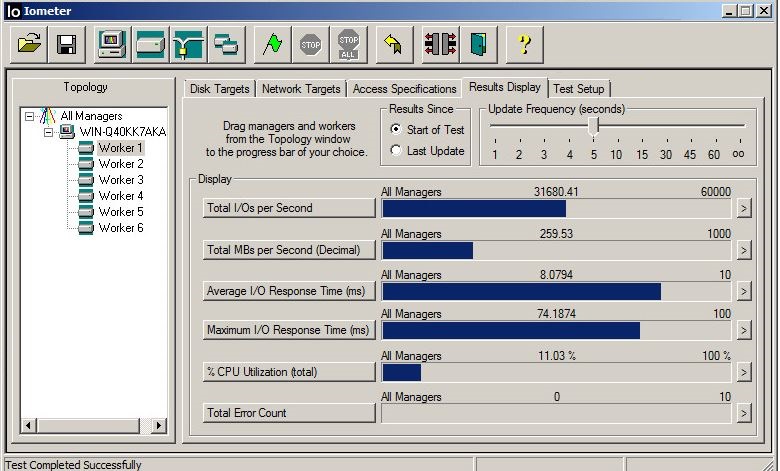

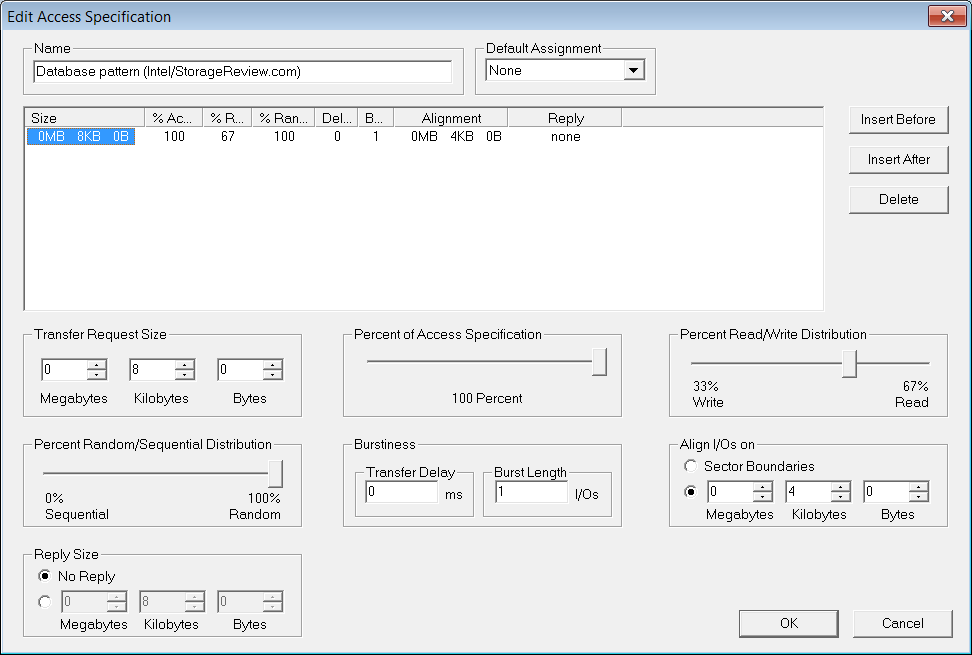

Запущен IOMeter, создано два воркера, каждому отдан один LUN.

block 8К

67% read / 33% write

100% random

Allign I/O on всегда должен быть 4К

Outstanding I/O 128

Максимум 256 для Outstanding I/O, число 128 для параметра означает высокую нагрузку схожую с высоконагруженными БД. Создаём два воркера отдаём одному один LUN, второму второй.

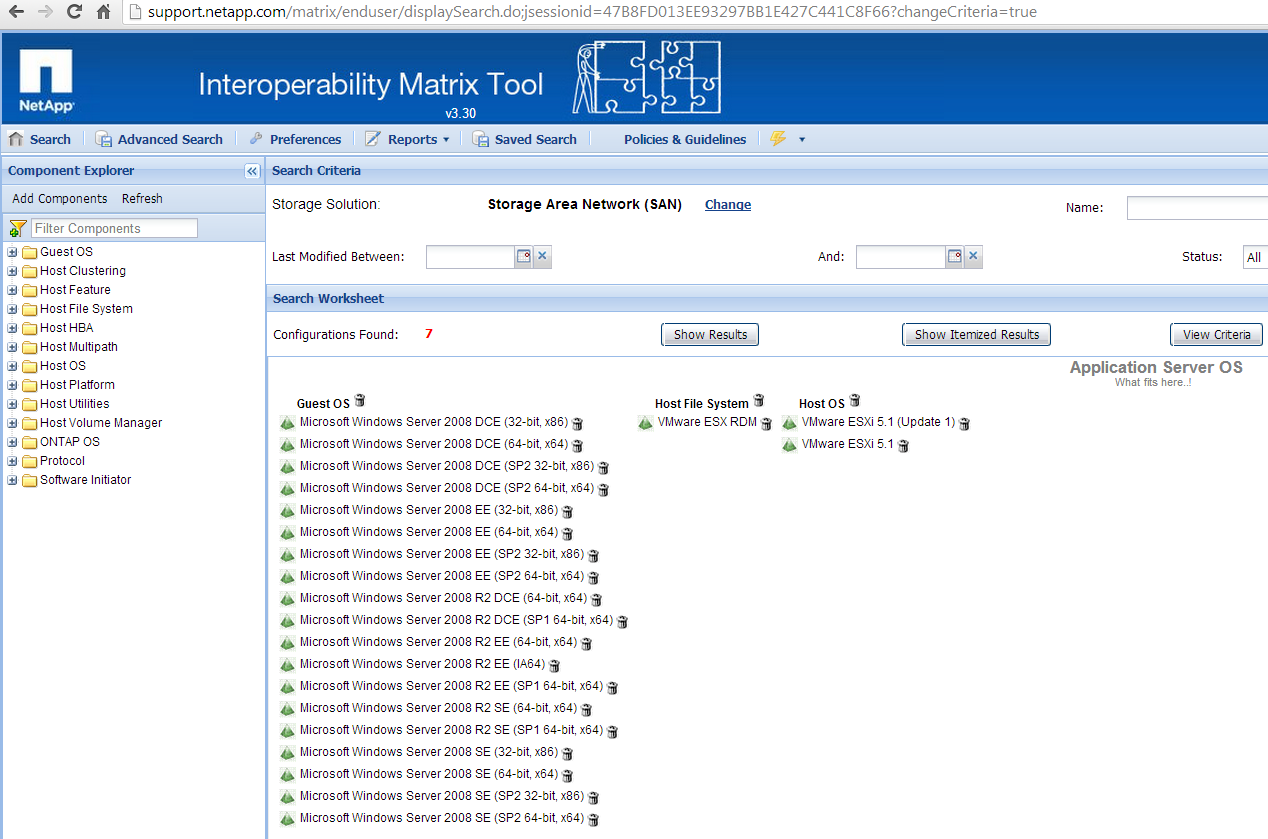

Матрица совместимости

Доступа здесь (нужен логин NetApp NOW ID). После входа выбираем Storage Solution: Storage Area Network (SAN).

Добавляем по очереди соответствующие у вас: DataOntap OS, HBA, Host OS, Host Utilities, Host Platform, Host Multipath, Host File System.

Генерируем Worksheet. Выбираем одну подходящую нам конфигурации и проверяем что всё в точности соответствует вашим реалиям. Если же у вас более новая или более старая прошивка/ОС/ПО и т.д. пробуем искать ещё раз в этот раз не выбирая версионность в самом нижнем уровне раскрывающегося дерева, а только пункты верхнего уровня. Если именно такого варианта как у вас нет, то приводим ваш демо-стенд к соответствию одного из вариантов в матрице. Обновляем/доунгрейдим прошивку/ОС/ПО и т.д. И добиваемся того, чтобы ваша конфигурация точно соответствовала матрице. Чтобы исключить все грабли совместимости прошивок, на которые много раз наступали до вас.

У меня получилось всего 7-мь вариантов исходя из описанного демо-стенда. Первый же из них мне подошел. Открываю и сверяю что всё сходится.

Мне пришлось обновиться с DataOntap 8.1.4 7-Mode до 8.2, обновить HBA FirmWare. Обратил внимание на Please see 5579 в колонке NetApp Host Utilities, там говориться о том, что необходимо установить тайм-аут жесткого диска (RDM LUN'а):

Windows Registry Editor Version 5.00

[HKEY_LOCAL_MACHINESYSTEMCurrentControlSetServicesDisk]

"TimeoutValue"=dword:0000003c

Файловая система

ФС может вносить существенные коррективы при тестировании производительности.

Размер блока ФС — кратный 4КБ, к примеру если мы запускаем синтетическую нагрузку подобную генерируемой OLTP, где размер оперируемого блока в среднем равен 8КБ, то ставим 8КБ.

Noatime

На уровне файловой системы можно настроить параметр при монтрировании noatime и nodiratime, который не даст обновлять время доступа к файлам, что часто очень положительно сказывается на производительности.

NTFS

UFS

ZFS

EXT3

Также этот же параметр нужно установить на разделе СХД с данными, к которым производится доступ. Включение этой опции предотвращает обновление времени доступа к файлу в инодах WAFL. Таким образом следующая команда применима для файловых шар SMB CIFS/NFS.

vol options vol1 no_atime_update on

MBR

Для Windows 2008 нужно при создании LUN'а выбрать геометрию диска «Windows 2008».

При инициализации диска с таблицей MBR, его можно использовать как блочное устройство не форматируя и не создавая ФС или с ФС в ходе теста с IOMeter'ом.

GPT

Для Windows c GPT нужно при создании LUN'а выбрать геометрию диска «Windows GPT» создав на нём файловую систему и производить нагрузку создавая тестовый файл (создание файла может занимать длительное время), в таком тесте будет добавляться прослойка файловой системы.

Не поддерживается IOmetr'ом в качестве блочного устройства.

IOMeter не умеет пока работать с блочными устройствами инициализированными как GPT. По-этому у нас два пути:

- использовать блочный доступ с MBR, который не может быть больше 2ТБ, при создании LUN на нетапе выбирать «Windows 2008», на хосте такой лун инициализировать как MBR.

- форматировать GPT диск.

Misalignment

В случае неправильно указанного размера блока ФС, неправильно указанной геометрии LUN, не правильно выбранного на хосте параметра MBR/GPT мы будем наблюдать в пиковые нагрузки сообщения в консоли о неком событии "LUN misalignment". Иногда эти сообщения могут появляться ошибочно, в случае редкого их появления просто игнорируйте их. Проверить это можно выполнив на системе хранения команду lun stats, ниже пример вывода, обратите внимание на align_histo.1:100% и write_align_histo.1:97%, так не должно быть в нормально сконфигурированной системе.

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:display_name:/vol/vol0/drew_smi

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_ops:1/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_ops:26/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:other_ops:0/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_data:10758b/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_data:21997484b/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:queue_full:0/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:avg_latency:290.19ms

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:total_ops:27/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:scsi_partner_ops:0/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:scsi_partner_data:0b/s

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.0:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.1:100%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.2:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.3:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.4:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.5:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.6:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.7:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.0:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.1:97%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.2:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.3:1%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.4:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.5:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.6:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.7:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_partial_blocks:0%

lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_partial_blocks:1%

misalignment также может возникать в среде виртуализации, на «общих datastor'ах» с VMFS, что может приводить к деградации производительности системы. В этом случае есть два варианта устранения проблемы существующей виртуальной машины — через плагин NetApp VSC для vCenter, запускается миграция виртуальной машины (Storage vMoution) на новый datastore (с правильно выставленной геометрией LUN) или вручную при помощи утилиты командной строки MBRalign выполнить выравнивание границ блоков в vmdk файле. Хочу отметить что ручной режим скорее всего сделает не рабочим загрузчик ОС виртуальной машины и его потребуется восстанавливать.

NetApp Host Utilities

Не игнорируйте этот пункт. Набор утилит устанавливает правильные задержки, размер очереди на HBA и другие настройки на хосте. Отображает подключённые LUN и их детальную информацию со стороны СХД. Набор утилит бесплатный и может быть скачан с сайта техподдержки нетапа. После установки запустите утилиту

host_config <-setup> <-protocol fcp|iscsi|mixed> <-multipath mpxio|dmp|non> [-noalua]

Она находиться

для Solaris

/opt/NTAP/SANToolkit/bin/

для Linux

/opt/netapp/santools/

для Windows настройки добавятся автоматически при установке.

После чего, скорее всего, понадобится перезапустить хост.

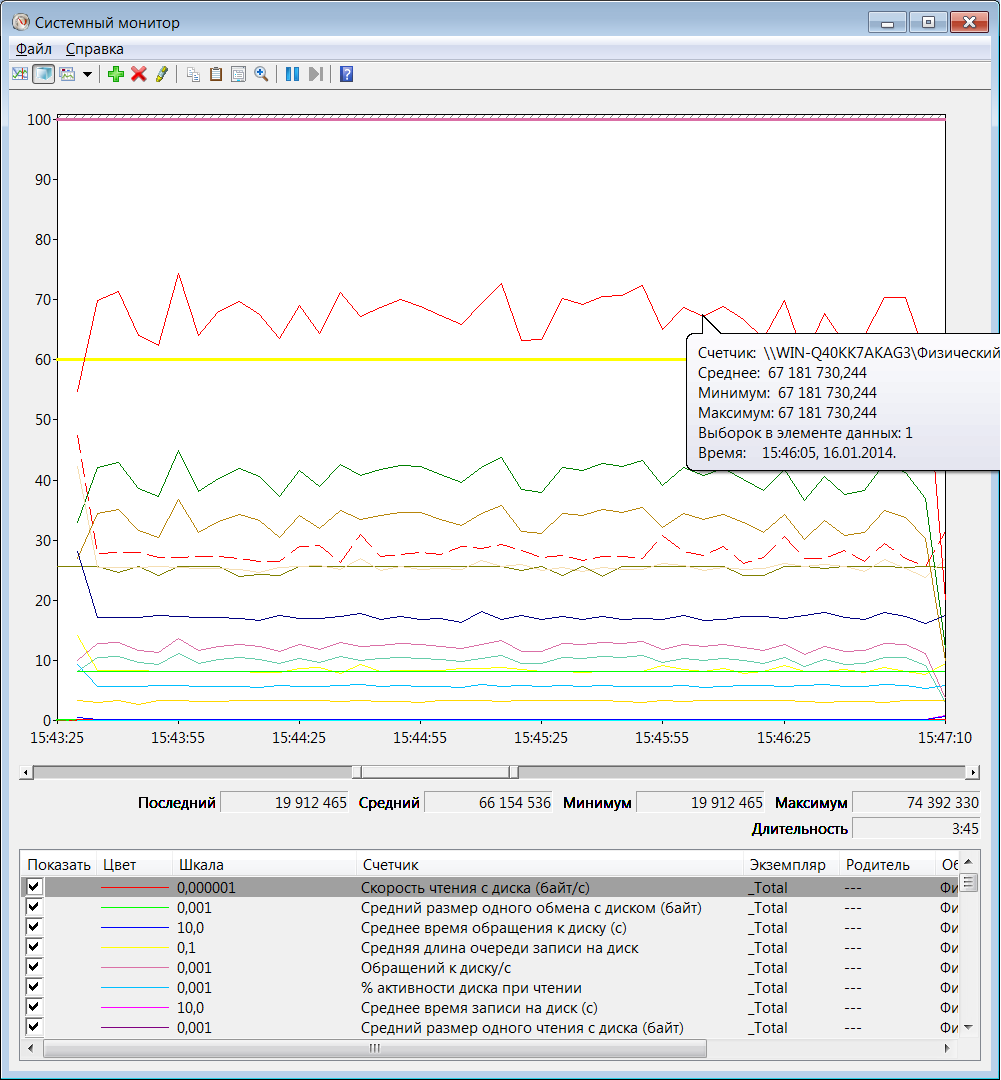

Сбор статистики на хосте

Windows perfmon.exe

Нас больше всего может интересовать счётчики: «Рабочие очереди» и «Физический диск». В сборщике производительности укажем место где будет сохранён результат сбора статистики.

Linux и другие Unix-like:

<source lang="bash">

iostat -xn 1

top

в Solaris как правило есть утилита собирающая подробную статистику о состоянии хоста

/opt/SUNWexplo/bin/explorer

ESXi perfomance

Утилита по сбору статистики нагрузки на хосте, обычно совпадает с MS perfmon.

Интерпретация результатов тестирования

Сопоставляя результаты теста с хоста и с СХД можно найти «узкое место» в тестируемой системе. Так по выводу команды perfstat ниже, видно, что СХД не достаточно нагружена (параметры CPU, Disk Usage и Total), использующая FC. Большинство операций в этой системе совершается в виде чтения содержимого кэша (значение Cache hit). Из чего делаем вывод — хост не может достаточно нагрузить систему хранения.

=-=-=-=-=-= PERF 192.168.0.12 POSTSTATS =-=-=-=-=-=

Begin: Wed Jan 15 07:16:45 GMT 2014

CPU NFS CIFS HTTP Total Net kB/s Disk kB/s Tape kB/s Cache Cache CP CP Disk OTHER FCP iSCSI FCP kB/s iSCSI kB/s

in out read write read write age hit time ty util in out in out

8% 0 0 0 227 1 1 2307 24174 0 0 8 89% 11% : 22% 3 224 0 12401 852 0 0

12% 0 0 0 191 1 5 3052 24026 0 0 6s 90% 14% F 27% 1 190 0 21485 864 0 0

18% 0 0 0 517 0 1 5303 46467 0 0 0s 90% 33% 2 38% 1 516 0 23630 880 0 0

15% 0 0 0 314 1 2 4667 24287 0 0 0s 91% 15% F 33% 27 287 0 27759 853 0 0

12% 0 0 0 252 0 1 3425 24601 0 0 9 91% 16% F 28% 20 232 0 22280 852 0 0

24% 0 0 0 1472 2 5 9386 46919 0 0 1s 82% 34% F 47% 9 1463 0 26141 673 0 0

14% 0 0 0 303 1 3 3970 24527 0 0 8s 90% 27% F 33% 1 302 0 22810 967 0 0

14% 0 0 0 299 2 6 3862 24776 0 0 0s 91% 21% F 29% 1 298 0 21981 746 0 0

13% 0 0 0 237 1 3 4608 24348 0 0 9 94% 15% F 30% 1 236 0 22721 958 0 0

17% 0 0 0 306 1 2 5603 48072 0 0 2s 92% 32% F 37% 1 305 0 22232 792 0 0

13% 0 0 0 246 0 1 3208 24278 0 0 8s 92% 14% F 26% 20 226 0 24137 598 0 0

--

Summary Statistics ( 11 samples 1.0 secs/sample)

CPU NFS CIFS HTTP Total Net kB/s Disk kB/s Tape kB/s Cache Cache CP CP Disk OTHER FCP iSCSI FCP kB/s iSCSI kB/s

in out read write read write age hit time ty util in out in out

Min

8% 0 0 0 191 0 1 2307 24026 0 0 0s 82% 11% * 22% 0 190 0 0 0 0 0

Avg

14% 0 0 0 396 0 2 4490 30588 0 0 2 90% 21% * 31% 7 389 0 22507 821 0 0

Max

24% 0 0 0 1472 2 6 9386 48072 0 0 9 94% 34% * 47% 27 1463 0 27759 967 0 0

Begin: Wed Jan 15 07:18:36 GMT 2014

Расшифровка параметра Cache age, Cache hit, CP ty. Ещё немного об оптимизации производительности и поиске узкого горлышка (bottleneck).

P.S. NOW ID

Если у вас нет NetApp NOW ID, то его можно завести, наличие СХД для этого не требуется. Также для получения перечисленных в этом посте утилит, можно обратиться к вашему Дистрибьютору NetApp, который скачает и передаст наиболее новые их версии.

Другие симуляторы нагрузки

sio

fio

Oracle Orion

MS SQLIO Disk Subsystem Benchmark Tool

IOZone

Замечания по ошибкам в тексте и предложения прошу направлять в ЛС.

Автор: bbk