Если вы спросите начинающего аналитика данных, какие он знает методы классификации, вам наверняка перечислят довольно приличный список: статистика, деревья, SVM, нейронные сети… Но если спросить про методы кластеризации, в ответ вы скорее всего получите уверенное «k-means же!» Именно этот золотой молоток рассматривают на всех курсах машинного обучения. Часто дело даже не доходит до его модификаций (k-medians) или связно-графовых методов.

Не то чтобы k-means так уж плох, но его результат почти всегда дёшев и сердит. Есть более совершенные способы кластеризации, но не все знают, какой когда следует применять, и очень немногие понимают, как они работают. Я бы хотел приоткрыть завесу тайны над некоторыми алгоритмами. Начнём с Affinity propagation.

Предполагается, что вы знакомы с классификацией методов кластеризации, а также уже применяли k-means и знаете его плюсы и минусы. Я постараюсь не очень глубоко вдаваться в теорию, а попытаться донести идею алгоритма простым языком.

Affinity propagation

Affinity propagation (AP, он же метод распространения близости) получает на вход матрицу схожести между элементами датасета

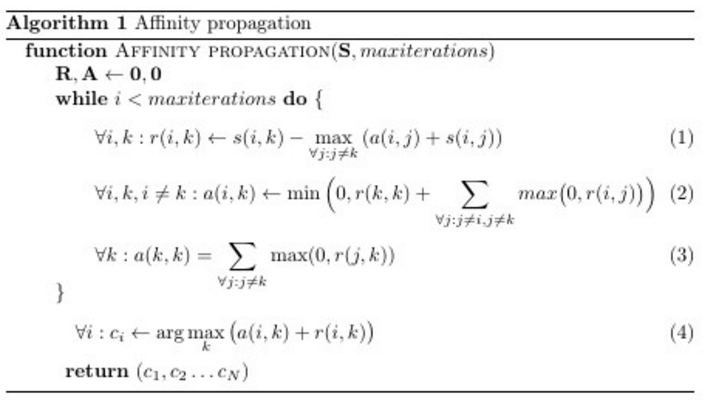

Ха, было бы что выкладывать. Всего три строчки, если рассматривать основной цикл; (4) — явно правило присвоения меток. Но не всё так просто. Большинству программистов совсем не очевидно, что же эти три строчки делают с матрицами

Так что я начну с другого конца.

Интуитивное объяснение

В некотором пространстве, в некотором государстве живут точки. У точек богатый внутренний мир, но существует некоторое правило

Одним жить на свете скучно, поэтому точки хотят собраться в кружки по интересам. Кружки формируются вокруг лидера (exemplar), который представляет интересы всех членов товарищества. Каждая точка хотела бы видеть лидером кого-то, кто максимально на неё похож, но готова мириться с другими кандидатами, если те нравятся многим другим. Следует добавить, что точки довольно-таки скромные: все думают, что лидером должен быть кто-нибудь другой. Можно переформулировать их низкую самооценку так: каждая точка считает, что когда дело доходит до объединения в группы, то она сама на себя не похожа (

Точки заранее не знают ни что это будут за коллективы, ни общее их количество. Объединение идёт сверху вниз: сначала точки цепляются за президентов групп, затем только размышляют, кто ещё поддерживает того же кандидата. На выбор точки в качестве лидера влияют три параметра: сходство (про него уже сказано), отвественность и доступность. Ответственность (responsibility, таблица

Возьмём простой пример: точки X, Y, Z, U, V, W, весь внутренний мир которых — любовь к котикам,

Итак, на первом шаге каждая точка

- Ближайшая (самая похожая) точка задаёт распределение ответственности для всех остальных точек. Расположение точек дальше первых двух пока что влияет только на

отведённую им и только им.

- Ответственность, возлагаемая на ближайшую точку также зависит от расположения второй ближайшей.

- Если в радиусе досягаемости

есть несколько более-менее похожих на него кандидатов, на тех будет возложена примерно одинаковая ответственность

выступает своего рода ограничителем — если какая-то точка слишком сильно непохожа на все остальные, ей ничего не остаётся, кроме как надеяться только на себя

Если

Возвращаясь к примеру: X возлагает на Y отвественность в размере $inline$-1-(-2)=1$inline$ балл, на Z — $inline$-2-(-1)=-1$inline$ балл, на U — $inline$-6-(-1)=-5$inline$, а на себя $inline$-2-(-1)=-1$inline$. X в общем-то не против, чтобы лидером группы котоненавистников был Z, если Y не захочет быть им, но вряд ли будет общаться с U и V, даже если они соберут большую команду. W настолько непохожа на все остальные точки, что ей ничего не остаётся, как возлагать отвественность в размере $inline$-2-(-35)=33$inline$ балла только на себя.

Затем точки начинают думать, насколько они сами готовы быть лидером (доступны, available, для лидерства). Доступность для самого себя (3) складывается из всей положительной ответственности, «голосов», отданных точке. Для

Начинается новый этап выборов, но теперь уже

. Тогда

не играет роли, и в (1) все $inline$-max(dots)$inline$ в правой части будут не меньше, чем были на первом шаге.

по сути отдаляет точку

от

. Самоответственность точки повышается от того, что у самого лучшего кандидата с её точки зрения, плохие отзывы.

. Тут выступают оба эффекта. Этот случай расщепляется на два:

— max. То же самое что и в случае 1, но повышается отвественность возлагаемая на точку

— max. Тогда $inline$-max(dots)$inline$ будет не больше, чем на первом шаге,

уменьшается. Если продолжать аналогию, то это как если бы точка, которая и так уже задумывалась, не стать ли её лидером, получила дополнительное одобрение.

Доступность оставляет в соревновании точки которые или готовы сами постоять за себя (W,

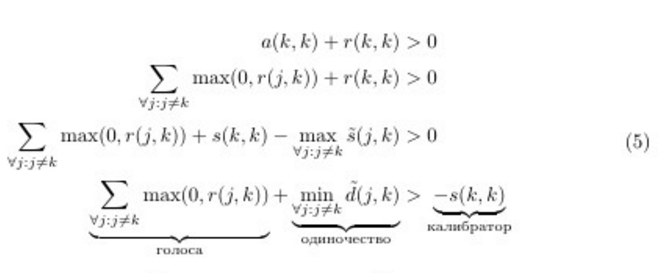

Перепишем решающее правило, чтобы получить ещё один взгляд на решающее правило алгоритма. Воспользуемся (1) и (3). Обозначим

Примерно то, что я сформулировал вначале. Отсюда видно, что чем менее уверены в себе точки, тем больше «голосов» необходимо собрать или тем более непохожим на остальные нужно быть, чтобы стать лидером. Т.е. чем меньше

Что ж, я надеюсь, вы приобрели некоторое интуитивное представление того, как работает метод. Теперь чуть серьёзнее. Давайте поговорим про нюансы применения алгоритма.

Очень-очень краткий экскурс в теорию

Кластеризацию можно представить в виде задачи дискретной максимизации с ограничениями. Пусть на множестве элементов задана функция сходства

где

Авторы AP при много говорят про «сообщения» от одного элемента графа к другому. Такая аналогия происходит из вывода формул через распространение информации в графе. На мой взгляд она немного путает, ведь в реализациях алгоритма никаких сообщений «точка-точка» нет, зато есть три матрицы

- При вычислении

идёт пересылка сообщений от точек данных

к потенциальным лидерам

— мы просматриваем матрицы

и

вдоль строк

- При вычислении

идёт пересылка сообщений от потенциальных лидеров

ко всем остальным точкам

— мы просматриваем матрицы

и

вдоль столбцов

Affinity propagation детерминирован. Он имеет сложность

Существует ускоренный вариант AP. Предложенный в статье метод основывается на идее, что необязательно вычислять вообще все обновления матриц доступности и ответственности, ведь все точки в гуще других точек относятся к далёким от них экземплярам примерно одинаково.

Если вам хочется экспериментов (так держать!), я бы предложил поколдовать над формулами (1-5). Части

Обязательные оптимизации и параметры

Affinity propagation, как многие других алгоритмов, можно прервать досрочно, если

Affinity propagation подвержен вычислительным осцилляциям в случаях, когда есть несколько хороших разбиений на кластеры. Чтобы избежать проблем, во-первых, в самом начале к матрице сходства добавляется немного шума (очень-очень немного, чтобы не повлиять на детерменированность, в sklearn-имплементации порядка

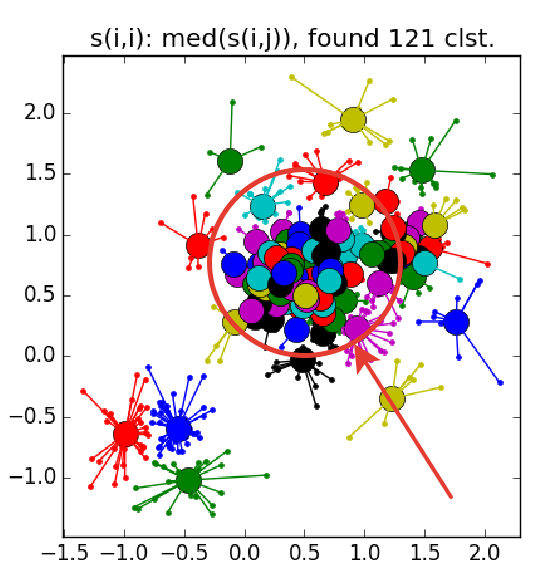

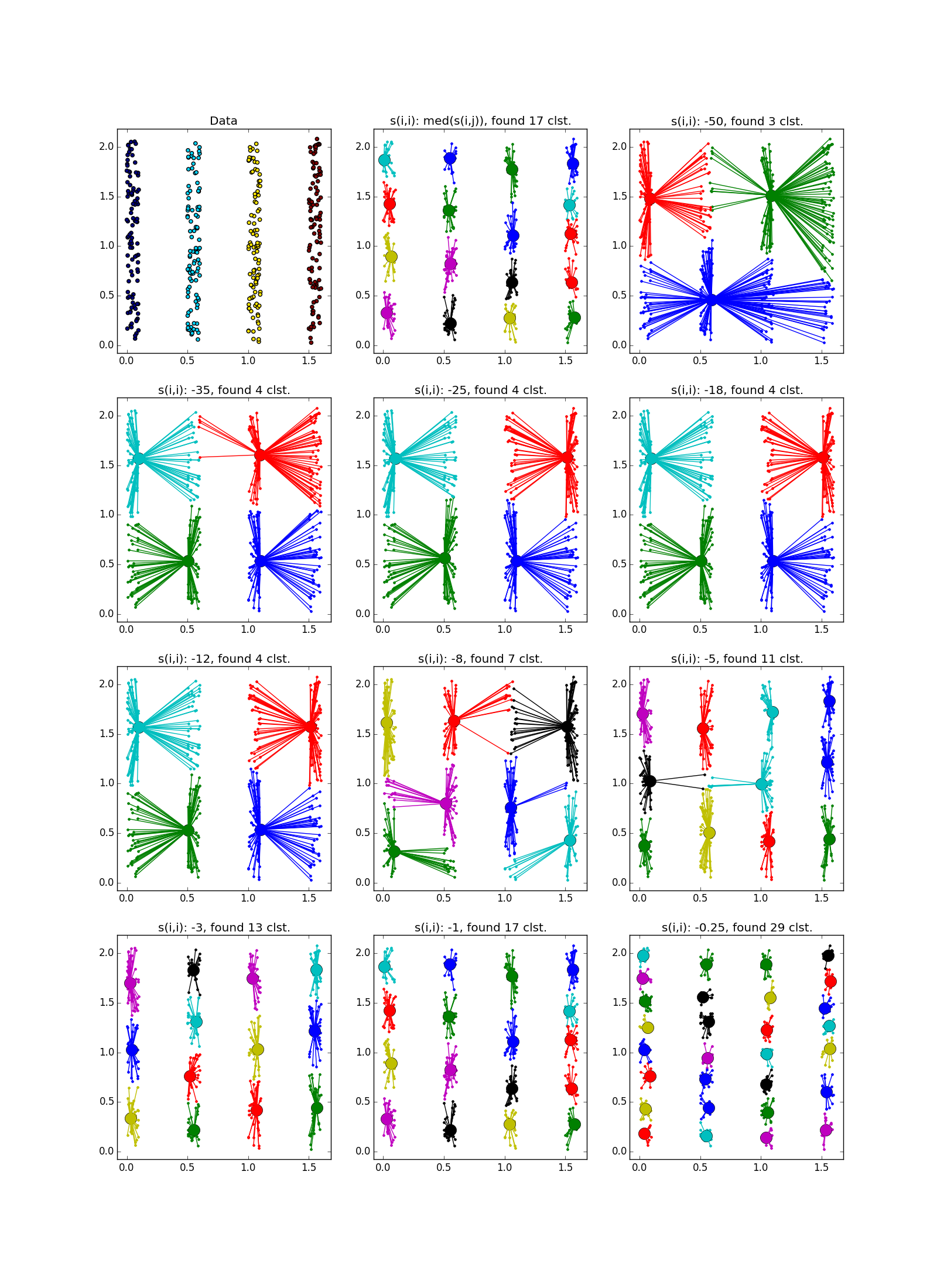

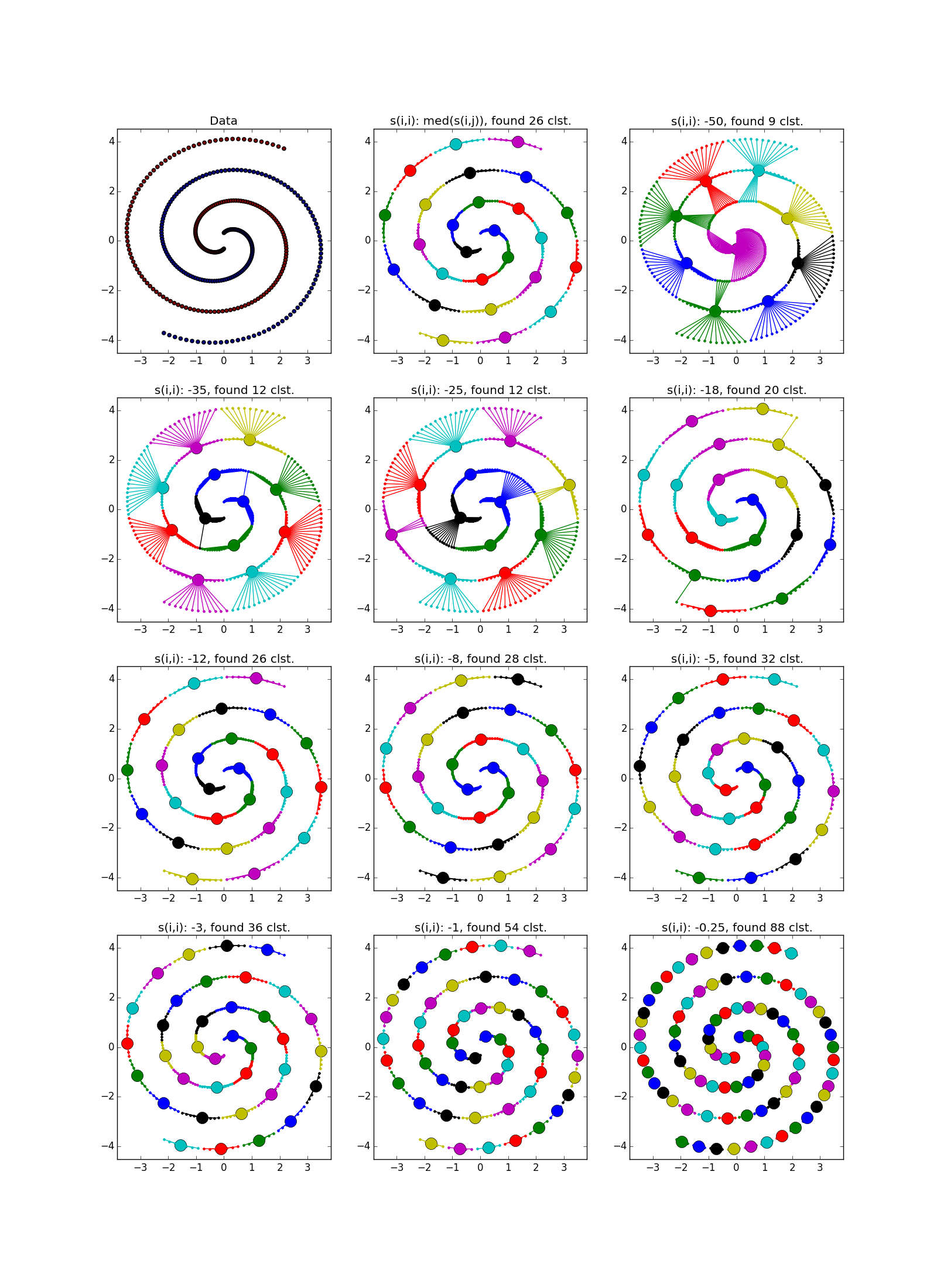

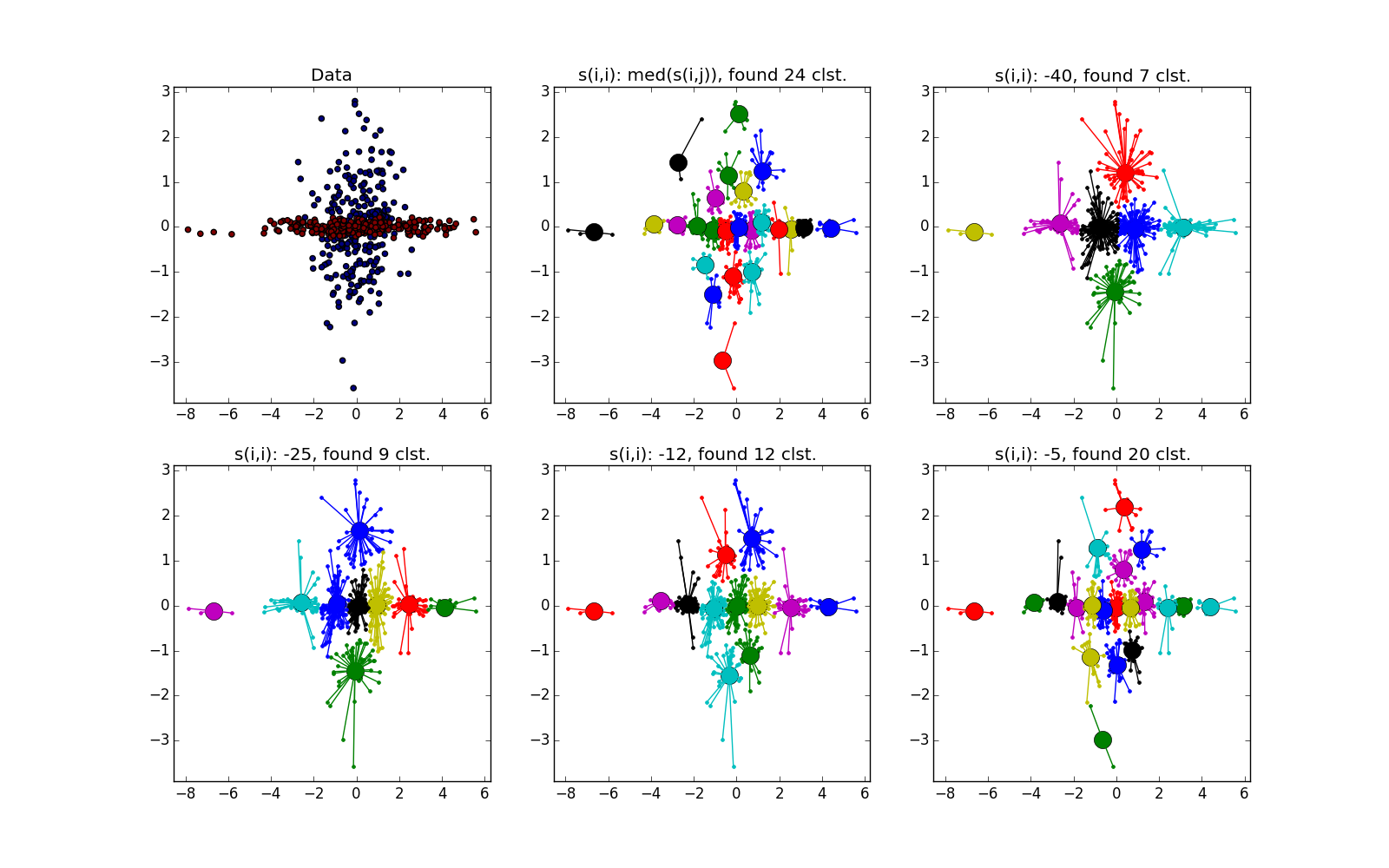

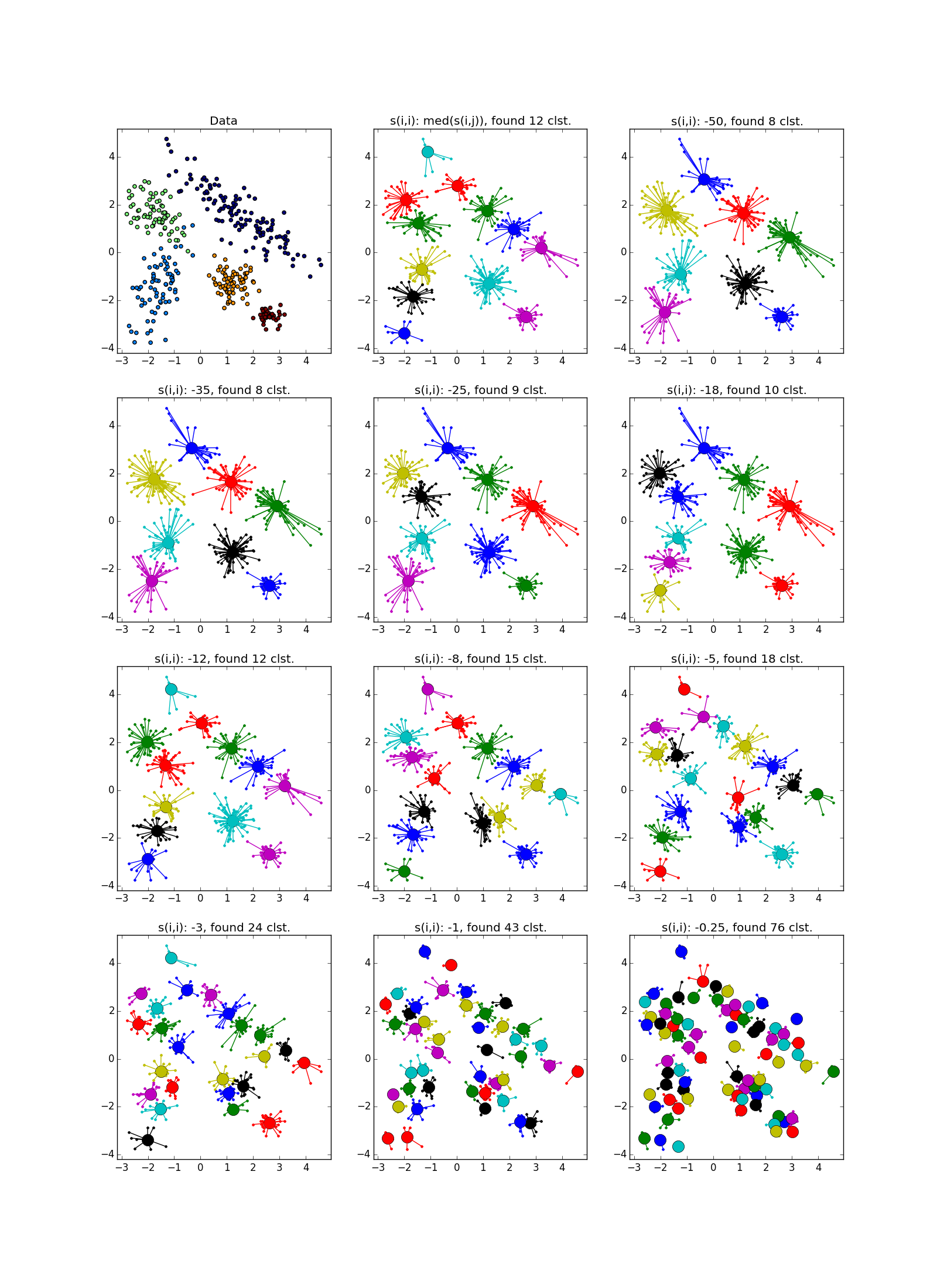

Вот так выглядит отказ — куча мелких кластеров, окружённая кольцом кластеров среднего размера:

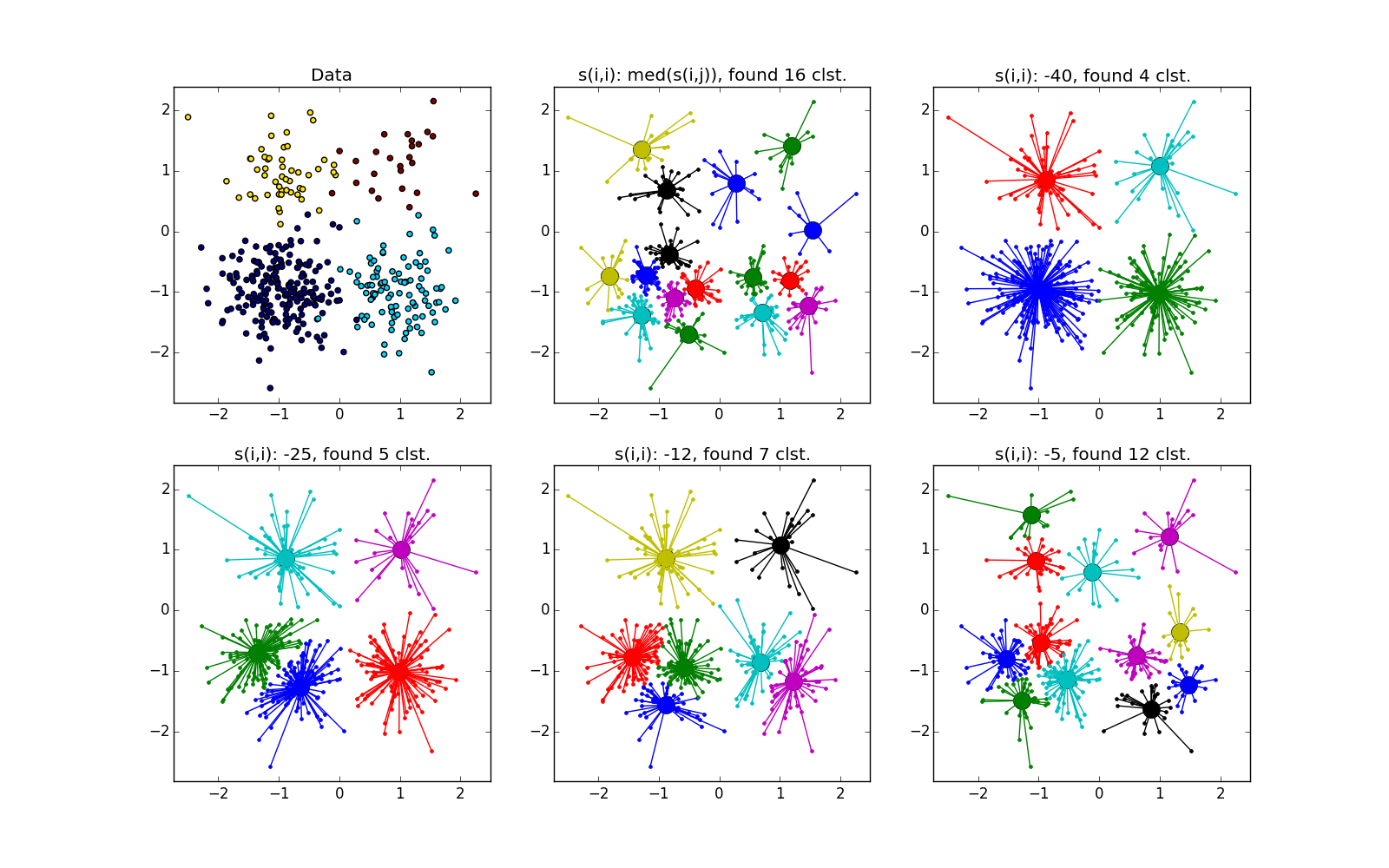

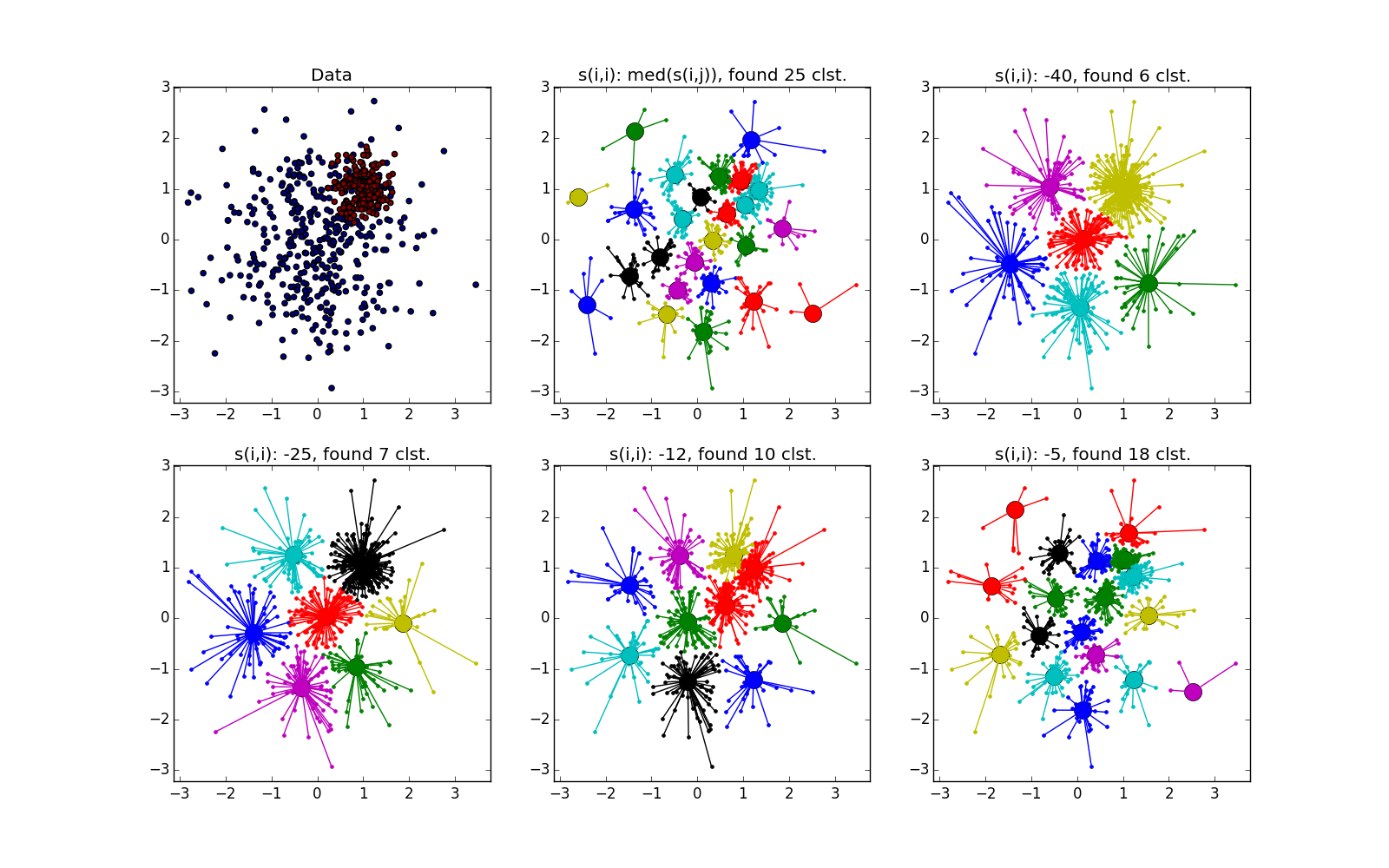

Как уже было сказано, вместо наперёд заданного количества кластеров используется параметр «самоподобия»

В качестве

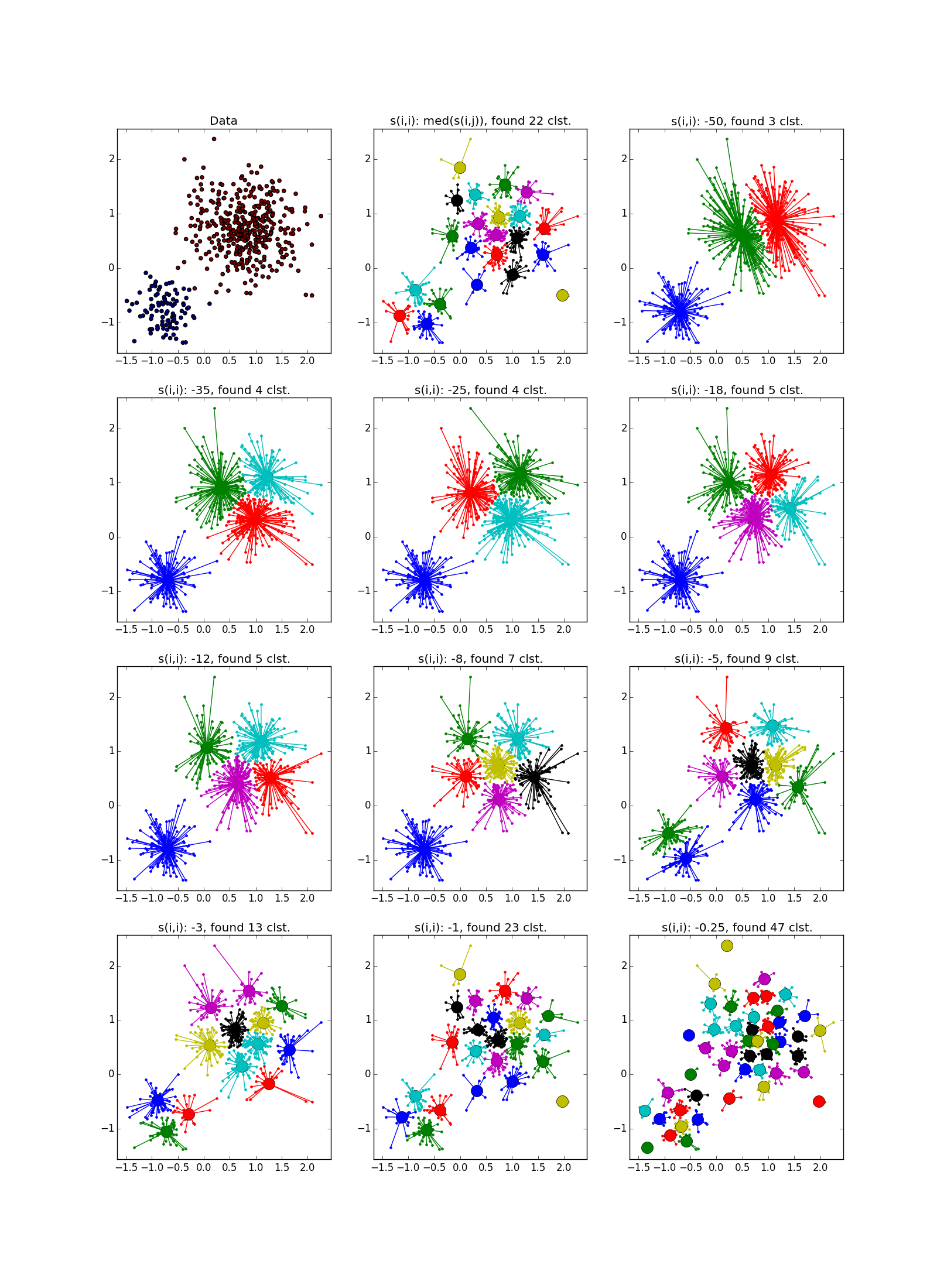

Размеры кластеров, полученных в ходе распространения близости, варьируются в довольно небольших пределах, и если в датасете есть сильно различные по размеру скопления, AP может либо пропустить маленькие, либо посчитать большие за несколько. Обычно вторая ситуация менее неприятна — она исправима. Поэтому часто AP нуждается в постобработке — дополнительной кластеризации лидеров групп. Подходит любой другой метод, тут может помочь дополнительная информация о задаче. Следует помнить, что честным одиноко стоящим точкам выделяется свои кластеры; такие выбросы нужно отфильтровывать перед постобработкой.

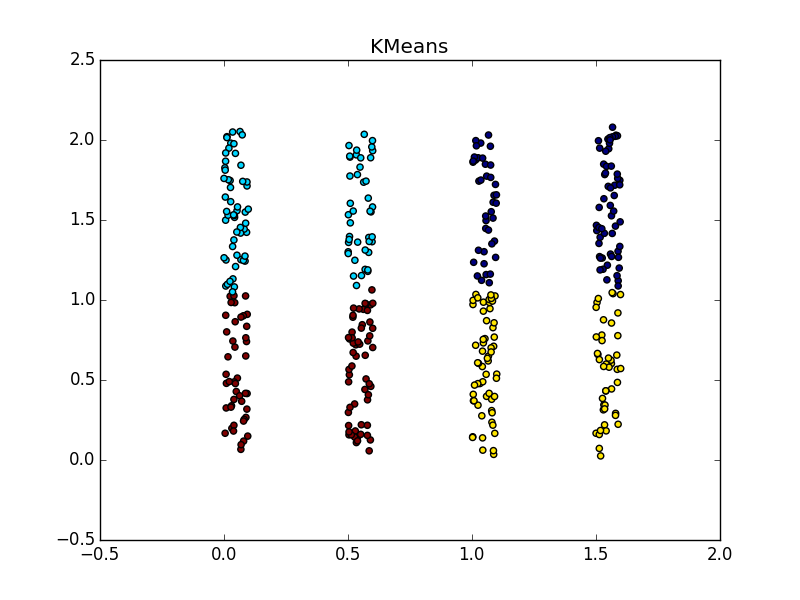

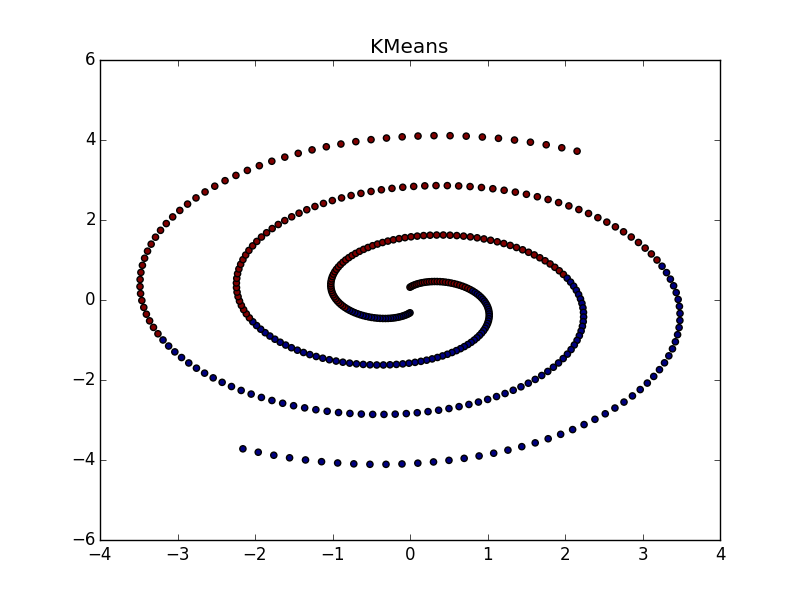

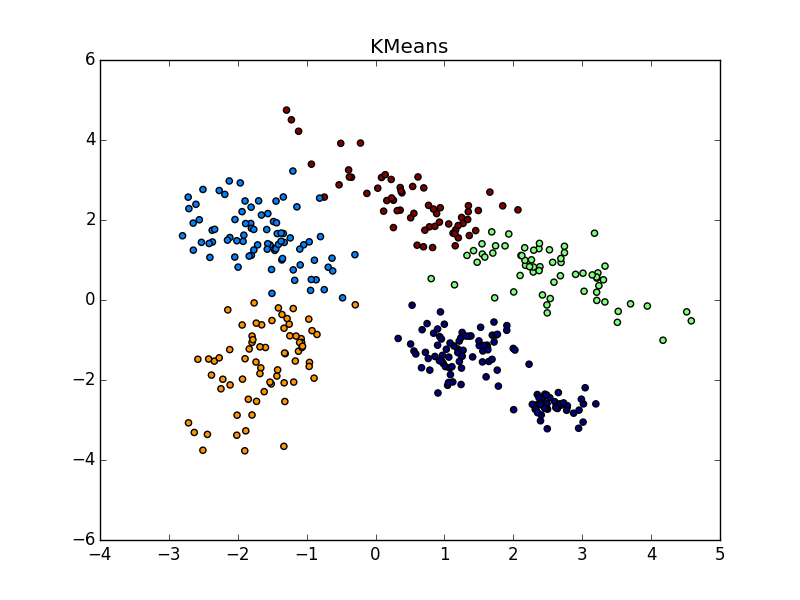

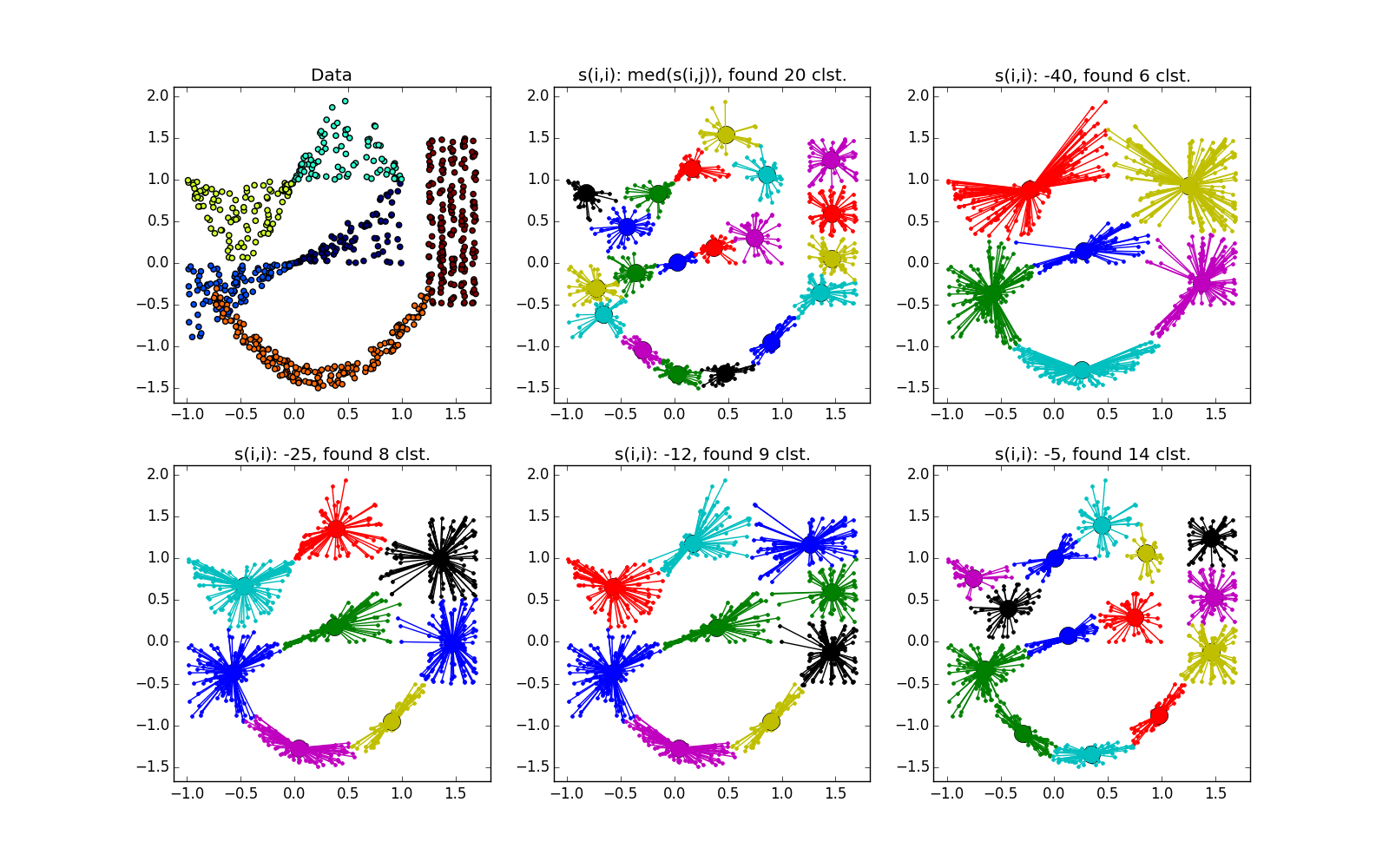

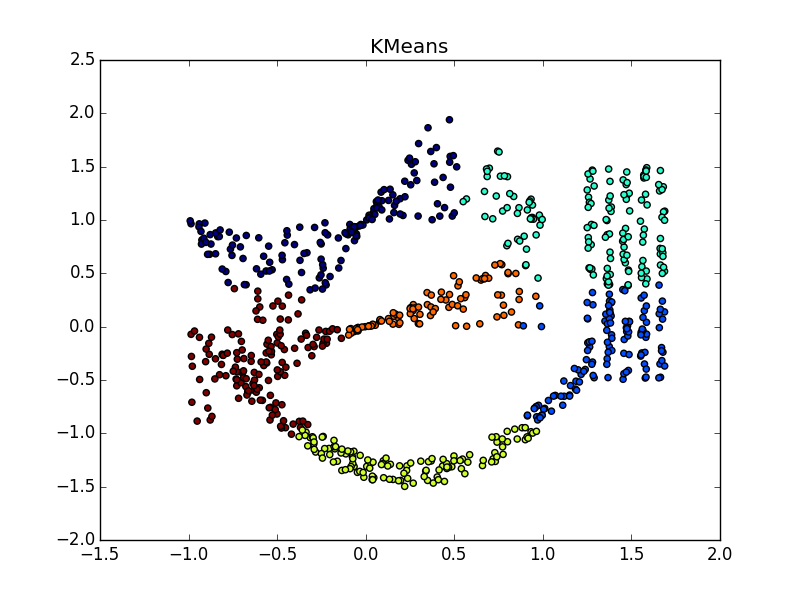

Эксперименты

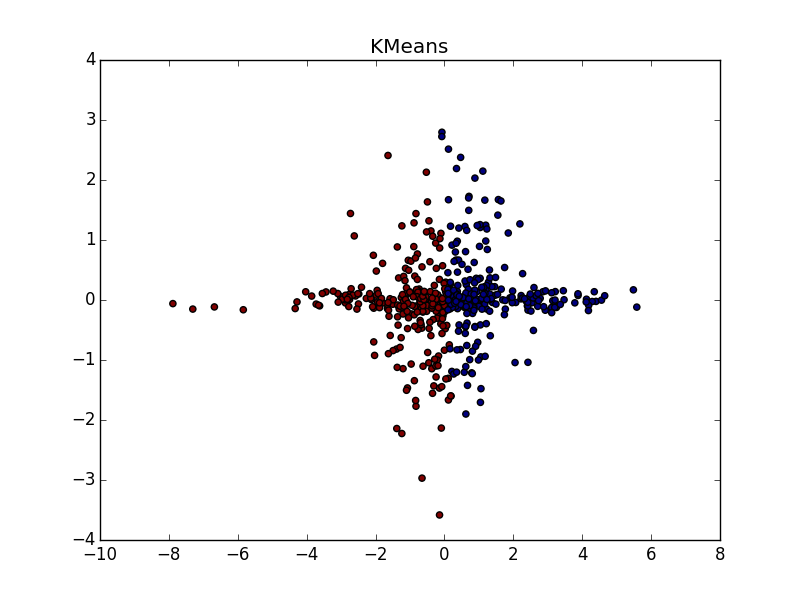

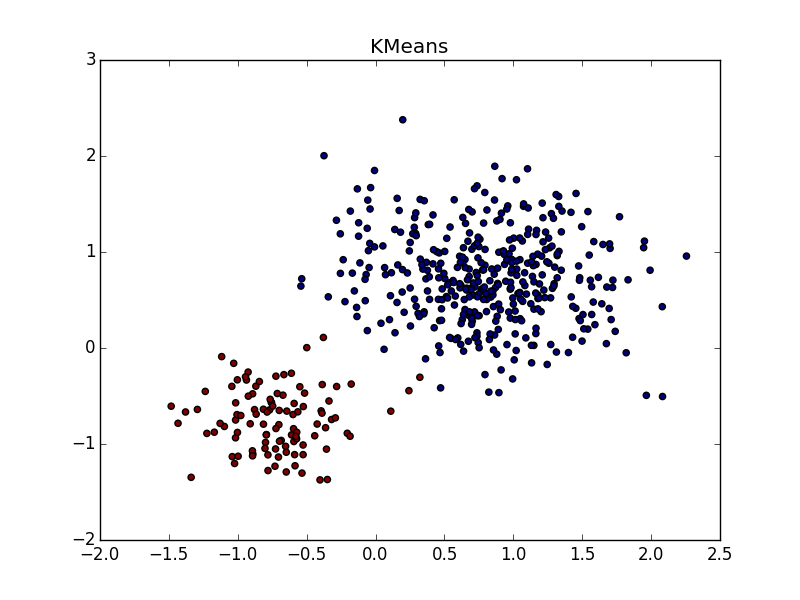

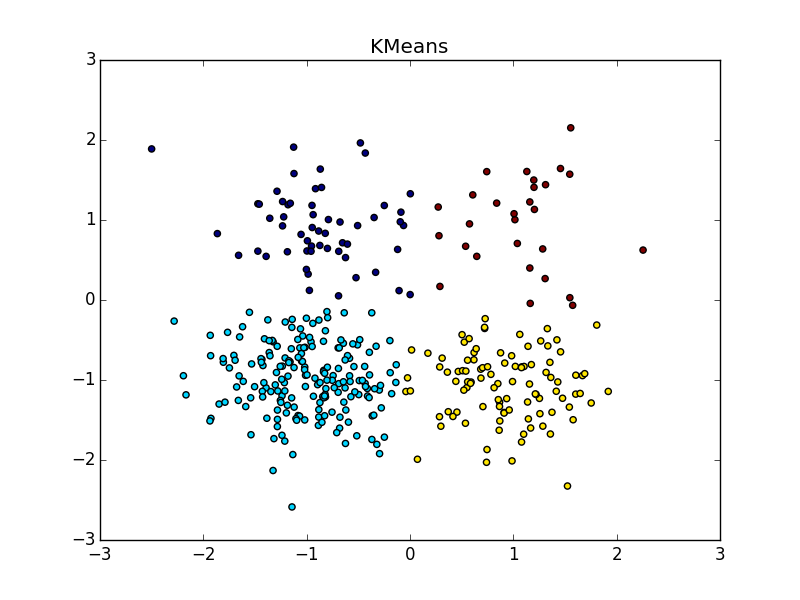

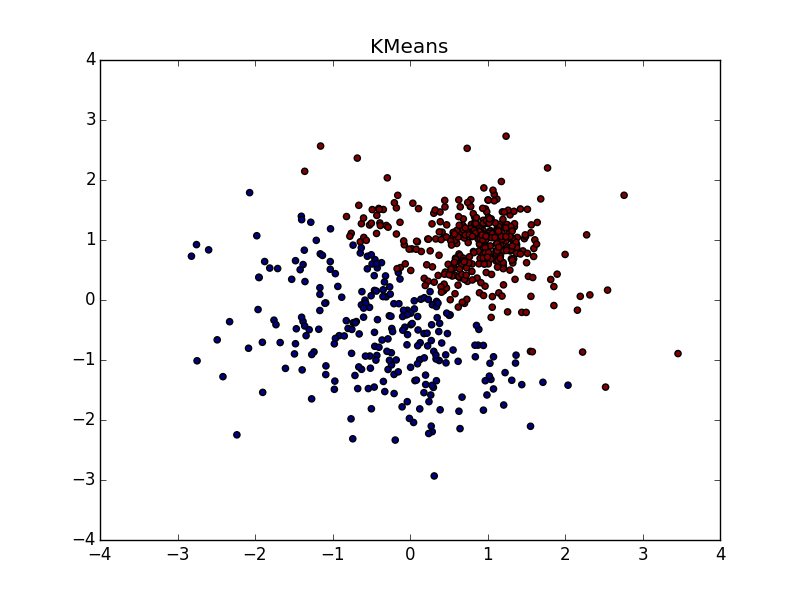

Фух, закончилась стена текста, началась стена картинок. Проверим Affinity propagation на разного вида кластерах.

Если складка пересекает другой сгусток, дело обстоит хуже, но даже так AP помогает понять, что в этом месте творится что-то интересное.

При хорошем подборе параметра и кластеризатора-постобработчика AP выигрывает и в случае кластеров разного размера. Обратите внимание на картинку с

С кластерами одинаковой формы, но разной плотности у AP и k-means плюс-минус паритет. В одном случае нужно хорошо угадать

Со сгустком большей плотности в другом сгустке, на мой взгляд, чуть-чуть выигрывает k-means. Он, конечно, «отъедает» значительный кусок в пользу кластера большей плотности, но по визуальному результату работы AP вообще не слишком видно неоднородность.

Ещё немного картинок:

Итог

Используйте Affinity propagation, когда

- У вас не очень большой (

) или в меру большой, но разреженный (

) датасет

- Заранее известна функция близости

- Вы ожидаете увидеть множество кластеров различной формы и немного варьирующимся количеством элементов

- Вы готовы повозиться с постобработкой

- Сложность элементов датасета значения не имеет

- Свойства функции близости значения не имеют

- Количество кластеров значения не имеет

Утверждается, что разные учёные успешно применяли Affinity propagation для

- Сегментирования изображений

- Выделения групп в геноме

- Разбиения городов на группы по доступности

- Кластеризации образцов гранита

- Группирования фильмов на Netflix

Во всех этих случаях был получен результат лучше, чем при помощи k-means. Не то чтобы это какой-то суперский результат само по себе. Мне неизвестно, проводилось ли во всех этих случаях сравнение с другими алгоритмами. Я планирую сделать это в грядущих статьях. По всей видимости, на датасетах из реальной жизни больше всего помогает умения распространения близости обходиться с кластерами разной геометрической формы.

Что же, вроде бы и всё. В следующий раз рассмотрим ещё какой-нибудь алгоритм и сравним его с методом распространения близости. Удачи!

Автор: Siarshai