Привет! Меня зовут Божена, я редактор блога компании. Часто бываю в интересных и даже запретных местах, чтобы рассказать об этом читателям. В один погожий денек (на самом деле была слякоть и грязь, заканчивался ноябрь, начался снег) меня и мою коллегу пригласили посетить один из дата-центров, где размещены наши серверы.

Несмотря на то, что водитель такси немного заплутал и возил нас кругами по шоссе, прибыли в место назначения мы вовремя. Нас встретил Сергей Кубасов, заместитель технического директора Mail.Ru Group, и сотрудники дата-центра.

Как попасть внутрь?

Территория оказалась очень большой: отдельно стоящие здания дата-центров. Периметр под присмотром службы охраны (как я позже узнала, она собственная), уровней защиты периметра всего четыре – въезд на территорию, вход в здание ЦОД, шлюз рядом с помещением охраны, после чего – вход в зал. И это далеко не все, что существует для безопасности: на посту охраны расположена тревожная кнопка МВД, системы IP-видеонаблюдения по всей территории снаружи и внутри зданий. Вход – строго по пропускам, которые заказывают заранее.

Практически сквозь вьюгу, прикрывая лица шарфами и варежками, мы добрались до КПП, где нас приветствовала охрана. Предъявить паспорта и расписаться в гостевой книге – стандартная процедура, после чего получаешь пропуск и можешь отправляться в путь.

Из интересного – нам был нужен третий этаж, и пока мы поднимались по лестнице, я уже расчехлила фотоаппарат и старалась запечатлеть надписи на стенах. Как мы выяснили позже, забавные выражения красуются практически на всех стенах и на всех этажах. Это и указатели, направляющие заблудившихся к пункту назначения, и напутствия сотрудникам, и даже забавные угрозы.

Мы не остались до 21:47: подумали, что задержавшихся сожгут вместе с забытыми вещами

Оказавшись на нужном этаже, мы оставили верхнюю одежду в импровизированной гардеробной и нацепили бахилы (а бахилы там – одна из главных вещей, которая нужна вам для работы). В серверных поддерживается практически стерильная чистота, а бахилы предотвращают попадание пыли и грязи в технические помещения.

Со своими бахилами вход воспрещен

Температура и влажность

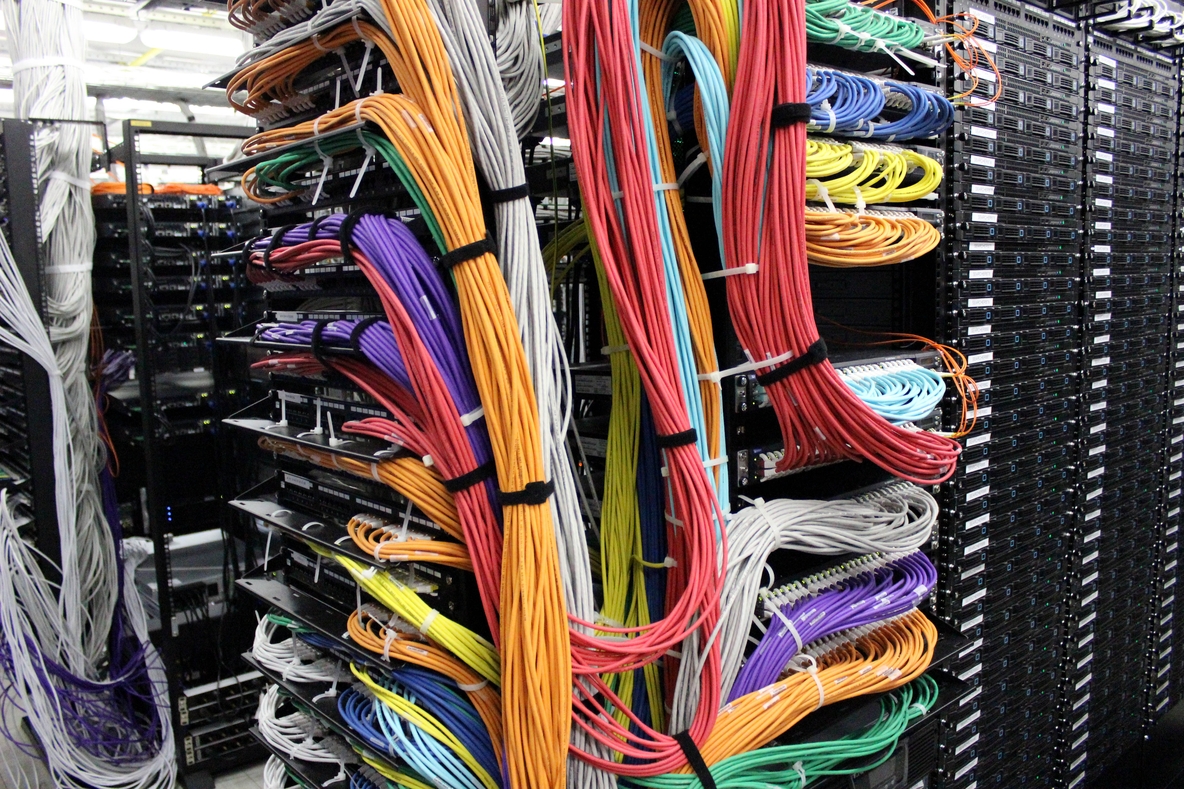

До того, как я побывала в этом дата-центре, примерно представляла, как выглядят серверные, но никогда не видела их вживую.

Здесь чисто, как в операционной

Внутри было откровенно холодно. Но ровно до того момента, когда я подошла ближе к стойкам. Все потому, что охлаждение оборудования в аппаратных залах организовано по принципу холодного-горячего коридора. Холодный воздух подается шкафными DX-кондиционерами зала под фальшпол (высотой 600 мм), откуда через перфорированные плитки он поступает в холодный коридор к оборудованию за счет общего нагнетаемого давления в подфальшпольном пространстве. Холодный воздух забирается оборудованием и выбрасывается в горячий коридор зала, где поднимается наверх, под потолок саркофага. В наших серверных в этом дата-центре используются Uniflair TDAR 2522 A – это модель кондиционера с пароувлажнителем, имеет резервированный компрессоры и внешние вентиляторные блоки. Так вот, если стоять там, где горячий воздух поднимается к потолку, то можно легко согреться. Я именно так и поступала.

Согласно SLA (Service Level Agreement), уровень влажности в серверной должен быть от 40 до 60%, у нас он поддерживается пароувлажнительными модулями в шкафных кондиционерах зала, о которых я писала чуть выше.

Мы спросили ребят, какие из наших проектов расположены на этих серверах, и выяснили, что в этом дата-центре есть практически все. Смогли посмотреть на ячейки Поиска Mail.Ru, они, нужно сказать, никак не отличаются от всех остальных :)

Безопасность и экстренные ситуации

Во всех коридорах и проходах дата-центра расположены системы видеонаблюдения. Каждый коридор просматривается с двух сторон, камеры находятся под потолком гермозоны. Добраться до камер можно только со стремянки, но и это практически нереально, потому как происходящее в помещениях наблюдается с поста охраны, а запись ведется постоянно. На мой вопрос: “А можно ли обмануть систему?” – ребята в шутку ответили, что обойти ее можно разве что с помощью технологии “стелс”.

Фотографию заберите на выходе

Кроме этого, меня интересовал вопрос электричества: что происходит, если вдруг происходит сбой.

Во-первых, эта ситуация не является опасной, потому как у дата-центра есть второй, независимый луч питания. Но если все же рассматривать ситуацию, когда нет напряжения ни по одному лучу питания от города, то стартуют ДГУ, а на время старта генератора (не более 20 секунд) нагрузку берут на себя источники бесперебойного питания. Время автономной работы на имеющемся в ДГУ топливе – 6-8 часов при полной нагрузке. Но, несмотря на это, у дата-центра есть контракты с целым рядом компаний-поставщиков дизельного топлива, которые в соответствии с условиями договора должны доставить топливо в течение 2-4 часов. И этого должно хватить с запасом.

Другие помещения

Когда мы вышли из ярко освещенного помещения серверной и сняли наконец-то синие бахилы, нас пригласили заглянуть в гости к дежурной смене. Сопровождающий нас сотрудник дата-центра провел нас внутрь. Наше внимание привлекли огромные экраны мониторинга, за которыми следили сразу несколько человек. Я, честное слово, представила, словно попала на базу секретной службы. Если присмотреться, то на экранах можно увидеть (помимо расположения ячеек) видеоконференции между площадками и информацию по открытым и взятым в работу тикетам системы ServiceDesk.

Выйти нам было настолько же сложно, как и попасть внутрь. Охрана с подозрением всматривалась в наши лица, но не нашла ни малейшей опасности, поэтому мы с легкой душой и полной картой памяти в фотоаппарате направились в офис.

Автор: yeah_boss