История проекта уходит корнями в далекий 2006 год.

Тогда в питерский НИИ Робототехники и технической кибернетики (ЦНИИ РТК) обратился активный член общества слепых с предложением создания устройства помощи слепым и слабовидящим.

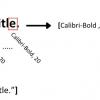

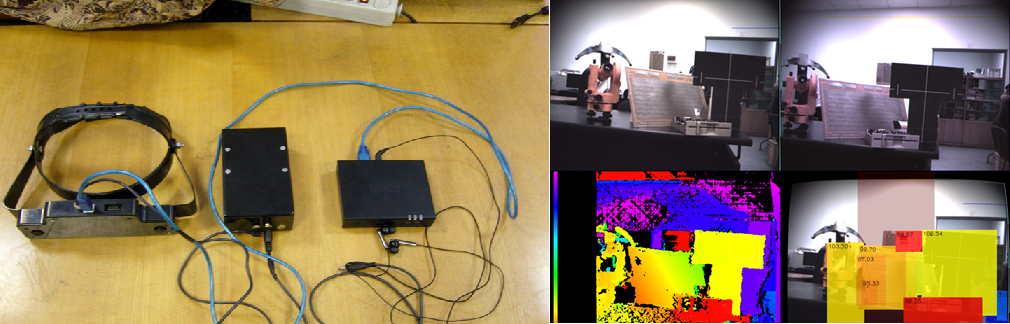

Один из основателей нынешнего Oriense тогда заведовал отделом телевизионных информационно-измерительных систем, который занимался в том числе зрением роботов и разрабатывал свою стереокамеру. На ней устройство и решили базировать: носимый компьютер обрабатывает информацию от двух камер и двух УЗ-сонаров и выдает подсказки в наушники с помощью голосового синтезатора.

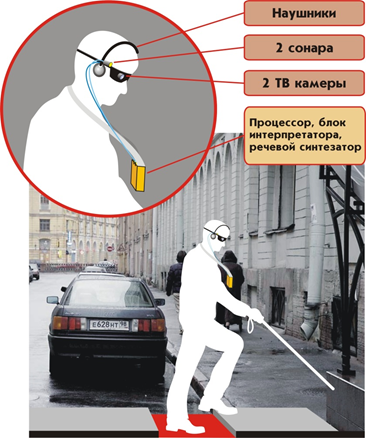

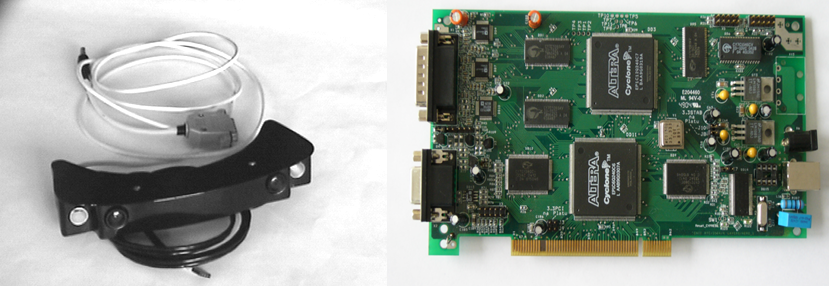

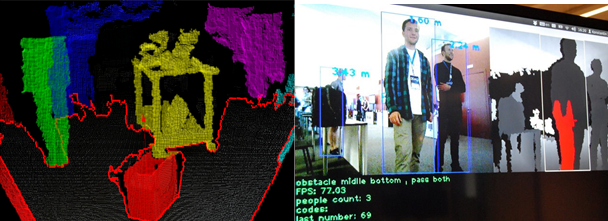

Карту глубины должен был строить отдельный стерео-процессор на Altera, но до этого не дошло, процессор лишь осуществлял стерео-ввод. ПО бортового компьютера строило облако точек, сегментировало на объекты, по-простому их классифицировало, определяло степень опасности и выдавало предупреждения.

Макет был сделан, проект привлек достаточное внимание, но подобного исполнения и функционала было недостаточно, а дальше дело не пошло и проект заморозился, так и не дойдя до пользователей.

В 2010 году работы возобновились, но в итоге вперед мы практически не продвинулись, лишь несколько осовременив макет. Тогда стало окончательно ясно, что доведение подобного устройства до состояния реальной полезности потребует немало времени и финансовых влияний. Да и подход должен быть другим: как и многие коллективы, пытавшиеся создать нечто подобное, мы отталкивались от имеющихся технологий, а не от реальных нужд пользователей. В итоге проект был снова заброшен, не считая моих экспериментов с распознаванием изображений в рамках диссертации и аспирантских грантов правительства Петербурга.

В 2012 был третий подход к снаряду, но этот раз в виде студенческо-аспирантской разработки для Microsoft Imagine Cup. Стерео-камера была заменена на Кинект (примотанный скотчем к строительной каске), софт на скорую руку был дополнен распознаванием объектов, текста и лиц.

Петербургский этап мы выиграли, а на Всероссийский довольствовались спец-призом от Intel. Затем был БИТ (конкурс «Бизнес инновационных технологий) — второе место и спец-приз — поездка на Slush. Затем школа стартапов SumIT, где нас приметили управляющие партнеры стартап-акселератора iDealMachine Сергей Фрадков и Михаил Авербах. Мы попали в акселератор, получили 20 тысяч долларов preseed’a от фонда RSV Venture Partners и стали стартапом Oriense, с поддержкой ЦНИИ РТК. Дело было в ноябре 2012.

iDealMachine поставил нам правильный процесс разработки, мы наконец-то пошли непосредственно к незрячим и слабовидящим с вопросами и сформировали проблему и требуемый функционал. Прототип был доведен до терпимого для демонстраций состояния, Кинект заменен на PrimeSense Carmine, закрепленным на груди. Агрегат был наконец протестирован незрячими в центре медико-социальной реабилитации инвалидов по зрению.

Затем мы погрузились в обычные стартаперские хлопоты: искали финансирование следующего этапа, решали юридические и организационные вопросы, много презентовались (в том числе на DEMO Europe и «железном» VC Day Ingria). В июне 2013 мы получили государственный грант по программе СТАРТ Фонда содействия, немного расширили штат, закупили комплектующих и наконец плотно занялись разработкой. Сейчас мы доделываем первую версию продукта, на которую у нас есть небольшой предзаказ от образовательного центра «Эдукор», уже имеющего опыт использования разработки РТК для людей с ограниченными возможностями – образовательный класс с устройствам для управления компьютером без помощи рук.

Oriense-1 все еще основан на PrimeSense, поэтому будет работать лишь в условиях помещений, но мы хотя бы сможем обкатать софт локальной навигации и конструкцию носимого устройства. В качестве бортового компьютера используется Odroid-U2, сейчас дорисовывается корпус.

Параллельно мы работаем над 3D сенсором на стерео-камере, планировалось использовать чип стерео-зрения компании Etron, но переговоры с ними пока зашли в тупик. На базе платы Hardkernel с SoC Exynos 4412 мы прорабатываем свой одноплатный компьютер, который будет включать всю сенсорику: стерео, GPS/GLONASS, 9-осевой датчик положения и опционально 3G-модем. Возможно, что стерео будет обсчитываться на новых 16-ти ядерных процессорах Epiphany от Adapteva, которые используются в Parallella Board. Таким образом мы сможем сделать устройство состоящее из одного модуля, с полным функционалом: локальная навигация, глобальная навигация, чтение текста, распознавание объектов и.т.д.

Мы хотели выпустить GPS-навигатор и как отдельный девайс, на базе RaspberryPi и платы сенсорики — она сейчас в разводке. Софт планировалось сделать открытым, на базе данных OpenStreetMap, под Линукс, чтобы затем включить его в полнофункциональное устройство. Правда пока по этому софту продвижения нет.

Самым популярным средством GPS навигации у незрячих являлось приложение LoadStone GPS для Symbian, но в связи с кончиной платформы они вынуждены переходить на смартфоны, и на базе приложения OsmAnd под Андроид есть разработанная в России версия для незрячих Osmand Access, включающая в себя и часть функционала LoadStone. Большой минус смартфона в отсутствии физической клавиатуры, поэтому мы сейчас общаемся с разработчиками OsmAnd Access на предмет создания заточенного под него навигатора с ее наличием.

1-2 ноября мы будем в Москве на Форуме «Открытые инновации» (благодаря тому что Russian Startup Rating одарил нас наивысшим AAA), 6-7 ноября на Webit Congress в Стамбуле, с собственным стендом.

Базируемся мы в Питере, наш сайт – oriense.com, почта – info@oriense.com, твиттер, канал на ютюбе, последняя версия нашей презентации

Спасибо за внимание, будем рады фидбеку.

Автор: zhukovv