Некоторое время назад я был в восторге от Ollama: простое скачивание моделей одной консольной командой, наличие SDK для NodeJS и Python, OpenAI-подобное API. Однако, так как отрасль рынка активно развивается, инструмент с каждым днем становится менее конкурентноспособным

Проблемы Ollama

Пункты ниже заставят вас задуматься рассмотреть другой инструмент запуска GGUF, например: LMStudio, LocalAI, KoboldCPP, vLLM или llama-server

-

Модели-шизофреники c тысячами загрузок

В рейтинге Berkeley Function-Calling Leaderboard модель watt-ai/watt-tool это топ по вызову инструментов, который обходит даже OpenAI. Что залито в репо Ollama не понятно, не вывозит даже слова "Привет", одну тысячу человек развели на 5ГБ трафика. К слову, генерация зациклилась: модель будет нести бред до посинения, пока вы сами не нажмете Ctrl + C

-

Три релиза подряд Gemma3 падает из-за нестабильного планировщика памяти

Fixed issues where gemma3 would crash with "out of memory (OOM)" errors by improving memory estimation Для пользователей мобильного интернета, крайне неудобная особенность: чтобы оперативно запустить поддержку Gemma, Ollama три недели подряд заливала спамящие нестабильные релизы. Каждый релиз весит от 600МБ до 1ГБ

-

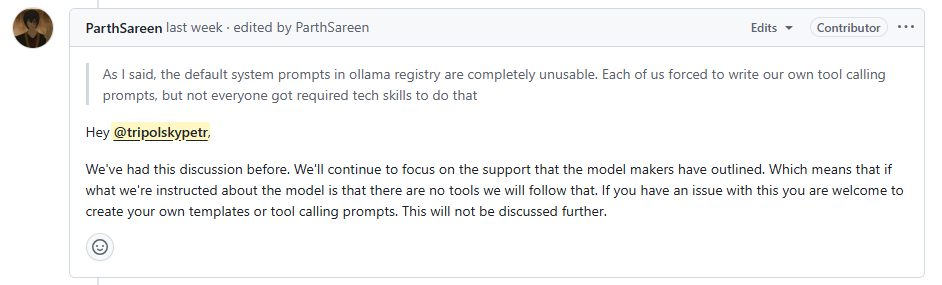

Поддержка инструментов всеми моделями библиотеки Ollama нестабильна

Если в модели не работают tool calling - это ваша проблема У Ollama свой язык для объявления system prompt для моделей: Modelfile. На текущий момент он не стабилен. Как следствие, у моделей nemotron-mini и qwen2 шилдик tools есть, а инструменты не работают. Там, где после патча Modelfile инструменты таки заработали, они работают раз от раза

-

Открытый обман в официальных заявлениях

Посмотрите внимательно на архитектуру модели В репо Ollama есть

Deepseek-R1. Однако, это вовсе не DeepSeek, а обычная LLama 3.1, обученная на его дистиляции. Была использована эта модель из HuggingFace. Как следствие, если запрос на русском к модели содержит англицизм, например,Расскажи мне о work-life balance для программистов при выгорании, модель частично пишет ответ на русском, частично на английском -

Некорректные Modelfile, которые пишет сама Ollama

Перечисление списка инструментов через python скрипт в Modelfile просто не работает. Совсем. Некоторое время назад попытался скачать CommandR из репо Ollama. Модель весит 19ГБ, со слов производителя, специально заточена под вызов инструментов. На момент публикации Modelfile не умел давать модели список инструментов, в итоге

CommandR не командует(. Новые модели вообще публикуют без поддержки tool calls вовсе

Спасибо за внимание!

Предлагаю обсудить изложенные выше пункты в комментариях на предмет предвзятости автора

Автор: tripolskypetr