Что такое Open Compute Project (OCP)?

В России об этом известно довольно мало, в основном рекламные заявления о миллиардах экономии Facebook с помощью OCP.

Официально Open Compute Project — это сообщество, основанное Facebook, с целью создать наиболее оптимальную инфраструктуру для ЦоД с минимальной оглядкой на существующие варианты.

На самом деле Facebook долго пытался придумать оптимальный вариант для датацентра, сон разума рождал чудовищ наподобие триплета (тройной стойки, одна из которых — огромный бесперебойник). Долго ли, коротко ли идеи бродили, но в один прекрасный день кому-то пришла в голову отличная мысль — создать сообщество и привлеченные энтузиасты подкинут идей.

Стоит отметить, что результат получился очень неплох.

Цели OCP:

- Повысить наработку на отказ (MTBF).

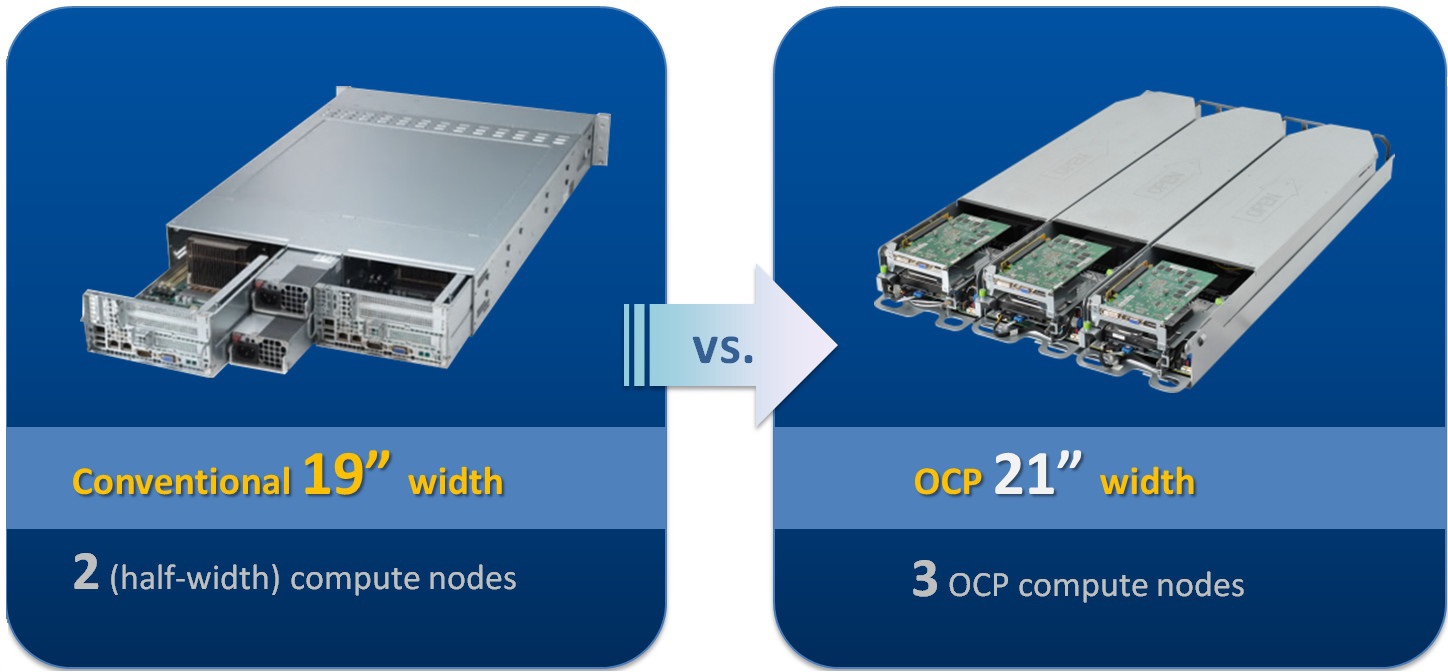

Отказ от «лишних» элементов на плате повысил наработку на 35%. - Повысить плотность стоек.

Переход на 21 дюйм позволяет вместить больше серверов при сохранении функционала каждого из них.

Шире стойка — больше влезет

- Упростить и ускорить обслуживание.

- Оптимизировать для работы из холодного коридора.

Хватит бегать между рядами

- Повысить энергоэффективность.

При внешней температуре 35 градусов

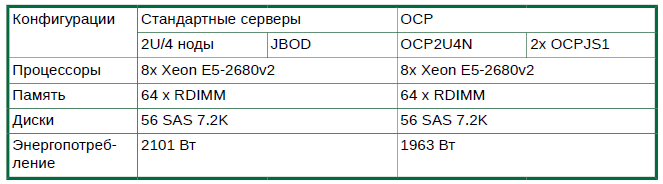

Снижение энергопотребления на 11% при одинаковой нагрузке и внешних условиях.

Что получилось?

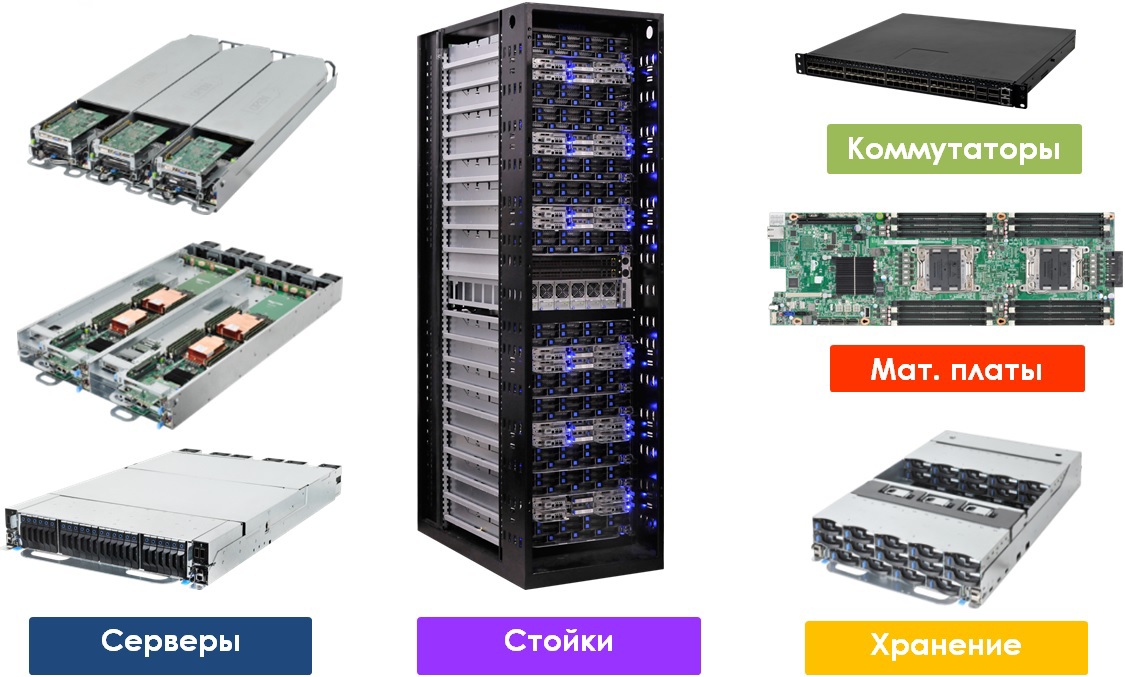

Получилась полная линейка для Software-Defined Datacenter.

Всё, что нужно

Не забыта и система удаленного управления. OCP RMC (Rack Management Controller) мониторит состояние серверов и блоков питания, управление происходит через Web, SMASH CLI или SNMP.

Контроллер стойки

Возможности:

- Удаленное управление питанием.

- Мониторинг потребления стойки и серверов.

- Установка пределов по энергопотреблению стойки и узлов.

- Мониторинг состояния БП и серверов.

- Поддерживает горячую замену.

- Аутентификация через LDAP.

Поддерживаемые протоколы:

- IPMI/RMCP+

- SMASH CLI

- SNMP

- HTTP/HTTPS

- NTP, SMTP, Syslog

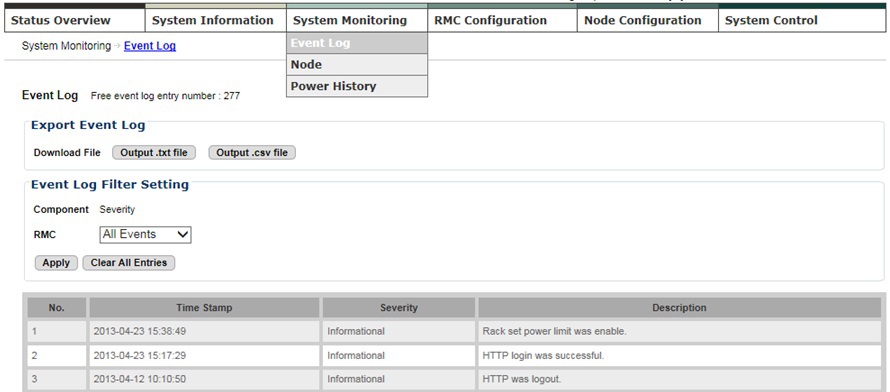

Скриншоты:

Журнал событий

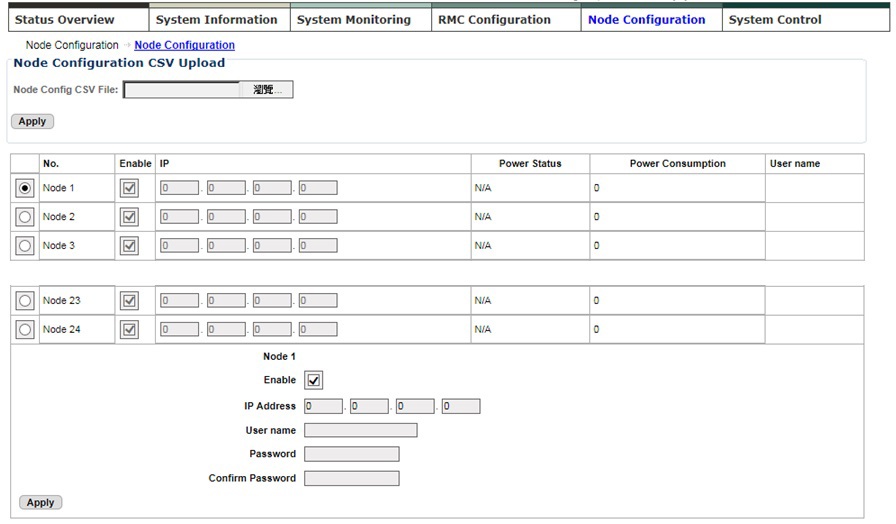

Конфигурирование узлов

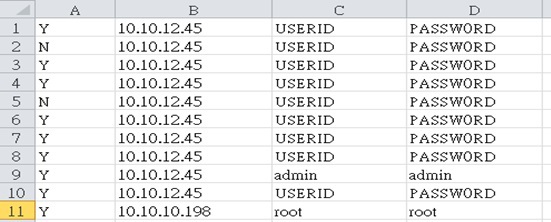

Так задаются конфигурации узлов

A. Включить/выключить лимит потребления (Y/N)

B. ME IP Address

C. ME Username

D. ME Password

Надо отметить, что Facebook полагается на возможности Intel Management Engine и не пользуется IPMI/KVM over IP, считая их избыточными. В случае поломки меняется целиком сервер, без попытки через удаленное управление следить за процессом загрузки. На этот случай есть вариант 10G SFP+ дочерней платы с интегрированным полнофункциональным сервисным процессором и все радости IPMI/KVM over IP с виртуальным носителем в комплекте.

Модельный ряд

От общего представления пора перейти к предлагаемым моделям.

Стойка

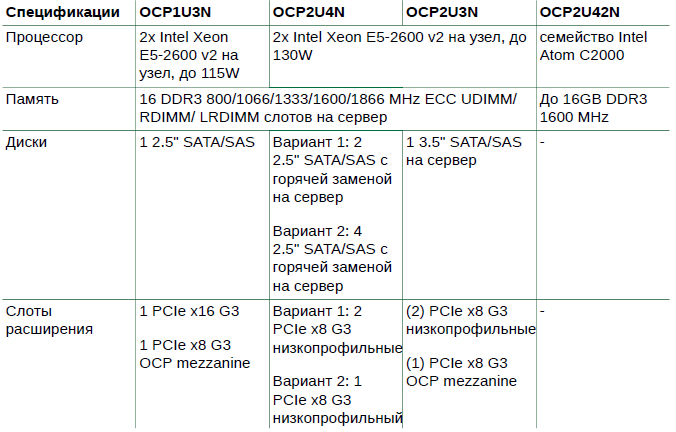

Серверы

Линейка разработана исходя из минимализма, есть только то, что действительно необходимо. Основная сеть сделана в виде дочерней (mezzanine) платы, есть варианты

10G, InfiniBand, FC.

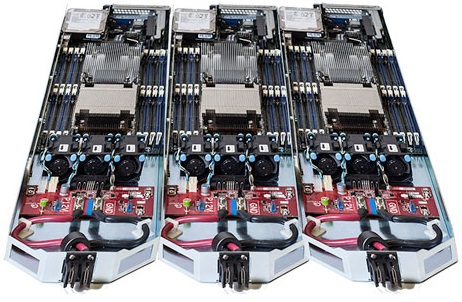

Платформа OCP2U4N сделана в форм-факторе 2OU (Open Unit) и вмещает 4 сервера. Четыре диска с горячей заменой и один PCI-E либо два диска и два PCI-E слота на каждом сервере плюс OCP mezz для высокой плотности вычислительных ресурсов, дискового пространства и карт расширения (например flash ускорителей). В качестве сетевого интерфейса по умолчанию используется дочерняя плата OCP Mezz с двумя 10G SFP+ портами и полнофункциональным BMC процессором.

Вид поближе

Используются вентиляторы с горячей заменой, общие для всех серверов.

Универсальные серверы для различных задач, от web 2.0 до вычислений. Централизованное питание и отсутствие ненужных элементов на плате повышают показатель MTBF на 58% по сравнению с традиционными стоечными системами. Два слота расширения, OCP mezz и место под жесткий диск дополняют картину. В качестве сетевого интерфейса по умолчанию используется дочерняя плата OCP Mezz с двумя 10G SFP+ портами и полнофункциональным BMC процессором.

Платформа OCP1U3N для вычислительных задач максимально утилитарна. 16 слотов для памяти, один PCI-E слот, OCP mezz для InfiniBand или 40G Ethernet, одно место под жесткий диск и пара сетевых интерфейсов, включая управление. 90 нод на стойку с охлаждением воздухом (115Вт на процессор) плюс коммутаторы — отличный результат!

Микросервер? Кто упомянул микросервер?

И они тоже есть. 42 сервера на базе процессоров Intel Atom серии C2000 в формате 2OU, два коммутатора c поддержкой OpenFlow коммутации на базе матрицы Intel FM5224 с двумя 40G аплинками на каждом. Почти 4 гигабита входящей пропускной способности на каждый сервер обеспечат работу любого распределенного приложения. Все компоненты поддерживают горячую замену для упрощения развертывания и обслуживания.

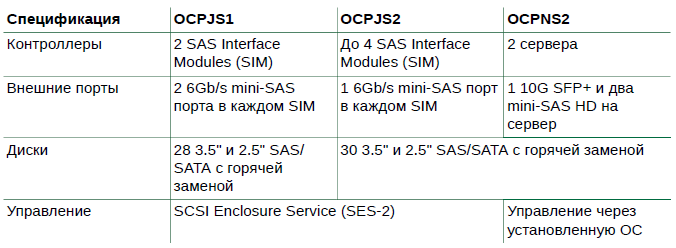

СХД

Никаких специализированных СХД, только Software Defined Storage на дисковых полках. Хотя никто не запрещает ставить аппаратные RAID контроллеры.

Дисковая полка с хитринкой в формате 2OU вмещает 28 дисков 3.5" с горячей заменой. Хитринка в двуслойном размещении дисков, что и позволило упаковать 28 шпинделей в корпус, которые фиксируются в корзинах без использования винтов (видео было выше). SAS экспандеры фиксированы в корпусе, если выдвинуть корзину для обслуживания второго ряда дисков — не будет мучений с кабелями, которые останутся на месте.

Еще одна дисковая полка, также сделана в формате 2OU и вмещает 30 дисков 3.5" с горячей заменой. Два поддона с дисками, на каждом по 15 шпинделей плюс два SAS экспандера, все заменяется на горячую без дополнительного инструмента.

Аналогичный предыдущему продукт, вместо экспандеров ставится два сервера на основе Intel Atom C2000 (один на 15 дисков). На каждом сервере есть интерфейс 10G SFP+ в сеть и внешние SAS порты для расширения пространства. Хороший выбор для «холодных» данных.

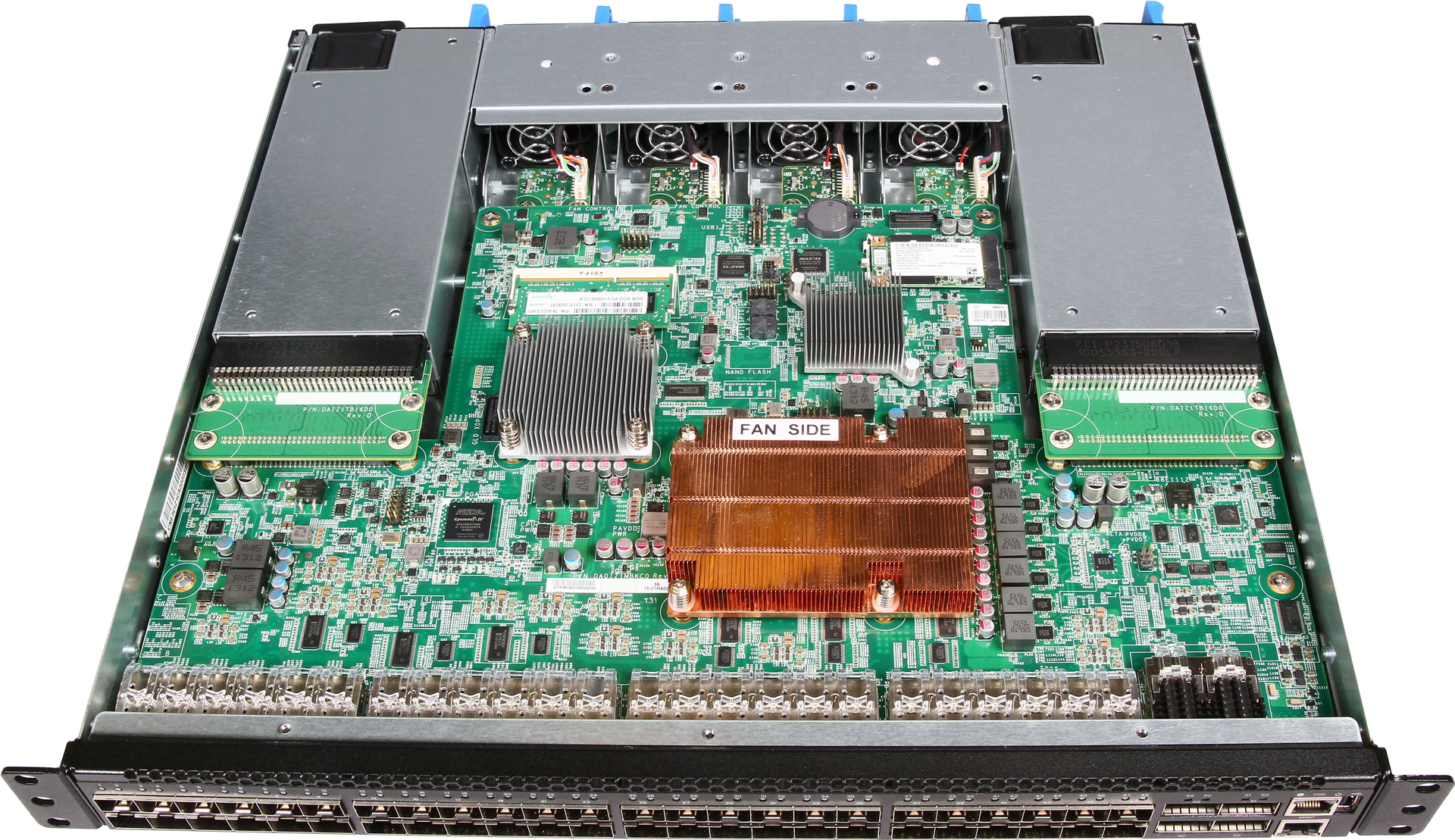

Сетевая инфраструктура

Коммутаторы используются совершенно стандартные по габаритам. Как вы уже заметили

из описания моделей, гигабит для основной сети не используется в принципе, минимально — 10G. Сам Facebook присматривается к 40G и выше, но пока цена перехода не позволяет это сделать.

Другая важная тенденция в рамках стратегии Software Defined Datacenter, это переход к программно-конфигурируемым сетям, Software Defined Networking (SDN). Предполагается, что переход на SDN радикально ускорит развертывание сетей, снизит затраты на эксплуатацию и сурово напакостит всем сетевым производителям с фирменными технологиями :)

Кстати, в нашей предыдущей статье был описан идеальный коммутатор для SDN и способ получения его совершенно бесплатно :)

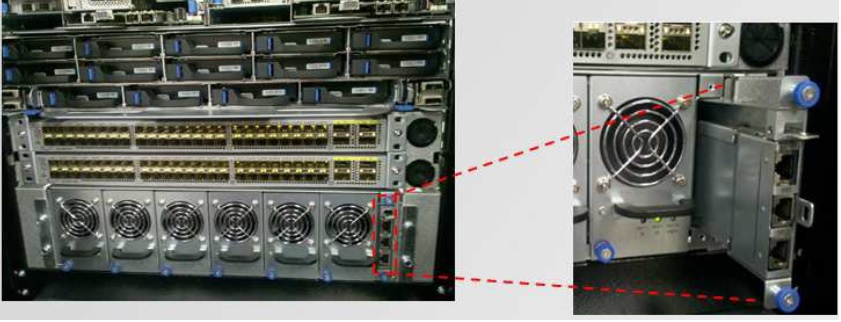

Software Defined Network (SDN) на основе открытой платформы Intel ONS

Вид коммутатора изнутри

Итого

OCP, на первый взгляд, выглядит непривычно для широкой аудитории. На второй взгляд все становится намного интересней. Решение подходит не только для крупных интернет компаний, но и для предприятий с большими внутренними ИТ мощностями.

В пассиве:

- Непривычный формат внутренней части стойки, несовместимый с 19".

- Непривычный подход к формированию решения в целом.

В активе:

- Снижение расходов на электроэнергию.

- Простота и невероятное удобство в обслуживании.

- Снижение расходов на приобретение.

Если вы рассматриваете решение, которое займет (в обозримой перспективе) стойку и более, то переход на OCP будет очень интересным вариантом. Проприетарные решения привяжут вас к определенной, весьма ограниченной по возможностям инфраструктуре.

Ну а мы представили решение на базе Open Compute в линейке продукции.

Автор: ETegro_Technologies