Как работает Google Поиск, основные алгоритмы обновлений

В наше время поисковые системы, в частности Google, напоминают «витрину» Интернета и являются наиболее важным каналом распространения информации в цифровом маркетинге. С помощью глобальной рыночной доли, которая составляет более 65% по данным за январь 2016 года, Google явно доминирует в поисковой индустрии. Хотя компания официально не раскрывает степень своего роста, к 2012 году было подтверждено, что их инфраструктура обслуживает около 3 миллиардов поисковых запросов в день.

Google.com глобально занял звание сайта номер 1 в Alexa Top 500 Global Sites. Учитывая эти цифры, владельцам собственных веб-страниц особенно важно иметь хорошую видимость своих сайтов поисковой системой.

Но не смотря на такую всеобщую популярность Google, знаете ли вы, как он действительно работает и что это за панды, пингвины, калибри?

Чем нужнее становится Google для современного маркетинга, тем важнее понимать функции поиска и алгоритмы обновлений, которые оказывают непосредственное влияние на ранжирование результатов. Moz предполагает, что Google изменяет свои алгоритмы по 600 раз за год. Многие из этих изменений и связанные с ними факторы ранжирования держатся в секрете. И только о крупных обновлениях объявляют публично.

В этой статье мы рассмотрим основы функциональности поисковой системы и объясним основные обновления алгоритма Google, начиная с 2011 года. Выведем также стратегии, следуя которым можно идти в ногу с изменениями поисковой системы. Так что читайте дальше…

Как работает Google?

Своим появлением поисковые системы напрочь изменили привычный для нас способ сбора информации. Интересует ли вас обновление данных фондового рынка или вы хотите найти лучший ресторан в районе, либо пишете академический отчет об Эрнесте Хемингуэе — поисковик даст ответ на все запросы. В 80 годы ответы на вопросы потребовали бы посещения местной библиотеки. Теперь же все решается в течении миллисекунды с использованием алгоритмических полномочий поисковика.

В этом отношении главная цель поисковой системы заключается в том, чтобы максимально быстро найти уместную и актуальную информацию, как ответ на введенные поисковые термины, также называемые ключевыми словами. Поэтому центральным аспектом для любой поисковой системы, желающей выдать действительно полезный результат, является понятие цели поиска, того, как именно люди ищут.

Результат работы Google можно сравнить с интернет-каталогом, отобранным с помощью рейтинговой системы на основе алгоритмов. Более конкретно алгоритм поиска можно описать как «нахождение элемента с заданными свойствами среди списка элементов».

Давайте теперь подробнее рассмотрим привлеченные процессы сканирования, индексирования и позиционирования.

Сканирование

Сканирование может быть описано, как автоматизированный процесс систематического изучения общедоступных страниц в Интернете. Проще говоря, во время этого процесса Google обнаруживает новые или обновленные страницы и добавляет их в свою базу. Для облегчения работы он использует специальную программу. «Googlebots» (можно встретить альтернативные названия: «боты» или «роботы») посещают список URL-адресов, полученных в процессе прошлого сканирования и дополненных данными карты сайта, которую предоставляют веб-мастера и анализируют их содержание. При обнаружении ссылок на другие страницы во время посещения сайта, боты также добавляют их в свой список и устанавливают систематические связи. Процесс сканирования происходит на регулярной основе в целях выявления изменений, изъятия «мертвых» ссылок и установления новых взаимосвязей. И это при том, что только по данным на сентябрь 2014 года насчитывается около миллиарда веб-сайтов. Можете себе представить сложность такой задачи? Тем ни менее, боты не посещают абсолютно каждый сайт. Чтобы попасть в список проверяемых, веб-ресурс должен быть рассмотрен, как достаточно важный.

Индексация

Индексация — процесс сохранения полученной информации в базе данных в соответствии с различными факторами для последующего извлечения информации. Ключевые слова на странице, их расположение, мета-теги и ссылки представляют особый интерес для индексации Google.

Для того чтобы эффективно хранить информацию о миллиардах страниц в базе данных поисковой системы, Google использует крупные центры обработки данных в Европе, Азии, Северной и Южной Америке. В этих центрах, как было подсчитано, на основе энергопотребления Google в 2010 году, работает около 900,000 серверов.

Основная цель процесса индексации: быстро реагировать на поисковой запрос пользователя. Его как раз мы и будем обсуждать на следующей стадии.

Обработка

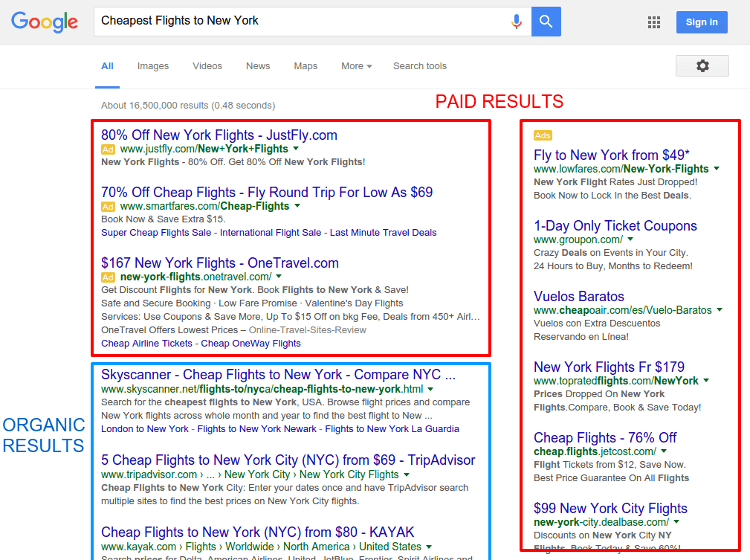

Когда пользователь вводит запрос, Google производит в базе данных поиск, подходящий под условия и алгоритмически определяет актуальность содержания, что выводит к определенному рейтингу среди найденных сайтов. Логично, что результаты, которые считаются более релевантными для пользователя поисковой системы, намеренно получают более высокий ранг, чем результаты, которые имеют меньше шансов обеспечить адекватный ответ.

Хотя Google и не выпустил официальных данных об этом, компания подтверждает, что использует более 200 факторов для определения релевантности и значимости конкретной страницы.

Естественно, всем веб-разработчикам важно знать, каковы факторы ранжирования, которые влияют на позицию страницы в поисковой выдаче. Иногда Google дает определенные намеки, объявив важные изменения в обновлениях своих алгоритмов.

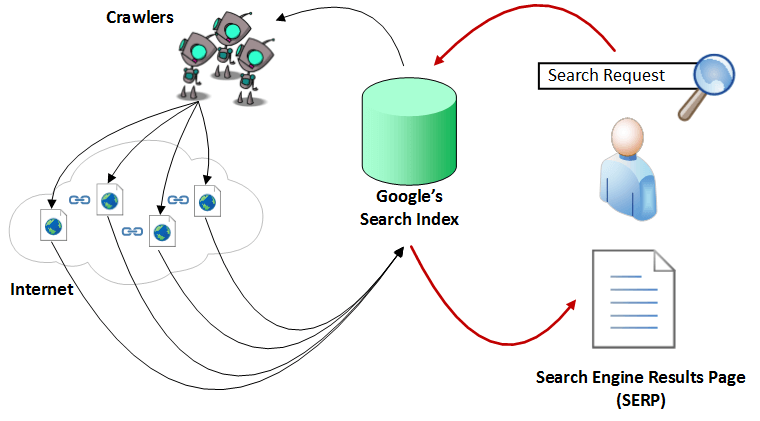

Все вышеописанные процессы сканирования, индексирования и позиционирования можно изобразить с помощью такой схемы:

Теперь, когда у вас есть базовое понимание того, как работает Google, рассмотрим основные обновления алгоритмов поиска, начиная с 2011 года.

Обновление алгоритмов начиная с 2011

Как вы и сами понимаете, Google никогда не будет публично раскрывать свои алгоритмы поиска и факторы ранжирования результатов. Это было бы равносильно тому, чтоб компания Coca-Cola выкладывала рецепты своей знаменитой газировки в Интернет. Тем ни менее, Google желает улучшать уровень пользовательского опыта и обеспечивать самые лучшие результаты поиска. Для того, чтобы уменьшить внедряемый контент в результатах поиска, компания хочет проинформировать веб-мастеров о том, когда и как изменились главные стандарты качества отбора. Поэтому вполне вероятно, что перед проведением крупного обновления алгоритма, последует анонс на Google Webmaster Central Blog.

Итак, давайте рассмотрим основные обновления, которые были осуществлены, начиная с 2011 года:

Panda

Обновление Panda впервые было представлено в конце февраля 2011 года. После было выпущено достаточно много его апдейтов, на данный момент текущая версия: 4.2. Обновление можно рассматривать, как значительное улучшение алгоритма поиска, потому что оно нацелено на повышение качества контента веб-сайтов. Основная идея заключается в том, что оригинальные сайты с авторским контентом в поисковой системе должны занять место выше, чем страницы с низким качеством, повторяющие то, что уже и так известно или же являющиеся копиями других сайтов. Обновление Panda установило новый базовый уровень стандартов качества:

- содержимое на странице должно иметь существенный объем. Больший объем информации статистически занимает место выше, чем содержащий меньше 1500 слов;

- информация, представленная на сайте должна быть оригинальной. Если вы просто копируете содержимое других веб-ресурсов, Google накажет за это;

- содержание сайта должно вносить что-то новое к теме. Мало кому будет интересно в сотый раз перечитывать одно и тоже. Для успешного продвижения контент должно быть то, чего нет на других сайтах;

- текст сайта должен быть орфографически и грамматически правильным и основываться на проверенных фактах;

- если вы собираетесь автоматически генерировать контент из базы данных, содержание должно соответствовать описанным стандартам.

Page Layout (Top Heavy)

Обновление, впервые выпущенное в январе 2012 года, предусматривает наказание сайтов, которые используют слишком много рекламы в верхней части страницы или делают ее чрезмерно агрессивной, отвлекающей от основного содержания. Это спровоцировано большим количеством жалоб от пользователей, которым бывало сложно найти нужную информацию и приходилось долго прокручивать страницу вниз. Данным обновлением Google призывает веб-мастеров размещать содержимое сайта в центре внимания. В этом отношении большое число рекламы мешает удобству усвоения информации.

Penguin

Был выпущен в апреле 2012 года. Новый алгоритм, направленный на борьбу с поисковым спамом. Сайты, которые использовали спам-методы, были значительно понижены в рейтинге или вовсе удалены из него.

Ещё одной особенностью Penguin является способность анализировать ссылочную массу.

Pirate

С обновлением Pirate, которое было введено в августе 2012 года, Google снизил рейтинг сайтов, нарушающих авторские права и интеллектуальную собственность. Для измерения этих нарушений, Google использует систему запросов о нарушении авторских прав, основанную на Digital Millenium Copyright Act. Правообладатели могут применять инструмент, чтобы сообщить и удалить содержание сайта плагиаторов из базы данных Google.

Exact Match Domain(EMD)

Выпущено в сентябре 2012 года и направлено на борьбу с доменами, похожими на MFA.

MFA(made-for-adsense) – домен, который создан специально для контекстно-медийной системы Google. Обычно такой домен предназначен для какого-то одного запроса (или семейства запросов) и на нем установлен Google Adsense. Пользователь, попавший на этот домен, не видит ничего, кроме рекламы и в итоге либо закрывает сайт, либо переходит дальше по контекстному объявлению. После выпуска алгоритма EMD, сайты, содержащие в доменном имени запрос, были изъяты или очень существенно понижены в рейтинге.

Payday Loan

Выпущен в июне 2013 года и направлен на уменьшение страниц, которые содержат переспамленные запросы. Такие запросы часто используются веб-мастерами для продвижения страниц определенной тематики.

Обновление было запущенно в связи с многочисленными жалобами, в которых говорилось, что даже после внедрения Panda и Penguin чистота выдачи оставляла желать лучшего.

Рассмотрим это обновление на обычном примере. Допустим, вам нужно купить дверь. Если ввести запрос, Google выдаст фотографии дверей. Из них: 2-3 страницы, где непосредственно можно купить двери, 3-4 сайта компаний-производителей дверей и 2-3 сайта о том, как выбрать и поменять дверь. Если бы не было обновления Payday Loan, вы бы увидели 15-20 запросов на одну тематику (к примеру, где купить дверь).

Критерии, по которым происходит отбор таких сайтов, Google раскрывать не хочет, но данный алгоритм явно упростил жизнь пользователям поисковой системы.

Hummingbird

С сентября 2013 года Google реализовал замену алгоритма поиска, которая была названа Hummingbird. Основные обновления, как Panda и Penguin, были интегрированы с этим новым алгоритмом. Имя Hummingbird выбрали в качестве синонима для описания гибкости, точности и скорости нового обновления.

Вместо того, чтобы возвращать точные ответы на запросы, используя введенные пользователем ключевые слова (как это было раньше), Google интерпретирует намерения и контекст поиска. Цель состоит в том, чтобы понять смысл поискового запроса пользователя и возвращать соответствующие результаты. Это означает, что точные совпадения ключевых слов становятся менее важными в пользу поиска намерения. В качестве примера: если вы вводите запрос «погода», то вряд ли ожидаете получить полное объяснение самого термина. Скорее в данном случае имеются в виду погодные условия. Что-то наподобие:

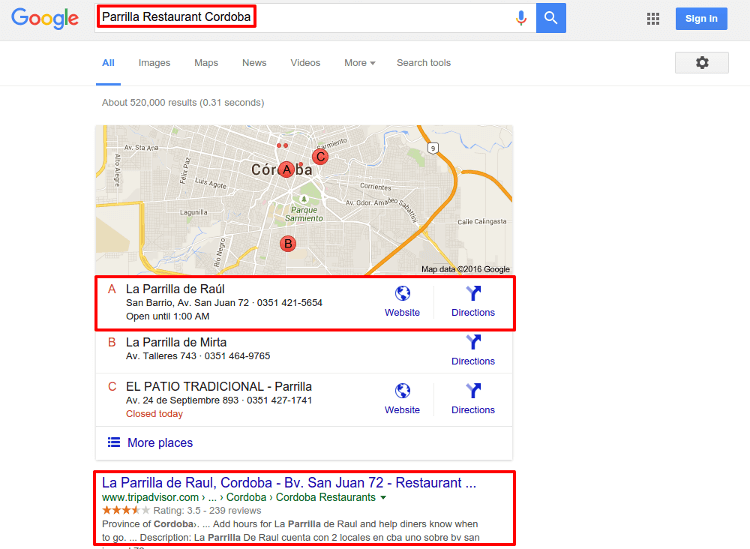

Pigeon

Обновление Pigeon впервые выпущено в июле 2014 года. Основное внимание в нем уделяется результатам геозависимого поиска. Расстояние и местоположение пользователя являются ключевыми параметрами ранжирования, чтобы обеспечить точность результата. Это обновление тесно связано с Google Maps. Например:

Mobilegeddon

Было выпущено в апреле 2015 года. Это обновление влияет только на мобильный поиск, оно дает преимущество страницам, дружественным к мобильным устройствам.

В текущем состоянии, обновление не влияет на результаты поиска со стационарных компьютеров или планшетов. В отличие от Panda или Penguin, алгоритм работает в режиме реального времени.

Существует специальный тест, с помощью которого веб-мастера могут проверить совместимость своего сайта с мобильными устройствами. Также можно использовать отчеты о мобильном юзабилити в Google Webmaster Tools, только они могут работать с задержкой.

Как идти в ногу с изменениями алгоритмов?

Обсуждение основных обновлений алгоритмов за последние годы, вероятно ставит перед вами вопрос, как не отставать от этих изменений? Основная задача Google — постоянно двигаться в направлении обеспечения самого высокого качества и надежности ответов на пользовательские запросы. В то время как технические особенности могут модифицироваться, широкая стратегия вряд ли изменится.

Поскольку поведение человека постоянно меняется, задача Google также адаптировать свои алгоритмы согласно изменениям. К примеру, «Mobilegeddon» было введено в качестве реакции на растущую тенденцию поисков с мобильных устройств.

Главное — это понимание того, кто ваши клиенты. Сосредоточенность на реальных потребностях этих клиентов имеет фундаментальное значение для того, чтобы идти в ногу с изменениями.

Итак, если вы — веб-программист, вам особенно важно быть в курсе изменений алгоритмов поиска Google. Вот подборка нескольких полезных ресурсов, которые могут помочь оставаться в курсе событий:

Google Webmaster Central Blog — ваш главный источник для официальных новостей и обновлений, на нем довольно часто впервые объявляли об алгоритмических изменениях.

Moz Google Algorithm Change History — в этой базе данных Moz опубликовал каждое из заметных изменений алгоритма и обновлений начиная с 2000 года.

Search Engine Land – один из наиболее важных онлайн журналов для SEO и SEM. В нем есть целый раздел об обновлениях алгоритмов Google с соответствующими статьями.

Search Engine Roundtable – также включает в себя интересный раздел об обновлениях алгоритмов.

Mozcast — это визуальное представление об изменениях алгоритмов в виде сводки погоды.

Algoroo — инструмент, который отслеживает результаты поиска колебания вокруг 17000 ключевых слов в связи с изменением алгоритма. Очень полезный сайт для обнаружения немедленных обновлений.

Сохраняя традицию. Вот тут можно найти первоисточник.

Автор: ua-hosting.company