В нашем блоге на Хабре мы рассказываем о развитии своего облачного сервиса 1cloud, а также рассматриваем интересные вопросы развития технологий и работы с инфраструктурой. К последней теме относится и вопрос обеспечения охлаждения ЦОД. Группа ученых Университета Торонто опубликовала исследование метода, при котором температура в дата-центре специально повышается. Мы представляем вашему вниманию основные моменты этой работы.

С недавних пор значительная часть потребляемой электроэнергии и выбросов углерода приходится на дата-центры. Огромные мощности тратятся на их охлаждение, что и явилось основным мотиватором для проведения исследовательской работы в области температурного управления. Интересен тот факт, что до конца не понятно, на каком уровне необходимо поддерживать температуру в дата-центрах.

Большинство компаний устанавливает температуру, рекомендуемую поставщиками используемого оборудования, однако не ясно, как её повышение сказывается на работоспособности систем. В то же время, согласно результатам проведенных исследований, повышение температуры всего на 1 градус может сократить энергопотребление на 2-5%.

Именно по этой причине было решено провести исследование и ответить на вопрос, как следует управлять температурой в дата-центрах? Для этого был собран обширный набор данных о производственном оборудовании, который позволил изучить влияние температуры на рабочие характеристики аппаратуры, включая надежность подсистемы хранения данных, подсистемы оперативной памяти и сервера в целом.

На основании полученных результатов мы надеемся дать некоторые рекомендации по управлению температурой в дата-центрах, что позволит сэкономить достаточно большое количество энергии, сохранив надежность и производительность на высоком уровне.

Предисловие

Хотя увеличение температуры в дата-центре выглядит самым простым способом сэкономить электричество и снизить выбросы углерода, здесь возникают несколько проблем: одна из них – это возможное снижение надежности работы системы. К сожалению, подробной информации о влиянии высоких температур на работоспособность серверов очень мало, более того, она весьма противоречива.

По результатам одних исследований установлено, что каждые 10°C после 21°C увеличивают вероятность отказа электроники на 50%. В других работах сказано, что каждые 15°C повышают частоту отказов жестких дисков в два раза, а в своем недавнем исследовании компания Google установила, что низкие температуры, наоборот, еще больше вредят работе запоминающих устройств.

С повышением температуры в дата-центрах возникает еще одна проблема, связанная со снижением производительности серверов. Дело в том, что когда температура достигает критической отметки, процессор входит в режим дросселирования тактов (тротлинг), а кулеры начинают вращаться с увеличенной скоростью – все это приводит к дополнительным утечкам мощности и повышению энергопотребления.

Температура и надежность

Давайте сперва обратим внимание на два особых компонента аппаратного обеспечения – это жесткие диски и DRAM, поскольку в современных дата-центрах они заменяются наиболее часто.

Температура и ошибки в скрытых секторах жесткого диска (LSE)

LSE – это один из самых распространенных видов ошибок, когда отдельные секторы диска становятся недоступными, а хранимые на них данные теряются (если система не обладает избыточностью и не может их восстановить). 3-4% всех дисков сталкиваются с LSE, и эти цифры только растут, поскольку растут доступные емкости.

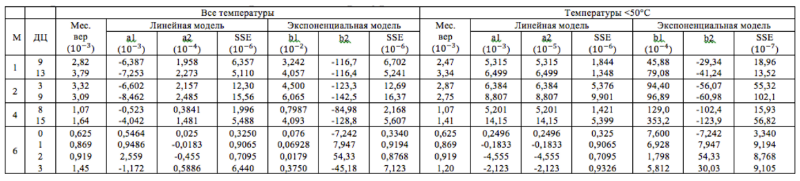

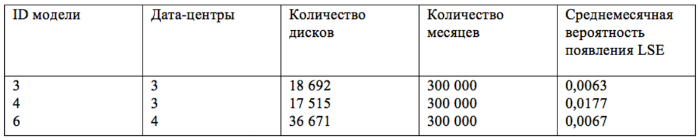

Чтобы проверить влияние температуры на появление LSE, мы взяли данные о трех моделях дисков, собранные в различных дата-центрах Google в период с января 2007 года по май 2009 года. У нас имелась информация о ежемесячном изменении внутренней температуры дисков, количестве ошибок в скрытых секторах, числе операций записи и чтения, а также возрасте записывающих устройств. Данные были собраны с помощью системы мониторинга SMART. В таблице ниже приведена собранная нами информация:

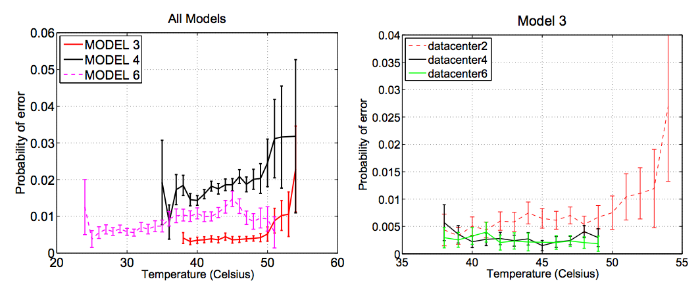

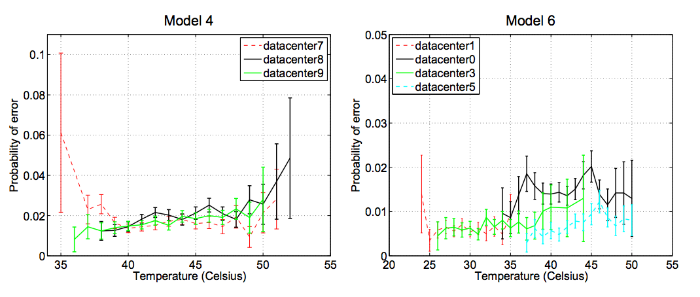

Рисунок 1 – Помесячная вероятность возникновения LSE как функция от температуры. Кривые трех последних графиков строились по данным разных дата-центров

На первой диаграмме (рисунок 1) показана вероятность возникновения LSE в зависимости от температуры для всех трех моделей дисков. Предел погрешности (здесь и во всей работе) вычислялся с уровнем доверия 95%. Большой разброс на высоких температурах возник из-за недостатка данных. Поскольку на надежность работы аппаратуры влияет огромное количество факторов (нагрузка, влажность, перепады напряжения, обслуживание устройств), мы разбили результаты, полученные для каждой модели, по дата-центрам.

Довольно очевидно, что с повышением температуры увеличивается и вероятность возникновения LSE. Однако увеличение происходит гораздо медленнее, чем предполагают стандартные модели оценки (например, модель, основанная на уравнении Аррениуса). Считается, что между температурой и количеством ошибок существует экспоненциальная зависимость, что ведет к удвоению частоты отказов за каждые дополнительные 10-15°C.

Чтобы как-то формализовать наши наблюдения, мы сравнили полученные данные с двумя моделями. Первая модель – простая линейная, то есть мы представили количество ошибок y как функцию от температуры t: y = a1 + a2t. Вторая модель – это модель Аррениуса, то есть экспоненциальная модель.

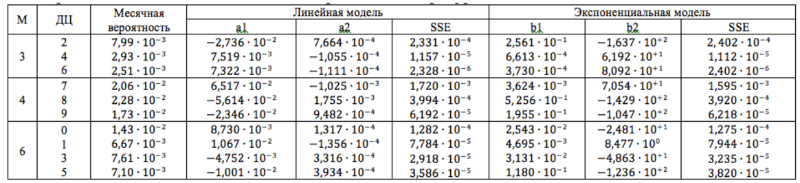

Результаты (включая значения параметров a1, a2, b1, b2 и соответствующие SSE – суммы квадратичной ошибки) представлены в таблице 1. Мы пришли к выводу, что во всех случаях линейная модель наиболее близко описывает зависимость LSE от температуры. Единственным исключением является диск №3 в дата-центре №2 – в этом случае больше подходит экспоненциальная модель. Скорее всего, это связано с внезапным ростом числа LSE на температурах, превышающих 50°C.

Таблица 1 – Параметры линейной и экспоненциальной моделей, описывающих зависимость вероятности возникновения LSE от средней температуры

Для нашего температурного диапазона (< 50°C) число ошибок в скрытых секторах растет гораздо медленнее, чем предполагают распространенные модели оценки надежности. Половина наших пар модель/дата-центр не выказывает тенденции к росту количества ошибок, в то время как для другой половины их рост идет по линейному закону, а не по экспоненциальному.

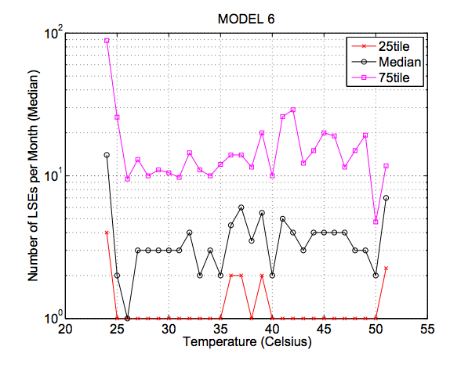

Пока что наш анализ сводился к оценке вероятностей возникновения LSE, но как повлияет на них температура, если у диска уже имеются ошибки в скрытых секторах? Чтобы ответить на этот вопрос, мы построили график (рисунок 3) для месяцев, в которых ошибки находились в пределах 25-ого и 75-ого процентилей и медианы. Мы видим, что для всех квартилей график получился ломаным – это говорит нам о том, что горячие диски не страдают от большего количества LSE (по сравнению с более холодными дисками).

Рисунок 3 – Квартили количества LSE для дисков с LSE как функция от температуры

Более высокие температуры не увеличивают количество LSE, если диск уже подвержен LSE, а это говорит нам о том, что причины возникновения ошибок в скрытых секторах одинаковы как для холодных дисков, так и горячих.

Рисунок 1 позволяет сделать еще один интересный вывод: частота возникновения LSE для одной модели диска может изменяться от дата-центра к дата-центру. Например, интенсивность ошибок для модели №3 значительно выше (больше чем в 2 раза) в дата-центре №2, чем в других дата-центрах, а количество ошибок для модели №6 выше в дата-центре №0 (опять же, более чем в 2 раза). Это подводит нас к вопросу, а влияют ли такие факторы, как условия использования или возраст дисков, на их реакцию на повышение температуры?

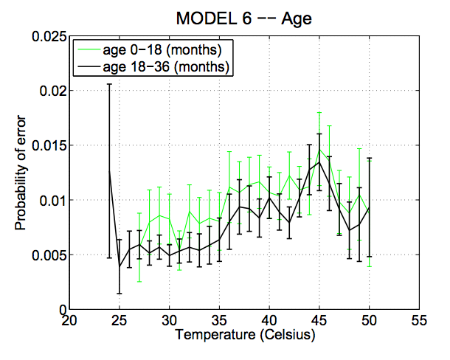

Рисунок 4 – Помесячная вероятность возникновения LSE в зависимости от температуры для двух возрастных диапазонов устройств

В известном нам диапазоне, а именно от 0 до 36 месяцев, старые диски имеют такую же вероятность столкнуться с LSE, как и новые.

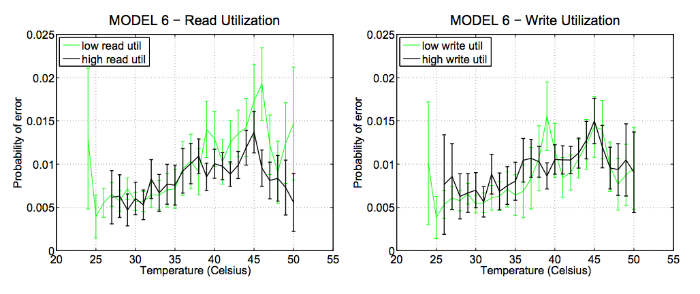

Рисунок 5 – Помесячная вероятность возникновения LSE в зависимости от температуры для дисков с низкой и высокой нагрузками по записи (справа) и чтению (слева)

Рисунок 5 призван продемонстрировать влияние нагрузки на вероятность возникновения сбоев. На графиках представлены две группы с высокой и низкой нагрузками по чтению и записи. Мы измеряли степень нагрузки по чтению количеством выполняемых операций в месяц и относили диск в группу с низкой степенью нагрузки, если оно [количество операций] оказывалось меньше медианы для представленного набора данных (в противном случае – в группу с высокой нагрузкой).

Мы можем с уверенностью сказать, что степень использования диска не влияет на вероятность возникновения LSE при повышении температуры.

Температура и отказы дисков

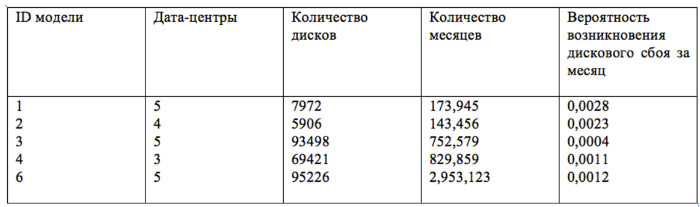

Цель этого раздела – рассмотреть вопрос о том, как температура влияет на частоту отказа дисков. Чтобы получить наиболее полный ответ на этот вопрос, мы учтем возможное влияние рабочей нагрузки, а также различия между моделями дисков и дата-центрами. У нас есть данные по 5 различным моделям запоминающих устройств, собранные в период с января 2007 года по май 2009 года и предоставленные 19 различными дата-центрами Google. Вся собранная нами информация сведена в таблицу ниже:

Рисунок 6 – Вероятность возникновения дискового сбоя за месяц в зависимости от температуры с учетом модели диска

На рисунке 6 приведены графики вероятности возникновения дискового сбоя в месяц для каждой из пяти моделей записывающих устройств (без привязки к определенным дата-центрам). За исключением модели №3, для всех устройств наблюдается рост количества ошибок с увеличением температуры, однако зависимость получилась линейная (тенденция нарушается на очень высоких температурах больше 50°C). Мы вновь оценили результаты наблюдений, используя линейную и экспоненциальную модели. Результаты сведены в таблицу 2.

Таблица 2 – Параметры линейной и экспоненциальной моделей, описывающих зависимость вероятности сбоя дисков от средней температуры

Для температур ниже 50°C частота отказа дисков растет гораздо медленнее, чем предполагают классические модели. Увеличение числа отказов с ростом температуры незначительно. Следуя той же методологии, как в случае с LSE, мы дополнительно разбили группы дисков по степени загруженности и возрасту – как оказалось, ни тот, ни другой фактор в значительной степени не влияют на частоту дисковых сбоев.

Температура и её влияние на надежность DRAM

В этом разделе мы посмотрим, как температура влияет на надежность DRAM.

DRAM имеет два режима обработки ошибок: корректируемые ошибки, когда неправильно записанный бит можно найти и исправить с помощью кодов обнаружения и коррекции ошибок, и некорректируемые ошибки – повреждение множества битов – которые могут стать причиной экстренных отключений.

Мы собрали данные из трех различных источников:

- Google ведет статистику появления корректируемых и некорректируемых ошибок во всех своих дата-центрах и собирает данные о температуре с датчиков на материнских платах.

- Los Alamos National Lab (LANL) предоставила нам информацию по выходу из строя узлов (а также причинам и длительности отключения) более чем 20 своих высокопроизводительных компьютерных кластеров.

- SciNet-GPC – это один из самых крупных суперкомпьютеров в Канаде. Нам удалось получить данные по количеству замененных элементов системы, информацию о которых администратор вводил вручную на протяжении 19 месяцев.

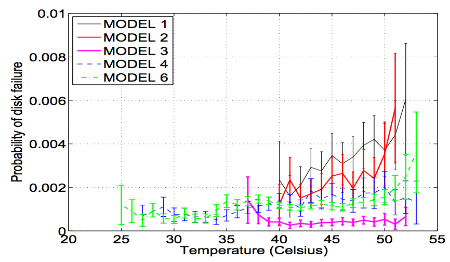

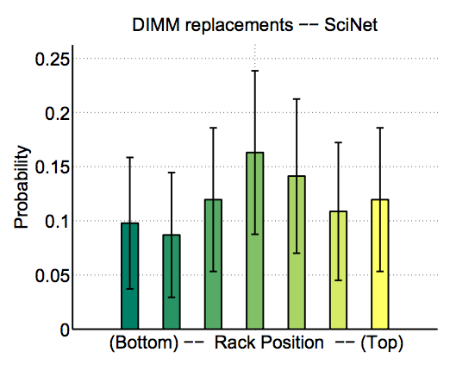

Рисунок 7 – Вероятность выхода из строя узла в LANL из-за проблем с DRAM в зависимости от температуры (слева) и позиции на стойке (средний, справа)

Рисунок 8 – Вероятность замены DIMM в SciNet в зависимости от расположения на стойке

Для построения графика на рисунке 7 (слева) были использованы данные о температуре системы LANL-system-20. На рисунке 7 (посредине и справа) изображена зависимость количества сбоев в узлах систем LANL-Type-1 и LANL-Type-2 от положения на серверной стойке. Ни один из графиков не позволяет с уверенностью сказать, что температура влияет на количество отказов. Точно такие же выводы были сделаны и в случае с частотой замены DIMM в SciNet (Рисунок 8).

Влияние температуры на производительность

Чтобы изучить влияние температуры окружающей среды на производительность серверов, мы соорудили испытательный стенд с термальной камерой. Термальная камера была достаточно большой, чтобы уместить внутри целый сервер, и позволяла нам контролировать температуру в диапазоне от -10°C до 60°C с точностью 0,1°C.

Для проведения эксперимента был выбран один из самых популярных серверов – Dell PowerEdge R710. Он имеет четырехъядерный процессор Intel Xeon 5520 с частотой 2,26 ГГц, 8 МБ кэша третьего уровня, 16 ГБ DDR3 ECC и работает под управлением Ubuntu 10.04 Server с ядром Linux 2.6.32-28-server. Мы также подключили к нему жесткие диски (SAS и SATA) от разных поставщиков.

В ходе работы была проведена серия нагрузочных тестов с использованием микробенчмарков и макробенчмарков, разработанных для моделирования рабочей нагрузки, которую создают реальные приложения. Использованные бенчмарки и методики: STREAM, GUPS, Dhrystone, Whetstone, случайная запись/случайное чтение, последовательная запись/ последовательное чтение, OLTP-Mem, OLTP-Disk, DSS-Mem, DSS-Disk, PostMark, BLAST.

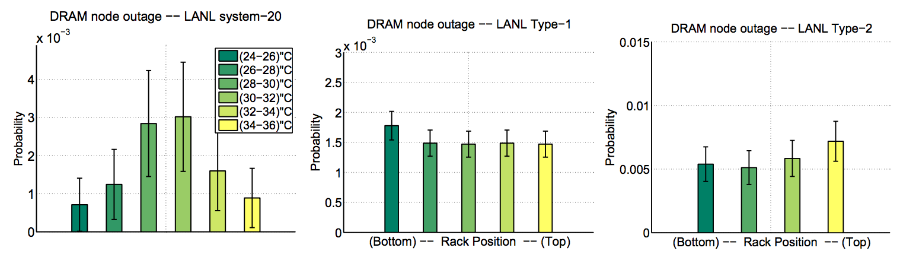

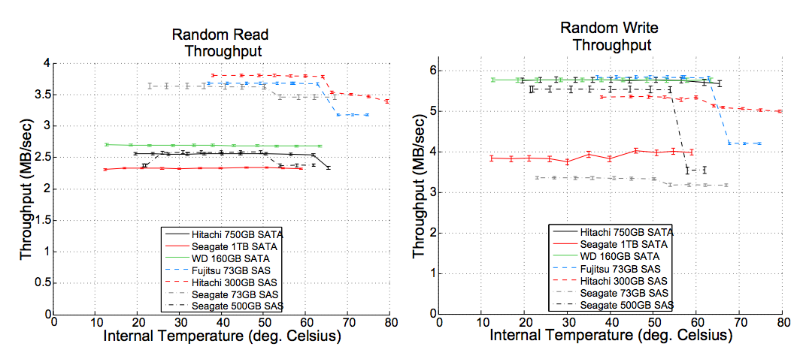

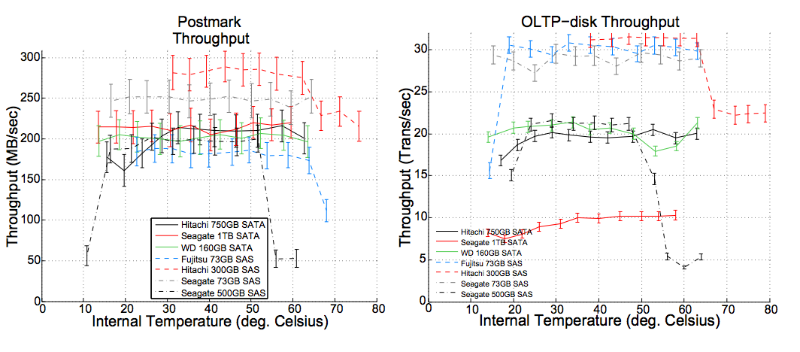

Рисунок 9 – Производительность диска при проведении случайной записи и чтения соответственно как функция от внутренней температуры диска. Результаты для последовательной записи/чтения получились похожими

Рисунок 10 – Производительность под интенсивной нагрузкой (Postmark, OLTP-disk) в зависимости от внутренней температуры диска

Мы видим, что у всех SAS-дисков и одного SATA-диска (Hitachi Deskstar) наблюдается некоторый спад в производительности на высоких температурах: от 5-10% до 30%. Принимая во внимание тот факт, что для всех моделей спад происходит в одном и том же температурном диапазоне (а не в произвольный момент), и ни один из дисков не сообщил о возникновении ошибок, мы считаем, что причиной деградации производительности является включение защитных механизмов записывающих устройств. В случае с микробенчмарками мы наблюдаем такую же тенденцию (рисунок 10).

Увеличение энергопотребления сервера

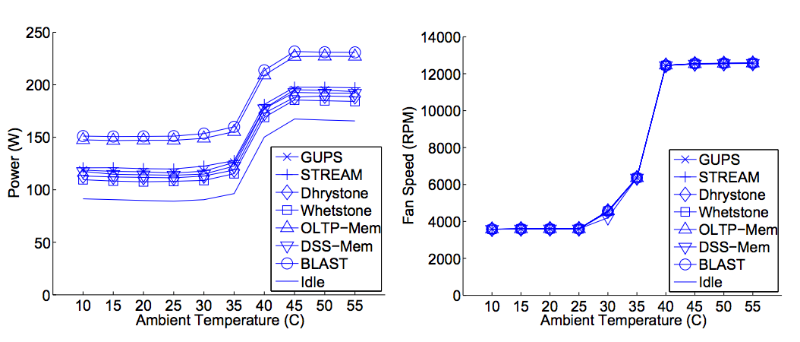

Увеличение температуры воздуха, поступающего к электронному оборудованию, может оказывать влияние на количество рассеиваемой энергии. Многие IT-фирмы начинают увеличивать скорость вращения кулеров, когда температура окружающего воздуха достигает определённого порогового значения.

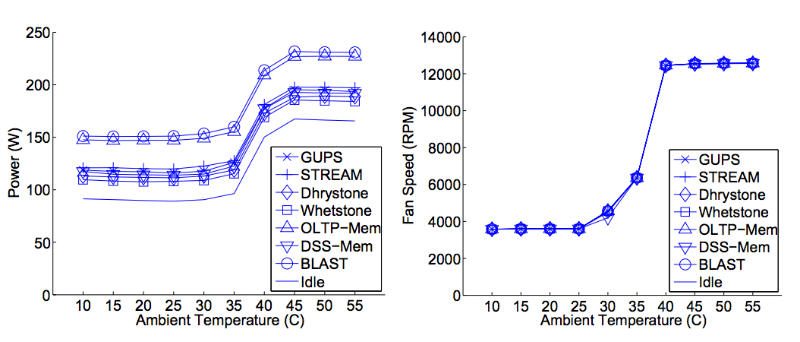

Рисунок 11 – Влияние температуры окружающей среды на энергопотребление (слева) и скорость вращения вентиляторов (справа)

На рисунке 11 мы видим, что хотя количество потребляемой энергии под различными нагрузками сильно меняется, оно начинает возрастать, когда температура окружающей среды достигает 30°C, и увеличивается вплоть до 40°C. Рост потребляемой энергии составляет 50% – это очень много.

Интересно было бы узнать, с чем именно связан этот перепад в энергопотреблении: с увеличением скорости вращения кулеров (которую контролирует сервер) или с увеличением мощности утечки (что определяют законы физики)? К сожалению, утечку энергии нельзя измерить напрямую.

Однако можно с уверенностью сказать, что перепады в энергопотреблении связаны с вентиляторами: на графике 11 (справа) показана зависимость скорости вращения кулеров от температуры окружающей среды для всех нагрузочных тестов. Мы видим, что увеличение скорости вращения происходит на тех же значениях температуры, на которых повышается энергопотребление.

Таким образом, с ростом температуры окружающей среды повышается количество потребляемой энергии, что по большей части связано с увеличением скорости вращения кулеров. Утечки энергии чрезвычайно малы.

Выводы

Увеличение температуры в дата-центрах потенциально может сэкономить огромное количество средств на электроэнергию и снизить углеродные выбросы. К сожалению, не до конца понятно, с какими трудностями это связано, поэтому многие дата-центры стараются поддерживать в помещении низкую температуру. Нам удалось выяснить, что температура оказывает гораздо меньшее влияние на надежность работы аппаратуры, чем предполагается: ошибки связанные с DRAM и выходом из строя серверных узлов слабо связаны с высокими температурами.

Эти воодушевляющие результаты позволяют обратить внимание на другие моменты, связанные с температурой, например, на увеличение энергопотребления отдельно взятых серверов при росте температуры поступающего к ним воздуха. В ходе исследования было установлено, что это связано с увеличением скорости вращения вентиляторов системы охлаждения. Утечки мощности в этом случае совершенно незначительны. Большинство этой энергии тратится напрасно из-за плохо составленных алгоритмов контроля скорости вращения кулеров.

Однако здесь не все так просто, чтобы можно было дать какие-то общие рекомендации или предсказания о том, какой должна быть температура в дата-центре, и о том, сколько энергии можно сэкономить. Ответы на эти вопросы зависят от слишком большого количества факторов, имеющих отношение к местоположению дата-центра и его предназначению. Однако мы видим, что большинство организаций могут немножко «разогреть» свое оборудование, при этом не жертвуя производительностью и надежностью системы.

Автор: 1cloud.ru