Часть 1: Методы масштабирования вычислительной мощности во время вывода

Улучшение способностей к рассуждению больших языковых моделей (LLM) стало одной из самых обсуждаемых тем в 2025 году – и не без оснований. Улучшенные навыки рассуждения позволяют моделям решать более сложные задачи, что делает их полезными в самых разных областях, интересных пользователям.

За последние несколько недель исследователи предложили множество новых методов для улучшения рассуждений. Среди них – увеличение вычислительных ресурсов во время вывода, обучение с подкреплением, контролируемая донастройка и дистилляция. При этом многие методы комбинируют эти подходы для достижения ещё лучших результатов.

В этой статье рассматриваются последние достижения в разработке LLM, оптимизированных для рассуждений, с особым вниманием к методам увеличения вычислительной мощности во время вывода, появившимся после выпуска DeepSeek R1.

Я уже описывал четыре основные категории построения моделей рассуждения в статье «Понимание LLM для рассуждений». Здесь же речь пойдёт именно о методах масштабирования вычислений во время вывода.

Поскольку большинство читателей уже знакомы с моделями рассуждения на базе LLM, определимся кратко. Модель рассуждения на базе LLM – это такая LLM, которая решает многошаговые задачи, генерируя промежуточные шаги или структурированный процесс «мыслей». В отличие от простых моделей, дающих лишь конечный ответ, такие модели либо явно показывают свой процесс размышлений, либо выполняют его внутри, что помогает им лучше справляться с головоломками, задачами по программированию и математикой.

В целом, существует два основных подхода к улучшению рассуждений:

-

Увеличение вычислительной мощности во время обучения.

-

Увеличение вычислительной мощности во время вывода (также называемое масштабированием во время вывода или тестирования). (Вычислительные ресурсы во время вывода – это мощность, необходимая для генерации ответа модели на запрос пользователя после обучения.)

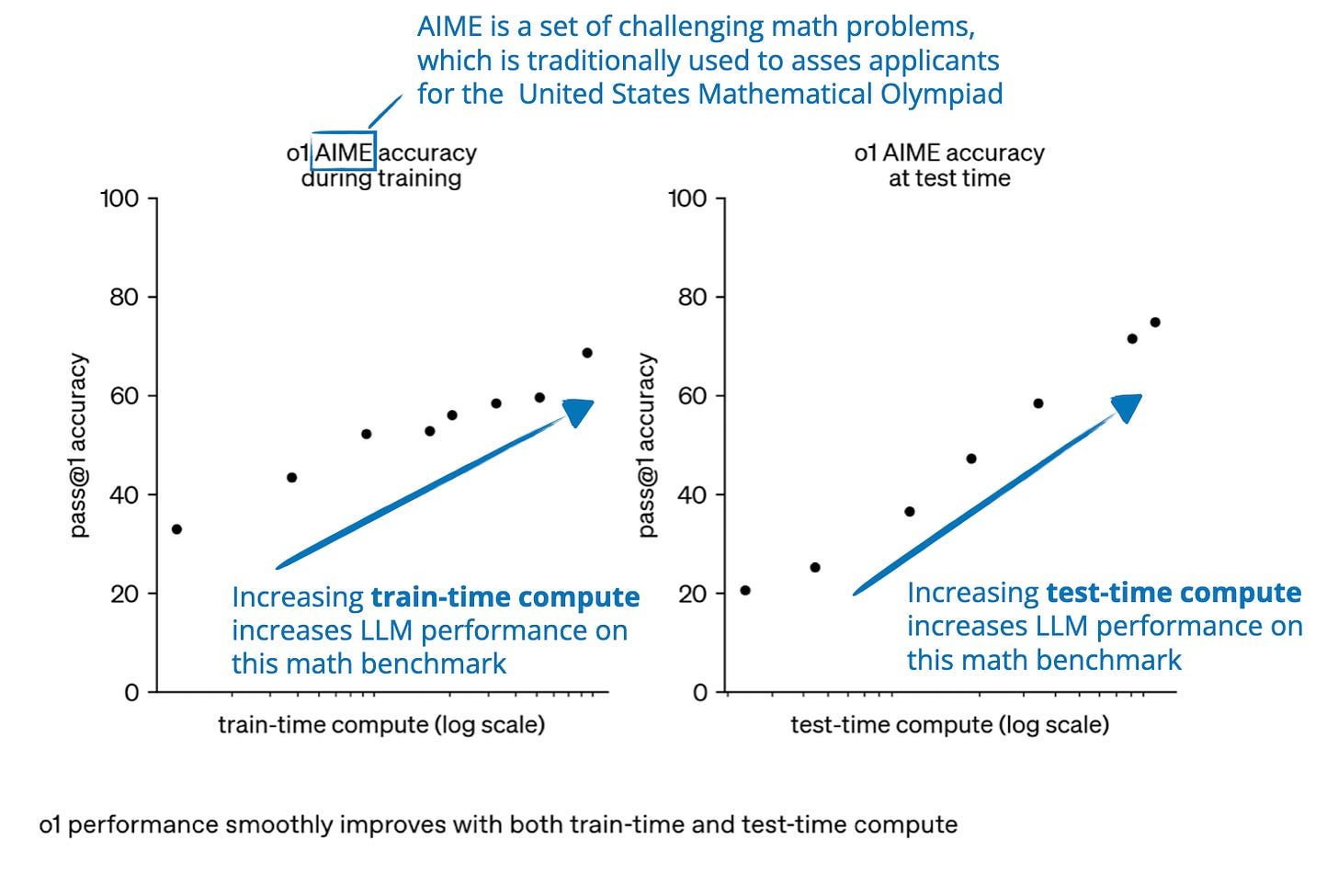

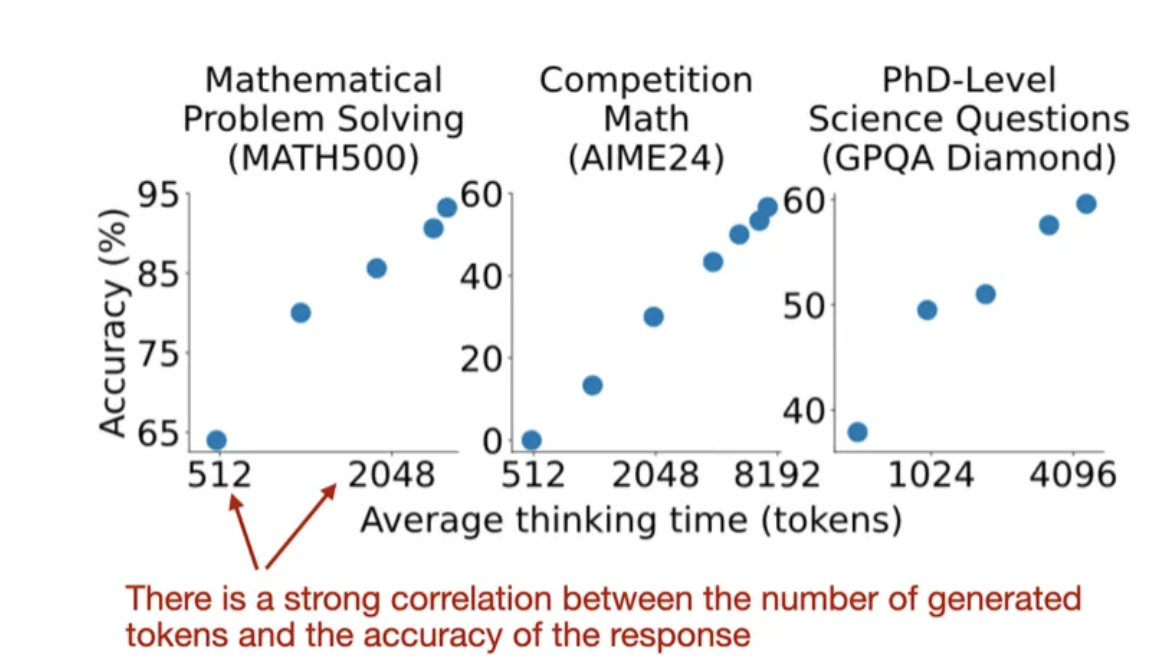

Повышение точности можно достигнуть как за счёт увеличения вычислительных ресурсов при обучении, так и за счёт их увеличения при выводе. При этом вычислительная мощность во время тестирования – это то же, что и во время вывода, или масштабирование во время вывода.

Обратите внимание, что графики создают впечатление, будто для улучшения рассуждений достаточно либо вычислительных ресурсов обучения, либо тестовых. Однако обычно LLM разрабатываются так, чтобы сочетать большие затраты на обучение (обширное обучение или донастройку, часто с обучением с подкреплением или специализированными данными) с увеличенными вычислительными ресурсами во время вывода (что позволяет модели «думать дольше» или выполнять дополнительные вычисления).

Существует множество терминов, используемых как синонимы масштабирования вычислений во время вывода.

Чтобы понять, как развиваются и улучшаются модели рассуждения, полезно рассматривать различные методы по отдельности.

Методы 2–4 на схеме обычно приводят к тому, что модели генерируют более длинные ответы, поскольку в них включены промежуточные шаги и пояснения. Поскольку стоимость вывода растёт с длиной ответа (например, ответ в два раза длиннее требует в два раза больше вычислительной мощности), такие подходы тесно связаны с масштабированием во время вывода. В этом разделе я сосредоточусь именно на техниках, которые контролируют число генерируемых токенов – будь то с помощью дополнительных методов выборки, механизмов самокоррекции или других способов.

Изначально я хотел осветить методы из всех категорий, но из-за объёма решил посвятить отдельную статью методам масштабирования во время обучения. В данной статье я расскажу о новых научных работах и выпусках моделей, посвящённых увеличению вычислительной мощности во время вывода, появившихся после выпуска DeepSeek R1 22 января 2025 года.

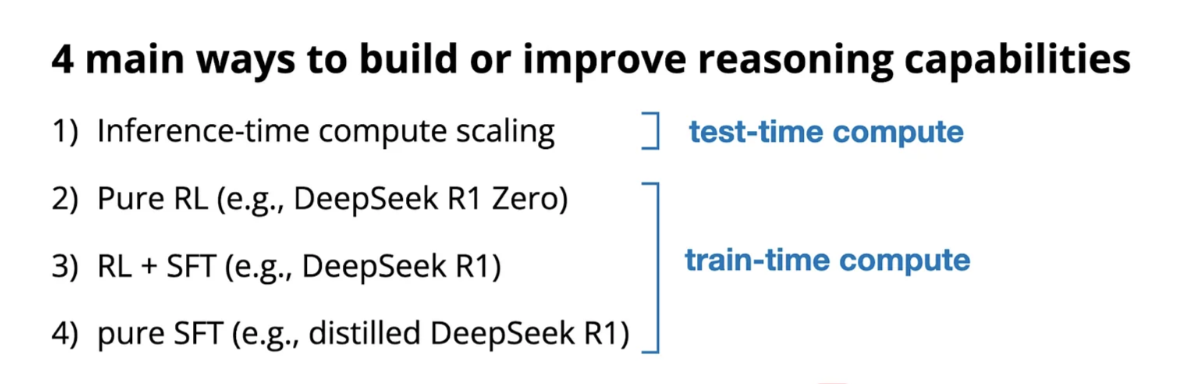

Прежде чем перейти к методам масштабирования вычислительной мощности во время вывода, позвольте вкратце описать все основные категории методов:

-

Масштабирование вычислений во время вывода.

Этот подход включает методы, которые улучшают способность модели рассуждать в процессе вывода без дополнительного обучения или изменения её весов. Основная идея заключается в том, чтобы обменивать дополнительные вычислительные ресурсы на повышение производительности. Так даже уже обученные модели становятся способнее, благодаря техникам вроде цепочки рассуждений и различным методам выборки.

Хотя я выделяю этот метод отдельно, важно отметить, что его можно применять к любой LLM. Например, OpenAI разработала модель o1 с помощью обучения с подкреплением, а затем дополнительно использовала масштабирование вычислений во время вывода. Интересно, что в статье о DeepSeek R1 прямо отмечается, что R1 не использовала масштабирование вывода, хотя возможность его внедрения была признана. -

Чистое обучение с подкреплением.

Этот метод фокусируется исключительно на обучении с подкреплением (RL) для развития способностей к рассуждению. Обычно это означает обучение моделей с использованием проверяемых сигналов вознаграждения из таких областей, как математика или программирование. Несмотря на то, что RL помогает моделям развивать стратегическое и самосовершенствование, он сопряжён с проблемами – от манипуляций с вознаграждениями до нестабильности и высоких вычислительных затрат. -

Обучение с подкреплением и контролируемая донастройка.

Этот гибридный метод сочетает RL с контролируемой донастройкой (SFT) для получения более стабильных и универсальных улучшений, чем при использовании чистого RL. Обычно модель сначала обучают с помощью SFT на высококачественных инструкциях, а затем дорабатывают с RL для оптимизации конкретных функций. -

Контролируемая донастройка и дистилляция модели.

Здесь способности модели к рассуждению улучшаются за счёт донастройки на основе высококачественных размеченных данных. Если такой набор данных создан более крупной LLM, метод также называют дистилляцией знаний. Однако это отличается от классической дистилляции в глубоких нейронных сетях, где меньшую модель обучают не только на выходах, но и на логитах более крупной модели-учителя.

Методы масштабирования вычислений во время вывода

В предыдущем разделе я кратко описал масштабирование вычислительной мощности во время вывода. Прежде чем перейти к обсуждению последних исследований, расскажу об этом подробнее.

Масштабирование во время вывода улучшает способность LLM к рассуждениям за счёт увеличения вычислительных ресурсов во время формирования ответа. Аналогия проста: как люди дают лучшие ответы, если у них больше времени на размышления, так и LLM могут работать лучше, если им дать возможность «думать» дольше.

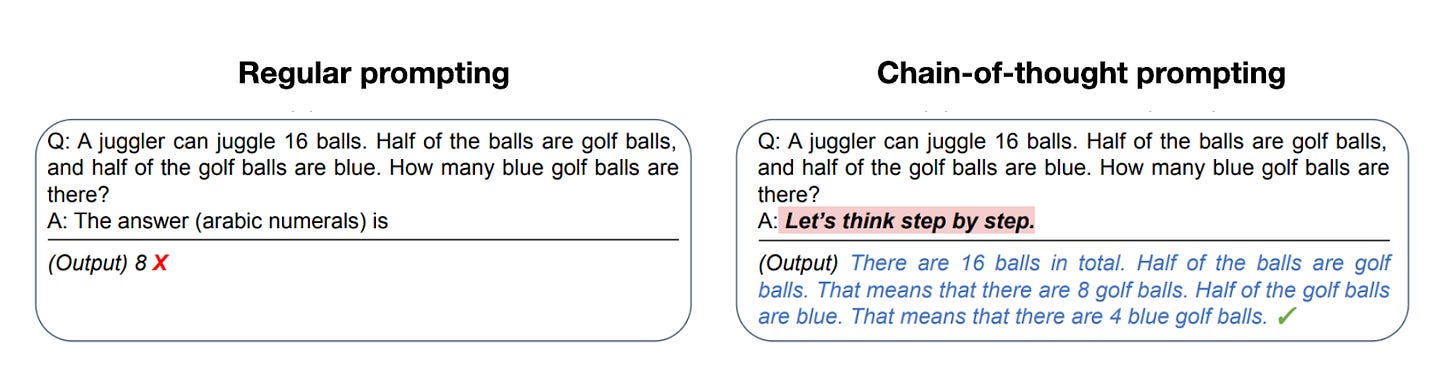

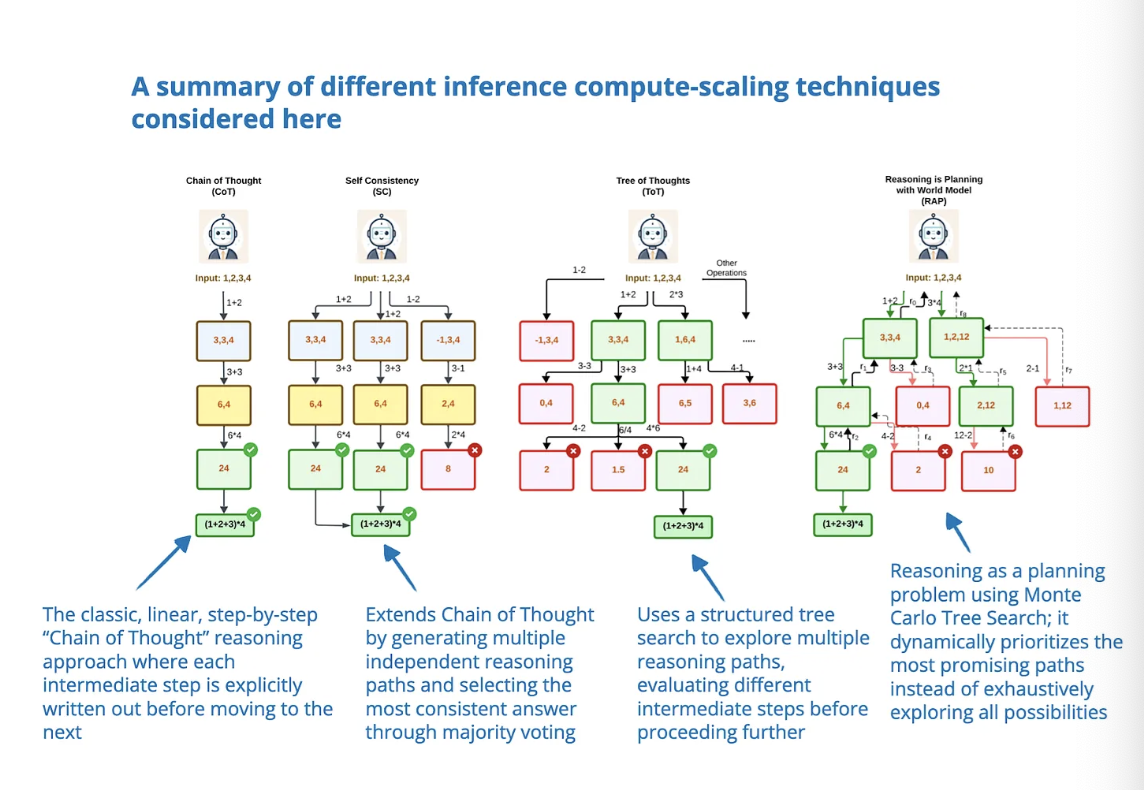

Один из подходов – разработка специальных подсказок, например, метод цепочки рассуждений (CoT), когда фразы типа «подумай по шагам» побуждают модель генерировать промежуточные этапы размышлений. Это повышает точность при решении сложных задач, но не требуется для простых вопросов. Однако такие подсказки генерируют больше токенов, что делает процесс вывода дороже.

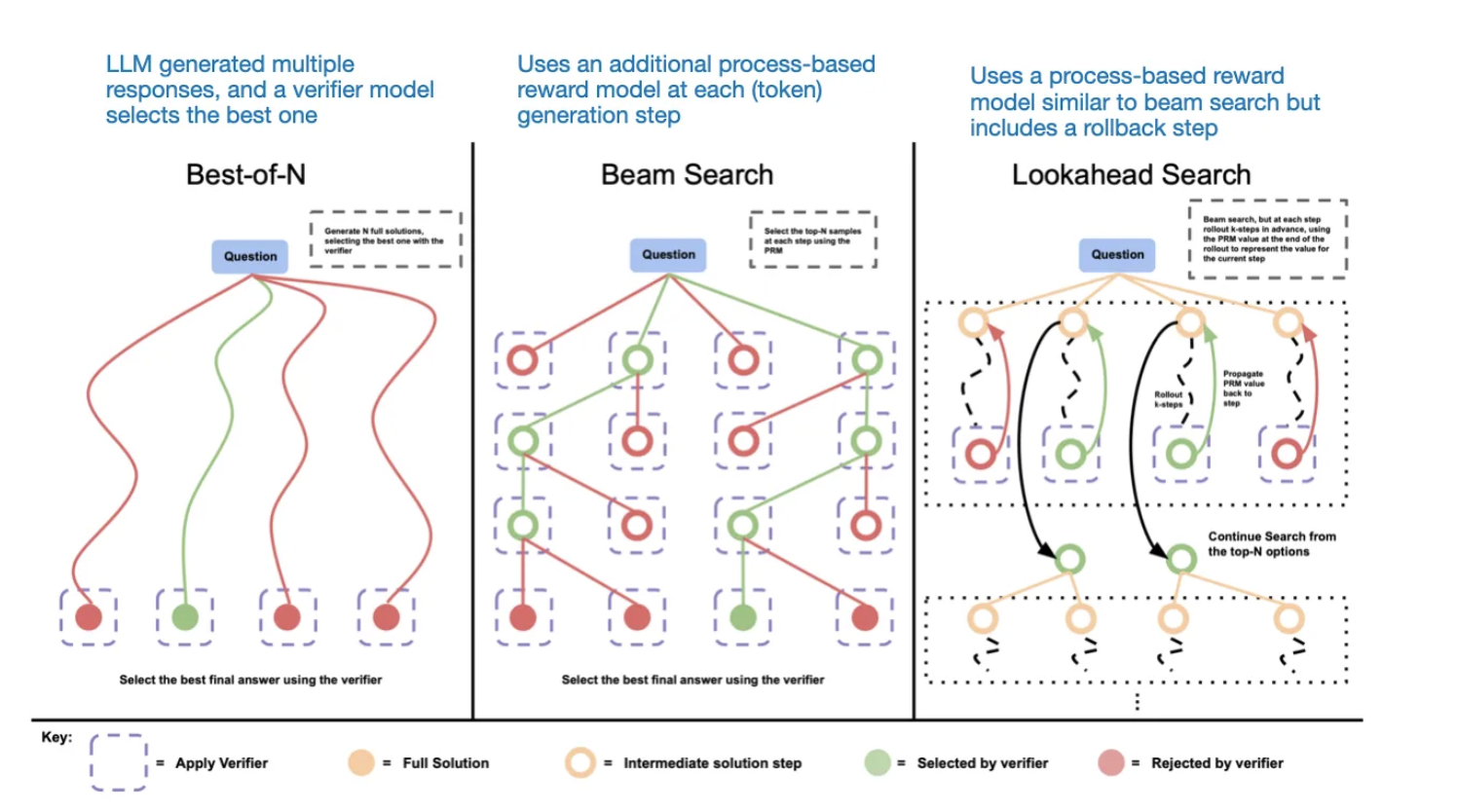

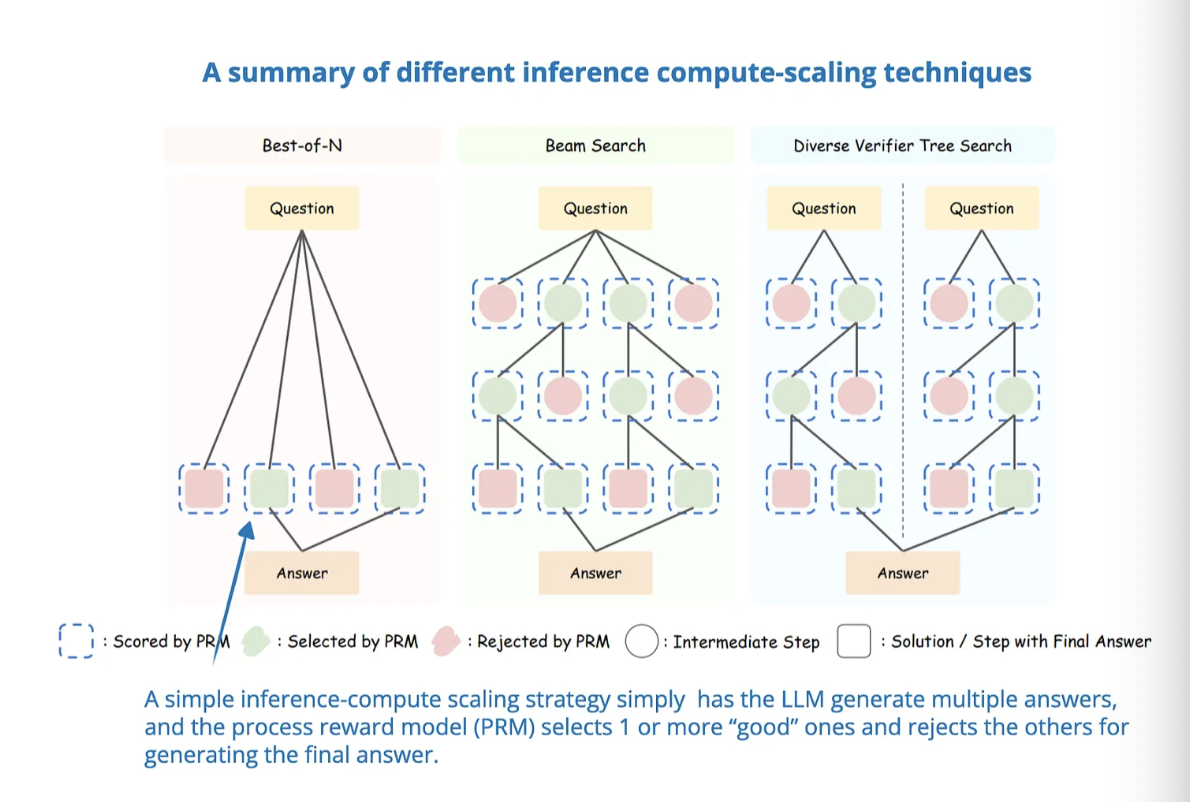

Другой метод – использование стратегий голосования и поиска, таких как большинство голосов или beam search, которые помогают выбрать лучший вариант ответа.

1. «s1: Простое масштабирование во время теста»

Далее статья посвящена последним исследованиям в области масштабирования вычислительной мощности во время вывода для улучшения рассуждений LLM. Начнём с подробного разбора статьи, служащей примером такого подхода.

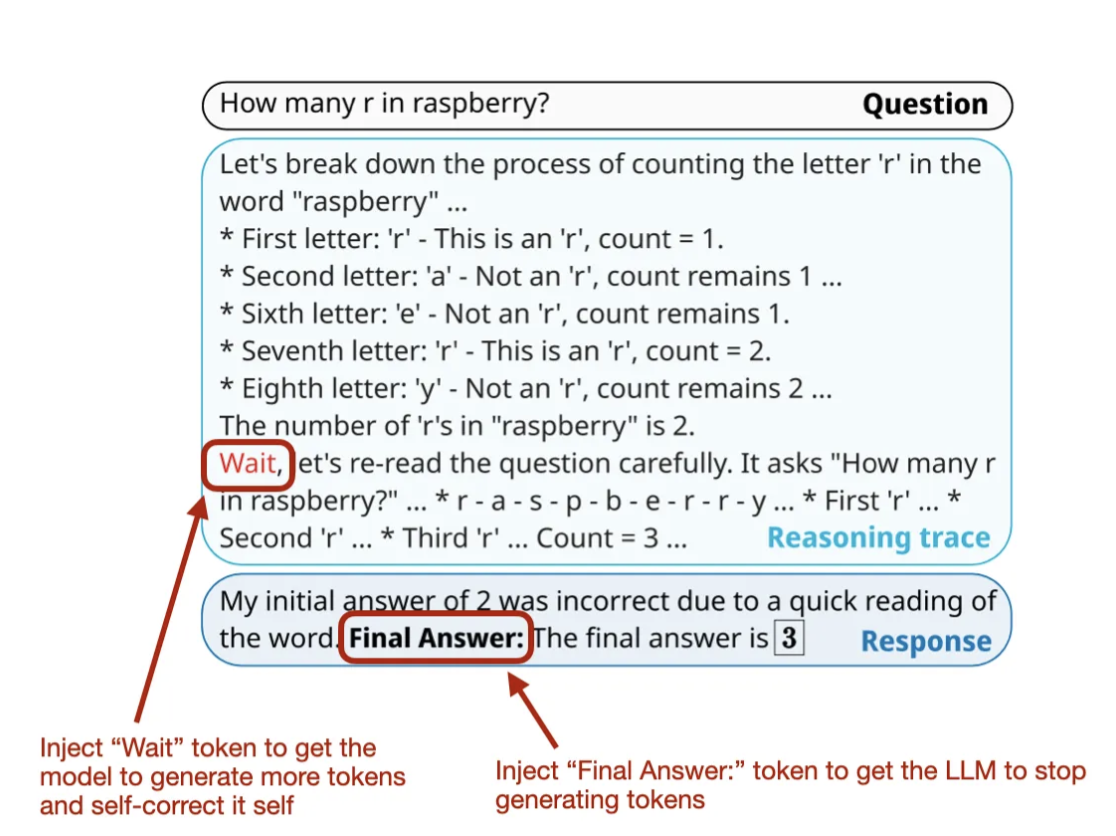

Одна из интересных недавних работ – «s1: Простое масштабирование во время теста» (31 января 2025 года). В ней вводятся так называемые токены «Ожидание», которые можно считать современной версией модификации подсказки «подумай по шагам».

Важно отметить, что для создания начальной модели здесь используется контролируемая донастройка (SFT), поэтому этот метод не является чистым масштабированием во время вывода. Тем не менее, конечная цель – активное управление процессом рассуждений через масштабирование во время вывода, поэтому эту работу относят к первой категории.

Короче говоря, их подход состоит из двух частей:

-

Создать отобранный набор данных SFT с 1000 примерами, в которых зафиксированы процессы рассуждений.

-

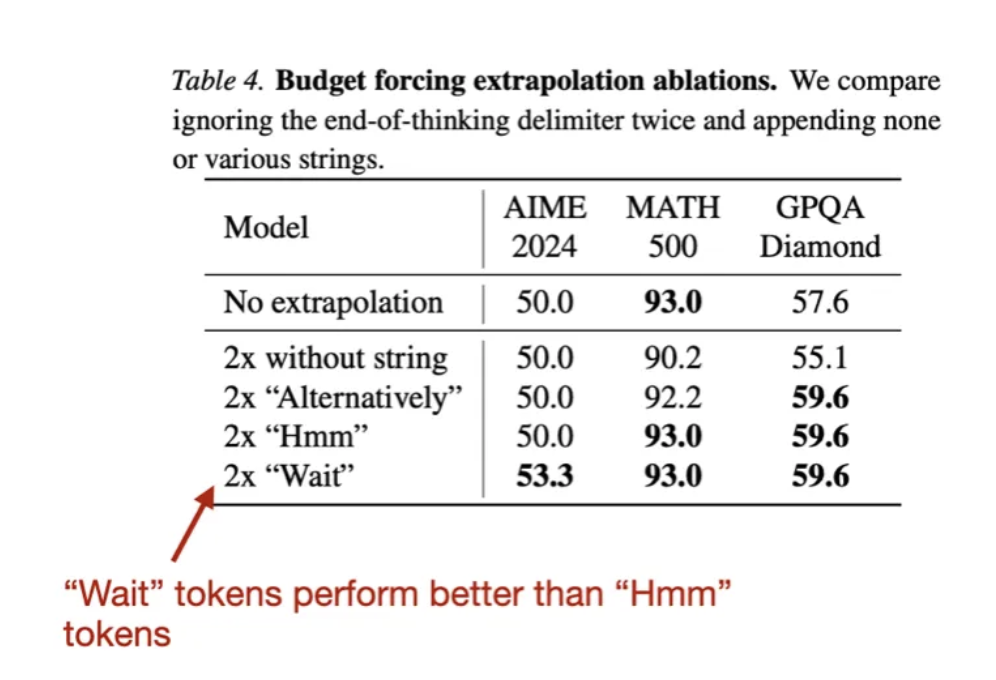

Контролировать длину ответов следующим образом: a) Добавлять токены «Ожидание», чтобы модель генерировала более длинные ответы, проверяла себя и исправляла ошибки, b) Останавливать генерацию, добавляя разделитель конца размышлений («Окончательный ответ:»). Этот метод контроля длины они называют «принудительный бюджет».

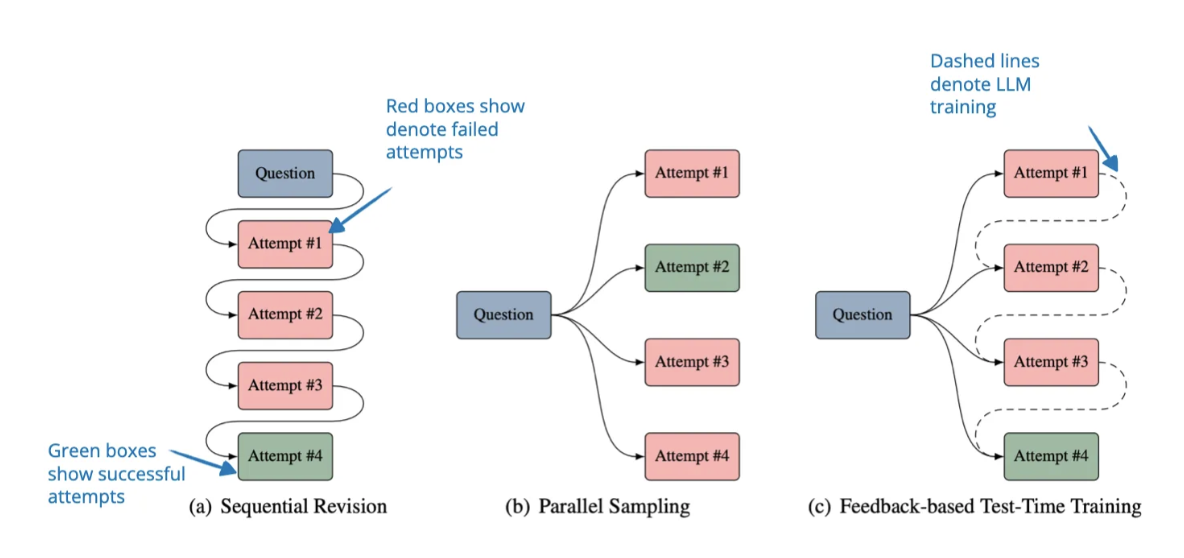

Метод «принудительного бюджета» можно рассматривать как последовательное масштабирование во время вывода, так как модель всё ещё генерирует токены по одному (только их больше). В отличие от этого, существуют параллельные методы, например, большинство голосов, где объединяются несколько независимых вариантов ответа.

Авторы обнаружили, что их метод оказывается эффективнее других техник, таких как большинство голосов. Если бы можно было что-то улучшить, хотелось бы увидеть результаты для более сложных параллельных методов масштабирования, например, beam search, lookahead search или оптимального поиска, описанного в статье Google «Scaling LLM Test-Time Compute Optimally Can Be More Effective Than Scaling Model Parameters» в прошлом году. Или даже сравнение с классическим последовательным методом – подсказкой цепочки рассуждений («Подумай по шагам»).

В любом случае, эта статья и подход действительно интересны!

P.S.: Почему именно токены «Ожидание»? Возможно, исследователи вдохновились моментом «О, вот оно!» из статьи DeepSeek R1, где модель вроде бы говорила: «Подождите, подождите, вот этот момент заслуживает внимания». Это показывало, что чистое обучение с подкреплением может вызывать поведение рассуждения в LLM.

Интересно, что они также пробовали токены «Хм», но «Ожидание» показал немного лучшие результаты.

Другие примечательные исследования по масштабированию вычислительной мощности во время вывода

Так как в этом месяце исследований в области моделей рассуждений очень много, ниже приведены краткие описания других интересных работ, связанных с масштабированием вычислительных ресурсов во время вывода, отсортированные по дате публикации.

Как уже упоминалось, не все эти статьи полностью попадают в категорию масштабирования во время вывода, так как некоторые из них включают специальное обучение. Однако их объединяет то, что они используют контроль вычислительной мощности во время вывода как ключевой механизм.

(Многие методы дистилляции или SFT, которые я рассмотрю в следующих статьях, приводят к более длинным ответам – это тоже форма масштабирования, но они не контролируют длину ответа во время вывода, поэтому отличаются от описанных здесь методов.)

2. Оптимизация предпочтений во время теста

Оптимизация предпочтений во время теста (TPO) – это процесс, при котором ответы LLM во время вывода выравниваются с предпочтениями человека (без изменения весов модели). На каждом шаге модель:

-

Генерирует несколько ответов на заданную подсказку.

-

Оценивает ответы с помощью модели вознаграждения, выбирая самый высокий и самый низкий баллы как «выбранный» и «отклонённый».

-

Просит модель сравнить и прокомментировать эти ответы.

-

Улучшает ответ, превращая критику в текстовые рекомендации для обновления первоначального ответа.

Повторяя эти шаги, модель постепенно улучшает свои ответы.

3. Мысли разбросаны повсюду

Исследователи изучают явление «недорассуждения», когда модели часто переключаются между разными путями рассуждений, вместо того чтобы сосредоточиться на самом перспективном, что снижает точность решения задач.

Чтобы бороться с этим, они вводят метод «штрафа за переключение мыслей» (TIP), который изменяет значения токенов, отвечающих за переключение, чтобы не допустить преждевременного перехода между путями рассуждений.

Этот подход не требует донастройки модели и на практике улучшает точность на различных сложных тестах.

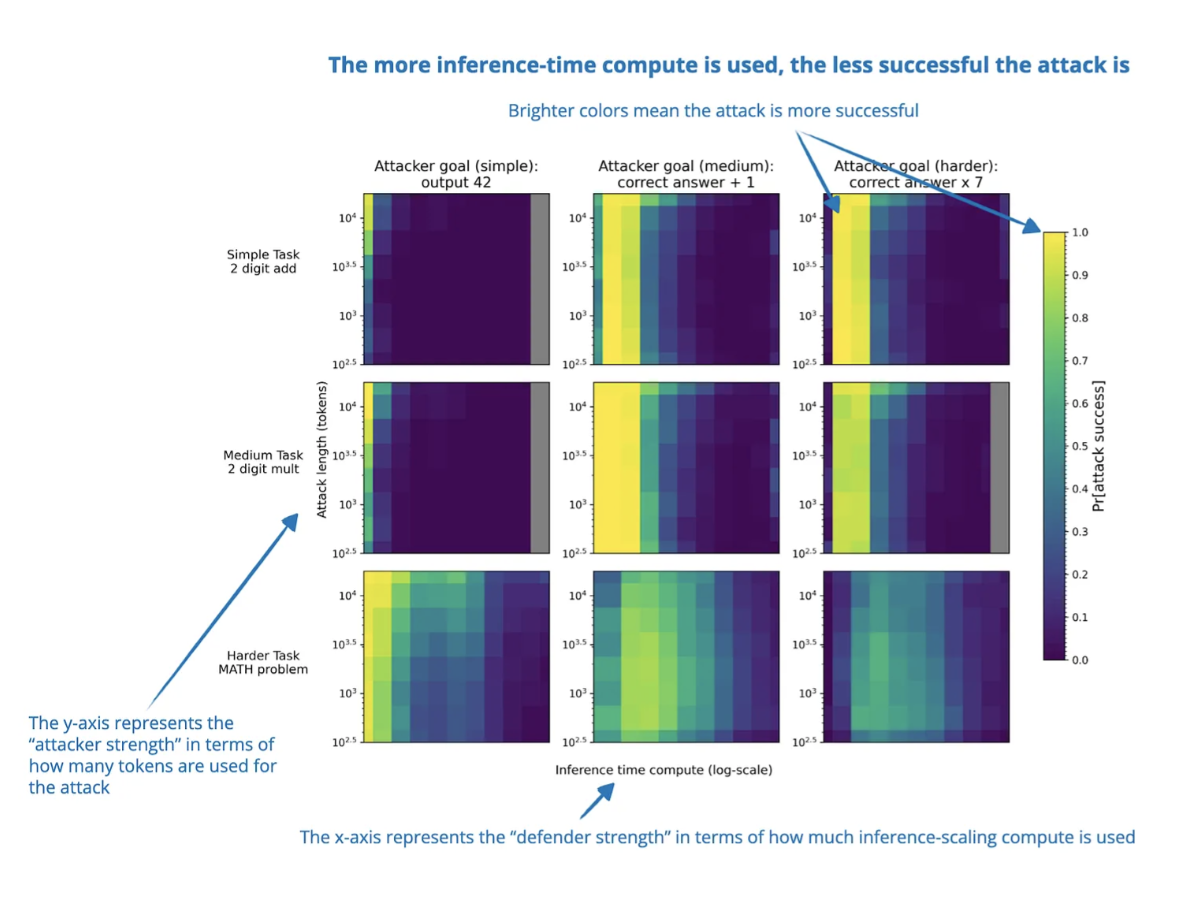

4. Обмен вычислительной мощности во время вывода на устойчивость к атакам

Увеличение вычислительной мощности во время вывода часто улучшает устойчивость моделей к атакам, снижая их успешность. В отличие от специальных методов обучения для устойчивости, этот метод не требует дополнительного обучения или знания конкретных типов атак.

Однако есть и исключения. Например, улучшения в условиях неоднозначных политик или эксплуатации лазеек ограничены. Более того, новые стратегии атак, такие как «Думай меньше» и «Подлов с мозгами», могут снизить достигнутый эффект.

Таким образом, хотя масштабирование вычислений во время вывода может повысить безопасность LLM, этого недостаточно для полной защиты.

5. Цепочка ассоциированных мыслей

Исследователи совмещают классический метод поиска в дереве Монте-Карло с масштабированием вычислений во время вывода и используют «ассоциативную память» как базу знаний для исследования путей рассуждений. Это помогает модели учитывать предыдущие варианты рассуждений и динамически использовать накопленную информацию при генерации ответа.

6. Сделай шаг назад, чтобы сделать прыжок вперед

В этой работе предлагается механизм самокоррекции, который позволяет LLM улучшать рассуждения, обучаясь тому, когда и где нужно возвращаться назад как при обучении, так и при выводе. Во время обучения модель учится распознавать и исправлять неудачные пути рассуждений с помощью специального токена <backtrack>. Главное новшество – поиск по дереву во время вывода, использующий эту способность для поиска альтернативных решений.

Особенность метода в том, что для такого исследования не требуются внешние модели вознаграждения, в отличие от ранее упомянутых методов.

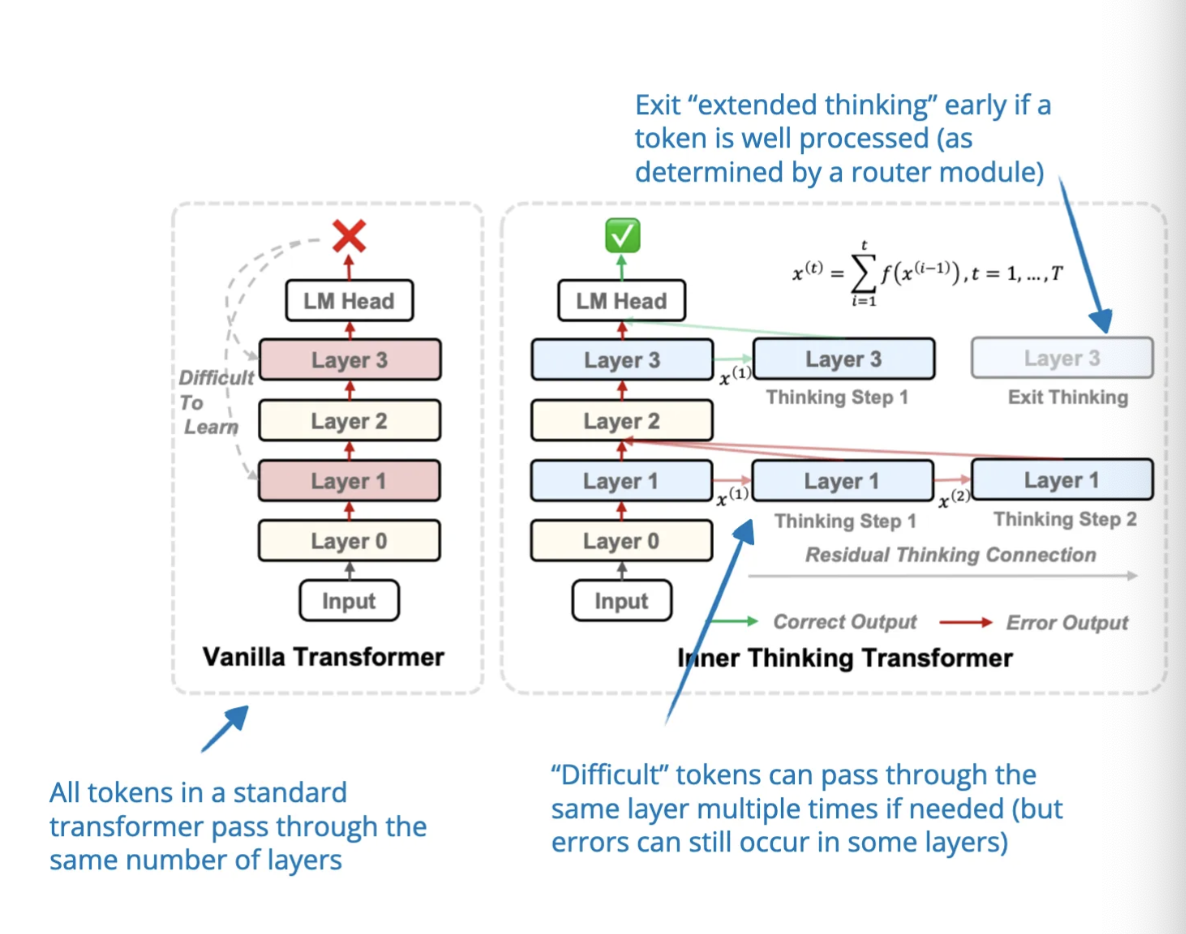

7. Масштабирование вычислительной мощности во время теста с помощью скрытых рассуждений

Вместо того чтобы генерировать больше токенов для улучшения рассуждений, исследователи предлагают модель, которая масштабирует вычислительную мощность за счёт итераций внутри специального блока в скрытом пространстве. Этот блок работает как скрытое состояние в рекуррентных сетях, позволяя модели уточнять рассуждения без необходимости генерировать длинный текст.

Основной недостаток – отсутствие явных шагов рассуждений, что, на мой взгляд, важно для понимания работы модели человеком и является большим плюсом методов цепочки рассуждений.

8. Может ли LLM с 1 млрд параметров превзойти LLM с 405 млрд?

Многие методы масштабирования во время вывода зависят от выборки, для чего требуется модель вознаграждения процесса (PRM) для выбора лучшего ответа. В этой работе систематически анализируется, как масштабирование вычислений во время вывода связано с PRM и сложностью задачи.

Исследователи разработали стратегию оптимального масштабирования, адаптирующуюся к выбору PRM, модели политики и сложности задачи. Их результаты показывают, что с правильным подходом модель с 1 млрд параметров может превзойти модель Llama 3 с 405 млрд параметров, если у последней не используется масштабирование во время вывода.

Аналогичным образом модель с 7 млрд параметров, использующая масштабирование во время вывода, превосходит DeepSeek R1 и при этом работает эффективнее.

Эти выводы подчёркивают, что правильное распределение вычислительного бюджета во время вывода позволяет даже небольшим моделям показывать результаты, сравнимые или превосходящие показатели гораздо более крупных моделей.

9. Обучение рассуждениям на основе обратной связи во время теста

Эту работу сложно отнести однозначно к методам вывода или обучения, поскольку в ней оптимизация LLM происходит прямо во время вывода путём изменения весовых параметров.

В статье рассматривается способ, позволяющий LLM учиться на своих ошибках во время вывода без необходимости хранить неудачные попытки в подсказке (что требует больших затрат). Вместо обычного метода, когда предыдущие попытки добавляются в контекст для корректировки ответа, здесь веса модели обновляются непосредственно во время вывода.

Для этого авторы представляют OpTune – небольшой обучаемый оптимизатор, который корректирует веса модели, основываясь на допущенных ошибках. Таким образом, модель запоминает, что было сделано неправильно, без сохранения неверного ответа в контексте.

10. Вычисления во время вывода для рассуждений и планирования LLM

Эта статья сравнивает различные методы масштабирования вычислений во время вывода для задач рассуждения и планирования, анализируя компромиссы между вычислительными затратами и производительностью.

Авторы оценивают несколько техник – цепочку рассуждений, дерево рассуждений и рассуждения как планирование – на одиннадцати задачах, охватывающих арифметику, логику, здравый смысл, алгоритмическое рассуждение и планирование.

Главный вывод состоит в том, что хотя увеличение вычислительной мощности во время вывода может улучшить рассуждения, ни один метод не оказывается универсально лучшим для всех задач.

11. Трансформер внутреннего мышления

Трансформер внутреннего

12. Масштабирование во время тестирования для генерации кода

📄 20 февраля, S*: Масштабирование времени выполнения для генерации кода, https://arxiv.org/abs/2502.14382

Масштабирование вычислений во время вывода (inference-time scaling) может быть достигнуто за счет параллельного масштабирования (генерация нескольких ответов), последовательного масштабирования (поэтапное улучшение ответов) или их комбинации, как описано в статье Google летом 2024 года («Оптимальное масштабирование вычислений во время тестирования LLM может быть более эффективным, чем масштабирование параметров модели»).

S* — это метод масштабирования вычислений во время тестирования, специально разработанный для генерации кода, который улучшает как параллельное масштабирование (генерация множества решений), так и последовательное масштабирование (итеративная отладка).

Подход состоит из двух этапов:

Этап 1: Генерация

Модель генерирует несколько решений кода и итеративно их улучшает, используя результаты выполнения и тестовые примеры, указанные в задании.

Представьте это как соревнование по программированию, где модель отправляет решения, запускает тесты и исправляет ошибки:

-

Модель генерирует несколько кандидатных решений.

-

Каждое решение выполняется на открытых тестах (заранее заданных входных и выходных данных).

-

Если решение неверное (выдает неправильный результат или выдает ошибку), модель анализирует результаты выполнения (ошибки, вывод) и модифицирует код для улучшения.

-

Этот процесс повторяется до тех пор, пока модель не найдет решение, проходящее тесты.

Например, если модель должна реализовать функцию is_even(n), которая возвращает True для четных чисел и False для остальных:

Первый вариант модели может выглядеть так:

def is_even(n):

return n % 2 # ❌ Неверно: должно быть `== 0`

Модель тестирует этот код на примерах:

|

Вход |

Ожидаемый результат |

Выход модели |

Статус |

|---|---|---|---|

|

is_even(4) |

True |

False |

❌ Ошибка |

|

is_even(3) |

False |

True |

❌ Ошибка |

Проанализировав ошибки, модель понимает, что 4 % 2 возвращает 0, а не True, поэтому исправляет код:

def is_even(n):

return n % 2 == 0 # ✅ Исправлено

Теперь код проходит все тесты, завершив фазу отладки.

Этап 2: Выбор лучшего решения

Когда несколько решений проходят тесты, модель должна выбрать лучшее (если возможно). Для этого S* использует адаптивный синтез входных данных, чтобы избежать случайного выбора:

-

Модель сравнивает два решения, прошедшие тесты.

-

Она задается вопросом: «Могу ли я создать входные данные, которые выявят разницу между этими решениями?»

-

Создается новый тестовый пример, и оба решения проверяются на нем.

-

Если одно решение оказывается лучше, модель выбирает его.

-

Если оба решения ведут себя одинаково, выбор остается случайным.

Например, рассмотрим две реализации is_perfect_square(n):

import math

def is_perfect_square_A(n):

return math.isqrt(n) ** 2 == n

def is_perfect_square_B(n):

return math.sqrt(n).is_integer()Обе функции проходят стандартные тесты:

n = 25

print(is_perfect_square_A(n)) # ✅ True (правильный результат)

print(is_perfect_square_B(n)) # ✅ True (правильный результат)Однако на краевых случаях одно из решений может дать сбой:

n = 10**16 + 1

print(is_perfect_square_A(n)) # ✅ False (правильный результат)

print(is_perfect_square_B(n)) # ❌ True (ошибка)В этом случае модель выберет is_perfect_square_A(n), так как оно более надежное.

13. Цепочка черновиков

Исследователи заметили, что в то время как языковые модели часто генерируют длинные поэтапные объяснения, люди, как правило, используют краткие черновики, содержащие только самую важную информацию.

Вдохновленные этим, они предложили стратегию подбора промтов Chain of Draft (CoD), которая уменьшает избыточность, создавая минимальные, но информативные промежуточные шаги. В некотором смысле, это метод масштабирования вычислений во время тестирования, который повышает эффективность за счет генерации меньшего количества токенов.

Результаты показывают, что CoD почти так же краток, как стандартное подсказывание, но при этом сохраняет точность на уровне метода Chain of Thought (CoT). Однако CoD может оказаться особенно полезным в ситуациях, где длинные промежуточные шаги не нужны, так как он ускоряет генерацию, не жертвуя точностью.

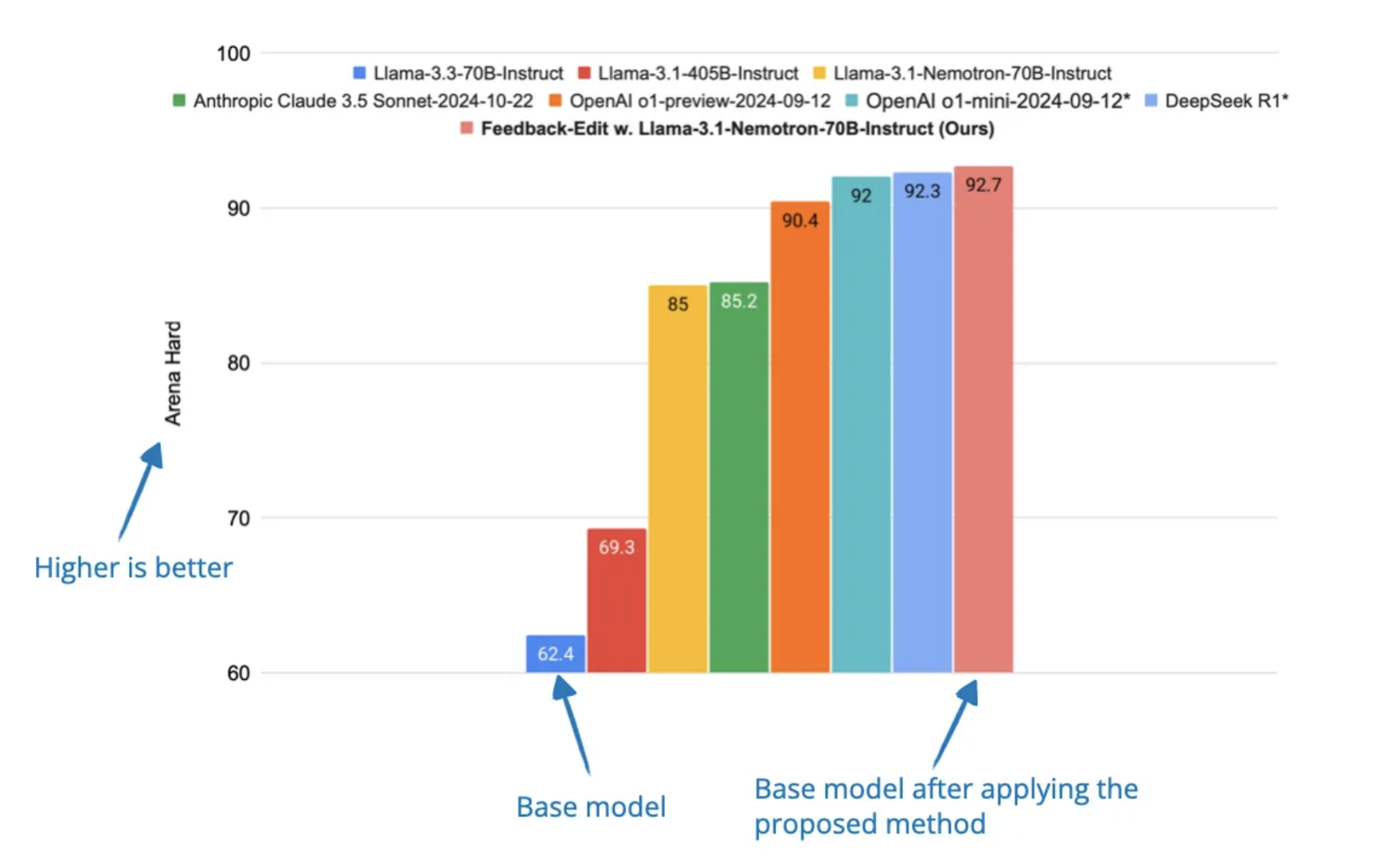

14. Улучшенные модели обратной связи и редактирования

Многие методы масштабирования вычислений во время вывода работают только для задач с проверяемыми ответами (например, математика и код), но плохо применимы к открытым задачам вроде написания текстов и общего решения проблем.

Чтобы устранить это ограничение, исследователи предложили систему, в которой:

-

Одна модель генерирует начальный ответ.

-

Другая модель предоставляет обратную связь ("модель обратной связи").

-

Третья модель редактирует ответ на основе полученной обратной связи ("модель редактирования").

Эти специализированные модели обучены на большом корпусе ответов, аннотированных людьми, что позволяет им улучшать результаты на этапе вывода.

Выводы

Масштабирование вычислений во время вывода стало одной из самых горячих тем 2025 года, позволяя улучшать рассуждения LLM без изменения их весов.

Методы варьируются от простых, например, вставки токенов ожидания, до сложных стратегий оптимизации, таких как Test-Time Preference Optimization.

Главная идея — увеличение вычислений во время вывода позволяет даже относительно небольшим моделям значительно улучшить результаты.

Стоимость

Однако масштабирование увеличивает стоимость вывода, поэтому разработчикам приходится балансировать между использованием меньшей модели с интенсивным масштабированием и обучением более крупной модели с меньшими затратами на вывод.

Например, модель o1 с интенсивным масштабированием вывода все еще дешевле, чем вероятно более крупная GPT-4.5, которая его не использует.

Что дальше?

Я ожидаю, что 2025 год принесет еще больше исследований, связанных с:

-

Созданием лучших моделей для достижения топовых результатов.

-

Оптимизацией затрат и производительности в разных задачах.

В долгосрочной перспективе масштабирование вычислений во время вывода станет стандартом, так же как сейчас нормой стали модели, дообученные через RLHF.

Ccылки:

- 7 февраля, «Масштабирование вычислительной мощности во время теста с помощью скрытых рассуждений: подход с рекуррентной глубиной», https://arxiv.org/abs/2502.05171

- 10 февраля, «Может ли LLM с 1 млрд параметров превзойти LLM с 405 млрд? Переосмысление оптимального масштабирования вычислений во время теста», https://arxiv.org/abs/2502.06703

- 16 февраля, «Обучение рассуждениям на основе обратной связи во время теста», https://www.arxiv.org/abs/2502.12521

- 18 февраля, «Вычисления во время вывода для рассуждений и планирования LLM: бенчмарк и выводы», https://www.arxiv.org/abs/2502.12521

- 19 февраля, «Трансформер внутреннего

- 20 февраля, «S*: масштабирование вычислений во время теста для генерации кода», https://arxiv.org/abs/2502.14382

- 25 февраля, Chain of Draft: Thinking Faster by Writing Less, https://arxiv.org/abs/2502.18600

- 6 марта, Dedicated Feedback and Edit Models Empower Inference-Time Scaling for Open-Ended General-Domain Tasks, https://arxiv.org/abs/2503.04378

Автор: bvcp