Привет! Представляю вашему вниманию перевод статьи "Here's how an AI lie detector can tell when you're fibbing" автора Rob Verger.

Сегодня искусственный интеллект встречается повсюду – он определяет, что находится на фотографиях еды (на таких сайтах, как Yelp), помогает исследователям в попытках ускорения процесса МРТ и даже может искать признаки депрессии в голосе человека. Но вот об использовании искусственного интеллекта как детектора лжи вряд ли многие задумывались.

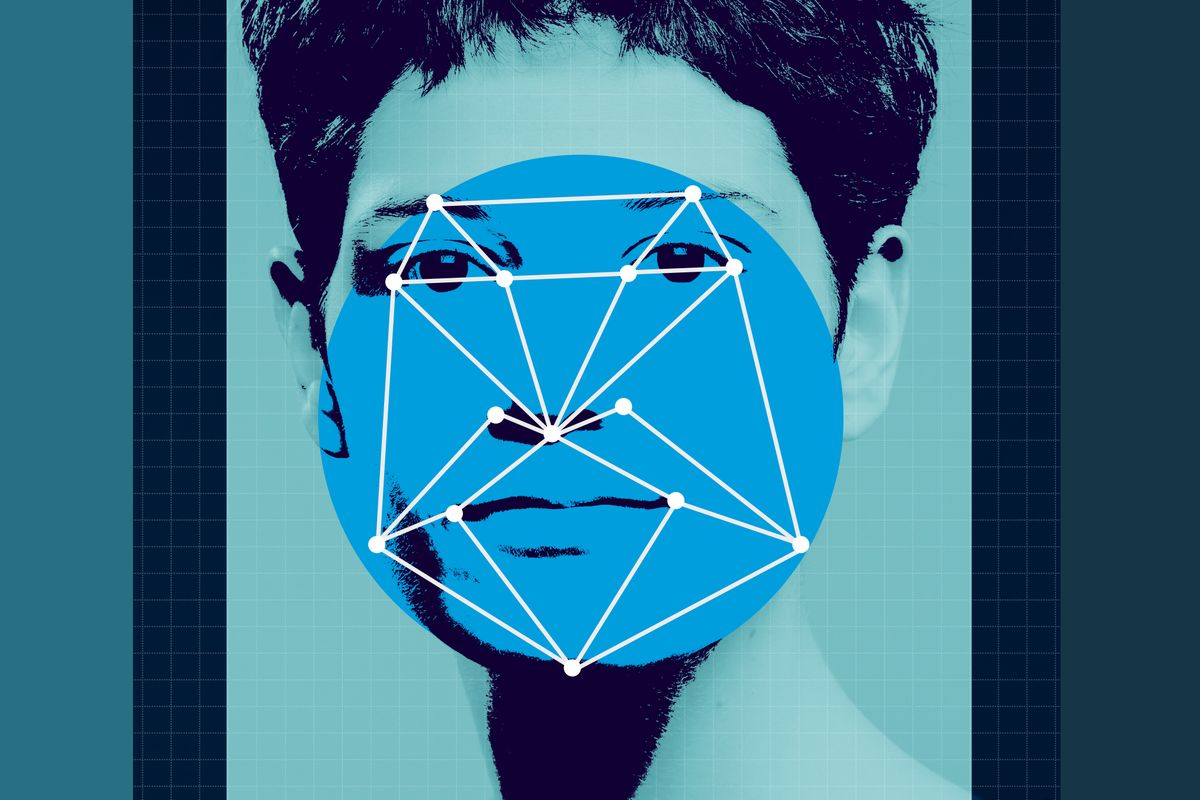

Эта идея – AI детектор лжи – сейчас в новостях, потому что новый европейский проект охраны границы “iBorderCtrl” включает в себя технологию, которая фокусируется на “обнаружении обмана”. Данная инициатива включает в себя двух этапный процесс, а этап, включающий “обнаружение обмана”, работает прямо из дома. В соответствии с Европейской комиссией, протокол начинается c предварительного отбора, во время которого путешественники “используют веб-камеру, чтобы отвечать на вопросы, задаваемые анимированным пограничником, который подбирается в соответствии с полом, этнической принадлежностью и языком путешественника. Уникальный подход к “обнаружению обмана” анализирует мельчайшие изменения выражения лица путешественников, чтобы определить, врет ли интервьюируемый”.

Все это звучит, как научная фантастика, и конечно напоминает о проблемной истории полиграфа. Но такой искусственный интеллект вполне реален. Вопрос лишь в том, насколько точным он может быть.

Рада Михальча, профессор информатики и инженерии в Университете Мичигана, работала над обнаружением обмана около десяти лет. Таким образом был сооружен один AI детектор лжи и его принцип работы.

Первое, что необходимо исследователям, работающим с искусственным интеллектом и машинным обучением, это данные. В данном случае команда Рады Михальча начала с видео реальных судебных дел. Например, подсудимый в судебном разбирательстве, в котором он был признан виновным, может предоставить пример обмана; показания свидетелей также были использованы как примеры правдивых или ложных показаний. (Конечно, алгоритмы машинного обучения напрямую зависят от данных, которые они используют, поэтому важно помнить, что человек, признанный виновным в преступлении, может на самом деле быть невиновным.)

В итоге был использован 121 видеоклип и соответствующие расшифровки того, что было сказано (соотношение лживых и правдивых высказываний приблизительно один к одному). Эти данные позволили команде построить классификаторы для машинного обучения, которые в конечном счете имели точность 60-75%.

Какую закономерность заметила система? “Использование местоимений. Люди, которые пытаются соврать, склоны к тому, чтобы редко использовать местоимения ‘я’ или ’мы’ и вообще упоминать вещи, связанные с ними. Вместо этого, они чаще используют местоимения ‘ты’, ’твое’, ’он(а)’, ’они’.” – объясняет Рада Михальча.

Это не единственный лингвистический признак. Врущие люди склоны к использованию “более сильных слов”, которые “выражают уверенность”, говорит Рада Михальча. Примерами таких слов служат такие слова, как “абсолютно” и “очень”, когда люди, говорящие правду, наоборот, уклоняются от ответа, используя такие слова, как “возможно” или “вероятно”.

“Я считаю, что обманчивые люди будут скорее компенсировать свою ложь тем, что попытаются казаться более уверенными в себе”.

Что касается мимики, Рада Михальча выделяет, что люди, которые лгут, более склонны смотреть прямо в глаза человека, опрашивающего их. Эти люди также чаще используют две руки для жестикуляции вместо одной, потому что, по предположению Рады Михальча, они таким образом пытаются казаться более убедительными. (Конечно, это лишь шаблоны: если кто-то смотрит вам в глаза и жестикулирует обеими руками, пока говорит, это еще не значит, что этот человек лжет.)

Это и есть список замечательных данных, которые AI способен замечать, как только исследователи дают ему примеры, с которыми он может работать и с помощью которых он может учиться. Но даже сама Рада Михальча признает, что ее работа “не идеальна”. “Как исследователи, мы были очень взволнованы тем, что мы смогли достичь точности в 75%”. Но с другой стороны, это означает, что вероятность ошибки – один к четырем. “Я не думаю, что данный AI может быть использован на практике, потому что вероятность ошибки до составляет 25%.”

В конечном счете, Рада Михальча видит эту технологию очень полезной для людей. К примеру, эта технология могла бы показывать, что она заметила что-то “необычное” в чьем-то высказывании, а позже этого человека, возможно, опросили бы повторно. Такое использование AI нередко: технология, которая расширяет то, что могут делать люди.

Автор: nottsk