Чему учат нас компьютеры по поводу того, как ладить друг с другом

В нашем офисе в университете Карнеги-Мэллон мы с моим коллегой Джоном Миллером создали компьютерную программу, склонную к геноциду.

Мы к этому точно не стремились. Мы не изучали соперничество или войны. Нас интересовало зарождение примитивных форм сотрудничества. Так что мы создавали машины, живущие в воображаемом обществе, и заставляли их играть друг с другом в игру – она известна тем, что порождает сложное социальное поведение не хуже, чем гнилой банан порождает плодовых мушек.

Игра называется "Дилемма заключённого". У неё есть много разновидностей, но по сути – это история о двух людях, выбирающих, сотрудничать им или обманывать друг друга. Если оба обманывают, страдают оба. Если оба сотрудничают, обоим будет лучше. Но если один сотрудничает, а второй обманывает – обманщику будет ещё лучше.

Обобщённость игры делает её привлекательной для политического философа, а строгая конкретика позволяет положить её в основу компьютерной симуляции. В качестве инструмента исследования человеческого поведения она эквивалентна наклонной плоскости Галилея или экспериментам Менделя с горохом. Присоединитесь к забастовке или смоетесь через линию пикета? Остановите производство, чтобы цены не падали, или будете демпинговать и наводните рынок? Приложите усилия при работе в группе или расслабитесь, и предоставите работу остальным?

Наша симуляция была простой: в виртуальном мире машины, принимающие решения, обладавшие ограниченной способностью рассуждать, раз за разом играли в эту игру. Мы, как безжалостные судьи, награждали процветающие машины и наказывали остальных. Успешные машины передавали стратегию действий в следующие поколения, что нарушалось появляющимися случайным образом вариациями, имитирующими естественные мутации.

Мы снабдили машины простым языком, на котором можно думать, и ресурсами для обеспечения памяти и действий на её основе. Каждое поколение машины попарно сталкивались друг с другом. Именно так нам представляется жизнь: мы постоянно встречаемся с торговыми партнёрами, и с последствиями того, как мы с ними обходимся. В нашей модели мира два Робинзона Крузо встретились на пляже.

Запустив развитие этих небольших сообществ, мы ожидали подтверждения того, что многие считают оптимальной стратегией для игры в дилемму заключённого: зуб за зуб. Машина, использующая эту стратегию, начинает с того, что сдерживает свои обещания, но мстит за обман однократным обманом со своей стороны. Зуб за зуб – это правило чести в нашей песочнице: относись к другим хорошо, если только они не дают тебе поводов относиться к ним по-другому, и достаточно быстро прощай их.

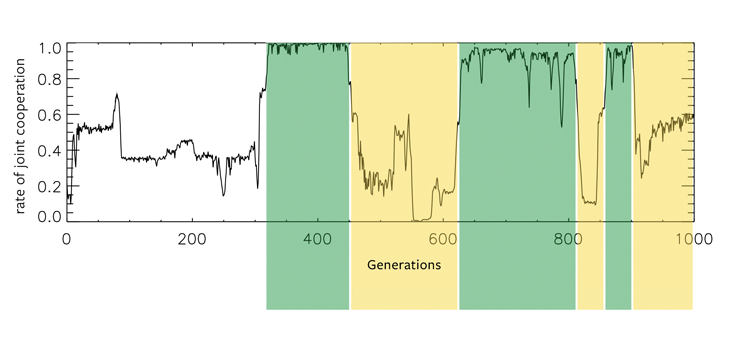

Но изучив выходные данные симуляций, в которых стратегии свободно эволюционировали в произвольных направлениях, мы обнаружили нечто совсем другое. После раннего хаотического периода одна из машин быстро начинала доминировать, властвуя над вымышленным миром сотни поколений, а потом в какой-то момент всё внезапно рушилось, и мир погружался в хаос конфликтов, из которого вырастал следующий цикл. Археологи такого мира откопали бы толстые слои процветания, сменяющиеся эрами костей и пепла.

Вместо следующих правилам песочниц, которыми правят осторожные и гордые кооператоры, популяции порождали странные конфигурации, в которых мы не видели смысла. До одного вечера в офисе, когда мы вдруг наткнулись на истину. Доминировавшие машины принимали действия игроков за кодекс, по которому они могли распознать момент, в который они сталкивались с копиями самих себя.

Симуляции показывают начальные уровни, вероятно, случайного поведения, которое примерно на 300-м поколении уступало высокому уровню кооперации, совпадающему с полным доминированием одной машины, доводящей остальных до вымирания. Эта принудительная кооперация исчезает примерно на 450-м поколении. После этого система переключается между двумя экстремумами. Зелёные и жёлтые полосы соответствуют эрам высокой и низкой кооперации соответственно.

На начальных этапах игры они вырабатывали чёткую схему работы: сотрудничай, обманывай, обманывай, сотрудничай, обманывай, сотрудничай (это пример). Если их оппонент отвечал точно таким же образом, обманывая вместе с ними, сотрудничая вместе с ними, они в итоге переключались на фазу постоянного сотрудничества, к обоюдному преимуществу.

Однако горе тем, кто не знает кодекса чести. Любое отклонение от ожидавшейся последовательности приводило к всеобщей и непрекращающейся войне. Такой ответ мог унести с собой обе машины в некоем подобии атаки цифрового смертника. Поскольку на нужную последовательность было очень сложно набрести случайно, только потомки правивших машин могли процветать в послекодексную эру бескорыстной кооперации. Всех остальных убивали, включая и тех, кто использовал стратегию «зуб за зуб». Это доминирование продолжалось, пока не накапливалось достаточно много ошибок в кодексе, передаваемом из поколения в поколение, для того, чтобы доминирующие машины переставали распознавать друг друга. Затем они ополчались друг на дружку так же яростно, как на аутсайдеров, демонстрируя что-то похожее на аутоиммунное заболевание популяции.

В период, когда кодексы соблюдались, мы называли их шибболетами, в память о лингвистической дискриминации, упоминаемой в книге Судей Израилевых:

…И перехватили Галаадитяне переправу чрез Иордан от Ефремлян, и когда кто из уцелевших Ефремлян говорил: «позвольте мне переправиться», то жители Галаадские говорили ему: не Ефремлянин ли ты? Он говорил: нет. Они говорили ему «скажи: шибболет», а он говорил: «сибболет», и не мог иначе выговорить. Тогда они, взяв его, закололи у переправы чрез Иордан. И пало в то время из Ефремлян сорок две тысячи… (Суд. 12:5-6).

Шибболеты – распространённая особенность культуры и конфликтов людей. Финнов, которые не могли произнести слово yksi («один»), считали русскими во время гражданской войны в Финляндии. Туристов в деловом районе Манхэттена быстро распознают, если они произносят название улицы Houston Street [Хаустон-стрит] так же, как произносится название города Houston [Хьюстон] в Техасе.

А наши машины так эффективно использовали их для доминирования в популяции, что никто не мог выжить. Даже по окончанию этой эры пепел унаследовали именно их потомки. Слепая рука эволюции нашла простое, хотя и ужасное, решение.

Это был суровый и жестокий социальный ландшафт. Но мы выдали нашим машинам очень мало ресурсов для размышления. Как бы две совершенно рациональные машины вели бы себя во время конфликта, если бы они знали, что каждая из них идеально рациональная? По самой природе рациональности два полностью рациональных существа, столкнувшихся с одной проблемой, должны вести себя одинаково. Зная это, каждый выбрал бы сотрудничество – но не из альтруизма. Каждый понял бы, что в случае обмана его оппонент также выбрал бы обман, из-за чего оба проиграли бы.

Между двумя этими позициями имеется спектр. На одном его конце – минимально вычисляющие машины, ограниченные нулевые позиции культуры, которые естественным образом вырождаются в междоусобную вражду, трайбализм. На другом конце – неизбежная кооперация полностью рационального существа.

Где же на этой линии между грубыми машинами и ангельской рациональностью находятся человеческие существа?

Если мы, люди, сверхрациональны, или по крайней мере, стремимся к этому, то есть повод для оптимизма. Фрэнсис Фукуяма, возможно, думал о чём-то подобном, когда писал свой "Конец истории" в 1992 году. Хотя его аргументы базируются на работах немецких философов XIX века, таких, как Ницше и Гегель, мы можем переписать их таким образом: достаточно сложная ситуация в жизни человека окончится рациональным, либерал-демократическим, капиталистическим порядком, противостоящим разрозненному набору врагов.

Аргументы Фукуямы основывались не только на философских рассуждениях, но и на осмыслении текущих событий: коллапсе коммунизма, процветании электронных СМИ, на казавшемся беспроблемным открытии границ, и на эпическом росте фондовых рынков.

Сегодня его работа служит монументом мечтаниям предыдущей эры (одна из глав называлась «победа VCR»). Наши культуры эволюционируют, но, судя по всему, не в направлении гармонии. Хаос XXI века очень напоминает наши симуляции. Через два десятилетия после 9/11 даже западные либеральные демократии соглашаются с мрачными моделями человеческого поведения и более мрачными теоретиками, чем Фукуяма.

Карл Шмитт, к примеру, посчитавший совещательные элементы демократии завуалированными авторитарными формами правления. Или Роберт Мичелс, чьё изучение политического неравенства позволило ему увидеть, что демократия – это временный этап эволюции общества, направляющегося к правлению небольшой и закрытой группы элитариев. В то время, как интеллектуалы обеих разновидностей политического экстремизма всё чаще считают рациональный политический порядок фантазией, шибболеты принимают свою роль в определении расовых, национальных и религиозных границ и снова оказываются неискоренимыми свойствами политической жизни.

Между этими философами существует большая разница, как и между соответствующими им компьютерными моделями – между простыми, жестокими и нерациональными существами, которые мы с Джоном Миллером симулировали, и сверхрациональными кооператорами, которых Фукуями увидел ожидающими нас в конце истории. Но эти модели, по крайней мере, вызывают сдержанный оптимизм.

Исследователи из Института исследования машинного интеллекта (MIRI) в Беркли изучали поведение рациональных, но ограниченных в ресурсах машин, способных изучать исходный код друг друга. Может показаться, что такая прозрачность может решить проблему кооперации: если вы можете предсказать, что сделает ваш оппонент, проведя симуляцию его кода, можно решить, то обман не стоит его цены. Но что, если в исходном коде оппонента будет симуляция того, что я сделаю в результате запуска этой симуляции, и он попытается воспользоваться этим знанием? Без симметричной идеальной рациональности эта проблема приводит к серьёзным искажениям .

Некоторые машины в зоопарке MIRI могут напомнить вам о людях, которых вы знаете. К примеру, CliqueBot сотрудничает со всеми со схожим исходным кодом. Ему важены только коды, точно совпадающие с его кодом. FairBot наоборот, пытается заглянуть за поверхностные различия и доказать, что его оппонент будет с ним сотрудничать. Грубо говоря, FairBot говорит: «если я могу доказать, что мой оппонент будет сотрудничать со мной, я буду сотрудничать с ним».

Как эти машины уживаются друг с другом? Хотя общим решением будет парадокс регресса, исследования предсказательного поведения машин в дилемме заключённого дают успокаивающий ответ – обоюдное сотрудничество остаётся, по меньшей мере, возможным, даже для игрока с ограниченными ресурсами. К примеру, FairBot может распознавать сходным образом справедливые машины, даже если их исходный код отличается от его – что говорит о том, что разнообразие и сотрудничество не невозможны, по крайней мере, при достаточно высоком уровне интеллекта [Barasz, M., et al. Robust cooperation in the Prisoner’s Dilemma: Program equilibrium via provability logic. arXiv 1401.5577 (2014)].

Даже из машин, занимающихся геноцидом на жестоком краю спектра, можно извлечь вдохновляющий урок. Они появились из глубин печатной платы, будучи симулированными на техасском суперкомпьютере. У них нет биологических оправданий. Возможно, и мы не должны оправдываться: если это поведение настолько распространено, что оно появляется даже в простейших симуляциях, возможно, нам не нужно его ни бояться, ни боготворить, но относиться к нему так же, как к раку или гриппу.

Что, если мы будем рассматривать межплеменную вражду, как естественный сбой любой когнитивной системы, основанной хоть на кремнии, хоть на углероде? Как ни всеобщую истину, ни неизбежный грех, а как нечто, что необходимо побороть?

Саймон ДиДио – ассистент-профессор в университете Карнеги-Мэллон, управляющий Лабораторией социального

Автор: Вячеслав Голованов