Создание видео со сложными, реалистичными движениями остается одной из самых трудноразрешимых задач для ИИ-моделей для генерации видео. Даже самые популярные инструменты, такие как Sora от OpenAI, Gen-3 от Runway и Kling AI, продолжают испытывать трудности с согласованностью движений.

Попробуйте сгенерировать сцену, в которой человек наливает молоко или нарезает помидор, и вы наверняка заметите несоответствия - жидкости не подчиняются силе тяжести, объекты сливаются друг с другом, а конечности неестественно извиваются.

Чтобы продемонстрировать эту проблему, я попытался с помощью Sora от OpenAI быстро сгенерировать видео мальчика, кусающего бургер.

Понимаете, о чем я? На видео мальчик вроде бы ест бургер, но кажется, что бургер "парит" в его руках, а когда он якобы откусывает кусочек, ничего не меняется - бургер остается совершенно целым.

Эти недостатки связаны с тем, что современные модели при обучении уделяют больше внимания реконструкции на уровне пикселей, чем точности движения. Видеомодели часто не распознают временные связи, в результате чего получаются статичные кадры, а не непрерывная, правдоподобная последовательность событий.

Meta стремится решить эту проблему с помощью нового фреймворка под названием VideoJAM.

Что такое VideoJAM?

Проще говоря, VideoJAM - это новый фреймворк от Meta, призванный заставить модели генерации текста в видео создавать более реалистичное движение.

Существующие видеомодели часто не справляются с движением, иногда создавая видео с нереалистичной физикой, даже при высоком визуальном качестве.

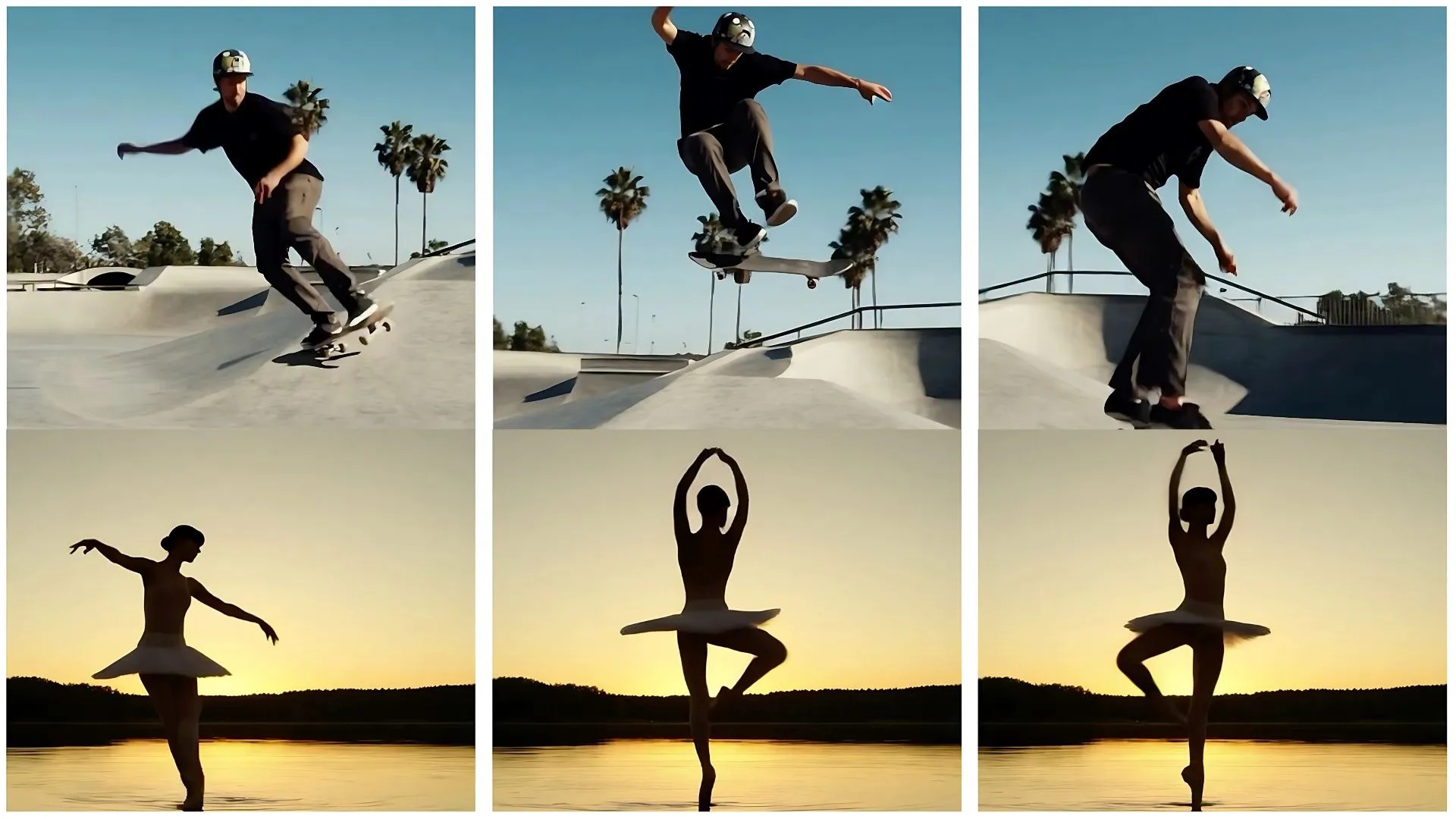

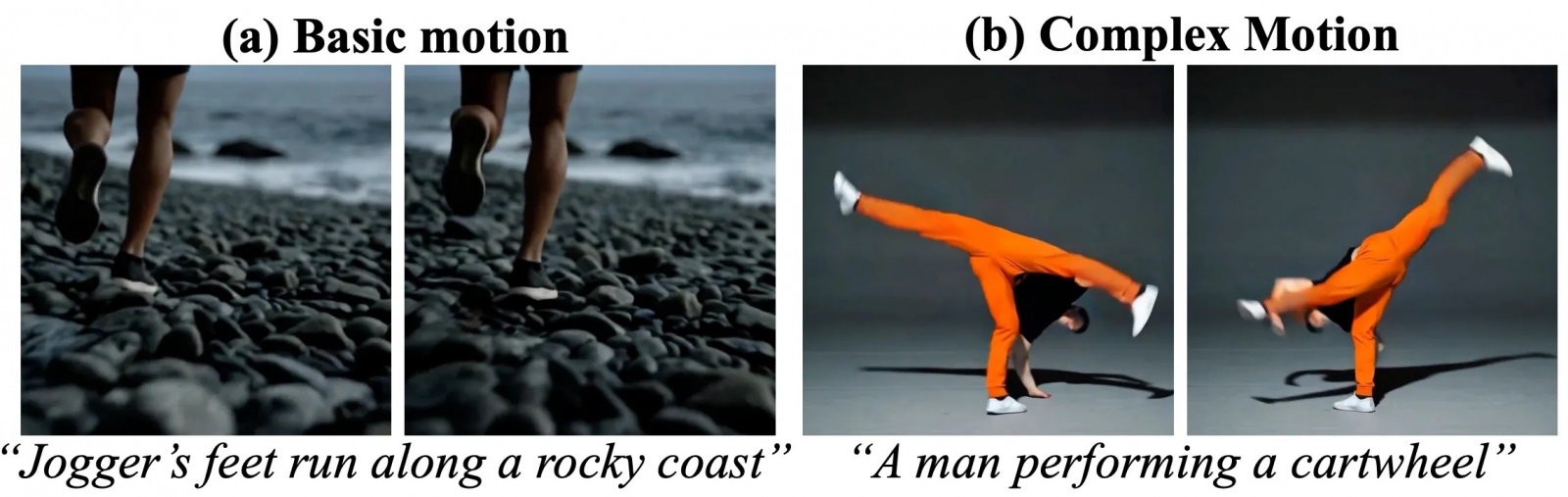

Примерами некогерентных генераций являются базовые движения, такие как бег человека (многократное наступание на одну и ту же ногу), или сложные движения, такие как гимнастика.

Когда перед ними ставится задача генерировать сложные движения, например гимнастические элементы, на видео часто появляются сильные деформации, например появление дополнительных конечностей.

В других случаях в генерируемых видео можно увидеть поведение, противоречащее фундаментальной физике, например, прохождение объектов сквозь другие твердые объекты, как в случае с обручем, проходящим сквозь человека внизу, и вращательные движения, которые не могут повторить простые повторяющиеся паттерны.

VideoJAM решает эти проблемы с помощью двух основных способов:

-

Совместное представление внешнего вида и движения. В процессе обучения VideoJAM учит модель понимать, как выглядят предметы (внешний вид) и как они движутся (движение). Вместо того чтобы сосредоточиться исключительно на воссоздании визуальных деталей, она также учится предсказывать движение в видео. Это достигается путем модификации задачи генерации видео, чтобы предсказывать как сгенерированные пиксели (внешний вид), так и соответствующее им движение на основе единого, выученного представления.

-

Внутреннее руководство. Во время генерации видео VideoJAM использует технику, называемую внутренним руководством. Она помогает модели сосредоточиться на создании когерентного движения, используя собственные предсказания движения для управления процессом генерации видео.

Посмотрите примеры ниже:

(Left) A skateboarder performs jumps. (Right) A slow-motion close-up of a chef slicing a tomato.

Обратите внимание, что ноги остаются на скейтборде после приземления - это невероятно естественно. Это самое реалистичное видео с быстрым движением, созданное ИИ, которое я когда-либо видел. Нарезка помидора также очень впечатляет, ведь он так убедительно деформируется во время нарезки. Даже то, как вытекает сок, придает дополнительный реализм.

Другие примеры вы можете посмотреть на этой странице GitHub.

Цель состоит в том, чтобы в генерируемых видеороликах движения были более реалистичными и слаженными, даже в сложных сценах. VideoJAM можно добавить к существующим видеомоделям без необходимости изменять обучающие данные или увеличивать размер модели.

Как работает VideoJAM?

Метод включает в себя два взаимодополняющих этапа:

-

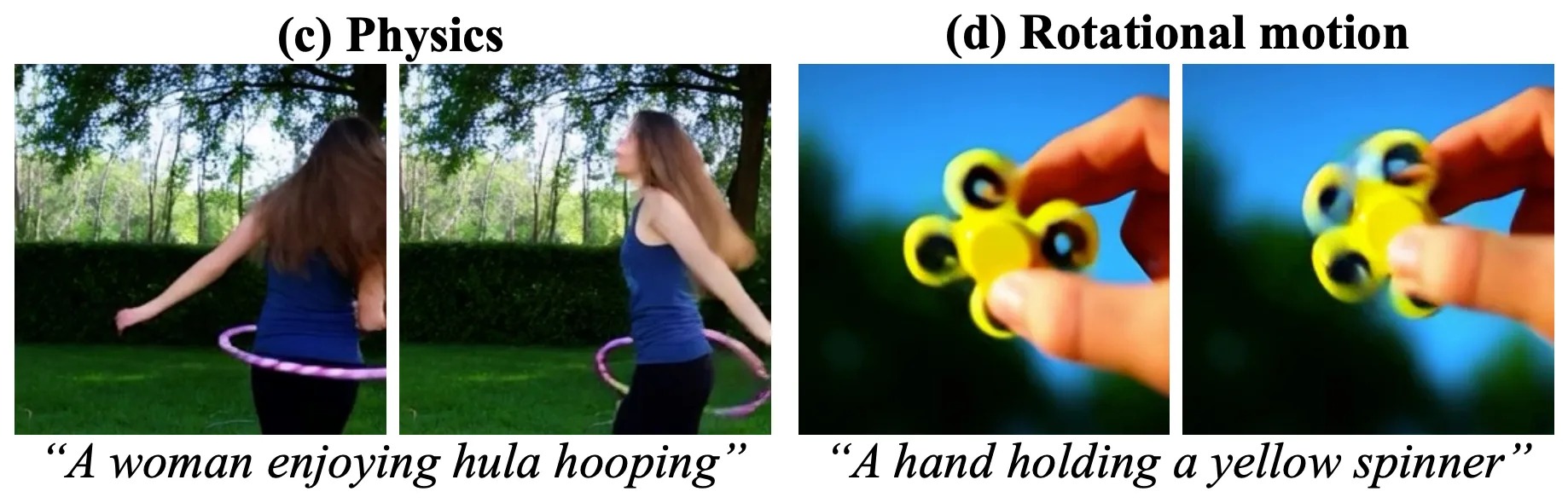

Фаза обучения. Модель модифицируется для предсказания совместного распределения внешнего вида и движения. Это достигается путем изменения архитектуры для поддержки двойного формата ввода-вывода, что позволяет модели предсказывать как внешний вид, так и движение в видео.

-

Фаза вывода. Вводится внутреннее управление - новый подход, который использует предсказанное движение для управления сгенерированным видео, обеспечивая согласованное и реалистичное движение.

В процессе обучения VideoJAM сопоставляет видео с соответствующими представлениями движения, модифицируя сеть для предсказания как внешнего вида, так и движения.

Архитектура изменена для поддержки двойного формата ввода-вывода, предсказывающего как внешний вид, так и движение видео. Для этого в архитектуру добавляются два линейных слоя:

-

Один из них - на входе, чтобы объединить два сигнала в единое представление. В частности, входная проекция Win расширяется для учета латентов видео и движения, что достигается путем добавления нулевых строк CTAE-p2 для создания матрицы двойной проекции

W+ in ∈ R2·CTAE·p2×CDiT. При инициализации сеть эквивалентна предварительно обученной DiT и игнорирует добавленный сигнал движения. -

Другой выход модели извлекает предсказание движения из выученного представления движения. Выходная проекция Wout расширяется с помощью дополнительной выходной матрицы, чтобы получить

W+ out ∈ RCDiT×2-CTAE-p2.

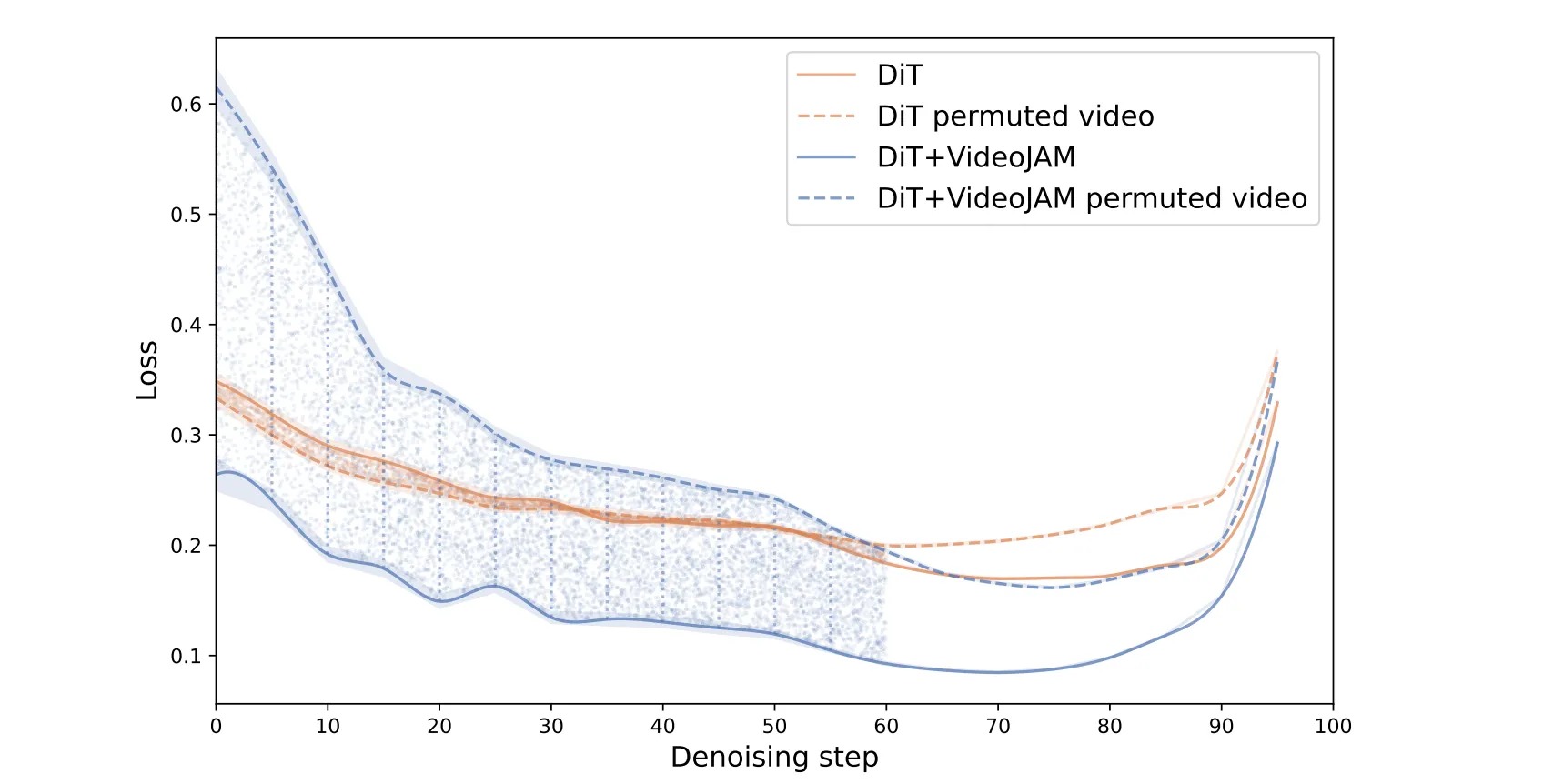

В процессе вывода Inner-Guidance использует собственное развивающееся предсказание движения модели в качестве динамического управляющего сигнала, чтобы направить генерацию к когерентному движению. Этот механизм напрямую изменяет распределение выборки модели, чтобы направить генерацию в сторону совместного распределения внешнего вида и движения и отвлечься от предсказания только внешнего вида.

Оценка VideoJAM показала заметное улучшение согласованности движений в различных типах видео. Основные результаты включают:

-

Улучшенное представление движения. По сравнению с такими известными моделями, как Sora и Kling, VideoJAM уменьшает количество артефактов, таких как искажения кадров и неестественные деформации объектов.

-

Улучшенная достоверность движений. VideoJAM неизменно демонстрирует более высокие показатели согласованности движений как при автоматизированной оценке, так и при оценке человеком.

-

Универсальность для всех моделей. Фреймворк эффективно интегрируется с различными предварительно обученными видеомоделями, показывая свою адаптивность и не требуя длительного переобучения.

-

Эффективная реализация. VideoJAM повышает качество видео, используя всего два дополнительных линейных слоя, что делает его легким и практичным решением.

Если вы хотите более подробно узнать о технических деталях работы VideoJAM, изучите техническую документацию здесь.

Два варианта моделей преобразования текста в видео

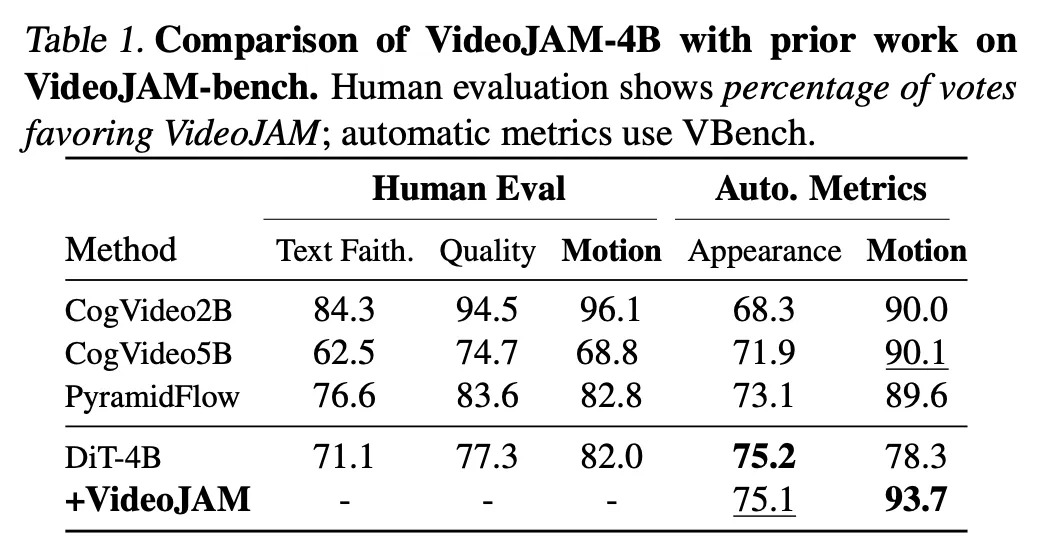

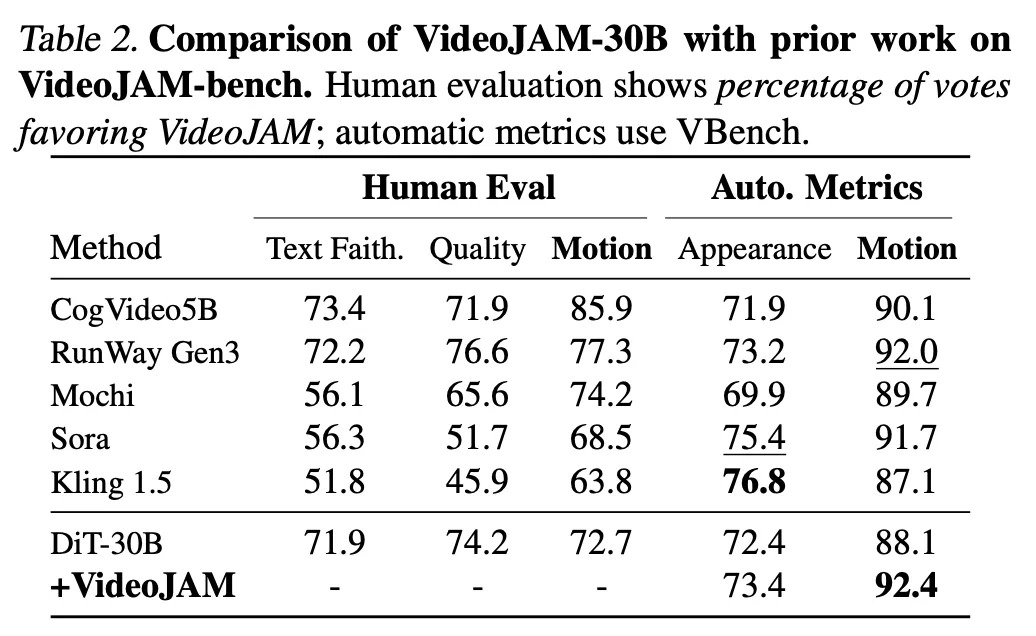

Исследователи рассматривают два варианта DiT-модели по преобразованию текста в видео - DiT-4B и DiT-30B, чтобы продемонстрировать, что согласованность движений является общей проблемой как для маленьких, так и для больших моделей.

-

Тонкая настройка VideoJAM-4B проводилась на 32 графических процессорах A100 с размером пакета 32 для 50 000 итераций при пространственном разрешении 256 × 25613. Латентная размерность - 3072 и 32 блока внимания.

-

VideoJAM-30B была настроена с использованием 256 графических процессоров A100 с размером блока 256 для 35 000 итераций при пространственном разрешении 256 × 25613. Латентная размерность составляет 6144, а количество блоков внимания - 48.

Обе модели были обучены с фиксированной скоростью обучения 5e-6, используя парадигму Flow Matching.

Оценка пользователями показывает процент голосов в пользу VideoJAM-4B и VideoJAM-30B по сравнению с другими конкурентами, такими как Sora и Kling.

Показатели оценивают качество каждого кадра, эстетику, согласованность объектов, количество сгенерированных движений и согласованность движений. На бумаге это, конечно, выглядит впечатляюще. Но давайте посмотрим на примерах, как VideoJAM сравнивается с ведущими конкурентами.

VideoJAM по сравнению с Kling и Sora

Давайте подробнее рассмотрим, как VideoJAM в сравнении с конкурентами, на нескольких примерах.

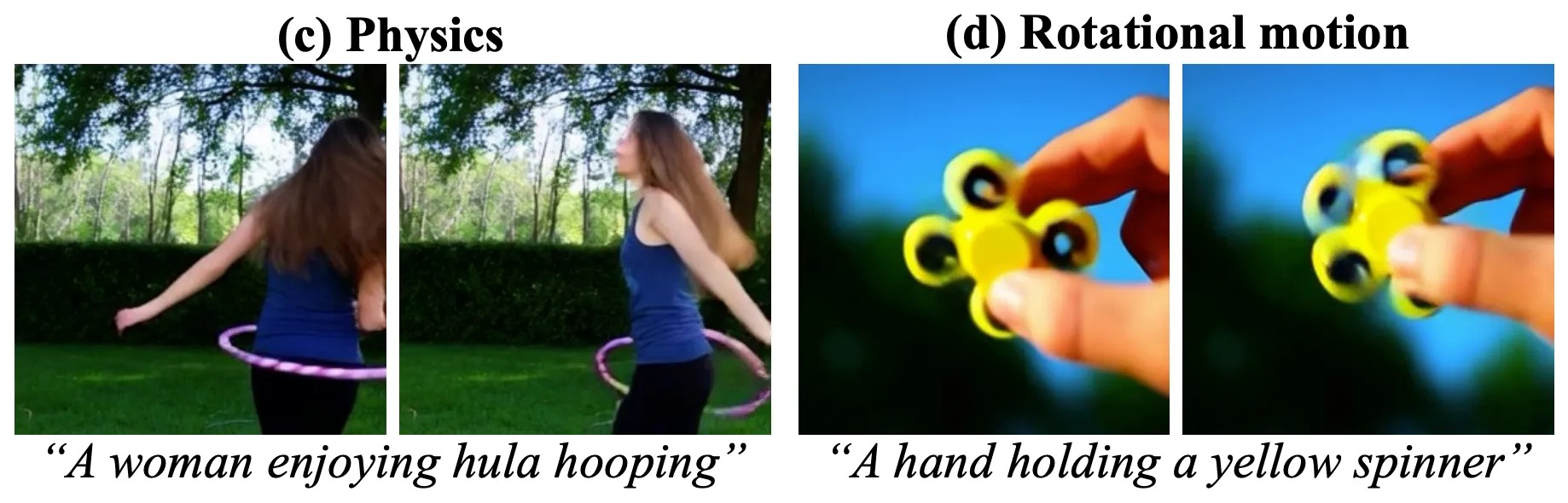

Пример № 1: Женщина, крутящая обруч

Промпт: A woman enjoying the fun of hula hooping.

В видео Sora обруч даже не касается женщины. Версия DiT не намного лучше - ее лицо настолько искажено, что просто жутко. У VideoJAM результат лучше - вращение обруча отлично синхронизировано с движением тела женщины.

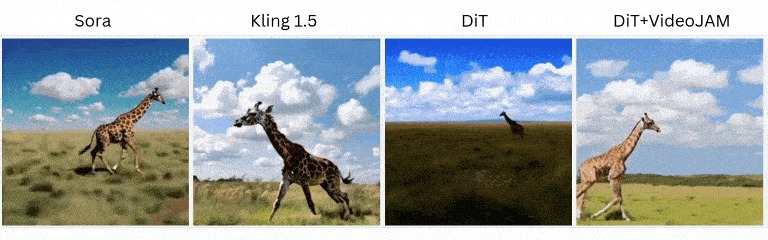

Пример № 2: Жираф, бегущий по полю

Промпт: A giraffe running through an open field. The background is a bright blue sky with fluffy white clouds.

Этот пример показывает, насколько сложно ИИ-моделям справиться даже с простыми движениями. В варианте от Sora жираф выглядит так, будто он бежит назад. На видео от Kling и DiT-30B у жирафа неловкие, резкие движения. VideoJAM значительно улучшает ситуацию, и на видео мы видим более плавные и естественные движения жирафа, которые действительно выглядят правдоподобно.

Пример № 3: Вращающийся в руке фиджет-спиннер

Промпт: A hand holding a yellow fidget spinner. The hand is fair-skinned and holds the bright yellow fidget spinner with silver bearings. The background is blurred and appears to be trees against a blue sky. The video captures the subtle movements of the hand as it spins the fidget spinner, creating a soothing and mesmerizing visual effect. As the video progresses, the hand continues to hold the fidget spinner, showcasing its smooth and satisfying motion. The background remains blurred, adding a sense of tranquility to the scene. Overall, the video is a calming and enjoyable display of the simple pleasure of fidget spinning.

Подобные быстрые движения кажутся сложными для рендеринга ИИ- моделями. Результаты Sora и Kling - это беспорядочное движение: спиннер размыт и движется несогласованно. DiT справляется лучше, а версия с VideoJAM обрабатывает высокоскоростное движение более плавно. Вы можете четко видеть, как вращается спиннер, при этом он визуально не распадается на части.

Ограничения VideoJAM

Хотя VideoJAM улучшает временную согласованность при генерации видео, у него все же есть ограничения.

-

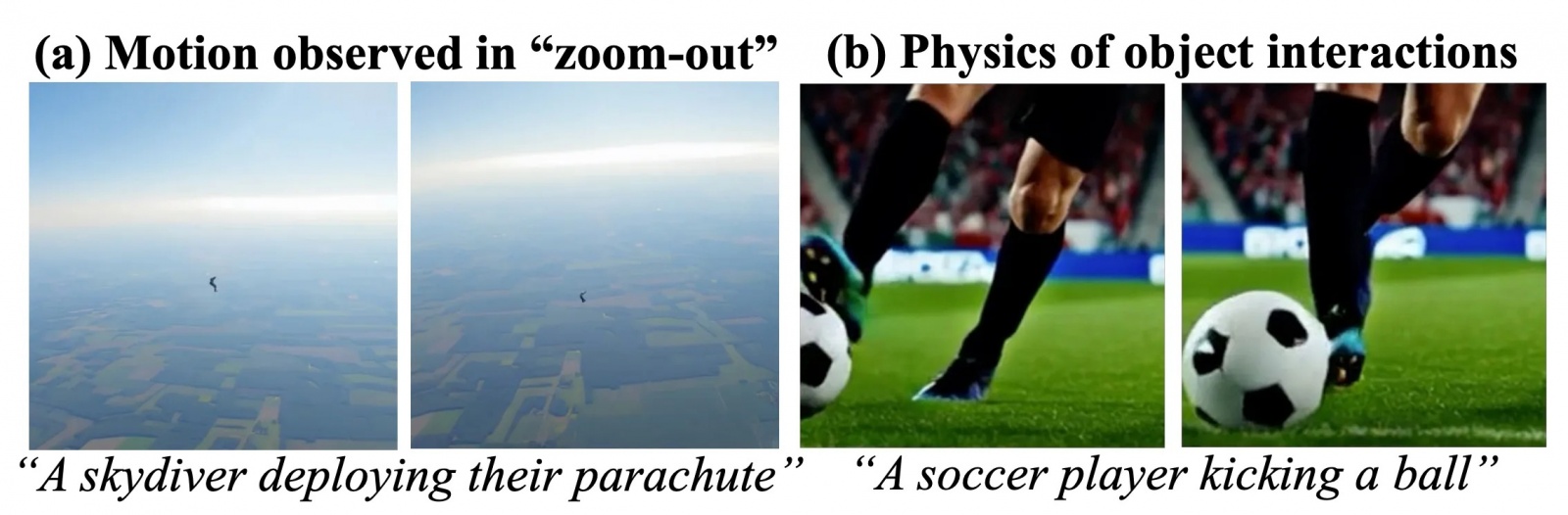

VideoJAM использует ограниченное разрешение при обучении и представление движения в формате RGB, что затрудняет захват движения, когда движущиеся объекты занимают лишь небольшую часть кадра. В таких ситуациях относительная величина движения уменьшается, что делает представление менее информативным.

-

Сложная физика взаимодействия объектов. В представлении движения в VideoJAM отсутствует явное кодирование физики, что ограничивает возможности модели по обработке сложных физических взаимодействий объектов. Хотя движение и физика связаны, и VideoJAM улучшает физику, модель не может обрабатывать сложную физику без явного кодирования.

-

Компромисс между динамической степенью и плавностью движения. Существует компромисс между степенью динамики и плавностью движения. Модели, создающие большое количество движений, имеют тенденцию быть более некогерентными. В VideoJAM соблюдается баланс между этими двумя параметрами.

-

Вычислительные ограничения. Модель опирается на ограниченное разрешение обучения и RGB-представление движения из-за вычислительных ограничений.

В приведенном выше примере на левом изображении видно, что парашют не развернут, и движение выглядит несогласованным. На правом изображении нога игрока не касается мяча до того, как он изменил траекторию.

VideoJAM - это, безусловно, интересное достижение, о чем свидетельствуют исследования и примеры видеороликов, выпущенные компанией Meta. Это еще одно подтверждение, что создание видео со сложными, реалистичными движениями с помощью одних лишь текстовых промптов возможно. Примеры намекают на то, что ИИ наконец-то сможет более точно обрабатывать физические симуляции.

Но означает ли это конец для таких моделей, как Veo2 или Sora? Пока нет. В ИИ часто существует огромная разница между успехами в исследованиях и реальными результатами. Чтобы преодолеть этот разрыв, требуются серьезные инженерные разработки, множество испытаний и время. Пока мы не увидим публичный релиз, сложно сказать, насколько хорошо VideoJAM будет работать в разных условиях и у разных пользователей.

Также остается вопрос, где эта технология может быть использована. Будет ли Meta использовать VideoJAM в таких приложениях, как Facebook или WhatsApp? Это еще предстоит выяснить. Пока же нам остается только следить за обновлениями и надеяться, что финальная версия оправдает надежды.

*Meta признана экстремистской организацией в России

Автор: NeyroEntuziast