За последние два года - за время невероятной популярности Generative AI - появилось много перспективных компаний, создающих новые прорывные модели. Последний пример - это китайский стартап DeepSeek, благодаря которому у нас есть открытые аналоги OpenAI GPT-4o и o1. С теми же (что проверено бенчмарками) возможностями в плане выполнения текстовых инструкций, задач на математику, логику и кодинг.

Становится любопытно, почему не особенно известный до сих пор стартап делает модели лучше, чем OpenAI?

OpenAI, получивший недавно 100 миллиардов долларов инвестиций на инфраструктуру, по их заявлению. А DeepSeek еще и выкладывает эти модели в опенсорс с MIT лицензией, бери и пользуйся. В чем их секрет?

Вспомним, на чем держится опенсорсная разработка больших языковых моделей (да и других, не только языковых моделей на базе трансформера). Уже старый эксперимент в Стэнфорде с Альпакой показал неожиданную способность небольшой LLM на архитектуре Llama обучаться до качества тогдашней флагманской модели OpenAI — GPT-3 — на данных, ею сгенерированных. Таким образом, SFT, Supervised Fine‑Tuning, в AI‑разработке сейчас — это прекрасный способ раздвинуть границы возможностей AI с высокими шансами на успех.

Хороший пример — моя модель ruslandev/llama-3–8b‑gpt-4o‑ru1.0. Я получил эту модель путем файнтюнинга Llama 3 8B на данных GPT-4o, существенно повысив качество базовой модели. Это потребовало всего лишь 1 эпохи на 2 NVIDIA A100 в облаке.

Существует другой метод «переноса знаний» большой качественной модели на модель поменьше — дистилляция. Модель‑ученик учится предсказывать не только следующий токен, который является результатом предсказания модели после применения софтмакс к значениям последнего слоя, но и промежуточные значения — логиты, еще до их преобразования в вероятности с помощью софтмакс. DeepSeek создали несколько моделей путем дистилляции из R1, размера 1.5B, 7B, 8B, 14B, 32B, 70B, на базе Llama и Qwen. Результат, на мой взгляд, ошеломляющий — даже 1.5 версия Qwen, полученная таким путем — DeepSeek‑R1-Distill‑Qwen-1.5B — существенно опередила GPT-4o и Claude-3.5 Sonnet на математическом бенчмарке AIME 2024, требующем от модели способности рассуждать последовательно.

Но как именно DeepSeek создали модель R1? А также V3 — обе имеют 671 миллиард параметров, реализуют MoE‑архитектуру и наверняка требовали огромных вычислительных затрат на обучение. Что касается базовой модели, DeepSeek‑V3-Base, она обучена на корпусе из 14.8 триллионов токенов — близко к Llama 3. На обучение ушло 2.788M H800 GPU‑часов. Приблизительно 6 миллионов долларов. Это не идет ни в какое сравнение с бюджетами OpenAI.

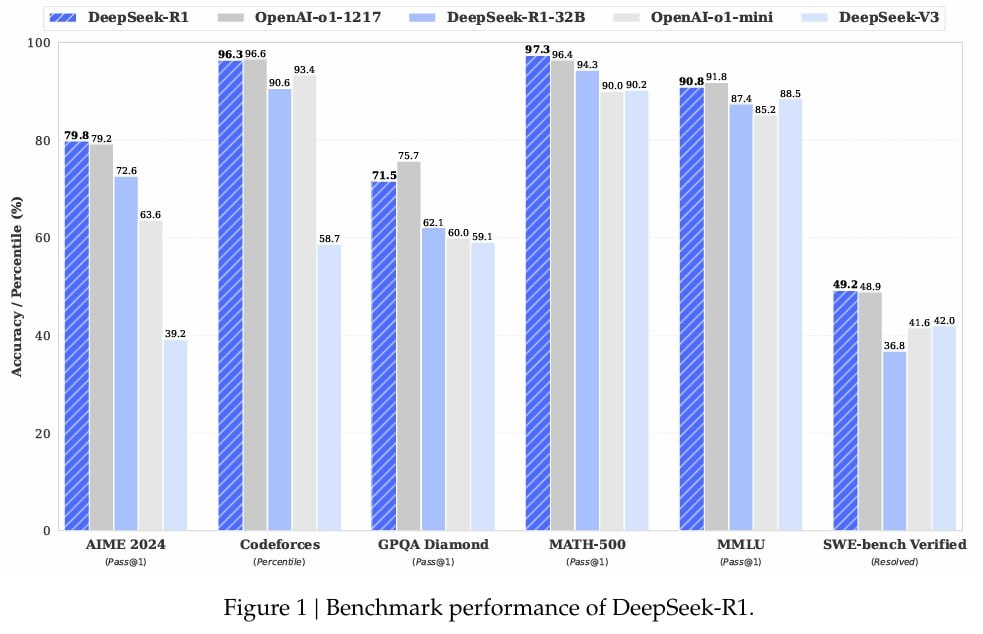

R1 обучена на DeepSeek‑V3-Base, причем первая стадия — RL‑обучение с помощью Group Relative Policy Optimization (GRPO) — дала в результате R1-Zero, а финальный успех R1, когда модель обошла o1 на ряде бенчмарков, обусловлен как раз‑таки файнтюнингом на небольшом, но качественном наборе размеченных данных, с приоритетом на рассуждения и следование инструкциям. т. е. SFT‑файнтюнинг — ключевой ингредиент для R1. К сожалению, датасет не опубликован. Вероятно, потому что он содержит выборки, сгенерированнные OpenAI o1? В любом случае, есть сама модель DeepSeek R1, и ничто не мешает использовать ее данные для файнтюнинга моделей.

Автор: ruslandevlabs