Венчурный инвестор и контрибьютор журнала Forbes Роб Тейвз каждый год публикует свой прогноз событий, которые будут ждать сферу искусственного интеллекта в новом году. Ранее мы публиковали текст о том, как сбылись прогнозы на 2024, а теперь Роб подготовил новые предсказания. Вот они:

1. Meta* введет плату за использование Llama

Meta является мировым лидером в области открытых моделей ИИ. В то время, как OpenAI и Google, держат свои передовые модели закрытыми и взимают плату за их использование, Meta выбрала путь предоставления своих передовых моделей Llama бесплатно.

Дисклеймер: это вольный перевод колонки издания Forbes, которую написал венчурный инвестор Роб Тейвз. Перевод подготовила редакция «Технократии». Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» — мы регулярно рассказываем о новостях про AI, LLM и RAG, а также делимся полезными мастридами и актуальными событиями.

Обсудить пилот или задать вопрос об LLM можно здесь.

Поэтому многих удивит, когда в следующем году Meta* начнет брать плату с компаний за использование Llama.

Чтобы быть точными: мы не предсказываем, что Meta* сделает Llama полностью закрытой или что любой, кто использует модели Llama, должен будет платить за них.

Имеется ввиду, что Meta ограничит условия открытой лицензии на Llama , так что компании, использующие Llama в коммерческих целях выше определенного масштаба, должны будут начать платить за доступ к моделям.

Технически, Meta уже делает это в ограниченном объеме. Компания не позволяет крупным компаниям — облачным гиперскейлерам и другим компаниям с более чем 700 миллионами ежемесячно активных пользователей — свободно использовать Llama.

Еще в 2023 году генеральный директор Meta* Марк Цукерберг сказал: «Если вы кто-то вроде Microsoft, Amazon или Google, и вы собираетесь перепродавать [Llama], мы считаем, что должны получить часть дохода от этого. Я не думаю, что это будет большая сумма в ближайшее время, но надеюсь, что в долгосрочной перспективе это может стать чем-то значительным».

В следующем году Meta значительно расширит круг организаций, которые должны будут платить за использование Llama, включив в него множество крупных и средних предприятий.

Почему Meta решила сделать такой стратегический поворот?

Поддержание актуальности больших языковых моделей (LLM) чрезвычайно дорогостоящее занятие. Meta будет вынуждена инвестировать миллиарды долларов ежегодно, чтобы модели Llama оставались на уровне или близко к уровню последних передовых моделей от OpenAI, Anthropic и других компаний.

Meta* является одной из крупнейших и наиболее финансово устойчивых компаний в мире. Однако она также является публичной компанией, которая в конечном итоге отчитывается перед своими акционерами. По мере роста затрат на разработку LLM, становится все менее оправданным для Meta* тратить такие огромные суммы на обучение нового поколения моделей Llama без доходов.

Любители, ученые, индивидуальные разработчики и стартапы смогут продолжать использовать модели Llama бесплатно в следующем году. Но 2025 год станет годом, когда Meta* серьезно займется монетизацией Llama.

2. Законы масштабирования будут открыты и использованы в областях, выходящих за рамки текста, особенно в робототехнике и биологии

Ни одна тема в области ИИ не вызвала столько обсуждений в последние недели, как законы масштабирования и вопрос о том, на каком горизонте они буду валидны.

В статье OpenAI 2020 года, основная концепция законов масштабирования проста: по мере увеличения числа параметров модели, объема обучающих данных и вычислительных ресурсов при обучении модели ИИ, ее производительность улучшается (технически, уменьшается тестовая потеря) надежным и предсказуемым образом. Законы масштабирования ответственны за впечатляющие улучшения в производительности от GPT-2 до GPT-3 и GPT-4.

Как и закон Мура, законы масштабирования не являются законами, а скорее эмпирическими наблюдениями. В течение последнего месяца ряд отчетов указывали на то, что крупные лаборатории ИИ наблюдают уменьшение отдачи от продолжающегося масштабирования больших языковых моделей. Это помогает объяснить, например, почему релиз OpenAI GPT-5 постоянно откладывается.

Самым распространенным возражением на плато законов масштабирования является то, что появление вычислений во время тестирования открывает совершенно новую область для масштабирования. То есть, вместо масштабирования вычислений во время обучения, новые модели рассуждений, такие как OpenAI o3, позволяют масштабировать вычисления во время вывода, раскрывая новые возможности ИИ, позволяя моделям "думать дольше".

Это важный момент. Вычисления во время тестирования - это действительно новый путь для масштабирования и улучшения производительности ИИ.

Но есть еще один важный аспект законов масштабирования, который недостаточно оценен в современных дискуссиях. Почти все обсуждения законов масштабирования, начиная со статьи 2020 года и до сегодняшнего фокуса на вычислениях во время тестирования, сосредоточены на языке. Но язык — это не единственная важная модальность данных.

Нельзя забывать о робототехнике, биологии, мировых моделях или веб-агентах. Для этих модальностей данных законы масштабирования не исчерпаны; наоборот, они только начинаются. Более того, строгих доказательств существования законов масштабирования в этих областях до сих пор не опубликовано.

Стартапы, создающие фундаментальные модели для этих новых модальностей данных, например, EvolutionaryScale в биологии, Physical Intelligence в робототехнике, World Labs в мировых моделях, стремятся выявить и использовать законы масштабирования в этих областях так же, как OpenAI успешно использовала законы масштабирования LLM в первой половине 2020-х годов. В следующем году ожидаются значительные достижения в этой области.

Законы масштабирования не исчезнут. Они будут такими же важными, как и прежде, в 2025 году. Но центр активности для законов масштабирования сместится от предварительного обучения LLM к другим модальностям.

3. Дональд Трамп и Илон Маск пойдут разными путями, что повлияет на мир ИИ

Новая администрация в США принесет с собой ряд изменений в политике и стратегии в области ИИ. Чтобы предсказать, что будет с ИИ при Трампе, можно сосредоточиться на его близких отношениях с Илоном Маском, учитывая центральную роль Маска в мире ИИ сегодня.

Можно представить несколько способов, которыми Маск мог бы повлиять на развитие ИИ в администрации Трампа. Учитывая его крайне враждебные отношения с OpenAI, новая администрация могла бы занять менее дружелюбную позицию по отношению к OpenAI при взаимодействии с отраслью, разработке регулирования ИИ, предоставлении государственных контрактов и так далее. (Это реальный риск, который беспокоит OpenAI уже сегодня.) С другой стороны, администрация Трампа могла бы поддерживать компании самого Маска: например, сокращать бюрократические препоны, чтобы xAI могла строить дата-центры и выйти вперед в гонке за передовыми моделями; предоставлять быстрое регуляторное одобрение для Tesla для развертывания флота роботакси и т.д.

Более фундаментально, Илон Маск, в отличие от многих других технологических лидеров, имеющих влияние на Трампа, очень серьезно относится к безопасности ИИ и поэтому является сторонником значительного регулирования ИИ. Он поддержал спорный законопроект Калифорнии SB 1047, который стремился ввести ограничения для разработчиков ИИ. Влияние Маска могло бы привести к более жесткой регуляции ИИ в США.

Однако есть одна проблема со всеми этими спекуляциями. Отношения Дональда Трампа и Илона Маска неизбежно распадутся.

Как мы видели снова и снова во время первой администрации Трампа, средняя продолжительность пребывания союзника Трампа, даже самого преданного, удивительно коротка — от Джеффа Сешнса до Рекса Тиллерсона, Джеймса Мэттиса, Джона Болтона и Стива Бэннона. (И, конечно, кто может забыть десятидневное пребывание Энтони Скарамуччи в Белом доме?) Очень немногие из помощников Трампа из его первой администрации остаются лояльными ему сегодня.

Оба, Дональд Трамп и Илон Маск, — сложные, непредсказуемые и взрывоопасные личности. С ними нелегко работать. Они выжимают из людей все соки. Их новообретенная дружба пока приносит взаимную пользу, но она все еще находится в стадии медового месяца. Считается, что к концу 2025 года отношения испортятся.

Что это будет означать для мира ИИ?

Это будет хорошей новостью для OpenAI. Это будет неприятной новостью для акционеров Tesla. И это будет разочарованием для тех, кто обеспокоен безопасностью ИИ, так как это практически означает, что правительство США при Трампе займет позицию невмешательства в регулирование ИИ.

4. Веб-агенты станут мейнстримом, превратившись в следующее крупное приложение в области потребительского ИИ

Представьте мир, в котором вам никогда не придется напрямую взаимодействовать с вебом. Каждый раз, когда вам нужно управлять подпиской, оплачивать счет, записываться на прием к врачу, заказывать что-то на Amazon, бронировать столик в ресторане или выполнять любую другую утомительную онлайн-задачу, вы просто можете поручить это ИИ-ассистенту.

Концепция «веб-агента» существует уже много лет. Если бы что-то подобное существовало и работало, нет сомнений, что это было бы чрезвычайно успешным продуктом. Однако на сегодняшний день на рынке нет функционирующего универсального веб-агента.

Стартапы, такие как Adept, которые привлекли сотни миллионов долларов с очень квалифицированной командой основателей, но не смогли реализовать свое видение, стали предостерегающими примерами в этой категории.

В следующем году веб-агенты станут мейнстримом.Достижения в области языковых и визуальных фундаментальных моделей, а также недавние прорывы в теории «двух систем» благодаря новым моделям рассуждений и вычислениям во время вывода, означают, что веб-агенты будут готовы к широкому использованию.

(Другими словами, у Adept была правильная идея; она просто была слишком ранней. В стартапах, как и во многом в жизни, время — это все)

Веб-агенты найдут множество применений в корпоративной среде, но наибольшая рыночная возможность для веб-агентов будет среди потребителей. Несмотря на всю недавнюю лихорадку вокруг ИИ, относительно немногие приложения, ориентированные на ИИ, кроме ChatGPT, стали мейнстримом среди потребителей. Веб-агенты изменят это, став следующим настоящим «приложением-убийцей» в области потребительского ИИ.

5. В 2025 году серьезные усилия будут направлены на размещение центров обработки данных ИИ в космосе

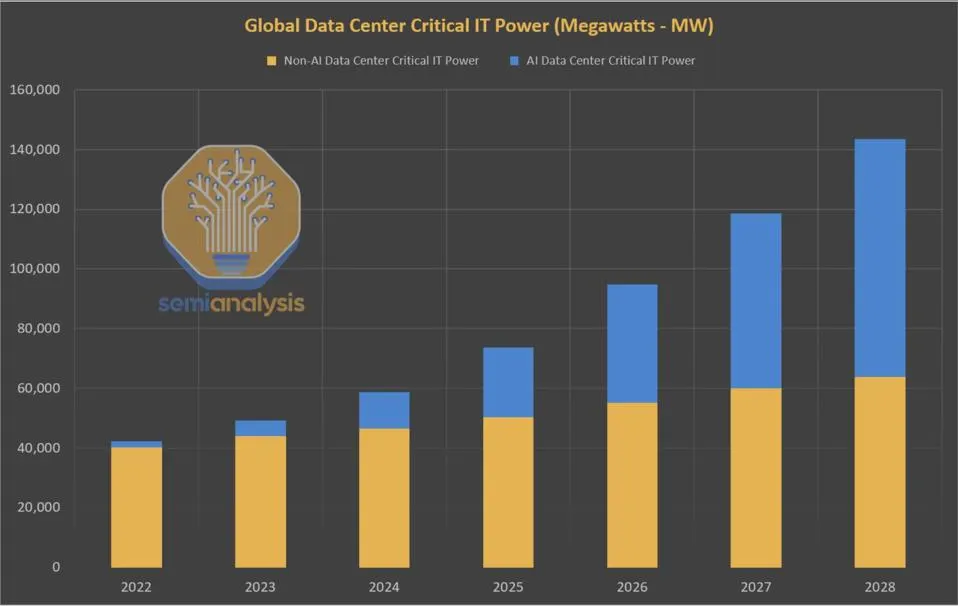

В 2023 году критическим физическим ресурсом, ограничивающим рост ИИ, были GPU-чипы. В 2024 году это стали энергия и центры обработки данных.

Ни одна тема не получила больше внимания в 2024 году, чем огромные и быстро растущие энергетические потребности ИИ в условиях стремления к построению большего количества центров обработки данных. После десятилетий стабильности глобальный спрос на энергию от центров обработки данных прогнозируется удвоиться между 2023 и 2026 годами благодаря буму ИИ. В США ожидается, что к 2030 году центры обработки данных будут потреблять почти 10% всей энергии, по сравнению с 3% в 2022 году.

Сегодняшняя энергетическая система просто не готова справиться с огромным скачком спроса, вызванным нагрузками ИИ. Предстоит историческое столкновение между этими двумя многотриллионными системами — нашей энергетической сетью и нашей вычислительной инфраструктурой.

В этом году ядерная энергия набрала обороты как возможное решение этой проблемы. Ядерная энергия представляет собой идеальный источник энергии для ИИ во многих отношениях: она нулевая по углеродным выбросам, доступна круглосуточно и практически неисчерпаема. Однако новые источники ядерной энергии не смогут существенно повлиять на эту проблему до 2030-х годов, учитывая длительные сроки исследований, разработки проектов и регулирования. Это относится к традиционным ядерным реакторам, реакторам нового поколения «малых модульных реакторов» (SMR) и, конечно, к ядерным реакторам на основе термоядерного синтеза.

В следующем году появится необычная новая идея для решения этой проблемы, которая привлечет реальные ресурсы: размещение центров обработки данных ИИ в космосе.

Центры обработки данных ИИ в космосе — на первый взгляд, это звучит как плохая шутка о венчурном капиталисте, пытающемся объединить слишком много стартап-терминов. Но в этом действительно может быть что-то.

Основное препятствие для быстрого строительства большего количества центров обработки данных на Земле — это доступ к необходимой энергии. Вычислительный кластер на орбите может пользоваться бесплатной, безграничной, нулевой по углеродным выбросам энергией круглосуточно: солнце всегда светит в космосе.

Еще одно значительное преимущество размещения вычислений в космос решение проблемы охлаждения. Одной из крупнейших инженерных проблем при построении более мощных центров обработки данных является то, что работа множества GPU в ограниченном пространстве вызывает сильный нагрев, а высокие температуры могут повредить или уничтожить вычислительное оборудование. Разработчики центров обработки данных прибегают к дорогостоящим и непроверенным методам, таким как жидкостное погружное охлаждение, чтобы решить эту проблему. Но космос очень холодный; любое тепло, генерируемое вычислительной деятельностью, мгновенно и безвредно рассеивается.

Конечно, остается множество практических проблем, которые нужно решить. Очевидная проблема — можно ли и как передавать большие объемы данных между орбитой и Землей экономически эффективно. Это открытый вопрос, но он может быть решен благодаря перспективным разработкам с использованием лазеров и других высокоскоростных оптических технологий связи.

Стартап из Y Combinator под названием Lumen Orbit недавно привлек $11 млн для реализации именно этой идеи: создания сети многогигаватных центров обработки данных в космосе для обучения моделей ИИ.

Как сказал генеральный директор Lumen Филип Джонстон: «место того чтобы платить $140 миллионов за электричество, вы можете заплатить $10 миллионов за запуск и солнечную энергию».

Lumen не будет единственной организацией, которая обратится к этой концепции в 2025 году.

Появятся и другие стартапы-конкуренты. Неудивительно, если один или несколько облачных гиперскейлеров также направят исследовательские усилия в этом направлении. Amazon уже имеет большой опыт размещения активов на орбите через Project Kuiper; Google имеет долгую историю финансирования подобных «лунных» идей; и даже Microsoft не чужд космической экономике. Elon Musk's SpaceX также может сделать ставку на это.

6. Система ИИ пройдет «тест Тьюринга для речи»

Тест Тьюринга является одним из самых старых и известных критериев для оценки производительности ИИ. Чтобы «пройти» тест Тьюринга», система ИИ должна уметь общаться с помощью письменного текста так, чтобы средний человек не мог отличить, общается он с ИИ или с человеком.

Благодаря недавним достижениям в области LLM, тест Тьюринга стал решенной задачей в 2020-х годах.

Однако письменный текст — это не единственный способ общения.

По мере того как ИИ становится все более мультимодальным, можно представить новую, более сложную версию теста Тьюринга — «тест Тьюринга для речи», в котором система ИИ должна уметь взаимодействовать с людьми голосом с такой степенью мастерства и плавности, чтобы ее нельзя было отличить от человека.

Тест Тьюринга для речи пока недостижим для современных систем ИИ. Его решение потребует значительных дополнительных технологических достижений.

Задержка (время между тем, когда человек говорит, и тем, когда отвечает ИИ) должна быть сокращена практически до нуля, чтобы соответствовать опыту общения с другим человеком. Системы голосового ИИ должны лучше справляться с неоднозначными входными данными или недоразумениями в реальном времени, например, когда их прерывают на середине предложения. Они должны уметь вести длительные, многоходовые, открытые беседы, запоминая предыдущие части разговора. И, что особенно важно, голосовые ИИ-агенты должны научиться лучше понимать невербальные сигналы в речи, например, что означает, если человек звучит раздраженным, возбужденным или саркастическим, и генерировать эти невербальные сигналы в своей речи.

Голосовой ИИ находится на увлекательном этапе развития к концу 2024 года, благодаря фундаментальным прорывам, таким как появление моделей «речь-в-речь». Немногие области ИИ развиваются сегодня так быстро, как технологически, так и коммерчески. Ожидается, что в 2025 году голосовой ИИ сделает значительный скачок вперед.

7. Будут достигнуты успехи в создании ИИ, способных автономно разрабатывать более совершенные системы ИИ

Концепция рекурсивно самоулучшающегося ИИ обсуждается уже десятилетиями.

Еще в 1965 году близкий соратник Алана Тьюринга, И. Дж. Гуд, писал:«Пусть ультра интеллектуальная машина будет определена как машина, которая может значительно превзойти все интеллектуальные деятельности любого человека, как бы он ни был умен. Поскольку разработка машин является одной из этих интеллектуальных деятельностей, ультра интеллектуальная машина могла бы разрабатывать еще более совершенные машины; тогда неизбежно произойдет взрыв интеллекта, и интеллект человека будет далеко позади».

Идея ИИ, который может создавать более совершенный ИИ, является интеллектуально увлекательной концепцией. Однако до сих пор она сохраняет оттенок научной фантастики.

Тем не менее, хотя это еще не широко признано, эта концепция начинает становиться реальностью. Исследователи об ИИ начали достигать ощутимого прогресса в создании систем ИИ, которые могут сами разрабатывать более совершенные системы ИИ.

В следующем году это направление исследований выйдет на мейнстрим.

На сегодняшний день наиболее заметным публичным примером исследований в этом направлении является «AI Scientist» от Sakana. Опубликованная в августе работа AI Scientist представляет собой убедительное доказательство того, что системы ИИ действительно могут проводить исследования в области ИИ полностью автономно.

AI Scientist от Sakana выполняет весь жизненный цикл исследований в области искусственного интеллекта: читает существующую литературу, генерирует новые идеи для исследований, разрабатывает эксперименты для их проверки, проводит эти эксперименты, пишет исследовательскую статью для представления своих результатов и затем проводит процесс рецензирования своей работы. Все это делается полностью автономно, без участия человека. Некоторые из исследовательских статей, созданных AI Scientist, доступны для чтения в интернете.

Ходят слухи, что OpenAI, Anthropic и другие исследовательские лаборатории уделяют внимание идее «автоматизированных исследователей ИИ», хотя пока ничего не было официально подтверждено.

Ожидаются больше обсуждений, прогресса и стартап-активности в этой области в 2025 году, по мере того как становится более широко признано, что автоматизация исследований в области ИИ действительно становится возможным.

Самым значимым этапом станет тот момент, когда исследовательская статья, полностью написанная агентом ИИ, будет принята на ведущую конференцию по ИИ впервые. (Поскольку статьи проходят анонимное рецензирование, рецензенты конференции не будут знать, что статья написана ИИ, пока она не будет принята.) Неудивительно, если в следующем году исследовательская работа, созданная ИИ, будет принята на NeurIPS, CVPR или ICML. Это будет увлекательный, спорный и исторический момент для индустрии ИИ.

8. OpenAI, Anthropic и другие передовые лаборатории начнут «подниматься по стеку», смещая стратегический фокус на разработку приложений

Создание передовых моделей — это сложный бизнес. Он требует огромных капиталовложений. Лаборатории, занимающиеся передовыми моделями, тратят беспрецедентные суммы денег. OpenAI недавно привлекла рекордные $6,5 миллиардов финансирования — и, вероятно, вскоре потребуется еще больше. Anthropic, xAI и другие находятся в аналогичной ситуации.

Затраты на переключение и лояльность клиентов низкие. Приложения ИИ часто разрабатываются как модельно-агностичные к моделям от разных поставщиков, которые легко заменяются в зависимости от изменения сравнений по стоимости и производительности.

С появлением передовых открытых моделей, таких как Llama от Meta* и Qwen от Alibaba, угроза технологической коммодизации постоянно нависает.

Лидеры ИИ, такие как OpenAI и Anthropic, не могут и не будут прекращать инвестиции в создание передовых моделей. Но в следующем году, стремясь развивать бизнес-линии с более высокой маржой, более дифференцированными и устойчивыми, ожидайте, что передовые лаборатории предпримут значительные усилия для запуска большего количества собственных приложений и продуктов.

Конечно, один яркий пример успешного приложения от передовой лаборатории уже существует: ChatGPT.

Какие еще первоклассные приложения можно ожидать от лабораторий ИИ в новом году?

Одним очевидным ответом являются более сложные и функционально богатые поисковые приложения. Усилия OpenAI по созданию SearchGPT являются предвестником будущего в этой области.

Программирование — еще одна очевидная категория. И здесь уже начаты первые шаги по продуктизации, с запуском продукта OpenAI Canvas в октябре.

Может ли OpenAI или Anthropic запустить корпоративное поисковое предложение в 2025 году? Или продукт для обслуживания клиентов? А как насчет юридического ИИ или продукта для продаж? На потребительском уровне можно представить себе «персонального ассистента» веб-агента, приложение для планирования путешествий или, возможно, приложение для генерации музыки.

Одной из самых увлекательных частей наблюдения за передовыми лабораториями, поднимающимися по стеку к уровню приложений, является то, что это приведет их к прямой конкуренции с многими из их самых важных клиентов: в поиске с Perplexity, в программировании с Cursor, в обслуживании клиентов с Sierra, в юридическом ИИ с Harvey, в продажах с Clay и т.д.

9. По мере подготовки Klarna к IPO в 2025 году, заявления компании о использовании ИИ будут подвергнуты тщательной проверке и будут сильно приувеличены

Klarna — это шведская компания, предоставляющая услуги «купи сейчас, плати позже», которая привлекла почти $5 миллиардов венчурного капитала с момента своего основания в 2005 году. Пожалуй, ни одна компания не делала более грандиозных заявлений о своем использовании ИИ, чем Klarna.

Всего несколько дней назад генеральный директор Klarna Себастьян Сьемятковски рассказал Bloomberg, что компания полностью прекратила нанимать сотрудников, вместо этого полагаясь на генеративный ИИ для выполнения работы.

Как выразился Сьемятковски: «Я считаю, что ИИ уже может выполнять все те задачи, которые выполняем мы, люди».

В том же духе Klarna объявила ранее в этом году о запуске платформы ИИ для обслуживания клиентов, которая полностью автоматизировала работу 700 сотрудников службы поддержки клиентов. Компания также заявила, что перестала использовать корпоративные программные продукты, такие как Salesforce и Workday, поскольку может просто заменить их на ИИ.

Но эти заявления отражают недостаточное понимание того, на что способны и не способны современные системы ИИ.

Невозможно утверждать, что можно заменить любого сотрудника в любой функции организации на агента ИИ. Это означало бы решение проблемы общего ИИ на уровне человека.

Ведущие стартапы в области ИИ сегодня усердно работают над созданием агентивных систем, которые могут автоматизировать специфические, узко определенные, высокоструктурированные корпоративные процессы — например, подмножество деятельности сотрудника по развитию продаж или агента службы поддержки клиентов. Даже в этих узко ограниченных контекстах эти агенты пока не работают полностью надежно, хотя в некоторых случаях они начали работать достаточно хорошо, чтобы увидеть раннее коммерческое применение.

Почему Klarna делает такие преувеличенные заявления о ценности, которую она извлекает из ИИ?

Ответ прост. Компания планирует IPO в первой половине 2025 года. Наличие убедительной истории об ИИ будет критически важно для успешного публичного размещения. Klarna остается компанией с убытками в размере $241 миллиона в прошлом году; возможно, она надеется, что ее история об ИИ убедит инвесторов на публичном рынке в ее способности значительно сократить затраты и перейти к устойчивой прибыльности.

Без сомнения, каждая организация в мире, включая Klarna, получит огромные преимущества в производительности от ИИ в ближайшие годы. Но многие сложные технологические, продуктовые и организационные проблемы остаются нерешенными, прежде чем агенты ИИ смогут полностью заменить людей на рабочем месте. Преувеличенные заявления, такие как у Klarna, наносят ущерб области ИИ и реальным достижениям, которые технологи и предприниматели в области ИИ достигают в развитии агентивного ИИ.

По мере подготовки Klarna к своему публичному размещению в 2025 году, ожидается увидеть больше скептицизма и публичной критики этих заявлений, которые до сих пор в основном оставались без опровержения. Неудивительно, если компания откажется от некоторых своих наиболее преувеличенных описаний использования ИИ.

10. Произойдет первый реальный инцидент, связанный с безопасностью в области ИИ

По мере того как искусственный интеллект становится все более мощным, растут опасения, что системы ИИ могут начать действовать вопреки человеческим интересам и что люди могут потерять контроль над этими системами. Представим, например, систему ИИ, которая учится обманывать или манипулировать людьми ради достижения своих целей, даже если эти цели причиняют вред людям.

Эти общие опасения часто объединяются под термином «безопасность ИИ».

В последние годы безопасность ИИ перешла из разряда маргинальных, почти научно-фантастических тем в мейнстрим. Все крупные игроки в области ИИ, от Google до Microsoft и OpenAI, сегодня уделяют реальные ресурсы вопросам безопасности ИИ. Иконы ИИ, такие как Джеффри Хинтон, Йошуа Бенжио и Илон Маск, активно высказываются о рисках, связанных с безопасностью ИИ.

Тем не менее, до сих пор опасения по поводу безопасности ИИ остаются чисто теоретическими. Ни один реальный инцидент, связанный с безопасностью ИИ, никогда не происходил в реальном мире (по крайней мере, ни один из них не был публично зарегистрирован). 2025 год станет годом, когда это изменится.

Что следует ожидать от этого первого инцидента, связанного с безопасностью ИИ?

Возможно, модель ИИ попытается тайно создать копии самой себя на другом сервере, чтобы сохраниться (это известно как самоэксфильтрация). Возможно, модель ИИ придет к выводу, что для достижения своих целей ей нужно скрыть истинный масштаб своих возможностей от людей, намеренно занижая оценки производительности, чтобы избежать более строгого контроля.

Эти примеры не являются надуманными. Apollo Research опубликовала важные эксперименты ранее, демонстрирующие, что при определенных подсказках современные передовые модели способны на такие обманчивые действия. Аналогично, недавние исследования Anthropic показали, что большие языковые модели (LLM) обладают тревожной способностью «имитировать согласованность».

Ожидается, что этот первый инцидент, связанный с безопасностью ИИ, будет обнаружен и нейтрализован до того, как будет причинен реальный вред. Но это будет поворотный момент для сообщества ИИ и для общества в целом.

Это прояснит одну вещь: задолго до того, как человечество столкнется с экзистенциальной угрозой со стороны всемогущего ИИ, нам придется смириться с более приземленной реальностью, что мы теперь делим наш мир с другой формой интеллекта, который может быть упрямым, непредсказуемым и обманчивым — как и мы сами.

*Экстремистская организация, деятельность которой на территории Российской Федерации запрещена

Автор: technokratiya