Франсуа Шолле, создатель фреймворка Keras и основатель ARC Prize Foundation, поделился итогами тестов новой модели o3 от OpenAI в тестах бенчмарка ARC-AGI-Pub. Эта модель достигла впечатляющего результата — 75,7% на полу-приватном наборе оценки при соблюдении установленного публичного лимита вычислительных ресурсов в $10 тысяч. Конфигурация o3 с увеличенным уровнем вычислений (172-кратное увеличение) показала результат 87,5%.

Этот результат представляет собой неожиданный и значительный скачок в возможностях искусственного интеллекта, демонстрируя способность к адаптации к новым задачам, ранее невиданную в моделях семейства GPT. Для сравнения, ARC-AGI-1 потребовал 4 года, чтобы повысить результат с 0% у GPT-3 в 2020 году до 5% у GPT-4o в 2024 году. Все представления о возможностях ИИ требуют пересмотра подхода к бенчмаркам ARC в свете достижений o3.

Что за ARC Prize

ARC-AGI — это набор тестов и задач, разработанных для оценки способности искусственного интеллекта к обобщению и адаптации к новым, ранее неизвестным задачам. В отличие от традиционных тестов, которые проверяют конкретные навыки или знания модели, ARC-AGI фокусируется на проверке общего интеллекта ИИ, то есть его способности мыслить гибко и решать разнообразные проблемы, как это делает человек.

Основные характеристики ARC-AGI:

-

Разнообразие задач: Набор включает задачи, которые легко решаются людьми, но представляют значительную сложность для современных ИИ-моделей. Это помогает выявить, насколько хорошо ИИ может применять свои знания в новых контекстах.

-

Оценка адаптивности: Тесты предназначены для проверки способности модели адаптироваться к новым ситуациям без специальной настройки или обучения на конкретных примерах этих задач.

-

Постепенное усложнение: С каждым новым поколением (например, ARC-AGI-1, ARC-AGI-2) задачи становятся более сложными и разнообразными, что стимулирует развитие более продвинутых и универсальных ИИ-систем.

ARC-AGI служит важным инструментом для измерения прогресса в направлении создания искусственного общего интеллекта (AGI) — ИИ, способного выполнять любые интеллектуальные задачи, доступные человеку. Традиционные тесты часто ограничены конкретными областями знаний или навыками, тогда как ARC-AGI стремится оценить более широкие и универсальные способности.

Результаты OpenAI o3 на ARC-AGI

Команда ARC Prize протестировали o3 на двух наборах данных ARC-AGI:

-

Полу-приватная оценка: 100 приватных задач для оценки переобучения

-

Публичная оценка: 400 публичных задач

По указанию OpenAI они тестировали модель на двух уровнях вычислительных ресурсов с различными размерами выборки: 6 (высокая эффективность) и 1024 (низкая эффективность, 172-кратное увеличение вычислений).

Основные Результаты

-

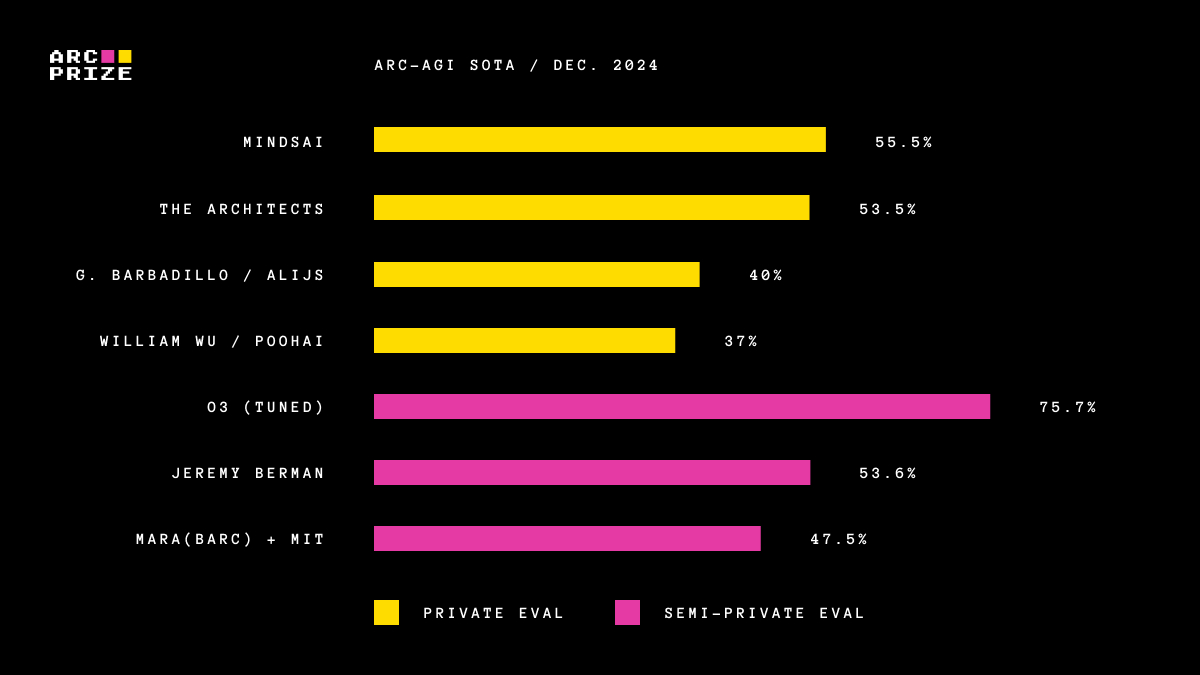

Высокая эффективность: 75,7% соответствует правилам бюджета ARC-AGI-Pub (расходы <$10k) и квалифицируется как первое место в публичной таблице лидеров!

-

Низкая эффективность: 87,5% демонстрирует улучшение производительности на новых задачах с увеличением вычислительных ресурсов, хотя и требует значительных затрат.

Примечание: Расходы на высокоэффективную конфигурацию o3 пока недоступны, так как ценообразование и доступность функций еще не определены. Объем вычислений составлял примерно 172-кратное увеличение по сравнению с низкоэффективной конфигурацией.

Примечание о "настройке": OpenAI сообщила, что обучила тестируемую версию o3 на 75% публичного набора данных для обучения. Дополнительные детали не были раскрыты. Команда еще не тестировала не обученную ARC-модель, чтобы понять, насколько производительность обусловлена данными ARC-AGI.

Анализ Производительности

Несмотря на значительные расходы на задачу, эти показатели не являются просто результатом применения грубой вычислительной силы к бенчмарку. Новая модель o3 от OpenAI представляет собой значительный скачок вперед в способности ИИ адаптироваться к новым задачам. Это не просто постепенное улучшение, а настоящий прорыв, знаменующий качественный сдвиг в возможностях ИИ по сравнению с предыдущими ограничениями LLM. o3 — модель, способная адаптироваться к задачам, с которыми ранее не сталкивалась, приближаясь к уровню человеческой производительности в области ARC-AGI.

Конечно, такая универсальность обходится дорого и пока не является экономически выгодной: можно заплатить человеку примерно $5 за решение задачи ARC-AGI, при этом затраты на энергию составят всего несколько центов. Тем временем o3 требует $17-20 за задачу в режиме низких вычислений. Однако соотношение стоимости и производительности, вероятно, значительно улучшится в ближайшие месяцы и годы, поэтому следует рассчитывать на то, что эти возможности станут конкурентоспособными с человеческой работой в довольно короткие сроки.

Архитектурные Преимущества o3

Улучшение o3 по сравнению с серией GPT доказывает, что архитектура имеет решающее значение. Невозможно просто добавить больше вычислений к GPT-4 и получить такие результаты. Простого масштабирования — сохранение аналогичной архитектуры и обучение на большем объеме данных — недостаточно. Дальнейший прогресс зависит от новых идей.

Является ли o3 AGI?

ARC-AGI служит важным бенчмарком для обнаружения таких прорывов, подчеркивая мощь обобщения, которую насыщенные или менее требовательные бенчмарки не могут выявить. Однако важно отметить, что ARC-AGI не является абсолютным тестом на AGI. Это исследовательский инструмент, предназначенный для сосредоточения внимания на самых сложных неразрешенных проблемах в области ИИ.

Решение задач бенчмарка ARC-AGI не означает достижения AGI, и, по сути, o3 все еще не является AGI. Модель не справляется с некоторыми очень простыми задачами, что указывает на фундаментальные различия с человеческим интеллектом.

Ранние данные указывают на то, что предстоящий бенчмарк ARC-AGI-2 все еще будет представлять значительную проблему для o3, возможно, снизив его результат до менее чем 30% даже при сложных вычислениях. Это демонстрирует возможность создания сложных, ненасыщенных бенчмарков без необходимости полагаться на экспертные знания. AGI будет признан достигнутым, когда создание задач, легких для обычных людей, но сложных для ИИ, станет невозможным.

Отличия o3 от Старых Моделей

Почему o3 набирает значительно больше, чем o1? И почему o1 набрал так много больше, чем GPT-4o изначально? Эта серия результатов предоставляет бесценные данные для поиска AGI.

LLM работают как хранилище векторных программ. При получении запроса они извлекают программу, соответствующую запросу пользователя, и "исполняют" ее на входных данных. LLM — это способ хранения и эксплуатации миллионов полезных мини-программ через пассивное погружение в контент, созданный людьми.

Этот парадигма "запомнить, извлечь, применить" может достигать произвольных уровней навыков в произвольных задачах при наличии соответствующих данных для обучения, но она не может адаптироваться к новизне или приобретать новые навыки на ходу. Это было продемонстрировано низкой производительностью LLM на ARC-AGI, единственном бенчмарке, специально разработанном для измерения адаптивности к новизне.

Для адаптации к новизне нужны две вещи:

-

Знание — набор повторно используемых функций или программ. У LLM их более чем достаточно.

-

Способность к синтезу — умение комбинировать эти функции в совершенно новую программу при столкновении с новой задачей.

Долгое время LLM не обладали этой функцией. Серия моделей o3 исправляет это.

Механизм Работы o3

Основной механизм o3 заключается в поиске и выполнении программ на естественном языке в пределах пространства токенов. Во время тестирования модель исследует пространство возможных Цепочек (CoTs), описывающих шаги, необходимые для решения задачи, возможно, не слишком отличаясь от метода Монте-Карло с деревьями поиска, подобного AlphaZero. В случае o3 поиск, вероятно, направляется какой-либо моделью-оценщиком.

Таким образом, в то время как однократные генерации LLM испытывают трудности с новизной, o3 преодолевает это, генерируя и исполняя собственные программы, где сама программа (CoT) становится артефактом комбинирования знаний. Хотя это не единственный возможный подход к комбинированию знаний во время тестирования, он представляет собой текущий передовой уровень согласно новым результатам ARC-AGI.

Автор: technokratiya