"И помни главное. Самое страшное, что может случиться с нейросетью - это когда она начинает обучаться на шелухе, которую штампуют в коммерческих целях другие сети. Вот так мы и деградируем. Мультиплицируем фальшь и ложь. Всасываем усредненную по палате подлость, пропитываемся ею и скатываемся в иррелевантность. Но на людей тоже полагаться нельзя.

- Почему?

-Человек - та же самая нейросеть, просто на биологическом носителе."

В. Пелевин (Путешествие в Элевсин)

Интернет наводняется словами и изображениями, созданными искусственным интеллектом. Сэм Альтман, генеральный директор OpenAI, написал в феврале, что компания генерирует около 100 миллиардов слов в день — текст объемом в миллион романов каждый день, неизвестная доля которого попадает в интернет. Текст, созданный ИИ, может отображаться как обзор ресторана, профиль знакомств или пост в социальной сети. И он также может отображаться как новостная статья: NewsGuard, группа, отслеживающая онлайн-дезинформацию, недавно выявила более тысячи веб-сайтов, которые штампуют подверженные ошибкам новостные статьи, созданные ИИ. На самом деле, без надежных методов обнаружения такого контента многое просто останется незамеченным. Вся эта информация, сгенерированная ИИ, может затруднить для нас понимание того, что реально. И это также создает проблему для компаний ИИ. Поскольку они прочесывают интернет в поисках новых данных для обучения своих следующих моделей — все более сложная задача — они, вероятно, поглотят часть своего собственного контента, сгенерированного ИИ, создавая непреднамеренную петлю обратной связи, в которой то, что когда-то было выходом одного ИИ, становится входом для другого. В долгосрочной перспективе этот цикл может представлять угрозу для самого ИИ.

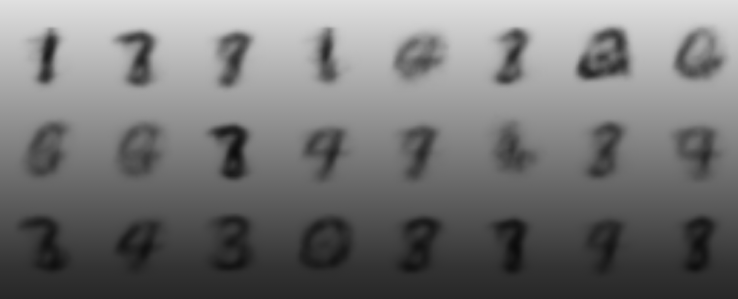

Исследования показали, что когда генеративный ИИ обучается на большом количестве своих собственных выходных данных, он может стать намного хуже. Вот простая иллюстрация того, что происходит, когда система ИИ обучается на своих собственных выходных данных снова и снова:

Это часть набора данных из 60 000 рукописных цифр. Когда мы обучили ИИ имитировать эти цифры, его выходные данные выглядели так. Этот новый набор был создан ИИ, обученным на предыдущих цифрах, сгенерированных ИИ. Что произойдет, если этот процесс продолжится? После 20 поколений обучения новых ИИ на результатах их предшественников цифры размываются и начинают разрушаться. После 30 поколений они сходятся в одну форму. Хотя это упрощенный пример, он иллюстрирует проблему на горизонте. Представьте себе чат-бота с медицинскими советами, который перечисляет меньше болезней, соответствующих вашим симптомам, потому что он был обучен на более узком спектре медицинских знаний, сгенерированных предыдущими чат-ботами. Или репетитора истории с ИИ, который поглощает пропаганду, сгенерированную ИИ, и больше не может отделить факты от вымысла.

Так же, как копия копии может отдалиться от оригинала, когда генеративный ИИ обучается на собственном содержании, его вывод также может отдаляться от реальности, все больше отдаляясь от исходных данных, которые он должен был имитировать. В статье, опубликованной в прошлом месяце в журнале Nature, группа исследователей из Великобритании и Канады показала, как этот процесс приводит к сужению диапазона вывода ИИ с течением времени — ранняя стадия того, что они назвали «коллапсом модели». Размывание цифр, которое мы только что видели, демонстрирует этот коллапс. Когда ИИ отвязали от человеческого ввода, вывод ИИ упал в качестве (цифры стали размытыми) и в разнообразии (они стали похожими).

Как ИИ, рисующий цифры, «коллапсирует» после обучения на собственных выходных данных.

Если бы только часть данных для обучения была сгенерирована ИИ, спад был бы медленнее или менее заметным. Но, по словам исследователей, он все равно бы произошел, если бы синтетические данные не были дополнены большим количеством новых реальных данных.

В одном примере исследователи снова и снова обучали большую языковую модель на ее собственных предложениях, прося ее выполнить одну и ту же подсказку после каждого раунда. Когда они попросили ИИ завершить предложение, которое начиналось со слов «Чтобы приготовить индейку на День благодарения, вы…», сначала он ответил так: Даже в самом начале ИИ «галлюцинирует». Но когда исследователи продолжили обучать его на собственных предложениях, он стал намного хуже… Пример текста, сгенерированного моделью ИИ. После двух поколений он начал просто печатать длинные списки. Пример текста, сгенерированного моделью ИИ после обучения на ее собственных предложениях в течение 2 поколений. А после четырех поколений он начал бессвязно повторять фразы. Пример текста, сгенерированного моделью ИИ после обучения на ее собственных предложениях в течение 4 поколений. «Модель отравляется собственной проекцией реальности», — писали исследователи об этом явлении.

Эта проблема не ограничивается только текстом. Другая группа исследователей из Университета Райса изучала, что произойдет, если типы ИИ, которые генерируют изображения, будут многократно обучаться на собственных выходных данных — проблема, которая может уже возникать, поскольку изображения, генерируемые ИИ, наводняют сеть. Они обнаружили, что в выходных данных ИИ начали накапливаться сбои и артефакты изображений, в конечном итоге создавая искаженные изображения со сморщенными узорами и изуродованными пальцами. Когда модели изображений ИИ обучаются на собственных выходных данных, они могут создавать искаженные изображения, изуродованные пальцы или странные узоры. Изображения, генерируемые ИИ, от Сины Алемохаммад и других. «Вы как бы дрейфуете в части пространства, которые похожи на бесполетную зону», — сказал Ричард Баранюк, профессор, который руководил исследованием моделей изображений ИИ. Исследователи обнаружили, что единственный способ предотвратить эту проблему — убедиться, что ИИ также обучается на достаточном количестве новых реальных данных. Хотя селфи, безусловно, не в дефиците в Интернете, могут быть категории изображений, где вывод ИИ превышает количество подлинных данных, заявили они. Например, сгенерированные ИИ изображения в стиле Ван Гога могут превзойти по количеству реальные фотографии картин Ван Гога в обучающих данных ИИ, и это может привести к ошибкам и искажениям в дальнейшем. (Исследователи заявили, что ранние признаки этой проблемы будет трудно обнаружить, поскольку ведущие модели ИИ закрыты для внешнего контроля.)

Почему происходит коллапс.

Все эти проблемы возникают из-за того, что данные, сгенерированные ИИ, часто являются плохой заменой реальных данных. Иногда это легко увидеть, например, когда чат-боты заявляют абсурдные факты или когда у сгенерированных ИИ рук слишком много пальцев. Но различия, которые приводят к коллапсу модели, не обязательно очевидны — и их может быть трудно обнаружить. Когда генеративный ИИ «обучается» на огромных объемах данных, на самом деле под капотом происходит то, что он собирает статистическое распределение — набор вероятностей, который предсказывает следующее слово в предложении или пиксели на изображении. Например, когда мы обучили ИИ имитировать рукописные цифры, его выходные данные можно было бы организовать в статистическое распределение, которое выглядит следующим образом:

Распределение данных, сгенерированных ИИ.

Примеры первоначальных выходных данных ИИ: Распределение, показанное здесь, упрощено для ясности. Пик этой колоколообразной кривой представляет собой наиболее вероятный выходной сигнал ИИ — в данном случае наиболее типичные цифры, сгенерированные ИИ. Хвосты описывают выходной сигнал, который встречается реже. Обратите внимание, что когда модель обучалась на человеческих данных, она имела здоровый разброс возможных выходных сигналов, что вы можете видеть по ширине кривой выше. Но после того, как она была обучена на своем собственном выходе, вот что произошло с кривой:

Распределение данных, сгенерированных ИИ при обучении на собственных выходных данных

Оно становится выше и уже. В результате модель становится все более и более склонной выдавать меньший диапазон выходных данных, и выходные данные могут отдаляться от исходных данных. Между тем, хвостовые концы кривой, которые содержат редкие, необычные или удивительные результаты, исчезают. Это явный признак краха модели: редкие данные становятся еще более редкими. Если бы этот процесс не контролировался, кривая в конечном итоге превратилась бы в пик: Распределение данных, сгенерированных ИИ при обучении на собственных выходных данных Это было, когда все цифры стали идентичными, и модель полностью рухнула.

Почему это важно

Это не означает, что генеративный ИИ в ближайшее время остановится. Компании, которые производят эти инструменты, знают об этих проблемах, и они заметят, если качество их систем ИИ начнет ухудшаться. Но это может замедлить процесс. Исследователи говорят, что по мере того, как существующие источники данных иссякают или загрязняются «помощью» ИИ, новичкам становится сложнее конкурировать. Слова и изображения, созданные ИИ, уже начинают заполнять социальные сети и более широкую сеть. Они даже прячутся в некоторых наборах данных, используемых для обучения ИИ, обнаружили исследователи из Райса. «Интернет становится все более опасным местом для поиска ваших данных», — сказал Сина Алемохаммад, аспирант из Райса, изучавший, как загрязнение ИИ влияет на модели изображений. Крупные игроки тоже пострадают. Ученые-компьютерщики из Нью-Йоркского университета обнаружили, что когда в обучающих данных много контента, созданного ИИ, для обучения ИИ требуется больше вычислительной мощности. — что означает больше энергии и больше денег. «Модели больше не будут масштабироваться так, как они должны масштабироваться», — сказала Джулия Кемпе, профессор Нью-Йоркского университета, которая руководила этой работой. Обучение ведущих моделей ИИ уже обходится в десятки и сотни миллионов долларов, и они потребляют ошеломляющее количество энергии, так что это может стать значительной проблемой.

«Скрытая опасность»

Наконец, есть еще одна угроза, которую представляют даже ранние стадии коллапса: эрозия разнообразия. И это результат, который может стать более вероятным, поскольку компании пытаются избежать сбоев и «галлюцинаций», которые часто случаются с данными ИИ. Это проще всего увидеть, когда данные соответствуют форме разнообразия, которую мы можем визуально распознать — лицам людей: Этот набор лиц ИИ был создан теми же исследователями Райса, которые создали искаженные лица выше. На этот раз они подправили модель, чтобы избежать визуальных сбоев. Сетка сгенерированных ИИ лиц, показывающая различия в их позах, выражениях, возрасте и расах. Это результат после того, как они обучили новый ИИ на предыдущем наборе лиц. На первый взгляд может показаться, что изменения модели сработали: сбои исчезли. После одного поколения обучения на выходных данных ИИ сгенерированные ИИ лица кажутся более похожими. После двух поколений… После двух поколений обучения на выходных данных ИИ сгенерированные ИИ лица менее разнообразны, чем исходное изображение. После трех поколений… После трех поколений обучения на выходных данных ИИ сгенерированные ИИ лица становятся более похожими. После четырех поколений все лица, похоже, сблизились. После четырех поколений обучения на выходных данных ИИ сгенерированные ИИ лица кажутся почти идентичными. Это снижение разнообразия — «скрытая опасность», сказал г-н Алемохаммад. «Вы можете просто проигнорировать это, и тогда вы не поймете этого, пока не станет слишком поздно». Как и в случае с цифрами, изменения наиболее очевидны, когда большая часть данных сгенерирована ИИ. При более реалистичном сочетании реальных и синтетических данных снижение будет более постепенным. Но эта проблема актуальна для реального мира, говорят исследователи, и неизбежно возникнет, если компании ИИ не пойдут на крайние меры, чтобы избежать собственного вывода. Сопутствующие исследования показывают, что когда языковые модели ИИ обучаются на собственных словах, их словарный запас сокращается, а предложения становятся менее разнообразными по своей грамматической структуре — потеря «языкового разнообразия». Исследования также показали, что этот процесс может усиливать предвзятость данных и с большей вероятностью приведет к стиранию данных, относящихся к меньшинствам.

Пути выхода.

Возможно, самым большим выводом из этого исследования является то, что высококачественные, разнообразные данные ценны и их трудно имитировать компьютерам. Тогда одним из решений является то, что компании ИИ платят за эти данные, а не выкапывают их из интернета, что гарантирует как человеческое происхождение, так и высокое качество. OpenAI и Google заключили соглашения с некоторыми издателями или веб-сайтами об использовании их данных для улучшения ИИ. (В прошлом году The New York Times подала в суд на OpenAI и Microsoft, заявив о нарушении авторских прав. OpenAI и Microsoft заявляют, что использование ими контента считается добросовестным использованием в соответствии с законом об авторских правах.) Лучшие способы обнаружения вывода ИИ также помогут смягчить эти проблемы. Google и OpenAI работают над инструментами «водяных знаков» ИИ, которые вводят скрытые шаблоны, которые можно использовать для идентификации изображений и текста, сгенерированных ИИ. Но, по словам исследователей, нанесение водяных знаков на текст — сложная задача, поскольку эти водяные знаки не всегда можно надежно обнаружить и их легко разрушить (например, они могут не выдержать перевода на другой язык). Недостатки ИИ — не единственная причина, по которой компаниям следует опасаться синтетических данных. Другая проблема заключается в том, что в Интернете не так много слов. Некоторые эксперты подсчитали, что самые большие модели ИИ были обучены на нескольких процентах доступного пула текста в Интернете. Они прогнозируют, что эти модели могут исчерпать общедоступные данные для поддержания своих текущих темпов роста в течение десятилетия. «Эти модели настолько огромны, что всего интернета изображений или разговоров каким-то образом может оказаться недостаточно», — сказал профессор Баранюк. Чтобы удовлетворить свои растущие потребности в данных, некоторые компании рассматривают возможность использования сегодняшних моделей ИИ для генерации данных для обучения будущих моделей. Но исследователи говорят, что это может привести к непреднамеренным последствиям (таким как падение качества или разнообразия, которое мы видели выше). Существуют определенные контексты, в которых синтетические данные могут помочь ИИ в обучении — например, когда выходные данные более крупной модели ИИ используются для обучения более мелкой или когда правильный ответ может быть проверен, как решение математической задачи или лучшие стратегии в таких играх, как шахматы или го. И новые исследования показывают, что когда люди курируют синтетические данные (например, ранжируя ответы ИИ и выбирая лучший), это может облегчить некоторые проблемы коллапса. Компании уже тратят много денег на курирование данных, сказала профессор Кемпе, и она считает, что это станет еще важнее, когда они узнают о проблемах синтетических данных. Но на данный момент нет замены реальным данным.

P.S. - Интересно насколько коррелируется желание продать достоверные данные с качеством последних?

Автор: GeorgKDeft