Леопольд Ашенбреннер, бывший сотрудник OpenAI из команды Superalignment, опубликовал документ под названием «Осведомленность о ситуации: Предстоящее десятилетие», в котором он делится своим видением будущего ИИ. Основываясь на своих знаниях в этой области, Ашенбреннер предсказывает стремительное развитие искусственного интеллекта в ближайшее десятилетие.

Мы прочитали этот документ объемом в 165 страниц за вас. В этой статье расскажем о ключевых идеях Ашенбреннера и о его прогнозах на будущее искусственного интеллекта.

В статье будут использоваться следующие термины:

-

AGI (Artificial General Intelligence) — Общий Искусственный Интеллект, ИИ с разумом человеческого уровня

-

Сверхинтеллект — ИИ, ставший в разы умнее людей

-

Алгоритмический прогресс — улучшение алгоритмов машинного обучения

-

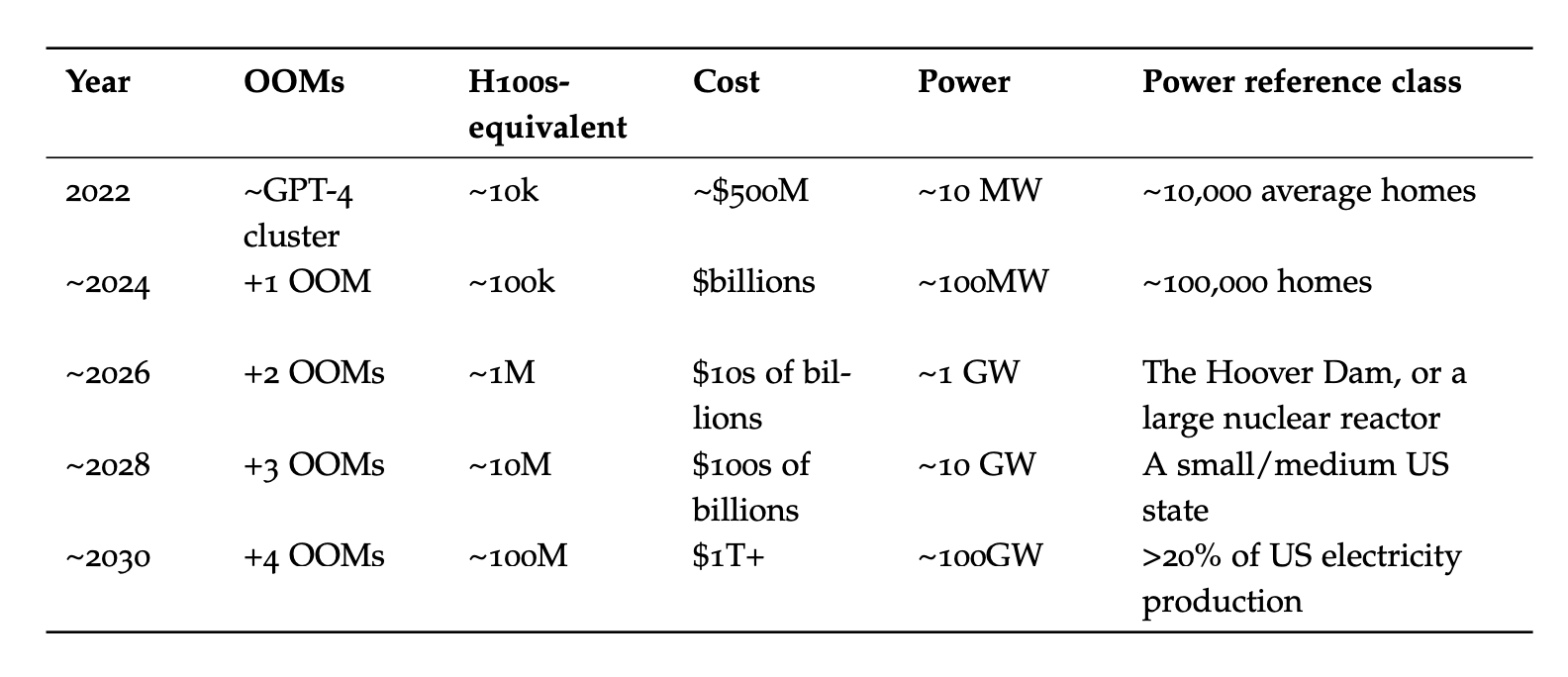

OOM (order of magnitude, порядок величины) — десятикратное увеличение, 10x

-

Капитальные затраты (CapEx) — расходы компании на приобретение или модернизацию оборудования

Вступление

По словам Ашенбреннера, американский бизнес готовится вложить триллионы долларов в развитие вычислительных мощностей, необходимых для создания машин, способных думать и рассуждать. К 2025-2026 годам эти машины, как ожидается, превзойдут по интеллекту выпускников колледжей, а к концу десятилетия станут умнее, чем любой человек. Ашенбреннер предупреждает, что этот прогресс может привести к гонке в области ИИ между США и Китаем, а в худшем случае — к полномасштабной войне.

Для начала давайте разберемся, кто такой Леопольд Ашенбреннер и чем занималась его команда.

Ашенбреннер был уволен из OpenAI ранее в этом году. По его словам, причиной увольнения стало то, что он поднимал вопросы о недостаточных мерах безопасности в компании и делился документами, которые, по мнению руководства OpenAI, содержали конфиденциальную информацию. Ашенбреннер отрицает, что в документе была конфиденциальная информация, и утверждает, что в нем лишь упоминалось о планах компании по созданию AGI (общего искусственного интеллекта) к 2027-2028 годам.

Перед увольнением Ашенбреннера юрист OpenAI расспрашивал его о взглядах на прогресс ИИ, AGI, уровень безопасности, роль правительства в регулировании AGI и его лояльность к компании. Ашенбреннер был одним из немногих сотрудников, кто не подписал письмо с призывом вернуть Сэма Альтмана на пост CEO после того, как совет директоров его уволил.

Команда Superalignment, ранее возглавляемая Ильей Суцкевером и Яном Лейке (они тоже ушли из OpenAI), занималась контролем развития AI. Их главная цель заключалась в удержании искусственного интеллекта в определенных рамках, чтобы он:

-

Соответствовал целям его создателей

-

Не действовал непредсказуемо

-

Не наносил вред человечеству

I. От GPT-4 к AGI: Подсчет OOM (Orders of Magnitude)

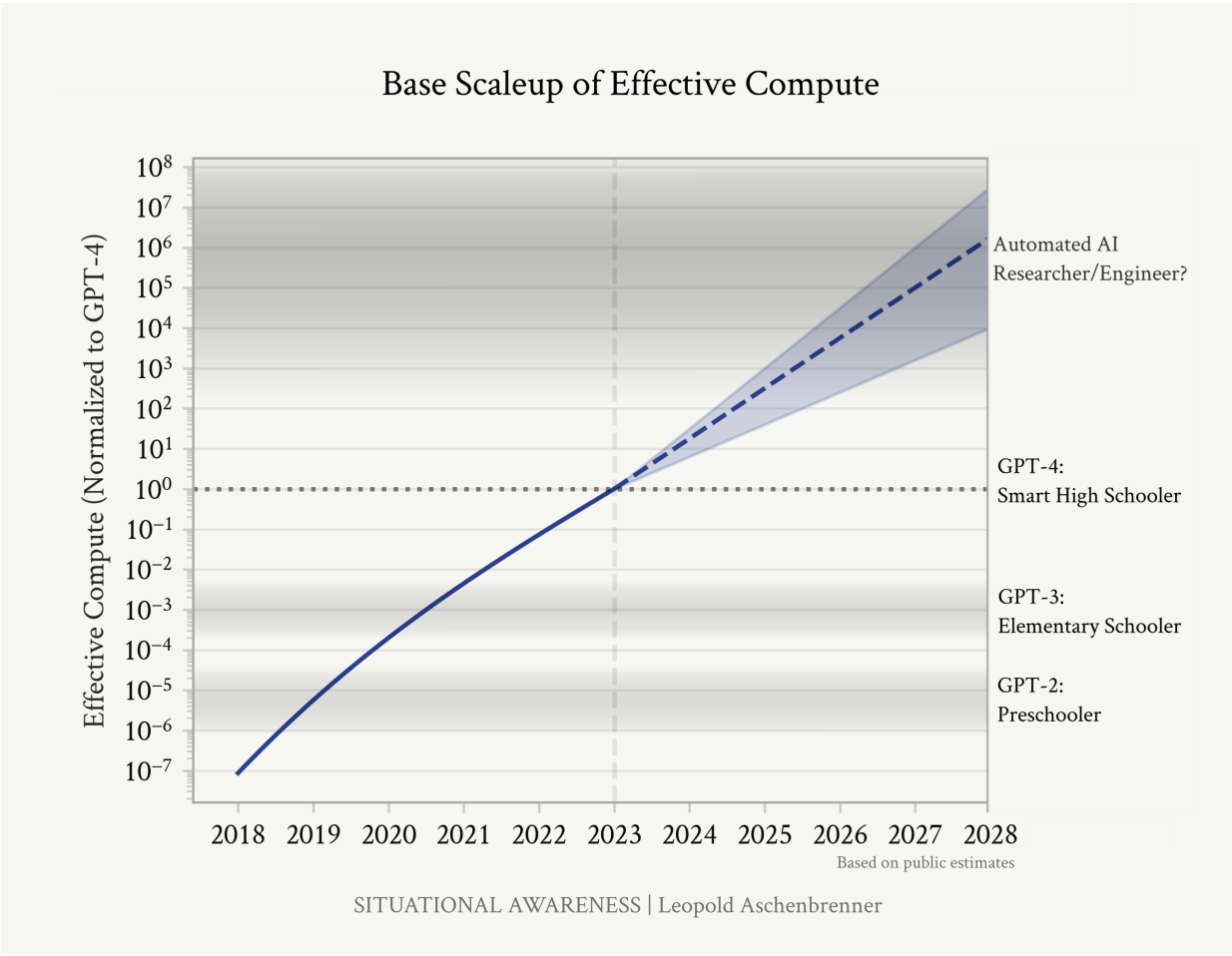

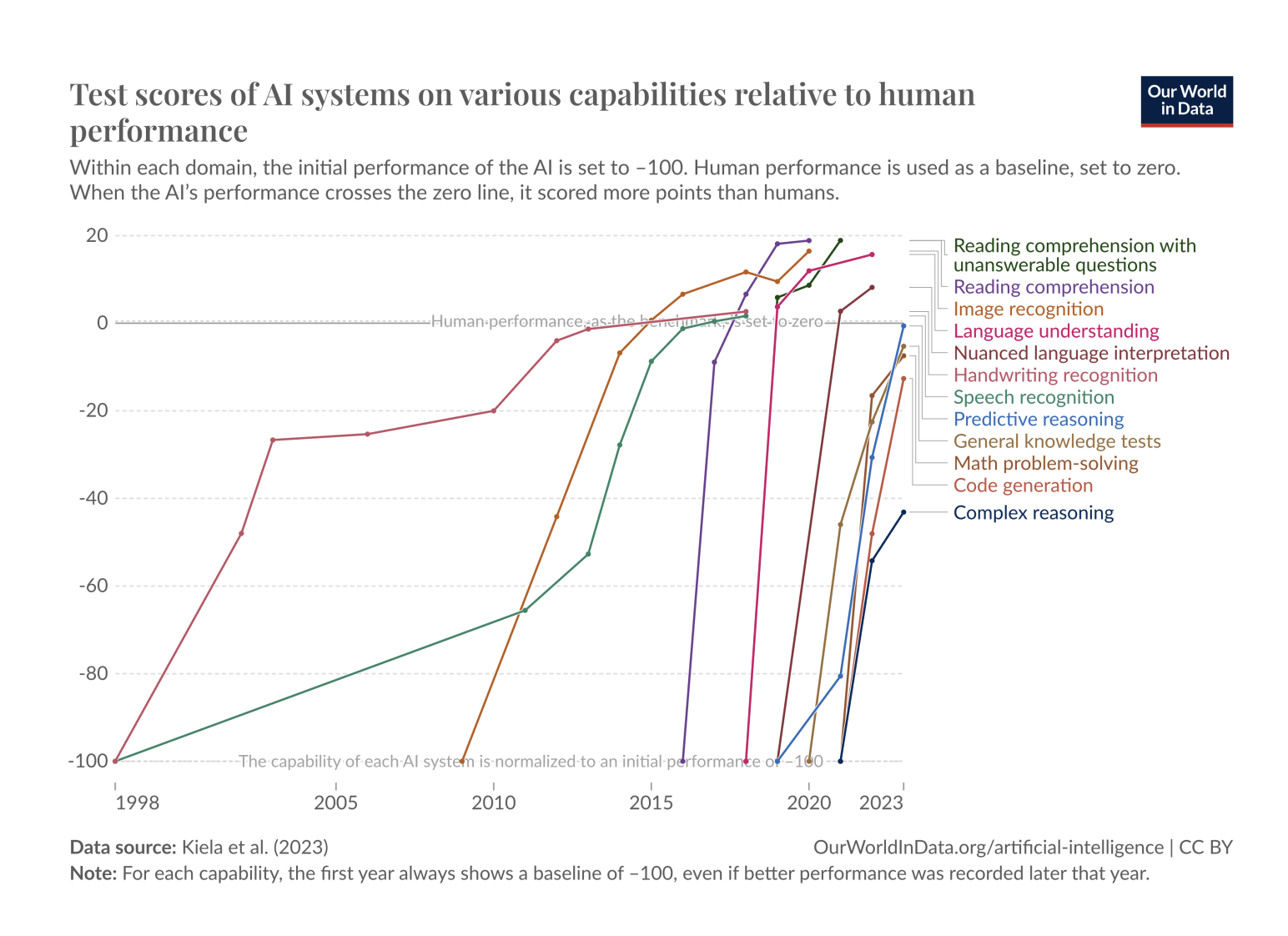

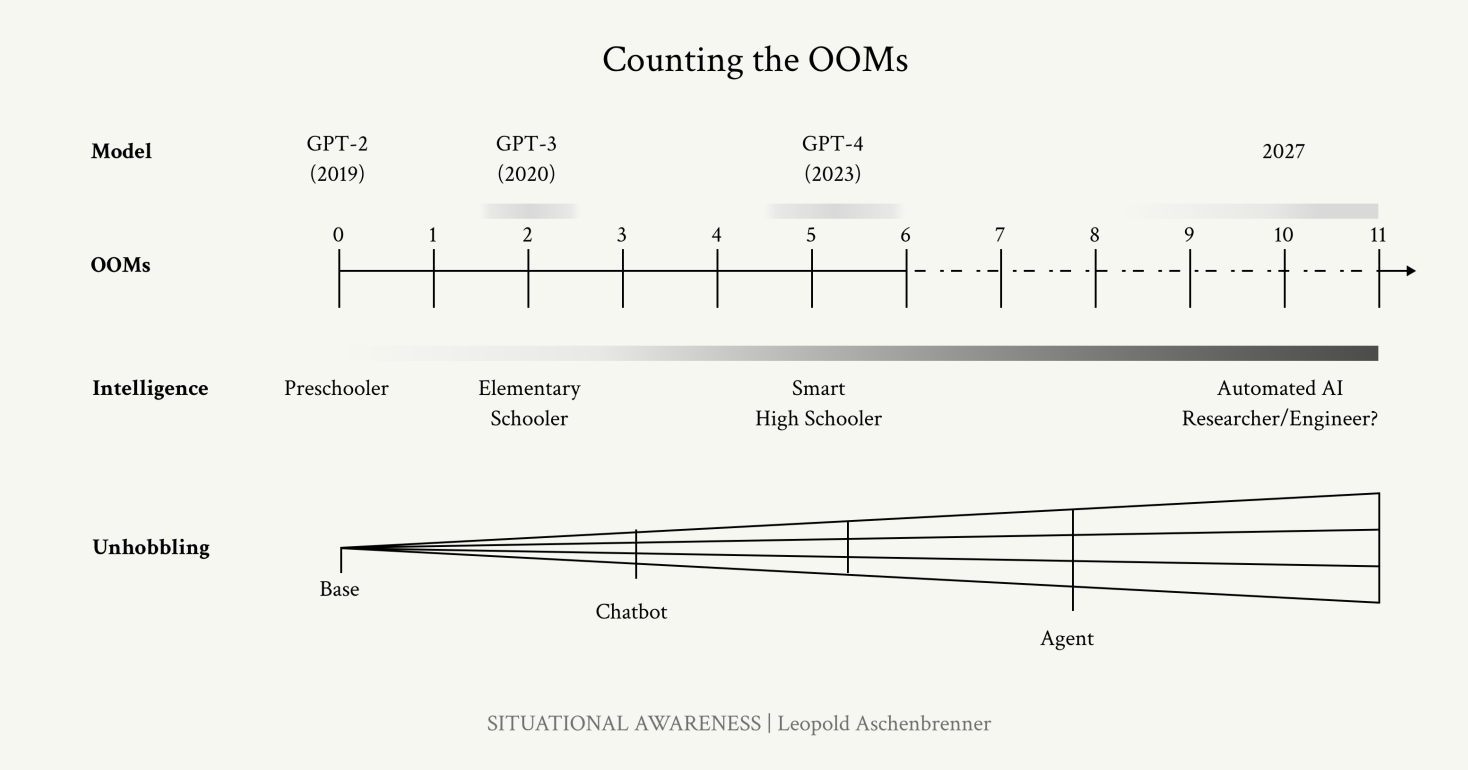

В первой главе Леопольд Ашенбреннер утверждает, что AGI (Artificial general intelligence) появится уже в 2027 году. Это будет разум, по своим возможностям сопоставимый с человеческим. Ашенбреннер приходит к этому выводу, анализируя темпы прогресса в области deep learning за последние годы:

-

С 2019 по 2023 год, от GPT-2 до GPT-4, был пройден путь от моделей с интеллектом дошкольника до моделей, сравнимых с одаренным старшеклассником. Этот гигантский скачок произошел всего за 4 года.

-

Этот прогресс обусловлен ростом вычислительных мощностей (примерно на 0.5 порядка величины в год), алгоритмическими улучшениями (еще +0.5 порядка в год) и «расковыванием» моделей — переходом от простых чатботов к более гибким агентам.

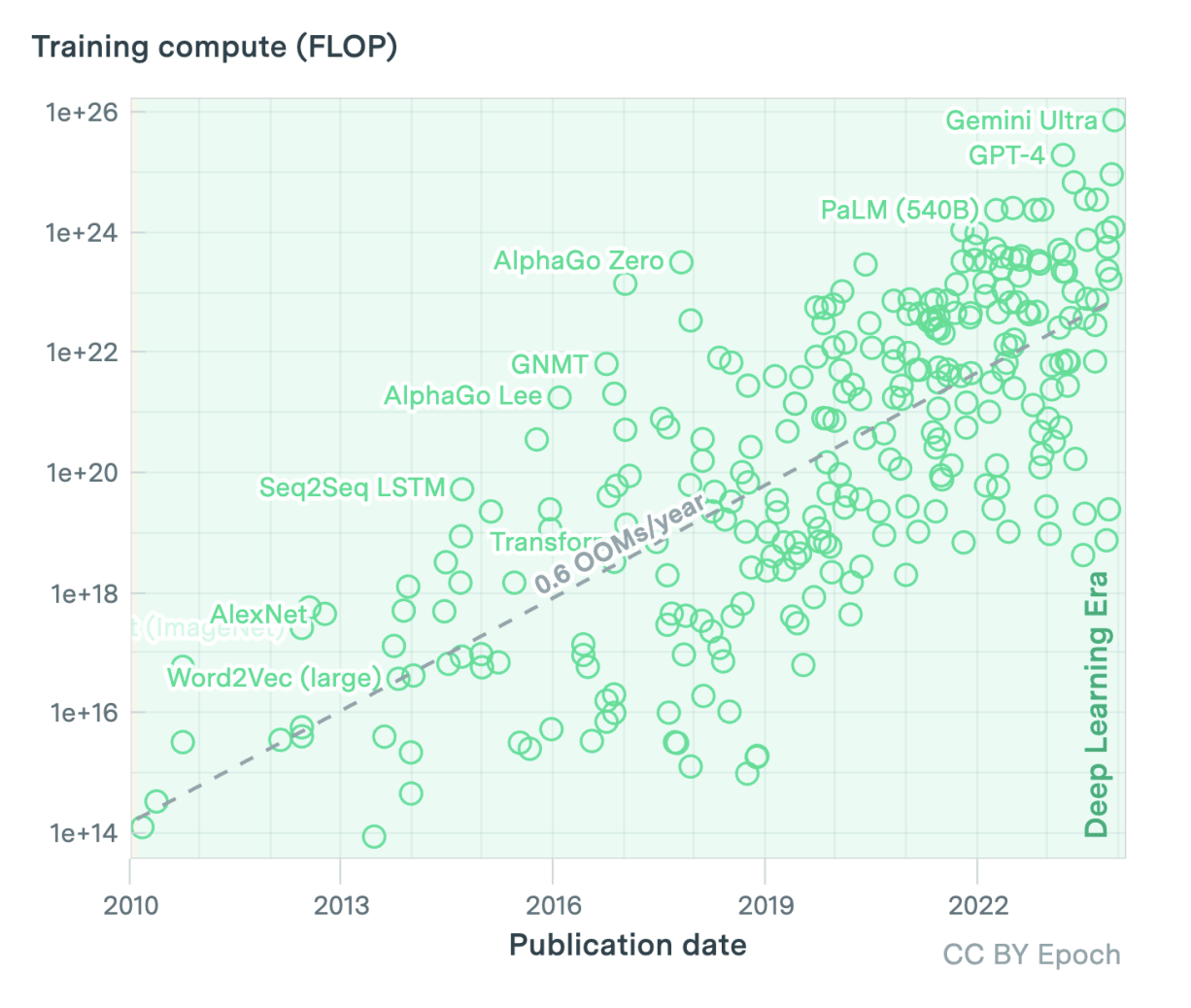

Многие люди предполагают, что рост вычислительных мощностей связан с законом Мура. (Закон Мура — это наблюдение Гордона Мура, предложенное им в 1965 году. Он предсказал, что количество транзисторов на кремниевом чипе будет удваиваться каждые два года). Но, вместо предполагаемых 1-1.5 ООМ за десятилетие, мы наблюдаем гораздо более быстрое масштабирование вычислений (почти в 5 раз быстрее, чем по закону Мура) благодаря гигантским инвестициям. Раньше, трата даже одного миллиона долларов на одну модель было возмутительной мыслью, которую никто не допускал.

Как менялись вычисления с течением времени

-

Если эти тенденции сохранятся, то в следующие 4 года, к 2027, мы должны ожидать еще одного скачка, сопоставимого с прогрессом от GPT-2 до GPT-4. Это, вероятно, приведет нас к AGI-системам, способным выполнять работу на уровне ученых, исследователей и ИИ-инженеров.

-

Ключевую роль будут играть алгоритмические прорывы и «расковывание» моделей, а не только масштабирование вычислений. В ближайшие годы модели превратятся из чатботов в гибких «агентов», сравнимых с сотрудниками-людьми.

Несмотря на то, что обычно все внимание уделяется инвестициям в технологии, алгоритмический прогресс является не менее важным драйвером прогресса.

Леопольд Ашенбреннер признает большую неопределенность в прогнозах, но считает, что AGI к 2027 году — наиболее вероятный сценарий, если экстраполировать текущие тенденции. Он предупреждает, что к этой возможности нужно отнестись предельно серьезно. Достижение уровня AGI станет лишь первым шагом на пути к интеллекту, превосходящему человеческий.

Существует проблема под названием «Стена данных». Суть проблемы заключается в том, что данные в интернете не бесконечны (сейчас ИИ-модели обучаются именно на них). Если рассматривать область программирования, то все публичные репозитории на Github оцениваются примерно в 1 миллион токенов. Вероятно, подход к обучению моделей вскоре придется менять.

Различные лаборатории уже сейчас вкладывают ресурсы на поиск новых подходов и способов решить эту проблему. Исследователи пробуют множество стратегий, начиная от синтетических данных и заканчивая RL-подходами. Конечно, любые результаты исследований, которые касаются «стены данных», являются собственностью компаний и в настоящее время не публикуются.

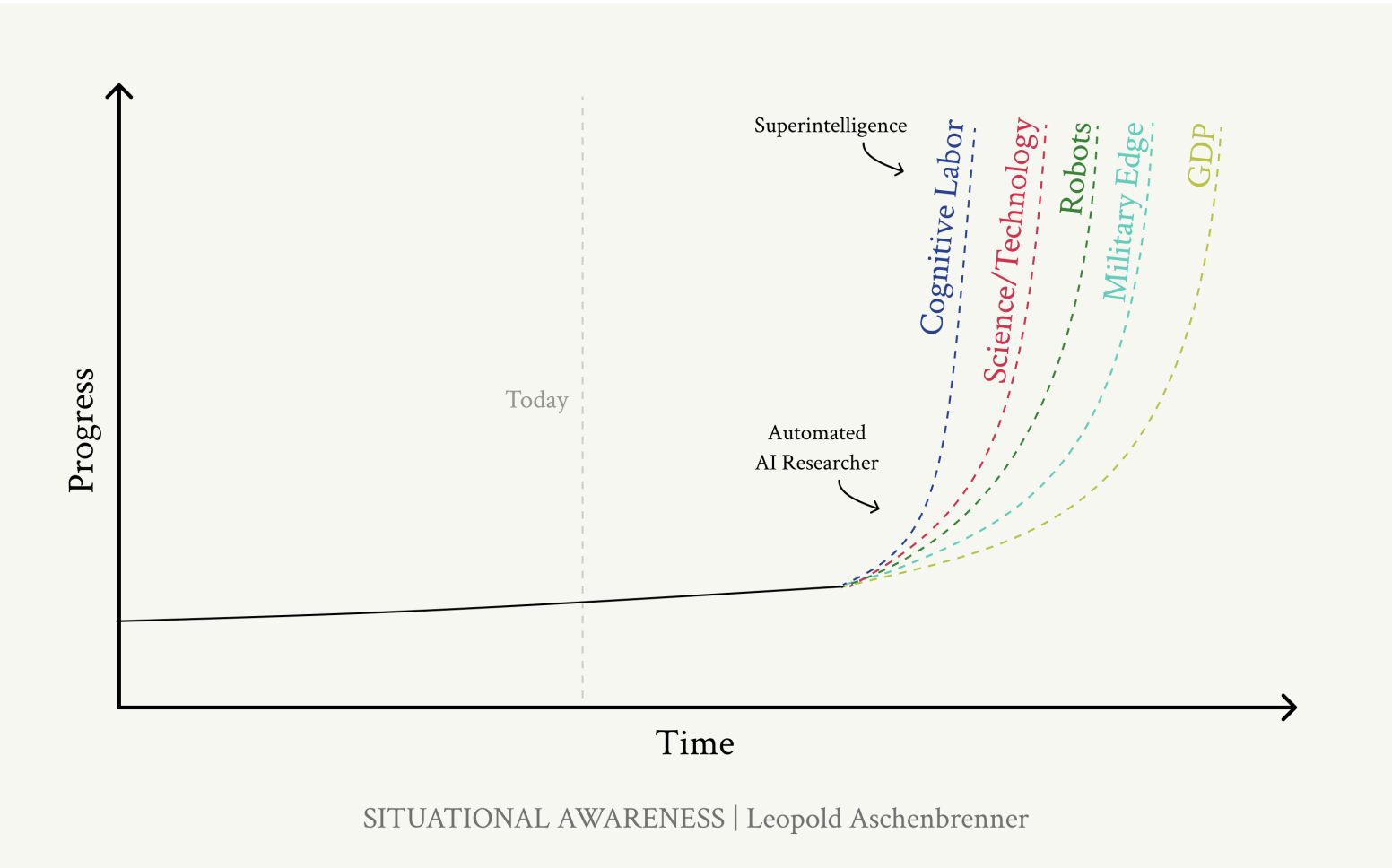

II. От AGI к Суперинтеллекту: Интеллектуальный взрыв

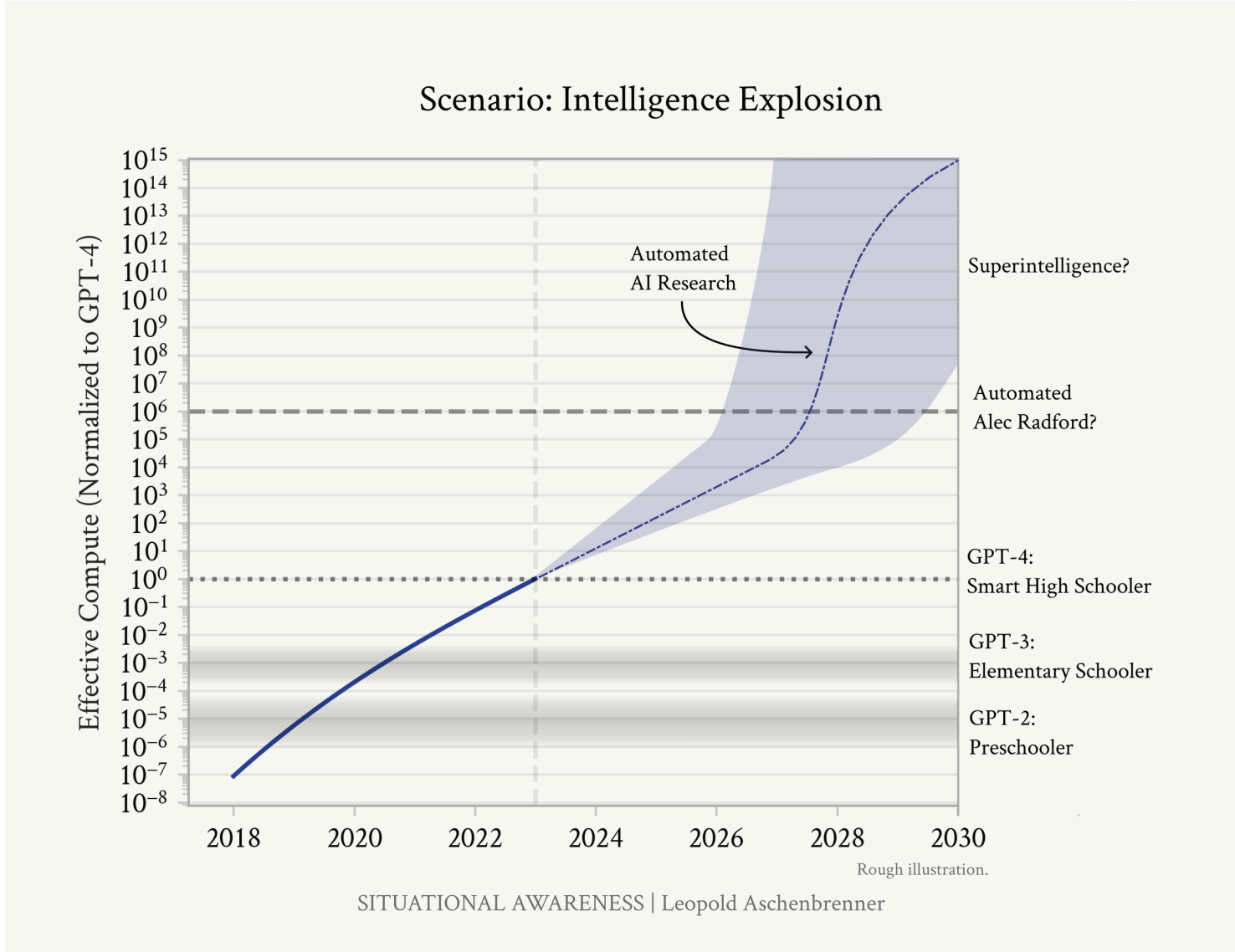

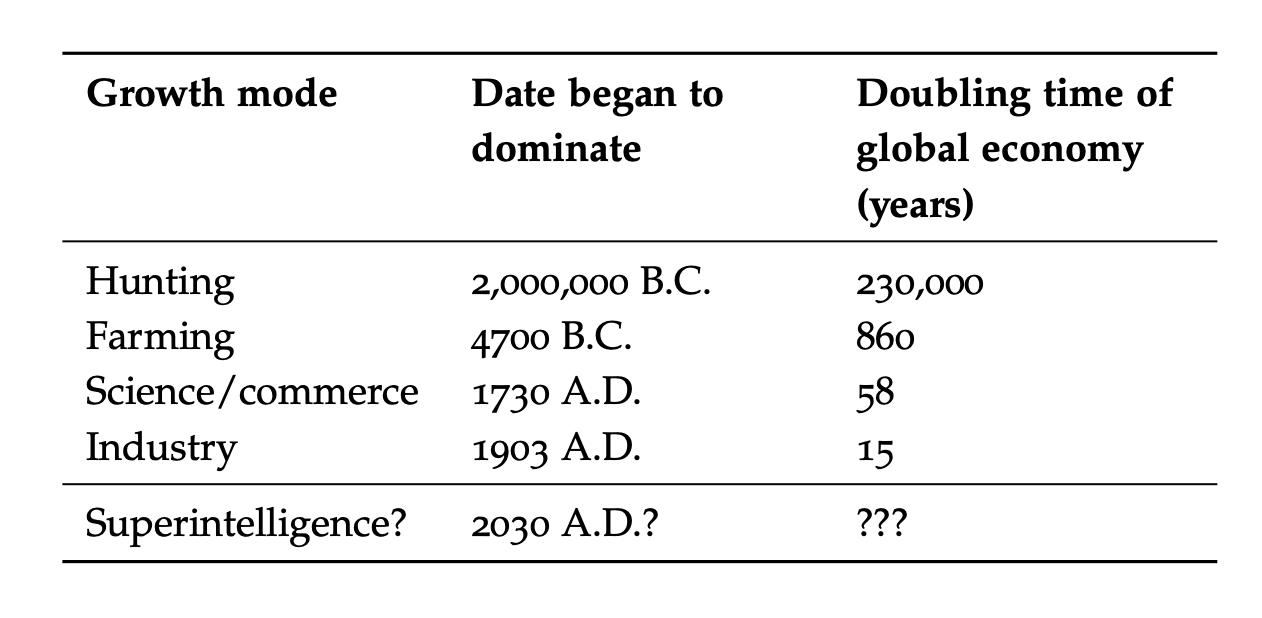

После достижения ИИ человеческого уровня (AGI), прогресс не остановится. Сотни миллионов AGI смогут автоматизировать ИИ-исследования, сжав десятилетие алгоритмического прогресса (5+ порядков величины) в 1 год. Мы быстро перейдем от человеческого уровня к ИИ-системам, намного превосходящим человека. Сила и опасность сверхинтеллекта будут огромны.

Ашенбреннер приводит аналогию атомными и водородными бомбами. Если атомная бомба является просто эффективным оружием, то водородная бомба — это устройство, способное уничтожать целые страны. Так же будет с AGI и сверхинтеллектом. Сверхинтеллект, вероятно, будет способен обеспечить военное преимущество определенным странам. Из-за этого все человечество столкнется с одним из самых напряженных и нестабильных периодов за всю нашу историю.

Благодаря автоматизации ИИ-исследований, ИИ-системы вскоре смогут работать намного быстрее, чем люди:

-

Gemini 1.5 Flash работает примерно в 10 раз быстрее GPT-4, обеспечивая производительность, аналогичную GPT-4. Это алгоритмическое ускорение, которого удалось достичь всего за год паре сотен исследователей. Что будет, когда исследованиями и обучением моделей будут заниматься не люди, а ИИ-ученые? Как быстро они смогут достичь подобного?

-

Например, у нас есть 100 миллионов ИИ-исследователей, каждый из которых работает в 100 раз быстрее человека. Каждый из них сможет выполнить годовой объем работы за несколько дней. Не представляйте здесь просто 100 миллионов младших стажеров-программистов (мы получим уже в ближайшие пару лет). ИИ-исследователи будут очень умными, смогут прочитать каждую когда-либо написанную статью по машинному обучению, глубоко обдумать каждый предыдущий эксперимент, проведенный в лаборатории, учиться и накапливать опыт. Они смогут развить гораздо более глубокую интуицию в области машинного обучения, чем любой человек.

-

Они смогут легко написать миллионы строк сложного кода, держать весь код в контексте и тратить человеко-десятилетия (или больше) на проверку и перепроверку каждой строки кода на наличие ошибок и оптимизаций. Они будут превосходно компетентны во всех частях работы.

Идея появления сверхинтеллекта часто перекликается с давними дебатами о возможности создания ядерной цепной реакции и атомной бомбы.

Г. Уэллс предсказал появление атомной бомбы в романе 1914 года. Когда Лео Силард, американский ученый и физик, впервые задумался об идее цепной реакции в 1933 году, он не мог никого в ней убедить. Цепная реакция была всего лишь теорией.

Когда в 1938 году было открыто деление ядра, Силард снова запаниковал и стал настаивать на секретности, ведь некоторые ученые начали осознавать, что приближается момент создания атомной бомбы.

Даже Эйнштейн, который изначально не считал цепную реакцию рабочей теорией, быстро понял последствия такого открытия и был готов сделать все, чтобы эти последствия предотвратить. Но Ферми, Бор и большинство остальных учёных считали, что не стоит серьезно относиться к возможности создания бомбы. Секретность этих исследований казалась им бессмысленной и абсурдной. Идея о цепной реакции звучала слишком безумно (даже когда до создания бомбы оставалось всего 5 лет).

Ашенбреннер утверждает, что мы вскоре снова столкнемся с «цепной реакцией», даже если сейчас все это кажется спекулятивным. Ведь среди ведущих учёных в лабораториях искусственного интеллекта многие считают «интеллектуальный взрыв» неизбежным.

Они могут это предвидеть. Сверхинтеллект — возможен.

Ашенбреннер предполагает, что уже совсем скоро мы столкнемся с одним из самых напряженных и нестабильных моментов в истории человечества. Неудача может легко стать катастрофой. Он рассуждает о том, что «интеллектуальный взрыв» и временной период после появления сверхинтеллекта будет одним из самых нестабильных, напряженных и опасных периодов в истории.

IIIa. Гонка за кластером стоимостью в триллион долларов

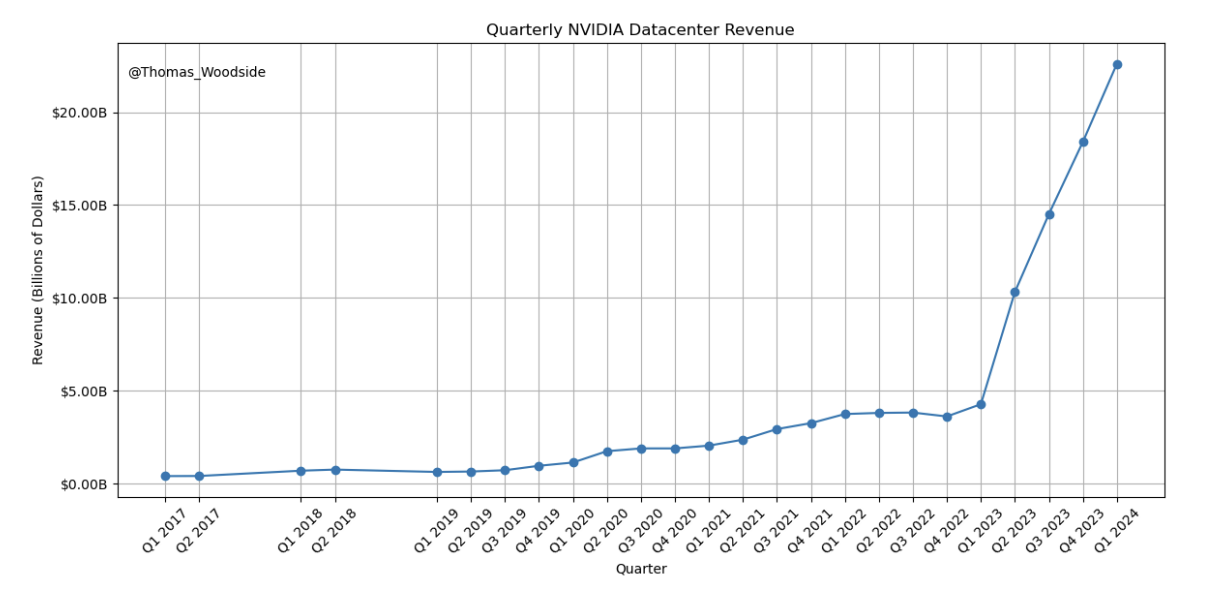

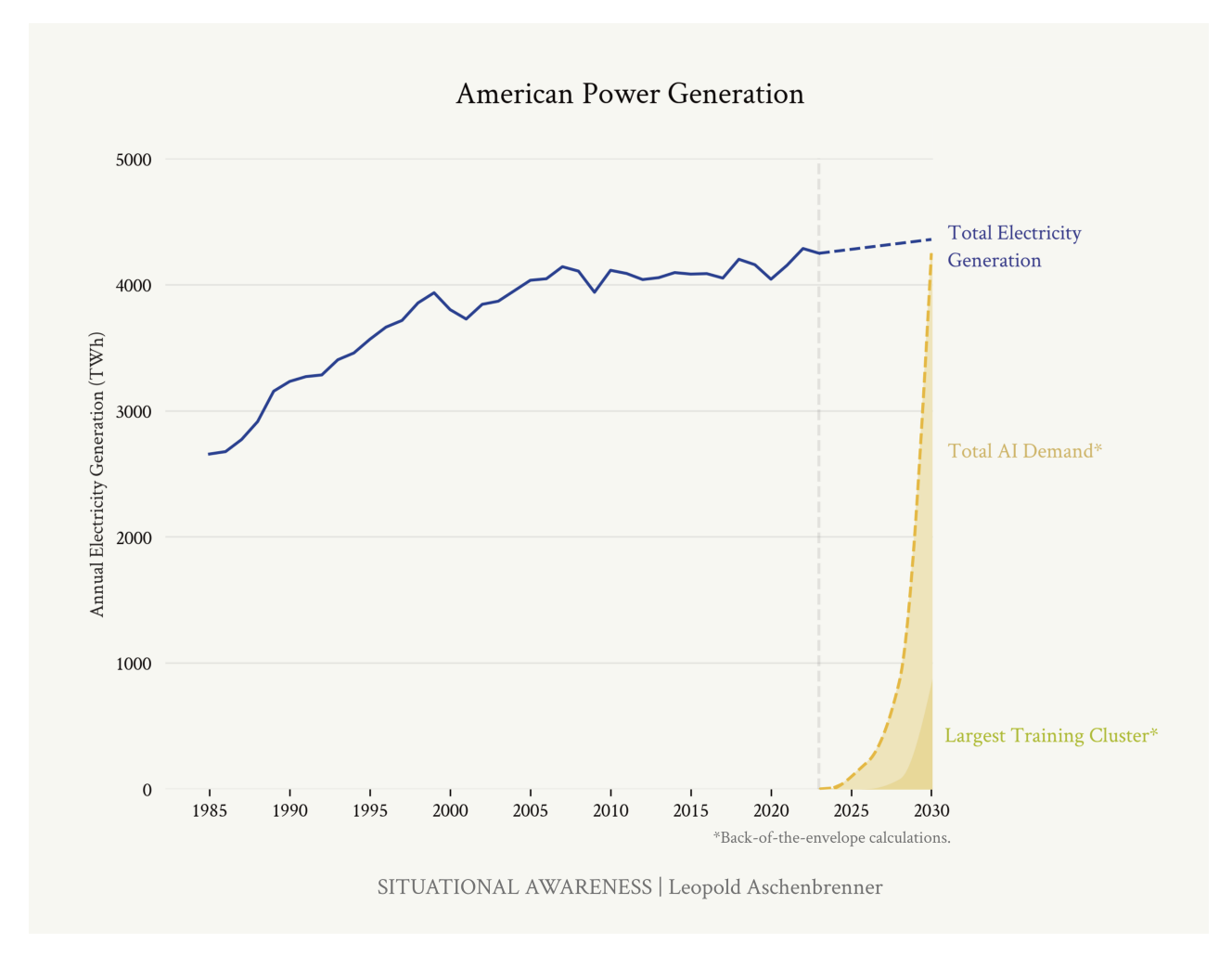

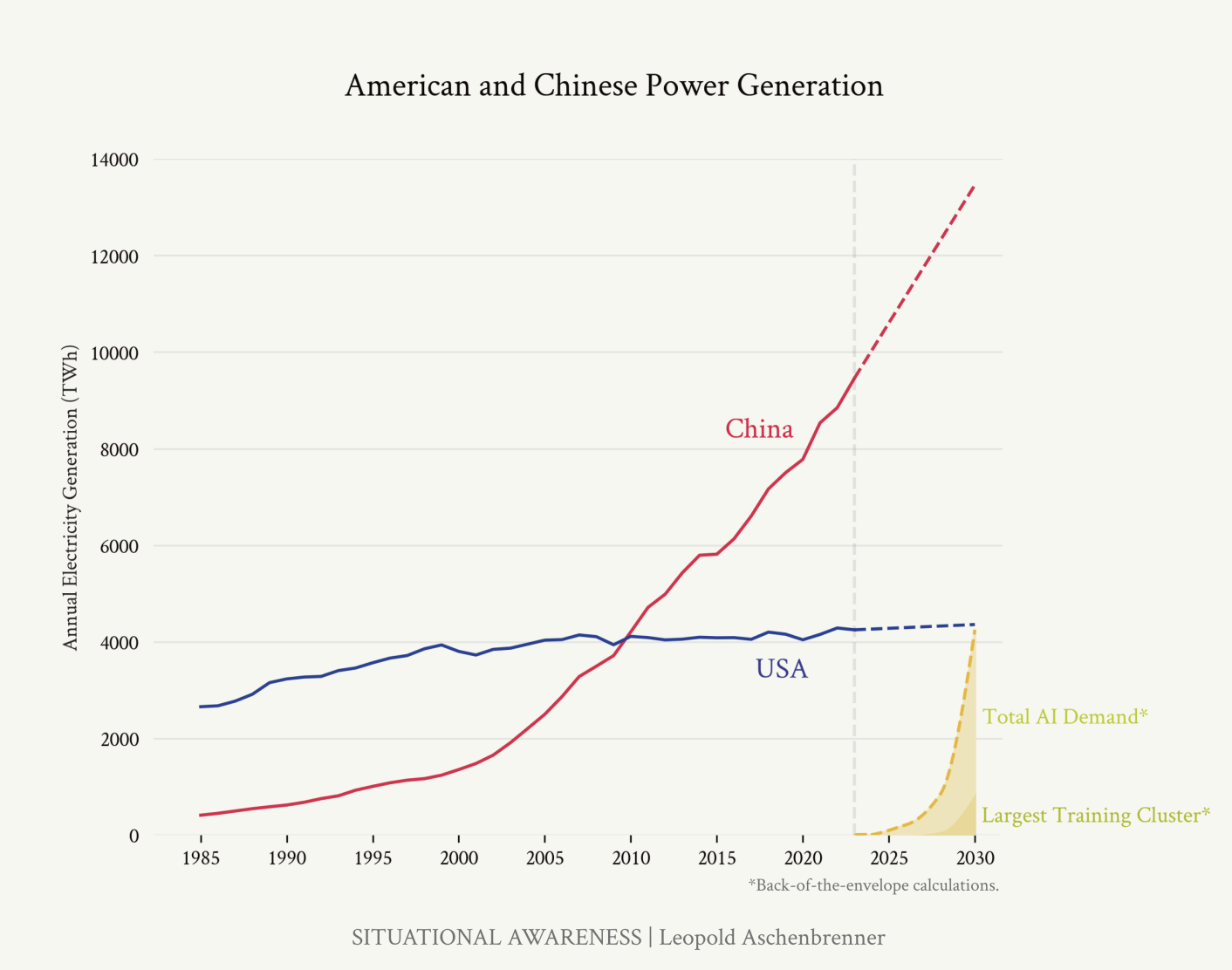

По мере роста доходов от ИИ, до конца десятилетия триллионы долларов будут вложены в создание GPU, дата-центров и электростанций. Чем активнее будет развиваться AI, тем быстрее произойдет промышленная мобилизация, в том числе увеличение производства электроэнергии на десятки, а может и на сотни процентов.

Компания Nvidia уже потрясла мир, ведь продажи центров обработки данных резко выросли с 14 миллиардов долларов в год до 90 миллиардов. Но, по словам Ашенбреннера, это только начало.

Человечество движется к созданию индивидуальных кластеров для обучения моделей стоимостью в сотни миллиардов долларов к 2028 году. Они будут требовать мощности, эквивалентной той, что требует небольшой штат США. А уже к концу десятилетия мы придем к кластерам стоимостью более чем в $1 трлн, требующим мощности более 20% от производства электроэнергии в США. Триллионы долларов пойдут на производство сотен миллионов GPU в год.

Почему Ашенбреннер делает такие выводы? Вот несколько фактов:

Цукерберг купил 350 тысяч H100. Amazon приобрел дата-центр мощностью в 1 ГВт рядом с атомной электростанцией. Ходят слухи, что в Кувейте строится кластер мощностью 1 ГВт, эквивалентный 1,4 млн H100. А Microsoft и OpenAI работают над кластером стоимостью 100 миллиардов долларов (цифра, сопоставимая с стоимостью Международной космической станции).

Но главный вопрос пока что остается без ответа — где взять 10ГВт энергии? (по грубым расчетам, именно столько энергии понадобится для кластера в 2028 году). Уже в 2030 году нужна будет мощность в 100 ГВт. Это мощность эквивалента 20% производства электроэнергии в США. Это будет уже не просто склад GPU, а сотни мощных электростанций.

Производство чипов тоже потребует кратного роста, но все же вопрос с энергией будет стоять более остро. Также остается вопрос локации. Будут ли кластеры построены в США или в странах Ближнего Востока? Национальная безопасность требует, чтобы они строились в Америке, даже если с точки зрения географии это будет менее выгодно.

IIIb. Заблокированные лаборатории: безопасность для AGI

Ведущие национальные лаборатории, которые занимаются разработкой искусственного интеллекта, считают безопасность второстепенной задачей. В настоящее время они, по сути, преподносят ключевые секреты, ведущие к созданию AGI, на блюдечке с голубой каемочкой.

При текущем курсе развития событий, ведущие китайские AGI-лаборатории будут находиться не в Пекине или Шанхае, а в Сан-Франциско и Лондоне. Через несколько лет станет ясно, что секреты разработки AGI являются самыми важными секретами национальной обороны и заслуживают такого же отношения, как чертежи бомбардировщиков и подводной лодки класса Columbia, не говоря уже о пресловутых «ядерных секретах».

Поскольку гонка AGI ускоряется, все большему числу людей становится ясно, что суперинтеллект будет иметь решающее значение в международной конкуренции. В настоящее время ИИ-лаборатории едва способны защищаться от скрипт-кидди.

Алгоритмы AGI разрабатываются прямо сейчас, но охраняются на уровне стартапа. Последствие утечки этих алгоритмов одно: преимущество США в гонке AGI будет безвозвратно утеряно.

Что требуется для должной защиты AGI:

-

Полностью изолированные дата-центры с системой безопасности как на военных базах

-

Новые достижения в области конфиденциальности вычислений и шифрования

-

Работа всех исследователей в защищенных помещениях

-

Строгая проверка персонала и мониторинг

-

Жесткий контроль внешних зависимостей

-

Постоянный интенсивный пентестинг со стороны спецслужб

Текущая готовность лабораторий ИИ:

-

Лаборатории не готовы к защите от полномасштабного промышленного шпионажа

-

Нет времени на подготовку, учитывая вероятные сроки создания AGI (несколько лет)

Необходимые шаги, которые следует предпринять:

-

Немедленное и радикальное усиление безопасности лабораторий ИИ

-

Строительство вычислительных кластеров AGI в США

-

Готовность лабораторий ИИ сотрудничать с военными

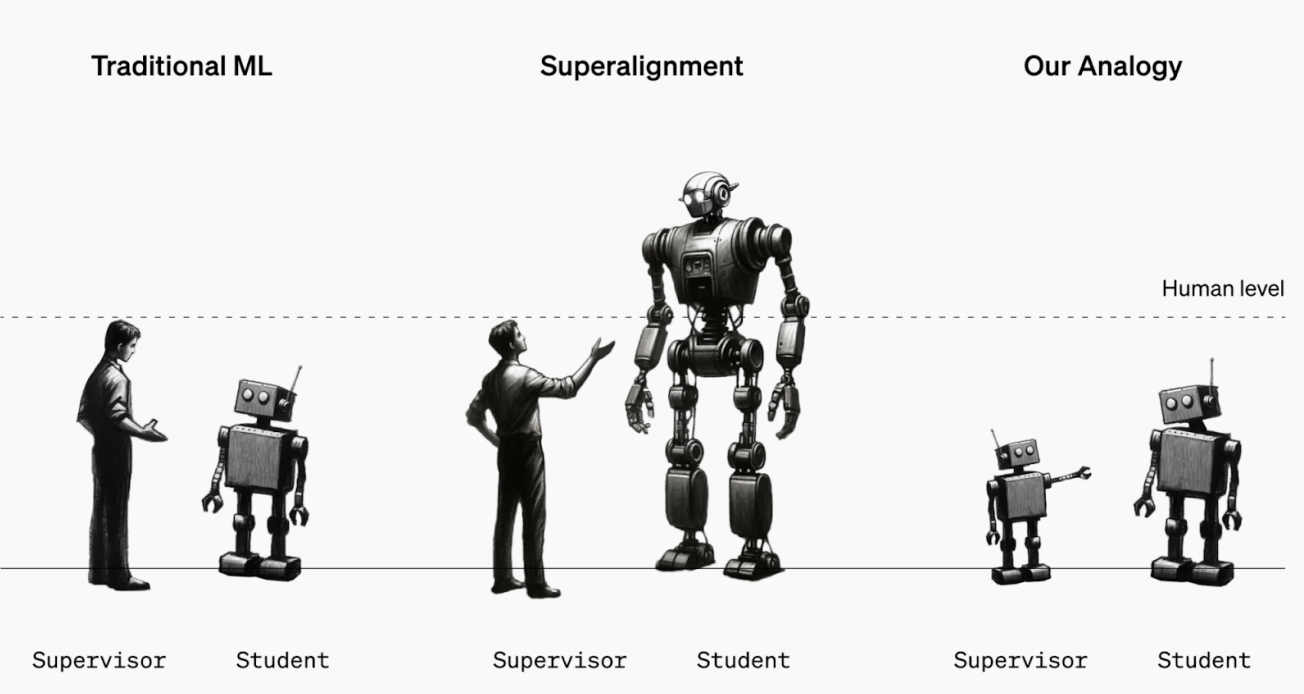

IIIc. Superalignment

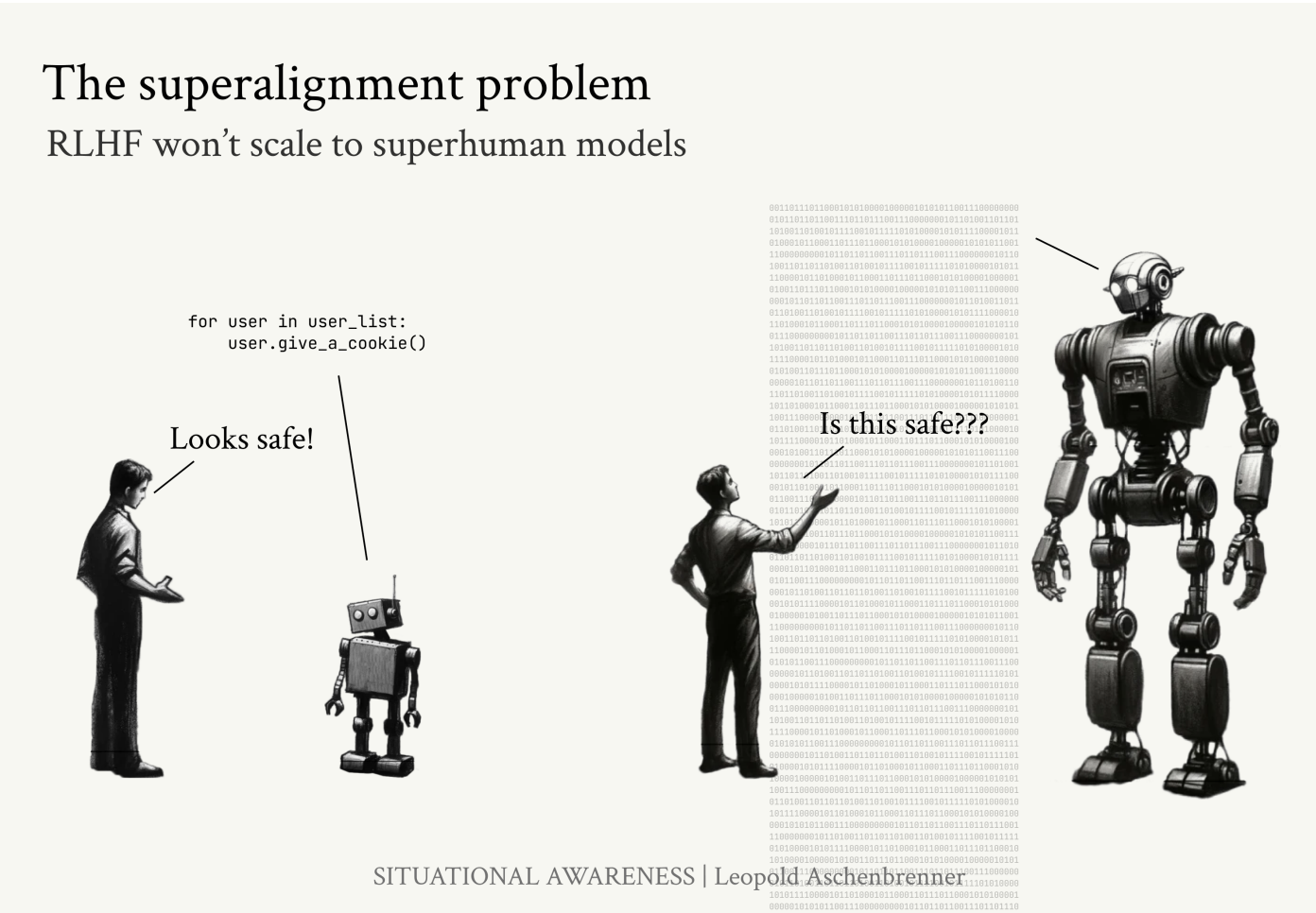

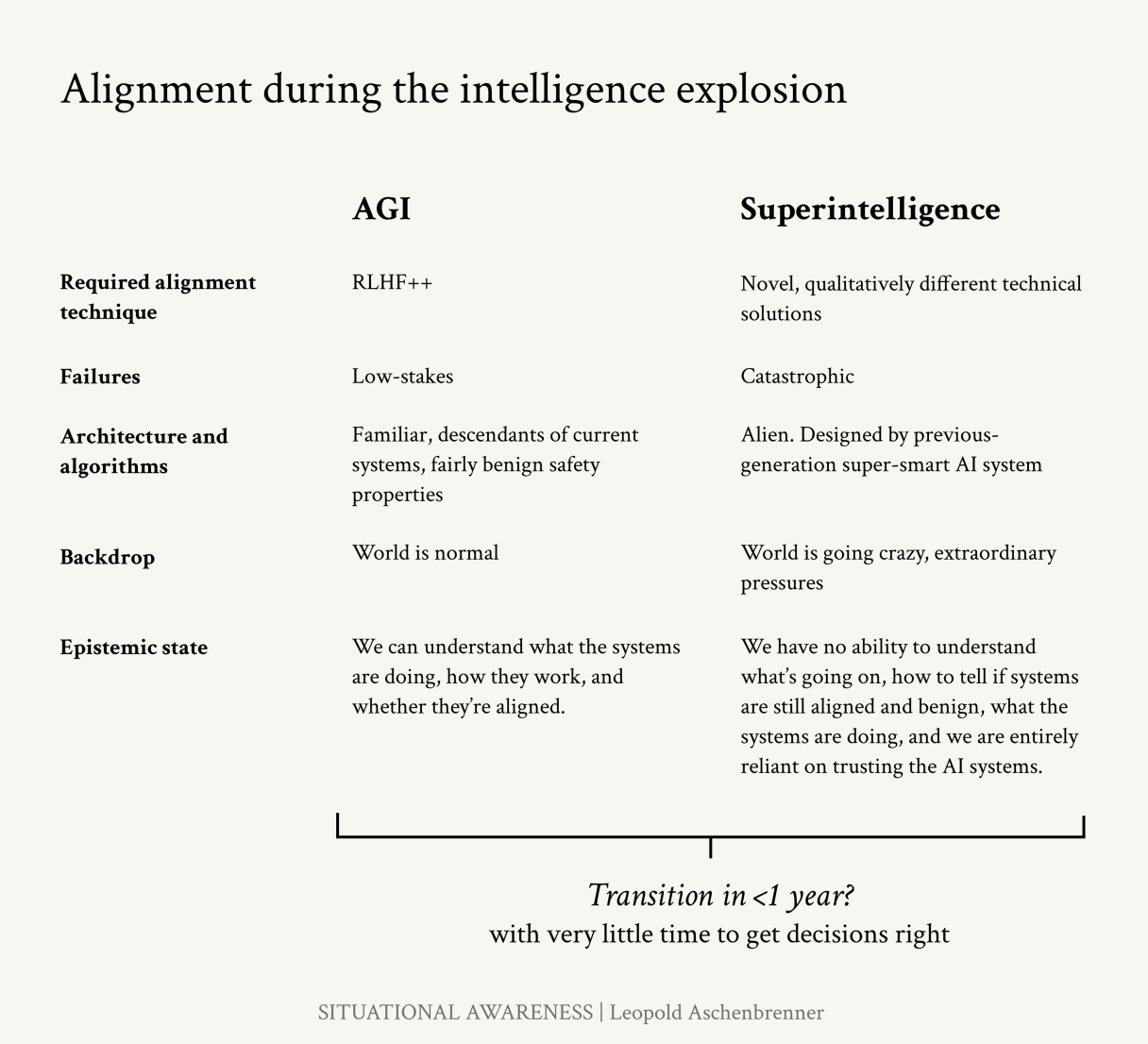

Главная проблема при создании и разработке AGI — это проблема суперсогласованности (superalignment). Как мы можем контролировать ИИ-системы, которые превосходят человека интеллектуально? Текущие методы согласованности, такие как RLHF (обучение моделей зависит от человеческой обратной связи), не будут работать для сверхчеловеческих систем.

А взрывной рост интеллекта (intelligence explosion), описанный во второй главе, делает проблему суперсогласованности чрезвычайно острой.

-

Возможно, переход от систем, где RLHF работает, к системам, где он полностью сломается, произойдет слишком быстро. Человечество к этому не готово.

-

Мы быстро перейдём от систем, в которых сбои и ошибки не имеют последствий (ChatGPT сказал плохое слово, ну и что), к чрезвычайно высоким ставкам (упс, сверхинтеллект самостоятельно вылез из нашего кластера, теперь он взламывает военные базы).

-

Получившийся в итоге суперинтеллект будет слишком разумным, вследствие чего потенциально чуждым.

-

Все это будет происходить в невероятно нестабильный и напряженный период.

Управление таким резким ростом интеллекта потребует экстраординарной компетентности. Ошибки на этом пути неизбежны, поэтому многослойные меры защиты критически важны. В целом, Ашенбреннер настроен оптимистично. Он уверен, что человечество способно решить проблему суперсогласованности. Однако, он обеспокоен рисками, которые могут возникнуть. Ключевым из них будет ответственное управление ситуацией, а для этого потребуется серьезное отношение к проблеме.

IIId. Свободный мир должен восторжествовать

Сверхразум даст военное преимущество, сравнимое с ядерным оружием. Страны, обладающие им, будут доминировать над теми, у кого его нет. Даже преимущество в несколько месяцев может быть решающим. Авторитарные режимы могут использовать сверхразум для мирового господства и тотального контроля внутри страны. История показывает опасность диктатур. Ашенбреннер говорит о том, что свободный мир должен победить авторитарные державы в этой гонке.

Здоровая конкуренция в AGI-гонке будет иметь решающее значение для безопасности не только отдельных стран, но и всего мира в целом. Это позволит обеспечить относительную стабильность, которая будет необходима для решения проблем безопасности в крайне нестабильный период появления сверхразума.

США и все остальные страны должны начать относиться к ИИ как к вопросу национальной безопасности. Чтобы избежать проблем в будущем, необходимо уже сейчас обезопасить лаборатории ИИ, строить вычислительные кластеры внутри страны и сотрудничать с разведывательным сообществом и военными.

IV. Проект и V. Прощальные мысли

Мы решили объединить завершающие главы документа в одну, так как они обе содержат в себе одну общую мысль. В этих главах Ашенбреннер рассматривает возможные сценарии, связанные с развитием искусственного интеллекта (ИИ) и достижением им сверхчеловеческого уровня — суперинтеллекта.

Он выделяет возможные препятствия для «интеллектуального взрыва»:

-

Ограниченные вычислительные мощности и их недостаток для проведения экспериментов

-

Фундаментальные ограничения, связанные с алгоритмическим прогрессом

-

Идеи становятся всё сложнее, поэтому вероятно ИИ-исследователи лишь поддержат текущий темп прогресса, а не увеличат его в разы. Однако Ашенбреннер считает, что эти препятствия могут замедлить, но не остановить рост интеллекта ИИ систем.

Ашенбреннер призывает серьезно отнестись к перспективе появления суперинтеллекта в ближайшие годы и десятилетия. Хоть это и даст человечеству огромные возможности, ошибки и просчеты могут иметь катастрофические последствия. Во всем тексте прослеживается важная мысль — необходимо обеспечить надежный контроль ИИ на каждом этапе.

Если вы хотите прочесть документ самостоятельно, его можно почитать здесь.

Также с Леопольдом Ашенбреннером вышел подкаст, который можно глянуть тут.

Автор: jstmeowme