Исследователи из IBM Research продемонстрировали успешную работу алгоритма машинного обучения без учителя, запущенного на PCM-устройствах (phase-change memory). Этот метод оказался в 200 раз быстрее и энергоэффективнее, чем традиционные вычисления по модели фон Неймана. Согласно заявлению IBM, технология подходит для создания высокоплотных массово-параллельных систем с низким энергопотреблением для использования в области ИИ.

/ Flickr / IBM Research / CC

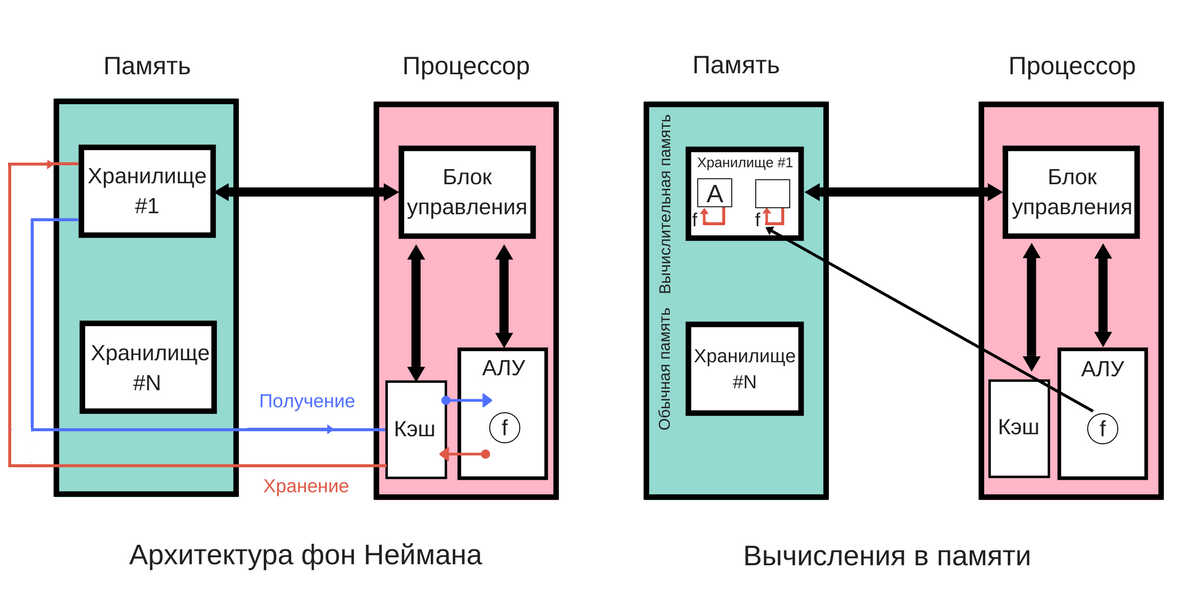

При вычислениях в памяти одно и то же устройство (память на основе фазового перехода — PCM) используется как для хранения, так и для обработки данных. Абу Себастиан (Abu Sebastian), исследователь из IBM Research, считает, что этот подход похож на то, как работает .

При традиционных вычислениях по модели фон Неймана, обработка и хранение данных происходит на разных устройствах. Постоянный перенос информации с одного устройства на другое отрицательно сказывается на скорости и энергоэффективности вычислений.

Эксперименты

В своем эксперименте команда IBM использовала миллион модулей памяти с изменением фазового состояния на основе легированного GeSbTe. Под воздействием электрического тока этот сплав изменяет строение с кристаллического на аморфное. Аморфная форма плохо проводит ток. Поэтому варьируя её объем относительно кристаллической, можно представлять состояния сложнее бинарных.

За счет этого явления удалось реализовать алгоритм машинного обучения по поиску связей между неизвестными потоками данных. Исследователи провели два эксперимента:

На имитированных данных. Имеется миллион случайных бинарных процессов, из которых составлена 2D-сетка, наложенная на черно-белое изображение Алана Тьюринга в разрешении 1000x1000 пикселей. Пиксели мигают с одинаковой частотой, но черные загораются и затухают слабо коррелированным образом.

Получается, когда «моргает» черный пиксель, повышается вероятность, что другой черный пиксель тоже мигнет. Эти процессы подключили к миллиону PCM-устройств и запустили алгоритм обучения. С каждым миганием вероятность «угадывания» повышалась. В результате система воспроизвела изображение.

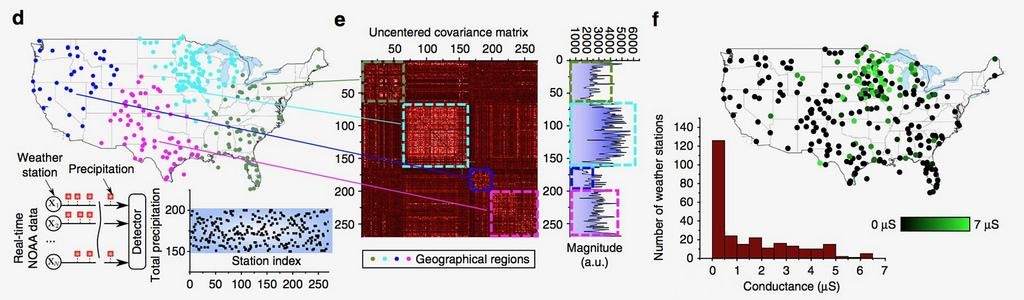

На реальных данных. Ученые взяли данные о дождях на территории США за 6 месяцев с 270 метеостанций с интервалом в 1 час. Если в течение часа шел дождь, он помечался как 1, иначе — 0. Ученые сравнили результаты своего алгоритма с результатами метода k-средних. Алгоритмы должны были установить корреляцию между данными с разных метеостанций. Результаты методов сошлись по 245 станциям из 270.

/ Flickr / IBM Research / CC

Пока это только эксперимент в лабораторных условиях, но ученые считают его очень важным. По словам Евангелоса Элефтериу (Evangelos Eleftheriou), это большой шаг в исследованиях физики ИИ, а архитектура вычислений в памяти позволит преодолеть ограничения в производительности компьютеров.

Среди недостатков решения исследователи называют возможное снижение точности вычислений. Поэтому использовать систему планируют в областях, где 100% точность не нужна. В декабре 2017 года состоится конференция IEDM, на которой IBM Research представят одно из применений вычислений в памяти.

P.S. Другие материалы из нашего корпоративного блога:

- SSD-кеширование в облаке VMware

- Как справиться с пиковыми нагрузками при помощи IaaS

- Сайзинг терминального сервера при развертывании в облаке IaaS-провайдера

Автор: ИТ-ГРАДовец