Привет! Мы, команда NLP‑исследователей из AIRI и Сбера, опубликовали недавно результаты исследования того, как языковые модели справляются с химическими задачами. Дело в том, что в последние годы интеграция методов обработки естественного языка в области химии неуклонно растёт, и это открывает новые горизонты для открытия лекарств. Однако возникает важный вопрос: действительно ли современные языковые модели научились понимать молекулы, или они просто запоминают их текстовые представления?

Чтобы выяснить это, мы создали ♡AMORE — метод, который проверяет, способны ли химические языковые модели различать одно и то же вещество в разных формах записи, например, при добавлении водородов, канонизации или изменении циклов. Мы протестировали самые популярные модели, такие как Text+Chem T5, MolT5, PubChemDeBERTa и другие, чтобы понять, насколько они устойчивы к таким изменениям.

О том, что мы обнаружили, — читайте в этой статье.

Введение

Развитие методов обработки естественного языка (Natural Language Processing, NLP) уже давно вышло за пределы одной лишь математической лингвистики. И речь в данном случае идёт даже не столько о повсеместном использовании обывателями языковых моделей (Language Models, LM) вроде GPT-4 или DeepSeek, сколько о проникновении NLP‑подходов в другие науки.

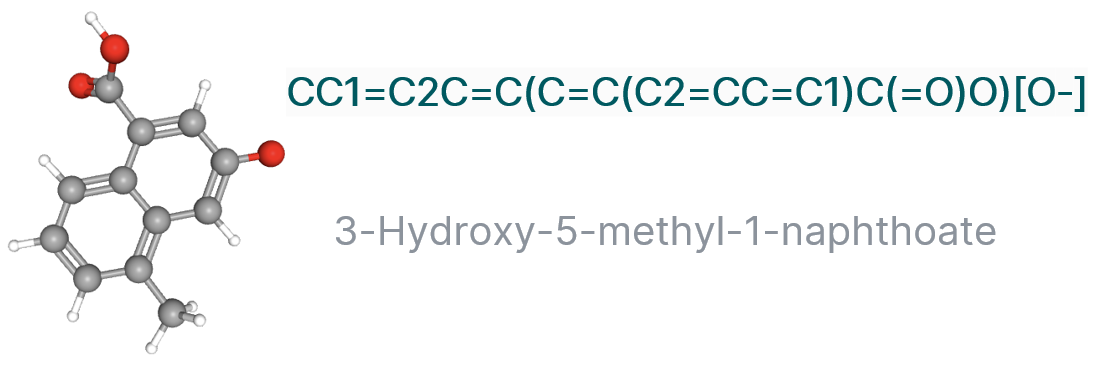

Так, интеграция химии с обработкой естественного языка значительно продвинула исследования в области поиска новых лекарств. Чтобы соединить две эти области, химические знания — формулы и структуру молекул, уравнения и тому подобное — необходимо представить в символьном виде каким‑либо образом, например, с помощью системы SMILES или просто текстового описания.

Такой текст будет содержать определённую логику, которую могут выучить языковые модели, усваивая химические законы. Подробнее про этот принцип можно прочитать, например, здесь или здесь.

Однако на этом пути всё идёт не столь гладко, как хотелось бы. Часто модели не способны различать одни и те же молекулы в разных форматах записи, например, при перестановке числовых индексов в циклических структурах. Всё это требует хороших бенчмарков, которые смогли бы тестировать модели на подобную устойчивость.

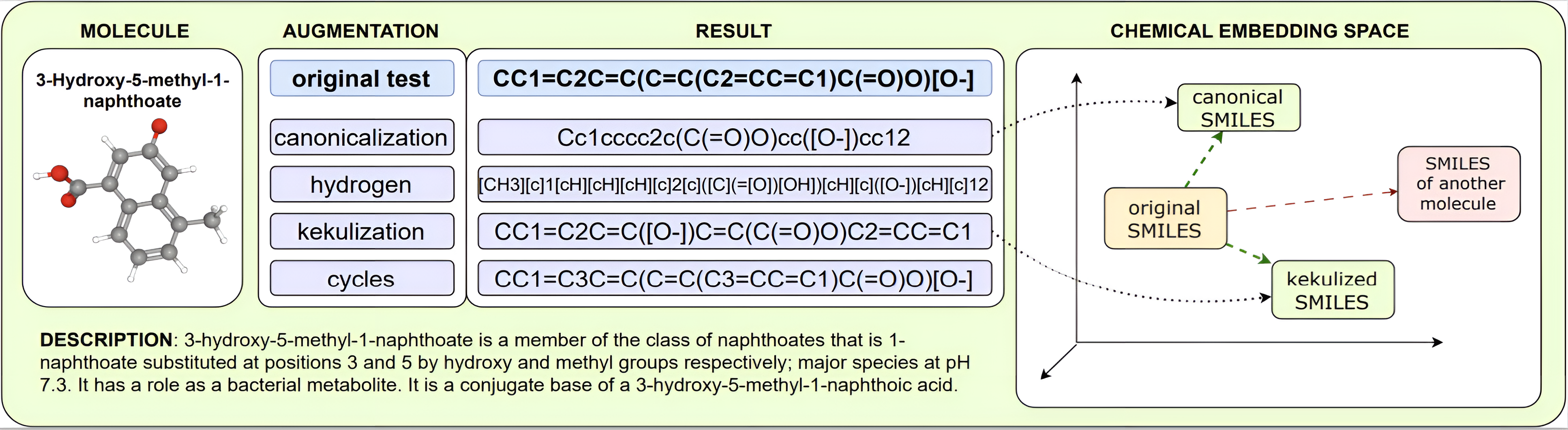

В данной работе мы представляем ♡AMORE (Augmented Molecular Retrieval) — гибкий метод оценки надёжности современных химических языковых моделей (ChemLMs), различных по своей природе: обученных исключительно на молекулах для решения химических задач и обученных на комбинированном корпусе текстовых данных и строковых структур молекул. ♡AMORE позволяет ответить на вопрос, научились ли химические языковые модели распознавать закономерности и связи внутри символьных представлений молекулярных структур во время предобучения?

Мы стремимся ответить на него, используя аугментации молекул, которые сохраняют их базовую химическую природу, например:

-

Канонизация: преобразование SMILES‑представлений в стандартный формат RDKit.

-

Добавление водорода: явное добавление атомов водорода.

-

Кекулизация: преобразование ароматических связей в явные двойные связи.

-

Перенумерация циклов: изменение числовых индексов в циклических структурах.

Эти аугментации позволяют нам проверить, насколько модель способна различать одни и те же молекулы в разных форматах записи.

♡AMORE: Основные принципы

♡AMORE — это новый метод, основанный на расстоянии между вложениями (embeddings) и аугментированными SMILES-представлениями молекул. Мы вычисляем метрику на основе схожести распределённых представлений молекул и их аугментаций.

Как работает метод?

-

Берём набор молекул

.

-

Применяем трансформацию

для создания аугментированных версий молекул

. Для каждой пары оригинальной молекулы

и её аугментированной версии

получаем их векторные представления

и

.

-

Вычисляем расстояние между этими представлениями (например, евклидовое расстояние).

-

Модель считается надёжной, если среди всех аугментированных молекул

ближайшим соседом для молекулы

является её производное

, а не любая другая аугментированная молекула

Данные и модели

Мы провели эксперименты на двух популярных наборах данных:

-

ChEBI-20: содержит около 3000 пар "молекула-описание".

-

Isomers (подмножество QM9): состоит из изомеров C9H12N2O, для которых мы нашли текстовые описания в PubChem.

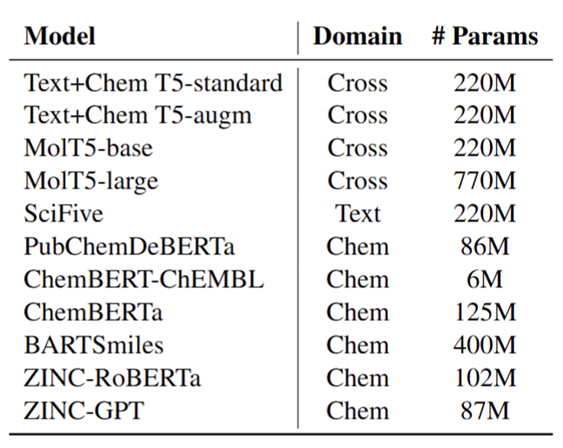

Экспериментам с нашей стороны подверглись лучшие из известных ChemLMs на базе архитектуры трансформер:

Также мы экспериментировали графовыми нейронными сетями (GNNs). Эта архитектура обрабатывает входные SMILES‑данные как графовые объекты и запускает алгоритм передачи сообщений (message‑passing algorithm) для создания узлов, вершин и полных графовых вложений.

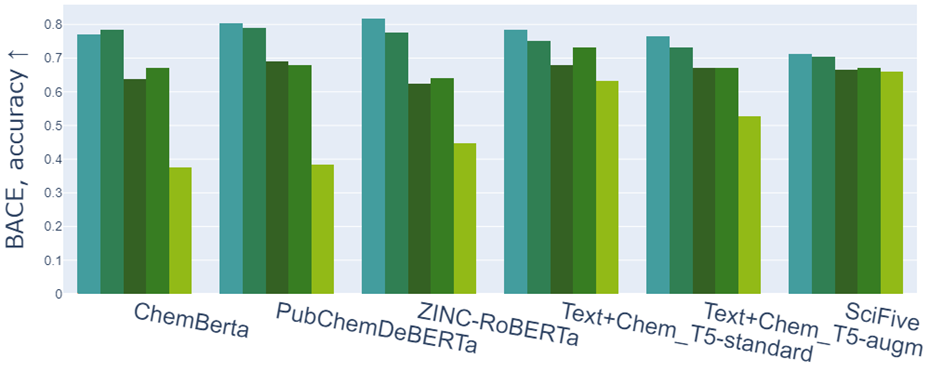

Мы сравнивали производительность моделей на основных задачах для аугментированных и неаугментированных данных. Кроме того, мы смотрели на то, как аугментации влияют на решение задачи описания молекул (molecule captioning), оценивая текст по классическими метриками текстовой генерации — ROUGE и METEOR.

Результаты экспериментов

1. Неустойчивость языковых моделей

Наши эксперименты показали, что существующие химические языковые модели неустойчивы даже к простым аугментациям SMILES‑строк, известным как идентичные преобразования молекул в химии. Например:

-

На задаче предсказания растворимости (ESOL) RMSE увеличился с 0.87 до 7.93 при добавлении водорода.

-

На задаче классификации токсичности (Tox21) точность некоторых моделей упала с 0.8 до 0.38 при добавлении водорода.

GNNs демонстрируют гораздо лучшие результаты, поскольку они работают с графовой структурой молекул, которая менее чувствительна к изменениям в записи SMILES.

2. Задача описания молекул

При использовании аугментированных SMILES‑представлений качество генерации описаний молекул значительно снижалось. Это особенно заметно при добавлении явных атомов водорода, где метрики ROUGE и METEOR падали больше всего. Например:

-

ROUGE и METEOR для Text+Chem T5-standard упали с 0.381/0.515 до 0.187/0.314 при добавлении водорода.

Мы также отметили, что модели часто полагаются на высокочастотные шаблоны из обучающих данных, вместо того чтобы глубже понимать химию.

3. Корреляция между метриками

Мы обнаружили значительную корреляцию между нашими метриками, основанными на представлениях, и классическими метриками генерации текста, такими как ROUGE и METEOR. Это подтверждает важность использования аугментаций для оценки качества химических моделей.

Выводы

Итак, мы разработали метод ♡AMORE, который проверяет, насколько языковые модели понимают молекулы, даже если их записи немного изменены. Например, если добавлены водороды или изменён порядок циклов.

Подытожим кратко ключевые моменты нашего исследования и выводы, которые мы сделали.

1. Языковые модели плохо справляются с аугментациями

Мы обнаружили, что современные языковые модели химии сильно теряют в точности, когда им дают чуть изменённые SMILES‑представления молекул. Даже такие простые изменения, как добавление явных водородов, приводят к значительному падению производительности.

2. Проблема с пониманием химии

ChemLMs запоминают конкретный формат SMILES вместо того, чтобы учиться понимать молекулы. Например, при добавлении явных водородов модель может вообще не узнать ту же самую молекулу.

3. Уровни сложности аугментаций

Самая сложная аугментация — это добавление явных водородов. Затем по сложности идут канонизация, кекулизация и перенумерация циклов. Модели лучше справляются с последними, но всё равно теряют в точности.

4. Задачи предсказания свойств молекул

При использовании аугментированных SMILES‑представлений точность предсказания свойств молекул резко снижается. Например, RMSE на задаче предсказания растворимости увеличился с 0.87 до 7.93 при добавлении водородов.

5. Генерация описаний молекул

На задаче генерации описаний молекул модели тоже показывают слабые результаты при аугментированных данных. ROUGE и METEOR упали почти вдвое, особенно при добавлении водородов.

6. Кросс-доменные модели — лучший выбор

Модели, обученные на комбинированных данных (текст + молекулы), такие как Text+Chem T5, справились лучше остальных. Они более устойчивы к изменениям в записях молекул, что подчёркивает важность использования мультимодальных подходов.

7. Этические вопросы

Использование AI в химии создаёт риски. Если модели делают ошибочные предсказания, то на практике это может привести к травмам или созданию опасных веществ. Поэтому важно тщательно проверять все результаты моделей.

Надеюсь, наше исследование поможет нашим коллегам создавать более точные языковые модели для химии. Если вас интересуют делали, их можно найти в нашей статье, которую мы представили на EMNLP 2024. Код ♡AMORE открыт и выложен на GitHub.

Автор: nika_ganeeva