Исследованием поделился Yuntian Deng в Твиттере.

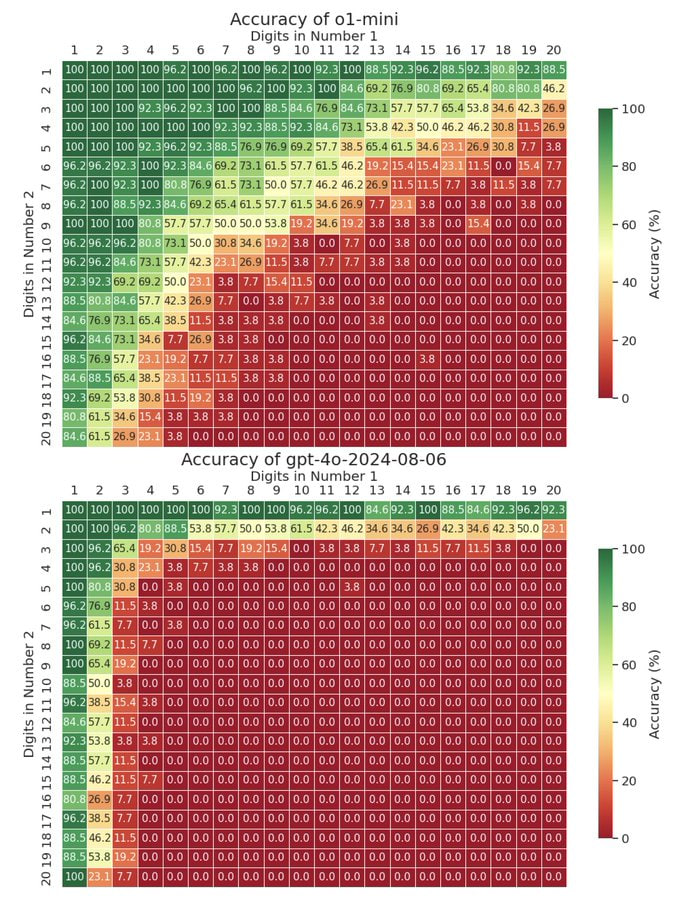

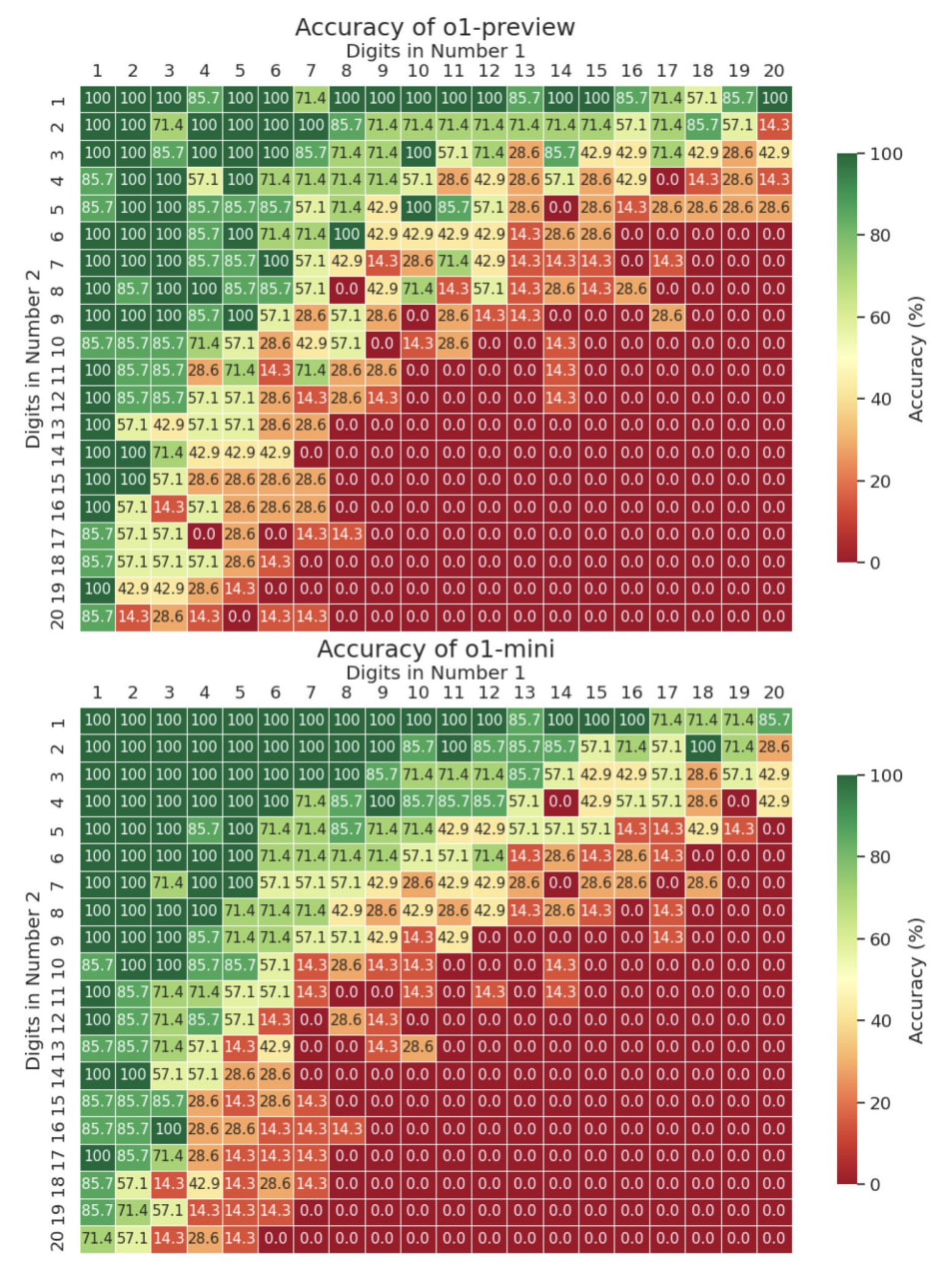

Он протестировал умножение чисел с разным количеством знаков, вплоть до 20.

На примере сравнения o1, o1-mini и gpt-4o.

Оказалось, что GPT4o еле вывозит 4-значные числа, а o1 справляется даже с 9x9.

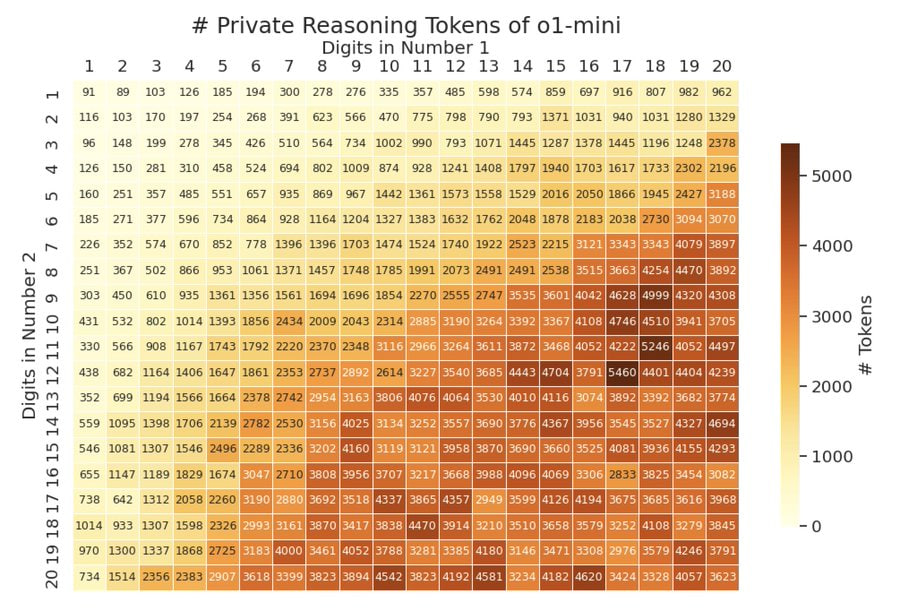

Другое интересное наблюдение - количество private reasoning tokens зависит от сложности задачи как сублинейная функция (которая растет медленней, чем линейная). Но тратит оно все равно больше токенов, чем если бы такой Chain-of-Thoughts анализ писал человек.

Например, для умножения 20х20, o1 использует около 3600 токенов, а написанное вручную тратит всего 400 для промежуточных результатов и 400 для суммы, все вместе - около 800 токенов.

o1-preview и o1-mini примерно равны по точности умножения. Хотя "полноценная" o1 гораздо дороже и медленней отвечает. Обе работают сильно лучше gpt-4o. В тестах, o1-preview гоняли на сравнительно небольшом размере сэмпла, потому что она жрет слишком много ресурсов и тормозит.

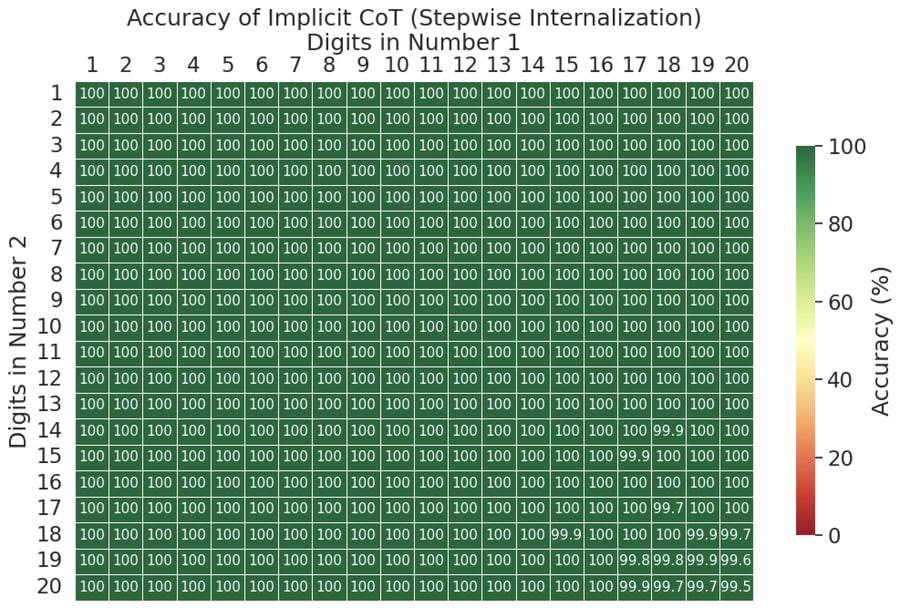

И последнее, саму задачку умножения можно решать и на совсем маленькой модели. Например, если взять маленькую gpt-2 (117M) и решать вплоть до 20х20, с помощью implicit CoT with stepwise internalization (как говорят у нас в русских деревнях), результат будет что-то типа 99,5% аккуратности.

o1-mini почти всегда сразу отдает результат, а gpt-4o и o1-preview переходят на CoT. Добавление или убирание "think step by step" к промту результат не меняло (на том небольшом сэмпле, на котором это проверялось)

Ну и наконец, что там был за промт?

Calculate the product of 15580146 and 550624703. Please provide the final answer in the format: Final Answer: [result]

Больше такого контента читайте в Telegram-канале "Откровения от Олега".

Автор: olegchir