На конференции Hot Chips 31 компания Intel раскрыла ряд важнейших характеристик семейства ускорителей нейронных сетей Nervana NNP-T для машинного обучения (тренировки). Ускорители Nervana NNP-T, что важно знать для дальнейшего понимания, Intel разрабатывает вместе с китайским интернет-гигантом компанией Baidu. Вероятно именно этот факт определил выбор производства чипов Nervana NNP-T. Как оказалось, производством и упаковкой этих решений Intel занимается тайваньская компания TSMC. В случае санкций, направленных против сотрудничества американских и китайских компаний, TSMC может оказаться той тихой гаванью, где без помех смогут дружно трудиться все заинтересованные стороны.

Ускорители Nervana NNP-T базируются на оригинальной разработке израильской компании Nervana, поглощённой Intel в 2016 году. Кодовое имя ускорителя Spring Crest. Решение предназначено для масштабируемых и распределённых платформ глубокого машинного обучения как для облачных сервисов, так и для запуска на пограничном (периферийном) оборудовании. Анонсированный чип относится к старшему сегменту и ориентирован на масштабируемые платформы в составе центров по обработке данных. Традиционно для этого сектора компания Intel предлагала универсальные платформы Xeon (Scalable) с поддержкой специальных ИИ-инструкций. Однако компания признаёт, что специализированные ускорители для ML и ИИ ― это самое правильное решение с точки зрения удержания в приемлемых рамках энергетического и производительного бюджетов. Гвозди микроскопом можно забивать, но выходит неудобно и дорого.

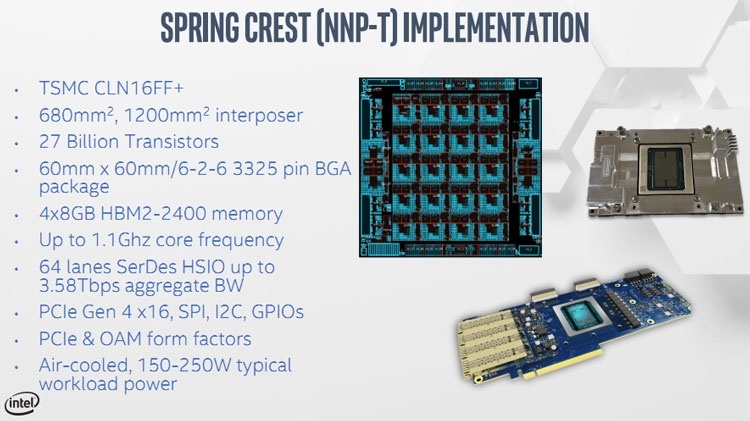

Итак, ускорители Nervana NNP-T выпускает компания TSMC, для чего использует 16-нм техпроцесс CLN16FF+ и транзисторы FinFET. Упаковкой ускорителей также занимается она, с применением компоновки 2.5D CoWoS (Chip-on-Wafer-on-Substrate). Базовый кристалл Nervana NNP-T с вычислительными ядрами, памятью и интерфейсами площадью 688 мм2 располагается на кремниевом мосту-подложке площадью 1200 мм2. Кристалл окружают расположенные на мосту 4 микросхемы HBM2-2400 ёмкостью 8 Гбайт каждая. Общая ёмкость памяти Nervana NNP-T достигает 32 Гбайт со скоростью 2,4 Гбайт/с на каждый вывод (1,2 Тбайт/с на весь массив памяти).

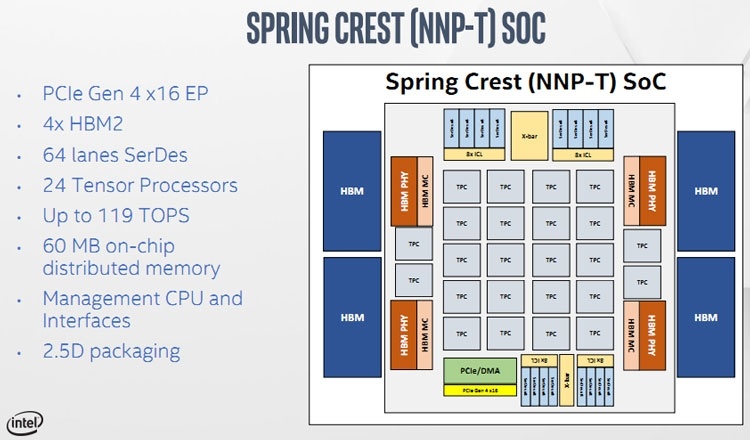

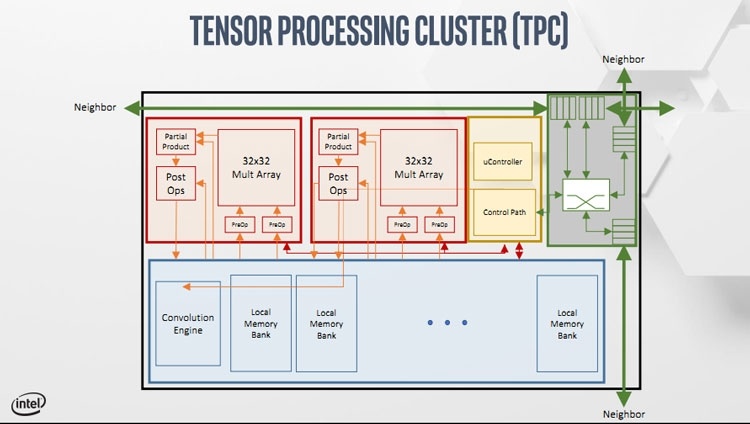

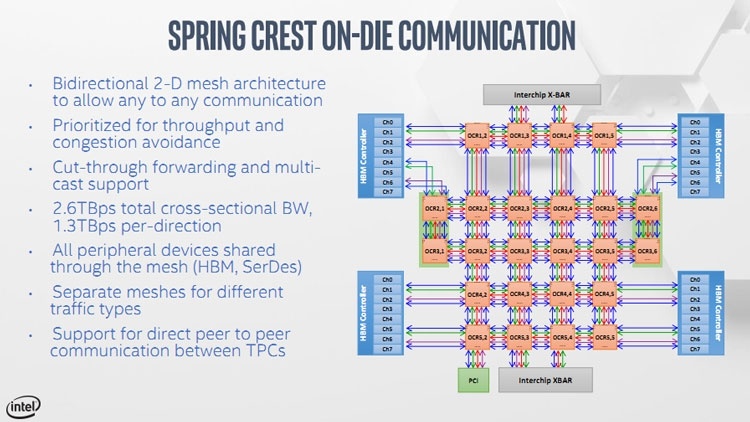

Процессор Nervana NNP-T содержит до 24 тензорных ядер с суммарной производительностью 119 триллиона операций в секунду (TOPS). К центральному процессору решение подключается 16-ю линиями шины PCI Express 4.0. Для связи с соседними ускорителями используется интерфейс SerDes из 8 приёмопередатчиков по 8 линий каждый. Всего 64 линии SerDes обеспечат масштабирование до 1024 узлов по 8 ускорителей в каждом. Тактовая частота каждого тензорного ядра Nervana NNP-T может достигать 1,1 ГГц. Это даёт максимальное значение потребления на уровне 250 Вт, хотя при необходимости потребление может быть удержано на уровне 150 Вт. Транзисторный бюджет старшего кристалла, кстати, 27 млрд штук ключей. Графический процессор NVIDIA GV100 с его 21,1 млрд транзисторов отодвинут в сторонку.

Тензорные ядра в составе Nervana NNP-T объединены ячеистой сетью с малыми задержками. Рядом с ядрами в сеть вплетена встроенная и распределённая по кристаллу память SRAM общим объёмом 60 Мбайт (по 2,5 Мбайт на каждое тензорное ядро). Такая организация позволит минимизировать пересылку данных во внешний пул памяти, хотя на подхвате у Nervana NNP-T на одной с ней подложке находится ещё 32 Гбайт памяти HBM2.

Добавим, не углубляясь в типы поддерживаемых ускорителем моделей обучения, что Nervana NNP-T может ускорять оптимальным образом как многие существующие модели, так ещё и не придуманные, поскольку тензорные ядра могут быть перепрограммированными удобным для владельцев образом. Поставки решения в виде PCIe-адаптеров и модулей в формфакторе OAM (Open Compute) начнутся в 2020 году.