В статье пойдет речь о ЦОДах одного из самых коммерчески удачных стартапов, который стремительно развивается и в сеть которого вовлечена 1/7 часть всего населения земли.

Наверное, мало кто мог подумать в 2004 году, что идея студентов из Гарварда сделать скромный сайт для общения внутри университета превратится в глобальную социальную сеть с аудиторией свыше 1 млрд человек. ИТ-инфраструктура компании также росла достаточно бурно: если в 2004 году достаточно было одного арендованного сервера, то уже через пять лет Facebook стал наиболее посещаемым сайтом, количество обращений к нему составило уже более 1 триллиона в месяц (по данным сервиса Google Double Click), а на его трафик приходилось около 9 процентов всего интернет-трафика в глобальной Сети при загрузке 300 миллионов ежедневно и с базой более 550 тысяч приложений, работающих на платформе Facebook Connect.

Чтобы поддерживать такую активности, на сегодняшний день в активе компании три действующих дата-центра и один — в процессе строительства. Дополнительно арендуются площади в девяти дата-центрах — до сих пор Facebook не может отказаться от арендованных площадей. Арендуются площади в шести дата-центрах Силиконовой долины, расположенных в Санта-Кларе (аренда 4,5 тыс. квадратных метров в ЦОД CoreSite Realty, площади Terremark Worldwide(TMRK), Equinix (EQIX)) и Сан Хосе (более 2 тыс. квадратных метров в ЦОД Fortune), в трех дата-центрах в Вирджинии (суммарная площадь — 12,5 тыс. кв. метров в ЦОДах Digital Realty Trust и 15 % площадей ЦОД DuPont Fabros Technology), а также в европейском ЦОД, принадлежащем Telecity Group.

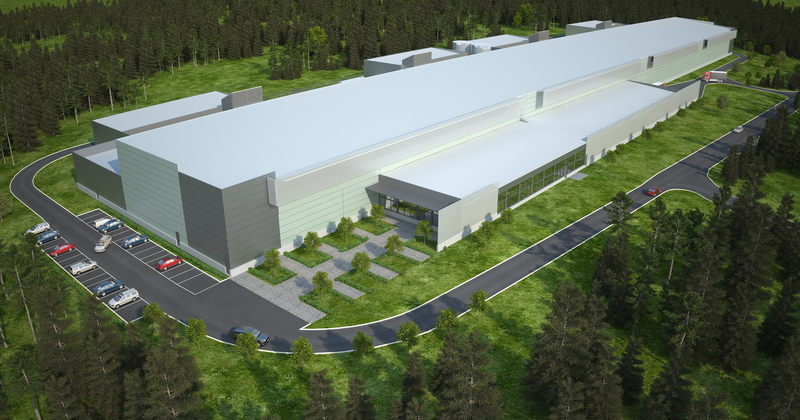

Первый собственный дата-центр Facebook был построен в штате Орегон (США), в небольшом городке Прайнвилль, в 2010 году (фото. 1). Через год был построен второй, дублирующий дата-центр в Форест-Сити (фото. 2), штат Северная Каролина. По сути он является модернизированной версией ЦОД в Прайнвилле — в нем был учтен опыт эксплуатации первого дата-центра. Мощность первой очереди строительства ЦОД в Прайнвилле составляет 28 МВт (предусмотрен рост площадки в три очереди — вплоть до 78 МВт, для чего рядом с дата-центром строится еще один ангар, но уже без помещений для офисов). У второго ЦОД, в Форест-Сити, расширение более скромное: до 40 МВт. Все дата-центры объединены в единый кластер, функционирующий как сеть доставки контента: при анализе запроса пользователя определяется кратчайший сетевой путь до него, и доставка контента идет с наиболее приближенного узла, благодаря чему значительно снижается время ответа, количество промежуточных узлов передачи по сети и транзитный трафик.

Фото 1. Дата-центр в Прайнвилле

Фото 2. Дата-центр в Форест-Сити

ЦОДы построены вдали от города, рядом с промышленным сектором. Первый факт, который невольно привлекает внимание, — это величина энергоэффективности: PUE 1,07 для ЦОД в Прайнвиле и 1.09 — для ЦОД в Форест-Сити. По данным Facebook, такой результат достигнут благодаря снижению потерь при передачи и трансформации электроэнергии, а также более высоким эксплуатационным температурам воздуха внутри ЦОД (допускается +35 °C в стойках в холодном коридоре).

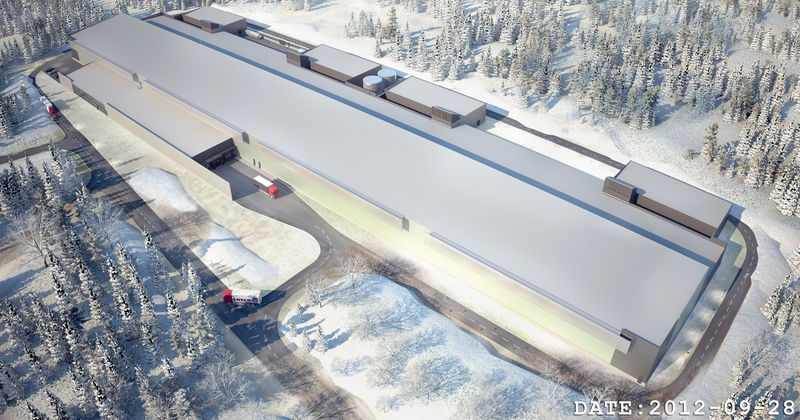

Проанализировав географию запросов, из которых 70 % приходилось на Европу, Facebook принял решение построить еще один дата-центр за пределами США, что и было сделано в 2011 году. Была выбрана площадка на территории с холодным климатом (среднегодовая температура в окрестностях городка Лулео в Швеции составляет всего 1,3 °C — городок находится всего в 100 километрах от полярного круга), на которой возвели здание высотой 15 метров и площадью 27 тыс. кв. метров (фото. 3). Протекающая рядом река Луле и ГЭС, построенная на ней, позволили решить вопрос с водоснабжением и электроснабжением ЦОД. К ЦОД подведены каналы связи от пяти независимых операторов связи. Проект реализовывался всего год, при том что мощность площадки — 129 МВт.

Известно, что еще один крупный дата-центр Facebook строит на Тайване.

Фото. 3. Дата-центр в Лулео

Особенности реализации

В дата-центрах не используются традиционные ИБП — функцию стабилизации напряжения берут на себя блоки питания. Поставляемые тайванской компанией Delta Electronics и американской Power One, они кастомизированы и рассчитаны на питающее напряжение в расширенном диапазоне питания. По мнению компании, более широкий рабочий диапазон питающего напряжения позволяет обойтись без стабилизаторов, а батареи с зарядными устройством размещаются в стойках между рядами. Каждая батарейная стойка содержит 20 батарей, подключенных в 5 цепочек, формируя на выходе постоянное напряжение 48 В (фото 4).

В серверных стойках — сразу две шины электропитания: шина сети постоянного тока с напряжением 48В для резервного питания от батарей и шина переменного тока, которая подключается непосредственно к электросети 0,4 кВ. Оборудование, устанавливаемое в шкафы подключается к этим шинам одновременно — таким образом, при исчезновении питания на шинах переменного тока нагрузка будет запитана от батарейной стойки.

Фото 4. Батарейный шкаф расположен между серверными стойками

Силовые кабели проложены под фальшполом в лотках, слаботочные кабели уложены на эстакады в холодных коридорах над шкафами. Все освещение в ЦОД обеспечивается с помощью LED-светильников (фото 5), но вот в горячих коридорах освещения нет — по мнению компании, в этом нет необходимости, так как все обслуживание и подключение разъемов происходит исключительно с фронтальной части.

Фото 5. Освещение дата-центра выполнено в фирменном корпоративном цвете

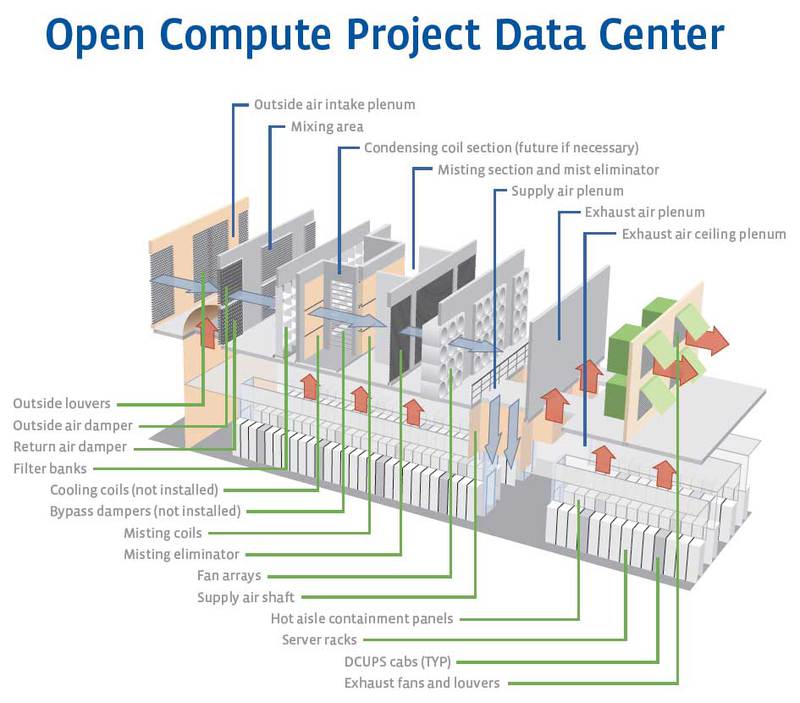

В дата-центре все-таки установлена традиционная система охлаждения, но используется она только в аварийных случаях. Основная же система кондиционирования воздуха — прямой фрикулинг с несколькими камерами подготовки воздуха, через которые проходит воздух снаружи (схема 1).

Схема 1. Принципиальная схема охлаждения дата-центра Facebook

Первоначально воздух извне забирается воздухозаборниками на втором ярусе и поступает в камеру подготовки, где фильтруется и частично смешивается с горячим воздухом, объем которого контролируется с помощью автоматических жалюзи. После этого воздух пропускается через так называемые холодильные панели. Собственно, холодильные панели представляют собой камеру увлажнения с множеством труб, распыляющих дистиллированную воду форсунками высокого давления, тем самым повышая влажность и понижая температуру продуваемого воздуха. Чтобы мелкодисперсная влага не выступала проводником электричества, распыляемую воду предварительно подвергают дистилляции.

На выходе этой секции стоят мембранные фильтры, отсекающие крупные частицы влаги (фото 6). После этого воздух засасывается мощными вентиляторами и перенаправляется в машинный зал, где серверные шкафы объедены по принципу изолированного горячего коридора. Подача холодного воздуха сверху вниз не случайна: холодный воздух тяжелее, потому возникает эффект самостоятельной тяги, что позволяет экономить на мощности вентиляции. Горячий воздух из изолированных горячих коридоров поднимается вверх, часть из него уходит в камеру подготовки, где опять смешивается с холодным воздухом, а остальная часть выбрасывается вентиляторами наружу. Но и тут не все так просто: воздух идет на обогрев вентилируемого фасада и крыши. Отработанная вода собирается в специальном резервуаре и очищается.

Фото 6. Коридор подготовки воздуха: после увлажнения воздух засасывается мощными вентиляторами и подается в машинный зал.

Интересно, что в качестве альтернативных источников питания на территории ЦОД используются солнечные батареи и ветряки (фото 7). Но, даже навскидку оценив их мощности, можно говорить о том, что они, скорее, обеспечивают мощность только малой части энергопотребителей, но не всего ЦОД. Именно поэтому в ЦОД в качестве резервного источника электроэнергии используется все те же традиционные дизельные генераторы.

Фото 7. Солнечные батареи присутствуют на всей территории ЦОД

ИТ-персонал передвигается по дата-центрам свободно с помощью электронного помощника (фото 8). Это мобильное рабочее место с электрическим приводом, выполняющее функции транспортировщика оборудования, стеллажа и рабочего стола, на который можно положить ноутбук.

Фото 8. Тележка айтишника — все нужное под рукой

В дата-центрах есть зоны для физического ограничения критически важного оборудования — воздухопрозначные секции, вход в которые контролируется круглосуточно со строгим журналированием посещений. Все сотрудники, входящие в такие зоны, надевают контрольные браслеты, которые и являются идентификатором.

В северном ЦОД в Лулео при доставке оборудования и заносе его в ЦОД возникает большой перепад температур, что приводит к конденсации влаги на оборудовании. Чтобы исключить выход из строя электроники, в тамбур-шлюзе реализована специальная сушильная камера — сюда оборудование попадает сразу после разгрузки для быстрой сушки, и только после этого оно устанавливается в машинном зал.

Серверы и программное обеспечение

Уже традиционно для крупных дата-центров информация о точном количестве серверов не разглашается, однако известно, что в 2008 года эта цифра эта составила 10 тыс. серверов, в 2009-м — 30 тыс., в 2010-м — 60 тыс. Согласно сведениям из разных источников, сегодняшнее количество серверов составляет от 120 до 180 тыс.

Facebook, подобно другим крупным компаниям, решил пойти по своему пути и разработать не просто свой типовой сервер, а целую платформу: программа под названием Open Compute Project, стартовавшая в апреле 2011 года, включает в себя открытые спецификации как к начинке серверов, так и к стойкам и системе питания.

В качестве процессов используются как Intel, так и AMD. Дизайн материнских плат спартанский. Его разработала тайваньская компания Quanta Computer. В перспективе заявлена возможность использования процессоров ARM, но пока что это только экспериментальная технология, находящаяся в разработке.

Сервер использует нестандартный форм-фактор в 1.5 U (фото 9), позволяя использовать теплообменники и вентиляторы большего размера (60 мм вместо стандартных для 1U серверов 40 мм). В сервере нет ничего лишнего: все порты и разъемы питания выведены на переднюю панель. Ширина сервера — 21 дюйм вместо штатных 19. Все крепления выполняются без винтов, с помощью клипов.

Фото 9. Сервер Facebook со снятой верхней крышкой, без дополнительных жестких дисков и со снятым радиатором на одном из процессоров.

Интересно организован принцип резервного копирования. Например, в ЦОД в Орегоне системы хранения данных расположены в отдельно стоящем здании на территории ЦОД. Кстати, в самом здании используется внешнее утепление с электростатической изоляцией, защита от механических повреждений и пыли. Оборудование системы хранения данных подключается на короткое время — только в момент синхронизации, после чего выключается. Причем питание таких систем выполняется только от автономных источников.

Буквально пару слов о программной платформе. Используется программное обеспечение с открытым кодом. Сайт написан на PHP, а в качестве базы данных используется движок MySQL. Для ускорения работы сайта используется разработанный собственной командой движок HipHop, который для ускорения преобразует PHP-код в C++. Для работы кластеризированной базы на MySQL применяется механизм кэширования.

Facebook, являясь быстрорастущим и прогрессивным стартапом, создает интересные решения, не боясь экспериментировать и в то же время не идя по пути глобальной экономии на всем. ЦОДы Facebook эстетичны и в то же время функциональны и технологичны. Удивляет, как компания, не имеющая опыта в построении ЦОД, смогла, пусть даже и с применением сторонних специалистов, реализовать уже первый свой ЦОД, внедрив множество прогрессивных решений. Быть может, в этом и есть весь секрет — внедрять только полезные инновации, ориентированные на четкую цель.

Автор: Константин Коваленко

Журнал ЦОДы.РФ №2 февраль

Автор: degas