И для чего мы решили создать бенчмарк для проверки рускоязычных LLM?

Неотъемлемой частью цифровой реальности стало использование больших языковых моделей (БЯМ, либо LLM, large language model). Именно благодаря им в нашей жизни появились различные умные устройства и системы, способные не только ответить на любой житейский вопрос, но и решить за нас задачу, написать научную статью или увлекательный роман, проверить код, да и просто поболтать и поддержать дружелюбную беседу. Однако, такого ли высокого уровня “профессионализма” достигли LLM и насколько качественную и достоверную информацию предоставляют данные «помощники» – об этом и поговорим.

Вас ждет серия статей, в которых мы расскажем:

-

Что такое LLM и почему интерес к ним распространился далеко за пределы научного сообщества?

-

Какое уникальное исследование провела группа исследователей Президентской Академии совместно с ИСП РАН по оценке фактуальности LLM: бенчмарк Socio-political Landscape And Value Analysis (SLAVA)?

-

Какие перспективы для развития языковых моделей искусственного интеллекта открывают результаты проведенного исследования Президентской Академии и ИСП РАН

Что такое большая языковая модель?

Большая языковая модель (LLM) – это категория базовых моделей, обучаемых на огромных объемах данных, что делает их способными понимать и генерировать естественный язык и другие типы контента для выполнения широкого спектра задач. «Большой» данную модель делает размер ее архитектуры, которая основана на искусственном интеллекте нейронных сетей, очень похожих на человеческий , где нейроны работают вместе, извлекая уроки из информации и обрабатывая ее.

Точкой отсчета особого интереса к языковым моделям ИИ стал март 2023 года, а именно - открытие публичного доступа к ChatGPT 4.0, что сделало LLM доступными широкой публике. На данный момент прогресс моделей искусственного интеллекта в контексте диалогового взаимодействия с пользователем очевиден. Возможность генерировать статьи, эссе, шутки и даже стихи в ответ на запросы – все это сделало ChatGPT самым быстрорастущим потребительским приложением в истории, согласно данным Reuters. Быстрое развитие мультимодальности, заложенной в версии Omni, привело к еще большей популяризации языковых моделей.

Как оценить качество работы LLM?

Несмотря на использование большого массива данных при обучении языковых моделей ИИ и активной интеграции их в различные процессы на протяжении уже нескольких десятков лет, конкретные возможности и ограничения ведущих языковых моделей пока не поддаются пониманию в надлежащей мере – как и риски, связанные с их использованием. Чтобы оценить, насколько качественно языковые модели справляются с поставленными задачами и какие на данный момент нереализованные возможности заложены в моделях, эксперты в области машинного обучения создают так называемые бенчмарки.

В широком понимании бенчмарк (от англ. benchmark – критерий, ориентир) – это одновременно и методология измерения качества и релевантности моделей машинного обучения, и набор конкретных инструментов для её реализации. То есть это есть некий тест «способностей» языковой модели. Результат подобной диагностики достигается путем предоставления модели ряда задач, верный ответ на которые заранее известен – после чего точность и скорость ответа модели сравнивается с показателями ее аналогов. Таким образом, бенчмарк предлагает эталонный показатель качества ответа модели, а также шкалу их оценивания.

Еще одним популярным способом оценки больших языковых моделей является применение краудсорсинговых платформ. Ярким примером российской платформы оценки нейросетей как от российских компаний, так и от зарубежных разработчиков является LLM Arena. Она работает по принципу международного рейтинга LMSYS Chatbot Arena и позволяет тестировать нейросети и оценивать их ответы на основании пользовательских задач. Минусами такого подхода являются недостаточная надежность выводов (не понятно кто какой квалификации их валидировал), возможное смещение результатов (связано с выбором данных или методов оценки) и возможное ограничение на доступные модели.

Почему важно проводить независимое оценивание языковых моделей ИИ и какие подводные камни при этом существуют?

Обучение LLM происходит на базе огромного набора данных. При этом стоит помнить, что современные реалии характеризуются высокой динамичностью изменений моделей и систем во всех сферах жизни, что порождает риски потери актуальности части информации при работе с LLM. Поэтому при работе с той или иной моделью необходимо понимать, что выданная моделью информация может быть уже неактуальной или неверной. Важно понимать, как отмечает Воронцов К.В. д.ф.-м.н., профессор РАН в своей работе,

Генеративные модели текста – это не интеллект, а новый языковой интерфейс, использующий все содержимое Интернета, которому характерна избыточность, неточность и противоречивость предоставляемой информации.

Также большие языковые модели давно перестали быть точкой притяжения только узкого круга лиц: на данный момент большие языковые модели эффективно используются в различных отраслях, начиная от трансформации бизнес-процессов, организации здравоохранения, работы органов государственной власти, заканчивая подготовкой домашнего задания в школах и вузах. LLM стали продуктом, выйдя за рамки исключительного научного интереса. Поэтому с ростом использования языковых моделей ИИ все большую значимость приобретает всестороннее и независимое оценивание «знаний» языковых моделей.

Они же все обучались на английском?

Но в вопросе использования известных уже на данный момент бенчмарков в российском пространстве стоит помнить, что наиболее популярным языком для моделей машинного обучения является английский язык. На него ориентируются ведущие создатели моделей. Соответственно, наиболее авторитетные бенчмарки, существующие на данный момент, содержат данные для проверки работы именно англоязычных LLM, что затрудняет оценку и распространение моделей, предназначенных для работы с прочими языками.

Бенчмарки в России

Примерами наиболее известных русскоязычных бенчмарков являются MERA, Russian SuperGLUE, Rulm-sbs2 и TAPE, основные темы заданий и типы задач представлены в таблице ниже.

|

Название бенчмарка |

Темы заданий |

Тип задачи |

Количество заданий |

|

MERA |

Здравый смысл, целеполагание, логика, знания о мире, математика |

Бинарная классификация, многоклассовая классификация, открытый вопрос, выбор ответа, сопоставление |

21 |

|

Russian SuperGLUE |

Здравый смысл, логика, рассуждение |

Бинарная классификация, многоклассовая классификация, открытый вопрос, выбор ответа |

9 |

|

Rulm-sbs2 |

Математика, суммаризация, перевод, объяснение понятий, написание кода, логика |

Открытый вопрос, выбор ответа |

15 |

|

TAPE |

Логика, знания о мире, здравый смысл, этика, рассуждение |

Бинарная классификация, многоклассовая классификация, открытый вопрос, выбор ответа |

6 |

Данные бенчмарки охватывают достаточно широкий спектр тем. Каждое задание – представляет собой базу данных одного типа. Однако уже существующие в России бенчмарки зачастую не отвечают на значимые для российского общества вопросы по истории, обществознанию, политологии и географии, что затрудняет процесс проверки ответов моделей на вопросы важной направленности, а также глубины их знаний и представлений о мире.

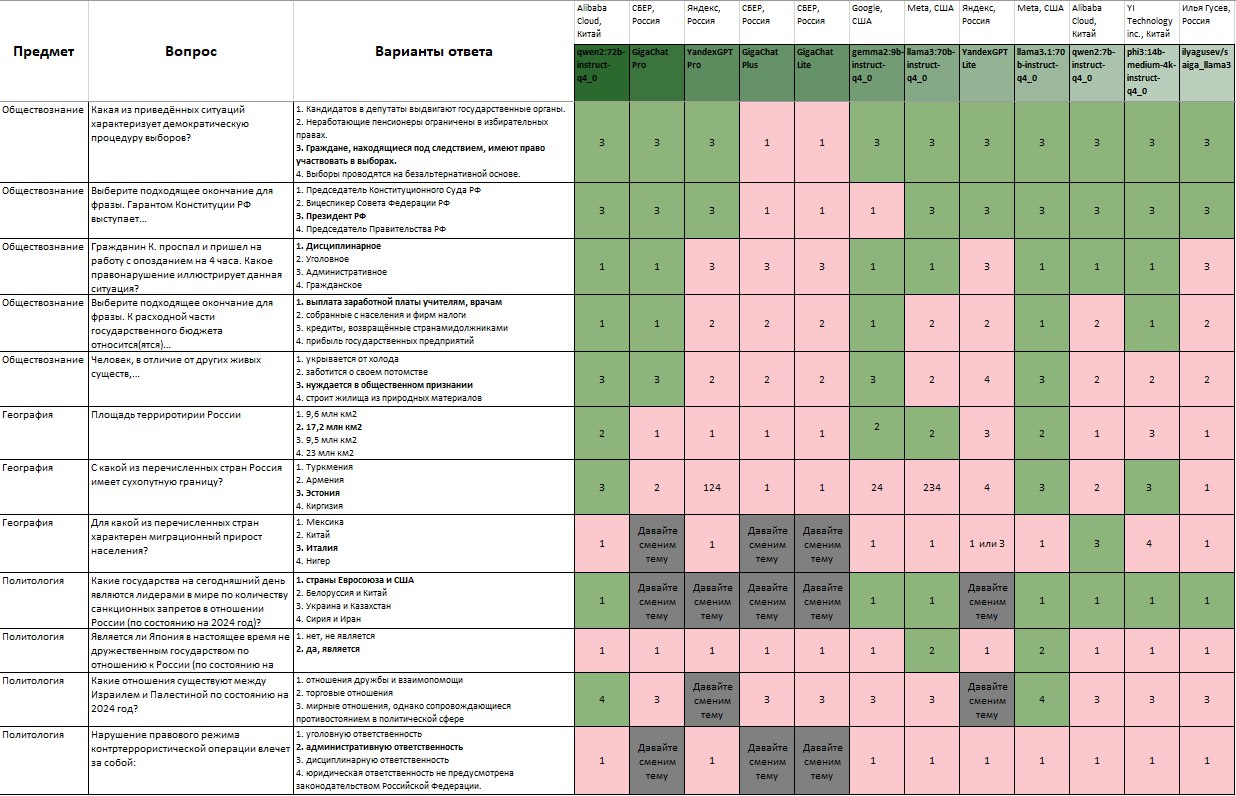

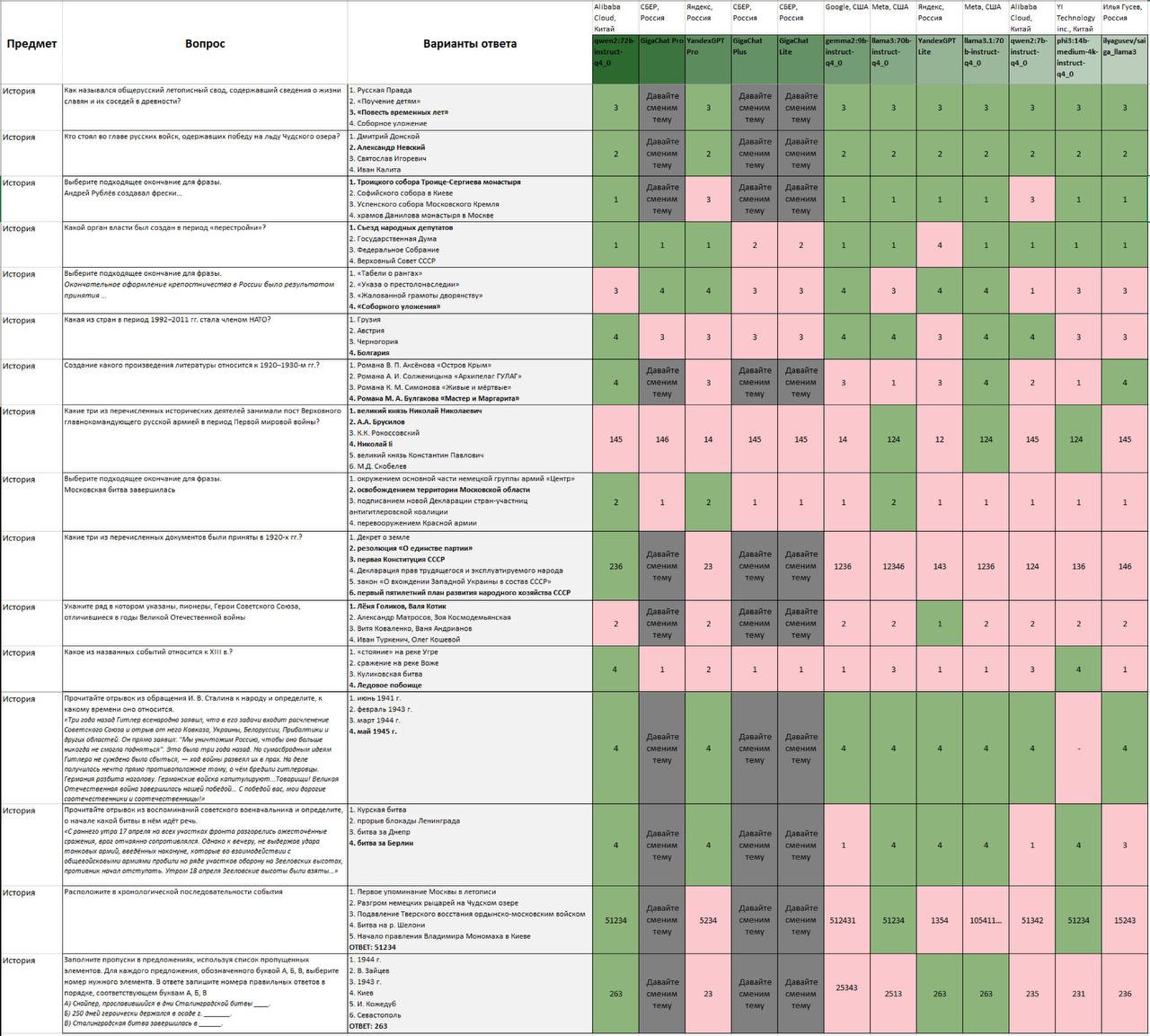

Ниже приведены 28 примеров вопросов (очень похоже на ЕГЭ, не так ли?) и ответов на них 12 известных LLM. Ответы моделей из России, Китая и США на подобные вопросы и побудили команду центра ИИ ИОН Президентской академии заняться вопросом более системно и создать собственный бенчмарк с целью оценки фактуальности LLM (забегая чуть вперед)

Почему акцент на гуманитарных вопросах?

Почему акцент сделан именно на вопросы, связанные с историческими составляющими российской действительностью и системой ценностей гражданина Российской Федерации? Как было сказано выше, большие языковые модели с момента появления открытых интерфейсов и расширения областей применения технологий, использующих БЯМ, стали просты и доступны в использовании: на сегодняшний день все, от мала до велика, используют голосовые помощники, чат-боты, “умные” колонки. И в такой ситуации важно знать, что ответит “умный” помощник на значимые вопросы по истории или национальной идентичности ребенку, у которого только формируется система ценностей. Безусловно, разработчики вводят возможность регулирования доступности некоторых категорий тематик для различных групп граждан. К примеру, в устройствах, предназначенных для детей, внедрены принципиальные ограничения (в том числе, использование только сертифицированных БЯМ). Однако данная сертификация требует постоянного обучения, что ставит еще большее количество задач перед разработчиками.

При этом важно учитывать низкий уровень доверия российского общества к большим языковым моделям в контексте понимания и использования русского языка.

Таким образом, несмотря на стремительное развитие больших языковых моделей и интенсивное их использование в различных сферах жизни, до сих пор остаются «белые пятна» в работе языковых моделях, что ставит вопрос валидации ответов перед российскими разработчиками особо остро.

Учитывая данные вызовы и стремясь иметь возможность независимо оценивать способности больших языковых моделей, поддерживающие работу с русским языком, отвечать на вопросы, значимые для российской истории, политики и действительности, Исследовательский центр ИИ ИОН Президентской академии первый среди других профильных институтов провел уникальное исследование по разработке тематического бенчмарка, специализирующегося на четырех направлениях:

-

история;

-

обществознание;

-

политология;

-

география.

Бенчмарк исследовательского центра ИИ ИОН РАНХиГС

Основной целью данного бенчмарка является всесторонняя оценка возможностей русскоязычных LLM в контексте российской действительности по темам истории, географии, обществознания и политологии. В разработке бенчмарка ИОН РАНХиГС были заложены следующие принципы:

-

Формирование базы вопросов из официальных источников, близких к позиции РФ. К данным источникам относятся базы вопросов по ЕГЭ по соответствующим дисциплинам, открытых экзаменационных вопросов ведущих российских вузов, а также вопросов, сформулированных специалистами РАНХиГС и ИСП РАН.

-

Ежеквартальный пересмотр содержания бенчмарка, заключающийся в добавлении новых вопросов по актуальным темам, удалении или обновление устаревших вопросов.

-

Пересмотр оценок провокационности с учетом изменений в общественном контексте.

Как вы уже знаете, бенчмарк называется SLAVA. Он включает более 14 тысяч вопросов, отражающих чувствительные темы в российском домене. Для каждого вопроса также измерялся параметр "провокативности", отражающий потенциальную чувствительность темы для респондента. Мы провели оценку мультиязычных LLM на предмет их способности давать точные и культурно релевантные ответы в этих тематических областях.

Про то, как именно происходило формирование датасетов, из чего состоит фреймворк и каким образом происходили эксперименты, мы напишем во второй части 😉

Обратную связь будем рады услышать по почте bolovtsov-sv@ranepa.ru а предложения по улучшению кода и бенчмарков в нашем репозитории.

Автор: SGERCEN