Эксклюзивный взгляд на использование искусственного интеллекта и машинного обучения в компании Apple

30 июля 2014 года Сирии [Siri] пересадили .

За три года до того Apple стала первой из крупнейших технологических компаний, внедривших ИИ-ассистента в операционную систему. Сири стала адаптацией приобретённого компанией стороннего приложения. Заодно с приложением в 2010-м была приобретена и компания-разработчик. Самые первые отзывы о технологии были восторженными, но в следующие месяцы и годы пользователей начали раздражать её недоработки. Слишком часто она неправильно распознавала команды.

Поэтому Apple перевела систему распознавания голоса Сири на работу при помощи нейросети для пользователей из США в упомянутый июльский день (во всём остальном мире это случилось 15 августа 2014 года). Некоторые из предыдущих техник остались в строю – включая «скрытые модели Маркова» – но сейчас система основывается на таких техниках машинного обучения, как глубокие нейросети (DNN), свёрточные нейросети, долгая краткосрочная память, рекуррентные сети с шлюзами и n-граммы. После обновления Сири выглядела так же, но ей на помощь пришло глубокое обучение.

И как это часто бывает со скрытыми обновлениями, Apple не стала его афишировать. Если пользователи что и заметили, так это уменьшение количества ошибок. Apple заявляет, что результаты улучшения точности работы были поразительными.

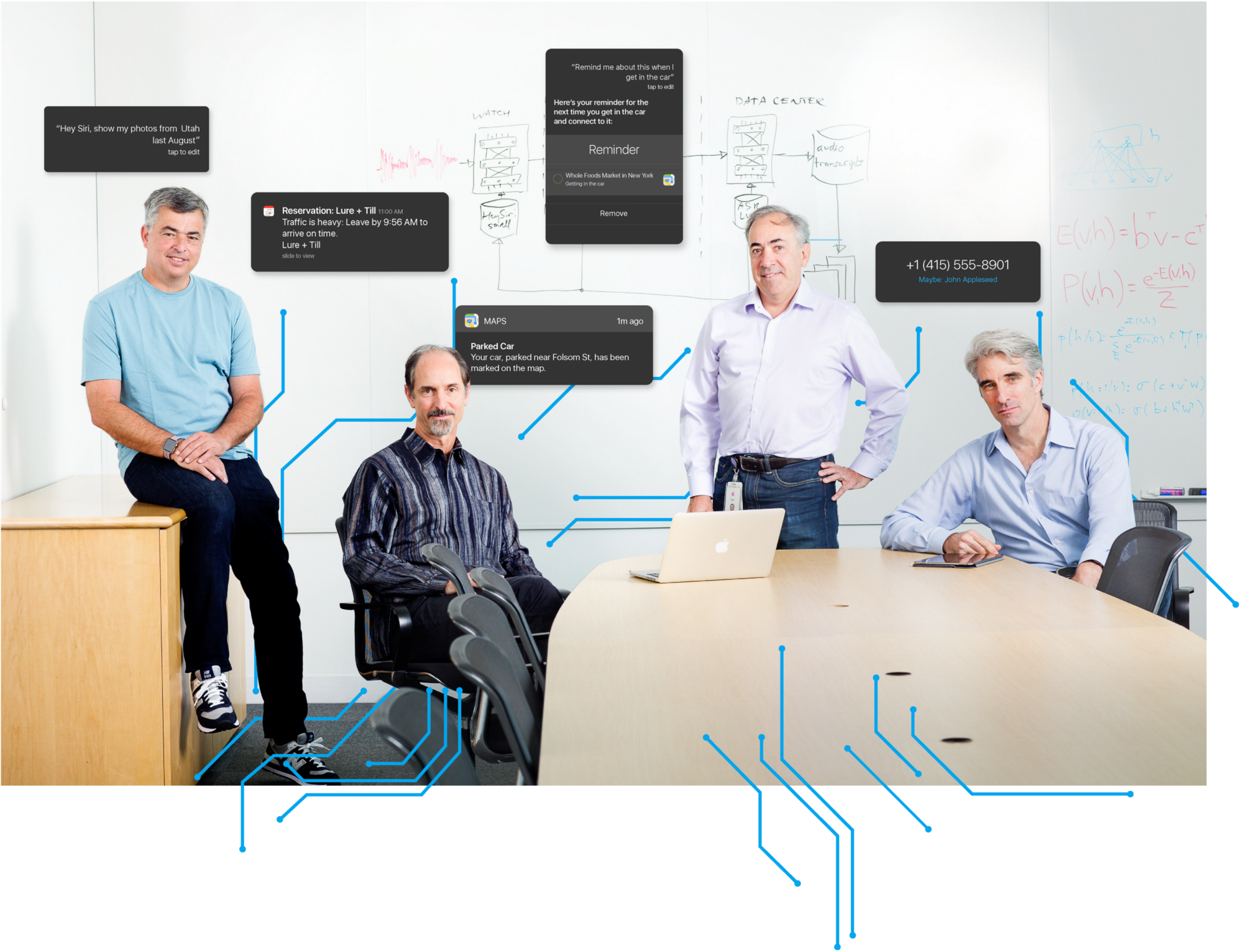

Главный вице-президент по интернет программам и сервисам, Эдди Кью

«Это был один из тех случаев, когда улучшение было настолько значительным, что пришлось перепроверять результаты, чтобы убедиться, что никто не поставил десятичный разделитель в другом месте»,- говорит Эдди Кью, главный вице-президент по интернет программам и сервисам.

История преобразования Сири, впервые описанная в этой статье, может удивить специалистов по ИИ. Не оттого, что нейросети улучшили систему, но потому, что Apple делала всё молча. До недавнего времени, когда компания усилила найм специалистов по ИИ и приобрела парочку специализированных фирм, наблюдатели считали Apple отстающей в самом захватывающем соревновании современности: гонке по использованию богатых возможностей ИИ. Поскольку Apple всегда с неохотой делилась информацией о происходящем за закрытыми дверями, ценители ИИ не подозревали, что компания занимается машинным обучением. «Apple не является частью сообщества»,- говорит Джерри Каплан, ведущей в Стэнфорде курс по истории ИИ. «Apple – это NSA в мире ИИ». Но специалисты по ИИ считали, что если бы Apple так же серьёзно занималась ИИ, как Google или Facebook, то об этом стало бы известно.

«В Google, Facebook, Microsoft машинным обучением занимаются лучшие люди,- говорит Орен Этцьони [Oren Etzioni] из Алленовского института ИИ. – Да, Apple наняла кое-кого. Но назовите мне пятерых крупнейших специалистов по ИИ, работающих на Apple? У них есть распознавание речи, но непонятно, где ещё им помогает машинное обучение. Покажите, где в вашем продукте используется МО!».

«Я сам с Миссури,- говорит Этцьони, который на самом деле родился в Израиле. – Покажите мне».

Недавно Apple показала, где в её продуктах используется машинное обучение – но не Этцьони, а мне. Большую часть дня я провёл в переговорной One Infinite Loop в Купертино, получая основную информацию о работе компании с ИИ и МО от начальников Apple (Кью, старший вице-президент по международному маркетингу Фил Шиллер, и старший вице-президент по разработке софта Крейг Федериги) и двух учёных, чья работа была ключевой в разработке Сирии. Мы сели, и они выдали мне двухстраничное содержание, перечисляющее продукты и услуги Apple, использующие машинные технологии – те, что уже готовились к выходу, или уже выходили – как тему для обсуждения.

Сообщение: Мы уже здесь. Не уступаем никому. Но делаем всё по-своему.

Если вы пользуетесь айфоном, то вы встречали ИИ от Apple, и не только в улучшенной версии Сири. Вы сталкиваетесь с ним, когда телефон определяет звонящего, не входящего в ваш список контактов (но писавшего вам недавно электронное письмо). Или когда вы проводите пальцем по экрану, чтобы вызвать список приложений, среди которых с большой вероятностью находится то, что вы захотите открыть после этого. Или когда вы получаете напоминание о встрече, которую вы не добавляли в календарь. Или когда на карте появляется точка с зарезервированным вами отелем, а вы ещё не вбили его адрес. Или когда телефон указывает вам на место, где вы запарковались, а вы его не спрашивали. Все эти возможности либо появились, либо были сильно улучшены благодаря применению глубокого обучения и нейросетей.

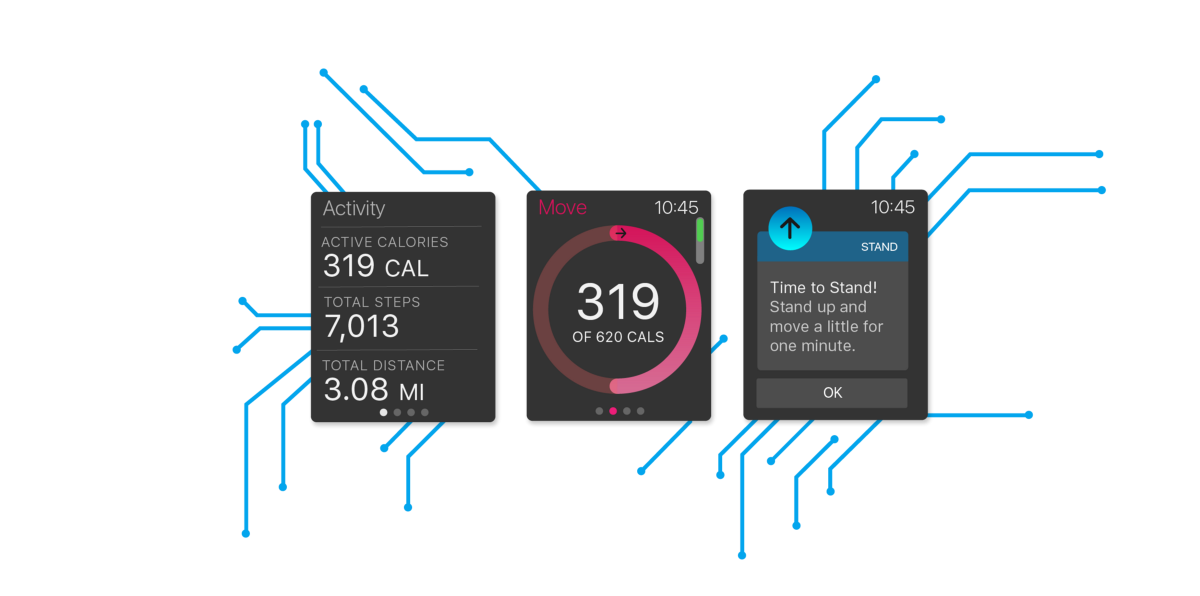

Распознавание лиц работает при помощи нейросетей

Как говорят мои докладчики, МО уже применяется во всех продуктах и сервисах компании. Apple использует глубокое обучение для определения мошенников в Apple store, для увеличения срока службы батареи, для отсева самого полезного из поступающих от бета-тестеров отзывов. МО помогает Apple выбирать для вас новости. Определяет, занимаются ли пользователи Apple Watch спортом, или же просто расхаживают взад-вперёд. Оно распознаёт лица и места по фотографиям. Оно определяет, не лучше ли разорвать слабое Wi-Fi соединение и перейти на мобильную связь. Она даже знает, как правильно делать кино, комбинируя фото и видео в небольшой фильм по нажатию кнопки. Конкуренты компании занимаются тем же, но, по словам её директоров, эти возможности ИИ не могут так же хорошо работать, при этом так сильно защищая приватность пользователей, как это делают в Apple. И конечно, никто из них не делает продуктов, как у Apple.

ИИ – не новинка для компании. Уже в 1990-х они использовали кое-какие техники МО в программах, распознававших рукописный текст (помните Newton?). Остатки этих попыток можно найти в сегодняшних программах, преобразовывающих написанные от руки китайские иероглифы в текст или распознаёт побуквенный ввод текста на Apple Watch. Обе эти возможности разрабатывались одной и той же командой специалистов по МО. Конечно, раньше машинное обучение работало примитивнее, а глубокое обучение было мало кому известно. Сегодня эти технологии на пике, и Apple ощетинивается в ответ на обвинения в том, что их МО не слишком серьёзное. И вот руководители компании рассказывают об этом подробнее.

«В последние пять лет мы наблюдаем за ростом этой области в компании,- говорит Фил Шиллер. – Наши устройства становятся всё умнее, и происходит это всё быстрее, особенно с использованием разработанных нами чипов серии А. Бэкенд умнеет, становится быстрее, и всё, что мы делаем, связывается друг с другом. Это позволяет использовать всё больше техник МО, потому что так многому нужно научиться, а оно нам уже доступно».

И хотя Apple изо всех сил стремиться использовать МО на полную катушку, директора подчёркивают, что этот процесс ничем особенным не является. Купертиновские заправилы видят в глубоком обучении и МО просто ещё одну технологию из потока сменяющих друг друга прорывных технологий. Да, да, она меняет мир, но не больше, чем другие прорывы, типа сенсорных экранов, плоских экранов, или ООП. С точки зрения Apple, МО это не последний рубеж, несмотря на мнение других компания. «Ведь нельзя сказать, что за прошедшие годы не было других технологий, критичных для смены принципов нашего взаимодействия с устройствами»,- говорит Кью. И никто в компании и близко не хочет подходить к обсуждению пугающих тем, неизменно всплывающих при упоминании ИИ. И, как и следовало ожидать, Apple не подтверждает, работает ли она над робомобилями или своей версией Netflix. Но команда чётко обозначила, что Apple не работает над Skynet.

«Мы используем эти технологии для того, что давно уже хотели делать и с лучшим качеством, чем это было возможно раньше,- говорит Шиллер. – И для новых вещей, которые мы делать не могли. Это технология станет эппловским методом достижения целей по мере своего эволюционирования внутри компании и оттого, каким образом мы делаем наши продукты».

Но во время брифинга становится понятно, как ИИ сильно поменял методы использования эппловской экосистемы. Специалисты по ИИ считают, что Apple ограничена тем, что не имеет своего поисковика (который мог бы поставлять данные для тренировки нейросетей) и своей негибкой убеждённостью в необходимости охраны пользовательской информации (данных, которые в другом случае можно было бы использовать). Но оказывается, что Apple уже придумала, как преодолеть оба этих препятствия.

И какого же размера этот

И, если верить Apple, всё это делается таким образом, чтобы ваши настройки, пристрастия и перемещения оставались приватными.

И хотя мне не объясняли всего по поводу использования ИИ в компании, я смог разобраться, как компания распространяет опыт в МО среди сотрудников организации. Талантом МО делятся по всей компании, он доступен для всех разработчиков, которых стимулируют использовать эти знания для решения задач и изобретения новых возможностей конкретных продуктов. «У нас нет особой выделенной организации, Храма МО, в Apple,- говорит Крейг Федериги. – Мы пытаемся держать информацию поближе к командам, применяющим её для создания правильного пользовательского опыта».

Сколько же людей в компании работают над МО? «Множество»,- говорит Федериги после некоторых раздумий. (Если вы думали, что он скажет мне точное количество, вы не знаете Apple). Интересно, что в Apple МО разрабатывают и те люди, кто не был специалистом по этому вопросу до того, как пришёл в компанию. «Мы нанимаем людей, хорошо разбирающихся в математика, статистике, программировании, криптографии,- говорит Федериги. – Оказывается, что множество таких талантов прекрасно преобразовывается в МО. Хотя сегодня мы, конечно, нанимаем специалистов по МО, мы также берём и людей с нужными склонностями и талантами».

Старший вице-президент по разработке ПО Крейг Федериги слушает старшего директора по Сири, Алекса Ацеро

И хотя Федериги не говорит об этом, такой подход может исходить из необходимости: склонность компании к секретности может поставить её в невыгодное положение по сравнению с конкурентами, поощряющими своих лучших программистов распространять результаты исследований. «Наши методы увеличивают разброс естественного отбора – те, кому больше всего нужна командная работа и выпуск отличных продуктов против тех, кому важнее всего публикации»,- говорит Федериги. Если во время улучшения продуктов Apple исследователи совершают прорыв в области – это хорошо. «Но для нас главным будет конечный результат»,- говорит Кью.

Какие-то талантливые люди попадают в компанию после поглощений. «В последнее время мы покупаем по 20-30 небольших компаний в год, занимаемся наймом рабочей силы»,- говорит Кью. Когда Apple покупает компанию, работающую над ИИ, она делает это не потому, что «вот тут есть толпа исследователей МО, давайте наберём из них целую конюшню,- говорит Федериги. – Мы ищем людей талантливых, но сконцентрированных на создании отличного пользовательского опыта».

Самое свежее приобретение – Turi, компания из Сиэтла, которую Apple купила за $200 миллионов. Они построили набор инструментов для МО, сравнимый с гугловским TensorFlow, и это приобретение привело к появлению слухов, что Apple будет использовать эту технологию в схожих целях, как для себя, так и для разработчиков. Директора не подтверждают и не опровергают эту информацию. «Некоторые их результаты очень хорошо сочетались с Apple как с точки зрения технологий, так и с точки зрения людей»,- говорит Кью. Через пару лет мы, возможно, узнаем, что произошло, как было тогда, когда Сири начала демонстрировать предсказательные возможности Cue (не имеет отношения к Эдди), продукта одноимённого стартапа, который Apple купила в 2013 году.

Неважно, откуда берётся талант, инфраструктура ИИ в Apple позволяет ей разрабатывать продукты и возможности, невозможные иначе. Она изменяет программу развития продуктов компании. «В Apple списку крутых идей нет конца,- говорит Шиллер. – МО позволяет нам обращаться к таким вещам, которые в прошлом мы бы не трогали. Оно вливается в процесс принятия решений о продуктах, которыми мы будем заниматься в дальнейшем».

Одним из примеров может служить Apple Pencil, работающий с Apple Pencil. Чтобы заставить этот высокотехнологичный стилус работать, компании пришлось решать проблему – когда люди пишут на экране, нижняя часть ладони проводит по сенсорному экрану, что приводит к появлению паразитных нажатий. Используя модель МО для исключения этих нажатий, компании удалось научить экран различать прокрутку, прикосновения, ввод со стилуса. «Если это не работает на 100%, эта бумага для записей для меня не подходит, и Pencil – плохой продукт»,- говорит Федериги. Если вам нравится Pencil, скажите за него спасибо МО.

Возможно, наилучшим мерилом прогресса МО в компании будет её самая главная покупка, Сири. Она берёт начало в амбициозной программе DARPA по разработке интеллектуальных помощников, после которой несколько учёных основали компанию, чтобы создать приложение при помощи этой технологии. Стив Джобс самолично убедил основателей компании продаться Apple в 2010 году, и настоял, чтобы Сири встроили в операционную систему. Её запуск был одним из самых ярких моментов презентации iPhone 4S в октябре 2011. Теперь она работает уже не только тогда, когда пользователь удерживает кнопку «домой» или бормочет «Эй, Сири» (сама по себе эта возможность тоже использует МО, позволяя айфону прослушивать эфир, не сильно сажая батарею). Интеллект Сири встроен в Apple Brain, и работает, даже когда ничего не говорит.

Кью описывает четыре компонента основного продукта: распознавание речи, понимание естественного языка, выполнение команд и отзыв. «МО повлияло на все эти области очень сильно»,- говорит он.

Глава отдела передовых разработок Том Грубер и гуру по Сири, Алекс Ацеро

Сири занимается глава отдела передовых разработок Том Груббер, попавший в Apple вместе с основным приобретением (сооснователи компании покинули Apple в 2011 году). Он говорит, что даже до применения нейросетей к Сири они получили огромное количество данных, поступавшее от пользовательской базы. В дальнейшем эти данные послужили ключом к тренировке нейросетей. «Стив сказал, что мы за одну ночь перейдём от пилотного приложения к сотням миллионов людей, без бета-тестирования,- говорит он. – Внезапно у нас будут пользователи. Нам говорили, как люди будут называть вещи, относящиеся к нашему приложению. Это была первая революция. А потом появились нейросети».

Переход Сири на нейросети, обрабатывающие распознавание речи, совпало с приходом в компанию нескольких ИИ-экспертов, включая Алекса Ацеро, сейчас руководящего командой речевых технологий. Ацеро начал свою карьеру в области распознавания речи в Apple в начале 90-х, а затем много лет провёл в Microsoft Research. «Мне очень нравилось там работать, я опубликовал множество работ,- говорит он. – Но когда вышла Сири, я сказал: 'Это шанс сделать глубокие нейросети реальностью, довести их от такого состояния, когда о них читала сотня человек, до такого, в котором их используют миллионы'». Иначе говоря, он принадлежал именно к тому типу учёных, которых искала Apple – ставящих продукт выше публикаций.

Когда три года назад Ацеро пришёл в компанию, Apple всё ещё занималась получением лицензий на большую часть речевых технологий Сири от сторонних производителей, и эта ситуация должна была вскоре поменяться. Федериги отмечает, что по этому шаблону Apple работает постоянно. «Когда становится понятным, что технологическая область необходима для наших возможностей со временем выпустить новый продукт, мы наращиваем наши внутренние способности производить то, что мы хотим. Чтобы сделать продукт великим, нам нужно полностью владеть технологиями и проводить инновации внутри компании. Речь – прекрасный пример того, как мы применили возможности, доступные извне, чтобы дать проекту старт».

Команда занялась тренировкой нейросети для замены оригинала Сири. «У нас была самая крутая GPU-ферма, работающая круглосуточно,- говорит Ацеро. – И мы загоняли в неё кучу данных». Релиз в июле 2014 года доказал, что всё это процессорное время не было потрачено впустую.

«Количество ошибок упало в два раза во всех языках, а в некоторых случаях – и сильнее,- говорит Ацеро. – В основном благодаря глубокому обучению и нашей его оптимизации – не просто самого алгоритма, но согласно контексту его работы в конечном продукте».

Упоминание конечного продукта не случайно. Apple — не первая, использовавшая глубокое обучение нейросетей в распознавании речи. Но Apple утверждает, что имеет преимущество, контролируя всю систему разработки и доставки продукта. Поскольку чипы Apple делает сама, у Ацеро была возможность поработать с командой их разработки и инженерами, писавшими прошивки для устройств, чтобы максимизировать быстродействие нейросетей. Нужды команды разработчиков Сири влияли даже на дизайн айфона.

«Дело не только в кремнии,- добавляет Федериги. – В том, сколько микрофонов на устройстве, где они расположены. Как мы настроим железо и микрофоны, и набор софта, обрабатывающего звук. Важно взаимодействие частей. Это огромное преимущество перед теми, кто просто написал софт и смотрит, что у него получается».

Ещё одно преимущество: когда нейросеть работает в одном продукте, её можно приспособить в качестве основы технологии для других целей. МО, помогающее Сири понимать вас, превращается в движок, записывающий под диктовку. В результате работы Сири люди обнаруживают, что их емейлы и сообщения будут более осмысленными, если они откажутся от экранной клавиатуры, нажмут на иконку микрофона и заговорят вслух.

Второй компонент Сири, упомянутый Кью, это понимание естественного языка. Сири начала использовать МО для понимания намерений пользователя в ноябре 2014 года, и выпустила версию с глубоким обучением через год. И, как и с распознаванием речи, МО улучшило пользовательский опыт – особенно в части более гибкой интерпретации команд. К примеру, Кью достаёт айфон и вызывает Сири. «Отправь Джейн двадцать долларов через Square Cash»,- говорит он. На экране появляется сообщение с описанием его запроса. Затем он пробует задать задачу по-другому: «кинь двадцатку моей жене». Результат тот же.

Apple утверждает, что без этих улучшений в Сири вряд ли была бы возможна текущая версия Apple TV, отличающаяся сложным голосовым управлением. Ранние версии Сири заставляли вас говорить чётко и раздельно, заряженная МО версия не только предлагает конкретные варианты из огромного каталога фильмов и песен, но и понимает концепции. «Покажи мне хороший триллер с Томом Хэнксом». (Если бы Сири была реально умная, она бы исключила «Код да Винчи»). «Такой возможности до появления этой технологии нельзя было бы предоставить»,- говорит Федериги.

На эту осень намечен выход iOS 10, и голос Сири станет последним из четырёх компонентов, преображённых МО. Глубокие нейросети заменили предыдущие реализации, выполненные по лицензии. По сути, реплики Сири выбираются из базы записей, собранных в голосовом центре и каждое предложение собирается по частям. По словам Груббера, машинное обучение сглаживает углы и заставляет Сири быть более похожей на настоящего человека.

Ацеро проводит демонстрацию – сначала знакомый голос Сири, с похожими на робота нотками, к которым мы привыкли. Затем новый, говорящий «Привет, чем могу помочь?», с завлекательной плавностью. В чём разница? «Глубокое обучение, детка»,- говорит он.

Это кажется мелкой деталью, но более естественный голос может привести к большим изменениям. «Люди больше доверяют голосу лучшего качества,- говорит Груббер. – Лучший голос затягивает пользователя и побуждает пользоваться им чаще. Эффект возврата увеличивается».

Желание использовать Сири, и все улучшения, сделанные благодаря МО, становятся ещё более важными, поскольку Apple, наконец, открывает Сири для сторонних разработчиков – а критики компании считают, что это было давно пора сделать. Многие отметили, что Apple, количество партнёров по Сири которой исчисляется десятками, отстаёт от таких систем, как Amazon’s Alexa, хвастающейся тысячей возможностей, предоставляемых сторонними разработчиками. Apple говорит, что сравнивать их некорректно, потому что пользователям Amazon приходится выражать пожелания особым языком. Сири более естественно включит в себя такие вещи, как SquareCash или Uber. (Ещё один конкурент, Viv – созданный другими сооснователями Сири – также обещает интеграцию со сторонними сервисами, когда наступит не объявленная пока дата выхода).

Возможно, самой большой проблемой освоения компанией МО будет достижение успеха при необходимости придерживаться принципов приватности пользователей. Компания шифрует их данные, так что никто, даже юристы Apple, не могут их прочесть (даже ФБР, даже с ордером). И компания кичится тем, что не собирает данные пользователей в рекламных целях.

И хотя такая суровость похвальна с точки зрения пользователей, она не помогает заманивать в компанию лучшие таланты в области ИИ. «Экспертам в МО нужны данные,- говорит бывший работник Apple, работающий на компанию, специализирующуюся на ИИ. – Но встав в позу приватности, Apple заставляет вас работать с одной связанной рукой. Можно спорить, правильно это или нет, но в результате у Apple нет репутации реально крутых спецов по ИИ».

Тут есть две проблемы. Первая – обработка персональной информации в системах, основанных на МО. Когда личные данные пользователя проходят через жернова нейросетевой обработки, что происходит с это информацией? Вторая проблема включает сбор информации, необходимой для тренировки нейросетей для распознавания поведения. Как это можно сделать, не собирая персональную информацию пользователей?

Apple считает, что у неё есть решения. «Некоторые считают, что мы не можем сделать это при помощи ИИ, потому что у нас нет данных,- говорит Кью. – Но мы нашли способы получать нужные нам данные, и сохранять при этом приватность. Вот так».

Apple решает первую проблему, пользуясь возможностью контролировать и софт и железо. Самая персональная информация остаётся внутри Apple Brain. «Самые чувствительные вещи мы храним там, где МО происходит локально по отношению к устройству»,- говорит Федериги. В пример он приводит предсказания приложений для запуска, иконки, появляющиеся при проведению по экрану вправо. Эти предсказания основаны на многих факторах, часть из которых зависит только от вашего поведения. И они работают – Федериги говорит, что 90% времени люди находят то, что им нужно, в этих предсказаниях. Все расчёты Apple проводит непосредственно на телефоне.

Кроме этого, на устройстве хранится, возможная, самая личная информация, получаемая компанией: слова, используемые людьми на клавиатуре iPhone QuickType. Используя систему обучения нейросетей, следящую за вашим вводом, Apple может распознавать ключевые события и моменты, типа информацию об авиаперелёте, контакты, встречи – но сама информация остаётся у вас на телефоне. Даже в хранящихся в облаке резервных копиях она разбавлена таким образом, что только из одной резервной копии её не достать. «Мы не хотим, чтобы эта информация хранилась на наших серверах,- говорит Федериги. – Корпорации Apple не нужно знать ваши привычки, или куда и когда вы ходите».

Apple пытается минимизировать хранящуюся информацию. Федериги привёл пример, в котором вы можете вести разговор, и кто-нибудь в нём упомянет термин, подходящий для поиска. Другие компании могли бы проанализировать весь разговор в облаке, чтобы найти эти термины, но устройство Apple может распознать их так, чтобы данные не уходили от пользователя – потому, что система постоянно ищет совпадения по базе знаний, хранящейся в телефоне (она является частью 200 Мб «мозга»).

«База компактная, но исчерпывающая, с сотнями тысяч местоположений и объектов. Мы её локализуем, поскольку знаем, где вы находитесь»,- говорит Федериги. К базе обращаются все приложения Apple, включая поисковик Spotlight, Maps и Safari. Она помогает автоматически исправлять ошибки. «И постоянно работает в фоне»,- говорит он.

Начиная с iOS 10, Apple будет использовать новую технологию дифференцированной приватности, позволяющую краудсорсить информацию так, чтобы в ней нельзя было идентифицировать отдельных людей. Это могут быть обретшие популярность слова, которых нет в базе данных, ссылки, предлагающие более релевантные ответы на запросы, или моду на использование определённых эмодзи. «Обычно в индустрии принято отправлять все вводимые вами слова и символы на серверы компании, чтобы они потом копались в них и замечали что-нибудь интересное»,- говорит Федериги. – Мы шифруем информацию от и до, поэтому мы этим не занимаемся". Хотя дифференцированная приватность зародилась в сообществе исследователей, Apple пытается внедрять её в массы. «Мы переносим её из исследовательского отдела на миллиард пользователей»,- говорит Кью.

И хотя ясно, что МО изменило продукты Apple, пока не ясно, изменило ли оно саму компанию. В каком-то смысле подход с использованием МО находится в противоречии с духом компании. Apple тщательно контролирует пользовательский опыт, вплоть до сенсоров, измеряющих проведение по экрану. Всё заранее спланировано и точно закодировано. Но при использовании МО инженерам приходится сделать шаг назад и дать софту возможность искать решения самостоятельно. Может ли Apple подстроиться под современную реальность, в которой системы с МО могут сами участвовать в дизайне продуктов?

«Это причина множества споров в компании,- говорит Федериги. – Мы привыкли выдавать очень продуманный и контролируемый опыт, в котором мы контролируем все измерения того, как система общается с пользователем. Когда ты начинаешь тренировать систему на основе большого набора данных по людскому поведению, получаемые результаты могут не совпасть с задумкой дизайнера. Они появляются на основе данных».

Но Apple не собирается отступать, говорит Шиллер. «Хотя такие технологии, конечно, влияют на разработку продуктов, в конце концов мы их используем для выпуска более качественных продуктов».

В результате, Apple может не делать объявлений о погружении в МО с головой, но она будет использовать как можно больше МО для улучшения продуктов.

«Типичный пользователь будет сталкиваться с глубоким обучением ежедневно, и это иллюстрирует то, что вам нравится в продуктах Apple,- говорит Шиллер. – Самые классные моменты настолько тонки, что вы задумываетесь о них только после третьей встречи с ними, и затем вы останавливаетесь, и восклицаете, 'Как это возможно?'».

Skynet подождёт.

Автор: SLY_G