Данная статья является реакцией на эту статью на Хабре. Это не подтверждение и опровержение того, что там написано. Скорее, мысли по поводу того, почему OpenAI ведет себя таким образом, а не каким-то другим, и что на самом деле показывает пример DeepSeek.

Скажу честно - сам DeepSeek не тестировал, и, очевидно, придется подождать где-то месяц минимум, прежде чем подкатят нормальные сравнения и бенчмарки (а не только те, что указал в релизе сам DeepSeek). Здесь скорее речь пойдет о ситуации, которую DeepSeek породил этим релизом.

Назад в будущее

Итак, год 1997. Netscape контролирует большую часть рынка веб-серверов со своими решениями. Но два конкурента быстро свели это преимущество на нет. Первый - это Microsoft со своим релизом IIS. Но более существенным был второй - Apache. Для интереса и приобщения к интернету 90-х можете перейти по ссылке на статью 1998 года об этом. Дело было не просто в появлении новых конкурентов. Дело было в появлении конкурента, представившего решение open-source, и это решение можно было использовать бесплатно. Ситуация изменилась радикально, и не только для Netscape. Microsoft со всей своей финансовой мощью и будучи на тот момент компанией № 1 в мире IT, уже не могла просто вышибить с рынка конкурента в виде Netscape и занять то положение, которое занимали они. По факту больше ни одна компания не могла мечтать о занятии монопольного положения в мире веб-серверов и привязке своих клиентов намертво к своим решениям.

И вот, четверть века спустя, ситуация в известной степени повторилась. Мы имеем (имели?) практически полную монополию в области генеративного ИИ со стороны OpenAI, пользующейся поддержкой все той же Microsoft. Точнее, эта монополия действовала до момента выхода DeepSeek.

Обычно, когда говорят об отличиях ChatGPT и DeepSeek, все сводят к техническим различиям. DeepSeek базируется на концепции смеси экспертов (Mixture of Experts или MoE). Иронично, что несколько месяцев назад я, не имея понятия о DeepSeek, и о самой этой концепции, переоткрыл в одном из комментариев велосипед и изложил эту самую идею для борьбы с галлюцинациями:

Я полагаю, нас ждут ансамбли LLM - где сначала 5 LLM генерируют решение. А затем три других LLM выбирают наиболее здравый вариант. Даже если каждая из них галлюцинирует, такой совместный контроль позволит ужать бред до приемлемых значений. Можно вообще жестко ввести правило полного консенсуса, что принимается только то решение, которое выбрали единогласно LLM на второй фазе. Если хоть кто-то выбрал другое решение, то привлекаем человека для разборки.

Однако ключевое отличие ChatGPT и DeepSeek не в этом, а в целеполагании, т.е. какие задачи ставит руководство перед авторами обеих систем.

Груз обязательств перед инвесторами

Название данной статьи - это отсылка к моей старой статье "Инфляция программного обеспечения". Там я возмущался тем, что программы становятся дороже с точки зрения потребления ресурсов, не прибавляя при этом в функционале. Во многом эта ситуация сложилась исторически в ходе естественного отбора нынешних зубров Кремниевой долины. Те, кто пытался сфокусироваться на удешевлении продукта (не в плане лицензий, а именно в плане затрат ресурсов оборудования конечных пользователей) проиграли тем, кто это игнорировал:

Джоэл Спольски в своей статье упоминает, что Microsoft удалось одержать верх над Lotus в 80-х годах в битве между Excel и 123 за счет того, что менеджеры Lotus допустили одну критическую ошибку — они попытались провести оптимизацию приложения. Конкретно они попытались ужать приложение так, чтобы оно всегда гарантированно умещалось в 640 Кбайт оперативной памяти. Они убили на это полтора года, и за это время Редмонд захватил рынок с помощью Excel, поскольку к этому моменту в строй вступали компьютеры с гораздо большими объемами оперативной памяти. Это решение очень дорого обошлось Lotus.

Да-да, та самая компания Microsoft 30-40 лет назад пришла к успеху и сформировала топ-менеджмента именно в данном направлении. Очевидно, что примерно в таком ключе мыслит и руководство OpenAI. Их ставка базируется на ожидаемом расширении аппаратной мощи, которая будет у них в наличии.

Проблема на самом деле несколько глубже, в данном случае. Проблема не просто в том, что Сэм Альтман и остальные топ-менеджеры OpenAI выросли и мыслят в такой парадигме. Проблема еще и в явных обязательствах перед инвесторами. Руководство Microsoft 80-х не вступало в явный сговор с производителями компьютеров. Билл Гейтс и его соратники просто здраво оценивали обстановку, размышляя "Смотрите, процессоры Intel c каждым годом все быстрее, планки памяти все дешевле. Делаем наши продукты, исходя из этого". Тогдашнему руководству Microsoft не пришлось добиваться расконсервирования АЭС для обеспечения своих проектов энергией. Тем более речи не стояло о такой инициативе, как Stargate. Давайте сами заглянем на официальную страницу OpenAI по этому поводу:

The Stargate Project is a new company which intends to invest $500 billion over the next four years building new AI infrastructure for OpenAI in the United States. We will begin deploying $100 billion immediately. This infrastructure will secure American leadership in AI, create hundreds of thousands of American jobs, and generate massive economic benefit for the entire world. This project will not only support the re-industrialization of the United States but also provide a strategic capability to protect the national security of America and its allies.

Заметили, о чем не говорится в этом пресс-релизе? Любой достаточно сложный инфраструктурный объект строится на основе некоторых предположений относительно будущего. Например, если мы строим АЭС, мы предполагаем наличие определенного числа потребителей энергии с АЭС, а также то, что в ближайшем будущем не появится альтеративного источника энергии, который сделал бы эту АЭС ненужной. Вот и Stargate строится на одном неявном предположении - что удешевления моделей в плане энергопотребления или чипов НЕ будет.

Конечно, явно этого нигде в официальных документах OpenAI не пишут, однако и задачи удешевления существующих моделей тоже не ставится, и это весьма симптоматично. Оно и понятно - авиакомпании будут проявлять интерес к разработке технологий, снижающих потребление топливо, но нелепо ожидать финансирования таких технологий со стороны нефтедобывающих компаний.

До инициативы Stargate OpenAI не являлась нефтедобывающей компаний в контексте ИИ - это скорее относилось к Nvidia. Собственно, достаточно было намека со стороны DeepSeek на возможность резкой экономии на топливе, чтобы капитализация Nvidia резко обвалилась.

Однако после объявления Stargate OpenAI оказалась в двойственном положении. Теоретически она могла бы ставить перед разработчиками задачу в стиле "Давайте-ка сделаем модель на урове 4o, но чтобы потребляла ресурсов вдвое меньше". На практике представить такое теперь сложно, поскольку это может вызвать панику среди потенциальных инвесторов и отток средств.

Не хочу ударяться в конспирологию, но это также создает для OpenAI, Microsoft и всех причастных к проекту мотивацию зорко следить за всеми потенциальными американскими стартапами в плане разработке альтернативных моделей с уменьшенным потреблением ресурсов и заранее скупать их на корню до выхода моделей на рынок. Пока что таких прецедентов в прессе не публиковалось, но они возможны. В конце концов, практика "купим стартап, чтобы не допустить выхода его на рынок" настолько распространена, что для этого даже термин есть - killer acquisitions.

Конспирологи могли бы даже предположить, что DeepSeek модель потому и была создана в КНР, что у OpenAI и Microsoft рычаги влияния в Китае отсутствуют. Кстати, о нем...

Про вечно отстающий Китай

Повторюсь еще раз, неясно, действительно ли DeepSeek так хорош, как утверждают его создатели. Подождем независимых бенчмарков на его сравнение.

Однако сам подход MoE является весьма перспективным. Если совсем вкратце - мы можем иметь модель общего уровня на 600 миллиардов параметров, а можем 8 моделей поменьше на 75 миллиардов параметров каждая. При поступлении очередного запроса можно определить, к какой из моделей он относится больше всего, и запустить ее, экономя вычислительные ресурсы. Насколько успешно DeepSeek реализовал этот подход - пока открытый вопрос, но сам подход и его потенциал вполне понятны любому программисту, имевшему дело со структурами данных типа quadtree - и как можно урезать пространство поиска и затраты по ресурсам на вычисление.

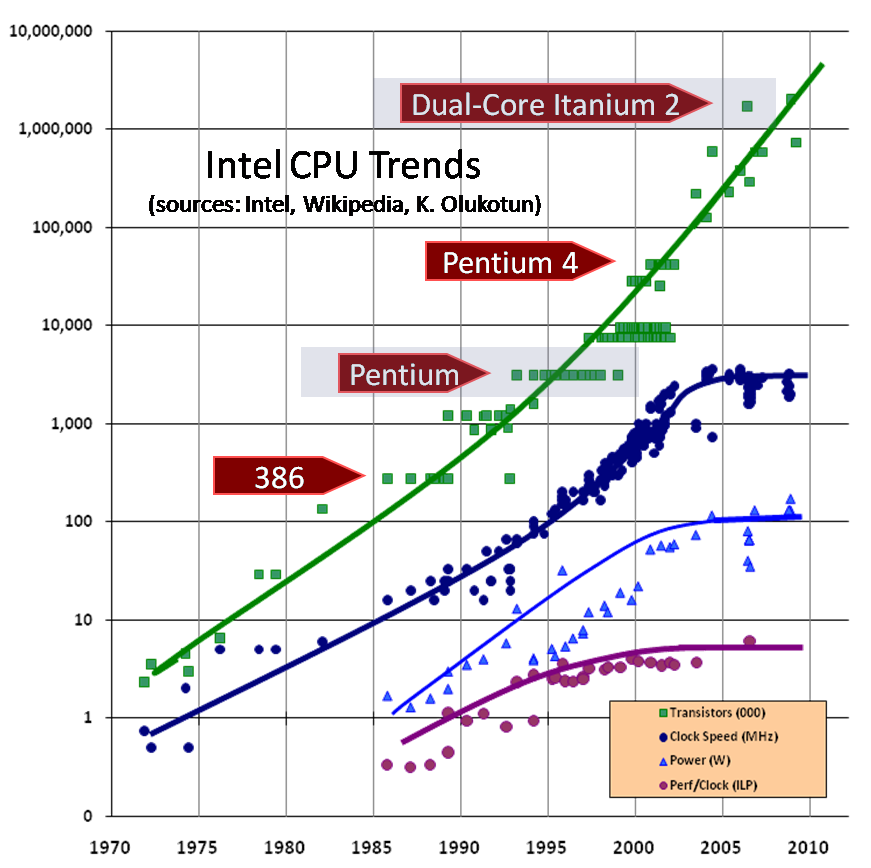

Однако за всем этим скрывается еще одна интересная тема. Обычно, когда говорят про современный AI, подразумевается, что без современных графических ускорителей тут никуда. Отсюда такой успех Nvidia. Давайте для начала взглянем на сей график:

Заметили нечто интересное насчет Intel процессоров? Да, пологий график, начиная с 2005-2006 годов для частоты процессоров и ILP. Прошло 20 лет, и мы до сих пор в тех же мобильных устройствах наблюдаем в характеристиках частоты в 1.8 Ггц. Мы сейчас не будем обсуждать технические причины этого, просто констатируем факт - с определенного момента мощность процессоров начала возрастать не за счет повышения тактовой частоты, а за счет увеличения числа ядер в процессоре и т.д. Зная это, присмотримся к ускорителям Nvidia - например, тот самый, который OpenAI и использует. Этот ускоритель работает на невероятной тактовой частоте в 1 Ггц и может быть разогнан аж до 1.4 Ггц. Это никоим образом не умаляет его достоинств, отнюдь. Просто надо кое-что понимать. Резкий рост капитализации Nvidia строится на нескольких обычно не формулируемых явно постулатах. Основной - что ИИ можно построить за счет скармливания все большего набора данных и это более перспективный путь, чем пытаться построить какие-то хитроумные алгоритмы. В наиболее явном виде это выразил автор фундаментальной книги по ИИ Питер Норвиг, бывший директор отдела исследований и качества поиска в Гугле:

Надо заметить, что Deepseek не то чтобы отклоняется от тренда, отмеченного Норвигом. Скорее они следуют второй его части, хитрым образом генерируя данные для обучения. Но здесь Норвиг ведет речь о качестве выдаваемого результата, а не оборудовании, которое нужно для полученной программы в итоге. Кроме того, конкретно в данном случае мы имеем потолок - OpenAI уже упирается в тот нехитырй факт, что данных, доступных для обучения новых моделей, осталось не так уж много, а тот же Китай имеет массу данных внутреннего пользования, на которых может обучать свои модели (типа материалов китайской академии наук и аффилированных научных учреждений).

Здесь вступает в силу второй постулат - чтобы обучать современный ИИ, нужно оборудование от Nvidia, на чем-то древнем такое сделать нельзя. Напоминаем, что обучение происходит на GPU - графических ускорителях. Графические ускорители, говорите?

Напомню, что второй терминатор вышел в 1991 и обладал спецэффектами, которые нисколько не смотрятся устаревшими даже сейчас. Понятно, что отнюдь не каждый фильм тех лет обладал такой графикой, и даже в самом фильме морфинг занимал суммарно три минуты, и стоил очень дорого. Однако это хороший пример того, что современную компьютерную графику можно сделать без всяких ускорителей от Nvidia.

Пример еще лучше, отмеченный самим Норвигом в его книгах и статьях - это первая область, в которой применили искуственный интеллект - шахматы.

Напомним, что времена, когда для шахматных программ нужны были суперкомпьютеры - давно прошли, и нынешние чемпионы мира по шахматам сливают программам, которые можно запустить и на мобильном телефоне, как, например, тот же Stockfish. Произошло это за счет применения более хитрых алгоритмов отсечения вариантов для перебора. Где гарантия, что это не произойдет и для генеративного ИИ?

Впрочем, даже если этого не произойдет, и для обучения и эффективной работы генеративного ИИ все равно будут требоваться графические ускорители, это не значит, что будущее Nvidia безоблачно. Напомню, что есть современные операционные системы, которые спокойно запустятся на старом добром 486-м.

Применительно к ИИ это означает вот что - интересный вопрос, на который я лично пока не знаю ответ (если кто в комментариях подскажет исследования по этому вопросу, буду очень признателен). Допустим, для обучения ChatGPT потребовалось, по грубым прикидкам,около 25 тысяч GPU A100. Сколько нужно для того же самого успеха взять ускорителей Nvidia образца 2015 года? При этом давайте еще ослабим ограничение по времени - если OpenAI натренировала модель за месяц, то давайте дадим на более слабой элементной базе 3 месяца - получится ли? На этот вопрос я нигде не мог найти явного ответа. В конце концов, нынешние модели появились не потому в 2022, что только в 2022 появилось оборудование, на котором это можно было сделать. А потому, что только в 2017-2018 появился математический аппарат GPT.

Можно взглянуть на это и по-другому. OpenAI выпускает очередную модель о4, о5, о6... Сколько времени будет уходить у китайских компаний (или тех же европейских), чтобы сделать путем дистилляции и MoE модель, показывающую себя не хуже или ненамного хуже, чем передовые разработки OpenAI, и работающую на устаревшем оборудовании? Если лет десять - то это не страшно. Но если в среднем полгода-год, как и произошло в случае с DeepSeek R1 - то это проблема с точки зрения потенциальных инвесторов в OpenAI и Nvidia. Проблема потому, что большинство кейсов применения ИИ в коммерции и не только не подразумевают необходимости именно последней, самой навороченной модели ИИ. В конце концов, те же военные работают на технике, где зачастую дай бог 65 нм используют.

OpenSource и Германская империя

В 1850-х Британия носила славное звание "мастерской мира". Однако к началу ХХ века она утратила это звание и начала резко уступать США и Германии. США оставим в покое, и присмотримся к Германии. Немецкая монархия, задавшись целью добиться индустриального преимущества, решила прижать к ногтю копирайт. И если в Британии книги порой издавались тиражом в 750 экземпляров, то в Германии ее могли издать тиражом в десятки тысяч. Это позволило, невзирая на меньшие ресурсы, чем у Британской империи, постепенно свести техническое превосходство Британии на нет.

Примерно это сделал DeepSeek, опубликовав не только модели в OpenSource, но и white paper c указаниями, как двигаться в дальнейшем направлении. Очевидная ставка на open source в данном случае со стороны китайских компаний, в отличие от OpenAI (которая ни разу не open).

Итоги

Так является ли ИИ сейчас пузырем, который так ловко схлопнул DeepSeek? Время покажет. После первого шока акции Nvidia вроде как оправились. Но прежде чем надумать инвестировать в них или в OpenAI, попробуйте ответить себе на вопросы:

-

Какова вероятность повторения ситуации с шахматами - появления программ ИИ, которые можно запустить с обычного мобильного, и для победы над чемпионом мира больше не потребуется суперкомпьютер?

-

Какова вероятность появления приемлемого ИИ - это когда топовая модель запускается только на новейших ускорителях от Nvidia, а модель, работающая на 85 процентов от топовой - запускается на обычном компьютере? И что, если эта вторая модель будет пригодная для большинства проблем, возникающих на практике?

-

Каков срок отставания - разрыва между появлением топовой модели, и такой же, только работающей существенно дешевле в плане прайса на токены?

Если ясных ответов на эти три вопроса нет - значит, есть хорошие основания полагать, что пузырь однажды лопнет. Возможно, оно и к лучшему, что Deep Seek выстрелил именно сейчас. Представьте, что было бы, если бы модель была опубликована, когда в Stargate успели бы вложить пару сотен миллиардов долларов. Тогда паника на рынках была бы куда круче.

Автор: spirit1984