«Наиболее совершенной моделью кота является такой же кот, а лучше — он сам» (Норберт Винер)

«Природу невозможно описать полностью, ведь такое описание природы должно было бы в точности воспроизводить природу» (Арчи Бам)

«Компьютеры — это физические системы: законы физики диктуют, что они могут и чего не могут делать. В частности, скорость, с которой физическое устройство может обрабатывать информацию, ограничено его энергией, а количество информации, которое оно может обработать, ограничено количеством степеней свободы, которыми оно обладает» (Ханс-Йоахим Бремерманн)

«Вселенная вычисляет свою собственную судьбу» (Джеймс Глейк)

Как мы выяснили в предыдущей статье, панкомпьютерализм и вычислительные теории всего – одно из мейнстримных направлений в современной теоретической физике. Но одно дело – чисто философские идеи вроде «а что, если Вселенная – квантовый компьютер?», другое дело – математические расчёты, которые могут эту идею подкрепить. Без понимания физических пределов вычислений любая онтологическая модель очень быстро вырождается в мистическую «теорию чего угодно», весьма далёкую от науки. Ведь если Вселенная способна производить вычисления, с таким же успехом она может быть нейросетью и даже мыслить. Отсюда уже недалеко до эзотерической веры в живую, самосознающую и разумную Вселенную, которая нас слышит, откликается на наши запросы, исполняет наши желания и посылает нам знаки. Что это – проявление первобытного анимизма и магического , светская замена патриархальному Богу или научно обоснованное знание? Для ответа на этот вопрос нам нужно подробно разобрать гипотезу «всё из кубита», определить, что, как и на каком компьютерном «железе» Вселенная вычисляет, похожа ли космическая паутина сверхскоплений галактик на структуру

Панкомпьютерализм против космопсихизма

В эзотерическом информационном пузыре популярна идея, что Вселенная является гигантским

В оправдание космопсихизма часто приводится очевидное сходство крупномасштабной структуры Вселенной с нейронными сетями нашего

«Наш анализ показал, что распределение флуктуаций в нейронной сети мозжечка в масштабе от 1 микрометра до 0,1 мм следует той же прогрессии распределения материи в космической паутине, но, конечно, в большем масштабе, который простирается от 5 миллионов до 500 миллионов световых лет»

«Вероятно, самоорганизация в обеих системах формируется схожими принципами сетевой динамики, несмотря на поразительную и очевидную разницу между физическими силами, регулирующими галактики и нейроны»

В предыдущей статье «Квантовый панкомпьютерализм против цифровой физики» мы сделали обзор теорий, которые рассматривают Вселенную как классический или квантовый компьютер. Как мы видим по происходящим событиям, от простого компьютера всего один шаг к искусственному интеллекту, при наличии необходимой для этого вычислительной мощности и программного обеспечения. Мы не будем сейчас обсуждать вопрос, имеет ли смысл наделять искусственный интеллект субъектностью, агентностью, разумом или сознанием. Просто примем за основу тезис Чёрча-Тьюринга, согласно которому компьютер, сравнимый по мощности с человеческим

Для сравнения рассчитаем технические характеристики компьютера, который находится у нас в голове. Человеческий

С одной стороны, у неё есть преимущество – для передачи сигналов Вселенной не нужны синапсы и нейромедиаторы, достаточно обычных фотонов, летящих в пустом пространстве со скоростью 300000 км/с. Для нас скорость света огромна, но, с другой стороны, по космическим меркам это очень медленно. Если бы

А если Вселенной просто некуда спешить, и она может позволить себе думать одну мысль миллиарды лет? Ну как же – спешить есть куда. Галактики взаимно удаляются из-за ускоренного расширения Вселенной, что делает невозможным регулярный обмен информацией между ними, особенно когда они пересекают взаимный горизонт событий. Космическая паутина, которую мы сейчас видим – это сеть галактических сверхскоплений в масштабах до 100 мегапарсек (300 млн св. лет), на большем расстоянии Вселенная в соответствии с космологическим принципом становится однородной и изотропной. Если тёмная энергия продолжит ускорять расширение Вселенной, примерно через 100 млрд лет она разорвёт все нити (филаменты) и превратит крупномасштабную структуру Вселенной в ковёр из отдельных галактик и скоплений, не связанных между собой, а через 150 млрд лет все галактики, кроме нашей местной группы, уйдут за космологический горизонт. То есть космическая паутина – явление временное и неустойчивое. А её сходство с нейросетью обусловлено вторым законом термодинамики и диссипативной самоорганизацией, о которой я писал в статье «Теория хаоса, синергетика, неравновесная термодинамика». Аналогичные фрактальные паттерны можно увидеть повсюду: рябь на поверхности воды, расположение городов и соединяющих их дорог, грибные сети в почве и т.д.

А может, разум Вселенной использует какие-то другие способы передачи и обработки информации? Например, червоточины или нелокальные связи между квантово запутанными частицами, позволяющие обойти запрет на преодоление скорости света? Нет, квантовая запутанность не позволяет мгновенно передавать информацию из одного уголка Вселенной в другой без классического локального канала связи – об этом я уже говорил в статье «Жуткое дальнодействие». К тому же сильная ЭПР-запутанность двух частиц разрушается, если эти частицы взаимодействуют со средой, т.е. подвергаются декогеренции. Квантовая теория также допускает «слабую» многочастичную запутанность, при которой информация распределяется по системе. Такая запутанность может поддерживаться даже между удалёнными макроскопическими объектами, не взаимодействовавшими со времён Большого взрыва, но использовать её для передачи информации и тем более вычислений никак не получится. Квантовая запутанность не доказывает нелокальную связь всего со всем и нисходящую причинность, как я уже объяснял в статье «Вселенная - голограмма?». Там же мы обсуждали гипотезу ER=EPR, согласно которой проходимые червоточины эквивалентны многочастичной квантовой запутанности. Однако, как показал Арон Уолл в статье «The Generalized Second Law implies a Quantum Singularity Theorem», обобщённый второй закон термодинамики Бекенштейна исключает возможность существования проходимых червоточин, варп-двигателей, замкнутых времениподобных кривых и других способов сверхсветовых путешествий на машине времени.

Таким образом, разумом или самосознанием компьютер наподобие нашей Вселенной обладать не может. Идея о Вселенной как о гигантском разумном организме, который живёт и размышляет – не более чем метафора, как и «гипотеза Геи» о Земле как живом существе. Вселенная устроена гораздо проще, чем человеческий

Ок, Вселенная не является разумной нейросетью, её «транзисторы» переключаются и обрабатывают информацию гораздо быстрее, чем передают. Но что, если Вселенная – это не последовательный, а параллельный многоядерный процессор, или скорее даже распределённая сеть компьютеров – галактик, звёздных систем, планет, которые производят грид-вычисление без необходимости обмена информацией? Просто они ещё на стадии Большого взрыва получили на вход один и тот же алгоритм, и с тех пор вычисляют каждый в своём локальном участке пространства, порождая в итоге жизнь и разум. Это уже гораздо более реалистичная картина, объясняющая появление сложности по крайней мере в нашем уголке Вселенной. Но достаточно ли у космологического компьютера вычислительных ресурсов, чтобы смоделировать Вселенную такой, какой мы её знаем? Соответствующие расчёты провёл Сет Ллойд, нынешний профессор Массачусетского технологического института, в статьях «Абсолютные физические пределы вычислений» (2000), «Вычислительная мощность Вселенной» (2001) и в книге «Программируя Вселенную» (2006). На эти источники мы будем опираться в следующих разделах.

Как Вселенная вычисляет

Итак, можно ли вычислить всю наблюдаемую Вселенную за конечное время и симулировать её на универсальном компьютере? Ну конечно – скажете вы – есть же достаточно подробные компьютерные симуляции эволюции всей наблюдаемой Вселенной и отдельных её участков. Например, сделанная в 2021 г. на суперкомпьютере ATERUI II симуляция Учуу содержит 2,1 триллиона "частиц" тёмной материи в пространстве диаметром 9,6 млрд св. лет. На неё было израсходовано 20 млн суперкомпьютерных часов и сгенерировано 3 петабайта данных. В 2023 г. на суперкомпьютерном кластере в Университете Дурхан в Великобритании была создана ещё более впечатляющая симуляция FLAMINGO, охватывающая как тёмную, так и барионную материю в объёме, эквивалентном кубу со стороной 9,1 млрд. св. лет. Ну а крупнейшей на сегодняшний день является симуляция MilleniumTNG, охватывающая 10 млрд св. лет с разрешением около 2*107 масс Солнца и занимающая эксабайты памяти. Но во всех подобных моделях масштаб в лучшем случае упирается в отдельные звёзды – всё, что меньше, просто не оказывает никакого влияния на динамику галактической эволюции. Нас же интересует полная симуляция Вселенной вплоть до субатомных масштабов, чтобы учитывалось квантовое состояние каждой элементарной частицы.

Чтобы ответить на вопрос: «может ли Вселенная симулировать саму себя?», мы примем за основу тезис Чёрча-Тьюринга-Дойча: «каждая конечная доступная пониманию физическая система может быть полностью симулирована с помощью универсальной машины Тьюринга». Также нам пригодится голографический принцип, согласно которому, как пишет Сет Ллойд, «…любая физическая система, ограниченная конечным объёмом пространства и конечным количеством энергии, имеет конечное число различимых состояний и поэтому содержит конечное число битов». Наблюдаемая вселенная в пределах космологического горизонта конечна во времени и пространстве, поэтому её можно идеально смоделировать на универсальном квантовом компьютере такого же размера и мощности. Симуляция будет неотличима от самой наблюдаемой вселенной, а значит, наблюдаемая вселенная является квантовым компьютером, как и предполагает гипотеза «всё из кубита». Когда одна часть Вселенной – например, наблюдатель, - проводит измерение другой её части, это аналогично квантовой операции, когда один регистр кубитов получает информацию о другом регистре.

Насколько справедливо такое расширенное определение вычисления – вопрос открытый. Обычно под вычислением понимают обработку информации – осуществление логических операций над (ку)битами, или преобразование входящего потока информации в отличный от него выходящий. Типичные примеры вычислений – решение математических уравнений и выполнение компьютерных алгоритмов. В принципе под определение вычисления подходят любые физические процессы: если рассматривать элементарные частицы как кубиты, а уравнения квантовой теории поля – как алгоритмы, каждое взаимодействие частиц – это обработка информации, универсальная по Тьюрингу. Как показали Эдвард Фредкин из Университета Карнеги-Меллона и Томмазо Тоффоли из Бостонского университета, булевы логические операции «и», «или», «не» и «копировать» естественным образом реализуются столкновениями атомов. Универсальный компьютер можно построить хоть из молекул газа, хоть из бильярдных шаров, если сообщать им соответствующие начальные положения и скорости, хоть из лазера и полимеров, как я показывал в статье «Квантовые эксперименты на дому».

Поскольку у нас нет рабочей теории квантовой гравитации, оцифровать искривление пространственно-временного континуума мы не сможем. Придётся ограничится моделированием статичной во времени Вселенной без гравитационного взаимодействия. Также нам неизвестна природа тёмной материи и тёмной энергии – их мы тоже учитывать не будем. Хотя на них и приходится соответственно 25% и 70% массы наблюдаемой вселенной, это величины одного порядка с массой барионного вещества (5%). С точки зрения вычислительной парадигмы тёмной материей и энергией можно и пренебречь, поскольку плотность этих субстанций невелика, и они практически не взаимодействуют как с барионной материей, так и сами с собой. Тёмная материя влияет только на формирование и эволюцию галактик, а тёмная энергия – на ускоренное расширение Вселенной. Но основную часть вычислений осуществляет обычное вещество, состоящее из атомов. Значит, сосредоточимся только на известных элементарных частицах. Как их можно оцифровать?

Самый простой способ цифровой записи – двоичный код. Каждую элементарную частицу можно представить как набор битов информации. Их количество будет соответствовать числу степеней свободы, таких как спин, поляризация, координата, импульс и т.д. Взаимное расположение частиц нас не интересует, поэтому Сет Ллойд исходит из простого расчёта – 1 бит на элементарную частицу. Частица выступает в качестве логического элемента, кодируя информацию своим спином (моментом импульса), который может менять значение с 0 (вверх) на 1 (вниз), осуществляя тем самым простейшую вычислительную операцию (инверсию). В каком базисе измеряется спин – не имеет значения, поскольку на выходе его значение в любом случае дискретно.

Каждое взаимодействие частиц – это логическая операция в гильбертовом пространстве волновых функций, преобразующая одно квантовое состояние в другое. Само квантовое состояние (волновую функцию) между двумя взаимодействиями оцифровать нельзя, но на «входе» и «выходе» этого чёрного ящика квантовые операторы принимают дискретные значения. Другими словами, измерение частицы (кубита) в определённом базисе всегда даёт результат в битах: спин направлен вверх или вниз, поляризация вертикальная или горизонтальная, частица проходит через левую или правую щель и т.д. Вот эти биты мы и будем рассматривать как фундаментальные единицы информации. Естественно, далеко не каждое взаимодействие частиц изменяет значение бита на противоположное. С подачи Сета Ллойда будем считать так: физическая система выполняет операцию всякий раз, когда она прикладывает достаточно энергии в течение достаточного времени, чтобы инвертировать бит.

Теперь мы можем немного уточнить наш первоначальный вопрос. Если каким-то образом собрать всю материю в пределах космологического горизонта и заставить её вычислять, сколько информации обработает такой компьютер за время существования Вселенной – 13,8 млрд лет? И может ли компьютер размером с наблюдаемую Вселенную вычислить результаты измерений всех её частиц, т.е. смоделировать сам себя? Ответ вы узнаете чуть позже, а пока нужно сказать пару слов о пределах вычислений.

Физические пределы вычислений

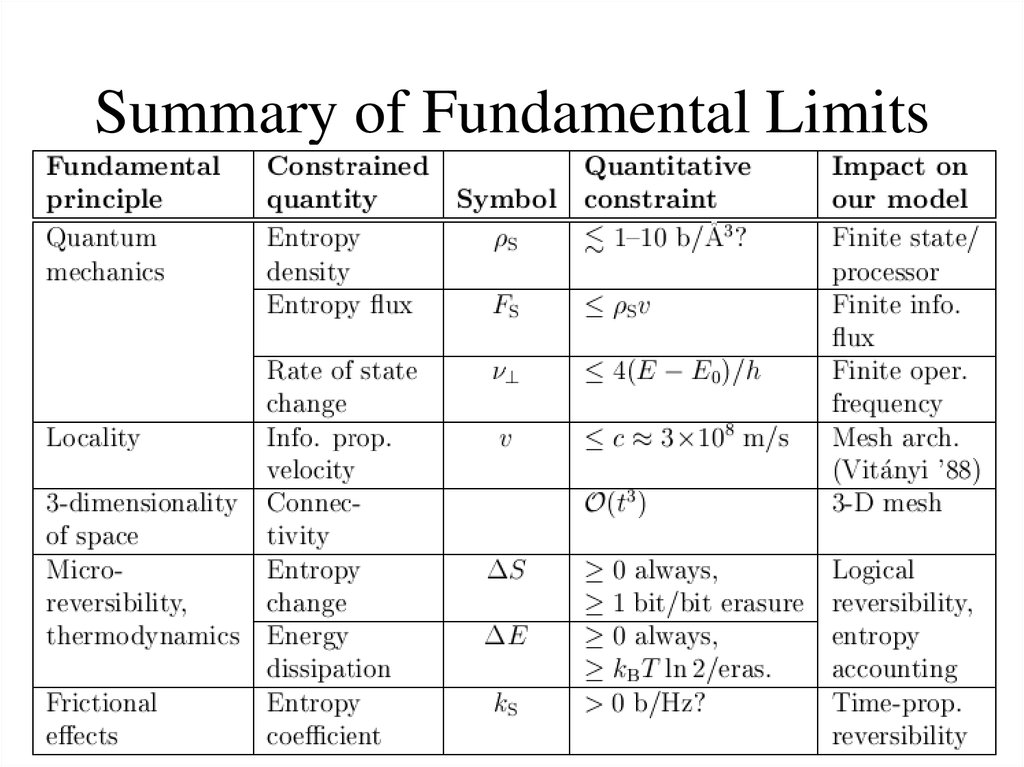

Существуют универсальные пределы вычислений, которые распространяются как на классические, так и на квантовые компьютеры. Они устанавливаются не информатикой и не математикой, а физикой мира, в котором мы живём. Это ограничения скорости обработки информации (операций/с), количества доступной энергии-массы (Дж или кг), плотности хранения информации (бит/см3), пропускной способности канала связи (бит/см2с), памяти (бит) и времени вычисления (с). Они определяют максимум того, что может сделать универсальный компьютер в нашей Вселенной. Один предел мы уже рассмотрели – это скорость света (2,98*108 м/с), ограничивающая передачу информации на расстояние. Сет Ллойд берёт за основу ещё три фундаментальных предела, ограничивающие скорость вычислений и память компьютера: предел Бремерманна, предел Бекенштейна и предел Ландауэра. Если учитывать их в совокупности, вычислительная мощность физической системы может быть подсчитана как функция количества доступной системе энергии-массы вместе с размером этой системы.

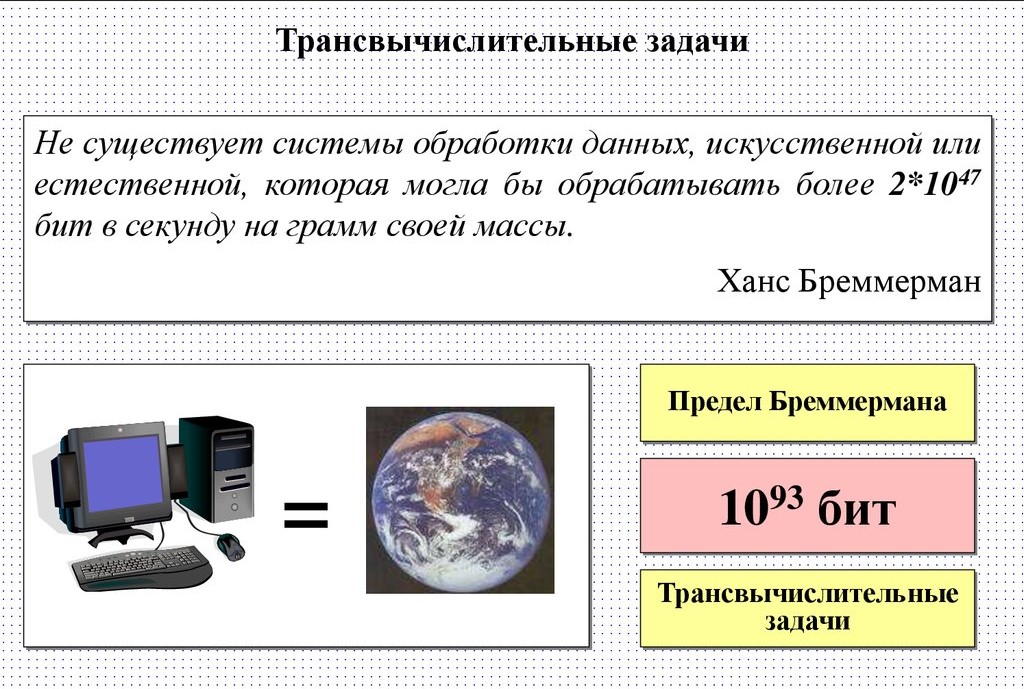

Предел Бремерманна – это верхний предел количества операций, которые может выполнить за секунду система с определённой массой. Он выводится из принципа неопределённости Гейзенберга (∆E∆t = h/2) и эйнштейновской формулы эквавалентности энергии-массы (E = mc2). Поскольку время, необходимое для изменения значения бита, зависит от величины прилагаемой энергии (t ≥ h/4E), работа универсального компьютера дискретна во времени, а вычислительная мощность масштабируется с массой компьютера. Согласно Бремерманну, максимальная скорость вычисления составляет c2/h = 1,36*1050 бит в секунду на килограмм. На такой скорости работает излучение Хокинга испаряющейся чёрной дыры массой 10-31 г (меньше массы электрона). Любой физической системе требуется некоторое время, чтобы она перешла из одного состояния в другое – мгновенные квантовые переходы невозможны.

Обобщением предела Бремерманна на квантовые системы является квантовый предел скорости (QSL), или предел Маргаре. Он устанавливает минимальное время для перехода между двумя чётко различимыми (ортогональными) состояниями кубита – например, инверсии спина с направления вверх в направление вниз: t ≥ ℏ/2∆E. Но есть также квантовый предел скорости перехода между не полностью различимыми состояниями произвольной широты и долготы, будь то на сфере Блоха или внутри неё, для всех возможных состояний спина.

Предел Бремерманна тесно связан с теоремой Марголуса-Левитина, сформулированной в 1998 г. Норманом Марголусом из Массачусетского технологического института и Львом Левитиным из Бостонского университета. Теорема утверждает, что максимальная частота, с которой (ку)бит может переключаться из одного состояния в другое (ортогональное), пропорциональна энергии системы: t ≥ πℏ/2E. Для совершения элементарной операции за время ∆t требуется энергия E не менее πℏ/2∆t. Чтобы узнать максимальную частоту вычисления, нужно взять общее количество энергии системы, умножить его на 4 и разделить на постоянную Планка: ν = 4E/ℏ. Соответственно система со средней энергией Е может выполнить не более 2E/πℏ логических операций в секунду. Исходя из этого, за каждый джоуль энергии можно выполнить не более 6*1033 операций в секунду.

В современной физике частицы рассматриваются как колебания квантовых полей. Пространство состояний включает совокупность вибраций этих полей со всеми возможными длинами волн. Как я уже объяснял в статье «Фрактальное самоподобие Вселенной», минимально возможная длина волны равна планковской длине, а максимальная – диаметру наблюдаемой Вселенной. Поскольку Вселенная расширяется, а планковская длина остаётся неизменной, в нашем мире может происходить всё больше разных событий, и в нём помещается всё больше разных типов волн. То есть пространство состояний увеличивается, и для описания нынешней Вселенной нужно гораздо больше информации, чем для описания однородной и горячей ранней Вселенной.

А сколько информации (энтропии) может поместиться в некотором объёме пространства? Если вы думаете, что неограниченно много, то вы ошибаетесь. Информация сама по себе нематериальна, но она не существует без вещественного носителя, а много вещества в одном месте сконцентрировать не получится. В качестве примера возьмём замкнутый контейнер, заполненный газом в состоянии термодинамического равновесия – максимальной энтропии для его объёма. Если увеличить объём контейнера в два раза, энтропия тоже вырастет в два раза, потому что у молекул газа будет больше пространства для хаотичного движения. А если снова уменьшить контейнер, система станет упорядоченнее, и энтропия снизится? Нет, энтропия увеличится, потому что энергия, которую мы затратили на расширение и сжатие контейнера, перейдёт в тепло и нагреет газ. А если, не меняя объёма контейнера, закачать туда в два раза больше газа? Произойдёт то же самое, что и при сжатии – давление увеличится, газ нагреется, и энтропия станет в два раза выше, соответственно для описания такой системы потребуется в два раза больше информации. Увеличивая плотность вещества дальше, мы рано или поздно дождёмся момента, когда его гравитационный радиус сравняется с размерами контейнера, и всё вещество коллапсирует в чёрную дыру. Более плотно упаковать вещество уже невозможно – дальше придётся с ростом массы расширять горизонт событий.

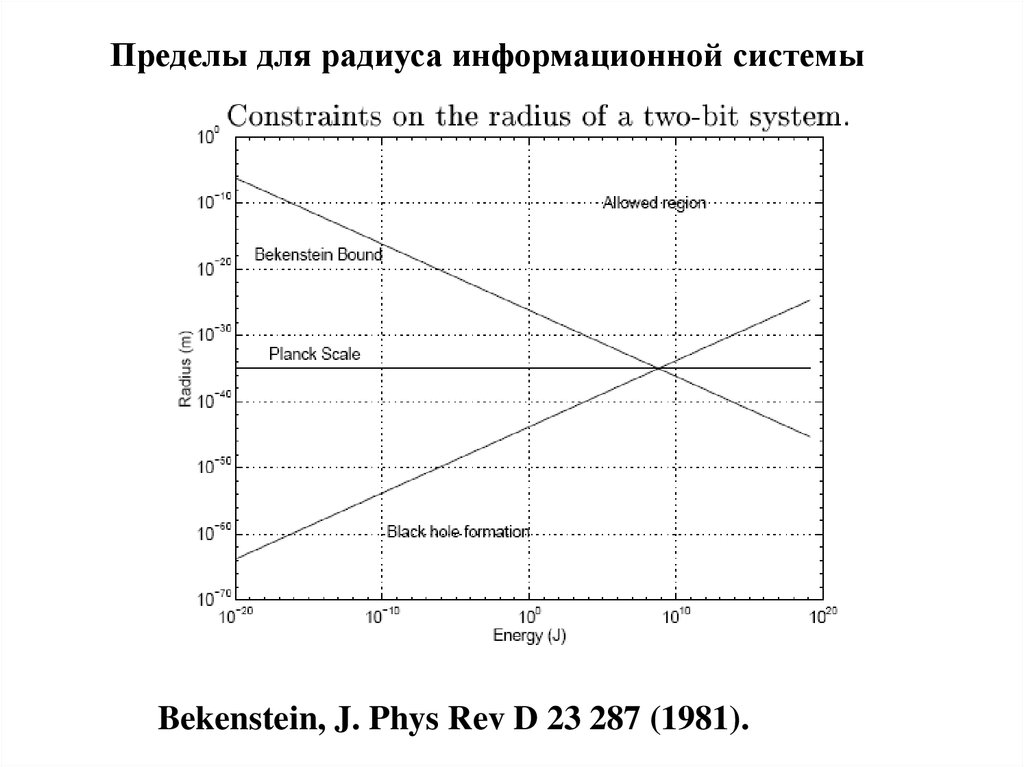

Здесь начинает действовать голографический принцип, о котором я писал в статье «Вселенная – голограмма?». Согласно формуле Бекенштейна-Хокинга, количество информации (энтропии), помещающейся в заданном объёме пространства, ограничено площадью поверхности этого пространства, выраженной в квадратах планковской длины: S = A/(2Lp)2 = 2πkRmc/ℏ. Неважно, какого объёма сфера, главное – сколько на её границе планковских ячеек. Это значит, что полное пространство состояний любой пространственно конечной квантовой системы конечно, т.е. она может содержать только конечное число (ку)битов. Предел Бекенштейна задаёт максимальное количество информации, которое вы можете записать в системе определённого размера. 30 лет назад ёмкость жёстких дисков составляла всего 1 Гб, сейчас у нас есть твердотельные SSD-накопители ёмкостью 60 Тб. У молекулы ДНК ёмкость в 3500 раз больше – при весе 1 г/см3 она может хранить до 214 Пб (5.6*1015 бит) на одном см3. Но это ничто по сравнению с устройством аналогичного размера (1 см3), находящимся на пределе Бекенштейна – на нём можно записать S = kc3V/ℏG = 1.6*1038 бит.

Исходя из предела Бекенштейна, максимальный объём информации, необходимый для идеального описания физической системы вплоть до квантового уровня, вычисляется по формуле I = S/kln2 = 2πER/ℏcln2 = 2.58*1043mR, где m – масса системы в килограммах, а R – радиус в метрах. В классическом приближении количество информации в системе равно её термодинамической энтропии, а в информатике есть своя энтропия Шеннона, отображающая количество информации в сообщении. Энтропии Шеннона и Больцмана – родственные величины, но они подсчитываются для разного числа степеней свободы: например, у транзистора их всего две (0 и 1) по Шеннону, а по Больцману их число пропорционально количеству составляющих транзистор частиц. Поэтому флэшка с кремниевым микрочипом на 1 Гб имеет энтропию Шеннона порядка 1010 бит, а термодинамическая энтропия того же чипа при комнатной температуре – порядка 1023 бит.

Наконец, давайте вспомним из статьи «Информация об информации», что такое предел Ландауэра, и увидим, как соотнести энтропию с компьютерными вычислениями. Масса пропорциональна энергии (E=mc2), а энергия напрямую связана с энтропией. Согласно принципу Ландауэра, существует нижний предел энергии, которую необходимо затратить для осуществления одной необратимой вычислительной операции (стирания бита). Он равен произведению константы Больцмана k (1,38*10-23 Дж/К), рабочей температуры T и натурального логарифма от 2: E = kTln2. Получается, при стирании одного бита информации при комнатной температуре выделяется как минимум 2.7*10-21 Дж тепловой энергии, соответственно один бит информации «весит» 3.19*10-38 кг. Хотя предел Ландауэра и можно обойти с помощью обратимых вычислений, на практике он работает даже для квантовых компьютеров, если число кубитов ограничено. Классическим компьютерам до предела Ландауэра ещё далеко – они потребляют гораздо больше энергии и работают не так быстро, как могли бы. Но теоретически компьютерная память, работающая при комнатной температуре на пределе Ландауэра, может изменяться со скоростью 1 млрд бит в секунду, при этом энергия преобразуется в тепло в носителе памяти со скоростью всего 2,85 пДж/с (2,85 триллионных ватта).

Экстремальные вычисления: предельный ноутбук и сингулярный компьютер

В статье «Чёрнодыровой компьютер», опубликованной в 2004 г. в журнале Scientific American, Сет Ллойд и Джек Энджи сравнили возможности обычного компьютера, «предельного ноутбука» и «сингулярного компьютера». Они взяли за ориентир современный ноутбук массой 1 кг и объёмом 1 л, работающий с частотой 109 Гц и обладающий памятью порядка 1 Тб (1012 бит). Предельным ноутбуком назвали устройство такой же массы и объёма, работающее на пределе вычислительных возможностей. Его частота составляла бы 1020 Гц или 100 ГГц, а память – 1031 битов. В свою очередь сингулярный компьютер – это чёрная дыра массой 1 кг и радиусом 10-27 м, занимающая объём меньше размеров протона. Частота такого «компьютера» составляла бы 1035 Гц, а память – 1016 битов.

Предельный ноутбук – это литровый куб горячей плазмы, в котором информация закодирована в положениях, импульсах и спинах частиц, а логические операции выполняются путём столкновений частиц. Источником питания служит вещество, полностью преобразуемое в энергию по формуле E=mc2. Преобразование 1 кг вещества в объёме 1 л даёт 1017 Дж энергии, температуру 1 млрд К и энтропию 1031 битов, что эквивалентно взрыву 20-мегатонной водородной бомбы. Если всю эту энергию направить на вычисление, компьютер сможет выполнять 1051 операций в секунду. Согласно теореме Марголуса-Левитина, предельный ноутбук может инвертировать каждый свой бит с невероятной скоростью 30 трлн раз в секунду. Для сравнения, обычный компьютер делает это в 10000 раз медленнее и тратит на зарядку и разрядку транзисторов в миллиард раз больше энергии. Но обмен данными будет проходить не так быстро: каждая частица может переключаться всего за 10-20 с, а сигнал за это время пройдёт не более 3*10-12 м – среднего расстояния между частицами. Поэтому предельный ноутбук будет состоять из множества отдельных процессоров и работать в параллельном режиме.

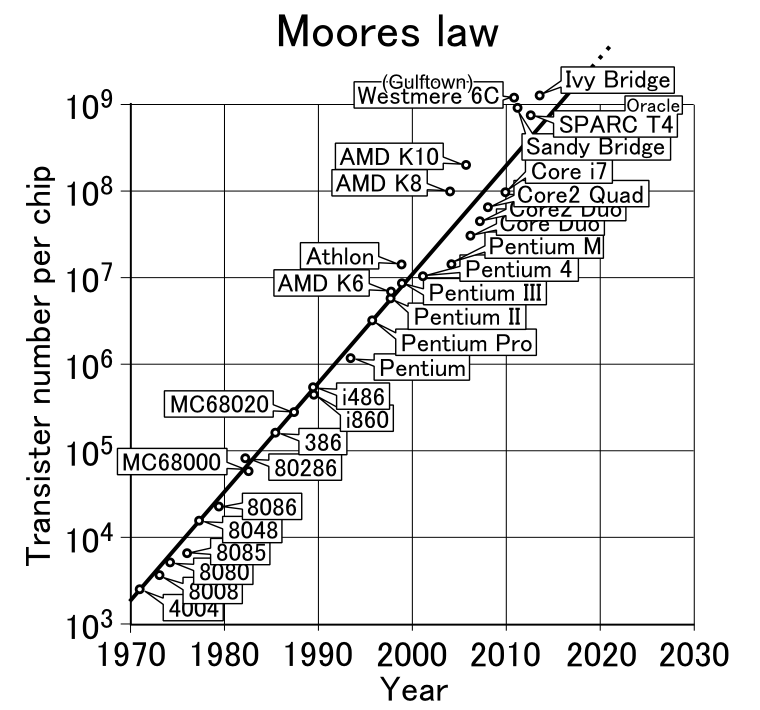

Сет Ллойд называет условия внутри предельного ноутбука «маленьким кусочком Большого взрыва» и отмечает, что для его «упаковки» потребовался бы технологический прорыв – сегодня на порядки менее горячую плазму (100 млн градусов) в термоядерных реакторах с большим трудом удерживают 20 минут. А для управления битами, исправления ошибок и программирования такого компьютера необходимы сверхточные лазеры широкого диапазона частот. В ходе вычисления предельный ноутбук постепенно теряет энергию и замедляется, а чтобы узнать результат, нужно измерить и расшифровать состояния частиц на выходе. По всем параметрам предельный ноутбук будет напоминать релятивистские ускорители частиц высокой энергии. Но если не перестанет работать закон Мура, согласно которому вычислительная мощность компьютеров удваивается каждые 18 месяцев, при текущей скорости технического прогресса мы сможем купить предельный ноутбук в магазине к началу XXIII века, а предельный жёсткий диск – всего через 55 лет.

Звучит как фантастика, но Сет Ллойд идёт ещё дальше и утверждает, что в качестве вычислительной машины или хранилища данных можно использовать чёрную дыру, если разработать технологию извлечения из неё информации, воспользовавшись будущей теорией квантовой гравитации. Сингулярный компьютер – одноразовое устройство: на вход подаётся материя, некая программа задаёт точный сценарий её коллапса в чёрную дыру, которая за доли секунды взрывается вследствие испарения и выдаёт на выходе излучение Хокинга, регистрируемое детекторами и анализируемое компьютерами. В отличие от предельного ноутбука, сингулярный компьютер выполняет последовательное вычисление одним процессором – время, необходимое на переключение одного бита (10-35 с), у него равно времени преодоления фотоном расстояния от края до края. Но сингулярный компьютер располагает гораздо меньшей памятью, чем аналогичное устройство до коллапса, поскольку энтропия чёрной дыры пропорциональна не объёму, а площади её горизонта. По расчётам Ллойда, искусственная чёрная дыра массой 1 кг и радиусом 1,485*10−27 м просуществует всего 10−19 секунд, но за это время на предельной скорости 5*1050 операций в секунду и при температуре порядка 109 K она успеет выполнить около 1032 операций с 1016 битами информации.

Идея сингулярного компьютера достаточно интересная, но практически не реализуемая. Построить сингулярный компьютер в принципе можно, а вот как извлечь из него информацию – большой вопрос. В статье «Решения информационного парадокса чёрных дыр» я объяснял, что чёрные дыры являются эффективными скремблерами, т.е. они быстро перемешивают информацию и делают её нечитаемой. Чтобы расшифровать полученный таким компьютером ответ по излучению Хокинга, придётся построить квантовый компьютер, закодировать состояние каждого фотона его кубитами и с помощью алгоритмов квантового машинного обучения смоделировать на нём чёрную дыру, что займёт гораздо больше времени, чем испарение чёрной дыры естественным путём. В случае с микроскопической чёрной дырой это может быть и недолго, но испаряется она взрывообразно, так что поймать каждую частицу будет непросто. Подобным образом сейчас ловят на детекторах продукты распада сверхтяжёлых частиц, образующихся при столкновениях на Большом адронном коллайдере. При этом работа коллайдера длится каких-то полчаса, а расшифровка результатов на компьютерах занимает месяцы. Но вернёмся к нашему основному вопросу: может ли Вселенная симулировать полную копию самой себя в своём текущем состоянии?

Может ли Вселенная вычислить саму себя?

У нас уже есть три фундаментальных предела, не хватает только данных об энергии, массе, энтропии и количестве частиц в наблюдаемой вселенной. Восполним этот пробел. Наблюдаемая космическая плотность энергии – около 10-9 Дж/м3, соответственно общее количество энергии в пределах космологического горизонта – порядка 1071 Дж. Если подставить это число в формулу скорости Марголуса-Левитина 2E/πℏ, получается, что компьютер размером с наблюдаемую Вселенную способен выполнять не более 10105 операций в секунду. Максимальное число операций, которые он мог бы осуществить за всю историю Вселенной (13,8 млрд лет) – 10122. Материя обладает наибольшей информационной ёмкостью, когда она преобразована в безмассовые частицы высокой энергии (фотоны и нейтрино), плотность энтропии которых пропорциональна кубу их температуры, а плотность энергии (определяющая число операций, которое они могут выполнить) пропорциональна четвёртой степени от температуры. Поэтому Сет Ллойд оценивает общее количество битов в 1092, что равно числу операций (10122), возведённому в степень три четверти: I = S/kln2 = 4E/3ln2kT = (ρc5t4/ℏ)3/4, где S – термодинамическая энтропия, k – константа Больцмана, E – энергия, ρ – плотность Вселенной, c – скорость света, t – возраст Вселенной, c3t3 – объём наблюдаемой вселенной.

Теперь давайте выясним, какой у Вселенной объём памяти и хватит ли его, чтобы записать эти биты. Для начала посчитаем, сколько всего во Вселенной частиц. Если взять среднюю плотность космического пространства (1 атом на м3), включая звёзды и межзвёздный газ, но не принимая в расчёт тёмную материю и тёмную энергию, наблюдаемая Вселенная состоит примерно из 1080 протонов и такого же количества электронов. В совокупности с нейтрино и всеми видами излучения (фотонами), в том числе реликтовым излучением, общее количество частиц во Вселенной – порядка 1090. Столько бит информации можно записать на жёстком диске, состоящем из всей материи в пределах космологического горизонта. Но достаточно ли 1090 битов, чтобы полностью смоделировать нынешнюю Вселенную? Нет. Такой энтропией Вселенная обладала в первые секунды Большого взрыва, и в то время для её описания хватило бы 1090 битов. В дальнейшем количество частиц (энергии) остаётся постоянным, а степеней свободы становится больше: Вселенная расширяется – энтропия растёт.

А какова максимально возможная энтропия для наблюдаемой Вселенной? Она будет равна энтропии чёрной дыры такого же размера. Обозримая Вселенная – это сфера радиусом 47 млрд св. лет, площадь поверхности у неё – около 1054 м2, соответственно максимальная энтропия для неё – порядка 10123. Нам до такого значения ещё далеко. По оценкам астрофизиков Чеса Эгана и Чарльза Лайнуэвера из Австралийского национального университета (см. их статью «Увеличенная оценка энтропии Вселенной», 2009), на сегодняшний день энтропия Вселенной составляет порядка 10104. В сравнении с этим числом исходная энтропия 1090 – это очень и очень мало, хотя на тот момент она была близка к максимальной для соответствующего объёма. Столько же информации (энтропии) можно уместить в чёрную дыру размером со Стрелец А*, расположенную в центре нашей галактики. Почему чёрные дыры обладают гигантской энтропией, я объяснял в статье «Термодинамика чёрных дыр»: огромное число микросостояний частиц, оказавшихся под горизонтом событий, даёт в результате одно и то же макросостояние – саму чёрную дыру, у которой, как известно, нет волос. Но если чёрные дыры мысленно убрать, энтропия реликтового излучения за 13,8 млрд лет практически не выросла.

Последний расчёт – сколько битов информации в наблюдаемой вселенной согласно принципу Ландауэра. По современным оценкам, масса наблюдаемой вселенной составляет 1052 кг. Разделив это число на массу одного бита информации по Ландауэру (при температуре реликтового излучения 2.7 К – порядка 10-40 кг), получим величину порядка 1092. Это минимальное количество операций, которые нужно осуществить для моделирования наблюдаемой Вселенной в её текущем состоянии. Оно на два порядка превышает общее количество частиц во Вселенной и её энтропию на момент Большого взрыва, что вполне закономерно: квантовый компьютер должен выполнить минимум одну операцию на кубит, чтобы придать ему нужное значение, а вращение кубита требует затратить энергию.

Как вычислил Сет Ллойд, за 13,8 млрд лет компьютер размером с обозримую Вселенную способен произвести максимум 10122 операций над 1092 битами. Первая величина – это логическая глубина Вселенной, то есть сумма вычислительных ресурсов, необходимых для её создания; вторая величина – её термодинамическая глубина, то есть минимальное число битов информации для её моделирования. Хотя число 1092 и превышает количество частиц материи в наблюдаемой вселенной, по термодинамической глубине моделирование Вселенной на один порядок не дотягивает до уровня трансвычислительной задачи – задачи, для решения которой требуется более 1093 бит информации. Это максимальное число битов, которые мог бы обработать компьютер массой с Землю, работающий на пределе Бремерманна (1075 операций в секунду), за время существования Земли (4.6 млрд лет). Кстати, неплохая сверхзадача для искусственного суперинтеллекта. Если прямо сейчас превратить нашу планету в гигантский компьютер, он успеет вычислить всю наблюдаемую вселенную за несколько млрд лет – ещё до того, как Солнце станет красным гигантом и раздуется до орбиты Земли. Слишком долго ждать? Тогда можно ускорить процесс, увеличив вычислительные ресурсы. Для полного моделирования Вселенной размером с нашу за разумное время понадобится несколько миллионов солнечных масс или один крупный квазар. Ну а вся наблюдаемая вселенная способна обрабатывать 1090 битов в секунду и симулировать себя буквально за считанные минуты.

Значит, теоретически Вселенная может вычислить саму себя. И не только себя – у неё есть достаточно энергии, чтобы создать множество компьютерных симуляций вселенных такого же объёма. Правда, есть один нюанс. Указанный суперкомпьютер способен просчитать всё прошлое нашей Вселенной и полностью смоделировать её в настоящий момент. Но для того, чтобы вычислить ещё и будущее, его мощности будет недостаточно. Вселенная, какая она есть сейчас – это лишь один набор состояний 1090 частиц из 10^10123 возможных комбинаций. Для вычисления всего множества сценариев эволюции волновой функции Вселенной нужен компьютер побольше – для его создания не хватит совокупной энергии всех сотен миллиардов видимых нами галактик. Если всю массу наблюдаемой вселенной (3*1052 кг) превратить в чёрную дыру и заставить вычислять как сингулярный компьютер, то за время порядка 2,8*10139 секунд до полного испарения она успеет осуществить 2,8*10229 операций – ничтожно мало в сравнении с числом 10^10123. Даже если мы используем квантовый компьютер, способный параллельно рассчитать все возможные сценарии эволюции Вселенной, он выдаст в качестве ответа случайный результат, а не тот, который фактически будет реализован. Как я рассказывал в статье «Квантовая случайность против детерминизма», предсказание будущего любой физической системы по её текущему состоянию – невычислимая задача, демон Лапласа невозможен.

В принципе это логично, ведь теорема Гёделя о неполноте исключает возможность полного описания действительности средствами непротиворечивой формальной системы. Чтобы быть полной, математическая теория должна содержать как минимум одну аксиому, истинность которой невозможно доказать. Как в математической логике нельзя избежать недоказуемых утверждений, так и в информатике не обойтись без невычислимых функций. В 1936 г. британский математик Алан Тьюринг доказал, что количество вычислимых функций счётно бесконечно, а всех возможных функций – несчётное бесконечное множество. Так, хорошо известна проблема остановки: не существует способа определить, завершится когда-нибудь или нет компьютерная программа с определёнными начальными данными, поскольку для выяснения этого компьютеру необходимо самому произвести вычисление по заданному алгоритму. Получается, что математически невозможно смоделировать более сложную систему, чем та, частью которой является универсальный компьютер. Поэтому в квантовом компьютере, который моделирует Вселенную, должно быть по крайней мере столько же кубитов, сколько во Вселенной, и он должен выполнить как минимум столько же операций, сколько элементарных событий произошло с тех пор, как возникла Вселенная.

В книге «Программируя Вселенную» Сет Ллойд отметил, что количество энергии в пределах космологического горизонта со временем растёт вместе с количеством информации (энтропии), поскольку горизонт расширяется и охватывает всё больше галактик. Следовательно, число операций в секунду, которое может выполнять обозримая Вселенная, увеличивается прямо пропорционально её возрасту, и нам будет доступно всё больше вычислительных ресурсов для моделирования виртуальных миров. К сожалению, в свете последних открытий в космологии этот оптимистичный сценарий уже не актуален. В книге ещё не был учтён такой фактор, как ускоренное расширение Вселенной, вызванное загадочной тёмной энергией. Какой бы ни была её природа, скорее всего, Вселенная продолжит расширяться с ускорением, и количество доступной материи будет только сокращаться. Как я уже писал, через 100-150 млрд лет в наблюдаемой вселенной останется только местная группа галактик – Млекомеда и её спутники.

В условиях тепловой смерти Вселенной Сет Ллойд предлагает стратегию «двигаться медленно и толстеть», т.е. при недостатке свободной энергии компьютер должен совершать всё меньше операций за единицу времени и расширяться, увеличивая площадь поверхности, по которой можно рассеять энергию. Так можно решить проблему избавления от энтропии, бесконечно понижая свою температуру (среднюю энергию на бит), но поддерживая её выше температуры окружающего пространства. Однако это работает только при условии, что температура Вселенной стремиться к нулю – в сценарии расширения с замедлением. Мы же знаем, что Вселенная расширяется с ускорением, следовательно, её космологический горизонт обладает постоянной температурой, как и горизонт событий чёрной дыры. Вселенная никогда не станет холоднее этого излучения Унру температурой порядка 10-30 K. Когда температура компьютера упадёт ниже этой отметки, он уже не сможет избавляться от своей энтропии – тепло будет перетекать обратно от среды к компьютеру. Реликтовое излучение остынет до 10-30 K примерно через 1.4*1012 лет – ещё до того, как погаснет последний красный карлик. Дольше смогут продержаться компьютеры, работающие на тепловом излучении белых карликов, нейтронных звёзд и чёрных дыр, но где-то через гугол лет (10100) испарится и последняя сверхмассивная чёрная дыра. Это предел во времени, после которого вычисления станут невозможными.

Что вычисляет Вселенная на самом деле?

«Что же Вселенная вычисляет? Насколько мы можем судить, она не ищет ответа на единственный вопрос, подобно гигантскому компьютеру из «Автостопом по Галактике» Дугласа Адамса. Вместо этого Вселенная вычисляет сама себя. Управляемая «программным обеспечением» Стандартной модели элементарных частиц и взаимодействий, Вселенная вычисляет квантовые поля, химические соединения, бактерии, людей, звезды и галактики. И, вычисляя, она отображает свою геометрию пространства-времени с предельной точностью, допускаемой законами физики. Вычисление и есть её существование» (Сет Ллойд)

Не знаю, как вам, а мне такой ответ кажется не совсем удовлетворительным. Когда мы что-то вычисляем – своей головой или на компьютере – мы не просто обрабатываем случайные биты информации, а ищем правильный ответ, заранее предполагая, что он есть. Собственно, этим компьютерное вычисление отличается от вычислений, выполняемых атомами и молекулами. Алгоритмы нужны для того, чтобы из случайной последовательности битов получить упорядоченную, организованную строку на программном языке, поддающуюся расшифровке и несущую определённый смысл. Так может, и Вселенная тоже обрабатывает биты по некоему алгоритму, создавая из энтропии сложность? Да, этим алгоритмом является второй закон термодинамики и дарвиновская эволюция, а результатом вычисления («правильным ответом») – жизнь и разум. Осталось только выяснить, насколько детерминирован этот вычислительный процесс. Не являемся ли мы единственным правильным решением уравнения, которое Вселенная решает с момента Большого взрыва?

На вопрос: «содержалась ли в ранней Вселенной информация о будущих событиях, например, о возникновении разума?» однозначного ответа наука дать ещё не может. Супердетерминисты и сторонники концепции «всё из бита» считают, что вся ваша судьба была предопределена на стадии космологической инфляции, и ничего случайного вообще происходить не может. С другой стороны, алгоритм вычисления не обязательно должен быть детерминистичным. Он может быть необратимым и вероятностным, когда одни и те же входные данные не всегда приводят к одним и тем же выходным данным. На классическом компьютере вероятностные алгоритмы реализуются с помощью псевдослучайных чисел и всё равно являются детермирированными, как и ответы больших языковых моделей. Но квантовый компьютер генерирует истинно случайные числа и всегда даёт вероятностный ответ, результат его вычисления не может быть полностью детерминирован. Здесь мы снова сталкиваемся с проблемой квантового измерения.

Согласно копенгагенской интерпретации, при квантовом измерении происходит необратимый коллапс волновой функции, значит, каждое такое событие содержит долю истинной случайности и тем самым привносит в систему новую информацию. Общее количество информации (энтропии) в системе постоянно увеличивается – Вселенная-компьютер создаёт сложность из простых начальных данных. В этом сценарии информации о завтрашнем курсе валют или о результатах последних выборов в США в ранней Вселенной не было, не будет её и в конце времён. Но проблема в том, что без участия наблюдателя все квантовые процессы обратимы и симметричны во времени, следовательно, энтропия растёт только в голове у наблюдателя. Если же применять квантовую механику и к самому наблюдателю, как это делает многомировая интерпретация Эверетта, складывается совсем другая картина. Каждое квантовое событие имеет несколько возможных исходов, они происходят параллельно в разных частях универсальной волновой функции. Вселенная в целом (Мультивёрс) остаётся симметричной, но для двойников наблюдателя в каждой из её ветвей происходит нарушение симметрии и появление из ниоткуда новой информации (энтропии), определяющей ход истории. На самом же деле расщепление не является необратимым физическим событием, просто информация из соседних ветвей становится для наблюдателя недоступной.

Я с позиции теории «всё из кубита» и многомировой интерпретации квантовой механики считаю, что информация о всех возможных вариантах развития событий всегда была и будет, а почему мы существуем именно в таком виде и живём именно в данной версии Вселенной, отчасти объясняется слабым антропным принципом, отчасти – законами универсальной эволюции. Теоретически допустимо существование огромного множества разных вселенных с одними и теми же начальными условиями. На уровне Мультивселенной их эволюция полностью детерминирована, а для наблюдателей из отдельной вселенной процессы кажутся случайными. Но, в конце концов, все возможные вселенные снова придут к одному макросостоянию – тепловой смерти или Большому разрыву. И если вы захотите обратить время вспять, вы не сможете сделать это на отрезке между двумя произвольно выбранными моментами. Вычисление обратимо только для Вселенной в целом (Мультивёрса) или для изолированной квантовой системы между двумя измерениями (квантового компьютера), а на всех остальных масштабах симметрия не соблюдается.

Вывод

Итак, мы разобрались с аппаратным обеспечением квантового компьютера под названием «Вселенная» и выяснили, каковы физические пределы его вычислений. Какие из всего этого можно сделать выводы? На вопрос: «может ли Вселенная вычислить сама себя?» ответ будет утвердительным, если речь идёт о текущем состоянии наблюдаемой вселенной в трёх пространственных измерениях, и отрицательным, если имеется в виду её развитие во времени от начала и до конца, включающее всё пространство состояний и всё множество параллельных линий реальности. На вопрос «обладает ли Вселенная единым разумом и сознанием?» мы ответим «нет», поскольку на космологических масштабах ей катастрофически не хватает скорости передачи сигналов. Но на вопрос «мыслит ли Вселенная?» однозначного ответа дать нельзя, это зависит от определения

Да, космологическая эволюция является вычислением, а некоторые виды обработки информации универсальным компьютером напоминают человеческое

Автор: dionisdimetor