Департамент корпоративных решений HP приглашает на очередную серию вебинаров, стартовавших 15 мая.

Департамент корпоративных решений HP приглашает на очередную серию вебинаров, стартовавших 15 мая.

Вебинары посвящены обсуждению существующих продуктов, решений, сервисов и новинок HP и наших партнеров для корпоративного применения.

В этой серии мы коснемся тем виртуализации, сетевого оборудования, систем хранения данных, конвергентной системы для SAP HANA, комплексного подхода к резервному копированию и архивированию, а также представим новую линейку продуктов в области высокопроизводительных вычислений.

На вебинаре у вас будет возможность обсудить интересующие вопросы с другими участниками и получить консультацию экспертов по корпоративным решениям HP.

Читать полностью »

Метка «высокопроизводительные вычисления»

Вебинары Enterprise Group

2014-05-21 в 9:57, admin, рубрики: SAP HANA, webinar, Блог компании HP, вебинар, виртуализация, высокопроизводительные вычисления, Сетевое оборудование, хранение данных, метки: SAP HANA, webinar, вебинар, виртуализация, высокопроизводительные вычисления, сетевое оборудование, хранение данныхВ Университете Иннополис стартовала бесплатная Школа по высокопроизводительным вычислениям

2013-09-08 в 10:52, admin, рубрики: high-PC, Innopolis University, биология, Биотехнологии, Блог компании Innopolis University, высокопроизводительные вычисления, ит-инфраструктура, медицина, МФТИ, университет, метки: high-PC, Innopolis University, биология, биотехнологии, высокопроизводительные вычисления, Иннополис, Медицина, МФТИ, университет Сегодня, 8 сентября, на казанской площадке Университета Иннополис состоялось открытие Летней школы по высокопроизводительным вычислениям и их приложениям к задачам современной биологии и медицины.

Соорганизатором мероприятия выступил Московский Физико-Технический Институт (Физтех).

Читать полностью »

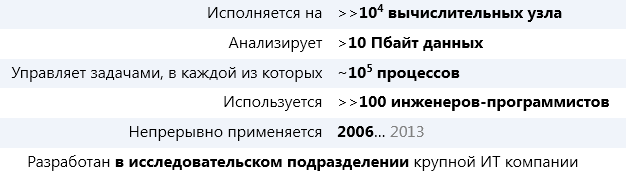

Dryad. Фреймворк распределенных вычислений

2013-06-05 в 6:33, admin, рубрики: big data, computer science, высокая производительность, высокопроизводительные вычисления, параллельное программирование, параллельные вычисления, метки: big data, computer science, высокопроизводительные вычисления, параллельные вычисленияПредставьте себе фреймворк общего назначения для распределенного исполнения приложений со следующими статистическими показателями*:

* Статистические данные за 2011 год.

А теперь представьте, что это не Hadoop.

О том, что это за фреймворк, о идеях и концепциях, заложенных в его основу и о том, почему этот фреймворк даже более инновационный (субъективно), чем Hadoop, речь пойдет ниже.

Читать полностью »

Что мы знаем о серверах высокой плотности

2013-04-04 в 6:39, admin, рубрики: blade, dell, high performance computing, HPC, Twin, блейд-сервер, блейды, Блог компании ИТ-ГРАД, высокая производительность, высокопроизводительные вычисления, Железо, микросервер, сервера, сервера лезвия, суперкомпьютер, суперкомпьютеры, метки: blade, dell, high performance computing, HPC, Twin, блейд-сервер, блейды, высокая производительность, высокопроизводительные вычисления, ИТ-ГРАД, микросервер, сервера, сервера лезвия, суперкомпьютер, суперкомпьютеры

Комментарии к некоторым постам хабра заставили задуматься, есть ли понимание у народа о серверах высокой плотности и их возможностях. Целью написания данного поста является внесение определенности по этому вопросу. Также планируется, что этот пост станет первым в череде статей на тему HPC (high performance computing, высокопроизводительные вычисления).

Сервера высокой плотности наиболее востребованы в технологиях построения суперкомпьютеров кластерного типа, систем виртуализации и организации облаков, систем параллельного доступа к системам хранения, систем аналитических расчётов, поисковых системах и др. Их применение обусловлено, прежде всего, невозможностью выполнить все предъявляемые требования, используя иные технологии. Рассмотрим варианты решений, их плюсы и минусы.Читать полностью »

Карта Интернета

2012-07-24 в 8:21, admin, рубрики: data mining, Google Maps, Maps API, Алгоритмы, высокопроизводительные вычисления, Карта Интернета, кластеризация, метки: Google Maps, высокопроизводительные вычисления, Карта Интернета, кластеризацияПривет всем!

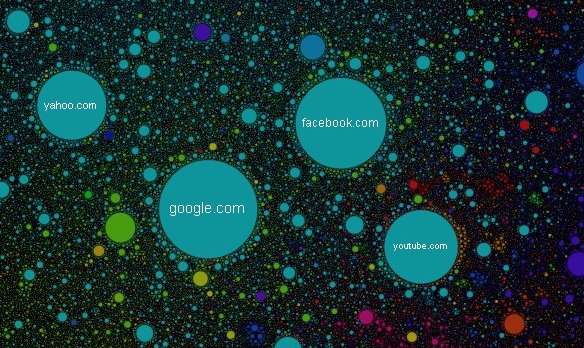

Хочу представить вам Карту Интернета или результат кластеризации более чем 350 тысяч сайтов в соответствии с переходами пользователей между ними. Размер круга определяется посещаемостью сайта, цвет – национальной принадлежностью, а положение на карте – его связями с другими сайтами. Если два сайта имеют стабильный поток пользователей между ними, то они будут «стараться» расположиться ближе друг к другу. После завершения работы алгоритма, на карте можно наблюдать скопления сайтов (кластеры) объединенные общими пользователями.

Например, если ввести в поиск habrahabr.ru, то можно увидеть, что dirty.ru и leprosorium.ru в том же «созвездии», а еще подальше livejournal.ru. Это говорит о том, что тот, кто сейчас читает этот текст, также с высокой вероятностью посещает эти сайты (относительно усредненного пользователя Рунета конечно).

Еще более интересный пример кластеризации можно увидеть внизу карты, между фиолетовой Японией и желтоватой Бразилией: там расположилась целая порнострана по размерам сопоставимая со всем Евронетом. Интересно, что будучи достаточно компетентным в рассматриваемом вопросе, внутри большого порнокластера можно различить тематические подкластеры меньшего размера.

Тем, кого интересует краткое техническое описание – добро пожаловать под кат

Читать полностью »

Быстрое сжатие изображений по алгоритму JPEG на CUDA

2012-03-14 в 14:35, admin, рубрики: benchmark, cpu, CUDA, DCT, fpga, GeForce, gpgpu, gpu, HPC, Nvidia, opencl, parallel computations, RLE, высокая производительность, высокопроизводительные вычисления, обработка изображений, параллельные вычисления, метки: benchmark, cpu, CUDA, DCT, fpga, GeForce, gpgpu, gpu, HPC, Nvidia, opencl, parallel computations, RLE, высокопроизводительные вычисления, параллельные вычисленияКраткое содержание: Создан быстрый кодер FVJPEG для сжатия изображений по алгоритму JPEG на видеокартах NVIDIA. Значительное ускорение получено при распараллеливании алгоритма, его реализации и оптимизации с помощью технологии CUDA. По скорости сжатия кодер FVJPEG превосходит все существующие в настоящее время программные и аппаратные решения для компрессии изображений по алгоритму Baseline JPEG.

При сравнении алгоритмов сжатия изображений с потерями, практически всегда обсуждаются степень сжатия и качество получаемой картинки, а вот время компрессии почему-то считается второстепенным показателем. По всей видимости, для большинства приложенийЧитать полностью »