Поскольку компания LSI (теперь уже часть Avago Technologies) продала свое подразделение flash-контроллеров небезызвестной Seagate, основной областью их внимания вновь становятся решения для RAID и SAS (своеобразный back to basics). Чтоб отметить это «возвращение к корням», я решил перевести интересную статью Томаса Павела (Thomas Pavel), директора по продажам storage-подразделения EMEA. Не уверен насчет того, выложена ли данная статья в Интернет, по крайней мере пока не нашел.

Читать полностью »

Метка «raid»

Производительность хранилищ

2014-06-29 в 21:11, admin, рубрики: avago, LSI, raid, sas, высокая производительность, Железо, производительность, пропускная способность, хранилище данных, метки: avago, LSI, raid, sas, производительность, пропускная способность, хранилище данныхИзвлечение дисков из живого рейда на adaptec 6805

2014-02-28 в 12:40, admin, рубрики: raid, Серверное администрирование, системное администрирование, метки: raidЗадача:

Извлечь 2 харда из raid-10 на логическом уровне (т.е., не извлекая из сервака физически), чтобы собрать из них raid-1, перенести туда систему и подготовить всё что можно к ребуту, таким образом минимизировав время и количество даунтаймов.

В чем сложность?

В 5 серии адаптеков вопрос решался двумя командами:

1. Зафейлили диск: arcconf setstate 1 device 0 0 ddd

2. Перевели в статус Ready: arcconf setstate 1 device 0 0 rdy

3. Делаем с дисками, что хотим.

В 6 серии так не прокатывает. Вне зависимости от того, включен failover или нет, диски возвращаются в состояние Present, и с ними ничего нельзя поделать (думаю, ясно, что сам рейд будет Degraded, пока не пройдет Rebuild).

Попытка обратиться в официальную тех.поддержку была неудачна — ответ я получил, но возникло ощущение, что я использую домашнюю железку, а не сервер, который нельзя просто так дергать туда-сюда:

После того как вы провели команду «arcconf setstate 1 device 0 0 ddd», система была перезагружена? Если нет, то перезагрузите и инициализируете оба диска в БИОСе контроллера. Там сразу же можно и создать RAID-1.

Чтобы стереть мете-данные на диске под Arcconf диск можно инициализировать с командой «arcconf task». Например: arcconf task start 1 device 0 0 initialize

После этого диск должен быть доступным для создания других логических дисков.

Однако, если Вы выбрасываете из RAID-10 два диска, то он остаётся в статусе «Degraded». При ошибке одного из оставшийся в массиве дисков может рухнуть весь массив. Поэтому, возможно, просто сделайте бэкап всех данных, потом просто удалите массив RAID-10 и создавайте два отдельных RAID-1.

Я подумал и решил вопрос очередью экспериментов, после чего смог выполнить поставленную задачу.

Производительность RAID массивов

2014-02-22 в 12:10, admin, рубрики: ESXi, raid, raid10, raid5, speedtest, VMware, виртуализация, Накопители, системное администрирование, метки: ESXi, raid, raid10, raid5, speedtest, vmwareУверен, что каждый системный администратор сталкивался с вопросом какой raid массив использовать для той или иной задачи. Хочу поделиться своими мыслями, цифрами и рассуждениями на эту тему.

Задача — планирование места для размещение виртуальных машин на системе хранения данных.

Используемое аппаратное и программное обеспечение для тестирования — VMWare ESXi 5.5 на HP ProLiant DL380 Gen8, виртуальная машина Windows 2008 R2 Enterprise (2 CPU, 4 Gb RAM, 60 Gb HDD), дисковая система HP P2000 G3 MSA FC, диски HP SAS 600Gb 10k, программа оценки скорости Cristal Disk Mark.

Цель — подбор типа raid массива.

Читать полностью »

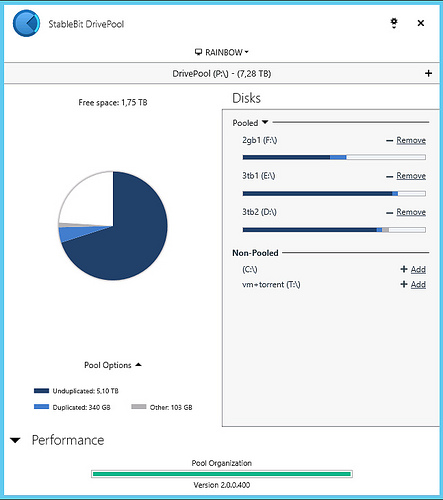

StableBit DrivePool — дисковый массив с дублированием файлов

2013-09-16 в 9:27, admin, рубрики: raid, windows, дисковый массив, резервное копирование, метки: raid, windows, дисковый массив, резервное копированиеЯ постоянно пытаюсь найти какие-то альтернативы RAID'ам в плане объединения нескольких жестких дисков в единый массив. Пробовал много что, но ни на чем так и не остановился окончательно. RAID не нравится тем, что штука достаточно капризная, негибкая и требовательная до дискового пространства.

Что мне вообще хочется:

- Объединить диски с данными в один массив большого объема, чтобы не приходилось вручную сортировать файлы — что возникает при нескольких дисках (пусть даже при монтировании их в папки).

- Иметь возможность добавлять/удалять/заменять диски в любой момент без развала массива.

- Независимость информации на дисках друг от друга — чтобы смерть одного из них не приводила к недоступности остальных.

- В идеале — какой-то метод хранения одного файла на нескольких дисках. Бэкапы — это хорошо и я их делаю, но лучше, когда к их помощи не приходится прибегать.

LSI Nytro MegaRAID NMR8100-4i в деле

2013-08-09 в 23:34, admin, рубрики: hostkey, LSI, raid, ssd caching, Блог компании HOSTKEY, виртуализация, выделенный сервер, высокая производительность, Железо, хостинг, метки: hostkey, LSI, raid, ssd caching, виртуализация, выделенный сервер, хостингКлиент сформулировал мне в HOSTKEY задачу — на 1 (один) сервер с 12 ядрами и 64Гб памяти надо примерно 3-4Тб места под более-менее однотипные виртуалки, но что бы работало все как на SSD и при этом уложиться в 16000р в месяц. Стали думать, вариантов было несколько:

- делаем все на SSD. берем 6 дисков по 500Гб типа Samsung 840 Pro eMLC, собираем их в страйп или еще как хитро, добавляем пару дисков по 3Тб для бакапа и… не проходим в бюджет. 2U сервер, 8 портовый RAID контроллер и диски по 12000р за штуку не пропускают.

- Делаем все на жестких дисках, берем 12x300Gb SAS 15K и опять не проходим ни в бюджет, ни в производительность.

- Используем RAID контроллер с внешним SSD кэшем – LSI CacheCade или Adaptec MaxCache. Идея получше, но нам надо 4 диска по 2Тб в RAID10 – придется брать 8 портовый контроллер и к нему SSD на 120Гб eMLC или SLC. Что бы к SSD был доступ, опять надо брать 2U корпус. Контроллер 8 портов + SSD стоит около 37000р, в бюджет не проходим.

- Используем новую LSI Nytro MegaRAID NMR8100-4i. Берем 1U систему, ставим в нее контроллер, ставим в нее 4 диска по 2Тб в RAID10 и вписываемся и в производительность и в бюджет. Нитра стоит 27000р, на ней уже стоят 2 диска по 44Гб, причем SLC!

Сказано – сделано, примерно 3 рабочих дня и 4 вариант у нас на столе. Посмотрим, на что он способен — не на рекламных проспектах, а на практике.

Читать полностью »

Голь на выдумки хитра

2013-07-19 в 11:28, admin, рубрики: ESXi, nagios, raid, windows, Песочница, метки: ESXi, nagios, raid, windows Большинство администраторов знает, что для сохранности своего времени, нервов и данных пользователей необходимо использовать RAID массивы. Однако их использование оправдано только в случае, если существует адекватная система мониторинга.

В случае если используется полноценная операционная система, проблем, как правило, не возникает: драйвера и программное обеспечение для получения информации от RAID-контроллера обычно есть.

Но в случае использования ESXi сервера без дополнительной обвязки в виде vCenter, получение информации от контроллеров может быть не совсем тривиальным.

Читать полностью »

Установка Citrix XenServer на програмный RAID

2013-05-16 в 1:47, admin, рубрики: citrix xenserver, raid, storage, виртуализация, установка, метки: citrix xenserver, raid, storage, виртуализация, установка Citrix Xen Server при том что основан на дистрибутиве Linux в процессе установки не позволяет управлять размерами разделов и конфигурацией жестких дисков под устанавливаемую систему. По умолчанию при установке он спрашивает только диск на который требуется установка с автоматической разметкой дискового пространства под свои нужды. В процессе установки на выбранном диске создается 3 primary раздела. Два по 4Гб и один на все оставшееся место. (Кстати, может кто подскажет, для чего нужен второй раздел на 4Гб? Предполагаю, что на случай обновлений, восстановлений системы там лежит копия первого раздела с установленной системой, но точной информации не нашел.)

Читать полностью »

Небольшое хранилище для небольших файлов

2013-04-15 в 14:10, admin, рубрики: btrfs, ext4, raid, Блог компании Webnames.ru, Накопители, системное администрирование, хранение данных, хранение файлов, метки: btrfs, ext4, raid, хранение данных, хранение файловВо время разработки одного проекта возникла необходимость хранить множество файлов (более 4 млн. штук). И их количество продолжало расти. Когда файлов стало более 6 млн., работать с ними стало затруднительно. Даже если разложить их по каталогам и создать разветвлённое дерево, обход даже части этих каталогов занимал часы. Разумеется, вначале никто не задумывался над тем, как все это хранить, и мы использовали обычный винт и ext4. В какой-то момент скорость чтения с этого раздела снизилась до 9MB/sec. Это слишком медленно. Экспериментальный переход на btrfs поднял скорость до 13MB, но такие показатели тоже не впечатляют. SSD для этого никто не собирался использовать да и объём уже перевалил за 1TB. Т.е. всё шло к использованию RAID'ов. Поскольку коммерческий успех проекта был под сомнением, то стоимость нужно было свести к минимуму. Следовательно, реализация должна была быть программной.

Итак, нужно небольшое хранилище — на одном сервере или компьютере, т.е. не более четырех дисков. Хранить нужно небольшие файлы — по 1-3Mb каждый.

Читать полностью »

ETERNUS DX — новая версия микрокода

2013-01-17 в 10:59, admin, рубрики: ETERNUS DX, Fujitsu, raid, Блог компании Fujitsu, дисковые массивы, Серверная оптимизация, метки: ETERNUS DX, Fujitsu, raid, дисковые массивыКак уже отмечалось ранее, ETERNUS DX – это действительно единая продуктовая линейка, поэтому, как правило, и новые версии микрокодов появляются тоже одновременно для всех моделей линейки. Посмотрим, что нового появилось в последнее время для систем ETERNUS DX80/90/410/440/8700 S2. Для всех этих систем апдейт на последнюю версию микрокода добавляет следующие «фичи».Читать полностью »

IOPS — что это такое, и как его считать

2012-12-29 в 4:35, admin, рубрики: IOPS, raid, ит-инфраструктура, метки: IOPS, raid  IOPS (количество операций ввода/вывода – от англ. Input/Output Operations Per Second) – один из ключевых параметров при измерении производительности систем хранения данных, жестких дисков (НЖМД), твердотельных диски (SSD) и сетевых хранилища данных (SAN).

IOPS (количество операций ввода/вывода – от англ. Input/Output Operations Per Second) – один из ключевых параметров при измерении производительности систем хранения данных, жестких дисков (НЖМД), твердотельных диски (SSD) и сетевых хранилища данных (SAN).

По сути, IOPS это количество блоков, которое успевает считаться или записаться на носитель. Чем больше размер блока, тем меньше кусков, из которых состоит файл, и тем меньше будет IOPS, так как на чтение куска большего размера будет затрачиваться больше времени.

Значит, для определения IOPS надо знать скорость и размер блока при операции чтения / записи. Параметр IOPS равен скорости, деленной на размер блока при выполнении операции.

Читать полностью »