Хранение и обработка данных – задача, которую человечество с переменным успехом решает ни одну тысячу лет. Проблемы, связанные с решением этой задачи, связаны не только с физическим объемом данных (volume), но и со скоростью изменчивости этих данных (velocity) и многообразием (variety) источников данных – то, что аналитики Gartner в своих статьях [11, 12] обозначили как «3V».

Computer Science не так давно столкнулась с проблемой Больших Данных, решения которой от ИТ ждут частные компании, правительства, научное сообщество.

И в мире уже появилась компания, которая, с переменным успехом, справляется с проблемой Big Data вот уже 10 лет. По моему ощущению (т.к. чтобы заявить достоверно нужны открытые данные, которых в свободном доступе нет) ни одна коммерческая или некоммерческая организация не оперирует большим объемом данных, чем компания, о которой идет речь.

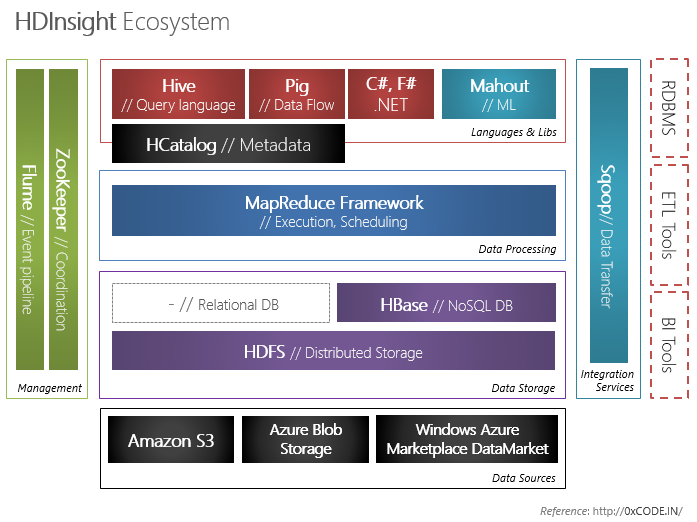

Именно эта компания являлась основным контрибьютором идей платформы Hadoop, а также многих компонентов экосистемы Hadoop, таких как HBase, Apache Giraph, Apache Drill.

Как Вы догадались, речь идет о Google.

Читать полностью »