В рамках работы над новым проектом возникла задача поиска и загрузки некоторых наборов данных с сайта открытых данных России. На станице сайта, предоставляющей доступ к реестру наборов открытых данных, присутствует возможность экспорта реестра в форматах csv или xls. Это очень хорошо, а главное удобно.

Метка «анализ данных»

Загрузка данных с сайта открытых данных data.gov.ru

2017-01-22 в 2:42, admin, рубрики: Статистика в IT, электронное правительство, метки: анализ данных, загрузка данных, открытые данные, скраппингЧего ждут работодатели от системных администраторов?

2014-12-01 в 21:20, admin, рубрики: Песочница, метки: анализ данных, вакансии, системное администрирование Во время поиска нового места работы, мне пришла в голову мысль проанализировать текущее состояние рынка труда системных администраторов на предмет востребованности различных навыков у работодателей.

Данные были взяты с одного очень известного в России ресурса по поиску работы и действительны по состоянию на середину ноября 2014 года.

Читать полностью »

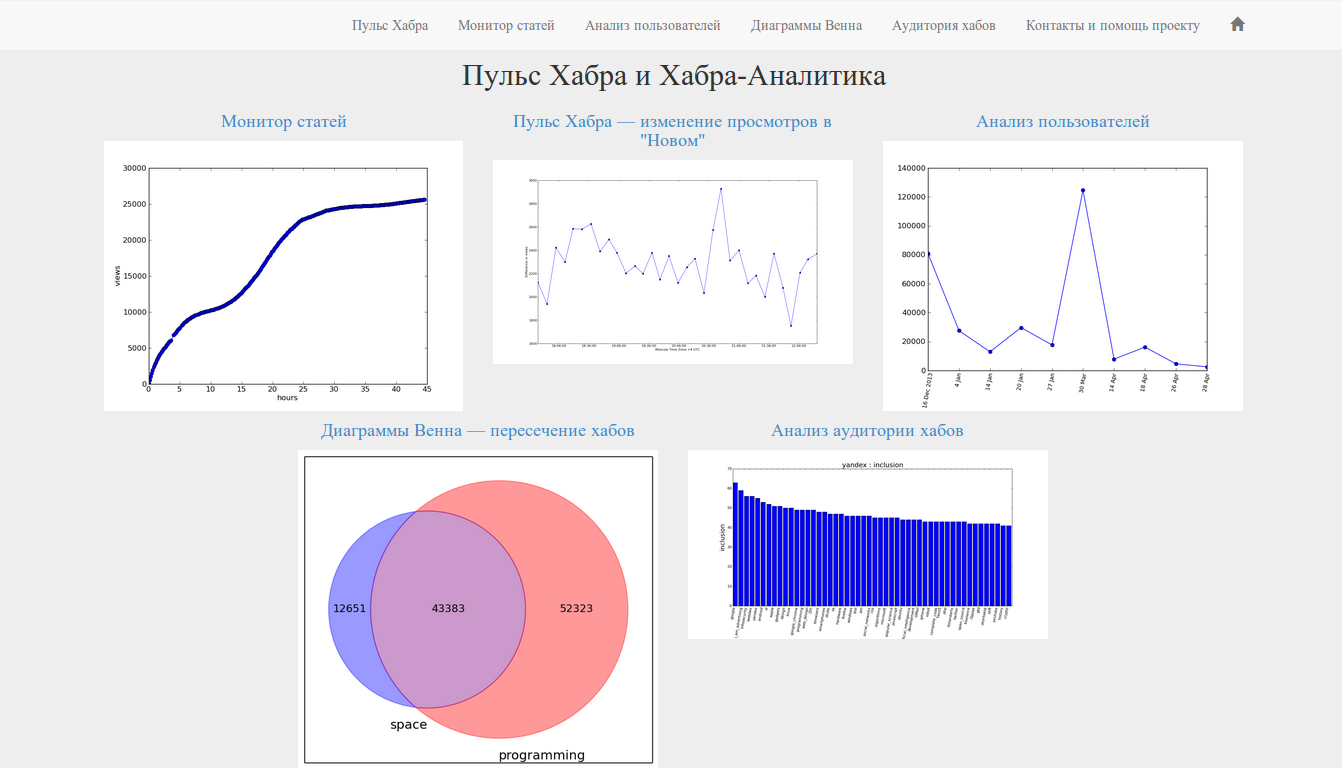

Пульс Хабра

2014-07-01 в 7:17, admin, рубрики: анализ данных, Медиа, Статистика в IT, Хабрахабр API, метки: анализ данных, Хабрахабр APIcallidus77: Помница в нашей сетке монтажники подключали абонента. Пришли, воткнули сетевуху, а у него Фря и дров нету. Почесали головы и ушли. Чел через три недели наконец-то коннектится.

Грят: «Долго ж ты искал дрова.»

Он: «Я не искал. Я их сам написал.» Баш

Наверное, каждый автор трепетно следит за судьбой своих статей, такому автору на хабре всегда чего-то не хватает. Мне всегда не хватало инструментов наблюдения за статьями — поэтому я и решил их написать.

Под катом мы разберемся с основными инструментами ресурса и потенциальной возможностью применения. Весь инструментарий доступен по адресу http://www.habr-analytics.com, исходный код (основные функции) на github. За примерами и деталями — добро пожаловать под кат!

Структура статьи

- Пульс Хабра

- Монитор статей

- Анализ пользователей

- Пересечение хабов — диаграммы Венна

- Аудитория хабов

- Исходный код и структура проекта

- Заключение

*Осторожно трафик*

Дайджест статей по анализу данных №3 (09.06.2014 —22.06.2014)

2014-06-22 в 15:03, admin, рубрики: big data, data mining, digest, анализ данных, дайджест, метки: big data, data mining, digest, анализ данных, дайджест .jpg)

Добрый день, уважаемые читатели.

Пролетели 2 недели и пришло время нашей подборки материалов по анализу данных. Сегодняшний дайджест получился большим, и признаюсь често сам осилил не все, что в него попало. Но так как на вкус и цвет товарище нет, то я решил выложить всю подборку.

Итак, из сегодняшней подборки вы узнаете о том как использовать хранилища данных различных типов в одном проекте, посмотрите какими большими данными может обладать бизнес и как их анализ может ему помочь. Также в нашей подборке будет статья посвященная алгоритму FTCA, а также будет материал про сравнени различных алгоритмов машинного обучения.

Читать полностью »

Дайджест статей по анализу данных №2 (26.05.2014 — 8.06.2014)

2014-06-08 в 14:44, admin, рубрики: big data, data mining, digest, анализ данных, дайджест, метки: big data, data mining, digest, анализ данных, дайджест .jpg) Добрый день, уважаемые читатели.

Добрый день, уважаемые читатели.

Представляю вашему вниманию дайджест новостей и полезных материалов из мира анализа данных. Предыдущий дайджест пользовался большой популярностью и поэтому я решил сделать их регулярными. Периодичность таких подборок будет 1 раз в 2 недели.

В сегодняшней подборки вы узнаете что общего у статистики и науке об анализе данных, как можно выявить ложную корреляцию, а также какие алгоритмы правят современным миром. Помимо этого вы получите небольшую шпаргалки по методам машинного обучения и NoSQL базам данных, ну и еще много чего интересного.

Дайджест статей по анализу данных и big data

2014-05-23 в 9:34, admin, рубрики: big data, data mining, digest, анализ данных, дайджест, метки: big data, data mining, digest, анализ данных, дайджест  Частенько читаю Хабр и заметил что в последнее время появились Дайджесты новостей по многим тематикам, таким как веб-разработка на php, разработка на Python, мобильные приложения, но не встретил ни одного подборки по популярному сейчас направлению, а именно анализу данных и big data.

Частенько читаю Хабр и заметил что в последнее время появились Дайджесты новостей по многим тематикам, таким как веб-разработка на php, разработка на Python, мобильные приложения, но не встретил ни одного подборки по популярному сейчас направлению, а именно анализу данных и big data.

Ниже я решил собрать небольшую подборку материалов по данной теме. Т.к. на русском материалов не так много, в данный дайджест попали в основном англоязычные статьи.

Кого заинтересовала данная тема прошу подкат. А также жду замечаний, пожеланий и дополнений, буду очень рад обратной связи.

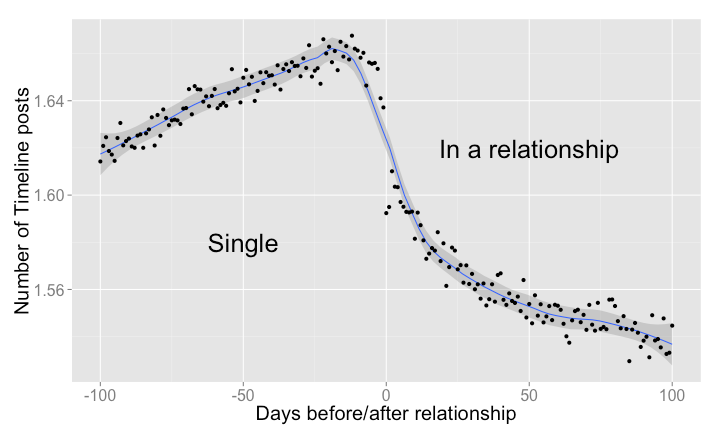

Facebook знает, в кого ты влюбился

2014-02-18 в 13:35, admin, рубрики: data mining, Facebook, анализ данных, любовь, Социальные сети и сообщества, метки: Facebook, анализ данных, любовь

Специалисты по анализу данных из компании Facebook опубликовали статистику, собранную с анонимных профилей в социальной сети. Как романтично сказано в официальном блоге, статистика показывает «формирование любви» между парами.

«В течение 100 дней перед началом отношений мы наблюдаем медленное, но стабильное увеличение количества сообщений между будущей парой», — пишет автор исследования Карлос Дьюк (Carlos Diuk). Но самое интересное происходит потом: резкое уменьшение коммуникаций в социальной сети сразу после установления отношений (и нового статуса в профиле).

Читать полностью »

Черная пятница. Как же всё было на самом деле

2014-01-14 в 17:33, admin, рубрики: Delphi, анализ данных, Инфографика, исследование, Исследования и прогнозы в IT, Программирование, черная пятница, метки: анализ данных, исследование, Программирование, черная пятница

6 декабря 2013 года в России проходила черная пятница. Было заявлено о больших скидках.

Я узнал об этом в одной статье еще за месяц до начала. Прочитав много комментариев к той статье, я понял, что все пользователи сходятся во мнении, что:

- Никаких грандиозных скидок не будет.

- Если скидки всё-таки будут, то только на те товары, которые не очень то и нужны.

- Сама скидка сводится к тому, что в этот день цена товара завышается, а за счет скидки понижается до первоначального уровня, но никак не меньше.

Было решено узнать, а как всё происходит на самом деле.

В той статье упоминались несколько компаний, участвующих в акции. Я выбрал 2 компании для анализа: Сотмаркет и Белый Ветер.

Читать полностью »

Введение в параллельные вычисления в R

2013-12-21 в 19:30, admin, рубрики: анализ данных, Параллелизм, параллельное программирование, метки: анализ данных, Параллелизм  Эта статья посвящена языку R. Он не так широко распространен на территории ex-USSR, как Matlab и тем более Python, но, безусловно, заслуживает внимания. Нельзя не отметить, что R — фактически стандарт для Data Science (хотя тут хорошо написано, что не R единым живут data scientists). Богатый синтаксис, совместимость с legacy кодом (что весьма важно в научных приложениях), удобная среда разработки RStudio и наличие огромного числа библиотек в CRAN делают R таковым.

Эта статья посвящена языку R. Он не так широко распространен на территории ex-USSR, как Matlab и тем более Python, но, безусловно, заслуживает внимания. Нельзя не отметить, что R — фактически стандарт для Data Science (хотя тут хорошо написано, что не R единым живут data scientists). Богатый синтаксис, совместимость с legacy кодом (что весьма важно в научных приложениях), удобная среда разработки RStudio и наличие огромного числа библиотек в CRAN делают R таковым.

Читать полностью »

Отказ от jParser (в пользу работы напрямую с буферами Node.js) ускоряет скрипт на порядок

2013-09-23 в 13:42, admin, рубрики: data processing, Fido, Fidonet, JAM, javascript, jParser, Node, node.js, Node.js на узле Фидонета, nodejs, анализ данных, обработка данных, эхопочта, метки: data processing, Fido, Fidonet, JAM, jParser, Node, node.js, Node.js на узле Фидонета, nodejs, анализ данных, обработка данных, эхопочта -uskoryaet skript-na poryadok.png) Перелистнём несколько страниц недавнего прошлого.

Перелистнём несколько страниц недавнего прошлого.

16 мая 2012 года RReverser во блогозаписи «Javascript BMP Parser» рассказал об употреблении модуля jParser для анализа двоичных данных, на движке Node.js совершаемого.

На следующий же день (17 мая 2012 года) во блогозаписи «jParser: анализ двоичных файлов работает просто» я перевёл документацию по jParser, а чуть позже (22 мая 2012 года во блогозаписи «Node.js на узле Фидонета: читаем джаваскриптом заголовки эхопочты, хранимой в формате JAM») поделился собственным опытом употребления этого модуля.

Прошло ≈1⅓ года…

12 сентября нынешнего (2013) года во блогозаписи «Недоволен скоростью джаваскриптов? — Подожди год-полтора, и это пройдёт!» я выразил неудовольствие от скорости работы модуля, прежде мною сочинённого, и указал на один только повод для оптимизма: поступательное развитие Node.js от версии 0.6 до версии 0.10 привело к росту скорости моего кода в три раза.

А сегодня события совершили полный круг — я напрочь отказался от употребления jParser. И достигнутый результат (как неприятная, так и радостная сторона его) оказался заслуживающим внимания.

Позвольте же поделиться с вами как впечатлениями, так и исходниками.