В 2016 году я наткнулся на руководство по стратегиям сбора данных для AI-стартапов, многие идеи из которого были визионерскими для своего времени. Автором этого текста был Мориц Мюллер-Фрайтаг, сооснователь компании Twenty Billion Neurons (TwentyBN).

Мы быстро нашли общий язык и занялись изучением практического применения технологии TwentyBN для анализа видео. Речь шла о масштабной базе видеозаписей, где группы людей демонстрировали бы различные концепции, действия и ситуации — все это должно было наделить машины визуальным здравым смыслом и пониманием базовой физики. Позже компанию приобрела Qualcomm, где Мориц сейчас работает директором по управлению продуктами.

Любой, кто работал с глубоким обучением в 2016 году, знает, насколько незрелой была тогда экосистема ИИ. Рынок с недоверием смотрел на любые попытки раздвинуть границы исследований ради новых возможностей. Открытые базы данных можно было пересчитать по пальцам, а создание качественных синтетических данных в нужных объемах казалось почти невыполнимой задачей. Каждая компания ломала голову над тем, как получить доступ к качественным размеченным данным.

Последние несколько лет принесли значительные перемены:

-

Теперь нам требуются действительно огромные объемы данных — предварительное обучение доказало свою эффективность, и мы стремимся создавать модели с более продвинутыми возможностями.

-

Сейчас у нас не только больше данных, чем раньше, но вдобавок мы лучше понимаем, как их использовать, и способны генерировать их в гораздо больших масштабах.

-

Появились гораздо более совершенные инструменты и методики, которые решили многие проблемы работы с большими наборами размеченных вручную данных.

В этой статье мы с Морицом поделимся обновленным руководством для основателей AI-first стартапов, учитывающим все изменения, которые произошли на рынке с 2016 года. Прошло уже достаточно времени, чтобы понять, какие подходы работают, а какие нет. В целом, когда мы наращиваем масштабы и создаем генеративные ИИ-системы для множества различных задач, вопросы владения данными, авторских прав, добросовестного использования и возможных нарушений становятся особенно актуальными. Все это подчеркивает, насколько важен продуманный подход к сбору данных.

Многие стратегии из старого руководства до сих пор отлично работают — будь то корпоративные партнерства, ручная работа или использование краудсорсинговых платформ. Мы не станем подробно их разбирать, поскольку вряд ли сможем добавить что-то существенное к словам Морица. Также в обзор не попали подходы, которые уже утратили актуальность или привлекают к себе излишнее внимание регуляторов — например, создание «стартапов-приманок» и поглощение других бизнесов для получения доступа к их данным.

Большие генеративные модели

Большие языковые и мультимодальные модели как генераторы синтетических данных

Если большие языковые модели (LLM) генерируют текстовый вывод, то большие мультимодальные модели (LMM) способны создавать синтетические данные самых разных типов: текст, код, изображения. Это особенно ценно в областях, где реальных данных мало, они конфиденциальны или их сбор и разметка слишком дорого обходятся. Такой подход активно применяется в обработке естественного языка, компьютерном зрении и разработке автономных систем (например, при создании сценариев для симуляционного обучения беспилотных автомобилей).

Синтетические данные обычно используются как дополнение к реальным данным или для тонкой настройки моделей, но не как полная замена. Какими бы продвинутыми они ни были, это всегда аппроксимация, имитирующая примеры из реального мира. Если слишком сильно опираться на синтетику, модель может начать подстраиваться под особенности процесса генерации, а не учиться решать реальные задачи.

Есть два основных способа генерации данных:

-

Самосовершенствование — здесь модель сама придумывает инструкции, контекст и ответы. Если пример оказывается некорректным или слишком похожим на уже существующий, он отбрасывается, а оставшиеся данные идут на дополнительную настройку исходной модели.

-

Дистилляция — при таком методе знания передаются от более мощной модели-учителя к менее производительной, но более эффективной модели-ученику. И даже притом, что синтетические данные часто содержат ошибки, они все равно отлично помогают в процессе обучения на инструкциях.

Microsoft недавно выпустила линейку небольших моделей Phi, обученных в основном на синтетических данных от других языковых моделей. Эти модели смогли превзойти большинство не самых передовых решений. Когда выяснилось, что Microsoft не раскрывает информацию о подготовке своих обучающих данных, команда Hugging Face запустила проект Cosmopedia, чтобы воспроизвести данные Microsoft.

Они подробно рассказали о процессе создания синтетических учебников, блог-постов и историй. В работе задействовали более 30 миллионов файлов и 25 миллиардов токенов, сгенерированных с помощью Mixtral-8x7B-Instruct. Контент был самый разный — от образовательных материалов до веб-данных, и его структурировали так, чтобы максимально приблизить к реальным наборам данных. Команда признала, что сложнее всего оказалось разработать промпты, которые бы сохраняли разнообразие материала и не допускали повторов.

Однако с этими подходами не все так однозначно. Особенно спорная ситуация с дистилляцией: некоторые исследования показывают, что получающиеся модели отлично копируют стиль более мощных LLM, но заметно хуже справляются с фактической точностью. Люди-эксперты могут и не заметить подвоха, но целенаправленное автоматическое тестирование сразу выявляет проблему. Более того, дистилляция рискует усилить предубеждения, которые уже были в данных для обучения более мощной модели.

Языковые модели как разметчики данных

Есть убедительные доказательства того, что современные языковые модели способны размечать текстовые датасеты не хуже, а то и лучше людей-разметчиков, причем делают это в разы быстрее. В отличие от людей, языковые модели не устают и не теряют объективности — они последовательно применяют одни и те же критерии разметки ко всему массиву данных. Это обеспечивает высокую согласованность результатов даже при работе с огромными объемами информации. Более того, большие генеративные модели вроде Segment Anything, обученные на колоссальных наборах данных, показывают более высокие результаты (часто даже без предварительной подготовки), чем специализированные негенеративные модели компьютерного зрения, которые традиционно используются для автоматической разметки в задачах вроде семантической сегментации.

Эти технологии набирают актуальность по мере того, как ИИ все чаще применяется в субъективных и социально значимых областях. Если вас больше интересует человеческая разметка и методы повышения ее качества, рекомендую прочитать пост на эту тему за авторством Лилиан Венг из OpenAI.

Языковые модели в роли дата-сайентистов

LLM можно использовать и для расширения доступного пула реальных данных с помощью «сшивания» датасетов. При таком подходе объединяются разные источники данных: языковая модель вникает контекст и семантику данных, устраняет несоответствия и создает связный структурированный датасет. Она также может объединять данные разных типов (например, текст и изображения) в единые наборы через обучение признакам. Первой общедоступной моделью, которая смогла делать это достаточно качественно, стала CLIP от OpenAI, научившаяся отображать разные модальности (типы данных) в едином пространстве эмбеддингов.

Языковые модели в роли оценщиков

Обучение с подкреплением на основе человеческого фидбека (RLHF) стало ключевой техникой точной настройки, которая превратила GPT-3 в прорывную систему для диалогов с пользователями. Как это работает?

Сначала LLM проходит масштабное предварительное обучение без учителя, предсказывая следующий токен. Затем эксперты формируют обучающую выборку, показывая модели предпочтительные ответы на разные запросы. После этого несколько версий LLM тестирую на новых примерах, а их ответы оценивают эксперты.

Эти оценки используются для обучения модели вознаграждения — отдельной нейросети, которая учится предсказывать, насколько хорош тот или иной ответ. На финальном этапе LLM дообучается с подкреплением, ориентируясь на сигналы от модели вознаграждения, которая уже впитала в себя человеческие предпочтения. В результате LLM начинает выдавать более точные и осмысленные ответы.

Теперь вместо людей для обратной связи можно использовать языковую модель — этот подход называется обучением с подкреплением на основе ИИ-фидбека (RLAIF). Модели задается набор принципов, которыми она должна руководствоваться при оценке. Эти принципы, иногда называемые конституцией, позволяют оптимизировать этичность поведения и безопасность наряду с возможностями модели. Главное преимущество RLAIF перед RLHF в том, что замена людей на машины делает процесс дешевле и масштабируемее.

Разметка данных: люди и платформы

В статье за 2016 год Мориц рассказывал о том, как использовать краудсорсинговые платформы и сервисы для аутсорсинга задач вроде Amazon Mechanical Turk — они помогают найти недорогую рабочую силу онлайн для разметки и очистки данных. Хотя эти сервисы все еще находят свое применение, время не стоит на месте: появились платформы намного умнее и популярнее, вроде V7 и Scale AI. Они предлагают автоматическую разметку и управление данными, следят за соблюдением нормативов и качеством работы. Благодаря этому компании с потребностями в больших объемах данных могут быстрее расти и получать более согласованные результаты.

У разных платформ свои сильные стороны. Например, V7 специализируется на задачах, требующих более глубокой экспертизы, таких как медицинская визуализация, а Scale развивается в сфере беспилотного транспорта и вышла на рынок оборонки. Нашли свою нишу и новички вроде Invisible — они предоставляют квалифицированных специалистов для работы с языковыми моделями, будь то управляемая точная настройка, RLHF, оценка результатов людьми или red teaming. Среди других популярных сервисов для разметки данных можно также выделить CVAT, Dataloop и Labelbox.

Многие из этих платформ все еще частично полагаются на людей-разметчиков, и нам предстоит еще немало работы по оценке качества их результатов. Особенно это важно сейчас, когда ИИ начинает все чаще применяться в сложных, субъективных и социально значимых областях. Помните пост Лилиан Венг из OpenAI, о котором мы говорили выше? В нем как раз разбираются некоторые методы улучшения качества данных, размеченных людьми.

Про какие методы речь:

-

Согласование и агрегация оценок разметчиков. Здесь в ход идут голосование большинством, оценка уровня согласия и вероятностное моделирование. Все это помогает вычислить истинные метки на основе оценок разных разметчиков и вычислить тех, кто просто «спамит» некачественной разметкой. Особенно полезно в субъективных областях, где нет единственно правильного ответа.

-

Моделирование разногласий. Специальные техники вроде деконволюции разногласий (disagreement deconvolution) и моделирования множественной разметки помогают поймать систематические расхождения между разметчиками и использовать эту информацию для улучшения обучения. Есть и другой подход — «обучение жюри», где моделируется поведение разметчиков с учетом их личных особенностей, чтобы собрать разные точки зрения.

-

Обнаружение ошибок разметки. Сюда входят функции влияния (они измеряют, как изменение веса или удаление отдельных примеров влияет на веса модели) и отслеживание изменений в предсказаниях во время обучения. А еще есть метод «шумной» кросс-валидации: датасет делят пополам, на одной половине модель обучается, а потом пытается предсказать метки для второй. Если предсказанные метки не совпадают с реальными — это сигнал о возможной ошибке.

Открытые наборы данных

С 2016 года мы наблюдаем настоящий бум открытых датасетов. Этому способствовало как движение за открытые данные, так и растущее понимание ценности обмена данными между бизнесом, научным сообществом и государством.

Открытые датасеты применяются практически во всех областях, но особенно их много в сферах компьютерного зрения, обработки естественного языка, работы с речью и аудио, а также в управлении роботами и навигации. Такой прогресс стал возможен благодаря усилиям сообществ (например, через Hugging Face, PyTorch, TensorFlow и Kaggle) и публикации крупных наборов данных технологическими гигантами.

И вот казалось бы, что может быть лучше бесплатных данных, которые еще и отлично подходят для бенчмаркинга? Но и тут есть свои нюансы.

Во-первых, в чувствительных или регулируемых областях открытые датасеты встречаются реже, они обычно старее и меньше по объему. В таких секторах наличие собственного проприетарного набора данных дает серьезное конкурентное преимущество.

Качество и актуальность открытых данных может сильно различаться, что создает проблемы в быстро развивающихся областях. Есть и риск переобучения из-за чрезмерного использования — когда модели, натренированные на популярных датасетах, показывают отличные результаты в бенчмарках, но спотыкаются на реальных задачах.

Количество открытых датасетов уже давно перевалило за тысячу, но все же остановимся на следующих полезных ресурсах:

-

Хабы открытых данных и поисковые системы по ним от технологических гигантов вроде Amazon, Google и Microsoft;

-

Хаб готовых к использованию датасетов от Hugging Face с набором инструментов для работы;

-

Поиск датасетов от Kaggle;

-

VisualData — хаб датасетов для компьютерного зрения;

-

Список из более чем 500 открытых датасетов от V7.

Моделируемая среда

Моделируемые среды позволяют моделям ИИ и агентам учиться в контролируемых условиях, генерировать синтетические данные и тестировать системы еще до выхода в реальный мир. Они особенно хороши как дополнение к реальным данным, а также для изучения частных случаев, которые либо редко встречаются на практике, либо слишком накладны в реализации.

Такие среды стали особенно популярны в embodied AI, так называемом воплощенном ИИ, где мы имеем дело с роботами или беспилотными автомобилями. Здесь критически важно обеспечить безопасное обучение систем и учесть бесчисленные вариации физического мира.

Конечно, создать с нуля продвинутую 3D-симуляцию, точно моделирующую физику, и проверить ее работу — задача, требующая серьезных ресурсов и инфраструктуры. Но и эта область быстро развивается: появляются новые компании вроде Physical Intelligence, которые берутся за решение этих проблем. К тому же NVIDIA уже создала мощную платформу ISAAC для роботов с GPU-ускорением, включающую моделируемую среду на базе Omniverse — их платформы для интегрированной 3D-графики и физических расчетов.

Существует множество сред моделирования с открытым исходным кодом, которые могут поспособствовать снижению затрат на разработку. Игровой движок Unreal Engine от Epic Games стал мощным инструментом для создания таких сред благодаря высококачественной графике, реалистичной физике и гибким программным интерфейсам.

Вот несколько примеров:

-

Applied Intuition — предоставляет решения для моделирования и валидации разработчикам систем автономного вождения.

-

Sereact — немецкий стартап по автоматизации складской комплектации заказов. Его ПО построено на среде моделирования, помогающей роботам понимать пространственные и физические нюансы.

-

Wayve — британский стартап в области беспилотного транспорта, создавший несколько 4D-сред моделирования.

Перечислим также несколько сред с открытым кодом.

Для беспилотного транспорта:

-

CARLA — симулятор с акцентом на реалистичное моделирование городской среды. Недавно обновлен для работы на Unreal Engine 5.

-

LG SVL Simulator — высокоточная платформа моделирования от LG Electronics с поддержкой множества датчиков и динамики транспортных средств.

-

AirSim — симулятор для дронов и наземного транспорта на базе Unreal Engine.

Для робототехники:

-

Gazebo — универсальный симулятор роботов, интегрируемый с ROS, популярным открытым фреймворком для разработки ПО для роботов.

-

CoppeliaSim — комплексная программа для прототипирования роботов.

-

PyBullet — Python-модуль для моделирования физики в робототехнике, играх и машинном обучении, с поддержкой GPU-ускорения и возможностями глубокого обучения.

-

MuJoCo — физический движок для управления на основе моделей, разработанный для исследований в робототехнике и биомеханике.

Скрейпинг веба, книг и других материалов

Массовый сбор текста, аудио и видео стал ключевым ингредиентом в создании фундаментальных моделей. И если технологические гиганты используют свои собственные закрытые системы, то стартапам доступен целый арсенал готовых инструментов с открытым кодом. Правда, как мы увидим дальше, эти методы довольно спорные — важно внимательно изучить вопросы добросовестного использования и лицензирования, иначе можно нарваться на проблемы.

Вот что есть в арсенале:

-

Распределенные фреймворки для краулинга вроде Apache Nutch, которые позволяют легко масштабировать задачи сбора данных на множество систем;

-

Доступные облачные сервисы для экономичного запуска скрейперов;

-

«Безголовые» браузеры вроде Puppeteer и Selenium для удобного скрейпинга сайтов, активно использующих JavaScript;

-

Продвинутые библиотеки парсинга, такие как Beautiful Soup, способные работать даже с запутанными и непоследовательными структурами HTML и CSS;

-

Сервисы управления прокси и IP-адресами наподобие Luminati, помогающие обойти защиту от скрейпинга;

-

Недорогие и эффективные OCR для сканирования книг.

Определившись с набором методов, вы столкнетесь с выбором между объемом и качеством данных. Обычно баланс зависит от области применения. Например, языковые модели могут эффективно учиться даже на относительно «шумных» и неструктурированных данных, если их достаточно много. А в компьютерном зрении хороших результатов можно добиться, расширяя небольшие качественные наборы данных за счет аугментации изображений (к примеру, через обрезку, поворот или добавление шума).

Важно также продумать, как именно подготавливать датасеты — например, используя curriculum learning. Это стратегия обучения, когда данные подаются модели «от простого к сложному». Как и люди, модели лучше усваивают базовые вещи перед тем, как браться за что-то посложнее — такой подход серьезно повышает эффективность обучения. Недавно эффективность этого подхода подтвердили исследователи из Databricks: в ходе разработки своей последней открытой языковой модели DBRX они пришли к выводу, что такой метод обучения существенно улучшает качество LLM.

А вот свежий пример из практики: два стартапа последнего набора венчурного фонда Y Combinator по-разному подошли к вопросу подбора датасетов. Sync Labs сделали ставку на количество — они взяли огромный массив видео не самого высокого качества и обучили модель синхронизировать движение губ с новым аудио. Metalware пошли другим путем: взяли небольшой, но специализированный набор отсканированных изображений из учебников, добавили GPT-2 и создали ассистента для инженеров по прошивкам.

Проблемы авторского права и перспективы лицензирования

Хотя развитие ИИ-экосистемы с 2016 года в целом сыграло на руку основателям стартапов, оно принесло и новые сложности. Массовый веб-скрейпинг со стороны провайдеров главных моделей спровоцировал волну судебных исков о нарушении авторских прав от медиакомпаний, писателей и художников. Эти дела все еще рассматриваются в судах Европы и США. И хотя сейчас иски направлены либо против крупных технологических компаний и их партнеров (например, Meta и OpenAI), либо против набирающих вес лабораторий (таких как Midjourney и Stability), они подчеркивают, насколько важно стартапам тщательно продумывать подходы к сбору данных.

Если эти судебные разбирательства закончатся не в пользу компаний, им придется либо потратить огромные ресурсы на поиск защищенных авторским правом материалов в своих тренировочных данных и выплаты правообладателям, либо полностью удалить эти данные и начинать все с нуля.

Чтобы уберечь себя от рисков, некоторые компании начали проактивно выстраивать дружественные к авторам стратегии сбора данных: кто-то заключает партнерства с медиаорганизациями, кто-то напрямую платит авторам за использование их контента или голоса.

Также появляются схемы сертификации этично собранных тренировочных данных — одну из таких предложил бывший руководитель Stability. Пока эти инициативы только набирают обороты, но за ними определенно стоит следить.

Еще несколько примеров:

-

ElevenLabs — выплаты актерам озвучки и партнерства в отношении сбора голосовых данных;

-

Google — соглашение с Reddit о доступе к данным для обучения Gemini;

-

OpenAI — партнерство с Shutterstock для обучения DALL-E на их библиотеке изображений, видео, музыки и метаданных, а также соглашение с Associated Press о доступе к их новостному архиву.

Как уменьшить потребность в больших размеченных датасетах

С 2016 года мы наблюдаем заметный сдвиг в сторону методов обучения без учителя и с частичным привлечением учителя. Благодаря этим подходам вам больше не обязательно иметь под рукой большой размеченный датасет, чтобы создать мощную модель. И хотя исследователи знали об этих методах задолго до 2016 года, за последнее время они стали гораздо доступнее, совершеннее и практичнее.

О каких подходах идет речь:

-

Обучение без учителя — здесь модель фокусируется на поиске статистических паттернов и структур, присущих самим данным. Традиционно этот метод использовался для исследования больших датасетов (например, для кластеризации без учителя), а теперь стал основой предварительного обучения языковых моделей.

-

Обучение с частичным привлечением учителя — использует небольшой объем размеченных данных вместе с большим массивом неразмеченных. Особенно эффективен при доработке и улучшении производительности моделей.

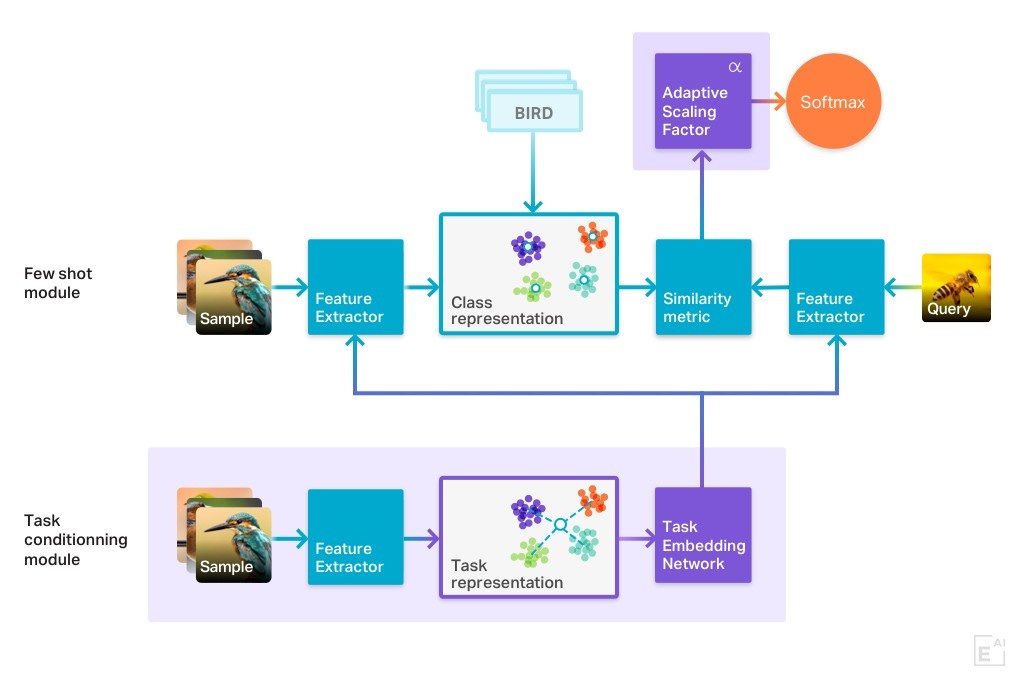

Чтобы добиться еще лучших результатов, эти подходы можно усилить контрастным обучением и few-shot learning. Контрастное обучение, например, учит модели находить тонкие различия между похожими элементами данных и явные — между непохожими. Это особенно ценно в компьютерном зрении. Яркий пример — ранее упомянутая модель CLIP от OpenAI, которая научилась связывать визуальные и текстовые представления именно благодаря контрастному обучению.

Few-shot learning, в свою очередь, позволяет моделям осваивать новые задачи всего на нескольких примерах. Исследования на эту тему показали, что чем больше модель, тем лучше она справляется с few-shot learning. Хотя такие модели и требуют больших объемов неразмеченных данных для предварительного обучения без учителя, эта особенность позволяет им решать последующие задачи с меньшим количеством размеченных примеров, чем их менее крупным негенеративным аналогам.

У этих действенных подходов есть и свои подводные камни. Модели, работающие с неразмеченными данными, часто требуют более сложной архитектуры. По сути, вы просто меняете затраты на разметку данных на затраты на вычислительные мощности.

Из-за этого такие модели не только сложнее внедрять и масштабировать — они еще и менее прозрачны в том, как принимают решения. Это становится серьезным недостатком в чувствительных областях, где критически важно понимать логику модели. К тому же вся эта сложность требует больших вычислительных ресурсов, а производительность все равно часто не дотягивает до уровня методов обучения с учителем.

Решения, которые «не взлетели»

Торговые площадки данных

С 2016 года стало проще и дешевле собирать, хранить, обрабатывать и делиться большими объемами данных. Казалось бы, самое время для появления специализированных торговых площадок — но эта идея так и не прижилась.

Платформы вроде Datarade, Dawex, AWS Data Exchange и Snowflake упростили поиск изображений, текста, аудио и видео для типовых задач. В основном это делается, чтобы предложить дополнительную ценность клиентам, которые хранят свои данные в этих озерах данных. Помимо самих таких площадок есть компании наподобие Appen, Scale AI, Invisible и Surge — они создают датасеты на заказ и размечают их с помощью внешних специалистов.

Как и в случае с открытыми данными, эти сервисы особенно хороши для задач компьютерного зрения, NLP и распознавания речи. Но есть и отраслевые решения — например, для финансов, ретейла и маркетинга, которые отвечают операционным потребностям стартапов. Плюс эти платформы можно напрямую подключать к инструментам разработчиков и исследователей, что делает весь процесс максимально безболезненным.

При этом все те же оговорки насчет специализации и конкурентного преимущества проприетарных данных остаются в силе. Да и нет особых свидетельств того, что AI-first стартапы активно используют эти площадки.

Несмотря на кажущееся удобство, все равно придется потратить немало сил на очистку, настройку, фильтрацию и отбор данных. Неудивительно, что многие предпочитают создавать собственные датасеты с нуля и использовать их как конкурентное преимущество.

То же самое касается и модели с агентствами — даже при хорошем контроле аутсорсинг имеет серьезные ограничения, когда речь заходит о специализированных приложениях.

Геймификация

Некоторые компании и организации пытались использовать игровые механики для сбора данных, особенно в проектах научного волонтерства и краудсорсинга. Яркий пример — проект Folding@Home, где с помощью геймификации удалось привлечь добровольцев, готовых предоставить свободные мощности своих компьютеров для моделирования сворачивания белков.

Но кроме нескольких подобных примеров, геймификация так и осталась нишевым решением. Она привлекает только определенную группу пользователей — людей, которых привлекает соревновательный элемент и у которых достаточно свободного времени. Это сразу ограничивает потенциальное число участников. Да и среди мотивированных пользователей качество и точность предоставляемых данных остается проблемой — нужны дополнительные проверки и контроль, особенно когда речь идет о спорных случаях.

Федеративное обучение

Google представила федеративное обучение (FL) в 2016 году, и оно выглядело многообещающе: модели можно было обучать на нескольких децентрализованных серверах или мобильных устройствах, при этом данные оставались на своих законных местах. В теории это позволило бы стартапам из таких чувствительных областей, как здравоохранение или финансы, получить доступ к важным тренировочным данным через партнерства, избегая традиционных проблем с приватностью. И хотя в последующие годы интерес к технологии взлетел как среди исследователей, так и в бизнес-среде, реальных внедрений по-прежнему очень мало.

Разработка Google столкнулась с тремя серьезными проблемами. Во-первых, вопросы ответственности, владения данными и их трансграничной передачи затормозили внедрение как раз в тех чувствительных областях, для которых технология создавалась. Во-вторых, усложнение моделей и датасетов привело к тому, что распределенное обучение и объединение данных стали требовать слишком много вычислительных ресурсов и пропускной способности сетей. В-третьих, владельцам данных сложно просто довериться математике — им предлагают принять на веру, что сложные технические решения действительно обеспечат заявленные преимущества.

Заключительные мысли

Несмотря на значительный прогресс с 2016 года, сбор данных остается больным местом для стартапов. И похоже, что ни сообщества, ни рынок пока не готовы решить эту проблему. Большинству AI-first компаний приходится начинать с нуля, но в этом есть и возможность выделиться среди конкурентов. Творческий подход к созданию качественной базы данных по-прежнему может дать серьезное конкурентное преимущество.

Впрочем, одни только данные не гарантируют долгосрочного лидерства. Рано или поздно конкуренты либо соберут собственные базы данных, либо найдут более эффективные способы достичь тех же результатов. Мы уже видим это на примере языковых моделей — за последний год разрыв в производительности между маленькими и большими моделями заметно сократился. Качественный сбор данных, безусловно, важен, но это лишь один из элементов успеха.

Автор: full_moon