Разработка AI агента, использующего большие языковые модели (LLM) – это малоизвестный пока еще и потому интересный инженерный процесс, охватывающий весь цикл создания от идеи до финального развертывания. Технические стандарты разработки агентских систем пока еще формируются. В данной статье я поделюсь своим опытом и рассмотрю ключевые этапы, технологии и практические нюансы, которые встречаются при разработке такой системы с нуля.

Рубрика «языковая модель»

Реализация AI агента на базе LLM с нуля – что включает цикл разработки

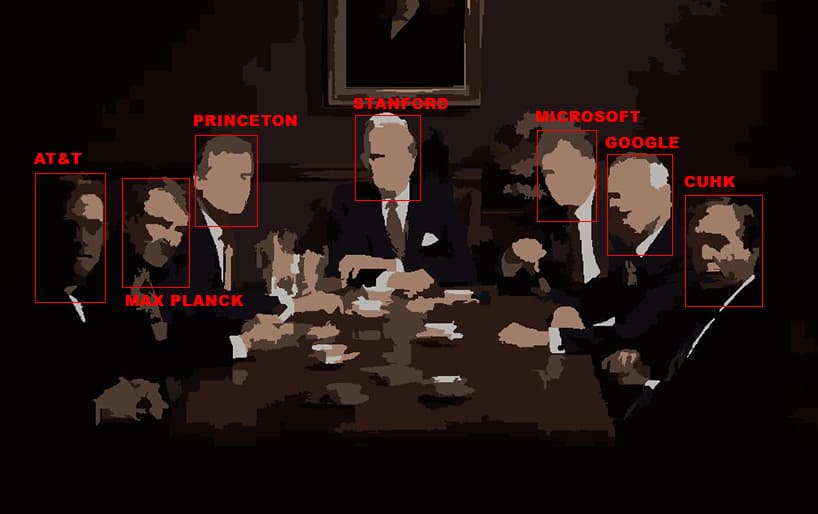

2025-03-27 в 13:16, admin, рубрики: AI, llm, llm-модели, ИИ, ии-модель, облачные сервисы, языковая модель, языковые моделиКартель влиятельных датасетов в обучении ИИ

2025-03-25 в 9:01, admin, рубрики: llm, OpenAI, ruvds_статьи, sota, YouTube, датасеты, ИИ, наборы данных, обучение ИИ, переобучение, языковая модель

В последнее время такие компании, как OpenAI и Google, заключают эксклюзивные соглашения об обмене данными с издателями, крупными форумами вроде Reddit и социальными медиаплатформами, что становится для них ещё одним способом сконцентрировать власть.

Такая тенденция выгодна крупнейшим игрокам на рынке ИИ, которые могут позволить себе такие сделки, в отличие от исследователей, некоммерческих организаций и небольших компаний. Крупнейшие корпорации располагают лучшими ресурсами для сбора датасетов. В результате эталонные датасеты для бенчмарков (и для обучения) моделей ИИ всё больше концентрируются в руках малого количества корпораций и академических учреждений.

По мнению некоторых исследователей, это «новая волна асимметричного доступа», которой ещё не было в истории открытого интернета в таком масштабе.Читать полностью »

Почему DeepSeek способен конкурировать с OpenAI и как повторить их опыт

2025-01-28 в 8:10, admin, рубрики: AI, chatgpt, deepseek, llama, OpenAI, ИИ, языковая модель, языковые моделиЗа последние два года - за время невероятной популярности Generative AI - появилось много перспективных компаний, создающих новые прорывные модели. Последний пример - это китайский стартап DeepSeek, благодаря которому у нас есть открытые аналоги OpenAI GPT-4o и o1. С теми же (что проверено бенчмарками) возможностями в плане выполнения текстовых инструкций, задач на математику, логику и кодинг.

Четыре Radeon RX 7900, нейросеть и настольная игра

2025-01-22 в 12:48, admin, рубрики: amd, llm, radeon, rocm, искусственный интеллект, настольная игра, эксперимент, языковая модельЯзыковые нейросетевые модели как только не тестировали: от решения олимпиадных задач до создания шедевров мировой литературы. У нас же родилась идея протестировать их на более прикладном уровне. А именно, сможет ли нейросеть играть по правилам в настольную игру, которая сложнее, чем крестики-нолики, и заодно посмотреть, как поведет себя в работе с LLM связка из четырех видеокарт Radeon RX 7900 XTX с 24 гигабайтами видеопамяти.

Я, Нейросеть: как программисты научили компьютеры говорить

2024-09-30 в 15:14, admin, рубрики: Eliza, gpt, нейросеть, языковая модель, языковые моделиНейросети сегодня пишут новости, рекламные тексты, стихотворения и даже целые сценарии. Как мы пришли к этому? Рассказываем историю языковых моделей — от симулятора психотерапевта из 1960-х до первых нейросетей в начале 21 века.

Автономный бизнес — Telegram канал + LLM

2024-08-29 в 16:41, admin, рубрики: python, telegram, искусственный интеллект, языковая модель

Всем привет, в этой статье я хотел бы рассказать о создании скрипта для рерайта постов Telegram каналов с помощью LLM модели и их публикации у себя на канале.

Первое, что нам потребуется это локально поднятая LLM модель, для обработки постов - их видоизменения.

Второе сам скрипт.

Импортируем нужные библиотеки:

Читать полностью »Гайд по работе языковых моделей для начинающих

2024-08-20 в 15:32, admin, рубрики: BERT, gpt, llm, nlp, nlp (natural language processing), pytorch, TensorFlow, обработка естественного языка, языковая модель, языковые моделиДля того, чтобы распознавать естественную человеческую речь, используют специальные модели — языковые. Они умеют воспринимать содержание текста, продолжать предложения и вести осмысленный диалог.

Вместе с дата-сайентистом и биоинформатиком Марией Дьяковой подготовили подробный гайд о том, как устроены самые популярные языковые модели и что нужно знать, чтобы начать с ними работать.

I в LLM означает Intelligence

2024-08-18 в 9:00, admin, рубрики: bug bounty, curl, llm, ruvds_перевод, искусственный интеллект, машинное обучение, охота на баги, языковая модель

Я уже давно ничего не писал об ИИ или том, как мы (не) используем его для разработки в нашем проекте curl. Больше откладывать нельзя. Хочу продемонстрировать вам наиболее значительный эффект, который ИИ может оказать на curl сегодня, подкрепив его примерами.Читать полностью »

Делаем анализатор ников на новой FRED-T5. Тотальный разнос

2023-05-08 в 21:12, admin, рубрики: chaosgpt, chatgpt, fred, fred-t5, python, sberai, sberdevices, анализ ников, машинное обучение, нейросети, ники, языковая модель

Мы так давно ждали, и, наконец, свершилось! В русском языке появилась новая, по-настоящему "понимающая" модель. По результатам тестов Russian SuperGLUEЧитать полностью »

GPT-апокалипсис отменяется

2023-04-03 в 14:12, admin, рубрики: chatgpt, апокалипсис, искусственный интеллект, Юдковский, языковая модель

Читая с утра новостную ленту – я обнаружил в ней очередное апокалипсическое предсказание. На этот раз от Элиезера Юдковского – известного рационального блогера, сооснователя Института Исследования Искусственного Интеллекта, более известного на Хабре как автор научно-популярного фанфика «Гарри Поттер и методы рационализма».