Рубрика «wunderfund»

Корутины в C++20 — что это и как с ними работать

2021-10-25 в 14:06, admin, рубрики: c++, C++20, wunder fund, wunderfund, асинхронное программирование, асинхронность, Блог компании Wunder Fund, корутины, Программирование, разработка, С++

Прим. Wunder Fund: В статьи описаны базовые подходы к работе с корутинами в 20м стандарте С++, на паре практических примеров разбораны шаблоны классов для промисов и фьючеров. По нашему скромному мнению, можно было бы реализовать и поизящнее. Приходите к нам работать, если имеете сильные мнения о корутинах хе-хе.

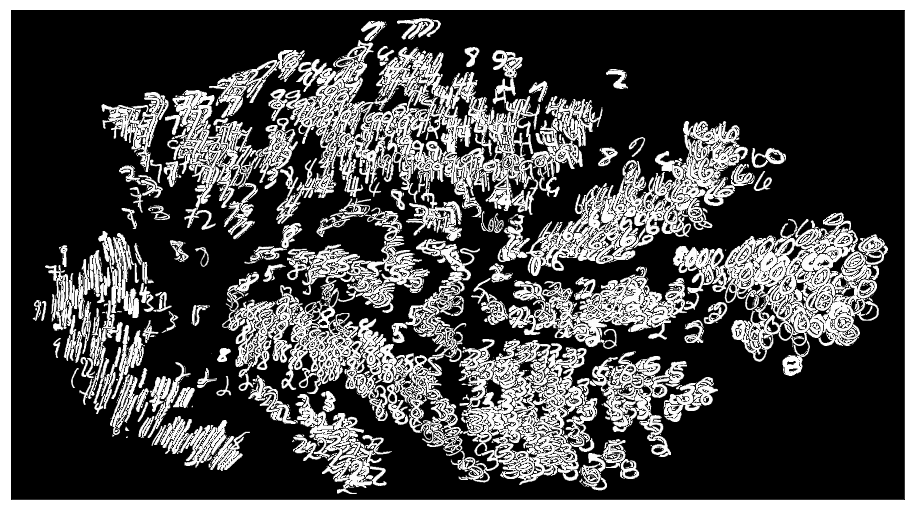

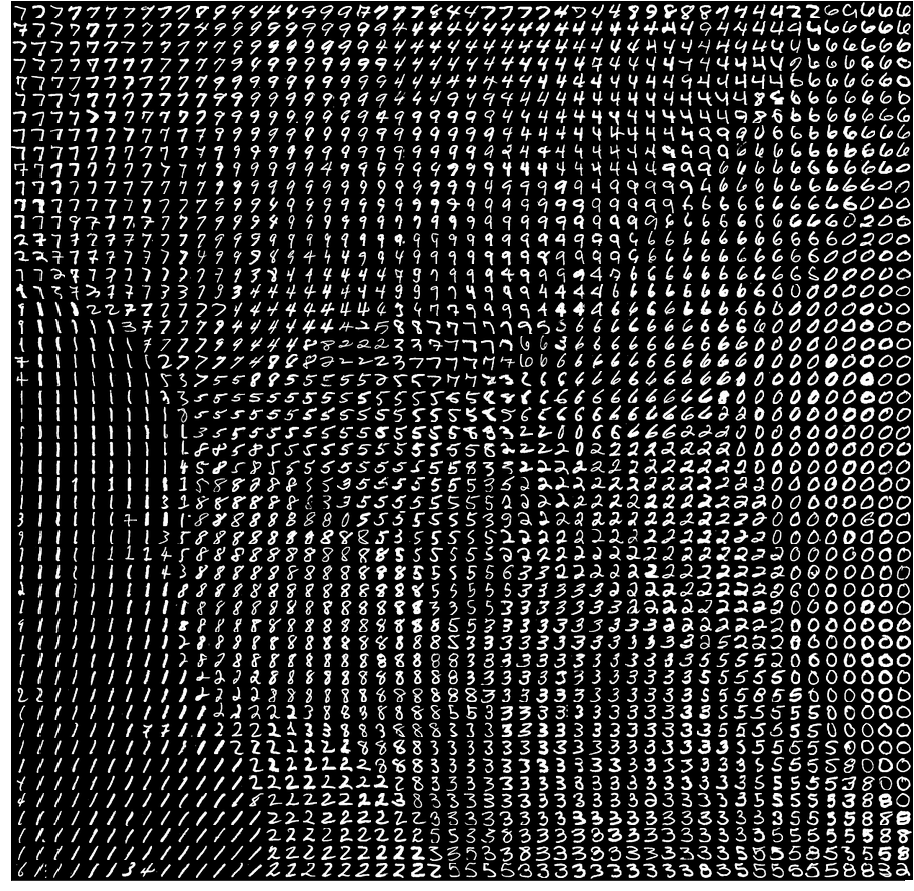

Attention для чайников и реализация в Keras

2019-07-06 в 9:28, admin, рубрики: attention, deep learning, keras, machine learning, neural networks, python, wunderfund, машинное обучениеО статьях по искусственному интеллекту на русском языке

Не смотря на то что механизм Attention описан в англоязычной литературе, в русскоязычном секторе достойного описание данной технологии я до сих пор не встречал. На нашем языке есть много статей по Искусственному Интеллекту (ИИ). Тем не менее, те статьи, которые удалось найти, раскрывают только самые простые модели ИИ, например, свёрточные сети, генеративные сети. Однако, по передовым новейшим разработками в области ИИ статей в русскоязычном секторе крайне мало.

Логарифмируй это: метод логарифмической производной в машинном обучении

2017-08-21 в 13:06, admin, рубрики: wunder fund, wunderfund, Алгоритмы, Блог компании Wunder Fund, вариационное исчисление, математика, машинное обучение, монте-карло, обучение с подкреплением, стохастическая оптимизация

Прием, о котором пойдет речь — метод логарифмической производной — помогает нам делать всякие штуки, используя основное свойство производной от логарифма. Лучше всего этот метод зарекомендовал себя в решении задач стохастической оптимизации, которые мы исследовали ранее. Благодаря его применению, мы нашли новый способ получения стохастических градиентных оценок. Начнем с примера использования приема для определения оценочной функции.

Довольно математично.

Читать полностью »

Генеративные модели от OpenAI

2017-08-01 в 16:49, admin, рубрики: deep learning, GAN, generative models, machine learning, OpenAI, wunder fund, wunderfund, Алгоритмы, Блог компании Wunder Fund, машинное обучение

Эта статья посвящена описанию четырех проектов, объединенных общей темой усовершенствования и применения генеративных моделей. В частности, речь пойдет о методах обучения без учителя и GAN.

Помимо описания нашей работы, в этой статье мы хотели бы подробнее рассказать о генеративных моделях: их свойствах, значении и возможных перспективах развития.

Читать полностью »

LSTM – сети долгой краткосрочной памяти

2017-06-21 в 10:03, admin, рубрики: LSTM, machine learning, neural networks, RNN, wunder fund, wunderfund, Алгоритмы, Блог компании Wunder Fund, машинное обучение

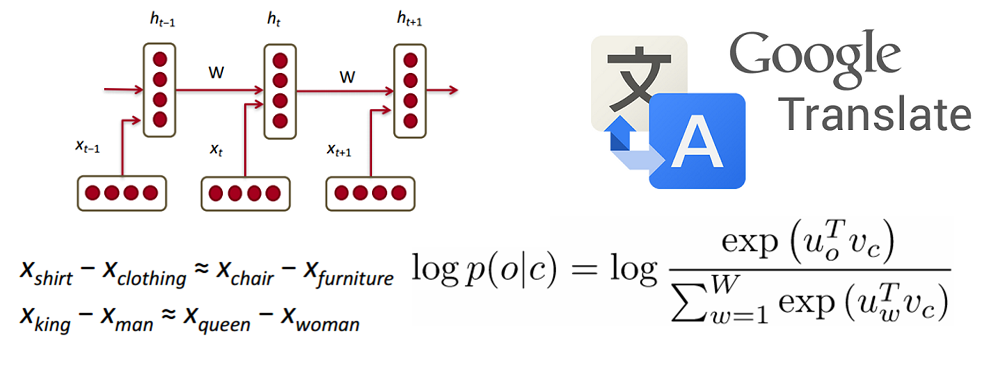

Рекуррентные нейронные сети

Люди не начинают думать с чистого листа каждую секунду. Читая этот пост, вы понимаете каждое слово, основываясь на понимании предыдущего слова. Мы не выбрасываем из головы все и не начинаем думать с нуля. Наши мысли обладают постоянством.

Традиционные нейронные сети не обладают этим свойством, и в этом их главный недостаток. Представим, например, что мы хотим классифицировать события, происходящие в фильме. Непонятно, как традиционная нейронная сеть могла бы использовать рассуждения о предыдущих событиях фильма, чтобы получить информацию о последующих.

Решить эту проблемы помогают рекуррентые нейронные сети (Recurrent Neural Networks, RNN). Это сети, содержащие обратные связи и позволяющие сохранять информацию.

Читать полностью »

Dropout — метод решения проблемы переобучения в нейронных сетях

2017-06-14 в 11:38, admin, рубрики: big data, deep learning, dropout, neural networks, overfitting, wunder fund, wunderfund, Алгоритмы, Блог компании Wunder Fund, машинное обучение, метки: dropout

Переобучение (overfitting) — одна из проблем глубоких нейронных сетей (Deep Neural Networks, DNN), состоящая в следующем: модель хорошо объясняет только примеры из обучающей выборки, адаптируясь к обучающим примерам, вместо того чтобы учиться классифицировать примеры, не участвовавшие в обучении (теряя способность к обобщению). За последние годы было предложено множество решений проблемы переобучения, но одно из них превзошло все остальные, благодаря своей простоте и прекрасным практическим результатам; это решение — Dropout (в русскоязычных источниках — “метод прореживания”, “метод исключения” или просто “дропаут”).

Читать полностью »

Обзор исследований в области глубокого обучения: обработка естественных языков

2017-06-05 в 12:54, admin, рубрики: deep learning, gru, LSTM, machine learning, natural language processing, neural networks, RNN, wunder fund, wunderfund, Блог компании Wunder Fund, машинное обучение

Это третья статья из серии “Обзор исследований в области глубокого обучения” (Deep Learning Research Review) студента Калифорнийского университета в Лос-Анджелесе Адита Дешпанда (Adit Deshpande). Каждые две недели Адит публикует обзор и толкование исследований в определенной области глубинного обучения. В этот раз он сосредоточил свое внимание на применении глубокого обучения для обработки текстов на естественном языке.

Читать полностью »

О том, как в Instagram отключили сборщик мусора Python и начали жить

2017-05-15 в 11:53, admin, рубрики: garbage collector, python, wunder fund, wunderfund, Блог компании Wunder Fund, высокая производительность, ненормальное программированиеОтключив сборщик мусора Python (GC), который освобождает память, отслеживая и удаляя неиспользуемые данные, Instagram стал работать на 10% быстрее. Да-да, вы не ослышались! Отключив сборщик мусора, можно сократить объем потребляемой памяти и повысить эффективность работы кэша процессора. Хотите узнать, почему так происходит? Тогда пристегните ремни!

Читать полностью »