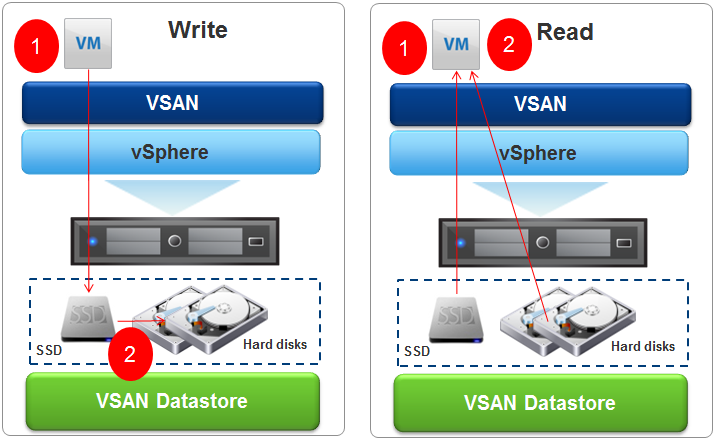

Использование виртуального твердотельного накопителя поможет Вам сэкономить и время и деньги. VMware vSphere 5.5 новейшая редакция передовой платформы виртуализации, это аппаратный гипервизор, устанавливается непосредственно на физический сервер и делит его на несколько виртуальных машин, которые могут работать одновременно, используя одни и те же физические ресурсы. Дисковое пространство необходимое для установки снижено до 150 MB платформы vSphere, за счет отсутствия базовой операционной системы. Управление такой платформой может производиться удаленно.

Рубрика «vSphere» - 3

Создание виртуального SSD для vSphere 5.5

2014-12-04 в 14:17, admin, рубрики: ESX, ESXi, secure shell, VMware, vSphere, виртуализация, системное администрирование, хостингО Nutanix, Web-Scale, конвергентных платформах и смене парадигм построения IT инфраструктур

2014-10-19 в 21:45, admin, рубрики: acropolis, azure, azure pack, big data, BigData, ESXi, hyper-v, hyperv, kvm, openstack, rest api, vcloud, vdi, vSphere, акрополис, Блог компании Nutanix, виртуализация, катастрофоустойчивостьВозможно, вы уже слышали достаточно новый для рынка не_онлайн проектов термин — Web-Scale IT, который по мнению Gartner в 2017 году займет не менее 50% рынка корпоративного IT.

В этом году — это один из основных модных терминов.

Ситуация на корпоративных рынках сейчас активно напоминает фразу про подростковый секс — все говорят что имели (= умеют), но реально — дела обстоят невесело.

Буквально каждый вендор рассказывает про BigData, конвергентные решения, перспективы и прочее.

Мы в свою очередь смеем надеяться, что у нас с этим реально все весьма неплохо, но тут всегда виднее со стороны и ваше мнение может не совпадать с нашим.

Все же попробуем рассказать о том, как мы пытаемся изменить рынок, который в ближайшее время будет составлять десятки миллиардов долларов ежегодно и почему мы считаем что время традиционных решений для хранения и обработки данных подходит к своему закату.

VMware vCloud Connector ч. 1. Обзор продукта и установка базовой версии

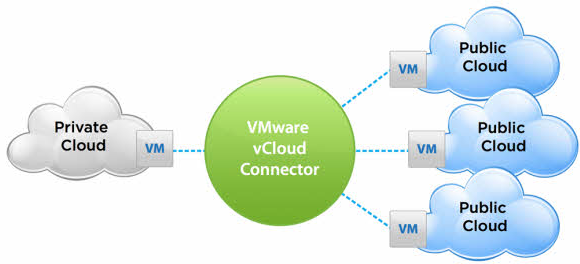

2014-07-23 в 5:29, admin, рубрики: cloud, hybrid cloud, private cloud, Public Cloud, vcloud connector, vcloud director, virtualization, VMware, vSphere, виртуализацияvCloud Connector — продукт компании VMware входящий в набор vCloud Suite — который позволяет подключать публичные облака (vCloud Director), удаленные vSphere инфраструктуры к локальной vSphere инфраструктуре, перемещать машины между инфраструктурами.

Возможности (общая схема работы):

Снова об облаках. Несколько инструментов для администраторов виртуальных инфраструктур от VMware

2014-06-25 в 9:35, admin, рубрики: NetWrix, VMware, vSphere, Блог компании NetWrix, виртуализация, виртуальная машина, системное администрирование, метки: NetWrix, vmware, vSphere, виртуальная машина

В VMware Community опубликовано сообщение от Mike Foley, бессменного автора vSphere Hardening Guide о том, что новая версия гайда стала доступна для загрузки.

vSphere Hardening Guide — это сборник информации об уязвимостях, типах операций, которые устраняют эти уязвимости, процедурах оценки соответствия нормативам безопасности и пр. Документ выполнен в виде книги Excel, каждая её страница соответствует типу объекта виртуальной инфраструктуры (VM, ESXi, vNetwrok, vCenterServer, VUM, SSO, WebClient, VCSA).

Оптимизация работы виртуальной инфраструктуры на базе VMWare vSphere

2014-06-15 в 9:30, admin, рубрики: ESXi, vSphere, виртуализация, системное администрирование, метки: ESXi, vSphere

Практика показывает, что любой процесс, в определенной степени, всегда можно оптимизировать. Это вполне можно отнести и к виртуализации. Возможностей оптимизации тут достаточно много, и задача эта многогогранна.

В пределах данной статьи я хочу ознакомить вас с методиками сайзинга виртуальных машин, а так же о методах оптимизации их работы. Материал будет техническим и рекомендуется к ознакомлению всем специалистам по vSphere.

Читать полностью »

Базовая информация о VMWare vSphere

2014-06-14 в 19:23, admin, рубрики: VMware, vSphere, виртуализация, метки: vmware, vSphereVMware и KVM: гонка гипервизоров OpenStack набирает обороты

2014-03-13 в 10:56, admin, рубрики: DynamicOps, kvm, linux, open source, openstack, vSphere, Блог компании Mirantis/OpenStack, гипервизор, мирантисАвтор: Борис Ренский

Используемый по умолчанию в облачном программном обеспечении OpenStack гипервизор KVM сталкивается с растущей конкуренцией со стороны VMware ESX Server. Один из основателей компании Mirantis Борис Ренский рассматривает данную гонку в контексте.Читать полностью »

Создание надёжного iSCSI-хранилища на Linux, часть 2

2014-01-21 в 9:39, admin, рубрики: drbd, fault, iscsi, linux, scst, target, tolerance, VMware, vSphere, виртуализация, системное администрирование, метки: drbd, fault, iscsi, linux, scst, target, tolerance, vmware, vSphereПродолжаем

Продолжаем создание кластера, начатое первой части.

На этот раз я расскажу про настройку кластера.

В прошлый раз мы закончили на том, что началась синхронизация DRBD.

Если мы в качестве Primary сервера для обоих ресурсов выбрали один и тот же сервер, то после завершения синхронизации должны в /proc/drbd увидеть примерно такую картину:

# cat /proc/drbd

version: 8.4.3 (api:1/proto:86-101)

GIT-hash: 89a294209144b68adb3ee85a73221f964d3ee515 build by root@debian-service, 2013-04-30 07:43:49

0: cs:Connected ro:Secondary/Primary ds:UpToDate/UpToDate B r-----

ns:0 nr:190397036 dw:190397036 dr:1400144904 al:0 bm:4942 lo:0 pe:0 ua:0 ap:0 ep:1 wo:d oos:0

1: cs:Connected ro:Secondary/Primary ds:UpToDate/UpToDate B r-----

ns:0 nr:720487828 dw:720485956 dr:34275816 al:0 bm:3749 lo:468 pe:0 ua:0 ap:0 ep:1 wo:d oos:0

Самое интересное поле тут ds:UpToDate/UpToDate, означающее что и локальная и удаленная копия актуальны.

После этого переведем ресурсы в secondary режим — дальше ими будет управлять кластер:

# drbdadm secondary VM_STORAGE_1

# drbdadm secondary VM_STORAGE_2

Pacemaker

Итак, менеджер кластера.

Если коротко, то это мозг всей системы, который управляет абстракциями, называемыми ресурсами.

Ресурсом кластера может быть, в принципе, что угодно: IP-адреса, файловые системы, DRBD-устройства, программы-службы и так далее. Довольно просто создать свой ресурс, что мне и пришлось сделать для управления iSCSI таргетами и LUN-ами, об этом далее.

Установим:

# apt-get install pacemaker

Corosync

Pacemaker использует инфраструктуру Corosync для взаимодействия между узлами кластера, поэтому для начала нужно будет настроить её.

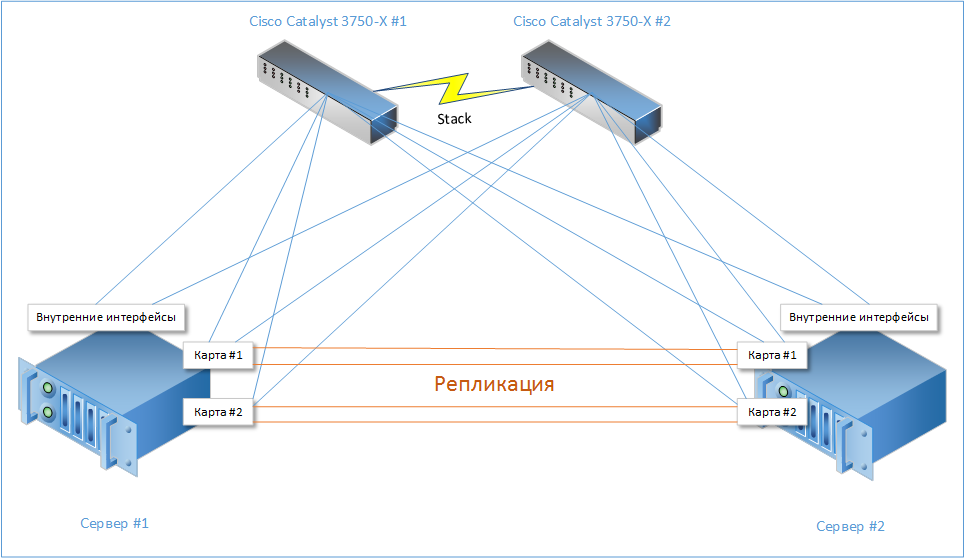

Corosync имеет достаточно широкий функционал и несколько режимов для поддержки связи между нодами (unicast, multicast, broadcast), имеет поддержку RRP (Redundant Ring Protocol), которая позволяет использовать несколько разных путей для общения между нодами кластера для минимизации риска получить Split-brain, то есть ситуации, когда связь между нодами полностью пропадает, и они обе считают что сосед умер. В результате обе ноды переходят в рабочий режим и начинается хаос :)

Поэтому мы будем использовать как репликационный, так и внешний интерфейсы для обеспечения связности кластера.Читать полностью »

Создание надёжного iSCSI-хранилища на Linux, часть 1

2014-01-18 в 19:31, admin, рубрики: drbd, fault, iscsi, linux, scst, target, tolerance, VMware, vSphere, виртуализация, системное администрирование, метки: drbd, fault, iscsi, linux, scst, target, tolerance, vmware, vSphereПрелюдия

Сегодня я расскажу вам как я создавал бюджетное отказоустойчивое iSCSI хранилище из двух серверов на базе Linux для обслуживания нужд кластера VMWare vSphere. Были похожие статьи (например), но мой подход несколько отличается, да и решения (тот же heartbeat и iscsitarget), используемые там, уже устарели.

Статья предназначена для достаточно опытных администраторов, не боящихся фразы «патчить и компилировать ядро», хотя какие-то части можно было упростить и обойтись вовсе без компиляции, но я напишу как делал сам. Некоторые простые вещи я буду пропускать, чтобы не раздувать материал. Цель этой статьи скорее показать общие принципы, а не расписать всё по шагам.

Вводные

Требования у меня были простые: создать кластер для работы виртуальных машин, не имеющий единой точки отказа. А в качестве бонуса — хранилище должно было уметь шифровать данные, чтобы враги, утащив сервер, до них не добрались.

В качестве гипервизора был выбран vSphere, как наиболее устоявшийся и законченый продукт, а в качестве протокола — iSCSI, как не требующий дополнительных финансовых вливаний в виде коммутаторов FC или FCoE. С опенсурсными SAS таргетами довольно туго, если не сказать хуже, так что этот вариант тоже был отвергнут.

Осталось хранилище. Разные брендовые решения от ведущих вендоров были отброшены по причине большой стоимости как их самих по себе, так и лицензий на синхронную репликацию. Значит будем делать сами, заодно и поучимся.

В качестве софта было выбрано:

- Debian Wheezy + LTS ядро 3.10

- iSCSI-таргет SCST

- DRBD для репликации

- Pacemaker для управления ресурсами кластера и мониторинга

- Подсистема ядра DM-Crypt для шифрования (инструкции AES-NI в процессоре нам очень помогут)

В итоге, в недолгих муках была рождена такая несложная схема:

Читать полностью »

Читать полностью »