Привет! В этом материале мы расскажем, стоит ли организовывать RAID-массивы на базе твердотельных решений SATA SSD и NVMe SSD, и будет ли от этого серьезный профит? Мы решили разобраться в этом вопросе, рассмотрев виды и типы контроллеров, которые позволяют это сделать, а также сферы применения таких конфигураций.

Рубрика «цод» - 7

Нужно ли создавать RAID-массив из SSD и какие контроллеры для этого нужны

2019-12-26 в 12:17, admin, рубрики: Kingston, raid, raid контроллер, SSD-накопитель, Блог компании Kingston Technology, высокая производительность, контроллер, Накопители, накопитель, серверное решение, хранение данных, цодЭкология и дата-центры. Как в России и за её пределами «озеленяют данные»

2019-12-17 в 8:01, admin, рубрики: apple, Facebook, Google, microsoft, биогаз, Блог компании ГК ЛАНИТ, ветроэнергостанции, гидроэлектростанции, загрязнение, зеленые дата-центры, Ланит, онланта, солнечные батареи, технологии, хранение данных, цод, чиллеры, экология, электроэнергия, Энергия и элементы питанияМы с коллегами изучили опыт мировых IT-гигантов в вопросе экологичности центров обработки данных, выжали самый сок из материалов о том, как Apple, Google, Facebook, Microsoft и многие другие организуют синергетическую модель эффективности работы дата-центров. Также мы узнали, насколько «грязные» данные в Европе, Америке, России и продемонстрировали, почему высокотехнологичная Азия – это «территория экологических контрастов».

На страже природы сегодня — магнитная левитация, искусственный интеллект, биогаз, ЦОДы, вживленные в экосистему, и другие эко-технологии. Эта статья максимально прокачивает КПД дата-центров, минимально влияя на окружающую среду.

Особенности строительства национальных дата-центров, Михалыч

2019-12-10 в 6:56, admin, рубрики: Блог компании КРОК, дата-центр, информационная безопасность, инфраструктура, оборудование, проектирование, технологии, цод

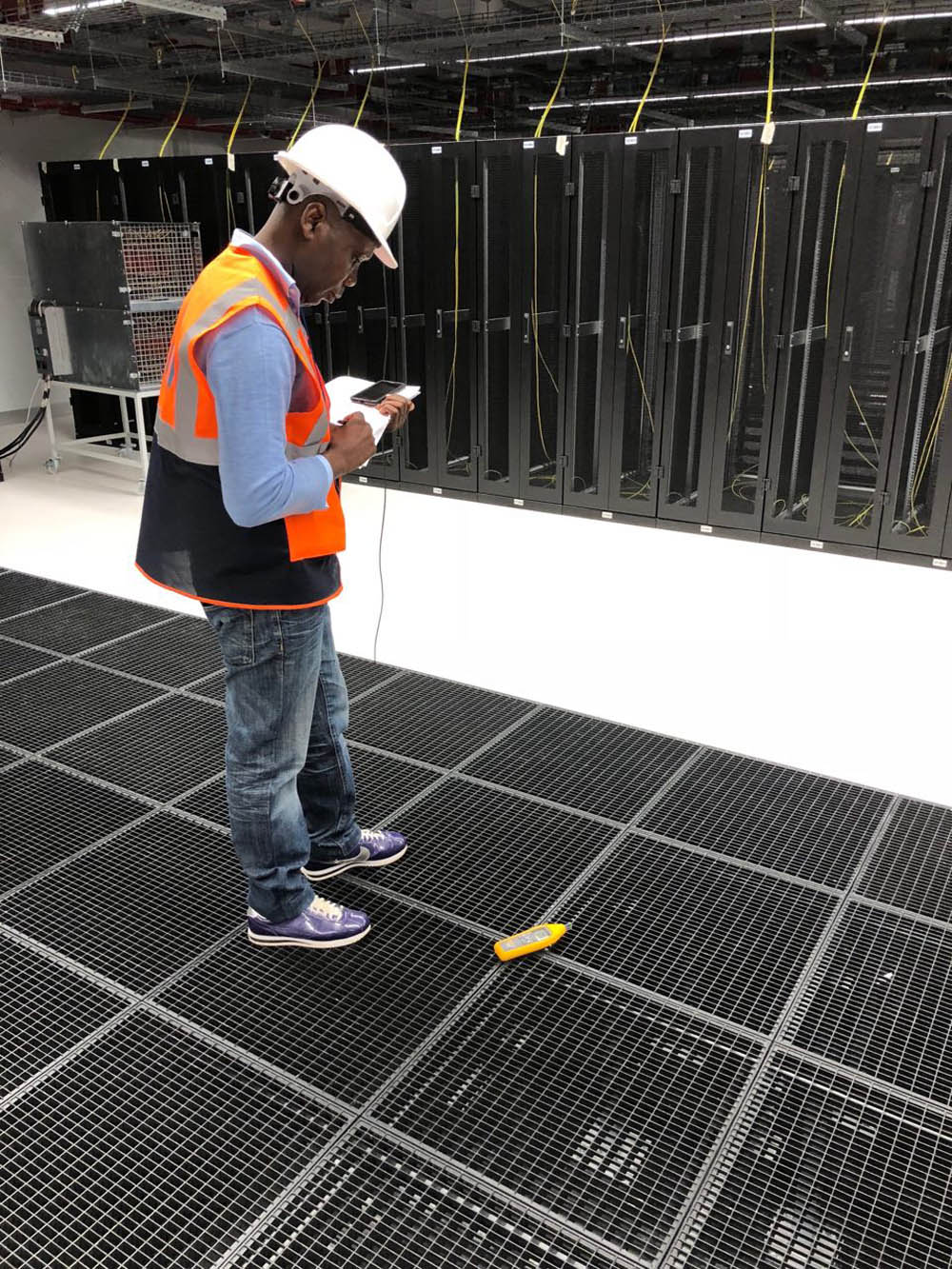

Проводим измерения для прохождения сертификации по Tier 3 в дата-центре в Стамбуле. И нет, на фото не я.

Я руковожу проектами создания ЦОДов в России и за рубежом. И хочу рассказать о том, как в последние годы российские ЦОДы приобретают свой особый стиль проектирования.

И я не про истории вроде того, что если в проекте есть контейнерный дизель-генератор, то надо обязательно сразу спроектировать площадку для курения близко к выходу из здания. Потому что, если так не сделать, народ будет курить за ДГУ и бросать бычки на землю или прямо в дырку вентиляции. А когда его нужно будет завести, он заберёт потоком воздуха их все в радиусе пары метров и сразу забьёт фильтр.

Скорее речь идёт о более глобальных вещах, касающихся общих идеи и стиля проектирования. Основывается этот стиль на том, что российский заказчик обычно знает, что ему нужен ЦОД, но не знает, какое ИТ-оборудование он поставит в него через год или два, не говоря уже про перспективу десяти лет. Поэтому дата-центр проектируется максимально универсальным. Если описать это как «следующие десять лет размещать любое оборудование, которое выходит на рынок», то не особо промахнётесь. В итоге получается, что проект ЦОДа нацелен на то, чтобы объект легко модернизировался в будущем без переделки здания, капитальных реноваций и так далее.

Пример: никто не знает «на берегу» какую необходимо делать ширину «холодного» коридора. Да, есть минимальные нормативы, но мы в последние годы стараемся сделать его шириной не менее 2,4 метра, потому что есть негабаритное оборудование в своём конструктиве, которое от 1 500 мм в глубину и необходимо учитывать его радиус поворота, закладывая ширину коридора.Читать полностью »

Конкурс! Истории при свете мерцающих серверов…

2019-10-31 в 14:56, admin, рубрики: halloween, байки, Блог компании Selectel, ДГУ, Занимательные задачки, истории, конкурс, Серверное администрирование, системное администрирование, цод

На Хабре сегодня уже звучали хэллоуинские байки. А как насчет конкурса на самую страшную историю?

Пускай она начинается так:

Пустой ночной офис отзывался холодом. Шум серверов и ветер в холодных коридорах притупляли накрывающее чувство одиночества. Уставший от ослепляющего света монитора, он решил найти минутное освобождение в какао с маковыми сушками. Едва сделав шаг в сторону кофе-поинта, он почувствовал, как запускается ДГУ...

А продолжение этой истории предстоит придумать вам!

Читать полностью »

Байки из ЦОДа: хэллоуинские страшилки о дизелях, дипломатии и саморезах в калорифере

2019-10-31 в 7:03, admin, рубрики: байки, Блог компании КРОК, ИБП, инженерия, инженерная инфраструктура, инженерные системы, охлаждение, цодМы с коллегами подумали: почему бы перед любимым хоррор-праздником вместо успехов и интересных проектов не вспомнить всякие ужастики, с которыми сталкиваются люди в цодостроительстве. Итак, выключите свет, включите тревожную музыку, сейчас будут истории, от которых мы до сих пор иногда просыпаемся в холодном поту.

«Тушить» ли сервера, если «загорелся» смоук тест датацентра?

2019-10-29 в 5:37, admin, рубрики: Блог компании Одноклассники, высокая производительность, инфраструктура, отказоустойчивость, пожар, системное администрирование, цодЧто бы вы почувствовали, если в один прекрасный летний день дата-центр с вашим оборудованием стал бы выглядеть вот так?

Всем привет! Меня зовут Дмитрий Самсонов, я работаю ведущим системным администратором в «Одноклассниках». На фотографии один из четырёх дата-центров, где установлено оборудование, обслуживающее наш проект. За этими стенами находится около 4 тыс. единиц техники: серверы, система хранения данных, сетевое оборудование и т.д. — почти ⅓ всего нашего оборудования.

Большинство серверов — это Linux. Есть и несколько десятков серверов на Windows (MS SQL) — наше наследие, от которого мы на протяжении многих лет планомерно отказываемся.

Итак, 5 июня 2019 г. в 14:35 инженеры одного из наших дата-центров сообщили о пожарной тревоге.

Читать полностью »

Развернуть дата-центр за время доставки пиццы

2019-10-22 в 7:05, admin, рубрики: Cisco, cisco hyperflex, Блог компании КРОК, виртуализация, дата-центр, Железо, настройка, пицца, развертывание, стенд, тест, цод

— Да этот ЦОД можно развернуть и настроить, пока ты пиццу заказываешь!

Я бросил эти слова на совещании, и расплата пришла немедленно. Коллега предложила заказать пиццу. Оплачивает проигравший: если я успеваю собрать ЦОД — то она, если не успеваю — то я.

Чёрт!

В общем, встречайте стресс-тест: гиперконвергентное решение от Cisco с простой настройкой против приготовления пиццы.Читать полностью »

По вашим заявкам: профессиональный тест SSD-накопителей Kingston DC500R и DC500M

2019-10-18 в 10:26, admin, рубрики: SSD-накопитель, Блог компании Kingston Technology, высокая производительность, накопитель, накопитель для ЦОД, серверные решения, Сетевое оборудование, стойка, хранение данных, хранилище, центр обработки данных, цодВы просили показать реальные примеры использования наших корпоративных SSD-накопителей и профессиональные тесты. Предоставляем вашему вниманию подробный обзор наших SSD-накопителей Kingston DC500R и DC500M от нашего партнера Truesystems. Эксперты Truesystems собрали реальный сервер и эмулировали абсолютно реальные задачи, с которыми сталкиваются все твердотельные накопители корпоративного класса. Давайте почитаем, что у них получилось!

Админ без рук = гиперконвергенция?

2019-10-15 в 7:02, admin, рубрики: Cisco, cisco hyperflex, Блог компании КРОК, виртуализация, гиперконвергенция, дата-центр, Железо, стенд, тест, цод

Это миф, достаточно распространённый в сфере серверного железа. На практике же гиперконвергентные решения (когда всё в одном) нужны много для чего. Исторически сложилось, что первые архитектуры были разработаны Amazon и Google под свои сервисы. Тогда идея была в том, чтобы сделать вычислительную ферму из одинаковых узлов, у каждого из которых есть собственные диски. Всё это объединялось неким системообразующим софтом (гипервизором) и разбивалось уже на виртуальные машины. Главная задача — минимум усилий на обслуживание одного узла и минимум проблем при масштабировании: просто докупили ещё тысячу-другую таких же серверов и подключили рядом. На практике это единичные случаи, и гораздо чаще речь про меньшее число узлов и немного другую архитектуру.

Но плюс остаётся тем же — невероятная простота масштабирования и управления. Минус — разные задачи по-разному потребляют ресурсы, и где-то локальных дисков будет много, где-то мало оперативки и так далее, то есть при разном типе задач будет падать утилизация ресурсов.

Получалось, что вы платите на 10–15% больше за удобство настройки. Это и вызвало миф из заголовка. Мы долго искали, где же будет применяться технология оптимально, и нашли. Дело в том, что у Циски не было своих СХД, но они хотели полный серверный рынок. И они сделали Cisco Hyperflex — решение с локальными хранилищами на нодах.

А из этого внезапно получилось очень хорошее решение для резервных дата-центров (Disaster Recovery). Почему и как — сейчас расскажу. И покажу тесты кластера. Читать полностью »

Путешествие по ЦОД Selectel. Динозавр в огне, VMware, С2F5H и невидимый оборотень

2019-09-18 в 18:06, admin, рубрики: selectel, Блог компании Southbridge, виртуализация, как всё устроено, как это работает, системное администрирование, хранилища данных, цод, экскурсияРабота сисадмина основана на вере, что инженеры ЦОДа знают свое дело. Мы создаем отказоустойчивые кластеры, но чего будет стоить эта отказоустойчивость, если отключится электричество? Какая разница, как быстро сервер обрабатывает запрос, если упал канал от ЦОДа до точки обмена трафиком? Как поднимать сервер, если он физически перегрелся?

А хотелось бы не верить, а знать, как именно создается отказоустойчивость на железном уровне. Откуда берутся те «девятки» надежности оборудования, о которых мы говорим, формулируя SLA Кубернетесов. Что происходит, когда проект горит в самом прямом смысле этого слова.

Нам повезло пройтись по ЦОД Selectel на третий день Слёрма DevOps, заглянуть в святая святых и даже кое-что сфотографировать на память. А также мы спросили о легендах компании, которые сотрудники Selectel никому никогда не рассказывают. Да и как выяснилось, сами уже не помнят.

Нашу компанию Southbridge связывают с Selectel давние партнёрские отношения. Сейчас мы поддерживаем 58 проектов, размещенных на серверах провайдера. Когда клиенту нужен сервер, расположенный в России, мы рекомендуем Selectel, потому что по опыту работы считаем его самым надежным и удобным провайдером IT-инфраструктуры.

Поехали!