В столице Нидерландов и в радиусе 50 км расположено 70% всех дата-центров страны и третья часть всех дата-центров Европы. Большинство из них открылись буквально за последние лет пять. Это действительно очень много, учитывая, что Амстердам относительно небольшой город. Даже Рязань больше! Дошло до того, что в июле 2019 года власти голландской столицы, сделав вывод, что такого количества ЦОДов, как в Амстердаме, нет ни в одном другом крупном городе мира, решили ограничить строительство новых центров обработки данных по крайней мере до конца 2019 года. Что же так влечёт операторов ЦОД и другие ИТ-компании (включая нас) в Амстер? Мы, конечно, пока не построили там свой дата-центр, но новую гермозону открыли. О ней – во второй части статьи, а в первой – о вожделенном Амстердаме.

Рубрика «цод» - 6

Почему в Амстердаме так много дата-центров

2020-04-07 в 12:10, admin, рубрики: Блог компании RUVDS.com, дата-центр, облачные сервисы, Офисы IT-компаний, Серверное администрирование, хранение данных, хранение информации, цодИнженерный спецназ: жара и холод

2020-04-02 в 6:57, admin, рубрики: байки, Блог компании КРОК, заказчик, оборудование, управление проектами, цод, эксплуатация

Используем товары ближайшего магазина для приготовления технической промывочной смеси.

Банк, аудит системы хладоснабжения ЦОДа. Есть действующая служба эксплуатации банка, у них сервисный договор с организацией ООО «Весёлые медузы». Ребята работают, деньги получают. Но системы сбоят регулярно, останавливаясь по высокому давлению, когда температура на улице повышается.

Приезжаем на место на Дальний Восток разбираться. Собрали фреон, взвесили, сравнили проектный расчёт от производителя и фактическую заправку. Всё просто: предыдущий «сервис» налил в него больше, чем нужно.

Есть шильдик, где написаны модель, серийный номер и большими буквами, сколько нужно заправлять хладагента. Но всё это игнорируется, люди работают по ощущениям:

— Зачем весы? Я же и так знаю, сколько туда надо. Был баллон 15 килограммов — стал весить примерно 12. Ну я и заправил три килограмма. Почему три? Ну этого же достаточно.

Или вот, например, крупный завод на Урале, там другая проблема. На монтаже подрядчик забыл добавить в хладоноситель присадку, которая снижает агрессивность среды. Через два года металлическую трубу разъело изнутри коррозией. Дальше — аварийная остановка оборудования. Мы приехали, перебрали. Почему изначально после запуска системы в работу никто не сделал отбор пробы хладоносителя, не провёл анализ химического состава для безопасной эксплуатации — вопрос. Читать полностью »

Электробусы и их батареи: что такое литий-титанат? (Part.1)

2020-03-31 в 16:25, admin, рубрики: electric vehicles, EVs, Li-Ion, Li-Ion технологии, Li-Titanat, lithum-Ion, LTO, ups, батареи, безопасный литий, бесперебойное электроснабжение, достоинства Li-Ion технологии, ИБП, инженерные системы, литий-ионные батареи, хранение данных, цод, электробус, Энергия и элементы питания фото c сайта www.zr.ru

фото c сайта www.zr.ru

Друзья здравствуйте, всем здоровья, берегите себя, антисептики — наше ВСЁ!

Сегодня попробуем рассмотреть московские электробусы по мотивам статьи в журнале «За рулем» в части используемых литий-титанатных батарей (Li4Ti5O12 или LTO), их стоимости и перспектив эксплуатации, также попробуем разобраться, почему литий-титанат не подходит для промышленных решений в ИБП.

После нашей статьи «Li-Ion технологии: удельная стоимость снижается быстрее прогнозов» вызвал интерес литий-титанат как «не автомобильный» литий. На мой взгляд LTO как раз и является самым что ни на есть тяговыми батареями, которые совершенно не подходят для работы в качестве аккумуляторных батарей в ИБП и телекоме. Почему? Давайте разберемся под катом, структуру статьи условно разделим на три части:

- Что такое электробус и почему LTO?

- Химия-химия...., все батарейки одинаковые? В чем отличие LTO, LpTO и LFP

- Стоимость литий-ионных решений на данном этапе: мировые данные и примерные коэффициенты на рынке РФ

Li-Ion технологии: удельная стоимость снижается быстрее прогнозов

2020-03-23 в 17:17, admin, рубрики: Li-Ion, Li-Ion технологии, ups, батареи, безопасный литий, бесперебойное питание, бесперебойное электроснабжение, достоинства Li-Ion технологии, ИБП, инженерные системы, литий-ионные батареи, цод, Энергия и элементы питания

И снова здравствуйте, друзья!

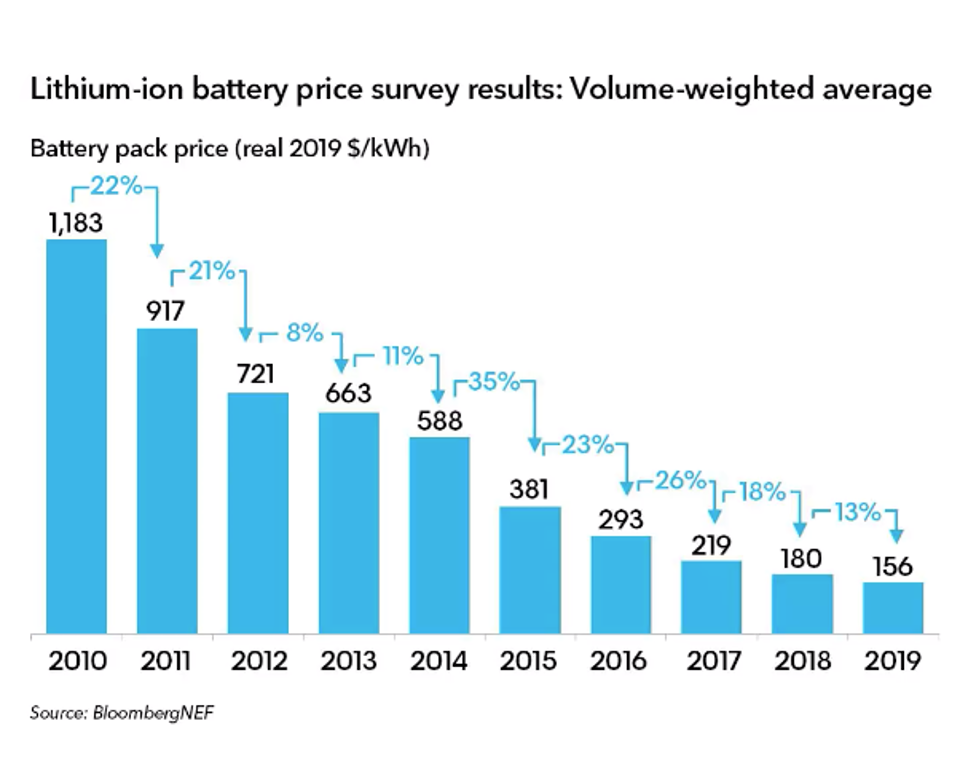

В статье «Время литий-ионных ИБП: пожароопасность или безопасный шаг в будущее?»мы касались вопроса о прогнозируемой стоимости Li-Ion решений (накопителей, аккумуляторов) в удельном выражении — $/кВт*ч. Тогда на 2020 год был прогноз в 200 $/кВт*ч. Сейчас, как видно из КДПВ стоимость лития ушла ниже 150$ и прогнозируется стремительное падение ниже 100$/кВтч (по версии Forbes). Что это меняет, спросите Вы? В первую очередь снижается разрыв между стоимостью классических батарей и перспективных технологий, а также решений на их базе. Давайте попробуем посчитать на базе кейса той самой японской субмарины на Li-Ion батареях.

Читать полностью »

USA: Компания PG&E будет строить накопители на Li-Ion от Tesla, NorthWestern делает ставку на газ

2020-03-23 в 15:07, admin, рубрики: Energy Storage systems, ess, Li-Ion, Li-Ion технологии, Lithium Battery, ups, usa, АББМ, альтернативные источники энергии, батареи, бесперебойное питание, бесперебойное электроснабжение, будущее здесь, достоинства Li-Ion технологии, ИБП, инженерные системы, литий-ионные батареи, открытые технологии, химия, хранение данных, цод, экология, Энергия и элементы питания

Здравствуйте, друзья! В статье «Литий-ионные ИБП: какой тип батарей выбрать, LMO или LFP?» мы касались вопроса Li-Ion решений (накопителей, аккумуляторов) для энергосистем частного и промышленного сектора. Предлагаю перевод сводки свежих коротких новостей из США от 3 марта 2020 по данной тематике. Лейтмотив данных новостей-литий-ионные батареи различной структуры в стационарном исполнении неуклонно вытесняют классические свинцово-кислотные решения, и значительный вклад внесла Tesla. Практика эксплуатации электромобилей дает возможность предполагать отличные перспективы и безопасность литиевых решений для энергосистем и промышленного оборудования типа ИБП и систем оперативного постоянного тока (СОПТ). Данные решения по-русски именуют аккумуляторными батареями большой мощности (АББМ), в англоязычной литературе это термин -Energy Storage System-ESS. Для начала оценим ситуацию на родине компании Илона Маска, в дальнейшем-продолжим публикации по данной теме систематически, поскольку «вести с полей» поступают достаточно стремительно.

Читать полностью »

Технический обзор архитектуры СХД Infinidat

2020-03-13 в 11:20, admin, рубрики: infinibox, infinidat, архитектура, инфраструктура, инфраструктура цод, системное администрирование, СХД, хранение данных, цодInfiniBox – модерновая система хранения, сразу попавшая в правую часть магического квадрата. В чем ее уникальность?

Краткая предыстория

Что такое InfiniBox? Это система хранения компании Infinidat. Что такое компания Infinidat? Это компания, созданная Моше Янаем (создатель Symmetrix и XIV) для реализации проекта идеальной СХД Enterprise-уровня.

Компания создана как разработчик ПО, которое ставится на проверенное оборудование, то есть это SDS, но поставляется как единый монолитный комплект.

Введение

В этой статье мы рассмотрим систему хранения InfiniBox, ее архитектуру, как она работает и как достигается высокая надежность (99,99999%), производительность, емкость при сравнительно невысокой цене. Поскольку основа системы хранения — это ее ПО, а для этой системы в особенности, то основной упор будет именно на софте, красивых фото железок не будет.

Зачем нужна еще одна система хранения на рынке?

Есть ряд задач, для которых нужна очень большая емкость, при этом надежность и производительность тоже важны. Например, облачные системы, стандартные задачи крупных компаний, интернет вещей, генные исследования, системы безопасности для больших структур. Оптимальную СХД для таких задач найти достаточно сложно, особенно если смотреть на цену. С прицелом на такие задачи и была построена программная архитектура InfiniBox.

Читать полностью »

Мониторинг в ЦОДе: как мы меняли старую BMS на новую. Часть 1

2020-03-13 в 7:19, admin, рубрики: bms, BMS-системы, Блог компании Linxdatacenter, дата-центр, инженерная инфраструктура, инженерные системы, ит-инфраструктура, система мониторинга, системы мониторинга, управление проектами, цод, эксплуатация

Что такое BMS

Система мониторинга работы инженерных систем в ЦОДе – ключевой элемент инфраструктуры, напрямую влияющий на такой важный показатель для дата-центра, как скорость реакции персонала на аварийные ситуации и, следовательно, на продолжительность бесперебойной работы.

Системы мониторинга BMS (Building Monitoring System) предлагают многие глобальные вендоры оборудования для ЦОДов. За время работы Linxdatacenter в России нам довелось познакомиться с разными системами и столкнуться с диаметрально противоположными подходами вендоров к эксплуатации этих систем.

Рассказываем, как мы полностью обновили нашу систему BMS за последний год и почему.

Читать полностью »

Дата-центры потребляют очень много электроэнергии, но пока не угрожают климату

2020-02-28 в 10:04, admin, рубрики: miran, PUE, Блог компании Дата-центр «Миран», высокая производительность, дата-центр "Миран", дата-центры, системы охлаждения, Статистика в IT, цод, экология, Энергия и элементы питания, энергоэффективность

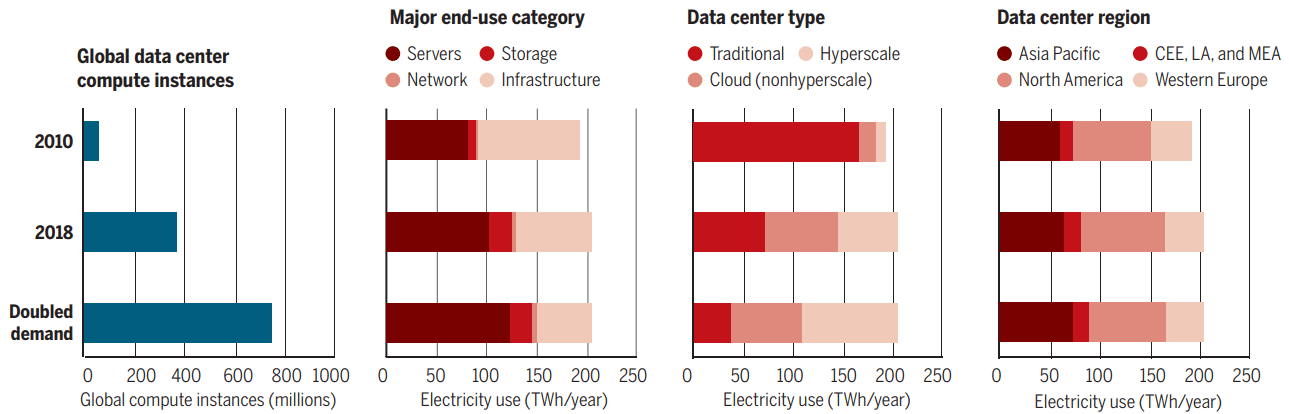

Рис. 1. Историческое потребление энергии ЦОД в 2010-2018 гг и прогноз на ближайшие годы, когда состоится очередное удвоение количества вычислительных инстансов (ядер) в дата-центрах

Спрос на услуги центров обработки данных (ЦОД) за последнее десятилетие вырос многократно. Его подогревает рост популярности социальных сетей, видео, мобильных приложений и различных облачных приложений.

В 2010 году на все дата-центры в мире ушло примерно 194 ТВт·ч, то есть 1% мирового энергопотребления. Что будет в случае экспоненциального роста вычислений? Звучали оценки, что энергопотребление ЦОД может вырасти в три или даже четыре раза. Например, см. оценку Бельхира и Эльмелиджи в статье "Assessing ICT global emissions footprint: Trends to 2040 & recommendations" (Journal of Cleaner Production, том 177, стр. 448).

Но последние исследования показывают, что повод для паники отсутствует. Так, с 2010 по 2018 годы вычислительные мощности ЦОД выросли в 6,5 раз, но энергопотребление осталось примерно на том же уровне (205 ТВт·ч, около 1%), так что планете пока ничего не угрожает.

Читать полностью »

SSO на микросервисной архитектуре. Используем Keycloak. Часть №1

2020-02-03 в 14:24, admin, рубрики: ci/cd, keycloak, SSO, авторизация пользователя, Администрирование баз данных, Блог компании X5 Retail Group, Микросервисная архитектура, микросервисы, СУБД, токены, цодВ любой крупной компании, и X5 Retail Group не исключение, по мере развития возрастает количество проектов, где требуется авторизация пользователей. С течением времени требуется бесшовный переход пользователей из одного приложения в другой и тогда возникает необходимость использования единого сервера Single-Sing-On (SSO). Но как быть, когда такие идентификационные провайдеры как AD или иные, не обладающие дополнительными атрибутами, уже используются в различных проектах. На помощь придет класс систем под названием «идентификационные брокеры». Наиболее функциональными являются его представители, такие как Keycloak, Gravitee Access management и пр. Чаще всего сценарии использования могут быть различны: машинное взаимодействие, участие пользователей и пр. Решение должно поддерживать гибкий и масштабируемый функционал, способный объединить все требования в одном, и такие решением в нашей компании сейчас является индикационный брокер – Keycloak.

Делимся опытом, как показывают себя SSD в рамках RAID и какой уровень массива выгоднее

2019-12-27 в 12:16, admin, рубрики: Kingston, raid, raid контроллер, SSD-накопитель, Блог компании Kingston Technology, высокая производительность, контроллер, Накопители, накопитель, серверное решение, хранение данных, цодВ прошлом материале мы уже рассмотрели вопрос о том “Применим ли RAID на SSD” на примере накопителей Kingston, но сделали это только в рамках нулевого уровня. В текущей статье мы разберем варианты использования профессиональных и домашних NVMe-решений в самых популярных типах RAID-массивов и расскажем о совместимости контроллеров Broadcom с накопителями Kingston.