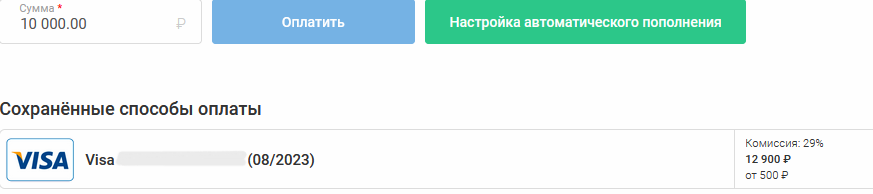

Молоко по 790 мл? Вот вам пример интереснее. У этого хостера цены те же, только комиссия чуть выросла.

Сейчас идёт серьёзный передел рынка хостингов из-за тенденции ходить в Интернет по паспорту.

Это моё личное мнение, но очень похоже на то, что в следующем году всё станет дороже, и сейчас я расскажу про факторы, которые с очень высокой вероятностью приведут к этому.

Сразу скажу, что в большинстве сценариев конкретно поднимать цен мы не будем, но у нас горизонт планирования — до мартовских выборов, а дальше ситуация может меняться довольно быстро. Мы уже поднимали в прошлом году с пониманием, что случится, и этого пока достаточно.

Итак, первое: теперь всем нужно будет интегрироваться с СОРМ и хранить netflow трафика.

Если что, то это:

- От трёх до пяти миллионов рублей на покупку софта.

- Примерно один-два человекомесяца разработки на интеграцию.

- Железо для хранения трафика. У нас получается примерно от 60 терабайт на каждый 1 Гбит/с у пользователя, и это без DDoS-атак.

Всё это ляжет на пользователей, конечно, потому что больше не на кого. То есть на вас.

Причём это только первый фактор. И это ещё даже не вся его цена, потому что само снятие копии трафика тоже занимает ресурс. Нужно будет либо покупать новые маршрутизаторы, которые делают это в железе, либо работать на уровне сетевого драйвера (минус часть производительности), либо лезть в юзерспейс на уровне ОС и через это замедлять его машину.

А ещё у всех — инфляция, курс доллара, проблемы с железом, лицензиями, платежами, гениальная схема «Яндекса» по повышению ставок и вообще тяжёлый год. Читать полностью »