IO — известный американский колокейшн-провайдер, который специализируется на строительстве, продаже и сдаче в аренду модульных дата-центров IO.Anywhere. Попросту говоря, занимается предоставлением помещений в машзалах своих ЦОД под размещение клиентского серверного оборудования.

Рубрика «цод» - 28

Почему дата-центрам нужны операционные системы

2014-12-16 в 11:04, admin, рубрики: Блог компании 1cloud.ru, дата-центры, ит-инфраструктура, операционные системы, разработка, хостинг, цод, ЦОДыРазработчики сегодня создают новые классы приложений. Эти приложения разрабатываются уже не под отдельный сервер, а запускаются с нескольких серверов в дата-центре. Примеры включают фреймворки, реализующие аналитические вычисления, такие как Apache Hadoop и Apache Spark, брокеров сообщений, вроде Apache Kafka, key-value хранилища, например Apache Cassandra, а также приложения, с которыми работают непосредственно конечные пользователи, вроде тех, которые используются компаниями Twitter и Netflix.

Эти новые приложения – больше, чем просто приложения, это – распределенные системы. Точно так же, как когда-то для разработчиков стало привычным создавать многопоточные приложения для отдельных машин, становится общепринятым проектировать распределенные системы для дата-центров.

Но разработчикам довольно сложно создавать такие системы, а администраторам тяжело их поддерживать. Почему? Потому что мы используем неверный уровень абстракции, как в отношении разработчиков, так и в отношении администраторов – уровень машин.Читать полностью »

DigitalOcean анонсировали ЦОД в Германии

2014-12-14 в 8:53, admin, рубрики: kvm, vps, виртуализация, германия, хостинг, цод

Компания DigitalOcean, один из крупнейших провайдеров услуг хостинга VPS в мире, в очередной раз радует пользователей тем, что прислушивается к их просьбам. В августе 2013 года одним из пользователей их услуг на портале User Voice было создано предложение открыть дата-центр в Германии. Это должно было значительно улучшить качество услуг для пользователей из Европы.

Совсем недавно, 12 декабря 2014, был получен официальный ответ от представителя компании.

Читать полностью »

Как согреться за «чужой» счет

2014-11-29 в 13:26, admin, рубрики: высокая производительность, дата-центр, ит-инфраструктура, Облачные вычисления, процессор, сервер, хостинг, цодДата-центры обычно не используют всю тепловую энергию, которую сами вырабатывают, но есть множество способов использовать ее с пользой на все 100%. Например, в своем собственном доме посреди зимы в каком-нибудь уголке планеты, не балующем жителей мягким климатом. Можно, конечно, жить прямо в дата-центре. А если серьезно, достаточно иметь небольшой ЦОДик, производящий необходимое количество тепла, у себя дома или в офисе.

Facebook запускает ЦОД с новой сетевой архитектурой

2014-11-25 в 14:30, admin, рубрики: Facebook, архитектура сети, ит-инфраструктура, кластер, Сетевые технологии, хостинг, цодВ последнее время штат Айова стал весьма популярным местом среди операторов дата центров. Компания Facebook официально объявила об открытии первого здания своего новейшего модульного ЦОД с воздушным охлаждением в городе Алтуна. Представители соцсети также сообщили, что этот дата центр станет самым длинным во всем мире.

Keystone NAP превратит сталелитейный завод в ЦОД

2014-11-23 в 18:51, admin, рубрики: keystone, Schneider electric, ит-инфраструктура, хостинг, цодКомпания Keystone NAP строит новый дата центр на месте бывшего сталелитейного завода в округе Бакс, Пенсильвания. Ввод в эксплуатацию планируется на первый квартал 2015. Сталелитейный завод был построен еще 60 лет назад и в свое время был одним из крупнейших производителей стали в США. Производство стали снизилось, но огромная энергетическая инфраструктура осталась. Вот как раз именно ее Keystone NAP планирует активно задействовать, и объединить с модульным зданием для нового ЦОД, а помогать ей в этом будет компания Schneider Electric.

«ИТ-театр» из бетона и зелени

2014-11-08 в 9:00, admin, рубрики: Tier, банк, дизайн, ит-инфраструктура, финансы, хостинг, цодИспанская финансовая группа Santander – финансовый лидер в Еврозоне и третий по величине частный банк в Бразилии – открыла в Кампинасе, штат Сан-Паулу, дата центр стоимостью почти 500 млн американских долларов. ЦОД в Кампинасе занимает 800 тыс квадратных метров и служит для обработки и размещения данных корпорации. Он спроектирован таким образом, чтобы сочетать в себе высокую скорость обработки данных, высокую устойчивость системы, безопасное размещение данных, и возможность внедрения новейших технологий.

Видеонаблюдение в ЦОДах: совмещаем паранойю охраны с паранойей инженеров

2014-10-30 в 7:13, admin, рубрики: безопасность, Блог компании КРОК, видеонаблюдение, информационная безопасность, ит-инфраструктура, контроль доступа, расследование инцидентов, цод

Инженер во время штатной проверки

В розничных сетях сейчас одна из главных задач видеонаблюдения — это распознавание лиц злоумышленников из известной базы на входе.

Видеонаблюдение в ЦОДах пошло по немного другой ветви эволюции. Начнём с того, что охрана даже просто не знает, на что смотреть, и контроль, по сути, заканчивается на периметре. А случается всякое. Знаю, например, о случае нештатного запуска системы пожаротушения. Причину искали по записям — оказалось, монтажник опёрся локтем в коридоре на кнопку.

Бывают запросы на то, кто открывал стойку. В каком-нибудь ЦОДе может случиться так, что несут что-то по проходу и задевают кабель. Или вот ещё случай: инженер одной компании обслуживал верхний сервер в стойке, в процессе у него упала лестница и ударила прямо по другому серверу, в итоге — раскололся разъём.

Поэтому, конечно, видеонаблюдение в ЦОДах нужно. Расскажу, как мы это делаем для заказчиков, и как организовали в своих дата-центрах. Читать полностью »

Практика эксплуатационщика: 1000 дней без простоя ЦОДа TIER-III

2014-10-16 в 5:49, admin, рубрики: Tier, Uptime Institute, авария, аудит, Блог компании КРОК, дата-центр, ит-инфраструктура, питание, практика, тепловизор, управление проектами, цод

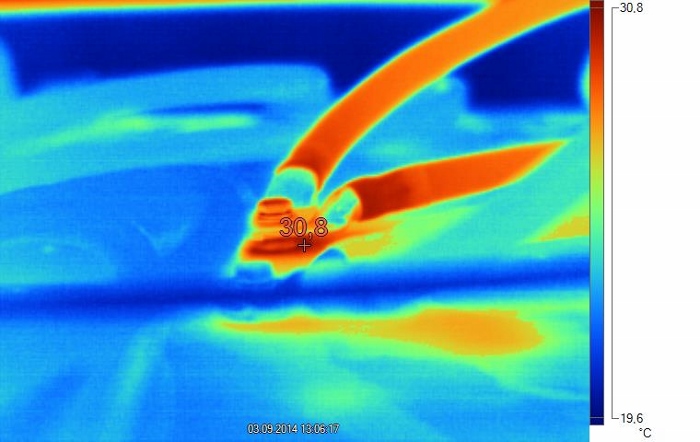

Окисление контактов перемычки аккумулятора вызвало нагрев. При наружном осмотре следов окисления не видно, поскольку оно произошло между клеммой аккумулятора и наконечником перемычки.

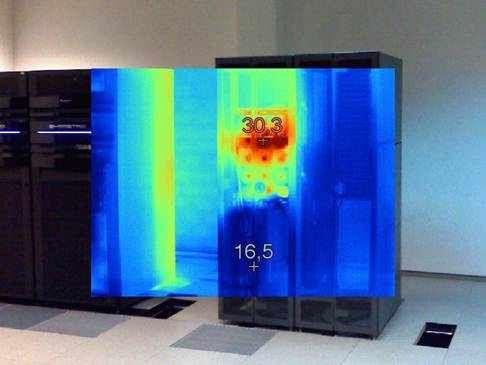

Пару недель назад у меня и коллег случился маленький праздник: 1000 дней непрерывной работы ЦОДа без простоя сервиса. В смысле — без влияния на оборудование заказчиков, но со штатными и не очень работами по системам.

Ниже я расскажу о том, как я и мои коллеги обслуживают ЦОД повышенной ответственности, и какие бывают подводные камни.

Читать полностью »

FAQ про охлаждение дата-центров: как сделать дёшево, сердито, надёжно и вписаться в габариты площадки

2014-10-02 в 6:18, admin, рубрики: бескомпрессорный холод, Блог компании КРОК, дата-центр, ит-инфраструктура, охлаждение, управление проектами, фрикулинг, хладоноситель, цод

— Какой обычно есть выбор для охлаждения ЦОДа?

- Фреоновое охлаждение. Проработано, просто, доступно, но главный минус — ограниченные возможности по манёвру в энергоэффективности. Также часто мешают физические ограничения по длине трассы между наружными и внутренними блоками.

- Системы с водой и гликолевыми растворами. То есть хладагентом всё ещё остаётся фреон, а вот хладоносителем уже будет другое вещество. Трасса может быть длиннее, но главное, что открывается многообразие вариантов настройки режимов работы системы.

- Системы комбинированного типа: кондиционер может быть и фреонового, и водяного охлаждения (здесь масса нюансов).

- Охлаждение воздухом с улицы — это различные варианты фрикулинга: роторные теплообменные аппараты, прямые и косвенные охладители и так далее. Общий смысл — либо прямой теплоотвод фильтрованным воздухом, либо замкнутая система, где уличный воздух охлаждает внутренний через теплообменник. Нужно смотреть на возможности площадки, так как возможны внезапные решения.

— Так давайте бахнем классические фреоновые системы, в чём проблема?

Классические фреоновые системы отлично работают в малых серверных и, не часто, средних ЦОДах. Как только машзал переваливает за 500–700 кВт, возникают проблемы с размещением наружных блоков кондиционеров. Для них банально не хватает места. Приходится искать свободные площади подальше от ЦОДов, но тут вмешивается длина трассы (её не хватает). Конечно, можно спроектировать систему на пределе возможностей, но тогда растут потери в контуре, снижается эффективность, усложняется эксплуатация. В итоге для средних и больших ЦОДов сугубо фреоновые системы зачастую невыгодны.Читать полностью »